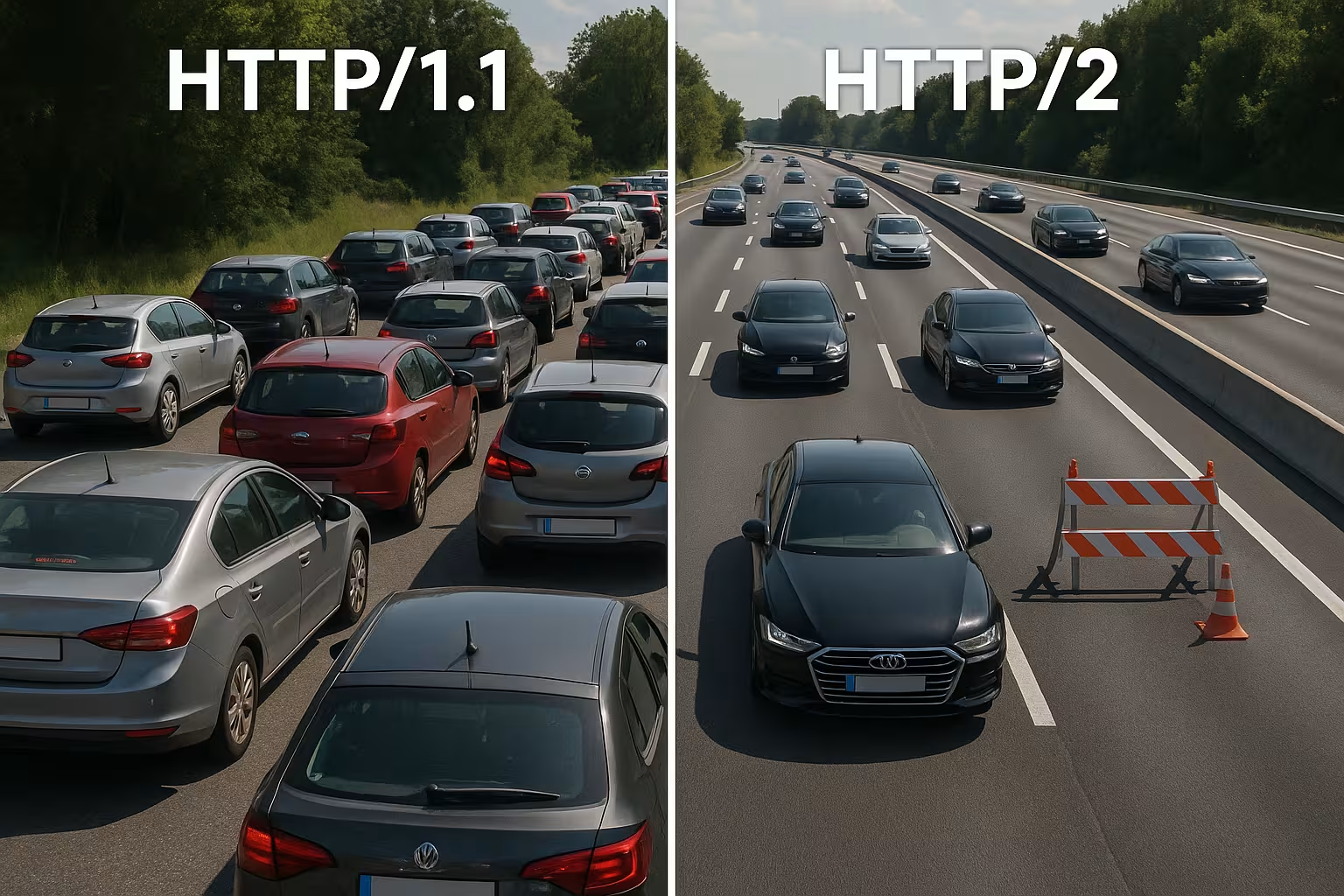

HTTP/2 マルチプレキシング 単一の接続で多くのリクエストをまとめ、プロトコルレベルの障害を取り除きます。しかし、実際のネットワークでは、TCPヘッド・オブ・ライン、TLSオーバーヘッド、優先順位付けの不備により、HTTP/2はHTTP/1.1よりも自動的に高速に動作するわけではありません。.

中心点

- 多重化 単一の TCP 接続を介して多くのリクエストを並行処理します。.

- TCP‑HoL 継続し、損失が発生した場合はすべてのストリームを停止します。.

- TLS設定 Time-to-First-Byte を著しく遅延させる可能性があります。.

- 優先順位 サーバープッシュは、適切な調整を行った場合にのみ機能します。.

- ページタイプ 決定:小さなファイル多数 vs. 大きなファイル少数。.

HTTP/2 マルチプレクシングの内部動作

私はすべての回答を細かく分析します。 フレーム, それらに番号を付け、論理的なストリームに割り当てて、複数のリソースが単一の接続で同時に実行されるようにします。これにより、あるリクエストが別のリクエストの終了を待つ必要がなくなるため、HTTP レベルでのブロックを回避できます。ブラウザは HTML、CSS、JS、画像、フォントを並行して送信し、追加の接続コストを削減します。HPACK によりヘッダーが縮小されるため、多数の小さなファイルの場合、負荷が大幅に軽減されます。 ただし、重要な点は、すべてのストリームが同じ TCP ラインを共有することであり、これは利点もあるが、新たな依存関係も生む。このアーキテクチャは、ネットワークが安定し、 優先順位付け 有意義に働く。.

HTTP/1.1 対 HTTP/2:主な違い

HTTP/1.1 は、テキストベースのメッセージとホストごとの複数の並列接続を使用してリソースを同時にロードするため、ハンドシェイクとオーバーヘッドが増加します。HTTP/2 はバイナリで動作し、すべてに単一の接続を使用し、ヘッダーを圧縮するため、特にオブジェクトが多い場合の待ち時間が短縮されます。 ウォーターフォール図では、ストリームが並行して進むため、長い待ち行列はなくなります。その代わりに、ボトルネックが HTTP 層から TCP 層に移るため、不安定なネットワークではその影響が顕著に感じられます。キャッシュの多い小さなページでは、1.1 とほとんどメリットがない場合が多いですが、アセットの多い大きなページでは、そのメリットがより顕著に現れます。これらの違いが、私の チューニング戦略 プロジェクト固有の決定を正当化する。.

フロー制御とウィンドウサイズを正しく選択する

HTTP/2 は、ストリームごと、接続ごとに独自のフロー制御機能を備えています。私は、以下の値について注意を払っています。 INITIAL_WINDOW_SIZE また、同時ストリームの数を調整して、回線が混雑したり、利用率が低くなったりしないようにします。ウィンドウが小さすぎると、不必要に多くの WINDOW_UPDATEフレームを制限し、データレートを抑制します。ウィンドウが大きすぎると、性能の低いクライアントに負担がかかりすぎる場合があります。帯域幅遅延積(BDP)が高いネットワークでは、大きな応答がストップアンドゴーで滞留しないように、ウィンドウサイズを意図的に大きくします。同時に、 MAX_CONCURRENT_STREAMS 実用的な:レンダリングに重要な部分には十分な並列処理を行いますが、細かい部分によってLCP画像が遅くなることは避けましょう。これらの調整は小さなものですが、ページやネットワークに適している場合は、実際の読み込み時間に大きな影響を与えます。.

ドメインシャーディングとバンドリングの再評価

HTTP/2 では、多くの 1.1 最適化は逆効果です。私は、単一の接続を効率的に利用する方が、人為的に分散したソケットよりも効率的であるため、古いドメインシャーディングを廃止しています。また、JavaScript を巨大なファイルにアグロバンドルすることにも疑問を感じています。論理的に分離された小さなバンドルを使用することで、ターゲットを絞ったキャッシュが可能になり、変更時にアプリ全体を再転送する必要がなくなります。 並列リクエストが安価になり、最新の画像フォーマットとキャッシュが効果的に機能するため、画像スプライトの重要性は低下しています。したがって、マルチプレキシングが有効である場合はそれを解消し、アーキテクチャが本当に簡素化される場合や、キャッシュのヒット率が測定可能に増加する場合にのみバンドルを行います。.

接続の結合と証明書

HTTP/2 では、証明書と DNS が一致する場合、ブラウザは複数のホスト名に対して 1 つの接続を使用することができます。私は、コアルシングが可能になり、追加のハンドシェイクが不要になるように、SAN エントリと SNI を計画しています。ALPN と暗号スイートが一致する場合、クライアントは CSS を cdn.example.com および画像 static.example.com 同じ回線を通じて取得します。これにより、RTT が節約され、優先順位付けが簡略化され、重要な資産が直接届く可能性が高まります。ネットワークタブでこれらの効果を具体的に確認します。実際に 1 つのソケットのみが使用されているのか、それとも証明書制限やポリシーによってブラウザが新しい接続を強制されているのか?

マルチプレクシングが妨げられる理由:TCPヘッド・オブ・ライン

唯一の TCP 接続でパケットが失われると、再送信が到着するまで回線全体が待機状態になり、HTTP/2 ストリームが一時的にすべて停止します。そのため、遅延が変動し、損失率が高いモバイルネットワークでは、複数の 1.1 接続と比較して、利益が減少したり、むしろ不利益になる場合がよくあります。 この影響により、マルチプレキシングは理論上は優れているものの、実際には必ずしも効果がないことが説明できます。研究および実地での測定により、実際のネットワークでまさにこの関連性が確認されています [6]。そのため、私は保守的な展開を計画し、典型的なユーザーパスでテストを行い、各ターゲットグループへの影響を確認しています。TCP‑HoL を無視すると、その効果を無駄にしてしまうことになります。 パフォーマンス また、読み込み時間をさらに長くすることもあります。.

TLSハンドシェイク、TTFB、ページタイプ

HTTP/2 は、ウェブ上ではほぼ TLS 経由で動作するため、追加のハンドシェイクが発生し、アセットが少ない場合、最初のバイトまでの時間が大幅に長くなる可能性があります。1 つの大きなファイルのみを配信する場合、並列転送が必要ないため、多重化のメリットは失われます。 10 から 20 個の小さなファイルを含むページの方がメリットが大きく、単一アセットの応答は HTTP/1.1 と同等になることが多い。TLS 1.3、セッション再開、クリーンなキープアライブを使用してオーバーヘッドを短縮し、再接続が不要になり、1 つの回線が実際に有効になるようにしています。微調整には、以下を使用しています。 キープアライブチューニング, 、負荷に合わせて再利用、アイドルタイムアウト、および制限を設定します。これにより、ハンドシェイクの割合が減少し、 TTFB トラフィックのピーク時でも安定しています。.

CDN およびプロキシチェーン:h2 からオリジンまで

多くのスタックはエッジで TLS を終了し、オリジンと通信を続けます。CDN とバックエンドの間でも HTTP/2 が使用されているか、あるいは HTTP/1.1 にフォールバックしているかを確認します。バッファリングプロキシは、応答を再シリアル化したり順序を変更したりすることで、ヘッダー圧縮や優先順位付けなどの利点を部分的に無効にしてしまう場合があります。 そのため、エンドツーエンドで最適化を行います。エッジノード、中間プロキシ、オリジンは h2 を理解し、適切なウィンドウサイズを実行し、優先順位を無視してはなりません。h2c(内部ネットワークで TLS を使用しない HTTP/2)が有効である場合は、セキュリティポリシーに違反することなく、レイテンシと CPU を節約できるかどうかをテストします。一貫性のあるチェーンによって初めて、その真価が発揮されるのです。 多重化効果を完全に発揮します。.

優先順位付けを正しく活用する

HTML、CSS、LCP 画像が最初に到着し、レンダリングのブロックが解除されるように、重要なリソースを高く評価します。明確な優先順位がない場合、重要度の低いスクリプトが貴重な帯域幅を消費し、Above-the-fold コンテンツが待機状態になります。すべてのサーバーがブラウザの優先順位を正しく認識しているわけではなく、一部のプロキシは順序を変更するため、私は希望的観測ではなく結果データを評価しています [8]。 プリロードヘッダーと早期に配置された画像参照は、ロードパスを短縮し、キャッシュのヒット率を向上させます。優先順位付けは魔法のような効果はありませんが、ユーザーが必要な情報を素早く見つけられるように、1 つの接続を誘導します。明確なルールは、顕著な効果をもたらします。 スラスト そして、マルチプレクシングを本当に効果的にするんだ。.

実践における優先順位付け:拡張可能な優先順位

ブラウザは優先順位付けモデルをさらに発展させています。私は、最新のクライアントは、固定のツリー重みではなく、「拡張可能な優先順位」をしばしば使用していることを考慮しています。これにより、各ストリームの緊急度と漸進的パラメータが示され、サーバーはそれを解釈して、公平なスケジューラに変換する必要があります。私は、自分のサーバーがこれらの信号を尊重しているかどうか、あるいは古い動作に基づいているかどうかを検証しています。 A/B テストでは、サーバー側の優先順位付けの有無によるロードパスを比較し、置換効果を確認します。重要な点:優先順位付けは、レンダリングに重要なものを優先すべきですが、長時間かかるダウンロードのスターベーション(資源不足)を招いてはなりません。慎重な組み合わせにより、ピークを回避し、可視コンテンツのパイプラインを空けておくことができます。.

サーバープッシュ:略語はめったに使われない

サーバープッシュは、過剰なプッシュが帯域幅を占有し、ブラウザのキャッシュを無視するため、特定の状況でのみ使用しています。すでにキャッシュされているリソースがプッシュされると、パスは高速化されるどころか、むしろ遅くなります。多くのチームはプッシュ機能を再び無効にし、プリロードを使用することで信頼性を大幅に向上させています [8]。 特定のケース、たとえば明確なパターンがある繰り返しルートでは、プッシュが役立つこともありますが、私は測定値でその効果を証明しています。証拠がない場合は、プッシュを削除して、本当に必要なデータのためにパイプラインを空けておきます。ここでは、少ないほど良い場合が多いのです。 もっと見る, 、唯一の連絡手段で。.

実践比較:HTTP/1.1 がより高速になる場合

HTTP/1.1 は、少数の大きなファイルが主流である場合や、損失率の高いネットワークで動作する場合に競争力があると思います。複数の個別の接続によりリスクが分散され、個々のファーストバイトタイムを短縮することができます。非常に小さなページでは、追加の TLS ハンドシェイクによって、マルチプレクシングの利点が完全に相殺される場合が多くあります。 一方、小さなオブジェクトが多い場合は、圧縮、優先順位付け、および単一のソケットが効果を発揮するため、HTTP/2 が優位に立ちます。以下の概要は、プロトコルの選択を決定する監査および実地試験から得られた典型的なパターンを示しています [6][8]。この表は試験に代わるものではありませんが、確かな情報を提供します。 オリエンテーション 最初の決定のために。.

| シナリオ | より良い議事録 | 理由 |

|---|---|---|

| 多くの小さなアセット(CSS/JS/画像/フォント) | HTTP/2 | マルチプレクシングとHPACKはオーバーヘッドを削減し、1つの接続で十分です。 |

| 少数の非常に大きなファイル | HTTP/1.1 ≈ HTTP/2 | 並行性はほとんど必要ない;ハンドシェイクのコストの方がより重要 |

| 不安定なモバイルネットワークによる損失 | HTTP/1.1 部分的に改善 | TCP‑HoL は HTTP/2 ではすべてのストリームを停止します。複数のソケットが役立つ場合があります。 |

| 最適化された TLS (1.3、再開)、明確な優先順位 | HTTP/2 | セットアップの簡素化、ターゲットを絞った帯域幅の制御 |

| オーバープッシングアクティブ | HTTP/1.1/HTTP/2(プッシュなし) | 不要なデータが回線を占有する。プリロードの方が安全である。 |

実際の読み込み時間を短縮するためのベストプラクティス

プロトコル前のバイト数を削減します。WebP/AVIF の画像、適切なサイズ、節約的なスクリプト、クリーンなキャッシュヘッダーを使用します。重要な CSS パスの部分は小さく保ち、フォントは早めに読み込み、レイアウトのシフトを防ぐためにフォールバックを設定します。接続の確立と DNS には、 プリコネクトと DNS プリフェッチ, パーサーがリソースに到達する前にハンドシェイクが開始されるようにします。テキストコンテンツ用の Brotli は、特に CDN 経由の繰り返しアクセスを高速化します。ウォーターフォールで効果を制御し、変更前後の LCP、FID、TTFB を比較します。測定値は私の判断の指針となります。 優先順位, 、直感はそうではない。.

gRPC、SSE、ストリーミングのケース

HTTP/2 は、gRPC やその他の双方向または長時間実行のストリームで特にその強みを発揮します。 その際、タイムアウト、バッファサイズ、バックログルールに注意して、ストリームの停滞が他のすべてのリクエストに悪影響を与えないようにしています。サーバー送信イベントやライブフィードの場合、サーバーが優先順位を正しく管理し、キープアライブの制限が早期に発動しない限り、安定した永続的な接続が有用です。 同時に、エラー発生時の動作もテストします。ストリームの再構築、指数バックオフ、および再接続の適切な制限により、多くのクライアントが同時に切断して再接続した場合の負荷のピークを回避します。これにより、リアルタイムのシナリオは予測可能なままになります。.

安定した多重化パフォーマンスのための OS および TCP チューニング

プロトコルの選択は、弱いネットワーク構成をカバーするものではありません。私は、輻輳制御アルゴリズム(BBR 対 CUBIC など)、ソケットバッファ、TCP ファストオープンポリシー、および初期輻輳ウィンドウサイズを確認します。パスに適した輻輳制御は、再送信を減らし、HoL 効果を緩和することができます。 同様に重要なのは、フラグメンテーションや回避可能な損失を防ぐための正しい MTU/MSS 値です。TLS レベルでは、ハンドシェイクを高速化するため、短い証明書チェーン、OCSP スタッフィング、および ECDSA 証明書を優先します。これらの設定を組み合わせることで、マルチプレキシングに必要な 下部構造, 優先順位付けとヘッダー圧縮が効果を発揮するように。.

日常業務における測定戦略とKPI

私は中央値に頼るのではなく、デバイス、ネットワークタイプ、ロケーションごとに分類したメトリクスの p75/p95 を確認しています。合成テストは再現性のある基本値を提供し、リアルユーザーモニタリングは現場でのばらつきを示します。 キーパスのウォーターフォールを比較し、HTML の初期バイト、CSS/JS の順序、LCP 画像の到着時間を確認します。変更は制御された実験として展開し、TTFB、LCP、エラー率を並行して観察します。 重要な点:測定可能なメリットがない優先順位付けは削除します。これにより、設定はスリムなまま、統計的に時間を節約できる調整要素に投資することができます。.

クロールおよびボットトラフィック

ユーザーだけでなく、クローラーもクリーンな HTTP/2 の恩恵を受けます。関連するエンドポイントで h2 を有効にし、ボットが接続を再利用して同じ時間でより多くのページを取得するかどうかを確認します。不要な 301 カスケード、非圧縮のレスポンス、または短すぎるキープアライブ制限は、クロール予算を消費します。 バックエンドの制限を超えずにマルチプレキシングが機能するように、ポリシーを調整しています。その結果、スキャン効率が向上し、負荷時の安定性が向上しています。.

HTTP/2、HTTP/3、そして次に重要なこと

HTTP/3 は UDP 上の QUIC を採用しており、TCP のヘッド・オブ・ライン・ブロッキングを解決します。これは、モビリティや損失において特に顕著な効果があります [6]。 接続の確立時間が短縮され、ストリームのブロックがすべてのリクエストに同時に影響することはなくなりました。混合フリートでは、HTTP/2 は依然として重要ですが、クライアントと CDN がすでに HTTP/3 に対応している場合は、HTTP/3 を有効にしています。詳細な比較については、以下をご覧ください。 HTTP/3とHTTP/2の比較 ロールアウトを段階的に、ターゲット層に合わせて計画するのに役立っています。実際のユーザーにメリットがあるよう、場所、デバイス、ネットワークタイプごとに個別に測定しています。そのため、プロトコルを使用して ロード時間 日常生活におけるストレスを軽減する。.

ホスティングとインフラストラクチャによる加速

優れたプロトコルは脆弱なインフラを救うことはできません。そのため、私はロケーション、ピアリング、CPU、RAM、I/O の制限を厳密にチェックしています。最新のウェブサーバー、適切なワーカー数、キャッシュレイヤーにより、唯一の接続がボトルネックになることを防ぎます。戦略的な CDN の使用により、RTT が短縮され、負荷のピークが緩和されます。 ヨーロッパ全域のユーザーにサービスを提供している場合は、プロトコルの微調整よりも、距離の短さを活用するほうが大きなメリットになることが多い。バーストトラフィックによってシステムがダウンしないように、予備の容量も考慮して容量を計画している。そうすることで、マルチプレキシングの効果が発揮される。 ポテンシャル 信頼できる。

エラーのパターンを素早く認識する

HTTP/2 の動作が予想よりも遅い場合、私は典型的なパターンを探します。1 つの長い転送が多くの小さな転送をブロックしている、優先順位が無視されている、モバイル回線での再送信率が高い、TLS 再開が機能していないなどです。 次に、HTTP/2 と HTTP/1.1 を同じ条件で比較し、CDN の影響をオリジンから切り離して、ソケット数、実際のストリーム数、最初のキロバイトの順序を確認します。 ボトルネックが見つかった場合は、フロー制御や優先順位を調整する前に、まず基本(バイト、キャッシュ、ハンドシェイク)を調整します。この順序で、最も確実な改善が得られます。.

迅速な意思決定のための実践的な要約

HTTP/2 マルチプレキシングは、オブジェクト数が多く、優先順位が適用され、TLS が適切に構成されている場合に使用します。大きなファイルが少なかったり、ネットワークが不安定な場合は、メリットが少ないと想定し、1.1 の結果を注視します。 サーバープッシュは証拠がある場合にのみ使用し、プリロードはほぼ常に使用し、圧縮、キャッシュ、早期接続によってオーバーヘッドを小さく抑えます。実際のデバイスとロケーションで測定を行い、変更を広く展開する前に私の仮定を確認します [6][8]。結局、重要なのはプロトコル番号ではなく、実際のユーザーにとって実感できる速度です。 このように進めれば、HTTP/2 を確実に活用することができます。 スピード を廃止し、HTTP/3 の基礎を築きます。.