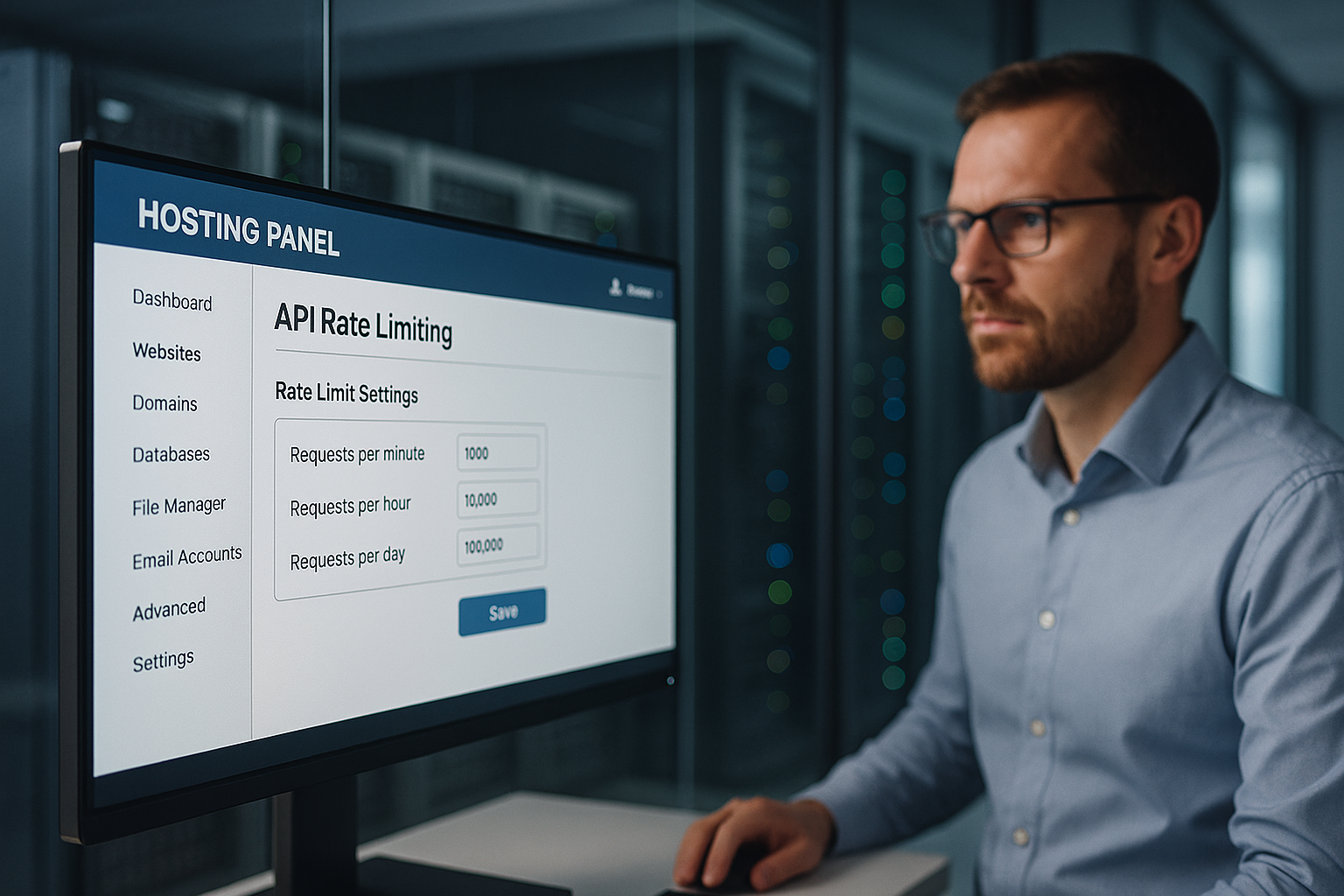

Hosting ograniczający szybkość API chroni panel hostingowy przed nadużyciami, ściśle kontrolując liczbę żądań na adres IP, klucz API i punkt końcowy, zapobiegając w ten sposób przestojom, niewłaściwemu wykorzystaniu danych i niepotrzebnym kosztom. Ustawiam wielopoziomowe limity, wcześnie rozpoznaję anomalie i zabezpieczam funkcje istotne dla klienta, takie jak logowanie, rozliczenia i dostęp do danych przed DDoS, upychaniem danych uwierzytelniających i nieuczciwymi szczytami obciążenia.

Punkty centralne

- Wielowarstwowy Ograniczenia: globalne, użytkownika, punktu końcowego

- Algorytmy Wybierz: Token/Słabe/Okno przesuwne

- Przezroczysty Nagłówek: Limit, Pozostało, Reset

- Monitoring w czasie rzeczywistym z powiadomieniami

- Uczciwy rozłożone w czasie: kwoty na segment klienta

Dlaczego ograniczanie szybkości API jest niezbędne w panelu hostingowym?

Używam wyraźnych limitów, aby temu zapobiec Atakujący Blokowanie punktów końcowych logowania lub danych z zalewem żądań. W ten sposób legalne procesy pozostają dostępne, a ja powstrzymuję nadużycia i utrzymuję niskie opóźnienia. Wszelkie przeciążenia serwerów współdzielonych kosztują pieniądze i zaufanie, więc na czas ograniczam nadmierne żądania. Zapobiegam eskalacji, dynamicznie dostosowując limity przed wyczerpaniem przepustowości. Klienci uzyskują stałe czasy odpowiedzi, ponieważ egzekwuję sprawiedliwe limity i eliminuję niekontrolowane szczyty.

Jak działa ograniczanie szybkości: koncepcje i algorytmy

Wybieram odpowiedni algorytm zgodnie z profilem obciążenia, krytycznością punktu końcowego i oczekiwanymi szczytami, ponieważ dobra metoda Nadużycie niezawodnie zatrzymuje i pozwala na legalne wybuchy. Metody z przesuwanym oknem wygładzają twarde granice, token bucket pozwala na szybkie krótkoterminowe wybuchy, a leaky bucket utrzymuje równomierny przepływ. Stałe okno jest odpowiednie dla prostych reguł, ale może wydawać się niesprawiedliwe na krawędziach okna. Łączę metody, gdy punkty końcowe znacznie się różnią, np. logowanie vs. zawartość statyczna. Pozwala mi to kontrolować przepływy bez niepotrzebnych blokad.

| Algorytm | Typowe zastosowanie | Korzyści dla bezpieczeństwa |

|---|---|---|

| Stałe okno | Prosty model kwotowy | Przewidywalny Warunki |

| Okno przesuwne | Bardziej precyzyjne wygładzanie | Mniej sztuczek granicznych |

| Token Bucket | Odporność na przepięcia | Elastyczne wskazówki |

| Nieszczelne wiadro | Stała przepustowość | Czysty odpływ |

Dla każdego punktu końcowego dokumentuję docelowy RPS, wielkość burstu i reakcję w przypadku naruszeń, tak aby Kontrola pozostaje powtarzalny. Każda reguła jest wersjonowana w infrastrukturze, dzięki czemu audyty mogą wyraźnie rozpoznać, kiedy który limit ma zastosowanie.

Wielowarstwowe limity: globalne, użytkownika, punktu końcowego

Najpierw ustawiam globalny limit, który definiuje Platforma jako całości, aby żadna pojedyncza aplikacja nie zużywała przepustowości. Następnie ustalam poziomy przydziałów dla poszczególnych klientów, tak aby konta premium otrzymywały większą przepustowość bez wyciskania innych. Na koniec dzielę punkty końcowe na warstwy: Autoryzacja, płatności, operacje zapisu są bardziej rygorystyczne; punkty końcowe odczytu są bardziej hojne. Nie blokuję na ślepo naruszeń reguł, ale najpierw zwiększam opóźnienie lub proszę o cofnięcie przed podjęciem ostrzejszych działań. Dzięki temu doświadczenie użytkownika jest sprawiedliwe, a krytyczne usługi pozostają chronione.

Prawidłowy pomiar wzorców ruchu

Analizuję typowe czasy szczytu, rozkład na punkt końcowy i poziom błędów, ponieważ dane te Ograniczenia scharakteryzować. Rozróżniam między ludzkim użyciem a zautomatyzowanymi wzorcami poprzez gęstość IP, agentów użytkownika i zachowanie tokenów. Anomalie rozpoznaję po nagłym wzroście liczby błędów 401/403/429 lub nieregularnych czasach odpowiedzi. Zwracam uwagę na anomalie, a następnie testuję bardziej rygorystyczne reguły w suchym przebiegu, aby uniknąć fałszywych alarmów. Dopiero gdy zachowanie zostanie potwierdzone jako stabilne, aktywuję egzekwowanie.

Przejrzystość dla klientów: Nagłówki i komunikaty o błędach

Otwarcie komunikuję ograniczenia, aby Zespoły integrują się w przewidywalny sposób i wycofują się w odpowiednim czasie. Uwzględniam kwoty w każdej odpowiedzi, aby programiści mogli kontrolować ich wykorzystanie. Jasne komunikaty o błędach pomagają zamiast frustrować. Oto przykład, którego używam:

Limit X-RateLimit: 120

X-RateLimit-Remaining: 15

X-RateLimit-Reset: 1731187200

Retry-After: 30

Zachowuję spójność formatów i opisuję je w dokumentacji API, tak aby nie było luk w interpretacji, a interfejs API był w pełni funkcjonalny. Integracja działa płynnie.

Ograniczenia oparte na kosztach i złożoności oraz jednoczesność

Nie tylko ograniczam czystą liczbę żądań, ale także Złożoność i współbieżność: Ścieżki wymagające dużej mocy obliczeniowej otrzymują wyższe „koszty“ niż proste odczyty. Przypisuję wynik dla każdego żądania (np. 1 dla prostych GET, 10 dla dużych eksportów) i dławię zgodnie z całkowitymi kosztami w oknie czasowym. Ograniczam również maksymalną liczbę jednoczesnych żądań na klucz, aby chronić pule backendu. Kolejki z krótkim TTL zapobiegają piorunującym stadom, a ja dzielę się sprawiedliwie poprzez „max-in-flight“. W przypadku przeciążenia wyłączam buforowanie etapami: najpierw buforowanie odpowiedzi, następnie dławienie odczytu, a na końcu buforowanie zapisu.

Rozproszone egzekwowanie w klastrach

Ustalam limity w całym klastrze aby żadna instancja nie stała się bypassem. Używam centralnych liczników (takich jak Redis) z atomowymi przyrostami, krótkimi TTL i shardingiem według prefiksu klucza, aby uniknąć hotspotów. Łączę liczniki okien przesuwnych ze strukturami probabilistycznymi (np. liczniki Approx) dla bardzo dużych wolumenów. Przechwytuję odchylenia zegara, synchronizując czas bramek i obliczając czasy resetowania po stronie serwera. Izoluję segmenty w „komórki“: każda grupa komórek ustawia własne limity, aby awaria pozostała lokalna. Fail-closed dla krytycznych zapisów, fail-open dla niekrytycznych odczytów - dzięki temu usługa jest niezawodna.

Integracja Edge/CDN i kwoty regionalne

Zapobiegam niepotrzebnemu przechodzeniu ruchu do zaplecza, ustawiając limity na krawędzi grab: Zasady związane z POP wcześnie powstrzymują nadużycia, podczas gdy ja definiuję regionalne limity na kontynent lub kraj. Dzięki temu pobliscy użytkownicy są szybcy, nawet jeśli szczyty występują gdzie indziej. Pamięci podręczne krawędzi zmniejszają presję na punkty końcowe odczytu; żądania warunkowe (ETag/If-None-Match) zmniejszają efektywne obciążenie. W przypadku wieloregionalnych interfejsów API synchronizuję liczniki okresowo i w oparciu o tolerancje, aby opóźnienia nie eksplodowały.

Obsługa klienta: ponawianie prób, backoff i idempotencja

Sprawiam, że klienci odnoszą sukcesy bez narażania platformy: Wykładniczy backoff z Jitter zapobiega burzom synchronizacyjnym; odpowiedzi 429 zawierają jasne wskazówki i wartość „Retry-After“. W przypadku punktów końcowych zapisu wymagam kluczy idempotencji, aby ponowne próby nie zaszkodziły. Używam przykładowego ciała dla 429 konsekwentnie:

{

"error": "rate_limited",

"message": "Zbyt wiele żądań. Spróbuj ponownie po resecie lub po Retry-After.",

"limit": 120,

"remaining": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Dokumentuję, czy „Retry-After“ zawiera sekundy czy datę i ustawiam wyraźne górne limity dla całkowitej liczby ponownych prób. Dzięki temu klienci mają kontrolę, a platforma stabilny.

Integracja z bramami i load balancerami

Ograniczam szybkość tak blisko krawędzi, jak to możliwe: najpierw brama API, potem load balancer, a następnie logika aplikacji, tak aby drogi Zasoby backendu nie są spalane w pierwszej kolejności. Bramy oferują gotowe wtyczki dławiące, zarządzanie nagłówkami i scentralizowane reguły. Load balancery rozkładają obciążenia i wcześnie rozpoznają hotspoty. Sama aplikacja ustawia drobnoziarniste kontrole dla każdego punktu końcowego, w tym zapobieganie powtórkom i bardziej rygorystyczne kontrole mutacji. Przyglądając się bliżej architekturze, można zauważyć, że Hosting oparty na API Pomocny materiał do przemyśleń na temat czystych punktów egzekwowania.

Obrona przed atakami DDoS, brutalną siłą i fałszowaniem danych uwierzytelniających

Rozpoznaję wzorce DDoS na podstawie rozproszonych adresów IP, jednolitych ścieżek i szczytów bez rzeczywistej głębokości sesji i spowalniam je za pomocą twardyn na IP i podsieć. Powstrzymuję brutalną siłę podczas logowania dzięki ściśle ustawionym seriom, uzupełnianiu captcha i progresywnym opóźnieniom. Ujawniam upychanie danych uwierzytelniających poprzez znane wycieki, serie nieudanych prób i odciski palców. Jeśli progi zostaną przekroczone, blokuję tymczasowo i wymagam dodatkowej weryfikacji. Używam sygnałów dla zautomatyzowanych wrogów Zarządzanie botami, aby nie ucierpieli na tym prawdziwi użytkownicy.

Sprawiedliwość i podział na poziomy: kwoty na segment klientów

Rozkładam kwoty w przejrzysty sposób: Enterprise otrzymuje wyższe budżety, Starter mniejsze, tak aby Koszty pozostają przewidywalne i każdy ma sprawiedliwy dostęp. Przykładowe wytyczne: 5000, 1000 i 100 żądań na minutę dla wersji Enterprise, Professional i Starter. Szczególnie wrażliwe ścieżki, takie jak /auth, /billing lub /write są poniżej tej wartości, podczas gdy punkty końcowe odczytu pozostają bardziej hojne. Co miesiąc sprawdzam, czy segmenty lub limity powinny zostać dostosowane, na przykład w przypadku nowych zachowań użytkowników. W ten sposób zapewniam rozwój bez narażania jakości platformy.

Interfejsy API czasu rzeczywistego: WebSockets, SSE i streaming

Ograniczam nie tylko żądania HTTP, ale także Połączenia i szybkości przesyłania wiadomości: Maksymalna liczba jednoczesnych połączeń WebSocket na konto, wiadomości na sekundę i limity bajtów na kanał zapobiegają czatowaniu klientów. Chronię transmisje za pomocą limitów kanałów i oddzielam zdarzenia systemowe od zdarzeń użytkownika. Interwały bicia serca i limity czasu ograniczają połączenia zombie do minimum. W przypadku SSE ograniczam częstotliwość ponownych połączeń i używam partii zdarzeń przyjaznych dla pamięci podręcznej, aby wygładzić szczyty obciążenia.

Przychodzące webhooki i presja zwrotna

Zabezpieczam przychodzące webhooki z zewnętrznych usług za pomocą Buforowanie wejścia, dedykowane limity i wyłączniki. W przypadku przeciążenia, odpowiadam 429/503, w tym „Retry-After“ i akceptuję tylko podpisane, idempotentne dostawy. Izoluję przetwarzanie webhooków w kolejkach, aby uniknąć blokowania podstawowych interfejsów API i dostarczam raporty dotyczące dostaw, aby partnerzy mogli dostosować swoje strategie ponawiania prób.

Ochrona danych i zgodność z przepisami w telemetrii

Rejestruję tylko to, co jest konieczne: hashe zamiast pełnych adresów IP, krótkie Zatrzymanie dla nieprzetworzonych dzienników, wyraźne ograniczenie celu dla audytu i danych rozliczeniowych. Zdarzenia limitów stawek zawierają pseudonimizowane klucze; dokumentuję okresy przechowywania i prawa dostępu. Zapewnia to zgodność z wymogami RODO bez utraty bezpieczeństwa i przejrzystości.

Monitorowanie, alerty i plany reagowania

Monitoruję liczbę żądań, wskaźniki błędów i opóźnienia w krótkich oknach, dzięki czemu mogę wczesny rozpoznawać eskalujące wzorce. Definiuję ostrzeżenia tuż poniżej przepustowości, aby umożliwić działanie. Jeśli próg 95% spada, skaluję limity lub redystrybuuję ruch. Jeśli wskaźnik 5xx wzrasta, najpierw szukam przyczyn: wadliwych wdrożeń, hotspotów baz danych, odstających punktów końcowych. Następnie informuję klientów o stanie i rozwiązaniach, zanim zaostrzę limity.

Konfiguracja, testy i bezpieczne wdrożenia

Zarządzam zasadami jako Kod (wersjonowanie, przeglądanie, kontrole CI) i wdrażanie zmian za pomocą flag funkcji: najpierw tryb cienia (tylko pomiar), następnie wdrożenie procentowe, a na końcu pełne egzekwowanie. Testy syntetyczne sprawdzają 429 ścieżek, spójność nagłówków i logikę retry-after. Testy chaosu symulują bursts, key fanout i opóźnienia Redis, dzięki czemu działanie pozostaje stabilne nawet w stresie. Przez ograniczony czas umieszczam na białej liście niezbędnych klientów systemu (potoki kompilacji, skanery zgodności), aby zminimalizować liczbę fałszywych alarmów.

Zapobieganie obejściom: Bypass, fanout klucza i normalizacja

Zamykam luki, które atakujący mogliby wykorzystać do obejścia ograniczeń: Kluczowy fanout (tysiące jednorazowych kluczy) są ograniczone kwotami wyższego poziomu na konto, organizację i adres IP/podsieć. Normalizuję ścieżki (duże/małe litery, Unicode, trasy aliasów), aby identyczne punkty końcowe nie były liczone wielokrotnie. Koreluję sygnały (IP, ASN, odcisk palca urządzenia, sesja, pochodzenie tokena), aby szybkie rotacje IP nie prowadziły do nieskończonych budżetów. W przypadku szczególnie wrażliwych ścieżek wymagam silniejszego uwierzytelniania (zakres mTLS/OAuth).

Sprawiedliwe rozliczanie nadmiernego użytkowania

Tworzę Możliwość planowania, oferując opcjonalne modele debetu: dodatkowe kwoty, które można zarezerwować z wyprzedzeniem, automatyczne limity (miękki / twardy limit) i przejrzyste raporty miesięczne. Dzięki temu koszty pozostają pod kontrolą, a zespoły nie muszą spowalniać tymczasowych projektów. Zapewniam wczesne powiadomienia za pośrednictwem webhooków i e-maili, gdy kwoty osiągną 80/90/100% i sugeruję odpowiednie aktualizacje, zanim twarde limity zaczną obowiązywać.

Dostrajanie: testy, dzienniki i ciągła regulacja

Weryfikuję limity za pomocą testów obciążeniowych i warunków skrajnych, rejestruję 429 zdarzeń granularnie i dostosowuję je. Zasady w oparciu o rzeczywiste użycie. Minimalizuję fałszywe alarmy za pomocą białych list dla skanowania zgodności i tworzenia potoków. W przypadku interfejsów API z zapytaniami opartymi na wykresach testuję złożoność pól, aby objąć nieuczciwe zapytania. Warto przyjrzeć się GraphQL w panelu hostingowym, ponieważ limity głębokości zapytań i kosztów skutecznie uzupełniają limity szybkości. Ciągła iteracja zapewnia równowagę między ochroną a wydajnością.

Podsumowanie: ochrona, sprawiedliwość i przewidywalna wydajność

Używam ograniczania szybkości w kilku warstwach, tak aby Klienci może działać niezawodnie, a nadużycia nie mają szans. Połączenie odpowiednich algorytmów, przejrzystej komunikacji i jasnych limitów sprawia, że platforma jest responsywna. Minimalizuję ryzyko i utrzymuję kosztowne szczyty pod kontrolą dzięki monitorowaniu i testom. Rozsądne modele poziomów zapewniają sprawiedliwość i przestrzeń do rozwoju. Jeśli myślisz o limitach jak o zasadach produktu, osiągasz stabilne usługi i zadowolonych użytkowników.