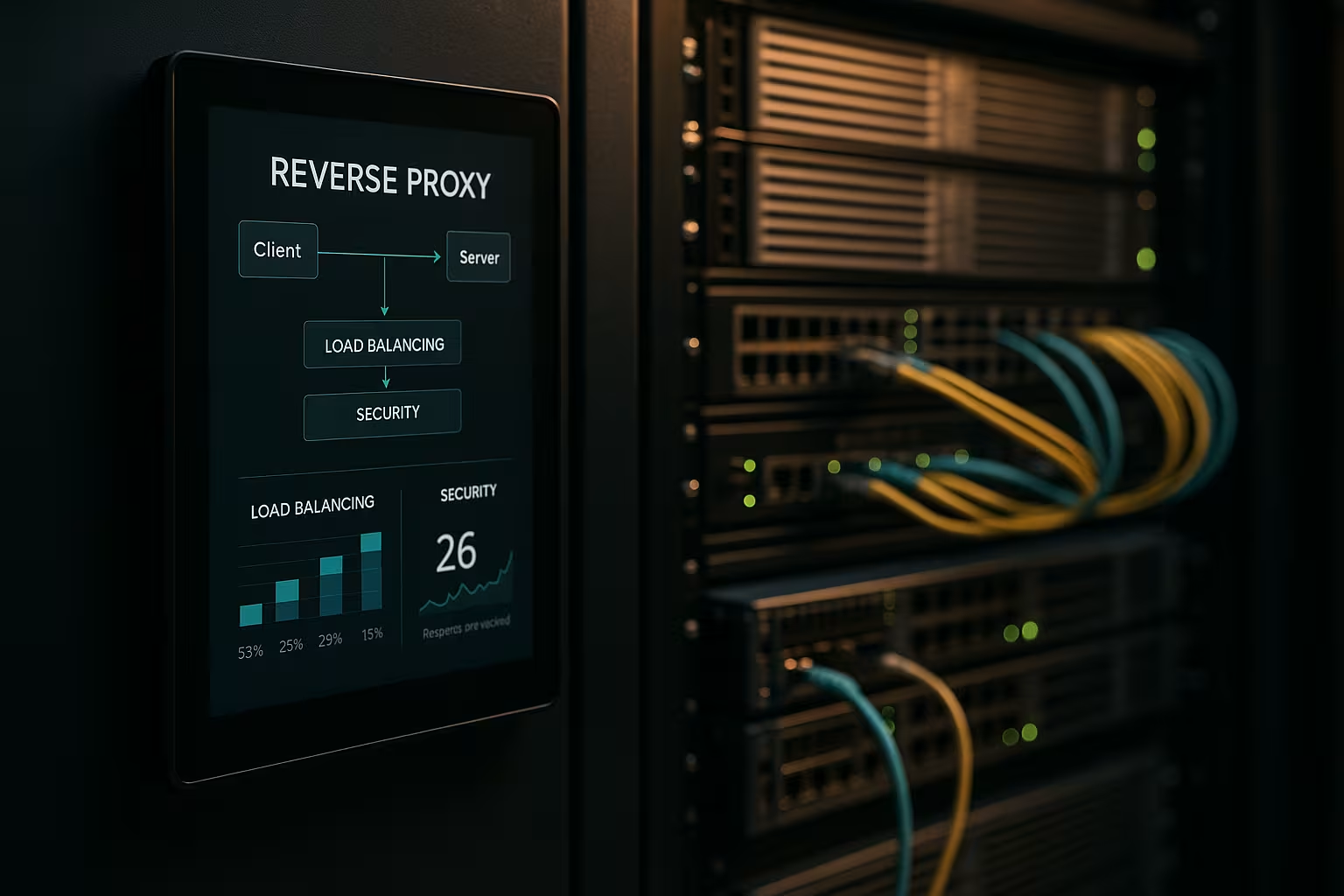

Architektura odwrotnego proxy przyspiesza żądania, chroni systemy zaplecza i skaluje aplikacje internetowe bez modyfikowania serwerów aplikacji. Pokazuję, w jaki sposób Odwrotne proxy wymiernie poprawia wydajność, bezpieczeństwo i skalowanie w codziennych operacjach.

Punkty centralne

- Wydajność poprzez buforowanie, odciążanie SSL i HTTP/2/3

- Bezpieczeństwo poprzez WAF, ochronę DDoS i blokowanie IP/geo

- Skalowanie z równoważeniem obciążenia i kontrolą kondycji

- Kontrola dzięki scentralizowanemu routingowi, rejestrowaniu i analizie

- Praktyka z NGINX, Apache, HAProxy, Traefik

Czym zajmuje się architektura reverse proxy?

Ustawiłem Odwrócony proxy przed serwerami aplikacji i zakończyć wszystkie połączenia przychodzące. W ten sposób hermetyzuję wewnętrzną strukturę, ukrywam adresy IP i minimalizuję bezpośrednie powierzchnie ataku. Serwer proxy decyduje, która usługa przejmie żądanie i może buforować zawartość. Zajmuje się TLS, kompresją i optymalizacją protokołów, takich jak HTTP/2 i HTTP/3. To znacznie zmniejsza obciążenie serwerów aplikacji i daje mi miejsce na wytyczne, oceny i szybkie zmiany.

Optymalizacja wydajności: buforowanie, odciążanie, edge

Łączę BuforowanieOdciążanie SSL i dostarczanie brzegowe w celu zmniejszenia opóźnień. Serwuję typowe zasoby, takie jak obrazy, CSS i JS z pamięci podręcznej, podczas gdy dynamiczne części pozostają świeże (np. buforowanie fragmentów). Używam zasad takich jak stale-while-revalidate i stale-if-error, aby skrócić czas oczekiwania i zapewnić dostarczanie w przypadku zakłóceń. TLS 1.3, zastępowanie HTTP/2 push poprzez wczesne podpowiedzi i kompresja Brotli zapewniają dodatkowe przyspieszenie. W przypadku użytkowników międzynarodowych proxy kieruje do pobliskich węzłów, co skraca czas do pierwszego bajtu. Spojrzenie na odpowiednie Zalety i scenariusze zastosowań pokazuje, które korekty warto wykonać w pierwszej kolejności.

Poprawa bezpieczeństwa: WAF, DDoS, geoblokowanie

Analizuję ruch na Pełnomocnik i filtruje złośliwe żądania, zanim dotrą one do systemów zaplecza. WAF rozpoznaje wzorce takie jak SQL injection lub XSS i zatrzymuje je centralnie. Zakończenie TLS umożliwia inspekcję zaszyfrowanego strumienia danych, po czym przekazuję go dalej. Obrona DDoS zależy od serwera proxy, który dystrybuuje, ogranicza lub blokuje żądania bez dotykania aplikacji. Blokowanie geograficzne i IP odcina znane źródła, podczas gdy limity szybkości i wykrywanie botów ograniczają nadużycia.

Skalowanie i wysoka dostępność z równoważeniem obciążenia

Rozkładam obciążenie poprzez Obciążenie Algorytmy równoważenia, takie jak Round Robin, Least Connections lub reguły ważone. Zabezpieczam lepkie sesje za pomocą powinowactwa plików cookie, jeśli sesje muszą pozostać związane z węzłem. Kontrola kondycji aktywnie sprawdza usługi, dzięki czemu proxy automatycznie usuwa wadliwe obiekty docelowe z puli. Skalowanie poziome działa w ciągu kilku minut: rejestracja nowych węzłów, odnowienie konfiguracji, gotowe. Aby wybrać narzędzie, wystarczy krótki Porównanie narzędzi równoważenia obciążenia z naciskiem na funkcje L7.

Scentralizowane zarządzanie i precyzyjne monitorowanie

Zbieram logi centralnie w Bramka i mierzyć kluczowe dane, takie jak czasy odpowiedzi, przepustowość, wskaźniki błędów i TTFB. Pulpity nawigacyjne pokazują hotspoty, wolne punkty końcowe i szczyty ruchu. Analizy nagłówków (np. trafienia w pamięci podręcznej, wiek) pomagają w dostrajaniu strategii pamięci podręcznej. Identyfikatory korelacji pozwalają mi śledzić żądania w różnych usługach i przyspieszać analizy przyczyn źródłowych. Ustalam standardowe wytyczne dla profili HSTS, CSP, CORS i TLS raz w proxy zamiast osobno w każdej usłudze.

Trasy, zasady i wydania bez ryzyka

Kontroluję Routing na podstawie nazwy hosta, ścieżki, nagłówków, plików cookie lub informacji geograficznych. Pozwala mi to na oddzielne kierowanie interfejsów API i frontendów, nawet jeśli działają one na tych samych portach. Wdrażam wydania Blue-Green i Canary bezpośrednio na proxy, kierując małe grupy użytkowników do nowych wersji. Nagłówki flag funkcji pomagają w kontrolowanych testach w rzeczywistym ruchu. Utrzymuję krótkie okna konserwacyjne, ponieważ przełączam trasy w ciągu kilku sekund.

Porównanie technologii w praktyce

Wybieram Narzędziektóry pasuje do obciążenia, protokołu i celów operacyjnych. NGINX zdobywa punkty dzięki statycznej zawartości, TLS, HTTP/2/3 i wydajnym funkcjom odwrotnego proxy. Apache błyszczy w środowiskach z .htaccess, rozbudowanymi modułami i starszymi stosami. HAProxy zapewnia bardzo silne równoważenie L4/L7 i precyzyjną kontrolę nad sprawdzaniem kondycji. Traefik dobrze integruje się z konfiguracjami kontenerowymi i dynamicznie odczytuje trasy z etykiet.

| Rozwiązanie | Mocne strony | Typowe zastosowania | Cechy szczególne |

|---|---|---|---|

| NGINX | Wysoki Wydajność, HTTP/2/3, TLS | Interfejsy sieciowe, API, dostarczanie statyczne | Brotli, buforowanie, odciążanie TLS, moduł strumieniowy |

| Apacz | Modułowy Elastyczność.htaccess | Starsze stosy, instalacje wykorzystujące PHP | Wiele modułów, precyzyjna obsługa dostępu |

| HAProxy | Wydajność Równoważenie, Kontrole stanu zdrowia | Równoważenie obciążenia L4/L7, brama | Bardzo szczegółowe, zaawansowane listy ACL |

| Traefik | Dynamiczny Odkrycie, Koncentracja na pojemniku | Kubernetes, Docker, mikrousługi | Automatyczna konfiguracja, integracja z LetsEncrypt |

Etapy wdrażania i lista kontrolna

Zaczynam od CelePriorytetem jest wydajność, bezpieczeństwo, dostępność i budżet. Następnie definiuję protokoły, certyfikaty, zestawy szyfrów i wersje protokołów. Jasno definiuję i wersjonuję reguły routingu, zasady buforowania i limity. Przed uruchomieniem konfiguruję kontrole kondycji, obserwowalność i alerty. Jeśli chcesz zacząć od razu, możesz znaleźć przegląd instrukcji na stronie Konfiguracja odwrotnego serwera proxy dla Apache i NGINX.

Najlepsze praktyki w zakresie dostrajania wydajności

Aktywuję HTTP/3 z QUIC tam, gdzie klienci go obsługują i utrzymują gotowość HTTP/2 dla szerokiej kompatybilności. Używam Brotli dla zasobów tekstowych i wydajnie kompresuję obrazy przez proxy. Celowo definiuję klucze pamięci podręcznej, aby kontrolować zmiany za pomocą plików cookie lub nagłówków. Minimalizuję czas uzgadniania TLS, używam wznawiania sesji i ustawiam zszywanie OCSP. Używam wczesnych wskazówek (103), aby dać przeglądarce wcześniejsze sygnały dla krytycznych zasobów.

Konfiguracja bezpieczeństwa bez strat tarcia

Trzymam Certyfikaty centralnie i zautomatyzować odnawianie za pomocą ACME. HSTS wymusza HTTPS, podczas gdy CSP i CORP kontrolują zawartość. Zaczynam bazę reguł WAF konserwatywnie i stopniowo ją zaostrzam, aby uniknąć fałszywych alarmów. Limity stawek, mTLS dla usług wewnętrznych i listy IP zmniejszają ryzyko na co dzień. Dzienniki audytu pozostają odporne na manipulacje, dzięki czemu mogę śledzić incydenty z pewnością prawną.

Koszty, obsługa i zwrot z inwestycji

Planuję Budżet za zasoby serwera, certyfikaty, ochronę DDoS i monitorowanie. Małe konfiguracje często zaczynają się od kilku wirtualnych rdzeni i 4-8 GB pamięci RAM dla serwera proxy, co w zależności od dostawcy mieści się w niskim dwucyfrowym przedziale euro miesięcznie. Większe floty wykorzystują dedykowane instancje, anycast i węzły globalne, co może oznaczać trzycyfrowe koszty w euro na lokalizację. Scentralizowane zarządzanie oszczędza czas: mniej indywidualnych konfiguracji, szybsze procesy wydawania i krótsze przestoje. Zwrot z inwestycji znajduje odzwierciedlenie w wyższej konwersji, niższych współczynnikach odrzuceń i bardziej produktywnej inżynierii.

Warianty architektury i topologie

Wybieram architekturę dopasowaną do profilu ryzyka i opóźnień. Proste środowiska działają dobrze z pojedynczym Bramka w DMZ, który przekazuje żądania do usług wewnętrznych. W środowiskach regulowanych lub dużych rozdzielam frontend i backend proxy na dwa etapy: etap 1 kończy ruch internetowy i obsługuje WAF, DDoS i buforowanie, etap 2 trasuje wewnętrznie, mówi mTLS i egzekwuje zasady zerowego zaufania. Aktywne/aktywne konfiguracje z anycast IP i globalnie rozproszonymi węzłami skracają czas przełączania awaryjnego i optymalizują bliskość użytkownika. W przypadku sieci CDN przed odwrotnym proxy zapewniam prawidłowe przekazywanie nagłówków (np. X-Forwarded-Proto, Real-IP) i zharmonizowane hierarchie pamięci podręcznej, aby pamięć podręczna krawędzi i bramy nie blokowały się nawzajem. Enkapsuluję scenariusze z wieloma dzierżawcami przy użyciu SNI/TLS, oddzielnych tras i izolowanych limitów szybkości, aby uniknąć efektów sąsiedztwa.

Protokoły i przypadki specjalne: WebSockets, gRPC i HTTP/3

Rozważam protokoły ze specjalnymi wymaganiami, aby funkcje pozostały stabilne. Dla WebSockets Aktywuję obsługę aktualizacji i długotrwałe połączenia z odpowiednimi limitami czasu. gRPC korzysta z HTTP/2 i czystych nagłówków; unikam H2C (zwykły tekst HTTP/2) na obwodzie na korzyść TLS z poprawnym ALPN. Dla HTTP/3 Zapewniam porty QUIC (UDP) i restrykcyjnie udostępniam tylko 0-RTT, ponieważ powtórki niosą ze sobą ryzyko. Strumieniowe punkty końcowe, zdarzenia wysyłane przez serwer i przesyłanie dużych plików mają własne zasady buforowania i rozmiaru ciała, aby serwer proxy nie stał się wąskim gardłem. W przypadku translacji protokołów (np. HTTP/2 na zewnątrz, HTTP/1.1 wewnątrz) dokładnie testuję normalizację nagłówków, kompresję i ponowne wykorzystanie połączenia, aby utrzymać niskie opóźnienia i przewidywalne zużycie zasobów.

Uwierzytelnianie i autoryzacja w bramie

Przenoszę się Auth-decyzje do odwrotnego serwera proxy, jeśli pozwala na to architektura i zgodność. Integruję OIDC/OAuth2 poprzez weryfikację tokenów w bramie: serwer proxy weryfikuje podpisy (JWKS), sprawdza wygaśnięcie, odbiorców i zakresy oraz ustawia zweryfikowane roszczenia jako nagłówki dla usług. Używam kluczy API dla punktów końcowych machine-to-machine i ograniczam je według trasy. W przypadku systemów wewnętrznych polegam na mTLS z wzajemną weryfikacją certyfikatów, aby zaufanie było wyraźne. Dbam o to, aby niepotrzebnie nie rejestrować wrażliwych nagłówków (autoryzacja, pliki cookie) i korzystam z list zezwoleń / odmów dla każdej trasy. Formułuję szczegółowe zasady za pomocą list ACL lub wyrażeń (np. ścieżka + metoda + roszczenie), co pozwala mi centralnie kontrolować dostęp bez zmiany kodu aplikacji.

Odporność: timeouty, próby, backoff i przerwanie obwodu

Definiuję Limity czasu świadomy na hop: ustanowienie połączenia, limit czasu nagłówka i limit czasu odpowiedzi. Aktywuję ponowienia tylko dla metod idempotentnych i łączę je z wykładniczym backoffem plus jitterem, aby uniknąć piorunujących stad. Wyłączniki chronią pule backendu: Jeśli proxy wykryje błędy lub skoki opóźnień, tymczasowo otwiera obwód, przekazuje tylko losowo do dotkniętego miejsca docelowego, a poza tym odpowiada wcześnie, opcjonalnie z rezerwą z pamięci podręcznej. Wykrywanie wartości odstających automatycznie usuwa "słabe" instancje z puli. Ograniczam również jednoczesne przesyłanie w górę, aktywuję ponowne wykorzystanie połączeń i korzystam z kolejek z uczciwą priorytetyzacją. Gwarantuje to, że usługi pozostaną stabilne, nawet jeśli poszczególne komponenty znajdą się pod presją.

Zgodność z przepisami, ochrona danych i ochrona informacji osobistych

Traktuję proxy jako Centrum danych z jasnymi zasadami ochrony danych. Maskuję lub pseudonimizuję dane osobowe w dziennikach; ciągi zapytań i poufne nagłówki są rejestrowane tylko na podstawie białej listy. Tam, gdzie to możliwe, skracam adresy IP i przestrzegam ścisłych okresów przechowywania. Dostęp do dzienników i metryk jest oparty na rolach, a zmiany są dokumentowane w sposób umożliwiający audyt. Na potrzeby audytów łączę zdarzenia bramy z wpisami zarządzania zmianami, dzięki czemu można śledzić zatwierdzenia i aktualizacje reguł. Pozwala mi to spełnić wymogi zgodności bez poświęcania dogłębnego wglądu w wydajność i bezpieczeństwo.

Kubernetes, interfejs API Ingress i Gateway

Płynnie integruję odwrotne proxy z Orkiestracja kontenerów. W Kubernetes używam kontrolerów ingress lub bardziej nowoczesnego API bramy do deklaratywnego opisywania routingu, TLS i polityk. Traefik dynamicznie odczytuje etykiety, NGINX/HAProxy oferują zaawansowane warianty ingress dla wysokiej przepustowości. Oddzielam wewnętrzny routing klastra wschód/zachód (siatka usług) od bramy obwodowej północ/południe, aby obowiązki pozostały jasne. Wdrażam wydania kanaryjskie z ważonymi trasami lub dopasowaniami nagłówków, jednocześnie ściśle definiując kontrole kondycji i gotowość podów, aby uniknąć flappingu. Wersjonuję konfiguracje jako kod i testuję je w klastrach przejściowych z symulacją obciążenia przed uruchomieniem.

Dojrzałość operacyjna: zarządzanie konfiguracją i CI/CD

Konfigurację proxy traktuję jako Kod. Zmiany są uruchamiane za pośrednictwem pull requestów, automatycznie testowane (składnia, linting, kontrole bezpieczeństwa) i wdrażane w potokach. Używam podglądu lub ruchu w tle, aby zweryfikować nowe trasy w rzeczywistych warunkach bez ryzykowania transakcji z klientami. Cofnięcia są możliwe w ciągu kilku sekund, ponieważ oznaczam wersje i wdrażam je atomowo. Wrażliwymi sekretami (certyfikatami, kluczami) zarządzam oddzielnie, w sposób zaszyfrowany i z minimalnymi uprawnieniami. Aby zapewnić wysoką dostępność, dystrybuuję wersje do węzłów w sposób rozłożony w czasie i rejestruję efekty w pulpitach nawigacyjnych, dzięki czemu mogę szybko podjąć środki zaradcze w przypadku regresji.

Typowe przeszkody i przeciwwskazania

Unikam Źródła błędówktóre często występują w praktyce. Zapobiegam zatruwaniu pamięci podręcznej dzięki ścisłej normalizacji nagłówków i czystemu zarządzaniu Vary; wykluczam pliki cookie, które nie wpływają na renderowanie, z klucza pamięci podręcznej. Wcześnie rozpoznaję pętle przekierowań, testując z X-Forwarded-Proto/Host i spójnymi politykami HSTS/CSP. "Zaufaj wszystkim X-Forwarded-For" to tabu: ufam tylko następnemu hopowi i czysto ustawiam Real-IP. Kontroluję przesyłanie dużych plików za pomocą limitów i streamingu, aby proxy nie buforowało, co backend może zrobić lepiej. Przy 0-RTT w TLS 1.3 zwracam uwagę na idempotencję. Zwracam też uwagę na rozmiary treści i nagłówków, aby pojedyncze żądania nie zajmowały całej przepustowości pracownika.

Podsumowanie dla szybkich decyzji

Stawiam na Odwrócony proxy, ponieważ łączy szybkość, ochronę i skalowanie w jednym miejscu. Buforowanie, odciążanie TLS i HTTP/2/3 znacznie przyspieszają rzeczywiste czasy ładowania. WAF, ochrona DDoS i kontrola IP/geo zauważalnie zmniejszają ryzyko. Równoważenie obciążenia, kontrole kondycji i kroczące wersje zapewniają dostępność usług, nawet podczas wzrostu. Dzięki NGINX, Apache, HAProxy lub Traefik znajduję jasne rozwiązanie dla każdej konfiguracji i zapewniam łatwość zarządzania operacjami.