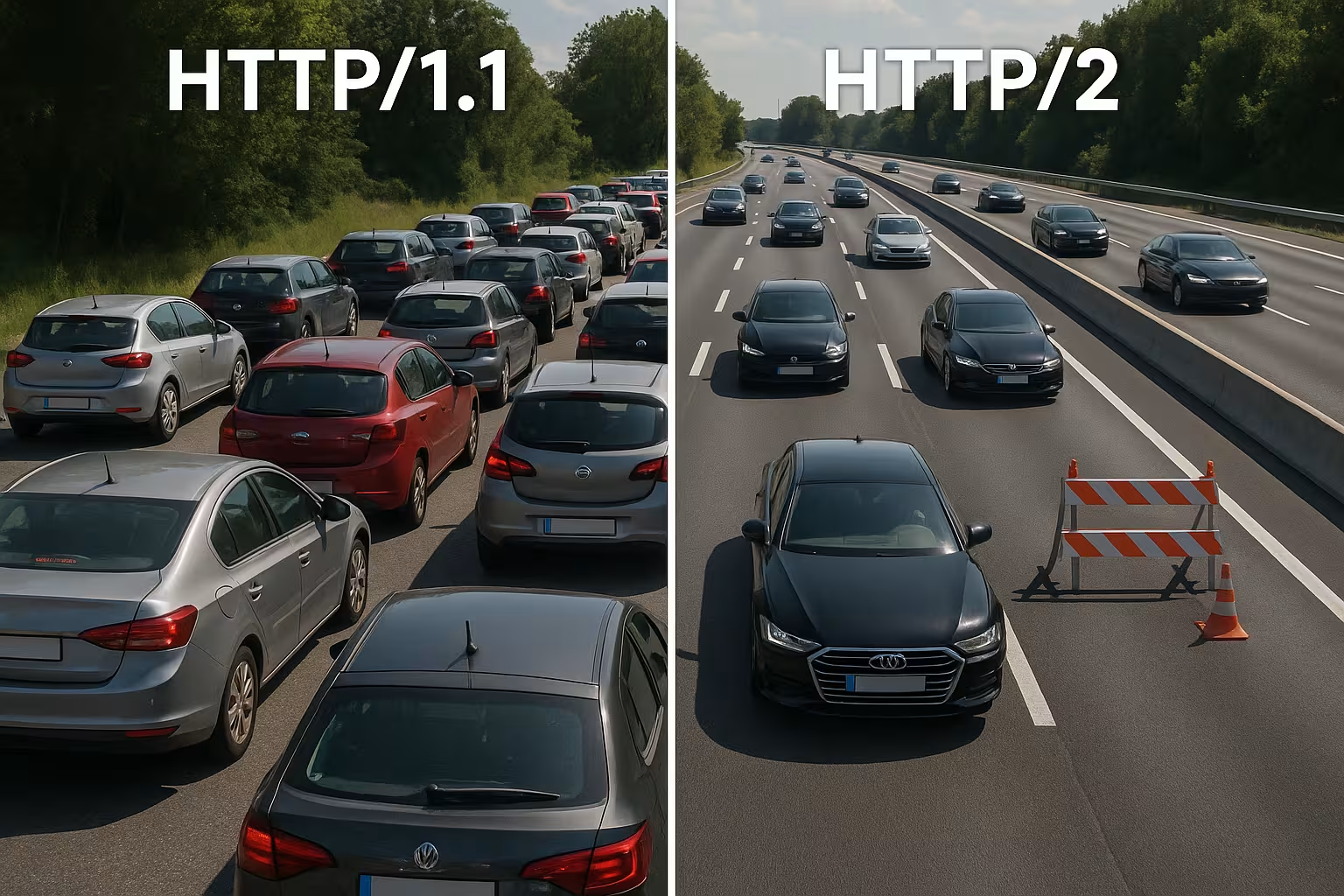

Multipleksowanie HTTP/2 łączy wiele żądań w jedno połączenie i usuwa blokady na poziomie protokołu. Jednak w rzeczywistych sieciach TCP Head-of-Line, TLS Overhead i niewłaściwe ustalanie priorytetów spowalniają działanie, więc HTTP/2 nie działa automatycznie szybciej niż HTTP/1.1.

Punkty centralne

- Multipleksowanie równolegle przetwarza wiele żądań za pośrednictwem pojedynczego połączenia TCP.

- TCP-HoL pozostaje aktywny i zatrzymuje wszystkie strumienie w przypadku strat.

- Konfiguracja TLS może znacznie opóźnić czas do pierwszego bajtu.

- Priorytety Funkcje „server push” i „server push” działają tylko przy prawidłowym dostrojeniu.

- Typ strony decyduje: wiele małych plików kontra kilka dużych plików.

Jak działa wewnętrznie multipleksowanie HTTP/2

Rozkładam każdą odpowiedź na małe części. Ramki, numeruję je i przypisuję do logicznych strumieni, aby wiele zasobów mogło działać jednocześnie za pośrednictwem jednego połączenia. W ten sposób unikam blokad na poziomie HTTP, ponieważ żadne żądanie nie musi już czekać na zakończenie innego. Przeglądarki wysyłają HTML, CSS, JS, obrazy i czcionki równolegle, zmniejszając koszty dodatkowych połączeń. Dzięki HPACK nagłówki ulegają zmniejszeniu, co znacznie zmniejsza obciążenie w przypadku wielu małych plików. Decydujące znaczenie ma jednak to, że wszystkie strumienie dzielą tę samą linię TCP, co stwarza korzyści, ale także powoduje nowe zależności. Architektura ta zapewnia szybkość, o ile sieć pozostaje stabilna, a Ustalanie priorytetów pracuje sensownie.

HTTP/1.1 a HTTP/2: podstawowe różnice

HTTP/1.1 opiera się na wiadomościach tekstowych i wielu równoległych połączeniach na host, aby jednocześnie ładować zasoby, co zwiększa liczbę uzgodnień i obciążenie. HTTP/2 działa w trybie binarnym, wykorzystuje jedno połączenie do wszystkiego i kompresuje nagłówki, co skraca czas oczekiwania, zwłaszcza w przypadku wielu obiektów. W diagramach kaskadowych znikają długie kolejki, ponieważ strumienie przebiegają równolegle. W zamian za to wąskie gardło przenosi się z warstwy HTTP do warstwy TCP, co wyraźnie odczuwam w przypadku niestabilnych sieci. Małe, silnie buforowane strony często nie odnotowują prawie żadnych korzyści w porównaniu z wersją 1.1, podczas gdy duże strony bogate w zasoby odnoszą bardziej widoczne korzyści. Te różnice kształtują moje Strategia tuningu i uzasadniają decyzję dotyczącą konkretnego projektu.

Właściwy wybór kontroli przepływu i rozmiarów okien

HTTP/2 zapewnia własną kontrolę przepływu dla każdego strumienia i każdego połączenia. Zwracam uwagę na sensowne wartości dla INITIAL_WINDOW_SIZE i liczbę jednoczesnych strumieni, aby linia nie była ani przeciążona, ani niewykorzystana. Zbyt małe okna generują niepotrzebnie wiele WINDOW_UPDATEramki i ograniczają szybkość transmisji danych, zbyt duże okna mogą przeciążać słabsze klienty. W sieciach o wysokim produkcie opóźnienia przepustowości (BDP) celowo zwiększam rozmiar okna, aby duże odpowiedzi nie utknęły w trybie „stop-and-go”. Jednocześnie ograniczam MAX_CONCURRENT_STREAMS Pragmatyczne: wystarczająca równoległość dla elementów krytycznych dla renderowania, ale nie na tyle duża, aby drobne elementy spowalniały obraz LCP. Te śruby regulacyjne są niewielkie, ale mają duży wpływ na rzeczywisty czas ładowania, jeśli są dostosowane do strony i sieci.

Ponowna ocena fragmentacji domen i pakietowania

Wiele optymalizacji 1.1 jest nieefektywnych w przypadku HTTP/2. Rezygnuję ze starego podziału domen, ponieważ pojedyncze, dobrze wykorzystane połączenie jest bardziej wydajne niż sztucznie rozdzielone gniazda. Kwestionuję również agregowanie JavaScript do mega plików: mniejsze, logicznie oddzielone pakiety pozwalają na ukierunkowane buforowanie i unikają konieczności ponownego przesyłania całej aplikacji w przypadku zmiany. Sprite'y obrazów tracą na znaczeniu, ponieważ równoległe żądania stały się tanie, a nowoczesne formaty obrazów wraz z buforowaniem działają lepiej. Dlatego eliminuję miejsca, w których multipleksowanie może przynieść korzyści, i łączę tylko wtedy, gdy naprawdę upraszcza to architekturę lub wymiernie zwiększa współczynnik trafień buforowania.

Łączenie i certyfikaty

HTTP/2 pozwala przeglądarkom na używanie jednego połączenia dla wielu nazw hostów, jeśli certyfikaty i DNS są zgodne. Planuję wpisy SAN i SNI tak, aby umożliwić łączenie i wyeliminować dodatkowe uzgodnienia. Jeśli ALPN i zestawy szyfrów są zgodne, klient może używać CSS z cdn.example.com i zdjęcia z static.example.com za pośrednictwem tej samej linii. Pozwala to zaoszczędzić RTT, ułatwia ustalanie priorytetów i zwiększa szansę, że krytyczne zasoby dotrą bez zbędnych opóźnień. Sprawdzam te efekty w zakładce sieciowej: czy naprawdę używane jest tylko jedno gniazdo, czy też ograniczenia certyfikatów i zasady zmuszają przeglądarkę do nawiązywania nowych połączeń?

Dlaczego multipleksowanie jest spowalniane: TCP Head-of-Line

Jeśli w jedynym połączeniu TCP utraci się pakiet, cała linia czeka na nadejście retransmisji, co powoduje krótkotrwałe zatrzymanie wszystkich strumieni HTTP/2. W sieciach komórkowych o zmiennym opóźnieniu i zwiększonej liczbie utraconych pakietów regularnie obserwuję mniejsze korzyści lub nawet wady w porównaniu z wieloma połączeniami 1.1. Efekt ten wyjaśnia, dlaczego multipleksowanie wygląda świetnie na papierze, ale w praktyce nie zawsze się sprawdza. Pomiary z badań i terenowe pokazują dokładnie tę zależność w rzeczywistych sieciach [6]. Dlatego planuję wdrożenia konserwatywnie, testuję typowe ścieżki użytkowników i sprawdzam wpływ na każdą grupę docelową. Kto ignoruje TCP-HoL, traci Wydajność i może nawet wydłużyć czas ładowania.

Uścisk dłoni TLS, TTFB i typ strony

HTTP/2 działa w sieci prawie wyłącznie przez TLS, co powoduje dodatkowe uzgodnienia i może znacznie wydłużyć czas oczekiwania na pierwszy bajt w przypadku niewielkiej liczby zasobów. Jeśli dostarczam tylko jeden duży plik, korzyść wynikająca z multipleksowania znika, ponieważ nie jest konieczna równoległa transmisja. Strony zawierające od dziesięciu do dwudziestu małych plików odnoszą większe korzyści, podczas gdy odpowiedzi zawierające pojedyncze zasoby często są na równi z HTTP/1.1. Skracam obciążenie dzięki TLS 1.3, wznowieniu sesji i czystemu Keep-Alive, dzięki czemu nie ma potrzeby ponownego łączenia się, a jedno łącze naprawdę działa. Do precyzyjnego sterowania stawiam na Optymalizacja Keep-Alive, aby dostosować ponowne wykorzystanie, limity czasu bezczynności i limity do obciążenia. W ten sposób zmniejsza się udział handshake'ów, a TTFB stabilizuje się nawet podczas szczytów ruchu.

Łańcuchy CDN i proxy: h2 do źródła

Wiele stosów kończy TLS na krawędzi i komunikuje się dalej z źródłem. Sprawdzam, czy między CDN a backendem również używany jest protokół HTTP/2, czy też następuje powrót do protokołu HTTP/1.1. Buforujące serwery proxy mogą częściowo zniwelować zalety (kompresja nagłówków, priorytetyzacja), jeśli ponownie serializują odpowiedzi lub zmieniają kolejność. Dlatego optymalizuję całość: węzeł brzegowy, proxy pośredniczące i źródło powinny rozumieć h2, stosować odpowiednie rozmiary okien i nie ignorować priorytetów. Tam, gdzie h2c (HTTP/2 bez TLS w sieci wewnętrznej) ma sens, sprawdzam, czy pozwala to zaoszczędzić opóźnienia i moc procesora bez naruszania zasad bezpieczeństwa. Tylko spójny łańcuch pozwala w pełni wykorzystać potencjał MultipleksowanieEfekt całkowicie.

Właściwe stosowanie priorytetów

Nadaję wysoki priorytet krytycznym zasobom, aby HTML, CSS i obraz LCP były wyświetlane jako pierwsze, a blokady renderowania zostały usunięte. Bez jasnych priorytetów mniej ważne skrypty pochłaniają cenną przepustowość, podczas gdy treści powyżej linii zgięcia czekają. Nie każdy serwer prawidłowo uwzględnia priorytety przeglądarki, a niektóre serwery proxy zmieniają kolejność, dlatego analizuję dane wynikowe, a nie pobożne życzenia [8]. Nagłówki preload i wcześnie umieszczone odniesienia do obrazów skracają ścieżki ładowania i zwiększają współczynnik trafień w pamięci podręcznej. Priorytetyzacja nie jest magicznym rozwiązaniem, ale kieruje połączeniem w taki sposób, że użytkownicy szybko widzą to, czego potrzebują. Przejrzyste zasady przynoszą zauważalne korzyści. Ciąg i sprawiają, że multipleksowanie jest naprawdę skuteczne.

Priorytetyzacja w praktyce: priorytety rozszerzalne

Przeglądarki rozwinęły swoje modele priorytetów. Biorę pod uwagę, że nowoczesne klienty często używają „rozszerzalnych priorytetów“ zamiast sztywnych wag drzewa. Sygnalizują one pilność i parametry progresywne dla każdego strumienia, które serwery muszą interpretować i przekładać na sprawiedliwe harmonogramy. Sprawdzam, czy mój serwer respektuje te sygnały, czy też opiera się na starym zachowaniu. W testach A/B porównuję ścieżki ładowania z priorytetami po stronie serwera i bez nich, aby wykryć efekty wypierania. Ważne: priorytetyzacja powinna faworyzować elementy krytyczne dla renderowania, ale nie może prowadzić do głodzenia długotrwałych pobrań. Ostrożna mieszanka pozwala uniknąć szczytów i utrzymuje przepływ danych dla widocznych treści.

Server Push: rzadko używany skrót

Używam funkcji Server Push tylko w określonych przypadkach, ponieważ nadmierne wykorzystanie tej funkcji zajmuje przepustowość i ignoruje pamięć podręczną przeglądarki. Jeśli zasób, który został już zapisany w pamięci podręcznej, jest ponownie przesyłany, ścieżka staje się wolniejsza zamiast szybsza. Wiele zespołów wyłączyło funkcję Push i korzysta z funkcji Preload, która jest znacznie bardziej niezawodna [8]. W szczególnych przypadkach, na przykład na powtarzających się trasach o wyraźnych wzorcach, funkcja push może być przydatna, ale potwierdzam ten efekt za pomocą pomiarów. Bez dowodów usuwam funkcję push i utrzymuję przepływ danych wolny dla naprawdę potrzebnych danych. W tym przypadku mniej często oznacza więcej. więcej, właśnie na jedynym połączeniu.

Porównanie praktyczne: kiedy protokół HTTP/1.1 może być szybszy

Uważam, że protokół HTTP/1.1 jest konkurencyjny, gdy dominują nieliczne, duże pliki lub gdy sieci działają z większymi stratami. Wiele oddzielnych połączeń rozkłada wówczas ryzyko i może skrócić czas pierwszego bajtu. W przypadku bardzo małych stron dodatkowe uzgodnienia TLS często całkowicie kompensują korzyści wynikające z multipleksowania. W przypadku wielu małych obiektów przewagę ma natomiast HTTP/2, ponieważ działa kompresja, priorytetyzacja i pojedynczy socket. Poniższy przegląd przedstawia typowe wzorce z audytów i testów terenowych, które kierują moim wyborem protokołu [6][8]. Ta siatka nie zastępuje testów, ale zapewnia solidną podstawę. Orientacja do podjęcia wstępnych decyzji.

| Scenariusz | Lepszy protokół | Powód |

|---|---|---|

| Wiele małych zasobów (CSS/JS/obrazy/czcionki) | HTTP/2 | Multipleksowanie i HPACK zmniejszają obciążenie, wystarczy jedno połączenie |

| Niewiele bardzo dużych plików | HTTP/1.1 ≈ HTTP/2 | Równoległość prawie nie jest potrzebna; koszty uzgodnień mają większe znaczenie |

| Niestabilne sieci komórkowe z utratami | HTTP/1.1 częściowo lepszy | TCP‑HoL zatrzymuje wszystkie strumienie w HTTP/2; pomocne może być użycie wielu gniazd |

| Zoptymalizowany protokół TLS (1.3, wznowienie), przejrzyste priorytety | HTTP/2 | Mniejsze wymagania konfiguracyjne, ukierunkowane zarządzanie przepustowością |

| Aktywne naciskanie | HTTP/1.1/HTTP/2 bez funkcji push | Niepotrzebne dane blokują łącze; Preload jest bezpieczniejszy |

Najlepsze praktyki pozwalające uzyskać rzeczywisty wzrost szybkości ładowania stron

Zmniejszam liczbę bajtów przed protokołem: obrazy w formacie WebP/AVIF, odpowiednie rozmiary, oszczędne skrypty i czyste nagłówki buforowania. Krytyczne części ścieżki CSS utrzymuję na niskim poziomie, czcionki ładuję wcześnie i ustawiam rozwiązania awaryjne, aby uniknąć zmian układu. Do nawiązywania połączeń i DNS używam Preconnect i DNS‑Prefetch, aby uzgodnienia rozpoczęły się przed dotarciem parsera do zasobu. Brotli dla treści tekstowych przyspiesza powtarzające się wywołania, zwłaszcza przez CDN. Sprawdzam efekty w wodospadzie i porównuję LCP, FID i TTFB przed i po zmianach. Wartości pomiarowe kierują moimi Priorytety, przeczucie nie.

gRPC, SSE i przypadki strumieniowania

HTTP/2 szczególnie dobrze sprawdza się w przypadku gRPC i innych strumieni dwukierunkowych lub długotrwałych. Zwracam uwagę na limity czasu, rozmiary buforów i reguły cofania, aby zacinający się strumień nie wpływał negatywnie na wszystkie inne żądania. W przypadku zdarzeń wysyłanych przez serwer i transmisji na żywo pomocne jest stabilne, trwałe połączenie, o ile serwer prawidłowo zarządza priorytetami, a limity Keep-Alive nie są stosowane zbyt wcześnie. Jednocześnie testuję, jak zachowują się przypadki błędów: odbudowa strumieni, wykładnicze wycofywanie i sensowne ograniczenia ponownego łączenia zapobiegają szczytom obciążenia, gdy wielu klientów jednocześnie przerywa połączenie i ponownie się łączy. Dzięki temu scenariusze czasu rzeczywistego pozostają przewidywalne.

Optymalizacja systemu operacyjnego i protokołu TCP zapewniająca stabilną wydajność multipleksowania

Wybór protokołu nie maskuje słabej konfiguracji sieci. Sprawdzam algorytmy kontroli przeciążenia (np. BBR vs. CUBIC), bufory gniazd, zasady szybkiego otwierania TCP i rozmiar początkowego okna przeciążenia. Kontrola przeciążenia dostosowana do ścieżki może zmniejszyć liczbę retransmisji i złagodzić efekty HoL. Równie ważne są prawidłowe wartości MTU/MSS, aby zapobiec fragmentacji i możliwym do uniknięcia stratom. Na poziomie TLS preferuję krótkie łańcuchy certyfikatów, OCSP-Stapling i certyfikaty ECDSA, ponieważ przyspieszają one uzgadnianie połączenia. Połączenie tych ustawień zapewnia multipleksowaniu niezbędną Konstrukcja nośna, aby priorytetyzacja i kompresja nagłówków mogły przynieść oczekiwane efekty.

Strategia pomiarowa i wskaźniki KPI w codziennej praktyce

Nie polegam na wartościach medianowych, ale patrzę na p75/p95 wskaźników, w podziale na urządzenie, typ sieci i lokalizację. Testy syntetyczne dostarczają powtarzalne wartości bazowe, a monitorowanie rzeczywistych użytkowników pokazuje rozrzut w terenie. Porównuję wodospady kluczowych ścieżek, sprawdzam wczesne bajty HTML, kolejność CSS/JS i czas przybycia obrazu LCP. Wprowadzam zmiany w formie kontrolowanych eksperymentów i obserwuję równolegle TTFB, LCP i wskaźniki błędów. Ważne: priorytetyzację bez wymiernych korzyści usuwam. Dzięki temu konfiguracja pozostaje prosta, a ja inwestuję w elementy, które statystycznie zapewniają oszczędność czasu.

Ruch indeksujący i ruch botów

Oprócz użytkowników, z czystego protokołu HTTP/2 korzystają również roboty indeksujące. Aktywuję h2 dla odpowiednich punktów końcowych i obserwuję, czy boty ponownie wykorzystują połączenie i pobierają więcej stron w tym samym czasie. Niepotrzebne kaskady 301, nieskompresowane odpowiedzi lub zbyt krótkie limity Keep-Alive kosztują budżet indeksowania. Dostosowuję zasady, aby multipleksowanie działało również w tym przypadku, bez przekraczania limitów zaplecza. Rezultat: bardziej wydajne skanowanie i większa stabilność pod obciążeniem.

HTTP/2, HTTP/3 i co będzie miało znaczenie w przyszłości

HTTP/3 opiera się na protokole QUIC przez UDP i rozwiązuje problem blokowania TCP Head-of-Line, co jest szczególnie pomocne w przypadku mobilności i utraty danych [6]. Nawiązanie połączenia trwa krócej, a blokady strumienia nie dotyczą już wszystkich żądań jednocześnie. W flotach mieszanych HTTP/2 pozostaje ważny, ale aktywuję HTTP/3 tam, gdzie klienci i CDN już go obsługują. Szczegółowe porównania, takie jak HTTP/3 vs. HTTP/2 Pomagają mi planować wdrożenia etapami i dostosowane do grup docelowych. Dokonuję pomiarów oddzielnie dla lokalizacji, urządzenia i typu sieci, aby prawdziwi użytkownicy mogli czerpać korzyści. W ten sposób wykorzystuję protokoły, aby Czasy ładowania w codziennych sytuacjach.

Hosting i infrastruktura jako czynniki przyspieszające

Dobre protokoły nie uratują słabej infrastruktury, dlatego dokładnie sprawdzam lokalizację, peering, procesor, pamięć RAM i limity wejścia/wyjścia. Nowoczesny serwer internetowy, rozsądna liczba pracowników i warstwa pamięci podręcznej zapobiegają sytuacji, w której jedyne połączenie kończy się wąskim gardłem. Strategiczne wykorzystanie CDN skraca RTT i łagodzi szczyty obciążenia. Kto obsługuje użytkowników w całej Europie, często bardziej korzysta z krótkich odległości niż z precyzyjnego dostrajania protokołów. Planuję pojemność z rezerwami, aby ruch impulsowy nie spowodował awarii. W ten sposób multipleksowanie rozwija swoje możliwości. Potencjał niezawodny.

Szybkie rozpoznawanie wzorców błędów

Jeśli HTTP/2 działa wolniej niż oczekiwano, szukam typowych wzorców: pojedynczej długiej transmisji, która blokuje wiele mniejszych; ignorowanych priorytetów; wysokich wskaźników retransmisji na trasach mobilnych; lub nieaktywnej funkcji wznowienia TLS. Następnie porównuję HTTP/2 i HTTP/1.1 w identycznych warunkach, oddzielam wpływ CDN od źródła i sprawdzam liczbę gniazd, rzeczywistą liczbę strumieni oraz kolejność pierwszych kilobajtów. Jeśli znajdę wąskie gardło, najpierw dostosowuję podstawy (bajty, buforowanie, uzgodnienia), a dopiero potem pracuję nad kontrolą przepływu lub priorytetami. Taka kolejność zapewnia najbardziej niezawodne ulepszenia.

Praktyczne podsumowanie umożliwiające szybkie podejmowanie decyzji

Korzystam z multipleksowania HTTP/2, gdy występuje wiele obiektów, obowiązują priorytety i TLS jest poprawnie skonfigurowany. W przypadku niewielkiej liczby dużych plików lub niestabilnych sieci uwzględniam niewielkie korzyści i zwracam uwagę na wyniki 1.1. Używam serwera push tylko wtedy, gdy mam na to dowody, prawie zawsze używam preload i ograniczam obciążenie poprzez kompresję, buforowanie i wczesne połączenia. Pomiary przeprowadzone na rzeczywistych urządzeniach i w rzeczywistych lokalizacjach potwierdzają moje założenia, zanim wprowadzę zmiany na szeroką skalę [6][8]. Ostatecznie nie liczy się numer protokołu, ale odczuwalna prędkość dla prawdziwych użytkowników. Kto postępuje w ten sposób, może niezawodnie korzystać z HTTP/2. Prędkość i stanowi podstawę dla HTTP/3.