Porównuję HTTP/3 Push i Preload na podstawie rzeczywistych zmierzonych wartości i wyjaśniam, która technologia jest najbardziej wydajna. Wydajność http3 zauważalnie do przodu. Aby to zrobić, przeanalizowałem zalety QUIC, priorytety ładowania i typowe błędy implementacji, które wpływają na First Paint i the Renderowanie hamulce.

Punkty centralne

Podsumowuję następujące kluczowe punkty, abyś mógł szybko dokonać wyboru między push a preload. kategoryzować może.

- HTTP/3QUIC eliminuje blokady na czele linii i utrzymuje płynność strumieni w przypadku strat.

- PushProaktywne dostarczanie pomaga w przypadku wysoce prawdopodobnych zasobów podstawowych, ale wiąże się z kosztami ogólnymi.

- Obciążenie wstępneDeklaratywne, kontrolowane, o niskim ryzyku z priorytetowym traktowaniem krytycznych zasobów.

- Zmierzone wartościZalety HTTP/3 są wyraźnie widoczne przy utracie pakietów i wielu atutach.

- StrategiaPołączenie preload i HTTP/3 często osiąga najlepsze wyniki w praktyce.

Krótkie wyjaśnienie HTTP/3 Push i Preload

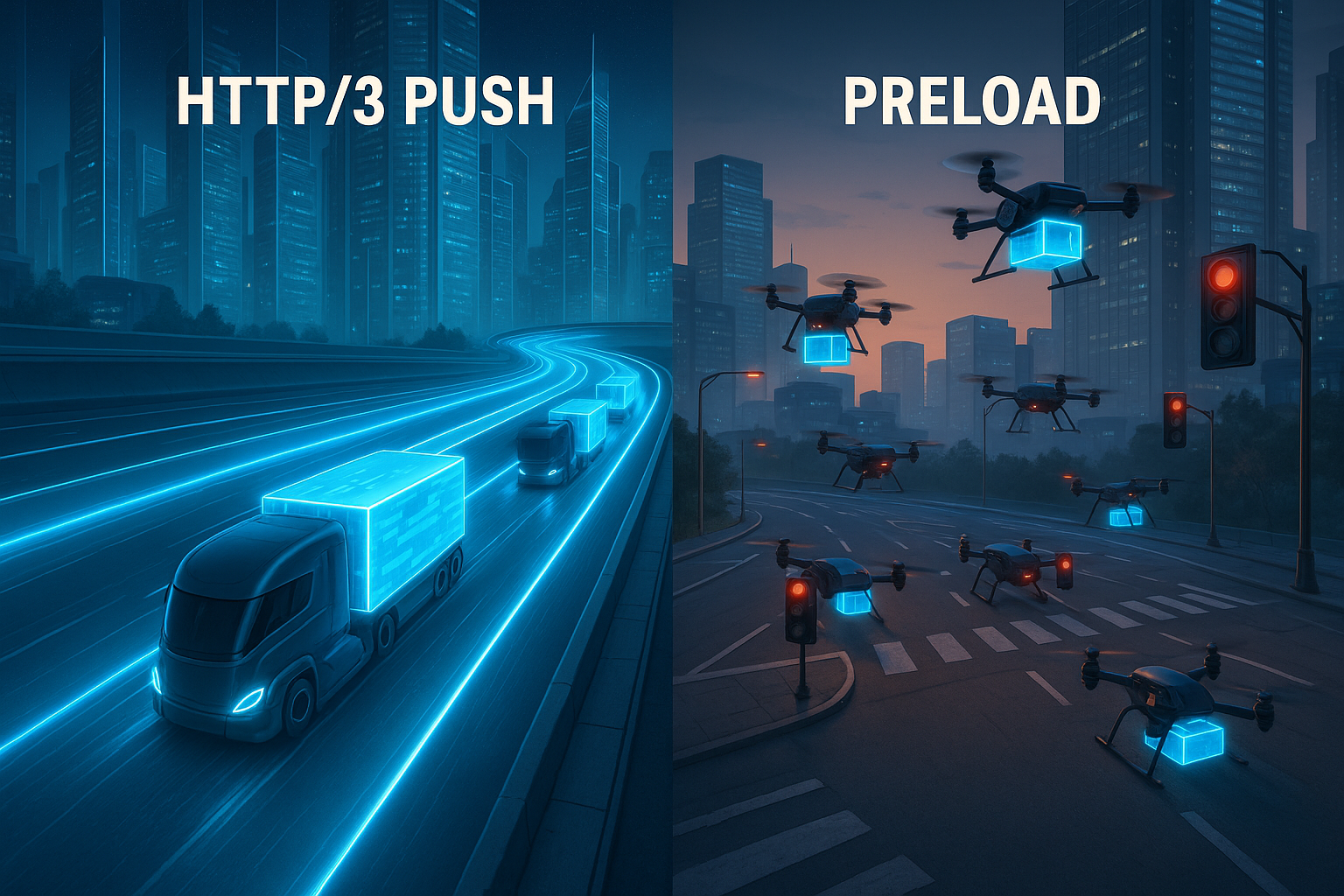

Ustawiłem Server Push gdy serwer dostarcza pliki zanim zażąda ich przeglądarka, na przykład CSS, JS lub czcionki internetowe, które są potrzebne bezpośrednio do renderowania. Ta taktyka umieszcza zasoby w pamięci podręcznej na wczesnym etapie, oszczędza podróże w obie strony i może zauważalnie faworyzować First Contentful Paint. Obciążenie wstępne Z drugiej strony, używam znaczników linków w znacznikach, aby przeglądarka dokładnie wiedziała, który plik powinna załadować jako pierwszy. Tworzy to wyraźne priorytety, redukuje duplikaty transferów i działa równie dobrze z HTTP/1.1, HTTP/2 i HTTP/3. Ponieważ HTTP/3 opiera się na QUIC, warto przyjrzeć się Protokół QUIC, która traktuje strumienie oddzielnie i w ten sposób unika przeciążenia na poziomie linii.

Jak HTTP/3 wpływa na czas ładowania

Dzięki QUIC, HTTP/3 znosi Head-of-Line-blocking, co oznacza, że pojedyncze straty pakietów nie spowalniają już ładowania wszystkich plików. Wiele strumieni działa równolegle, a straty wpływają tylko na dotknięty strumień, co jest szczególnie pomocne w przypadku wielu zasobów. 0-RTT może przyspieszyć połączenia, jeśli istnieje już historia, umożliwiając szybszy przepływ wczesnych żądań. Kontrola mocy transmisji i korekcji błędów jest również adaptacyjna, co utrzymuje wysoką częstotliwość taktowania pod obciążeniem. Dla tych, którzy cenią sobie bezpośrednie porównania HTTP/3 vs. HTTP/2 Porównanie wydajności z dodatkowymi perspektywami na opóźnienia i zachowanie transferu.

Push vs. preload: Logika podejmowania decyzji

Używam Push, gdy istnieje duże prawdopodobieństwo, że zasób będzie potrzebny natychmiast, np. centralny arkusz stylów lub skrypt typu above-the-fold. W takich przypadkach proaktywne dostarczanie może przynieść widoczne oszczędności czasu, zwłaszcza w sieciach mobilnych. Jeśli jednak plik jest wysyłany, mimo że klient ma go już w pamięci podręcznej lub w ogóle go nie potrzebuje, marnuje to przepustowość i wydłuża kolejki dla naprawdę ważnych danych. Obciążenie wstępne Używam go, gdy chcę dokładnie kontrolować, co zaczyna się od priorytetu i kiedy parser powinien zobaczyć żądanie. Dzięki temu kontrola pozostaje w moich rękach, unikam zduplikowanych transferów i minimalizuję błędy przy wyborze zasobów.

Porównanie wydajności w liczbach

W środowiskach pomiarowych z wieloma jednoczesnymi pobraniami, HTTP/3 pozostaje znacznie bardziej wydajny z zauważalnymi stratami przekraczającymi 8%. responsywny, podczas gdy HTTP/2 spada [4]. Przy plikach o rozmiarze 1 MB i stratach 2% testy wykazały czasy ładowania około 1,8 sekundy w przypadku HTTP/1 w porównaniu do 1,2 sekundy w przypadku HTTP/3 [5]. Różnice te mają bezpośredni wpływ na LCP, TTI i TBT, zwłaszcza gdy strona początkowo żąda wielu oddzielnych plików. W przypadku aplikacji jednostronicowych i stron multimedialnych separacja strumieni opłaca się w szczególności, ponieważ jeden słaby zasób nie wstrzymuje już innych. Zawsze oceniam dane liczbowe w kontekście typów zasobów, priorytetów i trafień w pamięci podręcznej, ponieważ jest to miejsce, w którym największa dźwignia dla Prędkość.

| Kryterium | HTTP/3 Push | Obciążenie wstępne | Wpływ na wskaźniki |

|---|---|---|---|

| System sterowania | Po stronie serwera, proaktywnie | Po stronie klienta, deklaratywnie | Wczesny start vs. jasne określenie priorytetów |

| Ryzyko podwójnych transferów | Zwiększona, jeśli pamięć podręczna jest już zapełniona | Niski, jak precyzyjnie zaadresowano | Wpływ na przepustowość i TBT |

| Obciążenie sieci/utrata pakietów | Straty buforów QUIC na strumień [4] | Zysk dzięki poziomowi transportu HTTP/3 | Zalety LCP/INP pod obciążeniem |

| Współczynnik trafień pamięci podręcznej | Wypchnięte aktywa mogą wygasnąć | Ukierunkowane wykorzystanie istniejących pamięci podręcznych | Krótszy czas oczekiwania dla powracających pacjentów |

| Wysiłek wdrożeniowy | Logika wymagana na serwerze | Korekty znaczników w głowicy | Szybki zysk z jasnymi zależnościami |

Status przeglądarki 2025: Push realistycznie skategoryzowany

Podczas planowania biorę pod uwagę, że wiele przeglądarek poważnie ogranicza lub całkowicie ignoruje push w praktyce. Dotyczy to w szczególności scenariuszy, w których zbliżają się podwójne transfery lub pamięci podręczne są już pełne. W rezultacie push pozostaje specjalną bronią dla jasno określonych przypadków - takich jak pierwsze wizyty przy nowych połączeniach - a nie panaceum. Dlatego też w moich konfiguracjach obliczam push jako opcjonalny wzmacniacz i polegam głównie na wstępnym ładowaniu i czystej priorytetyzacji na poziomie transportu. Tam, gdzie klienci nie korzystają z push, automatycznie wracam do preload i wczesnych podpowiedzi bez destabilizacji potoku. Ta trzeźwa priorytetyzacja zapobiega rozczarowaniom i utrzymuje realistyczną mapę drogową.

Wczesne wskazówki (103) i obciążenie wstępne w zespole

Zamiast naciskać na ślepo, wysyłam odpowiednie ustawienia Wczesne wskazówki (103) z Link: rel=preload przed właściwym kodem HTML. Pozwala to przeglądarce na uruchomienie krytycznych plików, podczas gdy serwer nadal renderuje stronę. Skraca to czas do pierwszego bajtu zasobów, a jednocześnie daje klientowi kontrolę. W praktyce działa to niezawodnie z HTTP/3 i oferuje wiele zalet push - bez ryzyka podwójnych transferów.

HTTP/1.1 103 Wczesne wskazówki

Link: ; rel=preload; as=style; fetchpriority=high

Link: ; rel=modulepreload

HTTP/1.1 200 OK

...Używam Early Hints głównie do głównego CSS, krytycznych czcionek internetowych i początkowych modułów. Ważne jak-typy muszą dokładnie pasować, aby nie były wyzwalane zduplikowane żądania. Upewniam się również, że specyfikacje CORS i nagłówki pamięci podręcznej są ustawione poprawnie. Pozwala mi to wykorzystać większość zalet wczesnego startu bez zbytniego zgadywania przez serwer.

Precyzyjna kontrola priorytetów: nagłówek priorytetu i fetchpriority

Oprócz Preload, polegam również na Sygnały priorytetowe na dwóch poziomach:

- W HTML poprzez

priorytet pobierania, np.fetchpriority="high"dla krytycznych stylów lub obrazów w rzutni ifetchpriority="low"dla aktywów dekoracyjnych. - W odpowiedzi poprzez nagłówek priorytetu, który dostarcza transportowi jasnych informacji o tym, które odpowiedzi powinny być traktowane priorytetowo. Jest to zgodne z HTTP/3 i zmniejsza obciążenie linii, gdy istnieje wiele równoległych strumieni.

W ten sposób współpracuję po stronie klienta i serwera: Przeglądarka szybko podejmuje właściwe decyzje, a serwer dostarcza je z odpowiednią wagą. W połączeniu z QUIC zmniejsza to presję na wąskie gardła i zapobiega blokowaniu ścieżki krytycznej przez nieistotne pliki.

Precyzyjnie określ napięcie wstępne

Wiele problemów z preloadem wynika z drobnych niespójności. Unikam ich dzięki czystym, wyraźnym znacznikom:

.

Konsekwentnie sprawdzam, czy jak-wartości odpowiadają rzeczywistym typom zasobów. Dla czcionek crossorigin Obowiązkowe, w przeciwnym razie istnieje ryzyko podwójnego pobrania. W przypadku skryptów zwracam uwagę na tryb (type="module" vs. klasyczny) i ustawić odroczenie, aby parser się nie blokował. Postrzegam preload jako uzupełnienie ścieżki renderowania, a nie jako jej zamiennik; regularna integracja pozostaje konieczna.

Szczegóły QUIC, które liczą się w praktyce

Planuję HTTP/3 z myślą o właściwościach, które są zauważalne w terenie:

- Migracja połączeńJeśli urządzenie przełączy się z sieci WLAN na sieć komórkową, połączenie QUIC zostanie utrzymane. Pozwala to uniknąć nowych uzgodnień i chroni długie transfery przed anulowaniem.

- QPACKKompresja nagłówków bez globalnego ryzyka head-of-line. Przyspiesza to strony z wieloma małymi żądaniami, zwłaszcza w sieciach CDN z wieloma powtarzającymi się nagłówkami.

- 0-RTTZezwalam na wczesne przyspieszone żądania tylko dla zasobów idempotentnych i oceniam sytuację bezpieczeństwa. Tam, gdzie działa 0-RTT, zyskuję zauważalny czas podczas ciepłego startu.

- Adaptacyjna kontrola przeciążeniaPrzepustowość pozostaje bardziej stabilna w sieciach stratnych. W połączeniu z priorytetyzacją skutkuje to solidnym zachowaniem, gdy ma to znaczenie.

Funkcje te są naprawdę przydatne tylko przy czystej konfiguracji serwera i CDN. Zapewniam TLS 1.3, krótkie łańcuchy certyfikatów, informacje o stanie stosu i spójne rozwiązania awaryjne, dzięki czemu starsi klienci mogą być obsługiwani z wysoką wydajnością.

Prawidłowe korzystanie z priorytetyzacji zasobów

Definiuję Aktywa podstawowe wyraźnie: krytyczny CSS, czcionki dla widocznego tekstu i skrypty, które wpływają na obszar powyżej złożenia. Pliki te mają najwyższy priorytet poprzez wstępne ładowanie lub są wypychane w szczególnych przypadkach. Pliki obrazów dla treści, które będą widoczne później, mają niższy priorytet lub są przenoszone w górę poprzez leniwe ładowanie, dzięki czemu ścieżka renderowania i interakcja są dostępne wcześnie. W przypadku zasobów stron trzecich starannie rozważam korzyści i w razie potrzeby ustawiam wstępne połączenie, aby uściski dłoni rozpoczęły się na czas. Pozostawia to wolną linię dla naprawdę ważnych danych i zapobiega blokowaniu startu przez zasoby deko.

W praktyce trzymam się krótkiej rutyny decyzyjnej:

- Czy zasób jest krytyczny dla FCP/LCP i prawie zawsze niezbędny? → Preload, opcjonalne wczesne podpowiedzi; selektywne wypychanie tylko wtedy, gdy jest wymiernie lepsze.

- Czy użycie jest zmienne lub zależne od użytkownika? → Brak push; co najwyżej wstępne ładowanie zgodnie z przetestowaną heurystyką lub ładowanie w dół.

- Czy zasób jest duży? → Preferuj wstępne ładowanie; wypychaj tylko wtedy, gdy przepustowość jest zabezpieczona, a trafienia do pamięci podręcznej są mało prawdopodobne.

- Czy istnieją alternatywy, takie jak inline critical CSS lub podział kodu? → Preferowane; skracają ścieżki i zmniejszają ogólne ryzyko.

Wdrożenie: Lista kontrolna z praktyki

Zaczynam od Audyt strony startowej i najważniejszych szablonów oraz zaznaczam wszystkie pliki, które są wymagane dla pierwszego widocznego obszaru. Następnie tworzę wpisy preload w head, testuję priorytety i sprawdzam, czy nie pojawiają się zduplikowane żądania. Tam, gdzie wczesny transfer jest bardzo opłacalny, rozważam selektywne wypychanie i mierzę wpływ na LCP i TTI. W przypadku QUIC/HTTP-3 aktywuję wsparcie na CDN lub serwerze i porównuję reguły priorytetyzacji ze ścieżkami krytycznymi. Aby uzyskać pomoc krok po kroku, korzystam z praktycznego narzędzia Implementacja HTTP/3, dzięki czemu konfiguracja, testy i wdrażanie przebiegają w uporządkowany sposób.

Ustalam również następujące procedury:

- Wczesne wskazówki i podaj mu te same wpisy linków, co ostateczny nagłówek HTML.

- Strategia pamięci podręcznej z wersjonowaniem:

app.abcdef.css, długimaksymalny wiek,niezmienny, dzięki czemu powracający klienci odnoszą korzyści. - Pracownik serwisu do wstępnego ładowania przepływów, aby nie powielać pracy w sieci i pamięci podręcznej SW.

- Nagłówek priorytetu w Origin/CDN, aby HTTP/3 faworyzował naprawdę ważne odpowiedzi.

- Flagi funkcji dla push/preload, aby szybko i bez ryzyka przeprowadzać testy A/B.

Typowe błędy i sposoby ich unikania

Nie naciskam Aktywa, które przeglądarka może już mieć w pamięci podręcznej, ponieważ marnuje to przepustowość. Zamiast tego sprawdzam nagłówki pamięci podręcznej, wersjonowanie i ważność, aby powracający użytkownicy mogli korzystać ze świeżych trafień. Nie przeciążam Preload, ponieważ tuzin krytycznych wpisów może zapchać linię i rozmyć priorytety. W przypadku czcionek zwracam uwagę na odpowiednie formaty i rangi unicode, dzięki czemu transfer pozostaje niewielki, a widoczny tekst pojawia się szybko. Testuję również na różnych urządzeniach i sieciach bezprzewodowych, ponieważ prawdziwy efekt staje się widoczny dopiero w rzeczywistych warunkach.

Mam na oku w szczególności te pułapki:

- Niedopasowanie pomiędzy

jaki typ zasobu (np.as="script"dla modułów) → prowadzi do niepotrzebnych drugorzędnych wymagań. - Brakujący crossorigin dla czcionek → podwójne pobieranie lub błędy blokowania.

- Wstępnie załadowane listy są zbyt szerokie → podważam priorytety; ograniczam się do podstawowych aktywów.

- Niejasne role Inline-Critical-CSS vs. Preload → Decyduję się na stronę i unikam mieszanych form, które obciążają obie strony.

- Pchanie na oślep bez znajomości pamięci podręcznej → Push pozostaje zakładem; mierzę i zabezpieczam za pomocą Early Hints.

Metody monitorowania i pomiarów

Mierzę LCP, TTI, TBT i INP za pomocą Lighthouse, dodawanie danych runtime za pomocą RUM i porównywanie wariantów za pomocą testów A/B. WebPageTest lub podobne narzędzia pomagają mi analizować diagramy wodospadowe i rozpoznawać, czy preload i push działają zgodnie z planem. Połączenie danych laboratoryjnych i terenowych pokazuje, czy optymalizacje są opłacalne, czy też generują efekty uboczne. Regularnie sprawdzam, jak przeglądarki radzą sobie z wypychaniem na serwer, ponieważ niektóre programy użytkownika ograniczają lub ignorują wypychane zasoby [8]. Na podstawie tych danych decyduję, którą technologię dalej rozwijać, a którą wycofać.

Rozróżniam wiarygodne stwierdzenia:

- Zimno kontra ciepłoOceniaj pierwszą wizytę bez pamięci podręcznej oddzielnie od ponownych wizyt.

- Profile siecioweSymuluj 4G/5G z realistycznymi stratami, scenariuszami wysokiego RTT i mocno wykorzystywanymi komórkami.

- Liczba żądańWyświetlanie stron z kilkoma dużymi lub wieloma małymi plikami osobno.

- Zestaw urządzeńUrządzenia mobilne średniej klasy ze słabszym procesorem, ponieważ koszty parsera i dekompresji są tam większe.

Dokładnie dokumentuję każdy eksperyment: wersje kompilacji, wpisy wstępnego ładowania, nagłówki priorytetów, reguły wypychania, status wczesnych wskazówek. Pozwala mi to odtworzyć efekty i w razie potrzeby szybko je odwrócić.

Hosting i infrastruktura jako dźwignia finansowa

Zwracam uwagę na Serwer z aktualną obsługą HTTP/3, solidną konfiguracją TLS i czystą priorytetyzacją. Wysokowydajna sieć CDN z dobrym zasięgiem PoP zmniejsza opóźnienia dla użytkowników mobilnych i sprawia, że korzyści płynące z QUIC są bardziej namacalne. Czysta konfiguracja TCP fallbacks dla starszych klientów również odgrywa rolę, aby nikt nie był pokrzywdzony. W przypadku budżetów najpierw obliczam efekt, ponieważ najmniejsze dostosowania CDN lub aktywacje HTTP/3 są często wystarczające bez wysokich dodatkowych kosztów w niskim dwucyfrowym przedziale euro miesięcznie. Im silniejsza podstawa, tym wyraźniejsze stają się efekty push i preload w codziennym życiu.

Sprawdzam również, czy infrastruktura obsługuje następujące punkty:

- Wczesne wskazówki z Edge, aby wstępne ładowanie rozpoczynało się przed HTML.

- Rozszerzalna priorytetyzacja lub nagłówki priorytetów, które są respektowane przez proxy.

- Szczegółowe zasady na ścieżkę/typ pliku, aby wypchnąć tylko wybrane zasoby lub wyróżnić je poprzez wstępne załadowanie.

- Przejrzyste wskaźniki na poziomie krawędzi (wskaźnik trafień, RTT, straty, zmiana priorytetów), aby uwidocznić przyczyny odchyleń.

Ostateczna kategoryzacja

Widzę HTTP/3 QUIC ma przewagę, gdy tylko w grę wchodzą sieci bezprzewodowe, wiele równoległych strumieni lub sytuacje utraty [4] [5]. W kontrolowanych konfiguracjach preload zapewnia niezawodną priorytetyzację, ponieważ dokładnie określam, co powinno być uruchamiane jako pierwsze. Używam push specjalnie dla niezbędnych zasobów, których korzyści są spójne i których rozmiar pozostaje w granicach limitów. Najlepszy efekt osiągam, gdy łączę preload dla priorytetów, HTTP/3 dla transportu i starannie dozowany push. Jeśli postępujesz w ten sposób, zauważalnie skracasz czas ładowania, chronisz przepustowość użytkownika i znacznie zwiększasz postrzeganą jakość strony.