W tym przewodniku pokażę ci, jak Rozszerzenia Plesk przyspieszyć moją codzienną pracę jako dewelopera, umożliwić bezpieczne wdrożenia i zautomatyzować powtarzające się zadania. Podaję jasne zalecenia dotyczące wyboru i konfiguracji - w tym kroki konfiguracji, rozsądne ustawienia domyślne i typowe pułapki.

Punkty centralne

- Konfiguracja i rozsądne ustawienia domyślne dla bezpieczeństwa, kopii zapasowych, wydajności

- Przepływ pracy z Gitem, stagingiem, hakami CI i stosami kontenerów

- Bezpieczeństwo za pośrednictwem Imunify360, Let's Encrypt i koncepcji inteligentnego hartowania

- Prędkość Poprzez Cloudflare CDN, buforowanie i monitorowanie

- Skalowanie z Dockerem, automatyzacją i jasnymi rolami

Dlaczego Plesk przyspiesza moją pracę jako dewelopera?

Łączę projekty, domeny i serwery centralnie i w ten sposób oszczędzam pieniądze każdego dnia. Czas. Rozszerzenia obejmują rozwój, bezpieczeństwo, wydajność i automatyzację i idealnie do siebie pasują. Aktualizacje i kroki migracji kontroluję bezpośrednio w panelu, bez objazdów przez skrypty powłoki dla standardowych zadań. Dzięki funkcji przeciągnij i upuść mogę posortować najważniejsze narzędzia tam, gdzie ich najczęściej potrzebuję i pozostać w ciągłym ruchu. Jeśli szukasz najpierw przeglądu, zacznij od sekcji Najlepsze rozszerzenia Plesk a następnie ustala priorytety w zależności od typu projektu i wielkości zespołu.

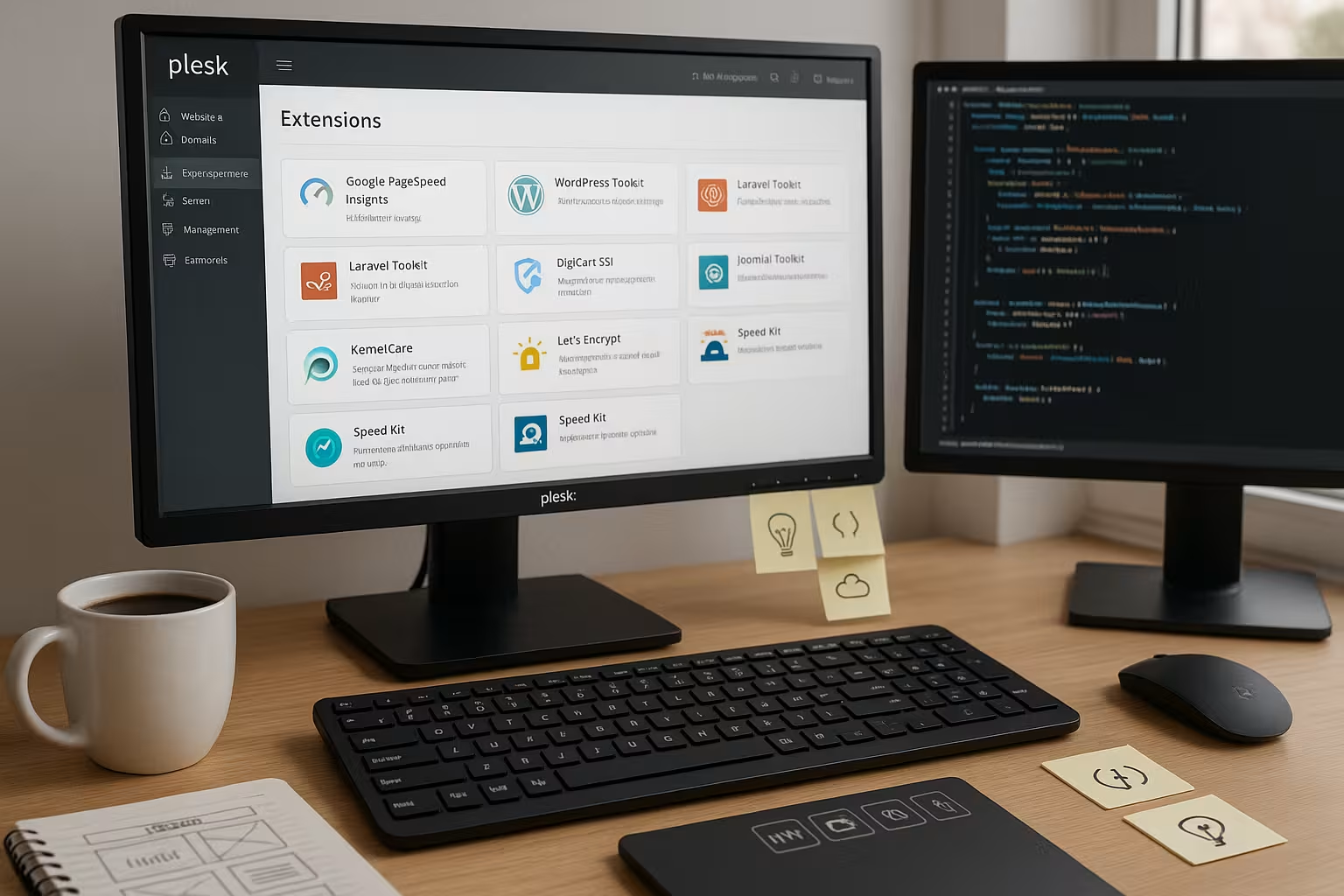

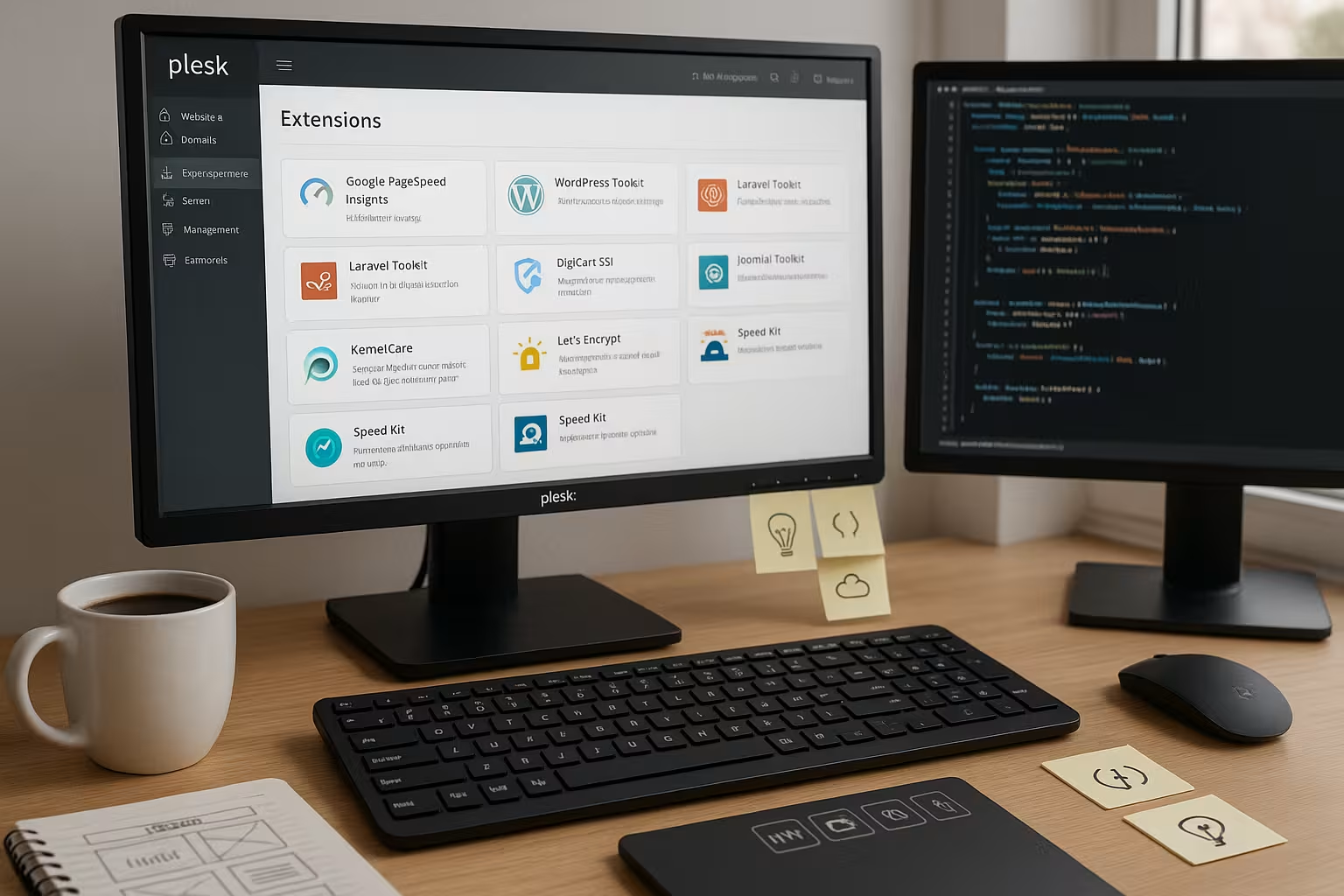

Najważniejsze rozszerzenia Plesk w skrócie

W przypadku nowoczesnych przepływów pracy polegam na wyraźnym rdzeniu WordPress Toolkit, Git, Docker, Cloudflare, Imunify360, Let's Encrypt i Acronis Backup. Wybór ten obejmuje wdrożenia, utwardzanie, SSL, CDN i tworzenie kopii zapasowych danych. Zwykle zaczynam od WordPress Toolkit i Git, następnie dodaję Docker dla usług takich jak Redis lub Node, a następnie włączam Cloudflare. SSL i bezpieczeństwo działają równolegle, przy czym natychmiast aktywuję automatyczne odnawianie dla nowych instancji. Poniższa tabela podsumowuje korzyści i zastosowanie.

| Rozszerzenie | Najważniejsza korzyść | Odpowiedni dla | OS | Konfiguracja w Plesk |

|---|---|---|---|---|

| Zestaw narzędzi WordPressa | Inscenizacja, klonowanie, aktualizacje | Strony WP, agencje | Linux/Windows | Zainstaluj, przeskanuj instancję, utwórz staging, ustaw automatyczne aktualizacje |

| Integracja z Git | Kontrola wersji, wdrażanie | Wszystkie aplikacje internetowe | Linux/Windows | Podłącz repo, wybierz gałąź, aktywuj webhook/auto-deploy |

| Docker | Stosy pojemników | Mikrousługi, Narzędzia | Linux/Windows | Wybór obrazu, ustawienie zmiennych środowiskowych, zwolnienie portów |

| Cloudflare | CDN i DDoS | Szczyty ruchu | Linux/Windows | Połącz strefę, aktywuj proxy, wybierz poziom buforowania |

| Imunify360 | Ochrona przed złośliwym oprogramowaniem | Koncentracja na bezpieczeństwie | Linux/Windows | Tworzenie zasad skanowania, sprawdzanie kwarantanny, ustawianie reguł zapory sieciowej |

| Let's Encrypt | Automatyzacja SSL | Wszystkie projekty | Linux/Windows | Żądanie certyfikatu, automatyczne odnawianie włączone, HSTS opcjonalnie |

| Acronis Backup | Kopia zapasowa w chmurze | Krytyczne dla działalności | Linux/Windows | Utwórz plan, wybierz okno czasowe, przetestuj przywracanie |

Podejmuję decyzje w oparciu o cele projektu, a nie przyzwyczajenia, i utrzymuję stos. szczupły. Każde rozszerzenie kosztuje zasoby, więc decyduję się na więcej tylko wtedy, gdy istnieje wyraźna korzyść. W przypadku zespołów zalecam zapisanie krótkiej listy w dokumentacji i zdefiniowanie wiążących ustawień domyślnych. Pozwala to zachować spójność konfiguracji i pomaga nowym współpracownikom szybciej odnaleźć się w środowisku. Przejrzystość w wyborze ogranicza późniejsze prace konserwacyjne.

WordPress Toolkit: Konfiguracja i przydatne ustawienia domyślne

Zaczynam od skanowania, aby Plesk automatycznie przeskanował wszystkie instancje. uznaje. Następnie tworzę staging dla każdej produktywnej witryny, aktywuję synchronizację plików i wybieram tabele bazy danych, jeśli jest to wymagane. Ustawiam automatyczne aktualizacje dla rdzenia na bezpieczne, dla wtyczek na ręczne lub rozłożone w czasie zgodnie z oknem konserwacji. Każdą zmianę najpierw testuję w wersji testowej, sprawdzam zabezpieczenia, a następnie uruchamiam. Jeśli chcesz zajrzeć głębiej, możesz znaleźć przydatne informacje w sekcji Szczegóły zestawu narzędzi WordPress.

Używam funkcji klonowania dla niebieskich/zielonych podejść i zachowuję plan wycofania gotowy. Pozwala mi to skrócić czas przestojów podczas większych aktualizacji. W przypadku wielu witryn dezaktywuję niepotrzebne wtyczki w instancjach testowych, aby przyspieszyć testy. Codziennie przeprowadzam skanowanie bezpieczeństwa i sprawdzam kwarantannę na pulpicie nawigacyjnym. Pomaga mi to minimalizować ryzyko i planować wdrożenia.

Integracja z Git: czyste wdrożenia bez objazdów

W Plesk podłączam repozytorium Git, wybieram odpowiednią gałąź i aktywuję Auto-Deploy na Push. Opcjonalnie ustawiam webhooki dla CI, które wykonują kompilacje i testy przed wdrożeniem na żywo. Dla projektów PHP tworzę krok kompilacji dla instalacji Composera, dla projektów Node dodaję npm ci i zadanie Minify. Ustawiam mapę wdrożenia tak, aby tylko wymagane katalogi były uruchamiane w webroot, podczas gdy artefakty kompilacji są generowane poza nim. Klucze dostępu i autoryzacje utrzymuję w czystości i regularnie je zmieniam.

Przed uruchomieniem przeprowadzam kontrolę stanu za pośrednictwem adresu URL konserwacji i weryfikuję ważne dane. Nagłówek. Pipeline automatycznie zatrzymuje rollout w przypadku wystąpienia błędów. W ten sposób unikam niedokończonych wdrożeń, które trudniej później wychwycić. Dokumentuję konwencje gałęzi dla zespołów i używam pull requestów jako wymogu. Dzięki temu współpraca jest przewidywalna, a identyfikowalność wysoka.

Docker w Plesk: produktywne korzystanie z kontenerów

W przypadku usług takich jak Redis, Elasticsearch, Meilisearch lub tymczasowych aplikacji podglądowych, uruchamiam kontenery bezpośrednio w aplikacji Panel. Wybieram obrazy z huba, ustawiam zmienne środowiskowe, mapuję porty i wiążę trwałe woluminy. Sprawdzam kondycję za pomocą prostych punktów końcowych, aby Plesk zgłaszał fałszywe uruchomienia. W przypadku scenariuszy z wieloma kontenerami pracuję z jasnymi konwencjami nazewnictwa i dokumentuję zależności. Jeśli potrzebujesz dobrego wprowadzenia, skorzystaj z kompaktowego przewodnika po Integracja Docker w Plesk.

W miarę rozwoju projektów skaluje usługi horyzontalnie i hermetyzuje komponenty stanowe, aby kopie zapasowe pozostały spójne. Logi kieruję do osobnych katalogów i regularnie je rotuję. Przed przełączeniem najpierw testuję aktualizacje w oddzielnej wersji kontenera. Wpisy DNS dodaję dopiero po przeprowadzeniu wiarygodnych testów kondycji. Dzięki temu wdrożenia są kontrolowane i powtarzalne.

Bezpieczeństwo przede wszystkim: prawidłowa konfiguracja Imunify360 i Let's Encrypt

Aktywuję tryb automatyczny Skany w Imunify360 i definiuję wyraźne działania w przypadku wykrycia, takie jak kwarantanna z powiadomieniem. Utrzymuję ścisłe reguły zapory i zezwalam tylko na to, co jest naprawdę konieczne. Ustawiam Let's Encrypt na automatyczne odnawianie dla wszystkich domen i dodaję HSTS, jeśli witryna działa konsekwentnie przez HTTPS. Sprawdzam również nagłówki zabezpieczeń, takie jak CSP, X-Frame-Options i Referrer-Policy. Regularne raporty pokazują, gdzie muszę zaostrzyć.

Używam uwierzytelniania dwuskładnikowego do logowania administratorów i ograniczam dostęp do określonych adresów IP. Dostęp do SSH odbywa się za pośrednictwem kluczy, a tam, gdzie to możliwe, dezaktywuję hasła. Szyfruję kopie zapasowe i regularnie testuję proces przywracania. Prowadzę listę krytycznych wtyczek i sprawdzam ich dzienniki zmian przed aktualizacjami. Bezpieczeństwo pozostaje codziennym zadaniem, a nie jednorazową czynnością Konfiguracja.

Prędkość przez CDN: sprytna konfiguracja Cloudflare

Podłączam strefę, aktywuję proxy i wybieram poziom buforowania, który umożliwia dynamiczną zawartość. szanowany. Dla API włączam cache według nagłówka, dla zasobów ustawiam długie TTL z wersjonowaniem. Używam reguł stron, aby wykluczyć obszary administracyjne z buforowania i ściśle chronić wrażliwe ścieżki. HTTP/2, Brotli i Early Hints zwiększają szybkość ładowania bez zmian w kodzie. Podczas szczytów ruchu limity szybkości tłumią próby nadużyć.

Reguły wyzwań i botów zmniejszają niepotrzebne obciążenie systemów zaplecza. Monitoruję wskaźniki HIT/MISS i dostosowuję reguły, aż do osiągnięcia pożądanego limitu pamięci podręcznej. W przypadku projektów międzynarodowych pracuję z geo-sterowaniem i mapuję warianty regionalne. Dokumentuję zmiany DNS w dzienniku zmian, aby można było szybko wykonać wycofanie. Dzięki temu wydajność jest mierzalna i możliwy do zaplanowania.

Kopie zapasowe, przywracanie i ponowne uruchamianie z Acronis

Tworzę codzienne przyrostowe kopie zapasowe i cotygodniowe kopie zapasowe pełny do chmury. Przechowuję dane w taki sposób, że mam dostęp do co najmniej 14-dniowej historii. Po każdej większej wersji testuję przywracanie w odizolowanym środowisku. Regularnie mierzę czasy odzyskiwania, aby mieć realistyczne oczekiwania w przypadku awarii. Tworzę kopie zapasowe baz danych w sposób spójny z transakcjami, aby uniknąć ich uszkodzenia.

Dla krytycznych witryn przechowuję oddzielną kopię zapasową poza siedzibą firmy. Podręczniki przywracania opisują kroki, w tym przełączanie DNS i czyszczenie buforowania. Hasła i klucze przechowuję w formie zaszyfrowanej i zmieniam je co kwartał. Kopie zapasowe bez testowego przywracania uznaję za niekompletny. Tylko to, co zostało przećwiczone, zadziała bezpiecznie w sytuacji awaryjnej.

Automatyzacja i monitorowanie: uproszczenie codziennych czynności

Automatyzuję powtarzające się Zadania z zadaniami cron, skryptami hook i akcjami git. Logi działają w centralnych katalogach, rotacja utrzymuje pamięć w czystości. Używam Webalizera do prostych analiz ruchu i sprawdzam anomalie, gdy wzrasta liczba kodów 4xx i 5xx. Ustawiam alerty w taki sposób, aby pozostawały istotne dla działania i nie powodowały zmęczenia alertami. Dokumentuję jasny czas rozpoczęcia i zakończenia okien konserwacyjnych.

Oznaczam wdrożenia i łączę je z mierzonymi wartościami, takimi jak czas do pierwszego bajtu i wskaźnik błędów. Jeśli te wartości zostaną przekroczone, automatycznie korzystam z wycofania. Zapisuję wersje konfiguracji, aby zachować możliwość śledzenia zmian. Testy wydajności są uruchamiane automatycznie po większych aktualizacjach i dają mi szybkie wyniki. Informacje zwrotne. W ten sposób unikam niespodzianek podczas pracy na żywo.

Twórz własne rozszerzenia: Gdy standardy nie wystarczają

Polegam na własnych rozszerzeniach Plesk, gdy zespół ma jasne Specjalne-Wymagania. Może to być wewnętrzna koncepcja autoryzacji, specjalny przepływ wdrażania lub pomost integracyjny z systemami innych firm. Przed budową sprawdzam, czy istniejące rozwiązanie z niewielkimi zmianami jest wystarczające. Jeśli nie, krótko i jasno definiuję punkty końcowe API, role i limity bezpieczeństwa. Dopiero wtedy piszę moduł i testuję go pod kątem typowych codziennych scenariuszy.

Czysta strategia odinstalowywania i aktualizacji jest ważna, aby system pozostał łatwy w utrzymaniu. Dokumentuję również funkcje i ograniczenia, aby współpracownicy mogli bezpiecznie korzystać z narzędzia. W razie potrzeby zbieram opinie i planuję małe iteracje zamiast dużych skoków. Dzięki temu rozbudowa jest łatwa w zarządzaniu i Niezawodny. Dostosowane moduły są opłacalne, jeśli skracają procesy w znaczący sposób.

Role, subskrypcje i plany usług: organizacja tworzy szybkość

Zanim utworzę projekty, strukturyzuję Plesk za pomocą Subskrypcjeplany usług i role. Pozwala mi to przydzielać limity (CPU, RAM, i-węzły, przydziały poczty) i autoryzacje (SSH, Git, Cron) w sposób możliwy do zaplanowania. W przypadku zespołów agencyjnych tworzę oddzielne subskrypcje dla każdego klienta, aby autoryzacje i kopie zapasowe pozostały czysto odizolowane. Standardowe plany zawierają rozsądne ustawienia domyślne: PHP-FPM aktywny, opcache włączony, codzienne kopie zapasowe, auto-SSL, restrykcyjne uprawnienia do plików. W przypadku bardziej ryzykownych testów używam oddzielnej subskrypcji laboratoryjnej ze ściśle ograniczonymi zasobami - chroni to resztę systemu przed wartościami odstającymi.

Utrzymuję granularne role: Administratorzy z pełnym dostępem, programiści z Git/SSH i logami, redaktorzy tylko z menedżerem plików/WordPress. Dokumentuję, która rola wykonuje jakie zadania i unikam mnożenia uprawnień poszczególnych użytkowników. Nowe projekty zaczynają się spójnie i łatwiej je później migrować lub skalować.

PHP-FPM, NGINX i buforowanie: Wydajność z panelu

Wydajność, z której wychodzę pierwszy Ustawienia czasu działaniaPHP-FPM z pm=ondemand, clean max-children per site, opcache z wystarczającą ilością pamięci i revalidate_freq dopasowanym do interwału deploy. Pozwalam NGINX na bezpośrednie dostarczanie statycznych zasobów i ustawiam określone nagłówki buforowania bez narażania dynamicznych obszarów. W przypadku WordPressa aktywuję mikro-buforowanie tylko dla anonimowych użytkowników, jeśli to możliwe, i wykluczam pliki cookie oznaczające sesje. Włączam Brotli/Gzip na całym serwerze, ale testuję poziomy kompresji pod kątem obciążenia procesora.

Utrzymuję dedykowane wersje PHP gotowe dla każdej witryny, aby czysto rozdzielić zależności. Dodaję optymalizacje ścieżki krytycznej (HTTP/2 push nie jest już potrzebny, zamiast tego wczesne podpowiedzi, czyste nagłówki preload/prefetch), jeśli zmierzone wartości to uzasadniają. Zasada: najpierw mierz, potem zmieniaj - testy porównawcze po każdej większej zmianie zapobiegają lataniu na ślepo.

Poczta e-mail i DNS: prawidłowa konfiguracja dostarczalności i certyfikatów

Kiedy Plesk wysyła maile, ustawiam SPF, DKIM oraz DMARC na domenę, sprawdzać rDNS i utrzymywać spójne adresy odrzuceń. Oddzielam newslettery od e-maili transakcyjnych, aby chronić swoją reputację. Podejmuję świadomą decyzję dotyczącą DNS: albo Plesk jako master, albo strefa zewnętrzna (np. przez CDN). Ważne: Przy aktywnym proxy planuję wyzwania Let's Encrypt w taki sposób, aby odnowienia przechodziły niezawodnie - na przykład z tymczasowym de-proxy lub wyzwaniem DNS dla symboli wieloznacznych. Dokumentuję wybraną strategię dla każdego klienta, aby przypadki pomocy technicznej mogły być szybko rozwiązywane.

Webhooki z CI/CD przechwytują stałe docelowe adresy IP, a ja zezwalam tylko na to, co jest potrzebne w firewallu. Dzięki temu zarówno poczta, jak i ścieżki kompilacji są stabilne.

Bazy danych i pamięć masowa: stabilność pod obciążeniem

W przypadku większych projektów outsourcuje bazy danych na serwery dedykowane lub kontenery. Kopie zapasowe uruchamiam spójne transakcyjnie, oparte na binlogach odzyskiwanie w czasie rzeczywistym. Używam replik odczytu do raportowania lub funkcji wyszukiwania, dzięki czemu podstawowa baza danych pozostaje nieobciążona. W Plesk zwracam uwagę na czyste nazwy DB na subskrypcję i ustawiam minimalne niezbędne uprawnienia.

Utrzymuję kontrolę nad pamięcią masową przy użyciu przydziałów i rotacji dzienników. W miarę możliwości wersjonuję przesyłanie multimediów i unikam niepotrzebnych duplikatów w środowiskach przejściowych. Ustawiam domyślne wartości 640/750 dla uprawnień do plików i regularnie sprawdzam, czy wdrożenia nie pozostawiają żadnych permisywnych wartości odstających. Dzięki temu przywracanie i migracje są obliczalne.

Wdrożenia bez przestojów: wersje blue/green i symlink

Oprócz inscenizacji, używam Blue/Green lub Symlink-releases. Kompilacje kończą się w wersjonowanych folderach wersji poza webrootem. Po udanych testach przełączam się za pomocą dowiązania symbolicznego, wykonuję migracje bazy danych w kontrolowanych krokach i przygotowuję revert. Jasno definiuję współdzielone katalogi (uploads, cache, session), aby przełączniki nie utraciły żadnych danych. W przypadku aplikacji WordPress i PHP tymczasowo uniemożliwiam dostęp do zapisu podczas krytycznych okien migracji, aby uniknąć niespójności.

Healthchecks monitorują nową wersję przed przerzuceniem. Automatycznie sprawdzam nagłówki, ważne trasy i połączenia DB. Przełączam się tylko wtedy, gdy wszystkie kontrole są zielone. Ta rutyna uratowała mi wiele nocnych wdrożeń.

Kontrola kosztów i zasobów: limity, alerty, czyszczenie

Ustawiłem Ograniczenia na subskrypcję: Czas procesora, pamięć RAM, liczba procesów, i-węzły. Zadania Cron i kolejki mają jasne okna czasowe, dzięki czemu można obliczyć szczyty obciążenia. Automatycznie porządkuję stare wydania i dzienniki, a kopie zapasowe są uproszczone i udokumentowane. Monitoruje kontenery docker pod kątem rozrastających się wolumenów i regularnie rotuje cache. Dzięki temu koszty operacyjne i wydajność są przewidywalne - bez niespodzianek na koniec miesiąca.

Alerty są pomocne tylko wtedy, gdy umożliwiają podjęcie działań. Rozróżniam ostrzeżenia (przechylenie trendu) i alerty (wymagana natychmiastowa interwencja) i łączę oba z runbookami. Każdy, kto budzi się w nocy, musi być w stanie przywrócić stabilność w trzech krokach.

Typowe pułapki i sposoby ich unikania

Automatyczne aktualizacje bez inscenizacji rzadko się psują, ale zwykle niekorzystnie - więc zawsze najpierw przetestuj. Cloudflare może agresywnie buforować obszary administracyjne, jeśli reguły są zbyt szerokie; konsekwentnie wykluczam logowanie, /wp-admin, API i podglądy. Nie zezwalam usługom Docker, takim jak Redis, na publiczne nasłuchiwanie i zabezpieczam je za pośrednictwem sieci wewnętrznych. Odnowienia Let's Encrypt kończą się niepowodzeniem, jeśli proxy blokuje wyzwania; wyzwanie DNS lub tymczasowe obejście pomaga tutaj. Wdrożenia Git, które wykonują kompilacje node/composer w webroocie lubią powodować chaos praw - dlatego twórz kompilacje poza nimi i wdrażaj tylko artefakty.

Drugi klasyk: dysk zapełniony z powodu zapomnianych logów debugowania lub coredumpów. Ustawiam limity, ściśle rotuję logi i sprawdzam nietypowy wzrost po wydaniach. I zawsze mam przygotowany ręczny dostęp do break-glass (klucz SSH, udokumentowana ścieżka) na wypadek, gdyby panel był niedostępny.

Kompakt najlepszych praktyk

Zachowuję Plesk i wszystkie rozszerzenia bieżący i testuję aktualizacje przed ich wdrożeniem. Kopie zapasowe działają zgodnie z planem i regularnie ćwiczę przywracanie w środowisku testowym. Organizuję panel za pomocą metody "przeciągnij i upuść", aby centralne narzędzia były natychmiast widoczne. Używam automatyzacji, ale tylko z jasnymi strategiami wyjścia i wycofania. Wszyscy członkowie zespołu znają najważniejsze kroki i pracują według tych samych standardów.

Krótkie podsumowanie

Dzięki dobrze przemyślanemu wyborowi Rozszerzenia Skupiam się na szybkości, bezpieczeństwie i niezawodnych wdrożeniach. WordPress Toolkit i Git tworzą szkielet, podczas gdy Docker i Cloudflare zapewniają elastyczność i wydajność. Imunify360 i Let's Encrypt zabezpieczają operacje, a Acronis chroni dane i skraca czas odzyskiwania. Przejrzyste ustawienia domyślne, testy i szczupła automatyzacja zapewniają organizację codziennych operacji. Oznacza to, że środowisko programistyczne pozostaje elastyczne, a projekty osiągają swoje cele w stabilny sposób.