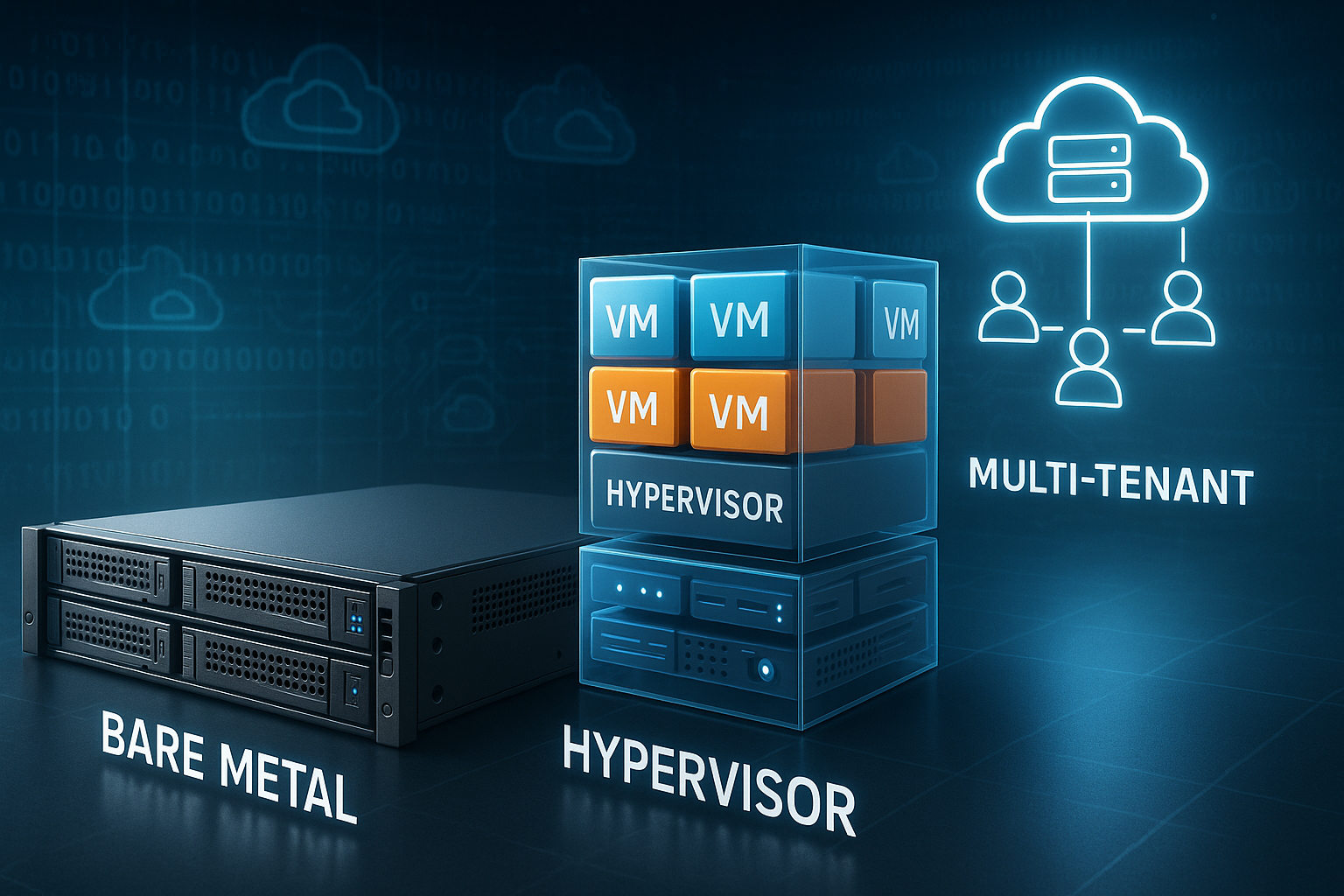

Wyjaśniam żargon związany z hostingiem stron internetowych Bare Metal, hypervisor oraz Wielodostępny konkretne i praktyczne. Dzięki temu od razu zrozumiesz, jak działają modele, czym się różnią i który z nich najlepiej pasuje do Twoich celów – od pojedynczego projektu po platformę z wieloma użytkownikami.

Punkty centralne

- Bare Metal: pełna kontrola sprzętu i najwyższa wydajność.

- hypervisor: Wirtualizacja z wyraźną izolacją i elastycznością.

- Wielodostępny: efektywne wykorzystanie zasobów dzięki logicznemu rozdzieleniu.

- Hałaśliwy sąsiad: Efektywne zarządzanie wydajnością i zapobieganie problemom.

- Hybryda: rozdzielanie wrażliwych obciążeń, elastyczne skalowanie.

Krótkie wyjaśnienie pojęcia „bare metal”

Bare Metal oznacza, że fizyczny serwer należy wyłącznie do Ciebie. Nie dzielisz z innymi procesora, pamięci RAM ani dysku SSD. Sam decyduję o systemie operacyjnym, konfiguracji pamięci masowej i funkcjach bezpieczeństwa. W ten sposób kontroluję każdy poziom, od BIOS-u po jądro. W przypadku wrażliwych danych i szczytowych obciążeń Bare Metal zapewnia najbardziej niezawodne rezerwy i najmniejsze opóźnienia.

Decydujące znaczenie ma brak sąsiadów na tym samym sprzęcie. W ten sposób unikam Hałaśliwy sąsiad-Efekt całkowity. Realistycznie planuję wydajność i utrzymuję stałą moc. Kto pochodzi ze środowisk współdzielonych, od razu odczuwa różnicę. Szybkie rozpoczęcie pracy jest możliwe dzięki porównaniu, takim jak Hosting współdzielony a hosting dedykowany.

Podstawy sprzętu i sieci dla niezawodnych platform

Podstawa decyduje o możliwościach rozwoju. Wybieram nowoczesne procesory z wystarczającą liczbą rdzeni i wysoką wydajnością pojedynczego wątku, a także pamięć RAM ECC zapewniającą integralność. W przypadku ścieżek danych stawiam na dyski SSD NVMe o wysokiej gęstości IOPS i planuję dedykowane poziomy RAID lub profile ZFS dostosowane do obciążenia. Karty sieciowe z SR-IOV zmniejszają obciążenie i zapewniają stabilne opóźnienia nawet przy dużej przepustowości. 25/40/100 GbE zapewnia rezerwy w zakresie replikacji, ruchu pamięci masowej i komunikacji wschód-zachód.

W przypadku Bare Metal korzystam bezpośrednio z funkcji sprzętowych. W stosach wirtualizowanych używam funkcji passthrough w sposób ukierunkowany: bezpośrednie podłączenie NVMe, przekazywanie SR-IOV-VF do maszyn wirtualnych, procesory z Pinning procesora Przypisuję. W trybie wielodostępnym świadomie ograniczam takie przywileje, aby zapewnić sprawiedliwość i izolację. Przemyślana konstrukcja topologii (Leaf-Spine, oddzielne sieci VLAN, własne sieci zarządzania) zapobiega powstawaniu wąskich gardeł i ułatwia wyszukiwanie błędów.

Hypervisor: typ 1 a typ 2 w praktyce

A hypervisor jest warstwą wirtualizacji pomiędzy sprzętem a maszynami wirtualnymi. Typ 1 działa bezpośrednio na komputerze i minimalizuje obciążenie. Typ 2 działa na istniejącym systemie operacyjnym i dobrze nadaje się do testów. W pracy zazwyczaj korzystam z typu 1, ponieważ liczy się izolacja i wydajność. W przypadku konfiguracji laboratoryjnych używam typu 2 ze względu na łatwość obsługi.

Ważne są CPU‑Pinning, NUMA‑Awareness i Storage‑Caching. Dzięki tym narzędziom kontroluję opóźnienia i przepustowość. Snapshots, Live‑Migration i funkcje HA znacznie skracają przestoje. Wybieram funkcje według obciążenia, a nie według terminów marketingowych. W ten sposób pozostaje Wirtualizacja przewidywalny i wydajny.

Strategie przechowywania danych i układ danych

Pamięć masowa decyduje o odczuwalnej szybkości. Dzielę obciążenia według profilu dostępu: transakcyjne bazy danych na szybkich pulach NVMe o niskim opóźnieniu, zadania analityczne na pamięciach masowych o dużej przepustowości i wysokiej wydajności sekwencyjnej. Buforowanie zapisu zwrotnego Używam tylko z podtrzymaniem bateryjnym/kondensatorowym, w przeciwnym razie istnieje ryzyko utraty danych. TRIM i prawidłowa głębokość kolejki zapewniają długotrwałą wydajność dysków SSD.

W środowiskach wirtualnych wybieram między pamięcią lokalną (niskie opóźnienia, ale skomplikowana wysoka dostępność) a pamięcią współdzieloną (łatwiejsza migracja, ale przeskok sieciowy). Rozwiązania takie jak replikacja na poziomie bloków, Thin Provisioning Dzięki ścisłemu monitorowaniu i oddzielnym poziomom przechowywania (hot/warm/cold) można zrównoważyć koszty i wydajność. Do tworzenia kopii zapasowych używam niezmiennych repozytoriów i regularnie testuję przywracanie danych – nie tylko sprawdzam sumy kontrolne, ale także przeprowadzam rzeczywiste ponowne uruchomienia systemów.

Multi-tenant w przystępny sposób

Wielodostępny Oznacza to, że wielu klientów korzysta z tej samej infrastruktury, ale pozostaje logicznie oddzielonych. Dokonuję precyzyjnej segmentacji zasobów i definiuję limity. Granice bezpieczeństwa na poziomie sieci, hiperwizora i aplikacji chronią dane. Monitorowanie kontroluje obciążenie, operacje wejścia/wyjścia i nietypowe wzorce. W ten sposób utrzymuję koszty na rozsądnym poziomie i elastycznie reaguję na szczyty obciążenia.

Siła tkwi w elastyczności. Mogę szybko przydzielać lub zwalniać zasoby. Modele typu „pay-as-you-go” zmniejszają koszty stałe i sprzyjają eksperymentom. Jednocześnie ustalam surowe ograniczenia, aby zapobiec nadużyciom. Dzięki jasnym Zasady skalowalny, bezpieczny i przewidywalny dla wielu użytkowników.

Planowanie zasobów: świadome zarządzanie nadmiernym zaangażowaniem

Overcommit nie jest tematem tabu, ale narzędziem. Wyznaczam jasne górne granice: umiarkowany overcommit procesora (np. 1:2 do 1:4, w zależności od obciążenia), RAM prawie lub wcale (memory ballooning tylko przy obliczonym obciążeniu), overcommit pamięci masowej z dokładną telemetrią. Ogromne strony stabilizują usługi wymagające dużej pamięci, Powiązanie NUMA zapobiega opóźnieniom cross-socket. Swap rozumiem jako poduszkę powietrzną, a nie tryb jazdy – przydzielone budżety pamięci RAM muszą wystarczyć.

- CPU: przypisz krytyczne rdzenie, zarezerwuj rdzenie hosta dla zadań hiperwizora.

- RAM: Korzystaj z rezerwacji i limitów, unikaj niekontrolowanego balonowania.

- Pamięć masowa: planuj budżety IOPS dla każdego klienta i ustaw harmonogram operacji wejścia/wyjścia odpowiednio do profilu.

- Sieć: QoS dla każdej kolejki, SR‑IOV dla opóźnień, dedykowane ścieżki dla pamięci masowej.

Hałaśliwy sąsiad, izolacja i zauważalna wydajność

Kłaniam się Hałaśliwy sąsiad w sposób ukierunkowany. Limity procesora, ograniczenia wejścia/wyjścia i jakość usług sieciowych chronią usługi przed obciążeniem zewnętrznym. Dedykowane pule pamięci masowej oddzielają dane krytyczne pod względem opóźnień. Oddzielne przełączniki vSwitch i zapory sieciowe wykluczają ruch poprzeczny. Testuję scenariusze za pomocą generatorów obciążenia i mierzę wpływ na działanie.

Przejrzystość buduje zaufanie. Korzystam z wskaźników takich jak opóźnienie P95 i P99 zamiast wartości średnich. Alerty reagują na wahania, a nie tylko na awarie. Dzięki temu mogę wcześnie wykrywać wąskie gardła i podejmować działania. Klienci pozostają odizolowani, a Doświadczenie użytkownika pozostaje stała.

Obserwowalność, testy i niezawodne SLO

Dokładnie mierzę: metryki, logi i ślady łączą się. W przypadku usług stosuję metodę RED (Rate, Errors, Duration), a w przypadku platform metodę USE (Utilization, Saturation, Errors). Definiuję SLO dla każdej usługi – na przykład 99,9% z opóźnieniem P95 poniżej 150 ms – i łączę je z alertami na Budżety błędów. W ten sposób unikam zalewu alarmów i skupiam się na efekcie dla użytkownika.

Przed wprowadzeniem zmian przeprowadzam testy obciążeniowe: bazowe, obciążeniowe, szczytowe i długotrwałe. Sprawdzam, jak zachowują się opóźnienia w przypadku przeciążenia i gdzie występuje przeciwciśnienie. Eksperymenty z chaosem Sprawdź na poziomie sieci, pamięci masowej i procesów, czy funkcje samonaprawy i przełączania awaryjnego naprawdę działają. Syntetyczne kontrole z wielu regionów wykrywają błędy DNS, TLS lub routingu, zanim użytkownicy je zauważą.

Porównanie: Bare Metal, wirtualizacja i multi-tenant

Klasyfikuję modele hostingu według kontroli, wydajności, bezpieczeństwa, skalowalności i ceny. Jeśli potrzebujesz maksymalnej kontroli, wybierz Bare Metal. Jeśli chcesz zachować elastyczność, wybierz wirtualizację opartą na typie 1. W przypadku dynamicznych zespołów i zmiennego obciążenia warto wybrać rozwiązanie wielodostępne. Poniższa tabela przedstawia różnice w skrócie.

| Kryterium | Bare Metal | Wirtualizacja | Wielodostępny |

|---|---|---|---|

| kontrola zasobów | Ekskluzywność, pełna suwerenność | Oparty na VM, precyzyjnie sterowany | Przypisane po stronie oprogramowania |

| Wydajność | Bardzo wysoka, niewielkie obciążenie | Wysoki, niewielki koszt ogólny | Zależy od gęstości |

| Bezpieczeństwo | Fizycznie oddzielone | Izolowane przez hiperwizor | Logiczne rozdzielenie, zasady |

| Skalowanie | Związane ze sprzętem | Szybko przez maszyny wirtualne | Bardzo elastyczny i szybki |

| Cena | Wyższy, możliwy do zaplanowania | Środki, w zależności od wykorzystania | Niski do umiarkowanego |

| Typowe zastosowania | Zgodność, wysokie obciążenie | Wszechstronny, Dev/Prod | SaaS, projekty dynamiczne |

Nigdy nie podejmuję decyzji w izolacji. Biorę pod uwagę architekturę aplikacji, wiedzę zespołu i budżet. Uwzględniam kopie zapasowe, plany DR i obserwowalność. Dzięki temu platforma pozostaje pod kontrolą i Skalowalność. Długoterminowe koszty eksploatacji są równie ważne jak krótkoterminowy czynsz.

Modele operacyjne i automatyzacja

Automatyzuję od pierwszego dnia. Infrastruktura jako kod definiuje sieci, hosty, zasady i limity. Złote obrazy i podpisane linie bazowe ograniczają dryft. Potoki CI/CD tworzą powtarzalne obrazy, aktualizują certyfikaty i uruchamiają wdrożenia typu canary. W przypadku powtarzających się zadań planuję okna serwisowe, zgłaszam je z wyprzedzeniem i przygotowuję ścieżki rollbacku.

Kontrolę zmian konfiguracji przeprowadzam poprzez okresowe audyty i pożądany stan docelowy. Zmiany trafiają na platformę poprzez procesy zmian – są one niewielkie, odwracalne i możliwe do obserwacji. Tajemnice zarządzam w wersjach, z rotacją i krótkotrwałymi tokenami. Dzięki temu działanie pozostaje szybkie, a jednocześnie bezpieczne.

Planowanie kosztów, skalowania i SLA dostosowane do codziennych potrzeb

Uwzględniam nie tylko sprzęt, ale także eksploatację, licencje i wsparcie techniczne. W przypadku rozwiązań typu bare metal planuję rezerwę na części zamienne i okna serwisowe. W środowiskach wielodostępnych uwzględniam zmienne obciążenie i ewentualne rezerwy. Jasna umowa SLA chroni cele dotyczące dostępności i czasów reakcji. W ten sposób koszty i Serwis prostopadły.

Skalowanie rozpoczynam ostrożnie. Skaluję w pionie, o ile ma to sens, a następnie w poziomie. Buforowanie, sieci CDN i fragmentacja baz danych stabilizują czasy odpowiedzi. Przed wdrożeniem mierzę efekty w środowisku testowym. Następnie ustawiam odpowiednie Ograniczenia produktywny.

Planowanie migracji w sposób przejrzysty i minimalizacja uzależnienia od dostawcy

Zaczynam od sporządzenia wykazu: zależności, ilości danych, wymagania dotyczące opóźnień. Następnie podejmuję decyzję między Lift-and-shift (szybko, niewielka przebudowa), Re-Platform (nowa baza, ta sama aplikacja) i Refactoring (większy nakład pracy, ale najskuteczniejszy w dłuższej perspektywie). Dane synchronizuję za pomocą ciągłej replikacji, ostatecznego cutoveru i jasnych poziomów awaryjnych. W razie potrzeby planuję krótkie przestoje w nocy – z drobiazgowym runbookiem.

Aby uniknąć uzależnienia od dostawcy, stawiam na otwarte formaty, standardowe obrazy oraz abstrakcyjne warstwy sieciowe i pamięci masowej. Opracowuję plany wyjścia: jak eksportować dane? Jak replikować tożsamości? Jakie kroki należy wykonać i w jakiej kolejności? Dzięki temu platforma pozostaje elastyczna – nawet w przypadku zmiany środowiska.

Zarządzanie finansami (FinOps) w codziennej praktyce

Aktywnie kontroluję koszty. Wyznaczam cele wykorzystania dla poszczególnych warstw (np. 60–70% CPU, 50–60% RAM, 40–50% Storage‑IOPS), precyzyjnie oznaczam zasoby i zapewniam przejrzystość w ramach zespołów. Optymalizacja wielkości Usuwam obciążenie jałowe, rezerwacje wykorzystuję tylko wtedy, gdy obciążenie podstawowe jest stabilne. Elastycznie radzę sobie z nagłymi wzrostami obciążenia. Showback/Chargeback motywuje zespoły do przestrzegania budżetów i sensownego wnioskowania o zwiększenie mocy obliczeniowych.

Wirtualizacja czy kontenery?

Porównuję maszyny wirtualne z kontenerowanie według gęstości, czasu uruchamiania i izolacji. Kontenery uruchamiają się szybciej i efektywniej wykorzystują zasoby. Maszyny wirtualne zapewniają lepszą separację i elastyczne systemy operacyjne gości. Powszechne są formy mieszane: kontenery na maszynach wirtualnych z hiperwizorem typu 1. Więcej informacji na ten temat przedstawiam w moim przewodniku. Kontenery lub maszyny wirtualne.

Ważny jest cel zastosowania. Jeśli potrzebuje funkcji jądra, używam maszyn wirtualnych. Jeśli potrzebuje wielu krótkotrwałych instancji, używam kontenerów. Oba światy zabezpieczam za pomocą polityk obrazów i podpisów. Segmenty sieci dzielę na drobne części. Dzięki temu wdrożenia pozostają szybkie i czysty.

Sensowne wykorzystanie modeli hybrydowych

Oddzielam wrażliwe dane podstawowe Bare Metal i obsługuję elastyczne interfejsy użytkownika w środowisku wirtualnym lub w klastrze wielodostępnym. W ten sposób łączę bezpieczeństwo z elastycznością. Szczyty ruchu wychwytuję za pomocą automatycznego skalowania i pamięci podręcznej. Przepływ danych zabezpieczam za pomocą oddzielnych podsieci i szyfrowanych łączy. Zmniejsza to ryzyko i pozwala kontrolować koszty.

Czy ta mieszanka jest odpowiednia, pokazuje praktyczne porównanie, jak Bare metal vs. wirtualizacja. Zaczynam od jasnych celów SLO dla każdej usługi. Następnie ustalam cele dotyczące wydajności i ścieżki eskalacji. Regularnie przeprowadzam realistyczne testy przełączania awaryjnego. W ten sposób zapewniam współdziałanie Niezawodny.

Bezpieczeństwo, zgodność z przepisami i monitorowanie na równi

Traktuję Bezpieczeństwo Nie jako dodatek, ale jako stały element działalności. Wzmocnienie bezpieczeństwa zaczyna się od BIOS-u, a kończy na kodzie. Sekrety zarządzam centralnie i wersjonuję. Sieci typu zero trust, MFA i dostęp oparty na rolach są standardem. Łatanie odbywa się według ustalonych cykli z jasno określonymi oknami serwisowymi.

Zgodność z przepisami realizuję poprzez rejestrowanie, śledzenie i ścieżki audytu. Gromadzę logi centralnie i koreluję zdarzenia. Alarmy priorytetyzuję według ryzyka, a nie ilości. Ćwiczenia sprawiają, że zespół jest gotowy do działania. Dzięki temu platforma pozostaje sprawdzalna i Przezroczysty.

Rezydencja danych, koncepcje usuwania danych i zarządzanie kluczami

Jasno określam, gdzie mogą być przechowywane dane i jakie drogi mogą one pokonywać. Szyfrowanie danych w spoczynku oraz w tranzycie są standardem, klucze zarządzam oddzielnie od miejsca przechowywania. Modele BYOK/HYOK stosuję, gdy wymagane jest rozdzielenie operatora i administratora danych. W przypadku usuwania danych stosuję przejrzyste procesy: od logicznego usuwania, poprzez kryptograficzne niszczenie, aż po fizyczne zabezpieczone usuwanie nośników danych. W ten sposób spełniam wymagania dotyczące ochrony danych i identyfikowalności.

Efektywność energetyczna i zrównoważony rozwój

Planuję z myślą o wydajności. Nowoczesne procesory o dobrych parametrach wydajności na wat, gęste konfiguracje NVMe i wydajne zasilacze zmniejszają zużycie energii. Konsolidacja przynosi więcej korzyści niż wyspy: lepiej mieć kilka dobrze wykorzystanych hostów niż wiele półpustych. Optymalizuję chłodzenie i przepływ powietrza poprzez rozmieszczenie szaf rackowych i stref temperaturowych. Pomiar jest obowiązkowy: wskaźniki mocy są uwzględniane w modelach wydajności i kosztów. W ten sposób oszczędzam energię bez utraty wydajności.

Podsumowanie: Pewne posługiwanie się żargonem związanym z hostingiem stron internetowych

Używam Bare Metal, gdy kluczowe znaczenie mają pełna kontrola, stała wydajność i fizyczne oddzielenie. W przypadku elastycznych projektów stawiam na wirtualizację opartą na hiperwizorze i w razie potrzeby łączę ją z kontenerami. Wybieram rozwiązanie wielodostępne, gdy priorytetem jest elastyczność i efektywność kosztowa oraz dobra izolacja. Rozwiązanie hybrydowe łączy mocne strony, oddziela wrażliwe elementy i dynamicznie skaluje się na obrzeżach. Dzięki jasnym pomiarom, automatyzacji i dyscyplinie żargon związany z hostingiem stron internetowych nie stanowi przeszkody, ale jest zestawem narzędzi do tworzenia stabilnych, szybkich platform.