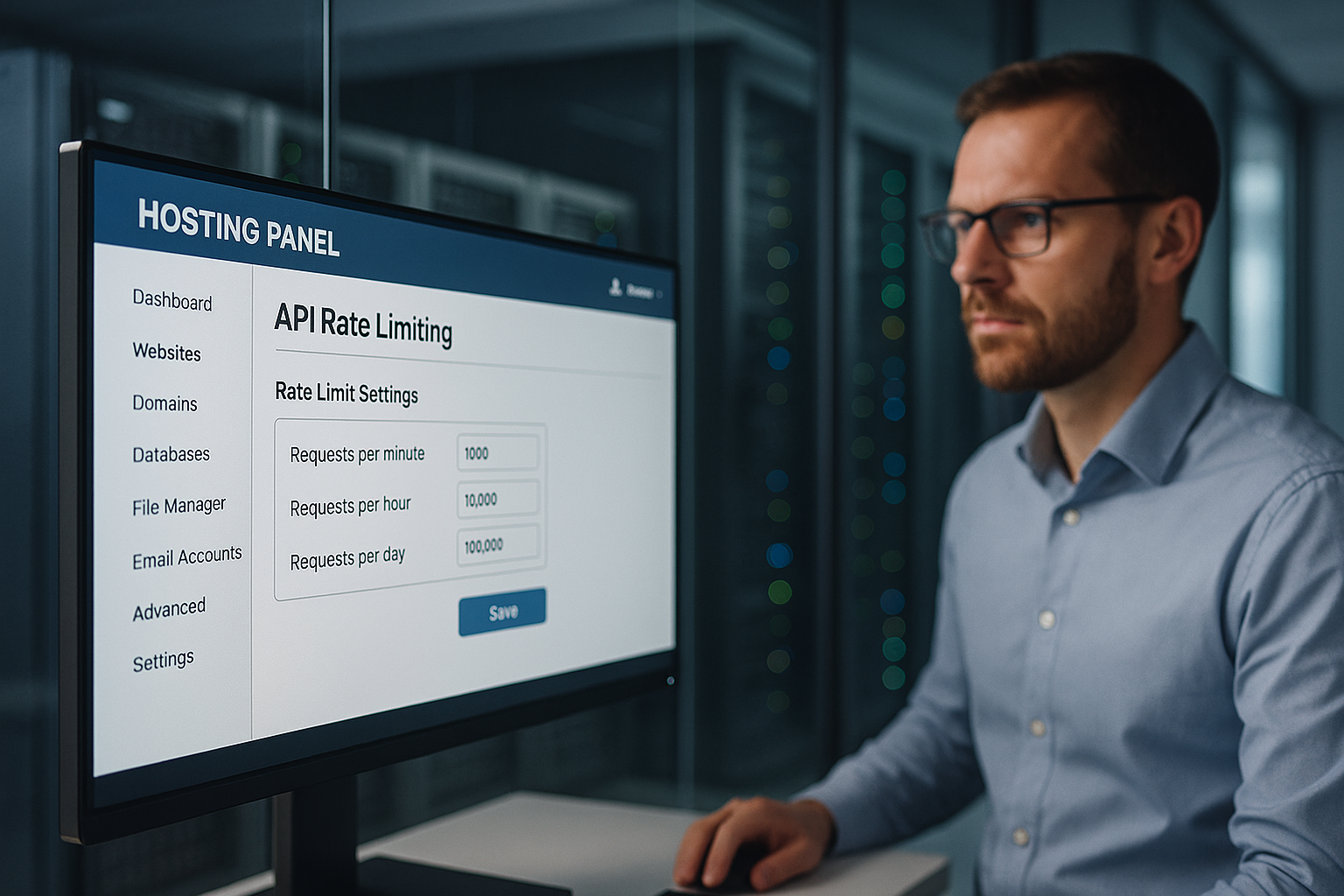

Alojamento com limitação da taxa de API protege um painel de alojamento contra abusos, controlando rigorosamente as taxas de pedidos por IP, chave API e ponto final, evitando assim interrupções, utilização indevida de dados e custos desnecessários. Defino limites a vários níveis, reconheço anomalias numa fase inicial e protejo as funções relevantes para o cliente, como o início de sessão, a faturação e o acesso aos dados, contra DDoS, credential stuffing e picos de carga injustos.

Pontos centrais

- Multicamada Limites: global, utilizador, ponto final

- Algoritmos selecionar: Token/Leaky/Sliding Window

- Transparente Cabeçalho: Limite, Restante, Repor

- Monitorização em tempo real com alertas

- Justo escalonado: quotas por segmento de clientes

Porque é que a limitação da taxa de API é indispensável no painel de alojamento

Utilizo limites claros para evitar isso Atacante Bloquear os pontos de extremidade de login ou de dados com muitos pedidos. Desta forma, os processos legítimos permanecem disponíveis enquanto eu impeço o abuso e mantenho a latência baixa. Qualquer sobrecarga em servidores partilhados custa dinheiro e confiança, pelo que limito os pedidos excessivos a tempo. Evito o escalonamento, ajustando dinamicamente os limites antes que a capacidade se esgote. Os clientes obtêm tempos de resposta consistentes porque eu aplico quotas justas e elimino picos descontrolados.

Como funciona a limitação da taxa: conceitos e algoritmos

Selecciono o algoritmo adequado de acordo com o perfil de carga, a criticidade do ponto final e os picos esperados, porque um bom processo Abuso pára de forma fiável e permite explosões legítimas. Os métodos de janela deslizante suavizam os limites rígidos, o token bucket permite explosões rápidas a curto prazo e o leaky bucket mantém um fluxo uniforme. A janela fixa é adequada para regras simples, mas pode parecer injusta nos limites da janela. Combino métodos quando os pontos de extremidade variam muito, como login vs. conteúdo estático. Isto permite-me controlar os fluxos sem bloqueios desnecessários.

| Algoritmo | Utilização típica | Vantagem para a segurança |

|---|---|---|

| Janela fixa | Modelo de quotas simples | Previsível Contingentes |

| Janela de correr | Alisamento mais preciso | Menos truques nas fronteiras |

| Balde de fichas | Tolerante a explosões | Dicas flexíveis |

| Balde com fugas | Rendimento constante | Limpar o dreno |

Para cada ponto final, documentei o RPS visado, o tamanho da explosão e a reação em caso de violação, para que o Controlo permanece reproduzível. Cada regra é versionada na infraestrutura para que as auditorias possam reconhecer claramente qual o limite aplicável.

Limites em várias camadas: global, utilizador, ponto final

Começo por definir um limite global que define o Plataforma como um todo, para que nenhuma aplicação individual consuma a capacidade. Em seguida, classifico as quotas por cliente, para que as contas premium obtenham mais rendimento sem excluir as outras. Por fim, classifico os terminais por níveis: Autenticação, pagamento, operações de escrita mais restritas; pontos finais de leitura mais generosos. Não bloqueio cegamente as violações de regras, mas primeiro aumento a latência ou peço um backoff antes de tomar medidas mais duras. Isto mantém a experiência do utilizador justa, enquanto os serviços críticos permanecem protegidos.

Medir corretamente os padrões de tráfego

Analiso as horas de ponta típicas, a distribuição por ponto final e a taxa de erro porque estes dados Limites caraterizar. Distingo entre utilização humana e padrões automatizados através da densidade do IP, dos agentes do utilizador e do comportamento dos tokens. Reconheço as anomalias através de um aumento súbito de erros 401/403/429 ou de tempos de resposta erráticos. Destaco as anomalias e, em seguida, testo regras mais rigorosas num ensaio para evitar falsos alarmes. Só quando o comportamento é confirmado como estável é que ativo a aplicação.

Transparência para os clientes: Cabeçalhos e mensagens de erro

Comunico os limites abertamente para que Equipas integram-se de uma forma previsível e recuam no tempo. Incluo as quotas em todas as respostas para que os programadores possam controlar a sua utilização. Mensagens de erro claras ajudam em vez de frustrar. Este é um exemplo que utilizo:

X-RateLimit limite: 120

X-RateLimit-Remaining: 15

X-RateLimit-Reset: 1731187200

Tentar novamente depois: 30

Mantenho os formatos consistentes e descrevo-os na documentação da API para que não haja lacunas na interpretação e a Integração funciona sem problemas.

Limites baseados no custo e na complexidade e simultaneidade

Não só limito a taxa de pedido puro, mas também Complexidade e simultaneidade: os caminhos de computação intensiva recebem „custos“ mais elevados do que as leituras simples. Atribuo uma pontuação por pedido (por exemplo, 1 para GETs simples, 10 para grandes exportações) e acelero de acordo com os custos totais na janela de tempo. Também limito o número máximo de pedidos simultâneos por chave para proteger os pools de backend. As filas de espera com um TTL curto evitam rebanhos estrondosos, enquanto eu partilho equitativamente através do „max-in-flight“. Em caso de sobrecarga, desligo por fases: primeiro o caching de resposta, depois o acelerador de leitura e, finalmente, o de escrita.

Aplicação distribuída em clusters

Eu estabeleço limites a nível do agrupamento para que nenhuma instância se torne um bypass. Utilizo contadores centrais (como o Redis) com incrementos atómicos, TTLs curtos e fragmentação por prefixo de chave para evitar hotspots. Combino contadores de janela deslizante com estruturas probabilísticas (por exemplo, contadores Approx) para volumes muito altos. Intercepto a variação do relógio fazendo com que as gateways sincronizem a sua hora e calculem os tempos de reposição no lado do servidor. Isolei os segmentos em „células“: cada grupo de células define os seus próprios limites para que uma falha permaneça local. Falha fechada para escritas críticas, falha aberta para leituras não críticas - isto mantém o serviço robusto.

Integração Edge/CDN e quotas regionais

Evito que o tráfego passe desnecessariamente para o backend, definindo limites no limite agarrar: as regras relacionadas com o POP impedem os abusos numa fase inicial, enquanto eu defino quotas regionais por continente ou país. Isto mantém os utilizadores próximos rápidos, mesmo que ocorram picos noutros locais. As caches de borda reduzem a pressão sobre os endpoints de leitura; os pedidos condicionais (ETag/If-None-Match) reduzem a carga efectiva. Para APIs multi-regionais, sincronizo os contadores periodicamente e com base em tolerâncias para que as latências não explodam.

Tratamento de clientes: tentativas, backoff e idempotência

Faço com que os clientes sejam bem sucedidos sem pôr em causa a plataforma: Backoff exponencial com Jitter evita tempestades de sincronização; as respostas 429 contêm dicas claras e um valor „Retry-After“. Para os pontos finais de escrita, exijo chaves de idempotência para que as tentativas não causem danos. Utilizo um exemplo de corpo para 429 de forma consistente:

{

"erro": "rate_limited",

"mensagem": "Demasiados pedidos. Por favor, tente novamente após a reinicialização ou após a repetição após",

"limite": 120,

"restante": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Eu documento se „Retry-After“ contém segundos ou uma data, e defino limites superiores claros para o número total de tentativas. Isto mantém os clientes sob controlo e a plataforma estável.

Integração em gateways e balanceadores de carga

Eu movo a limitação de taxa o mais próximo possível da borda: gateway de API primeiro, depois balanceador de carga, depois lógica de aplicação, para que dispendioso Os recursos de back-end não se esgotam em primeiro lugar. As gateways oferecem plug-ins de estrangulamento prontos a utilizar, gestão de cabeçalhos e regras centralizadas. Os balanceadores de carga distribuem as cargas e reconhecem os pontos críticos numa fase inicial. A própria aplicação define controlos finos por ponto final, incluindo controlos anti-repetição e mais rigorosos para as mutações. Se olhar mais de perto para a arquitetura, encontrará Alojamento API-first Um bom ponto de partida para refletir sobre pontos de aplicação limpos.

Defesa contra DDoS, força bruta e preenchimento de credenciais

Reconheço padrões de DDoS através de IPs distribuídos, caminhos uniformes e picos sem profundidade real da sessão e abrando-os com duron quotas por IP e sub-rede. Impeço a força bruta no início de sessão com rajadas bem definidas, acompanhamento de captcha e atrasos progressivos. Exponho o enchimento de credenciais através de fugas conhecidas, séries de tentativas falhadas e impressões digitais. Se os limites forem excedidos, bloqueio temporariamente e exijo verificação adicional. Utilizo sinais para inimigos automatizados Gestão de bots, para que os utilizadores reais não sejam prejudicados.

Equidade e escalonamento: quotas por segmento de clientes

Distribuo as quotas de forma transparente: a empresa recebe orçamentos mais elevados e a Starter orçamentos mais pequenos, para que Custos permanecem previsíveis e todos têm um acesso justo. Exemplo de diretriz: 5.000, 1.000 e 100 pedidos por minuto para Enterprise, Professional e Starter. Caminhos particularmente sensíveis como /auth, /billing ou /write estão abaixo deste valor, enquanto os pontos finais de leitura permanecem mais generosos. Verifico mensalmente se os segmentos ou limites devem ser ajustados, por exemplo, no caso de um novo comportamento dos utilizadores. É assim que asseguro o crescimento sem pôr em causa a qualidade da plataforma.

APIs em tempo real: WebSockets, SSE e streaming

Limito não só os pedidos HTTP, mas também Ligações e taxas de mensagens: O número máximo de ligações WebSocket simultâneas por conta, as mensagens por segundo e os limites de bytes por canal evitam clientes tagarelas. Protejo as transmissões com quotas de canal e separo os eventos do sistema dos eventos do utilizador. Os intervalos de batimento cardíaco e os tempos limite mantêm as ligações zombie no mínimo. Para o SSE, eu reduzo as frequências de reconexão e uso lotes de eventos em cache para suavizar os picos de carga.

Webhooks de entrada e backpressure

Protejo os webhooks de entrada de serviços externos com Buffer de entrada, limites dedicados e disjuntores. Em caso de sobrecarga, respondo com 429/503 incluindo „Retry-After“ e só aceito entregas assinadas e idempotentes. Isolo o processamento de webhooks em filas para evitar o bloqueio das APIs principais e forneço relatórios de entrega para que os parceiros possam ajustar as suas estratégias de repetição.

Proteção de dados e conformidade na telemetria

Registo apenas o que é necessário: hashes em vez de IPs completos, IPs curtos Retenção para registos em bruto, limitação clara da finalidade dos dados de auditoria e de faturação. Os eventos de limite de taxa contêm chaves pseudonimizadas; eu documento os períodos de retenção e os direitos de acesso. Isto garante a conformidade com os requisitos do RGPD sem perder a segurança e a transparência.

Monitorização, alertas e planos de resposta

Monitorizo os volumes de pedidos, as taxas de erro e as latências em janelas curtas para poder precoce reconhecer os padrões de escalada. Defino avisos imediatamente abaixo da capacidade para permitir a tomada de medidas. Se o limiar 95% baixar, aumento os limites ou redistribuo o tráfego. Se a taxa de 5xx aumentar, procuro primeiro as causas: implementações defeituosas, hotspots de bases de dados, pontos de extremidade anómalos. Em seguida, comunico o estado e as soluções alternativas aos clientes antes de aumentar as quotas.

Configuração, testes e implementações seguras

Gerir as regras como Código (controlo de versões, revisão, verificações de CI) e implementar alterações através de sinalizadores de funcionalidades: primeiro modo sombra (apenas medida), depois implementação percentual e, finalmente, aplicação total. As verificações sintéticas verificam 429 caminhos, a consistência do cabeçalho e a lógica de tentar novamente depois. Os testes de caos simulam explosões, fanout de chaves e latência do Redis para que o funcionamento se mantenha estável mesmo sob stress. Coloco na lista branca os clientes de sistema necessários (pipelines de construção, scanners de conformidade) durante um período de tempo limitado para minimizar os falsos alarmes.

Evitar desvios: Bypass, fanout de teclas e normalização

Fecho as brechas que os atacantes poderiam utilizar para ultrapassar os limites: Saída de chave (milhares de chaves únicas) são limitadas com quotas de nível superior por conta, organização e IP/sub-rede. Normalizo os caminhos (maiúsculas/minúsculas, Unicode, rotas de alias) para que os pontos finais idênticos não sejam contados várias vezes. Correlaciono os sinais (IP, ASN, impressão digital do dispositivo, sessão, origem do token) para que as rotações rápidas de IP não conduzam a orçamentos infinitos. Para caminhos particularmente sensíveis, exijo uma autenticação mais forte (âmbito mTLS/OAuth).

Faturação justa pela utilização excessiva

Eu crio Planeamento, oferecendo modelos de descoberto opcionais: quotas adicionais que podem ser reservadas com antecedência, limites automáticos (soft/hard cap) e relatórios mensais transparentes. Isto mantém os custos sob controlo, sem que as equipas tenham de abrandar os projectos temporários. Forneço uma notificação antecipada através de webhooks e correio eletrónico quando as quotas atingem 80/90/100% e sugiro actualizações adequadas antes de os limites rígidos entrarem em vigor.

Afinação: testes, registos e ajustamento contínuo

Valido os limites com testes de carga e de stress, registo 429 eventos de forma granular e personalizo-os. Regras com base na utilização real. Minimizo os falsos positivos com listas de permissões para verificações de conformidade e construção de pipelines. Para APIs com consultas baseadas em gráficos, testo a complexidade do campo para cobrir consultas injustas. Vale a pena dar uma olhadela em GraphQL no painel de alojamento, porque a profundidade da consulta e os limites de custo complementam efetivamente a limitação da taxa. A iteração contínua mantém a proteção e o desempenho em equilíbrio.

Resumo: proteção, equidade e desempenho previsível

Utilizo a limitação de taxa em várias camadas para que Clientes pode funcionar de forma fiável, enquanto os abusos não têm qualquer hipótese. A combinação de algoritmos adequados, comunicação transparente e quotas claras mantém a plataforma reactiva. Minimizo os riscos e mantenho os picos de custos intensivos sob controlo com monitorização e testes. Os modelos de classificação por níveis garantem equidade e espaço para crescimento. Se pensarmos nos limites como regras de produto, obtemos serviços estáveis e utilizadores satisfeitos.