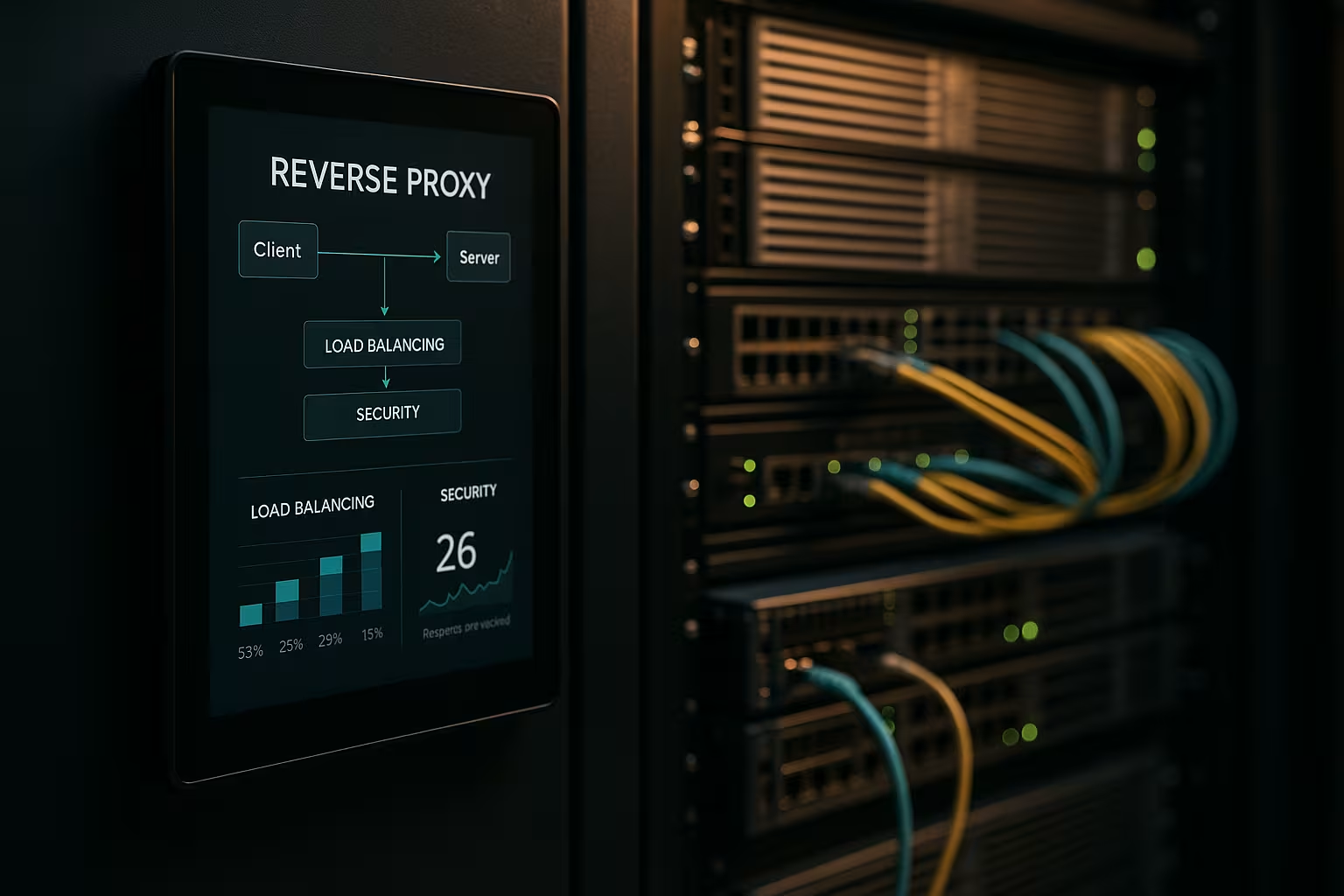

Uma arquitetura de proxy invertido acelera os pedidos, protege os sistemas de backend e dimensiona as aplicações Web sem modificar os servidores de aplicações. Eu mostro como uma Proxy invertido melhora de forma mensurável o desempenho, a segurança e o escalonamento nas operações diárias.

Pontos centrais

- Desempenho através de caching, descarregamento SSL e HTTP/2/3

- Segurança através de WAF, proteção DDoS e bloqueio de IP/geo

- Escalonamento com balanceamento de carga e controlos de saúde

- Controlo graças à centralização do encaminhamento, do registo e da análise

- Prática com NGINX, Apache, HAProxy, Traefik

O que faz uma arquitetura de proxy invertido?

Eu coloquei o Inverter proxy na frente dos servidores de aplicação e faço com que ele termine todas as conexões de entrada. Desta forma, encapsulo a estrutura interna, mantenho os IPs escondidos e minimizo as superfícies de ataque direto. O proxy decide qual o serviço que assume o pedido e pode armazenar conteúdos em cache. Trata do TLS, da compressão e das optimizações de protocolos como o HTTP/2 e o HTTP/3. Isto reduz visivelmente a carga nos servidores de aplicações e dá-me um local para orientações, avaliações e alterações rápidas.

Otimização do desempenho: armazenamento em cache, descarregamento, edge

Eu combino Armazenamento em cacheDescarregamento SSL e entrega de ponta para reduzir as latências. Sirvo activos comuns, como imagens, CSS e JS, a partir da cache, enquanto as partes dinâmicas permanecem frescas (por exemplo, cache de fragmentos). Utilizo políticas como stale-while-revalidate e stale-if-error para reduzir os tempos de espera e garantir a entrega em caso de interrupções. O TLS 1.3, o HTTP/2 push replacement através de early hints e a compressão Brotli proporcionam uma aceleração adicional. Para utilizadores internacionais, o proxy encaminha para nós próximos, o que reduz o tempo até ao primeiro byte. Um olhar sobre o adequado Vantagens e cenários de aplicação mostra quais os ajustes que valem a pena fazer primeiro.

Melhorar a situação de segurança: WAF, DDoS, bloqueio geográfico

Analiso o tráfego em Proxy e filtrar os pedidos maliciosos antes de chegarem aos sistemas backend. Um WAF reconhece padrões como a injeção de SQL ou XSS e bloqueia-os centralmente. A terminação TLS permite a inspeção do fluxo de dados encriptados, após o que o reencaminho de forma limpa. A defesa contra DDoS depende do proxy, que distribui, limita ou bloqueia os pedidos sem tocar nas aplicações. O bloqueio geográfico e de IP corta as fontes conhecidas, enquanto os limites de taxa e a deteção de bots reduzem os abusos.

Escalonamento e alta disponibilidade com balanceamento de carga

Distribuo a carga através de Carga Algoritmos de balanceamento, como Round Robin, Least Connections ou regras ponderadas. Protejo as sessões fixas utilizando a afinidade de cookies se as sessões tiverem de permanecer ligadas a um nó. Os controlos de saúde verificam ativamente os serviços para que o proxy remova automaticamente os alvos defeituosos do grupo. O escalonamento horizontal funciona em minutos: registar novos nós, renovar a configuração, pronto. Para a seleção de ferramentas, uma breve Comparação de ferramentas de balanceamento de carga com destaque para as funções L7.

Gestão centralizada e controlo preciso

Recolho os registos centralmente no Porta de entrada e medir valores-chave como tempos de resposta, débito, taxas de erro e TTFB. Os painéis de controlo mostram hotspots, pontos finais lentos e picos de tráfego. As análises de cabeçalhos (por exemplo, acerto de cache, idade) ajudam a afinar as estratégias de cache. As ID de correlação permitem-me seguir os pedidos entre serviços e acelerar a análise das causas. Defino diretrizes normalizadas para os perfis HSTS, CSP, CORS e TLS uma vez no proxy, em vez de o fazer separadamente em cada serviço.

Rotas, regras e libertações sem risco

Eu controlo Encaminhamento com base no nome do anfitrião, caminho, cabeçalhos, cookies ou informações geográficas. Isto permite-me encaminhar APIs e frontends separadamente, mesmo que sejam executados nos mesmos portos. Implemento as versões Blue-Green e Canary diretamente no proxy, direcionando pequenos grupos de utilizadores para novas versões. Os cabeçalhos de sinalização de recursos ajudam com testes controlados sob tráfego real. Mantenho as janelas de manutenção curtas porque mudo de rota em segundos.

Comparação de tecnologias na prática

Eu escolho o Ferramentaque corresponda aos objectivos de carga, protocolo e funcionamento. O NGINX pontua com conteúdo estático, TLS, HTTP/2/3 e funções eficientes de proxy reverso. O Apache destaca-se em ambientes com .htaccess, módulos extensos e pilhas antigas. O HAProxy proporciona um equilíbrio L4/L7 muito forte e um controlo preciso das verificações de saúde. O Traefik integra-se bem em configurações de contentores e lê rotas dinamicamente a partir de etiquetas.

| Solução | Pontos fortes | Aplicações típicas | Características especiais |

|---|---|---|---|

| NGINX | Elevado Desempenho, HTTP/2/3, TLS | Front-ends da Web, APIs, entrega estática | Brotli, armazenamento em cache, descarregamento de TLS, módulo de fluxo |

| Apache | Modular Flexibilidade.htaccess | Pilhas antigas, instalações com muito PHP | Muitos módulos, tratamento de acesso fino |

| HAProxy | Eficiente Equilíbrio, Controlos de saúde | Balanceador de carga L4/L7, gateway | ACLs muito granulares e sofisticadas |

| Traefik | Dinâmico Descoberta, Foco do contentor | Kubernetes, Docker, microsserviços | Auto-configuração, integração LetsEncrypt |

Etapas de implementação e lista de controlo

Começo por ObjectivosDar prioridade ao desempenho, à segurança, à disponibilidade e ao orçamento. De seguida, defino protocolos, certificados, conjuntos de cifras e versões de protocolos. Defino claramente e versiono as regras de encaminhamento, as políticas de cache e os limites. Configuro os controlos de saúde, a observabilidade e os alertas antes de entrar em funcionamento. Se quiser começar imediatamente, pode encontrar uma visão geral instrutiva em Configurar o proxy invertido para o Apache e o NGINX.

Melhores práticas para a otimização do desempenho

Eu ativo HTTP/3 com QUIC nos casos em que os clientes o suportam e mantenho o HTTP/2 pronto para uma compatibilidade alargada. Utilizo o Brotli para recursos de texto e faço com que o proxy comprima as imagens de forma eficiente. Defino deliberadamente chaves de cache para controlar as variações através de cookies ou cabeçalhos. Minimizo os tempos de handshake do TLS, uso a retomada da sessão e defino o grampeamento OCSP. Utilizo early hints (103) para dar ao browser sinais antecipados para recursos críticos.

Configuração de segurança sem perdas por fricção

Eu seguro Certificados centralmente e automatizar as renovações com o ACME. O HSTS impõe o HTTPS, enquanto o CSP e o CORP controlam o conteúdo. Inicio uma base de regras WAF de forma conservadora e reforço-a gradualmente para evitar falsos alarmes. Limites de taxa, mTLS para serviços internos e listas de IP reduzem o risco no dia a dia. Os registos de auditoria permanecem à prova de adulteração para que eu possa rastrear incidentes com segurança jurídica.

Custos, funcionamento e ROI

Estou a planear Orçamento para recursos de servidor, certificados, proteção DDoS e monitorização. As pequenas configurações começam frequentemente com alguns núcleos virtuais e 4-8 GB de RAM para o proxy, o que representa um custo mensal de dois dígitos de euros, consoante o fornecedor. As frotas maiores utilizam instâncias dedicadas, anycast e nós globais, o que pode significar custos de três dígitos de euros por localização. A gestão centralizada poupa tempo: menos configurações individuais, processos de lançamento mais rápidos e tempos de inatividade mais curtos. O ROI reflecte-se numa maior conversão, em taxas de rejeição mais baixas e numa engenharia mais produtiva.

Variantes e topologias de arquitetura

Escolho a arquitetura de acordo com o perfil de risco e latência. Os ambientes simples funcionam bem com um único Porta de entrada na DMZ, que encaminha os pedidos para os serviços internos. Em ambientes regulamentados ou de grandes dimensões, separo os proxies front-end e back-end em duas fases: a fase 1 termina o tráfego da Internet e lida com WAF, DDoS e caching, a fase 2 encaminha internamente, fala mTLS e impõe princípios de confiança zero. As configurações activas/activas com IP anycast e nós distribuídos globalmente reduzem os tempos de recuperação de falhas e optimizam a proximidade do utilizador. Para CDNs em frente ao proxy reverso, asseguro o encaminhamento correto de cabeçalhos (por exemplo, X-Forwarded-Proto, Real-IP) e hierarquias de cache harmonizadas para que a cache de borda e de gateway não se bloqueiem mutuamente. Encapsulo cenários multilocatários utilizando SNI/TLS, rotas separadas e limites de taxa isolados para evitar efeitos de vizinhança.

Protocolos e casos especiais: WebSockets, gRPC e HTTP/3

Considero os protocolos com requisitos especiais para que as funcionalidades permaneçam estáveis. Para WebSockets O gRPC beneficia do HTTP/2 e de cabeçalhos limpos; evito o H2C (texto simples HTTP/2) no perímetro a favor do TLS com o ALPN correto. Para HTTP/3 Forneço portas QUIC (UDP) e apenas liberto 0-RTT de forma restritiva, uma vez que as repetições comportam riscos. Endpoints de streaming, eventos enviados pelo servidor e grandes uploads recebem suas próprias políticas de buffering e tamanho do corpo para que o proxy não se torne um gargalo. Para traduções de protocolos (por exemplo, HTTP/2 no exterior, HTTP/1.1 no interior), testo exaustivamente a normalização de cabeçalhos, a compressão e a reutilização de ligações para manter as latências baixas e o consumo de recursos previsível.

Autenticação e autorização no gateway

Deslocalizo-me Autenticação-decisões para o proxy reverso se a arquitetura e a conformidade o permitirem. Integro o OIDC/OAuth2 através da verificação de tokens no gateway: o proxy valida as assinaturas (JWKS), verifica a expiração, o público e os âmbitos e define as declarações verificadas como cabeçalhos para os serviços. Utilizo chaves API para pontos de extremidade máquina-a-máquina e limito-as por rota. Para os sistemas internos, baseio-me no mTLS com verificação mútua de certificados para tornar a confiança explícita. Tenho o cuidado de não registar desnecessariamente cabeçalhos sensíveis (autorização, cookies) e utilizo listas de permissão/negação por rota. Formulo políticas detalhadas através de ACLs ou expressões (por exemplo, caminho + método + reivindicação), o que me permite controlar o acesso de forma centralizada sem alterar o código da aplicação.

Resiliência: timeouts, novas tentativas, backoff e interrupção de circuitos

Eu defino Intervalos ciente por salto: estabelecimento da ligação, tempo limite do cabeçalho e tempo limite da resposta. Só ativo tentativas para métodos idempotentes e combino-as com um backoff exponencial mais jitter para evitar rebanhos de trovões. Os disjuntores protegem os pools de backend: Se o proxy detetar picos de erro ou latência, abre o circuito temporariamente, encaminha apenas aleatoriamente para o destino afetado e responde mais cedo, opcionalmente com fallback a partir da cache. A deteção de anomalias remove automaticamente as instâncias "fracas" do grupo. Também limito os upstreams simultâneos, ativo a reutilização de ligações e utilizo filas com uma priorização justa. Isto garante que os serviços permaneçam estáveis mesmo que os componentes individuais estejam sob pressão.

Conformidade, proteção de dados e proteção de PII

Eu trato o proxy como Plataforma de dados com regras claras de proteção de dados. Mascaro ou pseudonimizo os dados pessoais nos registos; as cadeias de consulta e os cabeçalhos sensíveis só são registados numa base de lista branca. Sempre que possível, encurto os endereços IP e cumpro períodos de retenção rigorosos. O acesso aos registos e às métricas baseia-se em funções e as alterações são documentadas de forma a serem comprovadas por auditoria. Para as auditorias, estabeleço uma ligação entre os eventos de gateway e as entradas de gestão de alterações, para que as aprovações e as actualizações de regras possam ser controladas. Isto permite-me cumprir os requisitos de conformidade sem sacrificar as informações profundas sobre o desempenho e a segurança.

Kubernetes, API Ingress e Gateway

Eu integro o proxy reverso sem problemas no Orquestração de contentores. No Kubernetes, utilizo controladores de entrada ou a API de gateway mais moderna para descrever o encaminhamento, o TLS e as políticas de forma declarativa. O Traefik lê rótulos dinamicamente, o NGINX/HAProxy oferece variantes de entrada sofisticadas para alta taxa de transferência. Separo o roteamento leste/oeste interno do cluster (malha de serviço) do gateway de perímetro norte/sul para que as responsabilidades permaneçam claras. Implemento versões canárias com rotas ponderadas ou correspondências de cabeçalhos, definindo rigorosamente as verificações de saúde e a prontidão dos pods para evitar oscilações. Versiono as configurações como código e testo-as em clusters de teste com simulação de carga antes de entrar em funcionamento.

Maturidade operacional: gestão da configuração e CI/CD

Eu trato a configuração do proxy como Código. As alterações são executadas através de pedidos pull, são automaticamente testadas (sintaxe, linting, verificações de segurança) e lançadas em pipelines. Utilizo pré-visualizações ou tráfego sombra para validar novas rotas em condições reais sem arriscar as transacções dos clientes. Os rollbacks são possíveis em segundos, porque etiqueto as versões e faço a sua implementação atomicamente. Gerencio segredos sensíveis (certificados, chaves) separadamente, encriptados e com autorizações mínimas. Para garantir uma elevada disponibilidade, distribuo as versões pelos nós de forma escalonada e registo os efeitos em painéis de controlo para poder tomar rapidamente medidas preventivas em caso de regressão.

Obstáculos e antipadrões típicos

Eu evito Fontes de erroque ocorrem frequentemente na prática. Evito o envenenamento da cache com uma normalização rigorosa do cabeçalho e uma gestão limpa do Vary; excluo da chave da cache os cookies que não afectam a renderização. Reconheço loops de redireccionamento desde o início, testando com X-Forwarded-Proto/Host e políticas HSTS/CSP consistentes. "Confiar em todos os X-Forwarded-For" é tabu: confio apenas no próximo salto e defino o Real-IP de forma limpa. Eu controlo grandes uploads através de limites e streaming para que o proxy não faça buffer, o que o backend pode fazer melhor. Com 0-RTT no TLS 1.3, presto atenção à idempotência. E fico de olho nos tamanhos do corpo e do cabeçalho para que as solicitações individuais não ocupem toda a capacidade do trabalhador.

Resumo para decisões rápidas

Estou a apostar num Inverter porque combina velocidade, proteção e escalonamento num único local. O armazenamento em cache, a descarga de TLS e o HTTP/2/3 aceleram significativamente os tempos de carregamento reais. O WAF, a defesa DDoS e o controlo IP/geo reduzem significativamente os riscos. O balanceamento de carga, as verificações de saúde e os lançamentos contínuos mantêm os serviços disponíveis, mesmo durante o crescimento. Com NGINX, Apache, HAProxy ou Traefik, encontro uma solução clara para cada configuração e mantenho as operações geríveis.