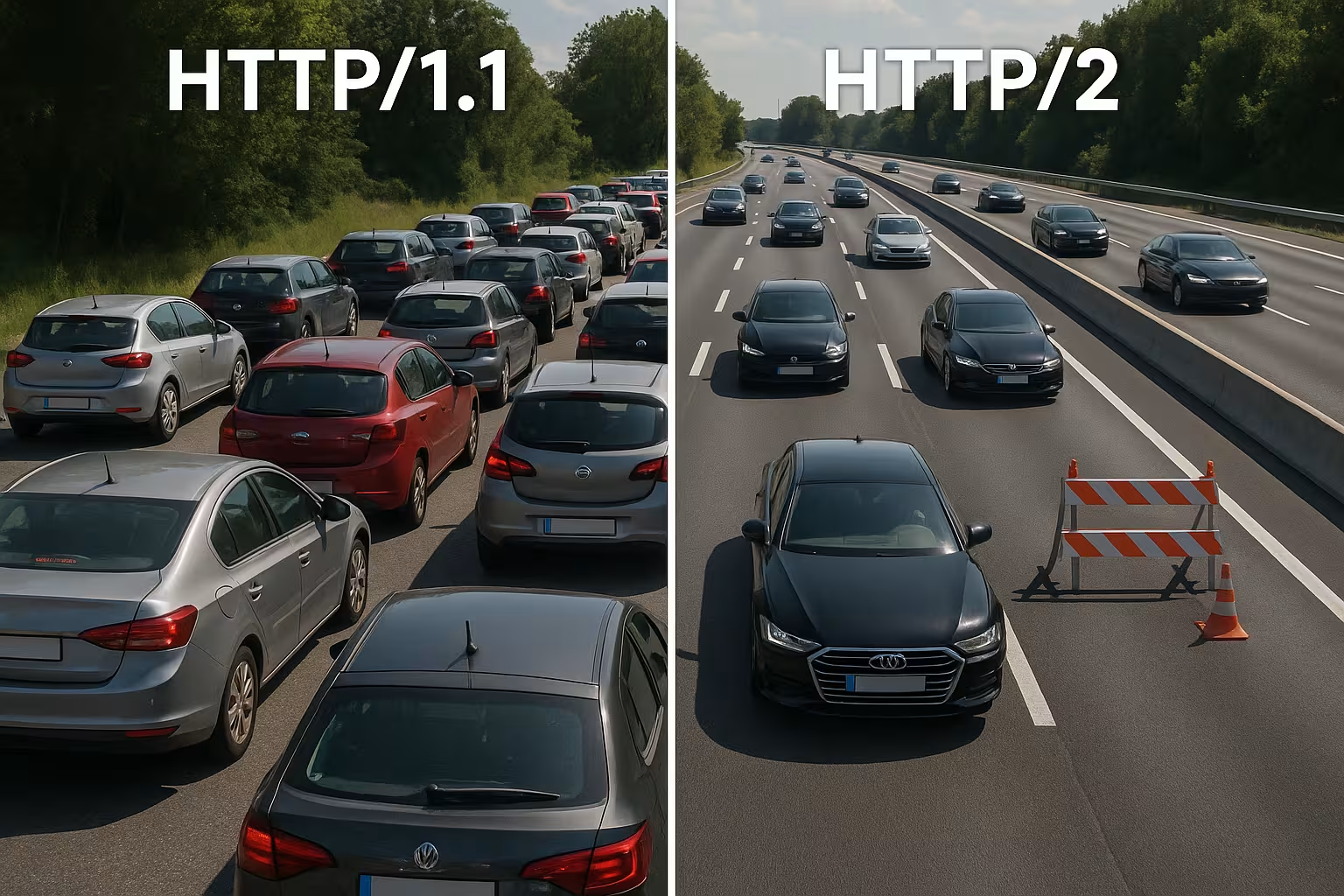

Multiplexação HTTP/2 agrupa muitas solicitações numa única ligação e elimina bloqueios ao nível do protocolo. No entanto, em redes reais, o TCP Head-of-Line, a sobrecarga TLS e a priorização inadequada causam lentidão, de modo que o HTTP/2 não funciona automaticamente mais rápido que o HTTP/1.1.

Pontos centrais

- Multiplexagem Paraleliza muitas solicitações através de uma única ligação TCP.

- TCP-HoL permanece ativo e interrompe todas as transmissões em caso de perdas.

- Configuração TLS pode atrasar significativamente o tempo até ao primeiro byte.

- Prioridades e o Server Push só funcionam com um ajuste preciso.

- Tipo de página decide: muitos ficheiros pequenos vs. poucos ficheiros grandes.

Como funciona internamente o multiplexing HTTP/2

Eu divido cada resposta em pequenas partes. Quadros, numere-os e organize-os em fluxos lógicos para que vários recursos possam ser executados simultaneamente através de uma única ligação. Assim, evito bloqueios ao nível do HTTP, porque nenhuma solicitação precisa esperar pelo fim de outra. Os navegadores enviam HTML, CSS, JS, imagens e fontes em paralelo, reduzindo os custos de ligações adicionais. O HPACK reduz os cabeçalhos, o que diminui significativamente a carga em muitos ficheiros pequenos. No entanto, o importante continua a ser: todos os fluxos partilham a mesma linha TCP, o que cria vantagens, mas também gera novas dependências. Esta arquitetura proporciona velocidade, desde que a rede permaneça estável e a Definição de prioridades funciona de forma sensata.

HTTP/1.1 vs. HTTP/2: principais diferenças

O HTTP/1.1 utiliza mensagens baseadas em texto e várias ligações paralelas por host para carregar recursos simultaneamente, o que aumenta os handshakes e a sobrecarga. O HTTP/2 funciona em binário, utiliza uma única ligação para tudo e comprime os cabeçalhos, reduzindo os tempos de espera, especialmente quando há muitos objetos. Nos diagramas em cascata, as longas filas desaparecem porque os fluxos avançam em paralelo. Em contrapartida, o gargalo passa da camada HTTP para a camada TCP, o que sinto claramente em redes instáveis. Páginas pequenas e fortemente armazenadas em cache muitas vezes apresentam poucas vantagens em relação à versão 1.1, enquanto páginas grandes e ricas em recursos se beneficiam de forma mais visível. Essas diferenças moldam a minha Estratégia de ajuste e justificam uma decisão específica para o projeto.

Selecionar corretamente o controlo de fluxo e os tamanhos das janelas

O HTTP/2 traz o seu próprio controlo de fluxo por stream e por ligação. Presto atenção a valores significativos para TAMANHO INICIAL DA JANELA e o número de transmissões simultâneas, para que a linha não fique congestionada nem subutilizada. Janelas muito pequenas geram um número desnecessário de ATUALIZAÇÃO DA JANELA-Frames e reduzem a taxa de dados; janelas demasiado grandes podem sobrecarregar clientes mais fracos. Em redes com elevado produto largura de banda-atraso (BDP), aumento o tamanho da janela de forma específica, para que respostas grandes não fiquem presas no stop-and-go. Ao mesmo tempo, limito MAX_CONCURRENT_STREAMS Pragmático: paralelismo suficiente para elementos críticos de renderização, mas não tanto a ponto de pequenos detalhes prejudicarem a imagem LCP. Esses ajustes são pequenos, mas têm um grande impacto nos tempos de carregamento reais quando adequados ao site e à rede.

Reavaliar o fragmentação de domínios e o agrupamento

Muitas otimizações 1.1 são contraproducentes no HTTP/2. Eu elimino o antigo domain sharding, porque uma única conexão bem utilizada é mais eficiente do que sockets distribuídos artificialmente. Também questiono o aggro bundling de JavaScript para mega arquivos: pacotes menores e separados logicamente permitem caches direcionados e evitam que toda a aplicação tenha de ser transferida novamente em caso de alteração. Os sprites de imagem estão a perder importância, porque as solicitações paralelas se tornaram baratas e os formatos de imagem modernos, incluindo o cache, funcionam melhor. Portanto, eu desagreguei onde o multiplexing pode ganhar e só agrupo quando isso realmente simplifica a arquitetura ou aumenta significativamente a taxa de acertos do cache.

Coalescência de ligações e certificados

O HTTP/2 permite que os navegadores utilizem uma ligação para vários nomes de host, desde que os certificados e o DNS sejam compatíveis. Eu planeio entradas SAN e SNI de forma a permitir a coalescência e eliminar handshakes adicionais. Se o ALPN e os conjuntos de cifras forem compatíveis, o cliente pode utilizar CSS de cdn.example.com e imagens de static.example.com através da mesma linha. Isso poupa RTTs, simplifica a priorização e aumenta a probabilidade de que os ativos críticos cheguem sem desvios. Eu verifico esses efeitos especificamente no separador Rede: será que é realmente utilizado apenas um socket ou será que os limites dos certificados e as políticas obrigam o navegador a estabelecer novas ligações?

Por que o multiplexing é desacelerado: TCP Head-of-Line

Se um pacote for perdido na única ligação TCP, toda a linha aguarda até que a retransmissão chegue, o que interrompe temporariamente todos os fluxos HTTP/2. Em redes móveis com latência variável e taxa de perda elevada, vejo regularmente ganhos menores ou mesmo desvantagens em comparação com várias ligações 1.1. Este efeito explica por que o multiplexing brilha no papel, mas nem sempre funciona na prática. Medições de investigação e de campo mostram exatamente essa relação em redes reais [6]. Por isso, planeio implementações de forma conservadora, testo em percursos típicos de utilizadores e verifico os efeitos para cada grupo-alvo. Quem ignora o TCP-HoL desperdiça Desempenho e pode até prolongar os tempos de carregamento.

Handshake TLS, TTFB e tipo de página

O HTTP/2 funciona na Web quase exclusivamente através do TLS, o que gera handshakes adicionais e pode prolongar significativamente o tempo até ao primeiro byte em poucos ativos. Se eu entregar apenas um ficheiro grande, a vantagem da multiplexagem desaparece, porque não é necessária nenhuma transmissão paralela. Páginas com dez a vinte ficheiros pequenos tendem a beneficiar mais, enquanto respostas de um único recurso costumam ficar no mesmo nível do HTTP/1.1. Reduzo a sobrecarga com TLS 1.3, retomada de sessão e keep-alive limpo, para que não haja reconexões e a linha fique realmente ativa. Para o controle preciso, aposto em Ajuste Keep-Alive, para definir reutilizações, tempos de espera e limites adequados à carga. Isso reduz a proporção de handshakes e a TTFB estabiliza-se mesmo em picos de tráfego.

CDN e cadeias de proxy: h2 até à origem

Muitas pilhas terminam o TLS na borda e continuam a comunicar com a origem. Verifico se o HTTP/2 também é utilizado entre o CDN e o backend ou se ocorre um regresso ao HTTP/1.1. Os proxies de buffer podem anular parcialmente as vantagens (compressão de cabeçalhos, priorização) quando resseralizam respostas ou alteram sequências. Por isso, otimizo de ponta a ponta: o nó de borda, o proxy intermediário e a origem devem compreender h2, utilizar tamanhos de janela adequados e não ignorar prioridades. Quando h2c (HTTP/2 sem TLS na rede interna) faz sentido, testo se ele economiza latência e CPU sem violar as políticas de segurança. Somente uma cadeia coerente desenvolve o MultiplexagemEfeito completo.

Utilizar corretamente a priorização

Eu classifico os recursos críticos como prioritários para que HTML, CSS e a imagem LCP cheguem primeiro e os bloqueios de renderização sejam eliminados. Sem prioridades claras, scripts menos importantes consomem largura de banda valiosa, enquanto o conteúdo acima da dobra espera. Nem todos os servidores respeitam corretamente as prioridades do navegador, e alguns proxies alteram a ordem, por isso eu avalio dados de resultados em vez de suposições [8]. Os cabeçalhos de pré-carregamento e uma referência de imagem colocada antecipadamente encurtam os caminhos de carregamento e aumentam a taxa de acertos na cache. A priorização não faz mágica, mas direciona a conexão de forma que os utilizadores vejam rapidamente o que precisam. Regras claras trazem resultados tangíveis. Impulso e tornam a multiplexação realmente eficaz.

Priorização na prática: Prioridades extensíveis

Os navegadores aperfeiçoaram os seus modelos de priorização. Levo em consideração que os clientes modernos costumam usar „prioridades extensíveis“ em vez de pesos rígidos em árvore. Assim, eles sinalizam urgência e parâmetros progressivos por fluxo, que os servidores precisam interpretar e traduzir em agendadores justos. Verifico se o meu servidor respeita esses sinais ou se se baseia no comportamento antigo. Em testes A/B, comparo caminhos de carregamento com e sem priorização do lado do servidor para identificar efeitos de deslocamento. Importante: a priorização deve dar preferência ao que é crítico para a renderização, mas não deve levar à escassez de downloads de longa duração. Uma combinação cuidadosa evita picos e mantém o pipeline livre para conteúdos visíveis.

Server Push: raramente a abreviação

Eu uso o Server Push apenas de forma seletiva, porque o Over-Pushing ocupa largura de banda e ignora os caches do navegador. Se um recurso já armazenado em cache for empurrado, o caminho fica mais lento em vez de mais rápido. Muitas equipas desativaram o Push e utilizam o Preload, que é significativamente mais confiável [8]. Em casos especiais, como em rotas recorrentes com padrões claros, o push pode ser útil, mas eu comprovo o efeito com valores medidos. Sem comprovação, removo o push e mantenho o pipeline livre para dados realmente necessários. Menos é mais, neste caso. mais, mesmo na única ligação.

Comparação prática: quando o HTTP/1.1 pode ser mais rápido

Considero o HTTP/1.1 competitivo quando poucos ficheiros grandes dominam ou quando as redes operam com perdas mais elevadas. Várias ligações separadas distribuem então o risco e podem reduzir os tempos de primeiro byte individuais. Em páginas muito pequenas, os handshakes TLS adicionais compensam frequentemente por completo os benefícios da multiplexação. Por outro lado, com muitos objetos pequenos, o HTTP/2 se destaca porque a compressão, a priorização e um único socket são eficazes. A visão geral a seguir mostra padrões típicos de auditorias e testes de campo que orientam a minha escolha do protocolo [6][8]. Essa grade não substitui os testes, mas fornece uma base sólida. Orientação para as primeiras decisões.

| Cenário | Melhor protocolo | Motivo |

|---|---|---|

| Muitos pequenos recursos (CSS/JS/imagens/fontes) | HTTP/2 | Multiplexagem e HPACK reduzem a sobrecarga, uma ligação é suficiente |

| Poucos ficheiros muito grandes | HTTP/1.1 ≈ HTTP/2 | Pouca necessidade de paralelismo; os custos do handshake têm maior peso |

| Redes móveis instáveis com perdas | HTTP/1.1 parcialmente melhor | O TCP‑HoL interrompe todos os fluxos no HTTP/2; vários sockets podem ajudar |

| TLS otimizado (1.3, retomada), prioridades claras | HTTP/2 | Configuração reduzida, controlo específico da largura de banda |

| Over-Pushing ativo | HTTP/1.1/HTTP/2 sem push | Dados desnecessários bloqueiam a linha; o pré-carregamento é mais seguro |

Melhores práticas para ganhos reais no tempo de carregamento

Eu reduzo os bytes antes do protocolo: imagens em WebP/AVIF, tamanhos adequados, scripts econômicos e cabeçalhos de cache limpos. Eu mantenho pequenas as partes críticas do caminho CSS, carrego as fontes antecipadamente e defino fallbacks para evitar alterações no layout. Para estabelecer a ligação e o DNS, eu uso Pré-conexão e pré-busca de DNS, para que os handshakes comecem antes que o analisador encontre o recurso. O Brotli para conteúdos de texto acelera as recuperações recorrentes, especialmente através de CDNs. Eu controlo os efeitos na cascata e comparo LCP, FID e TTFB antes e depois das alterações. Os valores medidos orientam a minha Prioridades, intuição não.

gRPC, SSE e casos de streaming

O HTTP/2 mostra os seus pontos fortes especialmente no gRPC e noutros fluxos bidirecionais ou de longa duração. Presto atenção aos tempos limite, tamanhos de buffer e regras de congestionamento, para que um fluxo lento não prejudique todas as outras solicitações. Para eventos enviados pelo servidor e feeds ao vivo, uma conexão estável e duradoura é útil, desde que o servidor gerencie as prioridades corretamente e os limites de keep-alive não sejam aplicados prematuramente. Ao mesmo tempo, testo como os erros se comportam: a reconstrução de fluxos, o backoff exponencial e limites razoáveis para reconexões evitam picos de carga quando muitos clientes se desconectam e se reconectam simultaneamente. Assim, os cenários em tempo real permanecem previsíveis.

Ajuste do SO e TCP para um desempenho de multiplexação estável

A escolha do protocolo não encobre uma configuração de rede fraca. Eu verifico algoritmos de controlo de congestionamento (por exemplo, BBR vs. CUBIC), buffers de socket, políticas TCP Fast Open e o tamanho da janela de congestionamento inicial. Um controlo de congestionamento adequado ao caminho pode reduzir as retransmissões e atenuar os efeitos HoL. Igualmente importante: valores MTU/MSS corretos para evitar fragmentação e perdas evitáveis. No nível TLS, prefiro cadeias de certificados curtas, OCSP stapling e certificados ECDSA, porque aceleram o handshake. Em conjunto, essas configurações fornecem ao multiplexing o necessário Subestrutura, para que a priorização e a compressão de cabeçalhos possam ter efeito.

Estratégia de medição e KPIs no dia a dia

Não confio nos valores medianos, mas analiso os p75/p95 das métricas, separados por dispositivo, tipo de rede e localização. Os testes sintéticos fornecem valores básicos reproduzíveis, enquanto a monitorização de utilizadores reais mostra a dispersão no campo. Eu comparo quedas em cascata de caminhos-chave, verifico os primeiros bytes de HTML, a sequência de CSS/JS e a hora de chegada da imagem LCP. Eu implemento as alterações como experiências controladas e observo o TTFB, o LCP e as taxas de erro em paralelo. Importante: removo priorizações sem benefício mensurável. Assim, a configuração permanece enxuta e invisto em ajustes que economizam tempo de forma estatisticamente comprovada.

Tráfego de rastreamento e de bots

Além dos utilizadores, os rastreadores também beneficiam de um HTTP/2 limpo. Eu ativo o h2 para pontos finais relevantes e observo se os bots reutilizam a ligação e recuperam mais páginas no mesmo tempo. Cascatas 301 desnecessárias, respostas não comprimidas ou limites de keep-alive muito curtos custam orçamento de rastreamento. Eu coordeno as políticas para que o multiplexing também funcione aqui, sem ultrapassar os limites do backend. Resultado: varreduras mais eficientes e mais estabilidade sob carga.

HTTP/2, HTTP/3 e o que vem a seguir

O HTTP/3 utiliza QUIC sobre UDP e resolve o bloqueio TCP Head-of-Line, o que ajuda significativamente na mobilidade e nas perdas [6]. O estabelecimento da ligação é mais rápido e os bloqueios de fluxo já não afetam todas as solicitações simultaneamente. Em frotas mistas, o HTTP/2 continua a ser importante, mas eu ativo o HTTP/3 onde os clientes e CDNs já o suportam. Comparações detalhadas, como HTTP/3 vs. HTTP/2 ajudam-me a planear implementações por fases e de acordo com o público-alvo. Faço medições separadas por localização, dispositivo e tipo de rede, para que os utilizadores reais beneficiem. Assim, utilizo protocolos para Tempos de carregamento em situações do dia a dia.

Hospedagem e infraestrutura como aceleradores

Bons protocolos não salvam uma infraestrutura fraca, por isso verifico cuidadosamente a localização, o peering, a CPU, a RAM e os limites de E/S. Um servidor web moderno, um número razoável de trabalhadores e uma camada de cache impedem que a única ligação acabe num estrangulamento. A utilização estratégica de CDN reduz o RTT e amortece os picos de carga. Quem atende utilizadores em toda a Europa muitas vezes se beneficia mais de distâncias curtas do que do ajuste fino de protocolos. Eu planeio a capacidade com reservas para que o tráfego de pico não cause lentidão. É assim que o multiplexing se desenvolve. Potencial fiável.

Reconhecer rapidamente padrões de erro

Se o HTTP/2 parecer mais lento do que o esperado, procuro padrões típicos: uma única transmissão longa que bloqueia muitas pequenas; prioridades que são ignoradas; altas taxas de retransmissão em rotas móveis; ou retomada TLS que não funciona. Em seguida, comparo o HTTP/2 e o HTTP/1.1 em condições idênticas, separo a influência do CDN da origem e verifico o número de sockets, o número real de streams e a sequência dos primeiros kilobytes. Se encontrar um gargalo, primeiro ajusto os fundamentos (bytes, cache, handshakes) antes de refinar o controlo de fluxo ou as prioridades. Essa sequência proporciona as melhorias mais confiáveis.

Resumo prático para decisões rápidas

Eu uso o multiplexing HTTP/2 quando há muitos objetos, prioridades em vigor e o TLS está configurado corretamente. Com poucos ficheiros grandes ou redes instáveis, calculo pequenas vantagens e fico atento aos resultados da versão 1.1. Utilizo o Server Push apenas com evidência, o Preload quase sempre, e mantenho a sobrecarga baixa através de compressão, cache e ligações precoces. As medições com dispositivos e locais reais confirmam as minhas suposições antes de implementar alterações em grande escala [6][8]. No final, o que conta não é o número do protocolo, mas a velocidade perceptível para os utilizadores reais. Quem procede desta forma obtém resultados fiáveis do HTTP/2. Velocidade e estabelece a base para o HTTP/3.