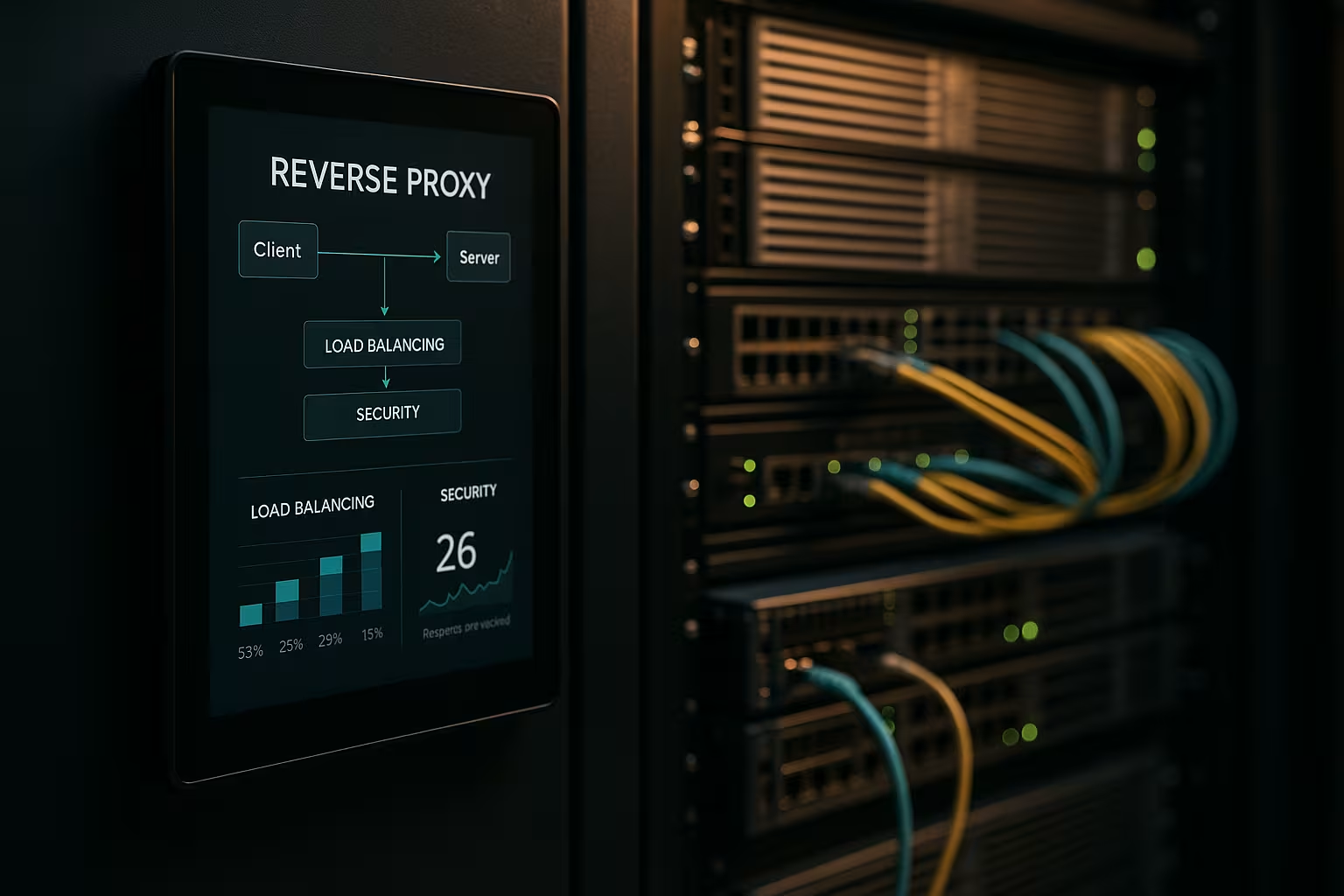

O arhitectură de proxy invers accelerează cererile, protejează sistemele backend și scalează aplicațiile web fără a modifica serverele de aplicații. Vă arăt cum o Reverse proxy îmbunătățește în mod măsurabil performanța, securitatea și scalarea în operațiunile de zi cu zi.

Puncte centrale

- Performanță prin caching, descărcare SSL și HTTP/2/3

- Securitate prin WAF, protecție DDoS și IP/geo-blocare

- Scalare cu echilibrare a sarcinii și verificări ale stării de sănătate

- Control datorită direcționării, înregistrării și analizei centralizate

- Practică cu NGINX, Apache, HAProxy, Traefik

Ce face o arhitectură de proxy invers?

Am setat Inversare proxy în fața serverelor de aplicații și îl pun să termine toate conexiunile de intrare. În acest fel, încapsulez structura internă, mențin IP-urile ascunse și minimizez suprafețele de atac direct. Proxy-ul decide ce serviciu preia cererea și poate stoca conținutul în cache. Se ocupă de TLS, de compresie și de optimizarea protocoalelor, cum ar fi HTTP/2 și HTTP/3. Acest lucru reduce considerabil sarcina serverelor de aplicații și îmi oferă un loc pentru orientări, evaluări și schimbări rapide.

Optimizarea performanței: caching, offloading, edge

Eu combin CachingSSL offloading și edge delivery pentru a reduce latențele. Servesc active comune precum imagini, CSS și JS din cache, în timp ce părțile dinamice rămân proaspete (de exemplu, fragment caching). Folosesc politici precum stale-while-revalidate și stale-if-error pentru a reduce timpii de așteptare și a asigura livrarea în caz de întreruperi. TLS 1.3, HTTP/2 push replacement via early hints și compresia Brotli asigură o accelerare suplimentară. Pentru utilizatorii internaționali, proxy-ul rutează către noduri apropiate, ceea ce reduce timpul până la primul byte. O privire asupra soluțiilor adecvate Avantaje și scenarii de aplicare arată care sunt ajustările care merită mai întâi.

Îmbunătățirea situației de securitate: WAF, DDoS, geo-blocare

Analizez traficul pe Proxy și filtrează cererile rău intenționate înainte ca acestea să ajungă la sistemele backend. Un WAF recunoaște modele precum injecția SQL sau XSS și le oprește la nivel central. Terminarea TLS permite inspectarea fluxului de date criptat, după care îl redirecționez curat. Apărarea DDoS depinde de proxy, care distribuie, limitează sau blochează solicitările fără a atinge aplicațiile. Blocarea geo și IP elimină sursele cunoscute, în timp ce limitarea vitezei și detectarea roboților împiedică abuzurile.

Scalare și disponibilitate ridicată cu echilibrarea încărcăturii

Distribuie sarcina prin Încărcare Algoritmi de echilibrare precum Round Robin, Least Connections sau reguli ponderate. Securizez sesiunile lipicioase folosind afinitatea cookie dacă sesiunile trebuie să rămână legate de un nod. Verificările de sănătate verifică în mod activ serviciile, astfel încât proxy-ul să elimine automat obiectivele defecte din pool. Scalarea orizontală funcționează în câteva minute: înregistrați noduri noi, reînnoiți configurația, gata. Pentru selectarea instrumentelor, o scurtă Compararea instrumentelor de echilibrare a sarcinii cu accent pe funcțiile L7.

Gestionare centralizată și monitorizare precisă

Colectez jurnalele în mod centralizat la Gateway și măsurați cifrele cheie, cum ar fi timpii de răspuns, debitul, ratele de eroare și TTFB. Tablourile de bord arată punctele fierbinți, punctele finale lente și vârfurile de trafic. Analizele de antet (de exemplu, accesarea cache-ului, vârsta) ajută la reglarea fină a strategiilor de cache. ID-urile de corelație îmi permit să urmăresc cererile între servicii și să accelerez analizele cauzelor principale. Stabilesc orientări standardizate pentru profilurile HSTS, CSP, CORS și TLS o dată la proxy, în loc să le stabilesc separat pentru fiecare serviciu.

Rute, reguli și eliberări fără riscuri

I control Rutare pe baza numelui de gazdă, a căii, a antetelor, a modulelor cookie sau a informațiilor geografice. Acest lucru îmi permite să direcționez API-urile și front-end-urile separat, chiar dacă acestea rulează pe aceleași porturi. Implementez versiunile Blue-Green și Canary direct pe proxy prin direcționarea grupurilor mici de utilizatori către noile versiuni. Feature flag headers ajută la testele controlate în condiții de trafic real. Mențin ferestrele de întreținere scurte, deoarece schimb rutele în câteva secunde.

Compararea tehnologiilor în practică

Îl aleg pe Instrumentcare se potrivește cu sarcina, protocolul și obiectivele de operare. NGINX punctează cu conținut static, TLS, HTTP/2/3 și funcții eficiente de proxy invers. Apache strălucește în mediile cu .htaccess, module extinse și stive vechi. HAProxy oferă o echilibrare L4/L7 foarte puternică și un control fin asupra verificărilor de sănătate. Traefik se integrează bine în configurațiile containerizate și citește rutele dinamic din etichete.

| Soluție | Puncte forte | Aplicații tipice | Caracteristici speciale |

|---|---|---|---|

| NGINX | Înaltă Performanță, HTTP/2/3, TLS | Front-end-uri web, API-uri, livrare statică | Brotli, caching, TLS offloading, modul de flux |

| Apache | Modulare Flexibilitate.htaccess | Stack-uri vechi, instalații PHP | Multe module, gestionare fină a accesului |

| HAProxy | Eficientă Echilibrarea, Controale de sănătate | Balansator de sarcină L4/L7, gateway | ACL-uri foarte granulare și sofisticate |

| Traefik | Dinamică Descoperire, Container focus | Kubernetes, Docker, microservicii | Auto-configurare, integrare LetsEncrypt |

Etape de implementare și listă de verificare

Încep cu ObiectivePrioritizez performanța, securitatea, disponibilitatea și bugetul. Definesc apoi protocoalele, certificatele, suitele de cifrare și versiunile de protocol. Definesc în mod clar regulile de rutare și versiunile acestora, politicile de cache și limitele. Stabilesc verificări de sănătate, observabilitate și alerte înainte de punerea în funcțiune. Dacă doriți să începeți imediat, puteți găsi o prezentare generală instructivă la adresa Configurați un proxy invers pentru Apache și NGINX.

Cele mai bune practici pentru reglarea performanței

Activez HTTP/3 cu QUIC acolo unde clienții îl acceptă și mențin HTTP/2 pregătit pentru o compatibilitate largă. Folosesc Brotli pentru resursele text și pun proxy-ul să comprime eficient imaginile. Definesc în mod deliberat chei de cache pentru a controla variațiile prin cookie-uri sau antete. Minimizez timpii de handshake TLS, folosesc reluarea sesiunii și setez capsarea OCSP. Folosesc indicii timpurii (103) pentru a da browserului semnale prealabile pentru resursele critice.

Configurație de siguranță fără pierderi prin frecare

Eu dețin Certificate la nivel central și automatizarea reînnoirilor cu ACME. HSTS impune HTTPS, în timp ce CSP și CORP controlează conținutul. Încep o bază de reguli WAF conservatoare și o restrâng treptat pentru a evita alarmele false. Limitele de viteză, mTLS pentru serviciile interne și listele IP reduc riscul zi de zi. Jurnalele de audit rămân inviolabile, astfel încât să pot urmări incidentele cu certitudine juridică.

Costuri, funcționare și ROI

Am de gând să Buget pentru resurse de server, certificate, protecție DDoS și monitorizare. Configurațiile mici încep adesea cu câteva nuclee virtuale și 4-8 GB RAM pentru proxy, ceea ce înseamnă un cost lunar de două cifre, în funcție de furnizor. Flotele mai mari utilizează instanțe dedicate, anycast și noduri globale, ceea ce poate însemna costuri de trei cifre în euro pe locație. Gestionarea centralizată economisește timp: mai puține configurații individuale, procese de lansare mai rapide și timpi de oprire mai scurți. ROI-ul se reflectă în conversii mai mari, rate de respingere mai mici și inginerie mai productivă.

Variante de arhitectură și topologii

Aleg arhitectura pentru a corespunde profilului de risc și latență. Mediile simple funcționează bine cu un singur Gateway în DMZ, care direcționează cererile către serviciile interne. În mediile reglementate sau mari, separ proxy-urile frontend și backend în două etape: etapa 1 termină traficul de internet și gestionează WAF, DDoS și caching, etapa 2 rutează intern, vorbește mTLS și aplică principiile de încredere zero. Configurațiile active/active cu IP anycast și noduri distribuite la nivel global reduc timpii de failover și optimizează proximitatea față de utilizator. Pentru CDN-urile din fața proxy-ului invers, asigur redirecționarea corectă a antetelor (de exemplu, X-Forwarded-Proto, Real-IP) și ierarhii armonizate ale cache-ului, astfel încât cache-ul de margine și cache-ul gateway-ului să nu se blocheze reciproc. Încapsulez scenariile multi-tenant utilizând SNI/TLS, rute separate și limite de viteză izolate pentru a evita efectele de vecinătate.

Protocoale și cazuri speciale: WebSockets, gRPC și HTTP/3

Am în vedere protocoalele cu cerințe speciale, astfel încât caracteristicile să rămână stabile. Pentru WebSockets Activez suportul de actualizare și conexiunile de lungă durată cu timeout-uri adecvate. gRPC beneficiază de HTTP/2 și de antete curate; evit H2C (text simplu HTTP/2) în perimetru în favoarea TLS cu ALPN corect. Pentru HTTP/3 Furnizez porturi QUIC (UDP) și eliberez 0-RTT doar în mod restrictiv, deoarece reluările prezintă riscuri. Punctele finale de streaming, evenimentele trimise de server și încărcările mari beneficiază de propriile politici de tamponare și de dimensiune a corpului, astfel încât proxy-ul să nu devină un gât de gâtuire. Pentru traducerile de protocol (de exemplu, HTTP/2 în exterior, HTTP/1.1 în interior), testez temeinic normalizarea antetelor, compresia și reutilizarea conexiunii pentru a menține latențele scăzute și consumul de resurse previzibil.

Autentificare și autorizare la gateway

Mă relochez Autorizare-deciziile către proxy-ul invers, dacă arhitectura și conformitatea o permit. Integrez OIDC/OAuth2 prin verificarea jetoanelor la nivelul gateway-ului: proxy-ul validează semnăturile (JWKS), verifică expirarea, audiența și domeniul de aplicare și stabilește cererile verificate ca antete pentru servicii. Folosesc chei API pentru punctele finale de la mașină la mașină și le limitez în funcție de rută. Pentru sistemele interne, mă bazez pe mTLS cu verificarea reciprocă a certificatelor pentru a face încrederea explicită. Am grijă să nu înregistrez în mod inutil antetele sensibile (autorizare, cookie-uri) și folosesc liste de permisiune/neadmitere pe rută. Formulez politici detaliate prin ACL sau expresii (de exemplu, cale + metodă + cerere), ceea ce îmi permite să controlez accesul la nivel central fără a modifica codul aplicației.

Reziliență: timpi de așteptare, reîncercări, backoff și întreruperea circuitului

Eu definesc Timpi morți conștient per hop: stabilirea conexiunii, timeout-ul antetului și timeout-ul răspunsului. Activez reîncercările numai pentru metodele idempotente și le combin cu backoff exponențial plus jitter pentru a evita turmele de tunete. Întrerupătoarele de circuit protejează bazinele backend: Dacă proxy-ul detectează erori sau vârfuri de latență, acesta deschide temporar circuitul, redirecționează doar aleatoriu către destinația afectată și, în rest, răspunde devreme, opțional cu fallback din cache. Detectarea excepțiilor elimină automat instanțele "slabe" din grup. De asemenea, limitez fluxurile ascendente simultane, activez reutilizarea conexiunilor și folosesc cozi cu prioritizare echitabilă. Astfel, serviciile rămân stabile chiar și în cazul în care componentele individuale sunt sub presiune.

Conformitate, protecția datelor și protecția DIIP

Tratez proxy-ul ca Hub de date cu reguli clare de protecție a datelor. Maschez sau pseudonimizez datele cu caracter personal din jurnale; șirurile de interogare și anteturile sensibile sunt înregistrate numai pe baza unei liste albe. Scurtez adresele IP atunci când este posibil și ader la perioade stricte de păstrare. Accesul la jurnale și măsurători se face în funcție de roluri, iar modificările sunt documentate într-o manieră rezistentă la audit. Pentru audituri, asociez evenimentele gateway cu intrările de gestionare a modificărilor, astfel încât aprobările și actualizările regulilor să poată fi urmărite. Acest lucru îmi permite să îndeplinesc cerințele de conformitate fără a sacrifica informații detaliate privind performanța și securitatea.

Kubernetes, Ingress și Gateway API

Integrez proxy-ul invers fără probleme în Orchestrarea containerelor. În Kubernetes, folosesc controlori de intrare sau API-ul de gateway mai modern pentru a descrie declarativ rutarea, TLS și politicile. Traefik citește etichetele în mod dinamic, NGINX/HAProxy oferă variante sofisticate de ingress pentru un debit ridicat. Separ rutarea est/vest internă a clusterului (service mesh) de gateway-ul perimetral nord/sud, astfel încât responsabilitățile să rămână clare. Implementez versiuni canare cu rute ponderate sau potriviri de antet, definind în același timp cu strictețe verificările de sănătate și disponibilitatea podurilor pentru a evita fluctuațiile. Versionez configurațiile sub formă de cod și le testez în clustere de staționare cu simulare de sarcină înainte de a intra în funcțiune.

Maturitate operațională: gestionarea configurației și CI/CD

Tratez configurația proxy ca Cod. Modificările se execută prin pull requests, sunt testate automat (sintaxă, linting, verificări de securitate) și lansate în pipelines. Folosesc previzualizări sau trafic fantomă pentru a valida noile rute în condiții reale, fără a risca tranzacțiile clienților. Rollback-urile sunt posibile în câteva secunde, deoarece etichetez versiunile și le implementez atomic. Gestionez separat secretele sensibile (certificate, chei), criptate și cu autorizații minime. Pentru o disponibilitate ridicată, distribui versiunile către noduri în mod eșalonat și înregistrez efectele în tablouri de bord, astfel încât să pot lua rapid contramăsuri în caz de regresii.

Obstacole și anti-patforme tipice

Eu evit Surse de eroarecare apar frecvent în practică. Previn otrăvirea memoriei cache prin normalizarea strictă a antetelor și gestionarea curată a Vary; exclud cookie-urile care nu afectează redarea din cheia memoriei cache. Recunosc din timp buclele de redirecționare prin testarea cu X-Forwarded-Proto/Host și politici HSTS/CSP coerente. "Trust all X-Forwarded-For" este tabu: am încredere doar în următorul hop și stabilesc Real-IP în mod clar. Controlez încărcările mari prin limite și streaming, astfel încât proxy-ul să nu facă buffer, ceea ce backend-ul poate face mai bine. Cu 0-RTT în TLS 1.3, acord atenție idempotenței. Și sunt atent la dimensiunile corpului și ale antetului, astfel încât cererile individuale să nu blocheze întreaga capacitate a lucrătorului.

Rezumat pentru decizii rapide

Eu pariez pe un Inversare proxy deoarece combină viteza, protecția și scalarea într-un singur loc. Caching-ul, offloading-ul TLS și HTTP/2/3 accelerează semnificativ timpii de încărcare reali. WAF, apărarea DDoS și controlul IP/geo reduc considerabil riscurile. Echilibrarea încărcăturii, verificările de sănătate și lansările continue mențin serviciile disponibile, chiar și în timpul creșterii. Cu NGINX, Apache, HAProxy sau Traefik, găsesc o soluție clară pentru fiecare configurație și mențin operațiunile ușor de gestionat.