Cachelagring av hierarkier levererar de snabbaste laddningstiderna när jag använder varje lager specifikt: opcode, page, browser och edge. Jag visar i tydliga steg hur jag kombinerar dessa lager, undviker konflikter och ställer in konfigurationer på ett sådant sätt att förfrågningarna blir kortare och TTFB minskar synligt.

Centrala punkter

För att säkerställa att översikten är tydlig sammanfattar jag först de viktigaste ämnena och anpassar dem direkt till prestationsmålen. Jag förklarar alla nivåer med specifika inställningar så att implementeringen lyckas utan omvägar. Jag avgränsar dynamiska delar tydligt för att bevara personanpassningen. Jag optimerar headers och cache-nycklar så att det inte finns något onödigt avfall i cacheminnet. Slutligen sammanför jag allt i en stringent kedja så att varje hämtning tar den snabbaste vägen.

- Opkod påskyndar PHP

- Sidans cache förkortad TTFB

- Webbläsare Sparar bandbredd

- Kant Minskar latenstiden

- Orchestrering Förebygger konflikter

Vad innebär egentligen „cachelagring av hierarkier“?

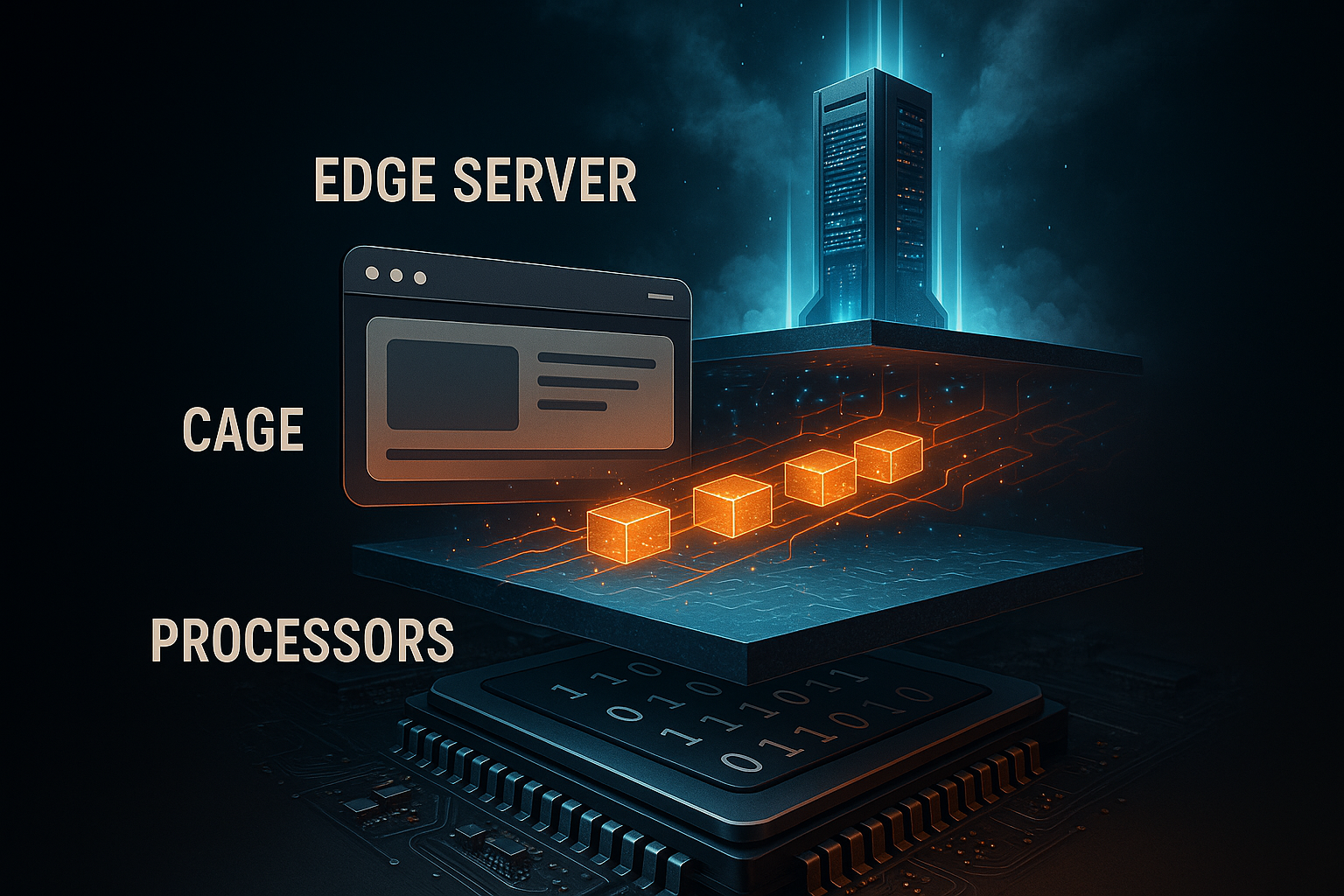

Jag förstår genom att Hierarki Förskjuten cachelagring från serverns kärna till slutenheten. Varje lager svarar på en annan fråga: måste servern kompilera om koden, måste PHP göra om sidan, måste webbläsaren ladda om tillgångar eller levererar en edge-nod färdigt innehåll nära användaren. Jag undviker dubbelarbete genom att harmonisera nivåerna och tilldela tydliga ansvarsområden. På så sätt minskar jag CPU-belastningen, backend-frågorna och nätverkslatensen utan att förlora funktionalitet. En kort introduktion till nivåerna finns i den här kompakta guiden: Enkla nivåer för cachelagring.

Opcode-caching: Snabbare PHP omedelbart

På Opkod-caching håller jag kompilerad PHP-bytekod i RAM-minnet och sparar mig själv upprepad parsning. Detta påskyndar alla förfrågningar som rör PHP, särskilt CMS-arbetsbelastningar som WordPress. Jag aktiverar OPcache och dimensionerar minnet tillräckligt generöst så att frekventa skript aldrig förskjuts. Jag ställer in måttlig revalidering så att ändringar förblir synliga snabbt utan att kontrollera för ofta. På så sätt minskar jag både CPU-belastningen och svarstiderna märkbart.

Jag ställer medvetet in typiska OPcache-parametrar i php.ini konservativt, övervakar träfffrekvensen och justerar vid behov. Jag håller antalet accelererade filer tillräckligt högt för att projektet ska passa helt. Jag använder förladdning för centrala klasser så att även kallstarter går snabbare. Jag distribuerar ändringar med en cacheåterställning för att undvika att riskera inkonsekventa tillstånd. Jag använder konfigurationsblocket som en utgångspunkt och inte som en rigid dogm.

opcache.enable=1

opcache.minnesförbrukning=256

opcache.max_accelererade_filer=20000

opcache.validera_tidsstämplar=1

opcache.revalidate_freq=2

Jag kontrollerar regelbundet OPcache-statistik, eftersom endast mätning visar om cachen är bärande eller thrash't. Hosting dashboards eller PHP status pages hjälper mig att minimera antalet missar. Jag undviker minnesvärden som är för små och som leder till evictions. Jag undviker också sällsynta valideringar så att produktiva ändringar inte fastnar. Med den här balansen arbetar jag effektivt och säkert.

Cachelagring av sidor: HTML utan väntetid

På Sidans cache Jag sparar den färdiga HTML:en så att PHP och databasen inte längre körs överhuvudtaget. Detta minskar TTFB drastiskt och ger de största hoppen under belastning. Jag utesluter konsekvent personliga sökvägar som kundvagn, kassa och användarkonton. Samtidigt kapslar jag in små dynamiska delar via AJAX eller edge-side includes så att resten kan komma hårt från cacheminnet. Detta gör att webbplatsen förblir snabb utan att förlora viktig individualitet.

Jag bestämmer om jag ska använda cachelagring på servernivå eller arbeta med ett plugin. På servern uppnår jag bästa möjliga Fördröjning, Plugins ger mig flexibel kontroll i CMS. Mekanismer för förladdning fyller cachen så att de första anropen inte behöver vänta. Jag rensar upp föräldralösa poster med hjälp av rensningsregler när jag uppdaterar innehållet. För särskilt dyra områden kombinerar jag också objektcache så att databasåtkomster är mindre frekventa.

Cachelagring i webbläsare: behåll tillgångar lokalt

På Webbläsare-Jag lämnar statiska filer som bilder, CSS och JS i den lokala cachen. Återkommande besökare laddar då nästan ingenting och servern förblir fri. Jag ställer in långa max-age-värden för oföränderliga tillgångar, som jag förser med versionering av filnamn. Jag lägger till korta tider eller must-revalidate till dynamiska endpoints för att hålla appen uppdaterad. På så sätt minskar jag bandbredden och optimerar den upplevda hastigheten.

Jag är uppmärksam på en ren blandning av cachekontroll, ETag och senast modifierad. För oföränderliga filer ställer jag in immutable så att webbläsaren inte kontrollerar i onödan. För resurser med frekventa uppdateringar använder jag villkorliga förfrågningar via ETag. Jag undviker tvetydiga headers, eftersom motsägelsefulla signaler leder till missförstånd. Jag behåller kontrollen direkt i webbservern eller via CMS-plugin, beroende på min miljö.

Edge-caching: närhet till användaren

Om Kant-Jag levererar innehåll i globala PoP:er, vilket minimerar fördröjning och jämnar ut toppar. HTML, bilder och API:er kan serveras nära användaren beroende på vilka regler som gäller. Jag arbetar med cache-nycklar som bara innehåller nödvändiga variabler för att minimera fragmentering. Regler som stale-while-revalidate och stale-if-error säkerställer att användarna omedelbart ser en giltig kopia, även om Origin bara håller på att värmas upp. Internationella målgrupper gynnas särskilt eftersom routningstiden minskar märkbart.

Jag separerar varianter när mobil och desktop skiljer sig mycket åt. Jag utelämnar medvetet kassa- och kontoområdet i utkanten för att undvika kollisioner med sessioner och cookies. Jag kontrollerar regelbundet träfffrekvensen och justerar TTL tills optimala odds uppnås. En praktisk fördjupad titt på detta Guide för Edge Caching med fokus på latens och nätverksvägar. Jag håller rena rensningsstrategier till hands så att uppdateringar träder i kraft omedelbart över hela världen.

Ställ in HTTP-header korrekt

Die Huvud styra hur långt innehåll får färdas och när det ska valideras på nytt. Jag använder cache-kontroll för att bestämma synlighet, livslängd och skyldigheter för revalidering. ETag identifierar en resurs på ett unikt sätt och möjliggör if-none-match-förfrågningar. Last-Modified ger en reservlösning för klienter som ignorerar ETags. Jag håller kombinationen tydlig så att klient, CDN och ursprung delar samma förväntningar.

Jag använder följande översikt som en praktisk referens under konfigurationen. Jag kontrollerar varje rad mot resurstypen och ändringsbeteendet. För statiska filer ställer jag in långa maxåldersvärden med immutable. För innehåll som uppdateras ofta förkortar jag varaktigheten och förlitar mig på villkorliga förfrågningar. Detta gör att datavägen förblir effektiv och korrekt.

| Huvud | Funktion |

|---|---|

| Cache-kontroll | Kontrollerar varaktighet, synlighet, validering (t.ex. max-age, public, must-revalidate) |

| ETag | Unik identifierare för en version, grund för villkorade anrop |

| Senast modifierad | Tidsstämpel som ett alternativ till ETag, används för validering |

Strategier för invalidisering och uppdatering av cacheminnet

Jag planerar att Ogiltigförklaring lika noggrant som själva cachelagringen. Selektiv rensning efter ID, tagg eller sökväg förhindrar fulla rensningar som orsakar kostnader. När jag distribuerar rensar jag bara det som verkligen har ändrats. Stale-while-revalidate håller användarna snabba medan bakgrunden laddar nya kopior. Stale-if-error fångar upp fel på Origin utan att försämra användarupplevelsen.

Jag kombinerar kort TTL med en hög träfffrekvens om innehållet roterar ofta. För arkiv, media och bibliotek väljer jag långa tider, versionerar filnamn och tar bort kontrollbelastningar. Dashboards på CDN- eller serversidan visar mig var cache buckets är för små. Då justerar jag antalet slots och objektstorlekar. Den här ständiga finjusteringen gör hela skillnaden i vardagen.

Cache-nycklar, cookies och Vary

Med smal Nycklar Jag håller antalet varianter litet. Endast parametrar som verkligen ändrar resultatet hamnar i nyckeln. Jag använder Vary-rubriker medvetet, till exempel efter klasserna Accept-Encoding eller User-Agent, om det behövs. För många cookies i nyckeln bryter upp cacheminnet och minskar träfffrekvensen. Jag rensar bort oanvända cookies och reglerar parametrar som används för spårning ur nyckeln.

Om jag behöver variera språk, valutor eller layouter använder jag specifika nycklar som lang=de eller currency=EUR. Jag begränsar denna variation till de fall som jag verkligen behöver. För A/B-tester separerar jag bara de segment som har skillnader i innehåll. Jag hanterar allt annat på klientsidan eller via edge-logik utan nyckelexplosion. Det är så här jag håller den globala cachen effektiv.

Objektcache och transienter

En Objekt-Cache minskar dyra databasförfrågningar genom att hålla resultaten i minnet. För WordPress väljer jag Redis eller Memcached för att säkerställa snabb åtkomst till ofta efterfrågade alternativ, frågor och sessioner. Jag använder transienter för att temporärt lagra dyra beräkningar. Jag rensar upp dessa värden under deployment när beroenden ändras. Detta håller sidan dynamisk och fortfarande snabb.

Den här jämförelsen hjälper mig när det gäller projektstorlekar med intensiv dataladdning: Redis vs Memcached. Där känner jag igen de typiska styrkorna hos båda systemen beroende på arbetsbelastningen. Jag dimensionerar RAM-minnet och kontrollerar evakueringsstrategier för att göra plats för sällan använda objekt. Övervakning av hit/miss-frekvenser visar om konfigurationen fungerar. Denna nivå kompletterar sidcachen på ett idealiskt sätt.

Kombination: Den optimerade kedjan

Jag kombinerar Nivåer så att varje förfrågan tar den kortaste vägen. OPcache påskyndar genereringen när HTML faktiskt skapas. Sidcachen tillhandahåller färdig markup för anonyma besökare. Cachelagring i webbläsaren förhindrar upprepade överföringar av tillgångar och Edge distribuerar innehållet globalt. I slutet finns en ren rensnings- och versionshanteringsstrategi så att uppdateringar träder i kraft omedelbart.

Jag har följande tabell till hands som en fusklapp när jag justerar inställningarna. Jag läser kolumnen „Configuration“ som en att-göra-lista under implementeringen. Jag ser till att nivåerna kompletterar varandra och inte tar ut varandra. På så sätt blir den övergripande arkitekturen tydlig och effektiv. Denna översikt förhindrar misstag under planeringen.

| Cache-nivå | Fördel | Typiskt innehåll | Konfiguration |

|---|---|---|---|

| Opkod | Snabb PHP-exekvering | PHP-bytekod | php.ini, Server-Panel |

| Sidan | Låg TTFB | Färdig HTML | Servernivå eller plugin |

| Webbläsare | Lokal återanvändning | CSS, JS, bilder | HTTP-rubrik, versionering |

| Kant | Global närhet | HTML och tillgångar | CDN-regler, Nycklar, Purge |

Mätning: TTFB, LCP och träffprocent

Jag mäter TTFB, för att se hur snabbt den första bytena kommer. LCP visar mig om det synliga innehållet visas i tid. Jag använder cache-analys för att kontrollera träfffrekvenser och känna igen vägar där missar ackumuleras. Jag korrelerar mätvärden med driftsättningar, crawlerbelastning och trafiktoppar. Endast siffrorna visar var jag behöver dra åt skruvarna.

Jag loggar svarsrubriker som ålder och CF-cachestatus för att visualisera framgångar på kanten. Serverloggar visar om sidcachen fungerar som den ska. Om det finns stora avvikelser letar jag efter cookies, frågeparametrar eller variabler som delar upp cacheminnet. Jag testar varianter med och utan inloggat tillstånd. På så sätt kan jag snabbt hitta justeringarna för stabil hastighet.

Typiska fel och korrigeringar

För många Varianter i cacheminnet är en vanlig bromskloss. Jag reducerar frågeparametrar i nyckeln och neutraliserar spårningsparametrar. En annan klassiker är motsägelsefulla headers, t.ex. no-store tillsammans med en lång max-age. Tomma eller felaktiga rensningar kan också ge intryck av att cachen inte fungerar. Jag löser snabbt sådana problem med tydliga regler och loggar.

Ett annat problem är plugins som skriver dynamiskt innehåll som är hårdkodat i HTML. Jag flyttar sådana element till fragmenterade ändpunkter som cachas eller laddas om oberoende av varandra. Cookies blockerar ofta edge-cachen oavsiktligt; jag tar bort onödiga cookies tidigt. Dålig versionshantering tvingar webbläsare att ladda om om och om igen; jag numrerar filer konsekvent. Detta håller pipelinen ren och motståndskraftig.

Beslutsträd: Vem svarar på en förfrågan?

Jag definierar en tydlig beslutsväg för att avgöra vilken nivå som får leverera. Detta undviker onödiga ursprungsträffar och minskar TTFB på ett reproducerbart sätt.

- 1) Är resursen oföränderlig (versionerad fil)? Webbläsarcache med lång max-age och oföränderlig.

- 2) Är förfrågan anonym, GET och utan känsliga cookies? Edge/page cache med public, s-maxage och stale-while-revalidate.

- 3) Innehåller begäran Auth-Cookies, Authorisation-Header eller är det POST? Origin, eventuellt med Object-Cache.

- 4) Innehåller URL:en bara kosmetiska parametrar (utm, fbclid)? Jag tar bort dem från cache-nyckeln.

- 5) Behöver du små levande delar (t.ex. antal varukorgar)? Fragmenteras via AJAX eller ESI.

// pseudo logik

if (immutable_asset) return browser_cache;

if (is_get && is_anonymous && cacheable) return edge_or_page_cache;

if (needs_fragment) returnerar cached_html + dynamic_fragment;

returnera origin_with_object_cache;Att bemästra fragmentering: ESI, AJAX och partiell rendering

Jag isolerar dynamiska öar så att resten kan cacha hårt. ESI är lämpligt för injektioner på serversidan (t.ex. personliga block), AJAX för omladdningspunkter på klientsidan. Det är viktigt att fragmenten får egna, korta TTL:er så att de hålls uppdaterade utan att hela dokumentet ogiltigförklaras.

- Statisk grundstruktur: lång TTL, publik, s-maxage, stale-while-revalidate.

- Dynamiskt fragment: kort TTL, must-revalidate eller no-store, om det är personligt anpassat.

- Felfall: stale-if-error på HTML-omslaget förhindrar vita sidor.

// Exempel på rubrik för HTML-kuvert

Cache-kontroll: public, max-age=0, s-maxage=600, stale-while-revalidate=60, stale-if-error=86400

// Exempel på rubrik för personligt fragment

Cache-kontroll: privat, no-storeUndvik cache-stampage och kontrolluppvärmning

Jag förhindrar flockeffekter där många samtidiga missar översvämmar Origin. Mjuk TTL / hård TTL, begäran coalescing och låsning är mina verktyg. Jag använder förladdare som cykliskt värmer upp sitemaps eller viktiga vägar och förskjuter TTL så att inte allt går ut samtidigt.

- Mjuk TTL: En arbetare kan förnya utgångna objekt medan andra konsumenter fortfarande får inaktuella objekt.

- Coalescing: Samtidiga förfrågningar om samma nyckel slås samman.

- Förskjutna TTL:er: Kritiska sidor får förskjutna körtider för att jämna ut rensningsvågor.

// Exempel för graderade körtider

/home, /category/* -> s-maxage=900

/artikel/* -> s-maxage=1800

/search -> s-maxage=120, stale-while-revalidate=30Rikta in TTL-konstruktionen rent i kedjan

Jag ställer in TTL för webbläsare, edge och origin så att revalidering sker där det är mest gynnsamt. För HTML förlitar jag mig på s-maxage vid kanten och håller max-age låg i webbläsaren för att garantera snabba rensningar. För tillgångar vänder jag på det: mycket långa TTL:er i webbläsaren eftersom versionshantering garanterar aktualitet.

// HTML

Cache-kontroll: public, max-age=0, s-maxage=600, stale-while-revalidate=60

// Versionerade tillgångar

Cache-kontroll: offentlig, max-age=31536000, oföränderligJag undviker motsägelsefulla specifikationer som no-cache tillsammans med immutable. Tydliga regler skapar konsekventa resultat genom hela hierarkin.

Komprimering, HTTP/2/3 och prioritering

Jag aktiverar Gzip/Brotli och ställer in Vary-headern korrekt så att varianterna separeras på ett snyggt sätt. Med HTTP/2/3 drar jag nytta av multiplexering och prioritering; detta minskar blockering av head-of-line när många tillgångar laddas parallellt.

# NGINX exempel

gzip på;

gzip_types text/css applikation/javascript applikation/json image/svg+xml;

brotli på;

brotli_types text/css applikation/javascript applikation/json image/svg+xml;

add_header Vary "Accept-Encoding" alltid;

# Lång TTL för tillgångar i webbläsare

plats ~* .(css|js|svg|woff2|jpg|png)$ {

löper ut 1 år;

add_header Cache-Control "public, max-age=31536000, immutable";

}Autentisering, cookies och säkerhet

Jag cachar aldrig personligt innehåll offentligt. Jag markerar förfrågningar med auktoriseringsrubriker eller sessionscookies som privata eller kringgår specifikt edge-cachen. Samtidigt vitlistar jag bara viktiga cookies så att cache-nyckeln förblir smal.

- Inloggning/konto områden: Cache-kontroll: privat eller no-store.

- Offentliga HTML-sidor: offentliga, s-maxage; undvik att sätta cookie.

- Cookie-hygien: Ta bort irrelevanta cookies (t.ex. spårning) från nyckeln.

// VCL-liknande logik

if (req.http.Authorisation) { return(pass); }

if (req.http.Cookie ~ "session=") { return(pass); }

// Endast nödvändiga cookies i nyckeln

unset req.http.Cookie: ".*";

Cache API och sökändpunkter på ett effektivt sätt

Jag gör en strikt åtskillnad mellan metoderna: GET kan cachas, POST vanligtvis inte. För frekventa sökfrågor ställer jag in korta s-maxage-värden plus stale-while-revalidate för att jämna ut svarstiderna. Svar med 4xx/5xx-fel cachar jag bara kortvarigt eller inte alls så att korrigeringar får effekt omedelbart.

// Exempel på rubrik för offentligt GET API

Cache-kontroll: public, max-age=0, s-maxage=120, stale-while-revalidate=30

// Sparsamt med fel i cacheminnet

Cache-kontroll: offentlig, s-maxage=10Observerbarhet: rubriker, loggar och TTFB-kontroll

Jag använder headerinspektion och loggar för att göra kedjan transparent. Ålder, hit/miss-indikatorer och uppströmsstatus visar mig var tid går förlorad. Jag använder enkla verktyg för att kontrollera TTFB på ett reproducerbart sätt och hitta outliers.

Mätning # TTFB

curl -o /dev/null -s -w "TTFB: %{tid_starttransfer}sn" https://example.org

Kontrollera #-huvudet

curl -I https://example.org | sed -n '1,20p'# NGINX-logg med cachestatus

log_format timed '$remote_addr "$request" $status $body_bytes_sent '

'$upstream_cache_status $upstream_response_time $request_time';

access_log /var/log/nginx/access.log timed;Jag jämför loggdata med utrullningar och rensningar. Höga miss-toppar direkt efter utrullningar indikerar en saknad uppvärmning eller TTL som är för korta. Om Age förblir permanent låg kontrollerar jag om cookies oavsiktligt kringgår edge-cachen.

Driftsättning: versionshantering och rullande rensningar

Jag bygger in versioner i filnamn (t.ex. app.9f3c1.js) så att webbläsarens cachelagring kan vara aggressiv. För HTML använder jag rullande rensningar som uppdaterar kritiska sidor först, följt av djup och långkörare. Blå/gröna implementeringar frikopplar build från release och ger mig tid att specifikt värma upp cacher.

// Tillgångspipeline

stil.[hash].css

app.[hash].js

// HTML hänvisar alltid till nya hasharJag planerar rensningsfönster utanför topptiderna och övervakar träfffrekvensen omedelbart efteråt. På så sätt undviker jag belastningstoppar på Origin.

Bildvarianter, DPR och responsiv cachelagring

Jag genererar bildvarianter (storlek, format) deterministiskt så att cache-nyckeln förblir stabil. För WebP/AVIF-varianter separerar jag uttryckligen via filsökväg eller parametrar istället för bara via Accept-rubriker för att undvika Vary-explosioner. För högupplösta skärmar (DPR) använder jag srcset/sizes, vilket gör att webbläsaren kan välja den bästa varianten och att cacheminnet träder i kraft för varje specifik tillgång.

<img src="img/hero-1024.jpg"

srcset="img/hero-768.jpg 768w, img/hero-1024.jpg 1024w, img/hero-1600.jpg 1600w"

sizes="(max-width: 768px) 90vw, 1024px" alt="">Jag håller antalet varianter per motiv lågt och rensar bort föråldrade storlekar från pipelinen så att cacheminnet inte fragmenteras.

Kapacitetsplanering: cacheminne och objektstorlekar

Jag dimensionerar cacheminnet efter verkliga åtkomstmönster: ett fåtal stora objekt (bilder, videor) kräver andra strategier än många små (HTML, JSON). Jag sätter gränser för maximal objektstorlek och kontrollerar om populära objekt finns kvar i minnet. En hög återanvändningsgrad är viktigare än absolut storlek; jag trimmar därför nycklar, slår samman varianter och förhindrar dubbletter.

// Exempel: Gränser

max_objektstorlek = 10m

standard_ttl = 600

nuke_limit = måttlig (avhysningar utan bås)Praktisk checklista för implementering

Jag aktiverar OPcache med tillräckligt minne och kontrollerar träfffrekvensen. Sedan ställer jag in cachelagring av sidor, exkluderar kritiska sökvägar och förladdar viktiga webbadresser. Sedan ställer jag in webbläsarheaders med långa tider för oföränderliga filer och versionshantering. I CDN definierar jag cache-nycklar, TTL:er och rensningsstrategier och aktiverar stale-while-revalidate. Slutligen använder jag mätverktyg för att kontrollera om TTFB, LCP och edge hit rate uppnår målen.

Kort sammanfattning

Jag använder Caching hierarkisk: OPcache accelererar kod, sidcachen levererar HTML, webbläsarheaders håller tillgångar lokala och Edge för innehållet nära användarna. Med tydliga nycklar, lämpliga TTL:er och smart invalidisering minskar jag serverbelastningen, bandbredden och latensen. Mätvärden säkerställer framsteg och visar på optimeringspotential. Detta skapar en pålitlig kedja från ursprunget till slutenheten. Den som vill veta mer om global leverans hittar tillräckligt med praktiska utgångspunkter för att göra sin egen arkitektur märkbart snabbare.