HTTP/2-multiplexering samlar många förfrågningar via en enda anslutning och undanröjer blockeringar på protokollnivå. I verkliga nätverk bromsar dock TCP-Head-of-Line, TLS-Overhead och bristfällig prioritering, så att HTTP/2 inte automatiskt körs snabbare än HTTP/1.1.

Centrala punkter

- Multiplexering parallelliserar många förfrågningar via en enda TCP-anslutning.

- TCP-HoL förblir aktiv och stoppar alla strömmar vid förluster.

- TLS-inställningar kan fördröja Time-to-First-Byte märkbart.

- Prioriteringar och Server Push fungerar endast med korrekt inställning.

- Sidtyp beslutar: många små filer kontra få stora filer.

Hur HTTP/2-multiplexering fungerar internt

Jag delar upp varje svar i små Ramverk, numrera dem och ordna dem i logiska strömmar så att flera resurser kan köras samtidigt via en enda anslutning. På så sätt undviker jag blockeringar på HTTP-nivå, eftersom ingen begäran längre behöver vänta på att en annan ska avslutas. Webbläsarna skickar HTML, CSS, JS, bilder och teckensnitt parallellt och minskar kostnaden för ytterligare anslutningar. HPACK minskar storleken på rubrikerna, vilket avsevärt minskar belastningen vid många små filer. Det avgörande är dock att alla strömmar delar samma TCP-linje, vilket skapar fördelar men också nya beroenden. Denna arkitektur ger hastighet så länge nätverket förblir stabilt och Prioritering fungerar på ett meningsfullt sätt.

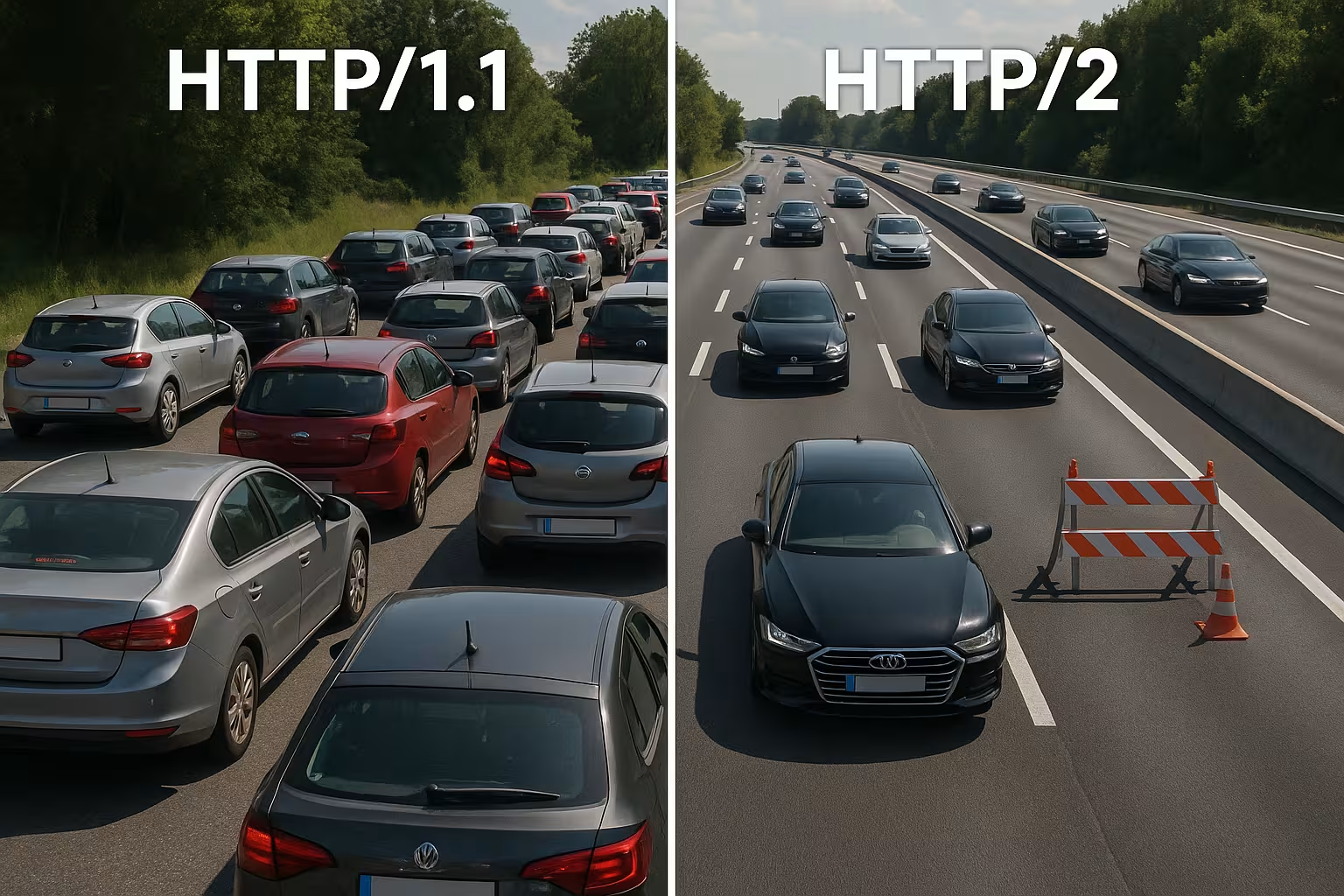

HTTP/1.1 vs. HTTP/2: Grundläggande skillnader

HTTP/1.1 använder textbaserade meddelanden och flera parallella anslutningar per värd för att ladda resurser samtidigt, vilket ökar handskakningar och overhead. HTTP/2 fungerar binärt, använder en enda anslutning för allt och komprimerar rubriker, vilket förkortar väntetiderna, särskilt när det finns många objekt. I vattenfallsdiagram försvinner långa köer eftersom strömmarna fortskrider parallellt. I gengäld flyttas flaskhalsen från HTTP-lagret till TCP-lagret, vilket jag märker tydligt i instabila nätverk. Små, starkt cachade sidor har ofta knappt några fördelar jämfört med 1.1, medan stora, tillgångsrika sidor har mer synliga fördelar. Dessa skillnader formar min Tuningstrategi och motiverar ett projektspecifikt beslut.

Välj rätt flödeskontroll och fönsterstorlek

HTTP/2 har egen flödeskontroll per ström och per anslutning. Jag ser till att använda meningsfulla värden för INITIAL_WINDOW_SIZE och antalet samtidiga strömmar, så att ledningen varken blir överbelastad eller underutnyttjad. För små fönster skapar onödigt många WINDOW_UPDATE-ramar och begränsar datahastigheten, för stora fönster kan överbelasta svagare klienter. I nätverk med hög bandbreddsfördröjningsprodukt (BDP) ökar jag fönsterstorleken på ett målinriktat sätt så att stora svar inte fastnar i stop-and-go. Samtidigt begränsar jag MAX_CONCURRENT_STREAMS Pragmatiskt: tillräcklig parallellitet för renderingskritiska element, men inte så mycket att småsaker bromsar LCP-bilden. Dessa justeringsskruvar är små, men deras inverkan på de faktiska laddningstiderna är stor om de passar sidan och nätverket.

Omvärdera domänsharding och bundling

Många 1.1-optimeringar är kontraproduktiva under HTTP/2. Jag avskaffar gammal domän-sharding, eftersom en enda välutnyttjad anslutning är effektivare än artificiellt fördelade socklar. Jag ifrågasätter också aggregering av JavaScript till megafiler: mindre, logiskt separerade buntar möjliggör riktade cacher och undviker att hela appen måste överföras på nytt vid en ändring. Bildsprites förlorar i betydelse eftersom parallella förfrågningar har blivit billiga och moderna bildformat inklusive caching fungerar bättre. Jag optimerar alltså där multiplexing kan vinna och binder bara ihop om det verkligen förenklar arkitekturen eller mätbart ökar caching-träfffrekvensen.

Anslutningskoalition och certifikat

HTTP/2 tillåter webbläsare att använda en anslutning för flera värdnamn om certifikat och DNS stämmer överens. Jag planerar SAN-poster och SNI så att sammanslagning blir möjlig och extra handskakningar inte behövs. Om ALPN och Cipher-Suites stämmer överens kan klienten CSS från cdn.example.com och bilder från static.example.com via samma linje. Det sparar RTT:er, förenklar prioriteringen och ökar chansen att kritiska tillgångar kommer fram utan omvägar. Jag kontrollerar dessa effekter specifikt i nätverksfliken: Används verkligen bara en socket, eller tvingar certifikatgränser och policyer webbläsaren att upprätta nya anslutningar?

Varför multiplexing bromsas upp: TCP-Head-of-Line

Om ett paket går förlorat på den enda TCP-anslutningen väntar hela linjen tills återutsändningen anländer – vilket tillfälligt stoppar alla HTTP/2-strömmar. I mobilnät med varierande latens och ökad förlustfrekvens ser jag därför regelbundet mindre vinster eller till och med nackdelar jämfört med flera 1.1-anslutningar. Denna effekt förklarar varför multiplexing ser bra ut på papperet, men inte alltid fungerar i praktiken. Mätningar från forskning och fältstudier visar just detta samband i verkliga nätverk [6]. Jag planerar därför distributioner konservativt, testar på typiska användarvägar och kontrollerar effekterna för varje målgrupp. Den som ignorerar TCP-HoL går miste om Effekt och kan till och med förlänga laddningstiderna.

TLS-handskakning, TTFB och sidtyp

HTTP/2 körs nästan uteslutande via TLS på webben, vilket genererar ytterligare handskakningar och kan förlänga tiden till första byte märkbart för få tillgångar. Om jag bara levererar en stor fil försvinner multiplexfördelen, eftersom ingen parallell överföring behövs. Sidor med tio till tjugo små filer gynnas mer, medan svar med en enda resurs ofta ligger på samma nivå som HTTP/1.1. Jag minskar overheadkostnaden med TLS 1.3, Session Resumption och ren Keep-Alive, så att återanslutningar inte behövs och en linje verkligen lever. För finjustering använder jag Keep-Alive-inställning, för att ställa in återanvändning, vilotidstidsgränser och begränsningar som passar belastningen. Detta minskar andelen handskakningar och TTFB stabiliseras även vid trafiktoppar.

CDN- och proxykedjor: h2 till ursprunget

Många stackar avslutar TLS vid kanten och kommunicerar vidare till ursprunget. Jag kontrollerar om HTTP/2 också används mellan CDN och backend eller om det sker en återgång till HTTP/1.1. Buffrande proxyservrar kan delvis upphäva fördelarna (headerkomprimering, prioritering) om de reserialiserar svar eller ändrar ordningen. Därför optimerar jag end-to-end: Edge-nod, mellanliggande proxy och origin ska förstå h2, använda lämpliga fönsterstorlekar och inte ignorera prioriteringar. Där h2c (HTTP/2 utan TLS i det interna nätverket) är meningsfullt testar jag om det sparar latens och CPU utan att bryta mot säkerhetspolicyer. Endast en harmonisk kedja utvecklar Multiplexering-effekten fullständigt.

Använda prioritering på rätt sätt

Jag prioriterar kritiska resurser så att HTML, CSS och LCP-bilden kommer först och renderingsblockeringar försvinner. Utan tydliga prioriteringar tar mindre viktiga skript upp värdefull bandbredd, medan Above-the-Fold-innehåll får vänta. Alla servrar följer inte webbläsarens prioriteringar korrekt, och vissa proxyservrar ändrar ordningen, varför jag utvärderar resultatdata istället för önsketänkande [8]. Preload-header och en tidigt placerad bildreferens förkortar laddningsvägarna och ökar träfffrekvensen i cachen. Prioritering är ingen magi, men den styr anslutningen så att användarna snabbt ser vad de behöver. Tydliga regler ger märkbara resultat. Tryckkraft och gör multiplexing riktigt effektivt.

Prioritering i praktiken: Extensible Priorities

Webbläsare har vidareutvecklat sina prioriteringsmodeller. Jag tar hänsyn till att moderna klienter ofta använder „Extensible Priorities“ istället för fasta trädvikter. De signalerar då brådskande och progressiva parametrar per ström, vilket servrarna måste tolka och översätta till rättvisa schemaläggare. Jag kontrollerar om min server respekterar dessa signaler eller baseras på gammalt beteende. I A/B-tester jämför jag laddningsvägar med och utan prioritering på serversidan för att identifiera trängningseffekter. Viktigt: Prioritering ska gynna renderingskritiska element, men får inte leda till att långvariga nedladdningar hamnar i bakgrunden. En försiktig blandning undviker toppar och håller pipelinen fri för synligt innehåll.

Server Push: sällan förkortningen

Jag använder server push endast i specifika fall, eftersom överdriven push upptar bandbredd och ignorerar webbläsarens cacheminne. Om en redan cachad resurs pushas, blir vägen långsammare istället för snabbare. Många team har stängt av push och använder istället preload, vilket är betydligt mer tillförlitligt [8]. I specialfall, till exempel på återkommande rutter med tydliga mönster, kan push vara användbart, men jag bevisar effekten med mätvärden. Utan bevis tar jag bort push och håller pipelinen fri för data som verkligen behövs. Mindre är ofta bättre här. mer, just på den enda förbindelsen.

Praktisk jämförelse: När HTTP/1.1 kan vara snabbare

Jag upplever HTTP/1.1 som konkurrenskraftigt när få, stora filer dominerar eller nätverk med högre förluster används. Flera separata anslutningar fördelar då risken och kan förkorta enskilda first byte-tider. På mycket små sidor kompenserar extra TLS-handskakningar ofta helt för multiplexing-fördelarna. Vid många små objekt är däremot HTTP/2 överlägset, eftersom komprimering, prioritering och en enda socket fungerar. Följande översikt visar typiska mönster från revisioner och fälttester som styr mitt val av protokoll [6][8]. Detta rutnät ersätter inte tester, men ger en solid Orientering för första beslut.

| Scenario | Bättre protokoll | Anledning |

|---|---|---|

| Många små tillgångar (CSS/JS/bilder/typsnitt) | HTTP/2 | Multiplexing och HPACK minskar overheadkostnaderna, en anslutning räcker |

| Få, mycket stora filer | HTTP/1.1 ≈ HTTP/2 | Parallellitet knappast nödvändig; handskakningskostnader väger tyngre |

| Instabila mobilnät med förluster | HTTP/1.1 delvis bättre | TCP-HoL stoppar alla strömmar vid HTTP/2; flera socklar kan hjälpa |

| Optimerad TLS (1.3, återupptagning), tydliga prioriteringar | HTTP/2 | Mindre installation, målinriktad bandbreddskontroll |

| Överdrivet tryck aktivt | HTTP/1.1/HTTP/2 utan push | Onödiga data blockerar ledningen; förladdning är säkrare |

Bästa praxis för verkliga laddningstidsvinster

Jag reducerar byte före protokollet: bilder i WebP/AVIF, lämpliga storlekar, sparsamma skript och rena caching-headers. Jag håller kritiska CSS-sökvägar små, laddar in teckensnitt tidigt och sätter fallbacks för att undvika layoutförändringar. För uppkoppling och DNS använder jag Preconnect och DNS-förhämtning, så att handskakningar startar innan parsern stöter på resursen. Brotli för textinnehåll påskyndar återkommande hämtningar, särskilt via CDN. Jag kontrollerar effekter i vattenfallet och jämför LCP, FID och TTFB före och efter ändringar. Mätvärden styr min Prioriteringar, magkänsla inte.

gRPC, SSE och strömningsfall

HTTP/2 visar sina styrkor särskilt vid gRPC och andra bidirektionella eller långvariga strömmar. Jag är uppmärksam på timeouts, buffertstorlekar och backlog-regler så att en hackig ström inte påverkar alla andra förfrågningar negativt. För Server-Sent Events och Live-Feeds är en stabil, permanent anslutning till hjälp, så länge servern hanterar prioriteringarna korrekt och Keep-Alive-gränserna inte träder i kraft för tidigt. Samtidigt testar jag hur fel fall beter sig: återuppbyggnad av strömmar, exponentiell backoff och meningsfulla gränser för återanslutningar förhindrar belastningstoppar när många klienter samtidigt avbryter och återansluter. På så sätt förblir realtidsscenarier förutsägbara.

OS- och TCP-optimering för stabil multiplexprestanda

Valet av protokoll kan inte kompensera för en svag nätverkskonfiguration. Jag kontrollerar algoritmer för överbelastningskontroll (t.ex. BBR vs. CUBIC), socketbuffertar, TCP Fast Open-policyer och storleken på det initiala överbelastningsfönstret. En överbelastningskontroll som är anpassad till vägen kan minska antalet återutsändningar och mildra HoL-effekter. Lika viktigt: korrekta MTU/MSS-värden för att förhindra fragmentering och onödiga förluster. På TLS-nivå föredrar jag korta certifikatkedjor, OCSP-stapling och ECDSA-certifikat, eftersom de påskyndar handskakningen. Tillsammans ger dessa inställningar multiplexing den nödvändiga Understruktur, så att prioritering och headerkomprimering kan få full effekt.

Mätstrategi och KPI:er i vardagen

Jag förlitar mig inte på medianvärden, utan tittar på p75/p95 i mätvärdena, uppdelat efter enhet, nätverkstyp och plats. Syntetiska tester ger reproducerbara basvärden, medan övervakning av verkliga användare visar spridningen i fält. Jag jämför vattenfall av nyckelvägar, kontrollerar tidiga byte av HTML, ordningen av CSS/JS och ankomsttiden för LCP-bilden. Jag rullar ut ändringar som kontrollerade experiment och observerar TTFB, LCP och felfrekvenser parallellt. Viktigt: Prioriteringar utan mätbar nytta tar jag bort igen. På så sätt förblir konfigurationen smidig och jag investerar i justeringar som statistiskt sett sparar tid.

Crawl- och bot-trafik

Förutom användare drar även sökrobotar nytta av ren HTTP/2. Jag aktiverar h2 för relevanta slutpunkter och observerar om bots återanvänder anslutningen och hämtar fler sidor på samma tid. Onödiga 301-kaskader, okomprimerade svar eller för korta Keep-Alive-gränser kostar crawlbudget. Jag anpassar policyer så att multiplexing också fungerar här utan att backend-gränser överskrids. Resultat: effektivare skanningar och mer stabilitet under belastning.

HTTP/2, HTTP/3 och vad som är viktigt härnäst

HTTP/3 använder QUIC över UDP och löser TCP-Head-of-Line-Blocking, vilket är särskilt användbart vid mobilitet och förluster [6]. Uppkopplingen går snabbare och strömblockeringar påverkar inte längre alla förfrågningar samtidigt. I blandade flottor förblir HTTP/2 viktigt, men jag aktiverar HTTP/3 där klienter och CDN redan talar det. Detaljerade jämförelser som HTTP/3 jämfört med HTTP/2 hjälper mig att planera utrullningar i etapper och efter målgrupp. Jag mäter separat efter plats, enhet och nätverkstyp så att verkliga användare kan dra nytta av det. Så använder jag protokoll för att Laddningstider i vardagliga situationer.

Hosting och infrastruktur som accelerator

Bra protokoll räddar inte en svag infrastruktur, därför kontrollerar jag noggrant plats, peering, CPU, RAM och I/O-gränser. En modern webbserver, rimligt antal arbetare och ett cache-lager förhindrar att den enda anslutningen hamnar i flaskhals. Strategisk användning av CDN förkortar RTT och dämpar belastningstoppar. De som betjänar användare i hela Europa drar ofta större nytta av korta avstånd än av finjustering av protokoll. Jag planerar kapaciteten med reserver så att burst-traffic inte tvingar systemet på knä. Så utvecklas multiplexing sin Potentiell pålitlig.

Snabbt känna igen felmönster

Om HTTP/2 verkar långsammare än förväntat letar jag efter typiska mönster: en enda lång överföring som blockerar många små, prioriteringar som ignoreras, höga återöverföringshastigheter på mobila sträckor eller TLS-återupptagning som inte fungerar. Jag jämför sedan HTTP/2 och HTTP/1.1 under identiska förhållanden, separerar CDN-påverkan från ursprunget och tittar på antalet socklar, det faktiska antalet strömmar och ordningen på de första kilobyterna. Om jag hittar en flaskhals justerar jag först grunderna (bytes, caching, handshakes) innan jag finjusterar flödeskontroll eller prioriteringar. Denna ordning ger de mest tillförlitliga förbättringarna.

Praktisk sammanfattning för snabba beslut

Jag använder HTTP/2 Multiplexing när det finns många objekt, prioriteringar gäller och TLS är korrekt konfigurerat. Vid få stora filer eller instabila nätverk räknar jag med små fördelar och håller ett öga på 1.1-resultaten. Jag använder server push endast med bevis, förladdning nästan alltid, och jag håller overheaden låg genom komprimering, caching och tidiga anslutningar. Mätningar med verkliga enheter och platser bekräftar mina antaganden innan jag rullar ut ändringar i stor skala [6][8]. I slutändan är det inte protokollnumret som räknas, utan märkbar hastighet för verkliga användare. Den som går tillväga på detta sätt får ut maximalt av HTTP/2. Hastighet och lägger grunden för HTTP/3.