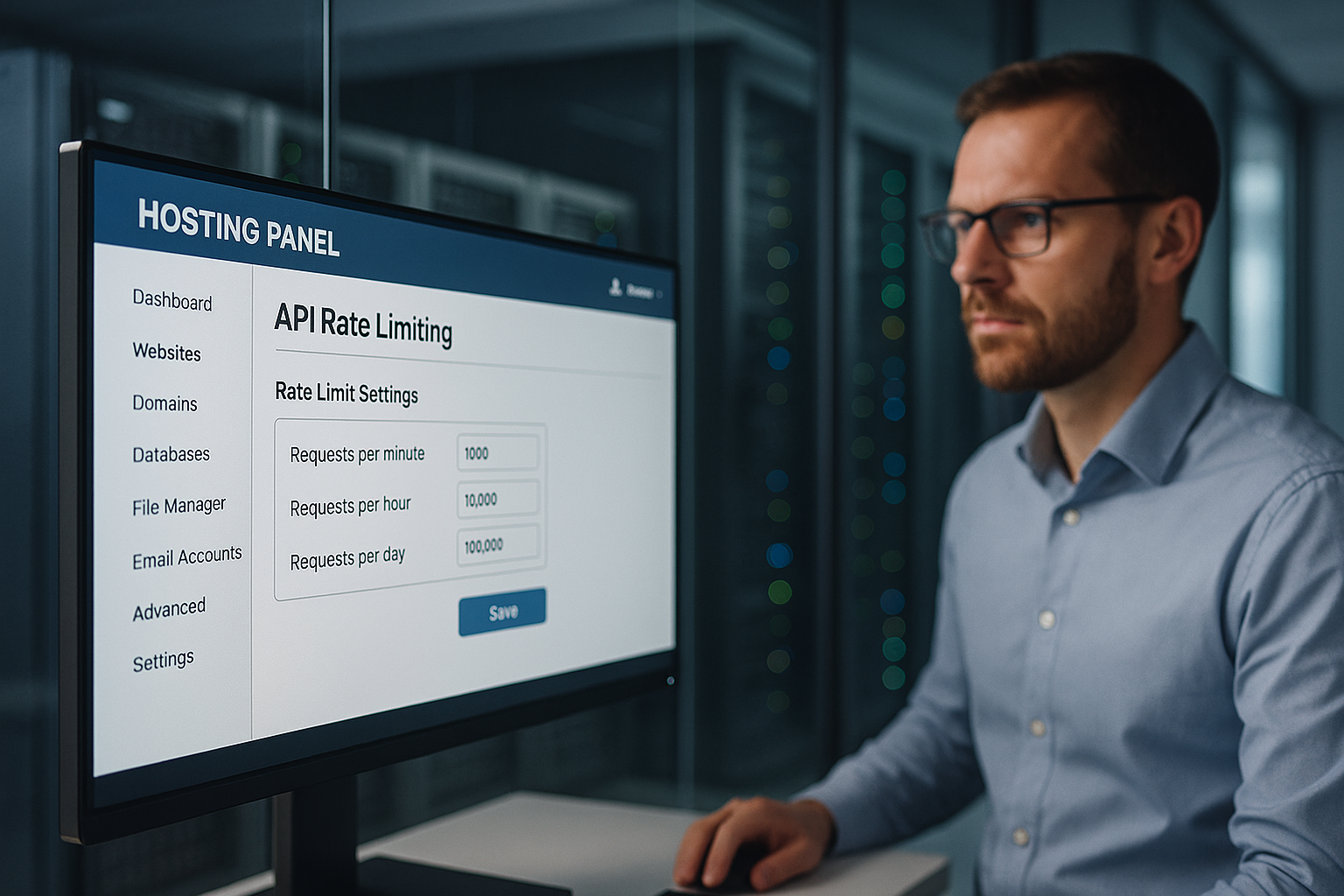

Hosting med begränsning av API-frekvens skyddar en hostingpanel från missbruk genom att strikt kontrollera antalet förfrågningar per IP, API-nyckel och slutpunkt, vilket förhindrar avbrott, missbruk av data och onödiga kostnader. Jag sätter gränser på flera nivåer, upptäcker avvikelser tidigt och skyddar kundrelevanta funktioner som inloggning, fakturering och dataåtkomst mot DDoS, "credential stuffing" och orättvisa belastningstoppar.

Centrala punkter

- Flerskikt Begränsningar: global, användare, slutpunkt

- Algoritmer välj: Token/Leaky/Sliding Window

- Transparent Rubrik: Begränsa, kvarvarande, återställa

- Övervakning i realtid med varningar

- Rättvist förskjutna: kvoter per kundsegment

Varför API-hastighetsbegränsning är oumbärlig i hostingpanelen

Jag använder tydliga gränser för att förhindra det Angripare Blockera inloggnings- eller dataändpunkter med översvämningar av förfrågningar. På så sätt förblir legitima processer tillgängliga medan jag stoppar missbruk och håller latensen låg. All överbelastning på delade servrar kostar pengar och förtroende, så jag stryper överdrivna förfrågningar i tid. Jag förhindrar eskalering genom att dynamiskt justera gränserna innan kapaciteten börjar tryta. Kunderna får konsekventa svarstider eftersom jag upprätthåller rättvisa kvoter och eliminerar okontrollerade toppar.

Hur hastighetsbegränsning fungerar: begrepp och algoritmer

Jag väljer lämplig algoritm beroende på belastningsprofil, endpoint-kritikalitet och förväntade toppar, eftersom en bra process Övergrepp stoppar på ett tillförlitligt sätt och tillåter legitima utbrott. Sliding-window-metoderna jämnar ut hårda gränser, token bucket tillåter snabba kortsiktiga utbrott, leaky bucket upprätthåller ett jämnt flöde. Fast fönster är lämpligt för enkla regler, men kan verka orättvist vid fönsterkanter. Jag kombinerar metoder när slutpunkterna varierar kraftigt, t.ex. inloggning kontra statiskt innehåll. Det gör att jag kan kontrollera flöden utan onödiga blockeringar.

| Algoritm | Typisk användning | Fördel för säkerheten |

|---|---|---|

| Fast fönster | Enkel kvotmodell | Förutsägbar Förpliktelser |

| Skjutfönster | Mer exakt utjämning | Färre tricks vid gränsen |

| Token-hink | Burst-tolerant | Flexibla tips |

| Läckande hink | Konstant genomströmning | Rengör avlopp |

För varje slutpunkt dokumenterar jag den eftersträvade RPS, burststorleken och responsen på överträdelser så att Kontroll förblir reproducerbar. Varje regel är versionerad i infrastrukturen så att revisioner tydligt kan se när vilken gräns gäller.

Begränsningar i flera lager: global, användare, slutpunkt

Jag sätter först en global gräns som definierar Plattform som helhet så att ingen enskild applikation förbrukar kapaciteten. Sedan nivåindelar jag kvoter per kund så att premiumkonton får mer genomströmning utan att tränga ut andra. Slutligen nivåindelar jag slutpunkterna: Auth, betalning, skrivoperationer snävare; lässlutpunkter mer generösa. Jag blockerar inte regelöverträdelser blint, utan ökar först latensen eller ber om en backoff innan jag vidtar hårdare åtgärder. Detta gör användarupplevelsen rättvis, samtidigt som kritiska tjänster förblir skyddade.

Mät trafikmönster korrekt

Jag analyserar typiska topptider, fördelningen per slutpunkt och felfrekvensen eftersom dessa data Gränser karaktärisera. Jag skiljer mellan mänsklig användning och automatiserade mönster via IP-densitet, användaragenter och tokenbeteende. Jag känner igen avvikelser genom en plötslig ökning av 401/403/429-fel eller oregelbundna svarstider. Jag lyfter fram avvikelser och testar sedan strängare regler i en torrkörning för att undvika falsklarm. Först när beteendet bekräftas som stabilt aktiverar jag verkställigheten.

Öppenhet för kunder: Rubriker och felmeddelanden

Jag kommunicerar gränser öppet så att Lag integrera på ett förutsägbart sätt och backa i tid. Jag inkluderar kvoterna i varje svar så att utvecklarna kan kontrollera deras användning. Tydliga felmeddelanden hjälper istället för att frustrera. Det här är ett exempel som jag använder:

X-RateLimit-gräns: 120

X-RateLimit-Resterande: 15

X-RateLimit-återställning: 1731187200

Försök på nytt efter: 30

Jag håller formaten konsekventa och beskriver dem i API-dokumentationen så att det inte finns några luckor i tolkningen och Integration går smidigt.

Kostnads- och komplexitetsbaserade begränsningar och samtidighet

Jag begränsar inte bara den rena begärandegraden, utan också Komplexitet och samtidighet: Beräkningsintensiva sökvägar får högre „kostnader“ än enkla läsningar. Jag tilldelar en poäng per begäran (t.ex. 1 för enkla GETs, 10 för stora exporter) och stryper enligt de totala kostnaderna i tidsfönstret. Jag begränsar också det maximala antalet samtidiga förfrågningar per nyckel för att skydda backend-pooler. Köer med kort TTL förhindrar dånande flockar, medan jag delar rättvist via „max-in-flight“. I händelse av överbelastning stänger jag av i steg: först svarscachning, sedan lässtrypning, slutligen skrivskydd.

Distribuerad verkställighet i kluster

Jag sätter gränser klusterövergripande så att ingen instans blir en bypass. Jag använder centrala räknare (t.ex. Redis) med atomiska inkrement, korta TTL och sharding med nyckelprefix för att undvika hotspots. Jag kombinerar sliding window-räknare med probabilistiska strukturer (t.ex. Approx-räknare) för mycket höga volymer. Jag fångar upp klockförskjutningar genom att låta gateways synkronisera sin tid och beräkna återställningstider på serversidan. Jag isolerar segment i „celler“: varje cellgrupp sätter sina egna gränser så att ett fel förblir lokalt. Fail-closed för kritiska skrivningar, fail-open för icke-kritiska läsningar - detta håller tjänsten robust.

Edge/CDN-integration och regionala kvoter

Jag hindrar trafik från att passera till backend i onödan genom att sätta gränser vid kanten grab: POP-relaterade regler stoppar missbruk tidigt, medan jag definierar regionala kvoter per kontinent eller land. Detta håller användare i närheten snabba, även om toppar inträffar någon annanstans. Edge-cacher minskar trycket på lässlutpunkter; villkorliga förfrågningar (ETag/If-None-Match) minskar den effektiva belastningen. För API:er med flera regioner synkroniserar jag räknare regelbundet och baserat på toleranser så att latenserna inte exploderar.

Klienthantering: Försök, backoff och idempotens

Jag gör kunderna framgångsrika utan att riskera plattformen: Exponentiell backoff med Jitter förhindrar synkroniseringsstormar; 429-svar innehåller tydliga ledtrådar och ett „Retry-After“-värde. För skrivslutpunkter kräver jag idempotency-nycklar så att omförsök inte gör någon skada. Jag använder en exempelkropp för 429 konsekvent:

{

"error": "rate_limited",

"message": "För många förfrågningar. Försök igen efter återställningen eller efter Retry-After.",

"limit": 120,

"remaining": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Jag dokumenterar om „Retry-After“ innehåller sekunder eller ett datum, och sätter tydliga övre gränser för det totala antalet försök. Detta håller klienterna kontrollerbara och plattformen stabil.

Integration i gateways och lastbalanserare

Jag flyttar hastighetsbegränsningen så nära kanten som möjligt: API-gateway först, sedan lastbalanserare, sedan applikationslogik, så att dyra Backend-resurser brinner inte i första hand. Gateways erbjuder färdiga plug-ins för strypning, headerhantering och centraliserade regler. Lastbalanserare fördelar belastningen och upptäcker hotspots tidigt. Applikationen själv ställer in finkorniga kontroller per slutpunkt, inklusive anti-replay och strängare kontroller för mutationer. Om du tar en närmare titt på arkitekturen hittar du API-första hosting Nyttig tankeväckare för rena verkställighetspunkter.

Försvar mot DDoS, brute force och credential stuffing

Jag känner igen DDoS-mönster med distribuerade IP-adresser, enhetliga vägar och toppar utan verkligt sessionsdjup och saktar ner dem med hårdn kvoter per IP och subnät. Jag stoppar brute force vid inloggning med snävt inställda bursts, captcha-uppföljning och progressiva fördröjningar. Jag avslöjar referensstoppning via kända läckor, serier med misslyckade försök och fingeravtryck. Om tröskelvärdena överskrids blockerar jag tillfälligt och kräver ytterligare verifiering. Jag använder signaler för automatiserade fiender Bot-hantering, så att de verkliga användarna inte blir lidande.

Rättvisa och nivåindelning: kvoter per kundsegment

Jag fördelar kvoterna på ett transparent sätt: Enterprise får större budgetar, Starter mindre, så att Kostnader förblir förutsägbara och alla har rättvis tillgång. Exempel på riktlinje: 5 000, 1 000 och 100 förfrågningar per minut för Enterprise, Professional och Starter. Särskilt känsliga sökvägar som /auth, /billing eller /write ligger under detta, medan read endpoints är mer generösa. Jag kontrollerar varje månad om segmenten eller gränserna bör justeras, till exempel på grund av nya användarbeteenden. På så sätt säkerställer jag tillväxt utan att riskera plattformens kvalitet.

API:er i realtid: WebSockets, SSE och streaming

Jag begränsar inte bara HTTP-förfrågningar, utan även Anslutningar och meddelandehastigheter: Maximalt antal samtidiga WebSocket-anslutningar per konto, meddelanden per sekund och bytebegränsningar per kanal förhindrar pratglada klienter. Jag skyddar sändningar med kanalkvoter och separerar systemhändelser från användarhändelser. Heartbeat-intervaller och timeouts håller zombieanslutningar till ett minimum. För SSE stryper jag återanslutningsfrekvenserna och använder cachevänliga händelsebatcher för att jämna ut belastningstoppar.

Inkommande webhooks och backpressure

Jag säkrar inkommande webhooks från externa tjänster med Buffring av inmatning, dedikerade gränser och kretsbrytare. Vid överbelastning svarar jag med 429/503 inklusive „Retry-After“ och accepterar endast signerade, idempotenta leveranser. Jag isolerar webhook-bearbetningen i köer för att undvika blockering av kärn-API:erna och tillhandahåller leveransrapporter så att partnerna kan finjustera sina retry-strategier.

Dataskydd och efterlevnad inom telemetri

Jag loggar bara det som är nödvändigt: hashes istället för fullständiga IP-nummer, korta Kvarhållande för råa loggar, tydlig ändamålsbegränsning för revisions- och faktureringsdata. Händelser som rör prisgränser innehåller pseudonymiserade nycklar; jag dokumenterar lagringsperioder och åtkomsträttigheter. Detta säkerställer efterlevnad av GDPR-kraven utan att förlora säkerhet och transparens.

Övervakning, varningar och åtgärdsplaner

Jag övervakar förfrågningsvolymer, felfrekvenser och väntetider i korta fönster så att jag kan tidigt känna igen eskalerande mönster. Jag definierar varningar strax under kapaciteten för att ge utrymme för åtgärder. Om 95%-tröskeln sjunker skalar jag upp gränserna eller omfördelar trafiken. Om 5xx-frekvensen ökar letar jag först efter orsakerna: felaktiga implementeringar, hotspots i databasen, avvikande slutpunkter. Sedan kommunicerar jag status och lösningar till kunderna innan jag stramar åt kvoterna.

Konfiguration, tester och säkra utrullningar

Jag hanterar regler som Kod (versionshantering, granskning, CI-kontroller) och lansera ändringar via funktionsflaggor: först skuggläge (endast åtgärd), sedan procentuell lansering och slutligen fullständig tillämpning. Syntetiska kontroller kontrollerar 429 vägar, header-konsistens och retry-after-logik. Kaostester simulerar bursts, key fanout och Redis latency så att driften förblir stabil även under stress. Jag vitlistar nödvändiga systemklienter (build pipelines, compliance scanners) under en begränsad tidsperiod för att minimera falsklarm.

Förhindra förbikopplingar: Bypass, key fanout och normalisering

Jag täpper till luckor som angripare kan använda för att åsidosätta gränser: Nyckel fanout (tusentals engångsnycklar) begränsas med kvoter på högre nivå per konto, organisation och IP/undernät. Jag normaliserar sökvägar (stora/små bokstäver, Unicode, aliasvägar) så att identiska slutpunkter inte räknas flera gånger. Jag korrelerar signaler (IP, ASN, enhetsfingeravtryck, session, token-ursprung) så att snabba IP-rotationer inte leder till oändliga budgetar. För särskilt känsliga vägar kräver jag starkare autentisering (mTLS/OAuth scope).

Rättvis fakturering för överanvändning

Jag skapar Planerbarhet, genom att erbjuda valfria modeller för checkräkningskrediter: extra kvoter som kan bokas i förväg, automatiska tak (mjukt/hårt tak) och transparenta månadsrapporter. På så sätt hålls kostnaderna under kontroll samtidigt som teamen inte behöver bromsa tillfälliga projekt. Jag ger tidiga meddelanden via webhooks och e-post när kvoterna når 80/90/100% och föreslår lämpliga uppgraderingar innan hårda gränser träder i kraft.

Finjustering: tester, loggar och kontinuerlig justering

Jag validerar gränser med belastnings- och stresstester, loggar 429 händelser på detaljnivå och anpassar dem. Regler baserat på verklig användning. Jag minimerar falska positiva resultat med vitlistor för compliance-scanningar och build pipelines. För API:er med grafbaserade frågor testar jag fältkomplexitet för att täcka orättvisa frågor. Det är värt att ta en titt på GraphQL i webbhotellets panel, eftersom begränsningar av frågedjup och kostnader effektivt kompletterar hastighetsbegränsning. Kontinuerlig iteration håller balansen mellan skydd och prestanda.

Sammanfattning: skydd, rättvisa och förutsägbar prestanda

Jag använder hastighetsbegränsning i flera lager så att Kunder kan fungera på ett tillförlitligt sätt, medan missbruk inte har någon chans. Kombinationen av lämpliga algoritmer, transparent kommunikation och tydliga kvoter gör att plattformen är responsiv. Jag minimerar riskerna och håller kostnadsintensiva toppar under kontroll med hjälp av övervakning och tester. Förnuftiga modeller för nivåindelning säkerställer rättvisa och utrymme för tillväxt. Om man tänker gränser som produktregler får man stabila tjänster och nöjda användare.