wordpress redis snabbar upp WordPress märkbart eftersom jag cachar dynamiska databasfrågor som objekt i RAM-minnet och därmed minskar belastningen på CPU. Jag konfigurerar cachelagring specifikt från objekt- till sid- till servercachelagring och kombinerar Redis med lämpliga plugins så att sidförfrågningar blir betydligt snabbare och tiden till första byte minskas.

Centrala punkter

Innan jag går djupare ska jag sammanfatta de viktigaste justeringarna som gör WordPress med Redis riktigt snabbt och samtidigt enkelt att administrera. Jag fokuserar på objektcaching med Redis, kompletterar det på ett förnuftigt sätt med sidcache och CDN och kontrollerar varje ändring med mätvärden. Jag väljer en hosting-tariff som tillhandahåller Redis på ett tillförlitligt sätt och erbjuder tillräckligt med RAM-minne för cachen. Jag kör Redis på ett säkert sätt, avgränsar instanser och rensar cachen på ett kontrollerat sätt. Jag håller konfigurationen slimmad, mäter regelbundet och justerar vid behov.

- Cache för objekt i RAM-minnet minskar antalet frågor och förkortar svarstiderna.

- Sidans cache lägger till Redis, särskilt för anonyma besökare.

- RAM-budget och LRU-strategi säkerställer konsekvent prestanda.

- Säker Anslutning och separata DB-ID:n förhindrar konflikter.

- Övervakning med mätvärden som visar de verkliga effekterna av varje förändring.

Varför cachelagring är obligatoriskt i WordPress

WordPress genererar varje sida dynamiskt, vilket utlöser många databasfrågor och leder till märkbara väntetider utan cache. Jag avbryter denna dyra cykel genom att spara fullständigt beräknade resultat i Cache och leverera den direkt nästa gång den anropas. Detta minskar belastningen på PHP och MySQL, och svarstiderna blir betydligt kortare. Mätningar visar att objektcaching kraftigt minskar laddningstiderna; exempelvärden går ner från 800 ms till cirka 450 ms [1][2]. Sökmotorer värderar korta svarstider positivt och besökare stannar längre eftersom sidor som Tillgångar öppna snabbare [1][2][5].

Hur Redis fungerar i objektcachen

Redis håller ofta använda objekt i arbetsminnet och levererar dem utan att gå via databasen. I WordPress hamnar t.ex. resultaten av WP_Query, alternativvärden eller transienter direkt i RAM-cache. Detta minskar drastiskt antalet rundresor till databasen och sparar servertid för komplexa sammanfogningar eller sorteringar. Till skillnad från en ren sidcache förblir sidan dynamisk eftersom Redis tillhandahåller datablock som WordPress sedan kombinerar. Detta tillvägagångssätt är perfekt för butiker, medlemsområden och mycket personliga komponenter, där fullständiga sidor sällan är identiska och en snabb Objekt-access hjälper märkbart [1][2][3].

Exakt vad som hamnar i cachen - och vad som inte borde göra det

Alla objekt är inte lämpliga för persistent cachelagring. Jag utesluter medvetet dynamiska eller säkerhetskritiska data (t.ex. nonces, sessioner, inloggningsstatus) eller kategoriserar dem som beständiga. icke beständig grupper. Mer stabilt innehåll som t.ex. sökresultat, alternativvärden, menyer, taxonomikartor eller produktlistor är mycket bra kandidater. I mer komplexa konfigurationer definierar jag globala grupper (t.ex. för alternativ) som är desamma i hela installationen, och icke-beständiga gruppersom måste förbli färska per begäran. Detta gör att cachen förblir konsekvent och förhindrar att flyktiga värden blir föråldrade.

För miljöer med flera instanser eller flera webbplatser anger jag ett unikt prefix så att nycklar förblir tydligt åtskilda och nycklar från olika projekt inte skriver över varandra. Jag använder ett talande salt/prefix för detta, helst med en miljöreferens (staging, prod):

// wp-config.php (exempel)

define('WP_CACHE_KEY_SALT', 'acme_prod_');

define('WP_REDIS_PREFIX', 'acme_prod_'); // beroende på vilket insticksprogram som stöds

Det innebär att nycklar kan rensas på ett målinriktat sätt och att jag med en blick i verktyg eller loggar kan se vilket projekt en post tillhör. Speciellt i CI/CD-arbetsflöden sparar detta mig gissningar av selektiva ogiltigförklaringar.

Installera Redis: Steg-för-steg på servern

Jag installerar först Redis-tjänsten på servern och kontrollerar om den är tillgänglig. På Debian/Ubuntu uppdaterar jag paketlistorna, installerar Redis och testar anslutningen med PING. Sedan lägger jag till Redis-tillägget i PHP så att WordPress kan tala. Sedan aktiverar jag ett lämpligt plugin för objektcache i backend och ansluter WordPress till tjänsten. Detta ger en snabb Objekt-cache, som på ett tillförlitligt sätt levererar data från minnet.

sudo apt uppdatering

sudo apt installera redis-server

redis-cli ping # Förväntat: PONG

sudo apt installera php-redis

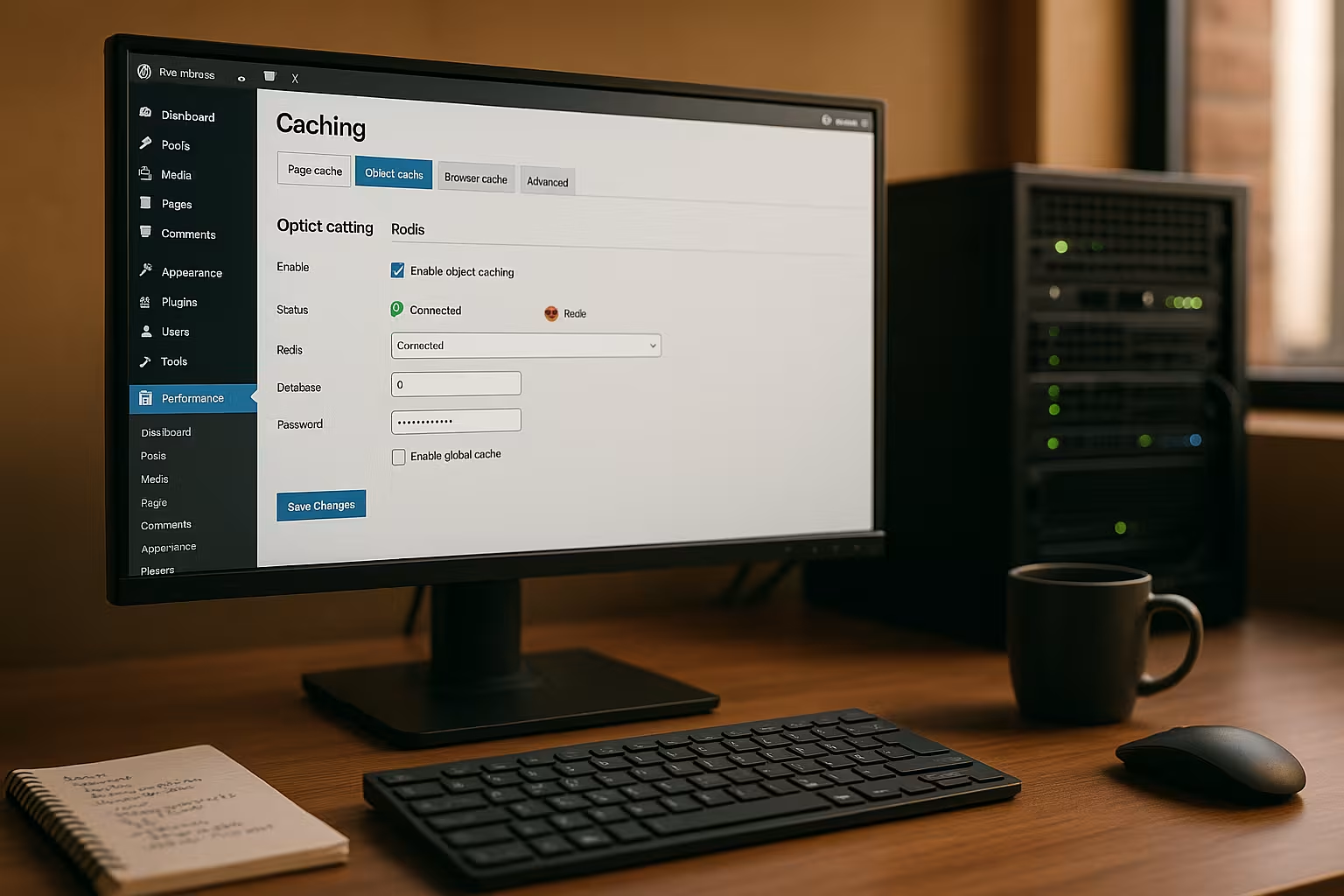

I nästa steg aktiverar jag plugin-programmet "Redis Object Cache" i WordPress och kontrollerar anslutningsstatusen. Många hostar inkluderar redan Redis eller tillåter att det aktiveras i panelen, vilket gör anslutningen särskilt enkel. Jag kontrollerar att socket- eller TCP-inställningarna är korrekta och rensar cachen en gång efter aktiveringen. Sedan mäter jag svarstiderna igen för att minimera effekten av Ändring kan ses tydligt [2][3][4].

Serialiserings-, komprimerings- och PHP redis-alternativ

Hur data hamnar i Redis påverkar hastigheten och RAM-förbrukningen. Om det finns tillgängligt använder jag en effektiv serialiserare (t.ex. igbinary) och valfri komprimering för stora objekt. Detta minskar minnesbelastningen och påskyndar deserialiseringen. Många plugins erbjuder switchar för detta i inställningarna; alternativt ställer jag in konstanter i wp-config.php om pluginet utvärderar dem. Tumregel: Stora objekt som ändras sällan har särskilt stor nytta av detta, mycket små nycklar har mindre nytta av det.

// wp-config.php (exempel, beroende på plugin)

define('WP_REDIS_SERIALIZER', 'igbinary'); // eller 'php'

define('WP_REDIS_COMPRESSION', 'true');

define('WP_REDIS_MAXTTL', 86400); // Max. Livstid (1 dag)

Med en rimlig MaxTTL Jag förhindrar "eviga" poster som aldrig uppdateras. Detta håller cacheminnet fräscht och förhindrar inkonsekventa visningslägen [1][4].

Redis och WordPress-plugins: kraftfulla kombinationer

Många cacheplugins kan använda Redis som backend för objektcachen och komplettera den med sidcache, HTML-minifiering eller bildoptimering. Jag gillar särskilt att använda LiteSpeed Cacheeftersom jag enkelt kan kontrollera objektcache med Redis, edge-side inkluderar och bildformat som WebP där. Jag aktiverar objektcachen i inställningarna, väljer "Redis" som metod och anger host, port eller socket. Anslutningstestet visar mig omedelbart om allt är igång och om cachen fungerar. Denna kombination ger dynamisk Innehåll snabbt och ser också till att anonyma besökare ofta serveras direkt från sidans cache.

WooCommerce, medlemsområden och ESI

För butiker och inloggningsområden håller jag specifikt tillbaka sidcachen, men förlitar mig starkt på objektcachen. För delar som är personaliserade (varukorgsindikator, hälsning, önskelistor) använder jag ESI (edge-side includes) eller hämtar fragmenten på klientsidan. Det är viktigt att ha en tydlig Varierande(t.ex. enligt cookies eller roller) så att anonyma besökare får maximal nytta, medan inloggade användare ser konsekvent, dynamiskt innehåll. Redis levererar byggstenarna blixtsnabbt utan att behöva förlita sig på full page identity [1][2][3].

Finjusteringar: wp-config och redis.conf

För socket-anslutningar ställer jag in specifika konstanter i wp-config.php så att WordPress använder rätt adress. Jag definierar schemat och sökvägen och kontrollerar om uttaget finns och har lämpliga behörigheter. Jag använder redis.conf för att begränsa minnet med maxmemory och väljer en förnuftig eviction-policy, ofta allkeys-lru. På så sätt håller jag cachen beräkningsbar och förhindrar Redis från att ge systemet RAM är omtvistad. Jag tilldelar också ett lösenord eller använder bindningsadresser och brandväggar så att ingen kan komma åt Redis från utsidan. frågor [1][4].

// wp-config.php

define('WP_REDIS_SCHEME', 'unix');

define('WP_REDIS_PATH', '/tmp/redis.sock');

// redis.conf (exempel)

maxminne 256mb

maxminne-policy allkeys-lru

kräver lösenord SecretPassword123

TTL-strategier, avhysningar och riktad invalidisering

En bra cache är inte bara snabb, utan också förutsägbar. Jag tilldelar TTL enligt dataklass: korta TTL för flyktiga flöden, längre för menyer, nästan inga för taxonomitilldelningar som sällan ändras - begränsat av en MaxTTL. För uppdateringar ogiltigförklarar jag selektivistället för att rensa hela cacheminnet: När jag sparar en produkt rensar jag bara nycklar som påverkar relevanta kategorier, prisfilter, produktlistor eller widgets. Detta håller träfffrekvensen hög och minimerar toppbelastningar [2][4].

Om avhysningspolicyn: alla nycklar-lru är vanligtvis det mest robusta valet eftersom det först ersätter föråldrade, lite använda tangenter. Om min installation har strikta TTL-specifikationer kan jag flyktig-lru kan vara vettigt (endast tangenter med TTL förskjuts). Jag övervakar missfrekvensen efter ändringar; om den stiger kraftigt är RAM-budgeten ofta för liten eller TTL för kort [1][4].

Typiska fel och snabba lösningar

Om WordPress blandar ihop socket och TCP förblir objektcachen tom eller rapporterar anslutningsfel. Jag kontrollerar då plugin-inställningarna, host/port eller Unix-sockeln och tittar på serverloggarna. Om cachen töms för ofta justerar jag TTL-värdena och ogiltighetsutlösarna, t.ex. när du sparar inlägg eller produkter. För flera WordPress -instanser tilldelar jag separata Redis-databaser så att poster inte skriver över varandra. På så sätt håller jag Uppgifter rent separerade och får en tydligt begriplig Cache-struktur [4].

Undvik cache-stampedyn

Utan skyddsmekanismer kan utgången av många populära nycklar leda till en "Thundering Herd": Hundratals förfrågningar om att bygga om samma innehåll. Jag mildrar detta genom att ställa in något förskjutna TTL, skydda ombyggnader med lås och - om plugin erbjuder det - använda Avstannar under omvalidering användning: Utgångna poster levereras kortvarigt medan nya poster skapas i bakgrunden. Detta håller svarstiderna stabila, även under trafiktoppar [2][3].

Mät och accelerera permanent

Jag förlitar mig inte på magkänsla utan mäter TTFB, First Contentful Paint och serverns svarstider före och efter varje förändring. Verktyg i webbläsaren, servermetrik och plugin-statistik visar mig flaskhalsar. Jag kombinerar också objektcache med clean page cache och avlastar PHP via serversidemekanismer som Nginx microcaching eller Apache accelerators. En bra introduktion ges av den kompakta Cachelagring på serversidan Översikt. Så här ökar jag antalet Prestanda steg för steg och uppnå permanent kort Laddningstider.

Viktiga nyckeltal och diagnostiska kommandon

Jag tittar regelbundet på dessa mätvärden för verksamheten:

- Keyspace träffar/missarRatio visar hur effektiv objektcachen är.

- avhysda_nycklar och utgångna_nycklarIndikerar för lite RAM-minne eller för korta TTL:er.

- använt_minne, mem_fragmentering_förhållande: Ger information om faktisk användning och fragmentering.

- anslutna_klienter, blockerade_klienter: Indikationer på flaskhalsar vid hög belastning.

Jag använder enkla kommandon på servern, till exempel redis-cli INFO, redis-cli MONITOR (endast under en kort tid) och redis-cli MINNESSTATUS. I själva WordPress hjälper debugplugins och statistiken för Object Cache-plugin till att bedöma cache-träffar, latenser och grupper [2][4].

Alternativen kortfattat kategoriserade

Filbaserad cachelagring fungerar enkelt, men begränsas av tung trafik eller många dynamiska element. Memcached är också en in-memory cache och är snabb, men erbjuder färre datatyper och mindre flexibilitet än Redis. Page cache lagrar kompletta HTML-sidor och är perfekt för anonyma användare, medan object cache accelererar dynamiska komponenter. Tillsammans med ett CDN minskar jag avstånd och belastningstoppar över hela världen. Rätt Kombination bestämmer resultatet, och Redis tillhandahåller den snabba Understruktur.

När jag avsiktligt inte använder Redis

Mycket små webbplatser utan databasbelastning eller extremt statiska projekt (headless med förrenderade sidor) har endast minimala fördelar. Även med mycket begränsat RAM-minne på delade system kan en för liten cache orsaka fler evakueringar än fördelar. I sådana fall brukar jag fokusera på sidcache och ren tillgångshantering och bara byta till Redis när uppmätta värden visar en tydlig vinst [1][5].

Hosting med Redis: en kort jämförelse

För tillförlitlig objektcachelagring behöver du en leverantör som tillhandahåller Redis och tillåter tillräckligt med RAM-minne för cachen. Jag letar efter garanterade resurser, SSH-åtkomst och möjlighet att konfigurera sockets eller portar på rätt sätt. En väldokumenterad panel och snabb support sparar tid i det dagliga arbetet. I följande översikt visar jag nyckeldata för ett typiskt urval. Så här hittar du rätt Tariff lättare att välja och den senare Konfiguration lyckas smidigt.

| Leverantör | Stöd för Redis | Prestanda | Pris/prestanda | Stöd |

|---|---|---|---|---|

| webhoster.de | Ja | Högsta klass | Utmärkt | Mycket bra |

| Leverantör B | Delvis | Bra | Bra | Bra |

| Leverantör C | Nej | Tillräcklig | Tillräcklig | Tillfredsställande |

Skalning, fördröjning och hög tillgänglighet

När ett projekt växer uppmärksammar jag topologin: lokala UNIX-sockets är snabbast, så länge webbservern och Redis körs på samma värd. För separata servrar väljer jag en nära nätverkslatens och säkerställer tillräcklig bandbredd. För Hög tillgänglighet replikering och sentinel; med rena cache-konfigurationer klarar jag mig ofta utan persistens (RDB/AOF) för att spara I/O. Om en nod går förlorad bygger cachen upp sig själv igen och sidan kan fortfarande serveras snabbt tack vare sidcachen [3][4].

Säkerhet och multisite/multi-instance-konfigurationer

Jag exponerar aldrig Redis oskyddat mot det publika nätverket och ställer in bindningsadresser, brandväggsregler och ett lösenord. På delade servrar föredrar jag att använda Unix-sockets med restriktiva behörigheter. Om jag kör flera WordPress-installationer tilldelar jag varje webbplats ett eget Redis DB-ID och, om möjligt, separata namnrymder. Detta förhindrar kollisioner och hjälper mig att hålla överblicken. Säkerhet kostar knappast någon tid, men bevarar Integritet uppgifterna och skyddar Tillgänglighet.

ACL:er, rättigheter och åtkomstbegränsning

Förutom lösenordet ställer jag in dedikerade Redis-användare med begränsade rättigheter där det är möjligt. Jag tillåter bara de kommandon som min installation behöver och blockerar administrativa kommandon. Binda adresser (binda 127.0.0.1 ::1) och brandväggar begränsar åtkomsten till interna nätverk. Jag använder separata åtkomstdata och prefix för staging och utveckling, så att jag aldrig av misstag kan skriva över produktiva data [4].

Praktiskt arbetsflöde: från testning till driftsättning

Jag börjar i en staging-miljö, aktiverar Redis, mäter, optimerar och rullar ut ändringarna enligt plan. Innan jag går live rensar jag cacheminnet, värmer upp viktiga sidor och övervakar serverns mätvärden under belastning. Om timeouts eller ovanliga missfrekvenser inträffar justerar jag policyer, TTL och storlek. För mer djupgående tuning-idéer använder jag regelbundet kompakta guider på WordPress prestanda. Det är så jag säkerställer en kontrollerad Inledning och få en rent dokumenterad Konfiguration.

Förvärmning, utsläpp och selektiv rensning

Efter driftsättningar förhindrar jag kallstarter genom att automatiskt hämta viktiga sidor (sitemap-baserad prewarming) och prewarming av kritiska frågor. När jag släpper innehåll rensar jag specifika drabbade områden (t.ex. en kategori och dess arkivsidor), inte hela webbplatsen. Detta håller träfffrekvensen hög och säkerställer att toppbelastningar träffar cacher som redan är varma. Jag dokumenterar vilka hooks som utlöser rensningar och testar dessa sökvägar i staging så att livekörningen går smidigt [2][4][5].

Att ta med sig: Min korta sammanfattning

Redis påskyndar WordPress avsevärt eftersom objektcachen sparar dyra frågor och levererar innehåll direkt från minnet. Jag kombinerar Redis med en sidcache och, beroende på projektet, ett CDN för global räckvidd. Med en ren installation, korrekta socket-/portspecifikationer, lämpliga minnesgränser och en säker anslutning förblir systemet snabbt och tillförlitligt [1][2][3][4][5]. Mätvärden avgör varje förändring, inte magkänsla. Det är så här jag uppnår korta Laddningstiderbättre Användarupplevelse och en märkbart snabbare WordPress-webbplats.