I den här guiden visar jag dig hur du Plesk-tillägg snabba upp mitt dagliga arbete som utvecklare, möjliggöra säkra driftsättningar och automatisera återkommande uppgifter. Jag ger tydliga rekommendationer om val och installation - inklusive installationssteg, förnuftiga standardvärden och typiska fallgropar.

Centrala punkter

- Inställning och förnuftiga standardvärden för säkerhet, säkerhetskopiering, prestanda

- Arbetsflöde med Git, staging, CI-hooks och containerstackar

- Säkerhet genom Imunify360, Let's Encrypt och smarta härdningskoncept

- Hastighet via Cloudflare CDN, cachelagring och övervakning

- Skalning med Docker, automatisering och tydliga roller

Varför Plesk snabbar upp mitt arbete som utvecklare

Jag samlar projekt, domäner och servrar centralt och sparar på så sätt pengar varje dag. Tid. Tilläggen täcker utveckling, säkerhet, prestanda och automatisering och passar perfekt ihop. Jag styr uppdateringar och migreringssteg direkt i panelen, utan omvägar via skalskript för standarduppgifter. Tack vare drag & drop kan jag sortera de viktigaste verktygen dit jag behöver dem oftast och hålla mig i flödet. Om du först vill ha en överblick kan du börja med De bästa Plesk-tilläggen och prioriterar sedan utifrån projekttyp och teamstorlek.

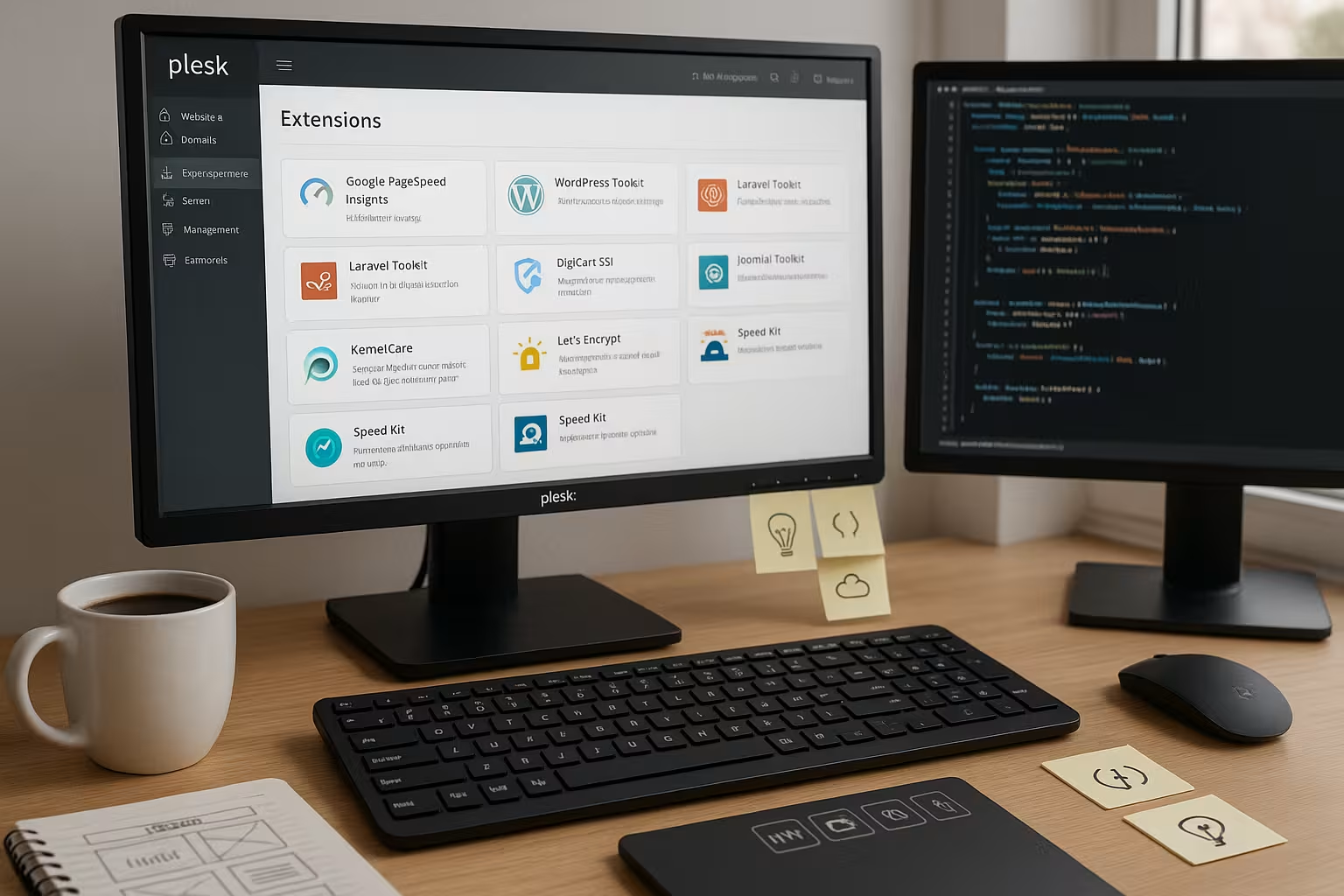

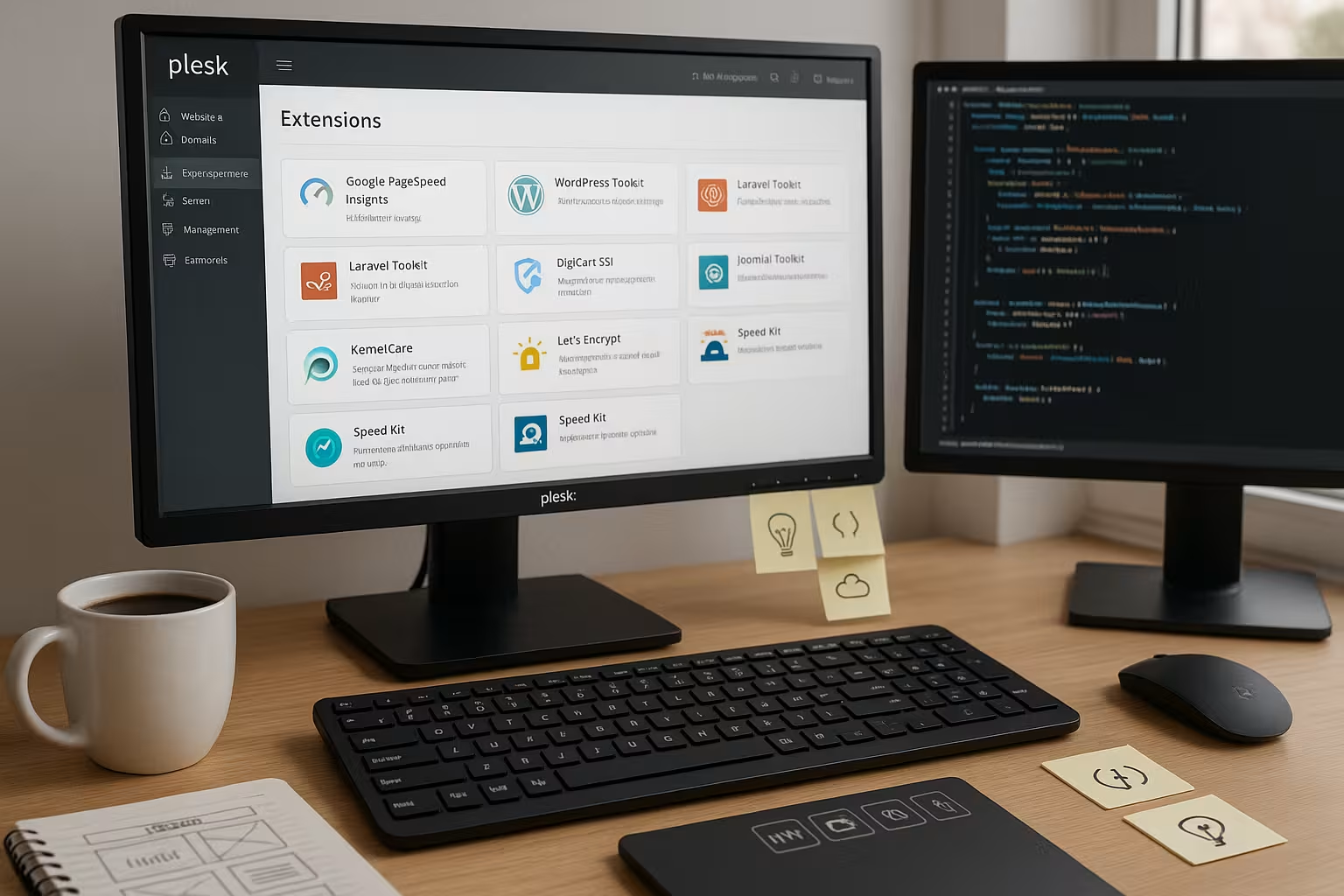

De bästa Plesk-tilläggen i en överblick

För moderna arbetsflöden förlitar jag mig på en tydlig kärna av WordPress Toolkit, Git, Docker, Cloudflare, Imunify360, Let's Encrypt och Acronis Backup. Detta urval omfattar distributioner, härdning, SSL, CDN och säkerhetskopiering av data. Jag brukar börja med WordPress Toolkit och Git, sedan lägga till Docker för tjänster som Redis eller Node och sedan koppla på Cloudflare. SSL och säkerhet körs parallellt, varvid jag omedelbart aktiverar automatisk förnyelse för nya instanser. I följande tabell sammanfattas fördelarna och användningen.

| Förlängning | Viktigaste förmånen | Lämplig för | OS | Inställning i Plesk |

|---|---|---|---|---|

| WordPress-verktygslåda | Staging, kloning, uppdateringar | WP-webbplatser, byråer | Linux/Windows | Installera, skanna instans, skapa staging, ställa in automatiska uppdateringar |

| Git-integration | Versionskontroll, driftsättning | Alla webbapplikationer | Linux/Windows | Anslut repo, välj gren, aktivera webhook/auto-deploy |

| Docka | Stapling av behållare | Mikrotjänster, Verktyg | Linux/Windows | Välj image, ställ in miljövariabler, släpp portar |

| Cloudflare | CDN & DDoS | Toppar i trafiken | Linux/Windows | Anslut zon, aktivera proxy, välj cachningsnivå |

| Imunify360 | Skydd mot skadlig programvara | Fokus på säkerhet | Linux/Windows | Skapa skanningspolicy, kontrollera karantän, ställ in brandväggsregler |

| Låt oss kryptera | SSL-automatisering | Alla projekt | Linux/Windows | Begär certifikat, automatisk förnyelse på, HSTS valfritt |

| Acronis Säkerhetskopiering | Backup i molnet | Verksamhetskritisk | Linux/Windows | Skapa plan, välj tidsfönster, testa återställning |

Jag fattar beslut baserat på projektmål, inte på vana, och behåller stacken smal. Varje utökning kostar resurser, så jag väljer bara fler när det finns en klar fördel. För team rekommenderar jag att du registrerar kortlistan i dokumentationen och definierar bindande standardvärden. På så sätt blir inställningarna konsekventa och nya kollegor hittar snabbare rätt. Öppenhet i urvalet minskar det efterföljande underhållsarbetet.

WordPress Toolkit: Inställningar och användbara standardvärden

Jag börjar med en skanning så att Plesk automatiskt skannar alla instanser. erkänner. Jag skapar sedan en staging för varje produktiv webbplats, aktiverar synkroniseringen av filer och väljer databastabeller om det behövs. Jag ställer in automatiska uppdateringar för kärnan för att säkra, för plugins till manuell eller förskjuten per underhållsfönster. För varje förändring testar jag först i staging, kontrollerar säkerhetskontroller och går sedan live. Om du vill titta djupare kan du hitta användbar bakgrundsinformation i Detaljer om WordPress Toolkit.

Jag använder kloningsfunktionen för blå / gröna tillvägagångssätt och håller en rollback-plan redo. Detta gör att jag kan minska stilleståndstiderna vid större uppdateringar. För flera webbplatser avaktiverar jag onödiga plugins på staging-instanser för att göra tester snabbare. Säkerhetsskanningar körs dagligen och jag kontrollerar karantän kortfattat i instrumentpanelen. Detta hjälper mig att minimera riskerna och planera driftsättningar.

Git-integration: Rena driftsättningar utan omvägar

I Plesk ansluter jag ett Git-repo, väljer den relevanta grenen och aktiverar Auto-Deploy på Tryck på. Eventuellt ställer jag in webhooks för CI, som kör builds och tester före live-distributionen. För PHP-projekt skapar jag ett byggsteg för Composer-installationen, för Node-projekt lägger jag till npm ci och en Minify-uppgift. Jag ställer in deploy-kartan så att endast nödvändiga kataloger körs på webroot, medan byggartefakter genereras utanför. Jag håller åtkomstnycklar och behörigheter enkla och roterar dem regelbundet.

Innan jag går live gör jag en hälsokontroll via en underhålls-URL och verifierar viktiga data. Huvud. Pipelinen stoppar utrullningen automatiskt i händelse av fel. På så sätt undviker jag halvfärdiga utrullningar som är svårare att fånga upp senare. Jag dokumenterar grenkonventioner för team och använder pull requests som ett krav. På så sätt blir samarbetet förutsägbart och spårbarheten hög.

Docker i Plesk: produktiv användning av containrar

För tjänster som Redis, Elasticsearch, Meilisearch eller tillfälliga förhandsgranskningsappar startar jag containrar direkt i Panel. Jag väljer images från hubben, ställer in miljövariabler, mappar portar och binder persistenta volymer. Jag kontrollerar hälsokontroller med enkla endpoints så att Plesk rapporterar falska starter. För scenarier med flera containrar arbetar jag med tydliga namngivningskonventioner och dokumenterar beroenden. Om du behöver en bra introduktion kan du använda den kompakta guiden till Docker-integration i Plesk.

I takt med att projekten växer skalar jag tjänsterna horisontellt och kapslar in tillståndspåverkande komponenter så att säkerhetskopiorna förblir konsekventa. Jag för över loggar till separata kataloger och roterar dem regelbundet. Jag testar först uppdateringar i en separat containerversion innan jag byter över. Jag lägger bara till DNS-poster efter tillförlitliga hälsokontroller. På så sätt blir driftsättningarna kontrollerbara och reproducerbara.

Säkerheten först: konfigurera Imunify360 och Let's Encrypt korrekt

Jag aktiverar automatisk Skannar i Imunify360 och definierar tydliga åtgärder för detektioner, till exempel karantän med avisering. Jag håller brandväggsreglerna strikta och tillåter bara det som verkligen är nödvändigt. Jag ställer in Let's Encrypt så att det förnyas automatiskt för alla domäner och lägger till HSTS om webbplatsen konsekvent körs via HTTPS. Jag kontrollerar också säkerhetsrubriker som CSP, X-Frame-Options och Referrer-Policy. Regelbundna rapporter visar var jag behöver strama upp.

Jag använder tvåfaktorsautentisering för administratörsinloggningar och begränsar åtkomsten till specifika IP-adresser. SSH-åtkomst sker via nycklar, jag avaktiverar lösenord där det är möjligt. Jag krypterar säkerhetskopior och testar återställningsprocessen regelbundet. Jag har en lista över kritiska plugins och kontrollerar deras ändringsloggar före uppdateringar. Säkerhet är en daglig uppgift, inte en engångsföreteelse Konfiguration.

Hastighet via CDN: smart konfiguration av Cloudflare

Jag ansluter zonen, aktiverar proxyn och väljer en cachelagringsnivå som möjliggör dynamiskt innehåll. respekterad. För API:er slår jag på cache per rubrik, för tillgångar ställer jag in långa TTL:er med versionshantering. Jag använder sidregler för att utesluta adminområden från cachning och för att strikt skydda känsliga sökvägar. HTTP/2, Brotli och Early Hints ökar laddningshastigheten utan kodändringar. Under trafiktoppar dämpar hastighetsbegränsningar försök till missbruk.

Utmanings- och botregler minskar onödig belastning på backend-system. Jag övervakar HIT/MISS-frekvensen och justerar reglerna tills önskad cachekvot har uppnåtts. För internationella projekt arbetar jag med geostyrning och regionala kartvarianter. Jag dokumenterar DNS-ändringar i ändringsloggen så att rollbacks kan utföras snabbt. Detta gör prestandan mätbar och planeringsbar.

Säkerhetskopiering, återställning och omstart med Acronis

Jag skapar dagliga inkrementella säkerhetskopior och säkerhetskopierar varje vecka full till molnet. Jag behåller lagringen på ett sådant sätt att jag kan komma åt minst 14 dagars historik. Efter varje större release testar jag en återställning i en isolerad miljö. Jag mäter återställningstiderna regelbundet så att jag har realistiska förväntningar i en nödsituation. Jag säkerhetskopierar databaser på ett transaktionskonsistent sätt för att undvika korruption.

Jag har en separat säkerhetskopia utanför webbplatsen för kritiska webbplatser. Playbooks för återställning beskriver stegen, inklusive DNS-växling och rensning av cachning. Jag lagrar lösenord och nycklar i krypterad form och roterar dem en gång i kvartalet. Jag anser att säkerhetskopior utan teståterställning är ofullständig. Endast det som har praktiserats kommer att fungera säkert i en nödsituation.

Automatisering och övervakning: förenkla de dagliga rutinerna

Jag automatiserar återkommande Uppgifter med cron-jobb, hook-skript och git-aktioner. Loggar körs i centrala kataloger, rotationen håller minnet rent. Jag använder Webalizer för enkla trafikanalyser och letar efter avvikelser när 4xx- och 5xx-koderna ökar. Jag ställer in varningar så att de förblir relevanta för åtgärder och inte orsakar varningströtthet. Jag dokumenterar tydliga start- och sluttider för underhållsfönster.

Jag taggar driftsättningar och kopplar dem till mätvärden som tid till första byte och felfrekvens. Om dessa värden överskrids gör jag automatiskt en rollback. Jag sparar versioner av konfigurationer för att kunna spåra förändringar. Prestandatester körs automatiskt efter större uppdateringar och ger mig snabba resultat. Återkoppling. På så sätt undviker jag överraskningar i skarpt läge.

Bygg dina egna tillägg: När standarder inte räcker till

Jag förlitar mig på mina egna Plesk-tillägg när ett team har tydliga Särskild-krav. Det kan handla om ett internt behörighetskoncept, ett särskilt deploy-flöde eller en integrationsbrygga till tredjepartssystem. Innan jag bygger kontrollerar jag om en befintlig lösning med mindre justeringar är tillräcklig. Om inte, definierar jag API-slutpunkter, roller och säkerhetsgränser kortfattat och tydligt. Först därefter skriver jag modulen och testar den mot typiska vardagsscenarier.

En ren avinstallations- och uppdateringsstrategi är viktig så att systemet förblir underhållbart. Jag dokumenterar också funktioner och begränsningar så att kollegorna kan använda verktyget på ett säkert sätt. Om det behövs samlar jag in feedback och planerar små iterationer i stället för stora språng. På så sätt förblir expansionen hanterbar och Pålitlig. Kundanpassade moduler är värdefulla om de förkortar processerna på ett meningsfullt sätt.

Roller, abonnemang och serviceplaner: organisation skapar hastighet

Innan jag skapar projekt strukturerar jag Plesk med Prenumerationerserviceplaner och roller. Detta gör att jag kan tilldela gränser (CPU, RAM, inoder, e-postkvoter) och behörigheter (SSH, Git, Cron) på ett planeringsbart sätt. För byråteam skapar jag separata prenumerationer för varje kund så att behörigheter och säkerhetskopior förblir rent isolerade. Standardplaner innehåller förnuftiga standardvärden: PHP-FPM aktiv, opcache på, dagliga säkerhetskopior, auto-SSL, restriktiva filbehörigheter. För mer riskfyllda tester använder jag ett separat labbabonnemang med strikt begränsade resurser - detta skyddar resten av systemet från avvikelser.

Jag håller rollerna granulerade: Administratörer med full åtkomst, utvecklare med Git/SSH och loggar, redaktörer med endast filhanterare/WordPress. Jag dokumenterar vilken roll som utför vilka uppgifter och undviker okontrollerad tillväxt med individuella användarrättigheter. Nya projekt startar konsekvent och är lättare att migrera eller skala senare.

PHP-FPM, NGINX och cachelagring: Prestanda från panelen

Prestanda Jag kommer ut först Inställningar för körtidPHP-FPM med pm=ondemand, clean max-children per webbplats, opcache med tillräckligt minne och revalidate_freq som matchar deploy-intervallet. Jag låter NGINX leverera statiska tillgångar direkt och ställer in specifika cachelagringsrubriker utan att äventyra dynamiska områden. För WordPress aktiverar jag om möjligt mikrocaching endast för anonyma användare och utesluter cookies som markerar sessioner. Jag slår på Brotli/Gzip på hela servern, men testar komprimeringsnivåerna mot CPU-belastningen.

Jag håller dedikerade PHP-versioner redo för varje webbplats för att kunna separera beroenden på ett snyggt sätt. Jag lägger till optimeringar på kritisk väg (HTTP/2 push inte längre nödvändigt, tidiga tips istället, rena preload/prefetch-rubriker) om de uppmätta värdena motiverar det. Regeln: mät först, sedan vänd - riktmärken efter varje större förändring förhindrar att man flyger i blindo.

E-post och DNS: korrekt inställning av leveransbarhet och certifikat

När Plesk skickar e-postmeddelanden ställer jag in SPF, DKIM och DMARC per domän, kontrollera rDNS och se till att bounce-adresserna är konsekventa. Jag separerar nyhetsbrev från transaktionella e-postmeddelanden för att skydda mitt rykte. Jag fattar ett medvetet beslut för DNS: antingen Plesk som master eller extern zon (t.ex. via CDN). Viktigt: Med en aktiv proxy planerar jag Let's Encrypt-utmaningar på ett sådant sätt att förnyelser går igenom på ett tillförlitligt sätt - till exempel med en tillfällig de-proxy eller DNS-utmaning för jokertecken. Jag dokumenterar den valda strategin för varje kund så att supportärenden kan lösas snabbt.

Webhooks från CI/CD fångar fasta mål-IP:n, och jag tillåter bara det som behövs i brandväggen. Detta håller både e-post och byggvägar stabila.

Databaser och lagring: stabilitet under belastning

För större projekt lägger jag ut databaser på dedikerade servrar eller containrar. Säkerhetskopior kör transaktionskonsekvent, binlogbaserad för återställning i tid. Jag använder läsrepliker för rapporterings- eller sökfunktioner så att den primära DB förblir obelastad. I Plesk är jag uppmärksam på att rensa DB-namn per prenumeration och ställa in minsta nödvändiga rättigheter.

Jag håller lagringen under kontroll med hjälp av kvoter och loggrotation. Jag versionerar mediauppladdningar där det är möjligt och undviker onödiga dubbletter i staging-miljöer. Jag ställer in 640/750 standardvärden för filbehörigheter och kontrollerar regelbundet att distributioner inte lämnar några tillåtna avvikelser. Detta håller återställningar och migreringar beräkningsbara.

Driftsättningar utan driftstopp: blå/gröna och symlink-versioner

Förutom staging använder jag Blue/Green eller Symlink-releaser. Byggnader hamnar i versionerade release-mappar utanför webroot. Efter lyckade tester växlar jag över via symlänk, utför databasmigreringar i kontrollerade steg och har en återgång redo. Jag definierar tydligt delade kataloger (uppladdningar, cache, session) så att switchar inte förlorar någon data. För WordPress- och PHP-appar förhindrar jag tillfälligt skrivåtkomst under kritiska migreringsfönster för att undvika inkonsekvenser.

Hälsokontroller övervakar den nya versionen innan den flippas. Jag kontrollerar automatiskt headers, viktiga vägar och DB-anslutningar. Först när alla kontroller är gröna byter jag över. Den här rutinen har räddat mig från många nattliga driftsättningar.

Kostnadskontroll och resurser: gränser, varningar, sanering

Jag ställer in Gränser per abonnemang: CPU-tid, RAM, antal processer, inoder. Cron-jobb och köer ges tydliga tidsfönster så att belastningstoppar förblir beräkningsbara. Jag städar automatiskt upp gamla utgåvor och loggar och håller säkerhetskopiorna smala och dokumenterade. Jag övervakar dockercontainrar för att upptäcka stora volymer och roterar cacher regelbundet. Detta gör att driftskostnaderna och prestandan förblir förutsägbara - utan överraskningar i slutet av månaden.

Varningar är bara till hjälp om de gör det möjligt att vidta åtgärder. Jag skiljer mellan varningar (trendbrott) och larm (omedelbar åtgärd krävs) och kopplar båda till runbooks. Den som väcks på natten måste kunna återställa stabiliteten i tre steg.

Typiska fallgropar och hur man undviker dem

Autouppdateringar utan staging går sällan sönder, men då oftast på ett ogynnsamt sätt - så testa alltid först. Cloudflare kan cachelagra admin-områden aggressivt om reglerna är för breda; jag utesluter konsekvent inloggning, /wp-admin, API och förhandsvisningar. Jag tillåter inte Docker-tjänster som Redis att lyssna offentligt och säkrar dem via interna nätverk. Let's Encrypt-förnyelser misslyckas om proxyn blockerar utmaningar; DNS-utmaning eller tillfällig förbikoppling hjälper här. Git-distributioner som kör node/composer-byggnationer i webroot gillar att orsaka rättighetskaos - skapa därför byggnationer utanför och distribuera endast artefakter.

En annan klassiker: full disk på grund av bortglömda felsökningsloggar eller coredumps. Jag sätter gränser, roterar loggar strikt och kontrollerar för ovanlig tillväxt efter utgåvor. Och jag har alltid manuell tillgång till brytglas redo (SSH-nyckel, dokumenterad sökväg) om panelen inte är tillgänglig.

Bästa praxis kompakt

Jag behåller Plesk och alla tillägg ström och testar uppdateringar innan de lanseras. Säkerhetskopieringarna går enligt plan och jag övar regelbundet på återställningar i en testmiljö. Jag organiserar panelen med hjälp av drag & drop så att centrala verktyg är omedelbart synliga. Jag använder automatisering, men bara med tydliga exitstrategier och rollbacks. Alla teammedlemmar känner till de viktigaste stegen och arbetar enligt samma standard.

Kort sammanfattning

Med ett väl genomtänkt urval av Förlängningar Jag fokuserar på hastighet, säkerhet och tillförlitliga driftsättningar. WordPress Toolkit och Git utgör ryggraden, medan Docker och Cloudflare levererar flexibilitet och prestanda. Imunify360 och Let's Encrypt säkrar driften, Acronis skyddar data och förkortar återställningstiderna. Tydliga standardvärden, tester och smidig automatisering håller den dagliga verksamheten organiserad. Detta gör att utvecklingsmiljön är anpassningsbar - och att projekten når sina mål på ett stabilt sätt.