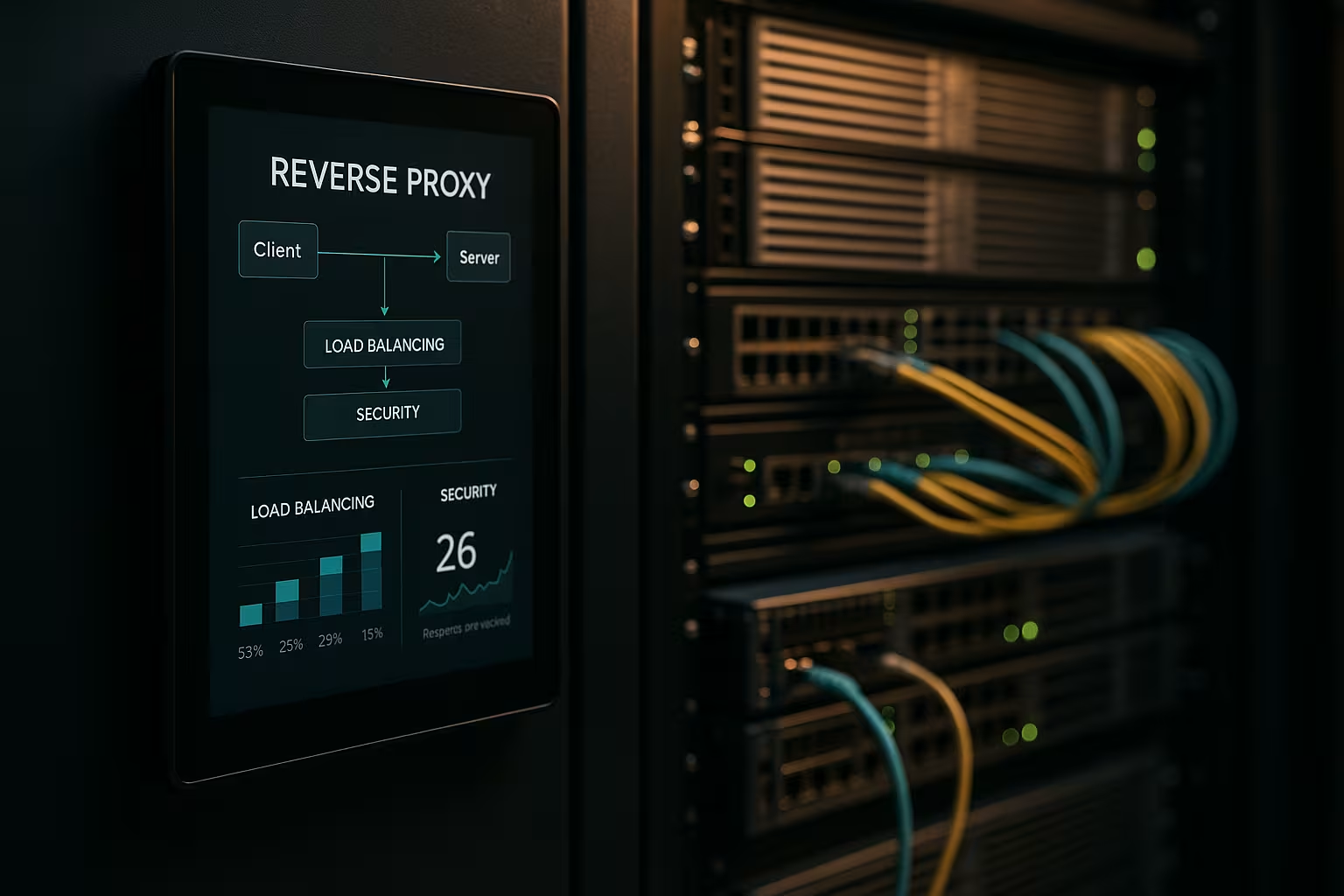

En arkitektur med omvänd proxy accelererar förfrågningar, skyddar backend-system och skalar webbapplikationer utan att modifiera appservrarna. Jag visar hur en Omvänd proxy förbättrar prestanda, säkerhet och skalning i den dagliga verksamheten på ett mätbart sätt.

Centrala punkter

- Prestanda genom cachelagring, SSL-avlastning och HTTP/2/3

- Säkerhet via WAF, DDoS-skydd och IP/geo-blockering

- Skalning med lastbalansering och hälsokontroller

- Kontroll tack vare centraliserad routing, loggning och analys

- Övning med NGINX, Apache, HAProxy, Traefik

Vad gör en arkitektur för omvänd proxy?

Jag ställde in Omvänd proxy framför applikationsservrarna och låter den avsluta alla inkommande anslutningar. På så sätt kapslar jag in den interna strukturen, håller IP-adresser dolda och minimerar direkta attackytor. Proxyn bestämmer vilken tjänst som tar över förfrågan och den kan cacha innehåll. Den tar hand om TLS, komprimering och protokolloptimeringar som HTTP/2 och HTTP/3. Detta minskar märkbart belastningen på appservrarna och ger mig en plats för riktlinjer, utvärderingar och snabba förändringar.

Prestandaoptimering: cachelagring, avlastning, edge

Jag kombinerar CachingSSL-avlastning och edge-leverans för att minska latensen. Jag serverar vanliga tillgångar som bilder, CSS och JS från cacheminnet, medan dynamiska delar förblir färska (t.ex. fragmentcaching). Jag använder policyer som stale-while-revalidate och stale-if-error för att minska väntetiderna och säkerställa leverans i händelse av störningar. TLS 1.3, HTTP/2 push replacement via early hints och Brotli-komprimering ger ytterligare acceleration. För internationella användare routar proxyn till närliggande noder, vilket minskar tiden till första byte. En titt på lämpliga Fördelar och tillämpningsscenarier visar vilka justeringar som är värda att göra först.

Förbättring av säkerhetsläget: WAF, DDoS, geo-blockering

Jag analyserar trafiken på Proxy och filtrerar skadliga förfrågningar innan de når backend-systemen. En WAF känner igen mönster som SQL-injektion eller XSS och stoppar dem centralt. TLS-terminering möjliggör inspektion av den krypterade dataströmmen, varefter jag vidarebefordrar den rent. DDoS-försvaret är beroende av proxyn, som distribuerar, begränsar eller blockerar förfrågningar utan att röra applikationerna. Geo- och IP-blockering stänger av kända källor, medan hastighetsbegränsningar och botdetektering hindrar missbruk.

Skalning och hög tillgänglighet med lastbalansering

Jag fördelar belastningen via Last Balanseringsalgoritmer som Round Robin, Least Connections eller viktade regler. Jag säkrar "sticky sessions" med cookie affinity om sessionerna måste förbli bundna till en nod. Hälsokontroller kontrollerar aktivt tjänsterna så att proxyn automatiskt tar bort defekta mål från poolen. Horisontell skalning fungerar på några minuter: registrera nya noder, förnya konfigurationen, klart. För val av verktyg krävs en kort Jämförelse av verktyg för lastbalansering med fokus på L7-funktioner.

Centraliserad hantering och exakt övervakning

Jag samlar in loggar centralt på Gateway och mäta nyckeltal som svarstider, genomströmning, felfrekvenser och TTFB. Dashboards visar hotspots, långsamma ändpunkter och trafiktoppar. Header-analyser (t.ex. cache hit, ålder) hjälper till med finjustering av cache-strategier. Med hjälp av korrelations-ID:n kan jag spåra förfrågningar mellan olika tjänster och påskynda analyser av grundorsaker. Jag fastställer standardiserade riktlinjer för HSTS-, CSP-, CORS- och TLS-profiler en gång hos proxyn i stället för separat i varje tjänst.

Routar, reglerar och släpper utan risk

I kontroll Routning baserat på värdnamn, sökväg, headers, cookies eller geografisk information. Detta gör att jag kan dirigera API:er och frontends separat, även om de körs på samma portar. Jag implementerar blågröna och kanariefågelversioner direkt på proxyn genom att dirigera små användargrupper till nya versioner. Feature flag headers hjälper till med kontrollerade tester under verklig trafik. Jag håller underhållsfönstren korta eftersom jag byter rutter på några sekunder.

Teknikjämförelse i praktiken

Jag väljer Verktygsom matchar belastningen, protokollet och driftsmålen. NGINX får poäng med statiskt innehåll, TLS, HTTP/2/3 och effektiva funktioner för omvänd proxy. Apache glänser i miljöer med .htaccess, omfattande moduler och äldre stackar. HAProxy ger mycket stark L4/L7-balansering och fin kontroll över hälsokontroller. Traefik integreras väl i containeriserade konfigurationer och läser in rutter dynamiskt från etiketter.

| Lösning | Styrkor | Typiska tillämpningar | Specialfunktioner |

|---|---|---|---|

| NGINX | Hög Prestanda, HTTP/2/3, TLS | Webbfrontend, API:er, statisk leverans | Brotli, cachelagring, TLS-avlastning, strömmodul |

| Apache | Modulär Flexibilitet.htaccess | Äldre stackar, PHP-tunga installationer | Många moduler, bra åtkomsthantering |

| HAProxy | Effektiv Balansering, Hälsokontroller | L4/L7 lastbalanserare, gateway | Mycket detaljerade och sofistikerade ACL:er |

| Traefik | Dynamisk Upptäckt, Container fokus | Kubernetes, Docker, mikrotjänster | Automatisk konfiguration, LetsEncrypt-integration |

Steg för genomförande och checklista

Jag börjar med MålPrioritera prestanda, säkerhet, tillgänglighet och budget. Jag definierar sedan protokoll, certifikat, chiffersviter och protokollversioner. Jag definierar tydligt och versionerar routningsregler, cachningspolicyer och begränsningar. Jag sätter upp hälsokontroller, observerbarhet och varningar innan jag går live. Om du vill komma igång direkt kan du hitta en instruktiv översikt på Konfigurera omvänd proxy för Apache och NGINX.

Bästa praxis för prestandatuning

Jag aktiverar HTTP/3 med QUIC där klienter stöder det och håller HTTP/2 redo för bred kompatibilitet. Jag använder Brotli för textresurser och låter proxyn komprimera bilder på ett effektivt sätt. Jag definierar medvetet cache-nycklar för att kontrollera variationer via cookies eller headers. Jag minimerar TLS-handskakningstider, använder sessionsåterhämtning och ställer in OCSP-häftning. Jag använder early hints (103) för att ge webbläsaren förhandssignaler om kritiska resurser.

Säkerhetsuppställning utan friktionsförluster

Jag håller Certifikat centralt och automatisera förnyelser med ACME. HSTS verkställer HTTPS, medan CSP och CORP kontrollerar innehållet. Jag startar en WAF-regelbas konservativt och stramar åt den gradvis för att undvika falsklarm. Hastighetsgränser, mTLS för interna tjänster och IP-listor minskar risken på daglig basis. Auditloggar förblir manipuleringssäkra så att jag kan spåra incidenter med rättssäkerhet.

Kostnader, drift och avkastning på investerat kapital

Jag planerar att Budget för serverresurser, certifikat, DDoS-skydd och övervakning. Små installationer börjar ofta med några virtuella kärnor och 4-8 GB RAM för proxyn, vilket innebär ett lågt tvåsiffrigt belopp i euro per månad, beroende på leverantör. Större flottor använder dedikerade instanser, anycast och globala noder, vilket kan innebära tresiffriga eurokostnader per plats. Centraliserad hantering sparar tid: färre individuella konfigurationer, snabbare releaseprocesser och kortare avbrottstider. Avkastningen på investeringen återspeglas i högre konvertering, lägre avvisningsfrekvens och mer produktiva tekniker.

Arkitekturvarianter och topologier

Jag väljer arkitektur för att matcha risk- och latensprofilen. Enkla miljöer fungerar bra med en enda Gateway i DMZ, som vidarebefordrar förfrågningar till interna tjänster. I reglerade eller stora miljöer separerar jag frontend- och backend-proxyer i två steg: Steg 1 terminerar internettrafik och hanterar WAF, DDoS och cachelagring, steg 2 routar internt, talar mTLS och upprätthåller zero trust-principer. Aktiva/aktiva konfigurationer med anycast IP och globalt distribuerade noder minskar tiden för failover och optimerar närheten till användaren. För CDN:er framför den omvända proxyn säkerställer jag korrekt vidarebefordran av rubriker (t.ex. X-Forwarded-Proto, Real-IP) och harmoniserade cachehierarkier så att edge- och gateway-cachen inte blockerar varandra. Jag kapslar in scenarier med flera hyresgäster med hjälp av SNI/TLS, separata vägar och isolerade hastighetsgränser för att undvika grannskapseffekter.

Protokoll och specialfall: WebSockets, gRPC och HTTP/3

Jag tar hänsyn till protokoll med särskilda krav så att funktionerna förblir stabila. För WebSockets Jag aktiverar uppgraderingsstöd och långlivade anslutningar med lämpliga timeouts. gRPC drar nytta av HTTP/2 och rena rubriker; jag undviker H2C (HTTP/2 i klartext) i perimetern till förmån för TLS med korrekt ALPN. För HTTP/3 Jag tillhandahåller QUIC-portar (UDP) och släpper endast 0-RTT restriktivt, eftersom repriser medför risker. Slutpunkter för streaming, händelser som skickas från servern och stora uppladdningar får sina egna buffrings- och body-size-policyer så att proxyn inte blir en flaskhals. För protokollöversättningar (t.ex. HTTP/2 utanför, HTTP/1.1 inuti) testar jag noggrant headernormalisering, komprimering och återanvändning av anslutningar för att hålla latenserna låga och resursförbrukningen förutsägbar.

Autentisering och auktorisering vid gatewayen

Jag flyttar Autentisering-beslut till den omvända proxyn om arkitekturen och efterlevnaden tillåter det. Jag integrerar OIDC/OAuth2 via tokenverifiering vid gatewayen: proxyn validerar signaturer (JWKS), kontrollerar utgång, målgrupp och omfattning och anger verifierade anspråk som rubriker för tjänsterna. Jag använder API-nycklar för maskin-till-maskin-slutpunkter och begränsar dem per rutt. För interna system förlitar jag mig på mTLS med ömsesidig certifikatverifiering för att göra förtroendet tydligt. Jag är noga med att inte logga känsliga rubriker (auktorisering, cookies) i onödan och använder listor med tillåtande/avvisande per rutt. Jag formulerar finkorniga policyer via ACL:er eller uttryck (t.ex. path + method + claim), vilket gör att jag kan kontrollera åtkomsten centralt utan att ändra applikationskoden.

Motståndskraft: timeouts, omförsök, backoff och kretsbrytning

Jag definierar Tidsfrister medveten per hopp: upprättande av anslutning, header timeout och response timeout. Jag aktiverar bara omprövningar för idempotenta metoder och kombinerar dem med exponentiell backoff plus jitter för att undvika dånande flockar. Strömbrytare skyddar backend-pooler: Om proxyn upptäcker fel eller fördröjningstoppar öppnar den kretsen tillfälligt, vidarebefordrar endast slumpmässigt till den berörda destinationen och svarar annars tidigt, eventuellt med fallback från cacheminnet. Detektering av avvikelser tar automatiskt bort "svaga" instanser från poolen. Jag begränsar också samtidiga uppströmmar, aktiverar återanvändning av anslutningar och använder köer med rättvis prioritering. Detta säkerställer att tjänsterna förblir stabila även om enskilda komponenter utsätts för påfrestningar.

Efterlevnad, dataskydd och PII-skydd

Jag behandlar fullmakten som Datahubb med tydliga regler för dataskydd. Jag maskerar eller pseudonymiserar personuppgifter i loggar; frågesträngar och känsliga rubriker loggas endast på vitlistningsbasis. Jag förkortar IP-adresser där det är möjligt och följer strikta lagringsperioder. Åtkomst till loggar och mätvärden är rollbaserad och ändringar dokumenteras på ett revisionssäkert sätt. För revisioner länkar jag gateway-händelser med poster i ändringshanteringen så att godkännanden och regeluppdateringar kan spåras. På så sätt kan jag uppfylla efterlevnadskraven utan att göra avkall på djupgående insikter om prestanda och säkerhet.

Kubernetes, Ingress och Gateway API

Jag integrerar den omvända proxyn sömlöst i Orkestrering av containrar. I Kubernetes använder jag ingress controllers eller det mer moderna gateway API:et för att beskriva routing, TLS och policies deklarativt. Traefik läser etiketter dynamiskt, NGINX/HAProxy erbjuder sofistikerade ingressvarianter för hög genomströmning. Jag separerar klusterintern öst/västlig routing (service mesh) från den nord/sydliga perimeter-gatewayen så att ansvarsområdena förblir tydliga. Jag implementerar "canary releases" med viktade rutter eller headermatchningar, samtidigt som jag strikt definierar hälsokontroller och pod-beredskap för att undvika "flapping". Jag versionerar konfigurationer som kod och testar dem i staging-kluster med belastningssimulering innan jag går live.

Operativ mognad: konfigurationshantering och CI/CD

Jag behandlar proxykonfigurationen som Kod. Ändringar körs via pull requests, testas automatiskt (syntax, linting, säkerhetskontroller) och rullas ut i pipelines. Jag använder förhandsgranskningar eller skuggtrafik för att validera nya rutter under verkliga förhållanden utan att riskera kundtransaktioner. Rollbacks är möjliga på några sekunder eftersom jag taggar versioner och distribuerar dem atomiskt. Jag hanterar känsliga hemligheter (certifikat, nycklar) separat, krypterat och med minimala behörigheter. För hög tillgänglighet distribuerar jag releaser till noder på ett förskjutet sätt och registrerar effekterna i instrumentpaneler så att jag snabbt kan vidta motåtgärder vid regressioner.

Typiska stötestenar och anti-mönster

Jag undviker Felkällorsom ofta förekommer i praktiken. Jag förhindrar cacheförgiftning med strikt header-normalisering och ren Vary-hantering; jag utesluter cookies som inte påverkar rendering från cache-nyckeln. Jag känner igen omdirigeringsslingor tidigt genom att testa med X-Forwarded-Proto/Host och konsekventa HSTS/CSP-policyer. "Lita på alla X-Forwarded-For" är tabu: jag litar bara på nästa hopp och ställer in Real-IP på ett rent sätt. Jag kontrollerar stora uppladdningar via gränser och streaming så att proxyn inte buffrar, vilket backend kan göra bättre. Med 0-RTT i TLS 1.3 är jag uppmärksam på idempotens. Och jag håller ett öga på kropps- och rubrikstorlekar så att enskilda förfrågningar inte binder upp hela arbetskapaciteten.

Sammanfattning för snabba beslut

Jag satsar på en Omvänd proxy eftersom den kombinerar hastighet, skydd och skalning på ett och samma ställe. Cachelagring, TLS-avlastning och HTTP/2/3 snabbar upp verkliga laddningstider avsevärt. WAF, DDoS-försvar och IP/geo-kontroll minskar riskerna märkbart. Lastbalansering, hälsokontroller och rullande releaser håller tjänsterna tillgängliga, även under tillväxt. Med NGINX, Apache, HAProxy eller Traefik hittar jag en tydlig lösning för varje installation och håller driften hanterbar.