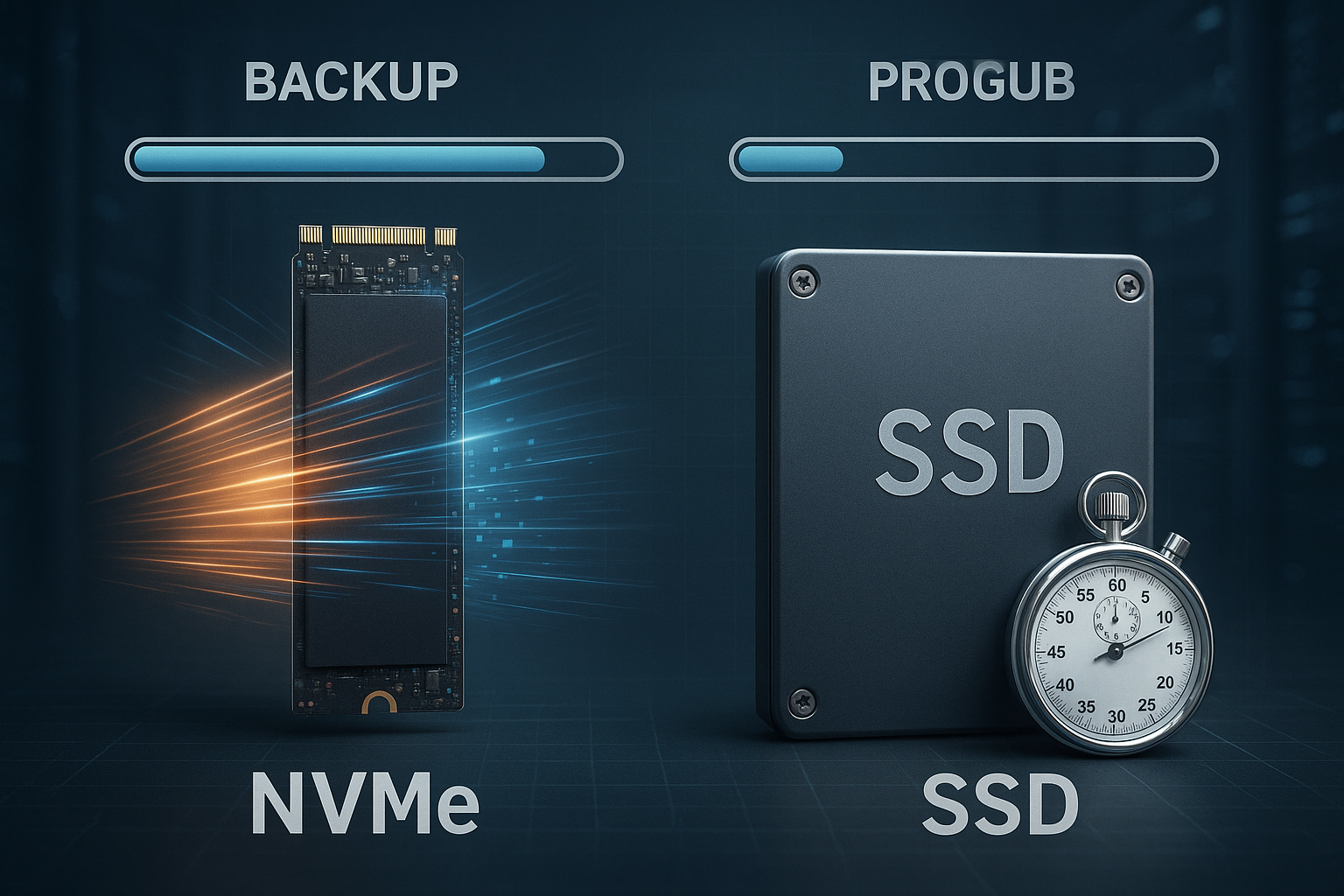

Storage classes Backup afgør, hvor hurtigt jeg sikkerhedskopierer og gendanner data: NVMe reducerer ofte backuptiden med flere minutter pr. 100 GB sammenlignet med SATA SSD'er, afhængigt af throughput og latency. Denne artikel viser, hvordan NVMe og SSD påvirke backup-tider, hvilke flaskehalse der virkelig tæller, og hvordan jeg kan udlede en pålidelig strategi for hosting af backups ud fra dette.

Centrale punkter

- NVMe-fordelHøjere gennemstrømning, lavere ventetid, betydeligt kortere backup- og gendannelsestider

- Backup-type: Fuld, inkrementel, differentieret brug af NVMe i varierende grad

- Cloud-klasserS3-standard for hastighed, IA/Arkiv for omkostningskontrol

- RAID/FSLayout og filsystem påvirker reelle overførselshastigheder

- RTO/RPOTest og overvågning sikrer pålidelige genstartstider

NVMe vs SATA SSD: Hvorfor backups har så stor fordel

NVMe bruger PCIe-baner og en slank protokol, som øger Gennemstrømning og IOPS, og ventetiden falder markant sammenlignet med SATA SSD'er. SATA-SSD'er er typisk 520-550 MB/s, mens PCIe 4.0 NVMe opnår op til 7.000 MB/s og PCIe 5.0 NVMe over 10.000 MB/s, hvilket i høj grad fremskynder fulde sikkerhedskopieringer. For 100 GB betyder det helt enkelt: SATA-SSD tager omkring 3-5 minutter, PCIe-4.0-NVMe 15-30 sekunder, afhængigt af komprimering, kryptering og filmix. Inkrementelle jobs nyder også godt af den lave Forsinkelse, fordi mange små tilfældige læsninger/skrivninger kører hurtigere. Hvis du vil lave en dybere sammenligning, kan du finde praktiske forskelle i Sammenligning af NVMe/SSD/HDD, som sammenligner ydeevne og omkostninger.

Backup-typer og deres interaktion med storage-klassen

Fuld sikkerhedskopiering skriver store datablokke sekventielt, hvilket er grunden til, at Backup-hastighed næsten lineært med lagerklassens rå gennemstrømning. Inkrementelle backups gemmer deltaer siden sidste kørsel; den lave NVMe-latency og den høje IOPS-performance med mange små filer er særligt vigtig her. Differentielle backups ligger midt imellem og nyder i praksis godt af hurtige læsninger, når gendannelseskæden samles. Til hosting-backups minimerer jeg RTO og RPO på denne måde: mindre delta, hurtige medier, ren planlægning. Jeg kombinerer metoderne og kører fulde backups mindre hyppigt, mens inkrementelle jobs planlægges på NVMe roter dagligt eller oftere.

Gennemstrømning, IOPS og latenstid i backup-sammenhæng

For at få realistiske backup-tider ser jeg på tre nøgletal: sekventiel Gennemstrømning, tilfældig IOPS og latenstid pr. operation. Sekventiel gennemstrømning bestemmer varigheden af en fuld backup, IOPS og latenstid driver inkrementelle jobs, mange små filer og metadata. Komprimering og kryptering kan begrænse de rå værdier, hvis CPU'en ikke kan følge med datahastigheden. Jeg måler derfor både storage-performance og CPU-udnyttelse under backuppen. Følgende tabel viser typiske størrelser for 100 GB-jobs under optimale forhold uden en flaskehals i netværket:

| Opbevaringstype | Maks. læsning | Max. Skriv | Sædvanlig backup-tid (100 GB) | Forsinkelse |

|---|---|---|---|---|

| SATA SSD | 550 MB/s | 520 MB/s | 3-5 minutter | 80-100 µs |

| PCIe 3.0 NVMe | 3.400 MB/s | 3.000 MB/s | 30-60 sekunder | ~25 µs |

| PCIe 4.0 NVMe | 7.000 MB/s | 6.800 MB/s | 15-30 sekunder | 10-15 µs |

| PCIe 5.0 NVMe | 12.000 MB/s | 11.000 MB/s | < 15 sekunder | 5-10 µs |

I praksis er værdierne ofte lavere, fordi filstørrelser, kontrolsummer, snapshots og CPU-belastning bremser fordelen ved NVMe forbliver tydeligt synlig. NVMe er særligt fordelagtigt til parallelle jobs, da flere køer behandles pr. kerne. For mange små filer tæller IOPS og latency mere end den rene MB/s-specifikation. Jeg planlægger derfor buffere: 20-30% headroom på den forventede hastighed, så sikkerhedskopier ikke glider ud af tidsvinduet i flaskehalsfaser. Denne reserve betaler sig under natkørsler og flaskehalse i netværket.

Cloud storage-klasser i backup-mixet

Til eksterne kopier bruger jeg S3-kompatible klasser, hvor Standard er det bedste valg til hurtig gendannelse. Sjælden adgang sparer driftsomkostninger, men kræver længere genfindingstider og muligvis genfindingsgebyrer. Arkivklasser er velegnede til lovlig opbevaring, ikke til tidskritiske gendannelser. Jeg kombinerer lokale NVMe-snapshots med S3-standard til friske kopier og flytter ældre versioner til mere fordelagtige klasser. En god introduktion til begreberne findes i Objektlagring i hosting, som tydeligt forklarer fordele og ulemper.

RAID og filsystemer: hastighed og beskyttelse

RAID-layout påvirker den effektive Backup-hastighed fordi stripe-størrelse og parallelitet opfylder eller ikke opfylder softwarens skrivemønstre. RAID 10 giver høj IOPS og solid skriveydelse, RAID 5/6 giver mere kapacitet, men svagere tilfældige skrivninger. Moderne filsystemer som XFS eller ZFS behandler parallelle strømme effektivt og letter snapshots, som kan forkorte backup-vinduer. For Linux-værter tjekker jeg specifikke arbejdsbelastninger og vælger derefter filsystemet. En kortfattet hjælp til beslutningstagning findes i ext4, XFS eller ZFS med noter til almindelige scenarier.

Praktisk eksempel: 100 GB beregnet i tal

Lad os antage, at jeg sikkerhedskopierer 100 GB ukomprimeret med en nettohastighed på 2.000 MB/s til NVMe, så er varigheden omkring 50 sekunder. På en SATA SSD med 500 MB/s skal jeg bruge ca. 3,3 minutter plus overhead til checksummer og metadata. Hvis jeg bruger 2:1-komprimering, og CPU'en opretholder hastigheden, bliver den nødvendige tid ofte halveret. Det bliver svært, når CPU'en eller netværket ikke kan følge med: Et 10 GbE-link begrænser sig til 1.000-1.200 MB/s netto, uanset hvor hurtigt drevet er. Det er derfor, jeg tester end-to-end og ikke isoleret, for at bestemme den reelle Tid til backup at planlægge sikkert.

Netværk og software: den ofte oversete bremse

Backup-software afgør, hvor godt jeg kan udnytte fordelene ved NVMe overhovedet. Single-threaded pipelines mætter næppe hurtige medier, multi-stream og asynkron I/O øger hastigheden betydeligt. Deduplikering sparer transmission og hukommelse, men koster CPU og tilfældige IOP'er, hvilket hurtigt udnytter billige SSD'er. TLS-kryptering beskytter dataene, men kræver også computerkraft; AES-NI og hardware-offload hjælper her. Jeg tjekker derfor parallelt: streams, komprimering, dedup og kryptering - og tilpasser pipelinen til målmediet i stedet for blindt at overtage standardværdier.

Omkostningstjek: Euro pr. sparet minut

Jeg kan godt lide at regne baglæns: Hvis NVMe i gennemsnit sparer 2,5 minutter om dagen sammenlignet med SATA SSD ved 100 GB, svarer det til omkring 75 minutter om måneden og 15,6 timer om året, pr. år. Server. Med en timepris på 50 euro for driftstid eller alternativomkostninger svarer det til 780 euro om året; i mange opsætninger overstiger fordelene betydeligt de ekstra omkostninger ved en NVMe-løsning. Kritiske systemer med små backup-vinduer nyder især godt af det, fordi forsinkelser straks bliver til RTO-risici. Alle, der opbevarer arkiver, kan tilføje omkostningseffektive objektlagringsklasser og dermed reducere medieomkostningerne. Denne opfattelse hjælper med at underbygge beslutninger økonomisk ud over de rene MB/s tal.

Brug sikkerhedsfunktioner uden at miste hastighed

Uforanderlige sikkerhedskopier med Objektlås beskytte mod manipulation, ransomware og utilsigtet sletning. Jeg opretter snapshots på NVMe-kilder, eksporterer dem dedikeret og overfører dem med throttling, så produktionens IO ikke bliver bremset. Versionering i S3 giver mulighed for finkornede gendannelsespunkter, som jeg tilpasser med livscyklusregler. Kryptering i hvile og i transit er fortsat obligatorisk, men jeg måler CPU-omkostningerne og vælger parametre, der er i overensstemmelse med backup-vinduerne. På den måde er sikkerhed ikke en bremseklods, men en del af den planlægbare rutine.

Migrationsstrategi uden risiko for nedetid

Når du skifter fra SATA SSD til NVMe Jeg tager først en backup af status quo, laver testkørsler og måler end-to-end-tiderne. Derefter migrerer jeg workloads løbende og starter med de største backup-vinduer, så effekten bliver synlig med det samme. Snapshots og replikering reducerer overgangstiderne; jeg planlægger overlapning, indtil nye jobs kører stabilt. Backoff-strategier forhindrer flere store jobs i at generere peaks på samme tid. Dokumentation og en kort rollback-sti sikrer driften, hvis de første par nætter afviger.

Konfiguration, der muliggør hastighed

Jeg indstillede køens dybde og parallelitet, så IO-køer af NVMe-drevene udnyttes, men ikke overfyldes. Større blokstørrelser hjælper med fulde backups, små blokke og flere streams fremskynder inkrementelle kørsler. Write-through vs. write-back cache og flush-intervaller påvirker latenstid og konsistens; den tilsigtede brug er det, der tæller her. Overvågning med I/O-ventetider, CPU-steal og netværksbuffere afslører flaskehalse på et tidligt tidspunkt. Jeg bruger disse signaler til gradvist at skærpe pipelinen i stedet for at risikere store spring.

Implementer applikationskonsistens og snapshots korrekt

Hurtige medier er ikke til megen hjælp, hvis dataene er inkonsistente. Jeg opnår applikationskonsistente backups ved specifikt at stabilisere databaser og tjenester før snapshottet: pre/post hooks til frysning/optøning, korte flush-intervaller og journalskrivning undgår beskidte sider. Under Linux bruger jeg LVM eller ZFS snapshots med XFS, hvis det er nødvendigt. xfs_freeze, under Windows VSS. Følgende gælder for databaser: Tag backup af write-ahead-logfiler, og dokumenter genoprettelseskæden. Virtuelle maskiner modtager quiesced snapshots med gæsteagenter; dette holder filsystemet og app-status konsistent. Resultatet: færre overraskelser ved gendannelse og pålidelige RPO'er uden at forlænge backup-vinduet unødigt.

Verifikations- og genopretningsøvelser: Tillid skabes på vejen tilbage

Jeg kontrollerer systematisk, om sikkerhedskopierne er læsbare og komplette. Det omfatter ende-til-ende-kontrolsummer, katalog-/manifestkontrol og tilfældige gendannelser til et isoleret målmiljø. Månedlige gendannelsesøvelser for kritiske tjenester måler reelle RTO'er og opdager skema- eller autorisationsfejl. Regelmæssige integritetsscanninger er obligatoriske for deduplikerende repositorier; objektlagring drager fordel af ETag-sammenligninger og periodisk rensning. Resultaterne ender i en runbook: Hvilke trin, hvilket mål, hvilken varighed. Det gør recovery til en rutine i stedet for et særtilfælde - og investeringer i NVMe viser deres fordele i sandhedens øjeblik.

Hardwaredetaljer: NAND-type, TBW, PLP og termiske effekter

Ikke alle NVMe er ens: TLC-modeller holder høje skrivehastigheder længere end QLC, hvis SLC-cache opbruges hurtigere under kontinuerlig belastning. I backups med lange sekventielle skrivninger kan dette halvere nettohastigheden, så snart den termiske neddrosling sætter ind. Jeg er opmærksom på tilstrækkelig køling, kølelegemer og luftstrøm for at undgå throttling. Enterprise-drev med beskyttelse mod strømtab (PLP) sikrer data i tilfælde af strømsvigt og leverer mere ensartede latenstider. Jeg sætter nøgletallet TBW (Total Bytes Written) i forhold til min daglige backup-volumen for at holde sliddet beregneligt. Det holder pipelinen stabil - ikke bare i benchmarket, men nat efter nat.

Skalering af backup-pipeline

Når antallet af værter vokser, bliver orkestrering afgørende. Jeg forskyder starttider, begrænser samtidige fulde sikkerhedskopieringer og reserverer tidsintervaller pr. klient. En NVMe-understøttet Landingszone-Cache på backupserveren buffer høje spidsbelastninger og lagrer data asynkront i objektlageret. Fair share-algoritmer og IO-hastighedsgrænser forhindrer, at et enkelt job bruger alle ressourcer. Jeg øger kun antallet af parallelle streams, så langt kilden, målet og netværket kan følge med; ud over mætning øges ventetiden, og nettohastigheden falder. Målet er en jævn udnyttelseskurve i stedet for natlige toppe - det er sådan, jeg opretholder SLA'er, selv hvis en gendannelse uventet griber ind.

Netværks- og OS-tuning til høje hastigheder

For 10-25 GbE optimerer jeg MTU (jumbo frames, hvis det er muligt fra ende til ende), TCP-buffer, skalering på modtagersiden og IRQ-affinitet. Moderne stakke drager fordel af io_uring eller asynkron I/O; det reducerer syscall-overhead og øger paralleliteten. Jeg vælger en TCP-overbelastningskontrolmetode, der passer til min latenstid, og bruger flere streams for at udnytte ruter med høj BDP. På CPU-siden hjælper AES-NI og muligvis komprimeringsniveauer, der matcher core clock (f.eks. er mellemniveauer ofte det bedste forhold mellem throughput og ratio). Vigtigt: Man må ikke optimere i den ene ende og skabe flaskehalse i den anden - end-to-end-måling er fortsat retningslinjen.

Arbejdsbelastningsspecifikke noter: Databaser, VM'er og containere

Jeg tager backup af databaser på logbasis og på præcise tidspunkter: Basisbackup plus kontinuerlig logregistrering reducerer RPO til næsten nul og fremskynder gendannelser. For VM'er er change block tracking og agentbaserede quiesce-metoder guld værd, fordi de præcist fanger inkrementelle volumenændringer. I containermiljøer adskiller jeg kontrolplansdata (f.eks. klyngemetadata) fra vedvarende volumener; snapshots via CSI-drivere på NVMe-backends forkorter backup-vinduer mærkbart. Fællesnævner: applikationskonsistens før rå performance. Kun når semantikken er rigtig, er det værd at udnytte det fulde potentiale af NVMe-gennemstrømning og IOPS.

Regler og overholdelse: 3-2-1-1-0 i praksis

Jeg etablerer 3-2-1-1-0-reglen operationelt: tre kopier, to medietyper, en offsite, en uforanderlig, nul ukontrollerede fejl. Konkret betyder det: lokal NVMe-snapshot-kopi, sekundær kopi på separat lager (anden RAID/anden tilgængelighedszone) og offsite i S3 med objektlås. Livscykluspolitikker kortlægger opbevaringsperioder, juridiske holdmandater forbliver upåvirket af sletningskørsler. Regelmæssige kontrolsummer og testgendannelser giver „0“. Dette gør tekniske foranstaltninger kompatible og reviderbare - uden at overskride backup-vinduerne.

Benchmarking uden målefejl

Korrekt måling betyder reproducerbar måling. Jeg vælger blokstørrelser og kø-dybder, der passer til målet (f.eks. 1-4 MB til sekventielle fulde backups, 4-64 KB med højere parallelitet til inkrementer). Jeg tager højde for cacher og preconditioning for at kunne visualisere SLC-cacheeffekter. Opvarmning, „dd“-testen, ensartet testvarighed og evaluering af P99-latenstider viser, om der er spidsbelastninger på vej. "dd" med OS-cache giver dummy-værdier; asynkrone I/O-mønstre, der ligner backup-softwaren, er meningsfulde. Sideløbende logger jeg CPU, IO wait og netværk, så årsagen er klar - ikke kun symptomet.

Kapacitets- og omkostningsplanlægning over tid

Backups vokser gradvist: nye kunder, større databaser, flere filer. Jeg planlægger kapaciteten i tre dimensioner: Gennemstrømning (MB/s pr. vindue), IOPS/latency (for metadata og små filer) og lagerkrav (primær, offsite, uforanderlig). På NVMe dimensionerer jeg 20-30% reserve til spidsbelastninger, i S3 overvejer jeg hentningsomkostninger og potentiel replikering på tværs af regioner i katastrofesituationer. En NVMe-understøttet landingszone giver mulighed for aggressiv deduptering/komprimering i opfølgningen og reducerer omkostningerne til objektlagring. Vigtigt: Tjek tendenser hver måned, og definer tærskelværdier, der udløser hardware- eller netværksopgraderinger i god tid.

Hvilken platform passer til mit mål?

For produktive hostingmiljøer tjekker jeg, om udbyderen NVMe RAID, snapshots og S3-forbindelse. Afgørende detaljer er PCIe-generation, tilgængelige baner, netværksbåndbredde og pålidelige offsite-mål. En sammenligning af aktuelle tilbud viser hurtigt, om de annoncerede hastigheder er realistisk opnåelige eller bare spidsværdier. Hvis du vil orientere dig, kan du holde nøgledataene op mod praktiske målinger og evaluere testbackups. På den måde undgår jeg fejlinvesteringer og prioriterer de komponenter, der rent faktisk reducerer backuptiden.

Planlæg at tage med

Først måler jeg den faktiske tid pr. job og registrerer RTO og RPO-krav pr. tjeneste. Derefter identificerer jeg flaskehalsen: storage, CPU, netværk eller software pipeline. Derefter foretager jeg målrettede opgraderinger: NVMe til primære data og backup-cache, 10-25 GbE i kernen, multi-stream og komprimering i henhold til CPU. Dette efterfølges af restore-tests, som jeg gentager hver måned, og en livscyklusplan for offsite-kopier. For yderligere kontekstuelle oplysninger er det værd at tage et kig på den kompakte oversigt over NVMe/SSD/HDD, som kort sammenligner ydeevne, omkostninger og anvendelsesområder.

Kort opsummeret

NVMe forkortet Tidspunkter for backup mærkbart: mere gennemstrømning, mange flere IOPS, betydeligt mindre ventetid. Fuld backup nyder godt af sekventiel hastighed, inkrementelle kørsler af hurtig tilfældig adgang. Cloud-klasser supplerer lokale NVMe-snapshots, hvis jeg vil holde RTO og omkostninger i balance. RAID-layout, filsystem, netværk og software afgør, om hardwaren viser sit potentiale. Hvis du måler systematisk, fjerner flaskehalse og justerer pipelinen, kan du opnå pålidelige storage class-backups med forudsigelige tidsvinduer.