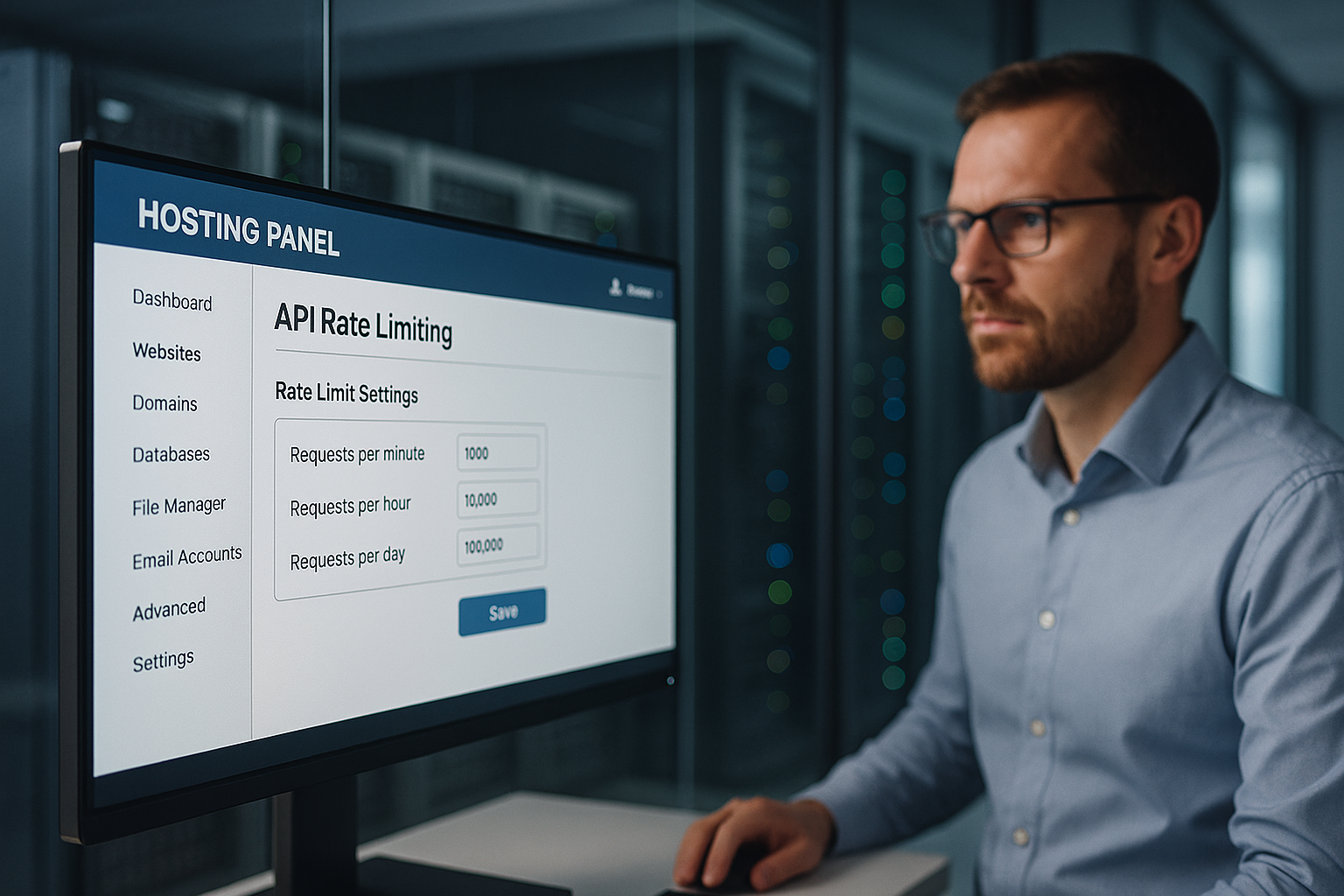

Hosting med begrænsning af API-hastighed beskytter et hostingpanel mod misbrug ved strengt at kontrollere forespørgselshastigheder pr. IP, API-nøgle og slutpunkt og forhindrer dermed udfald, datamisbrug og unødvendige omkostninger. Jeg sætter grænser på flere niveauer, genkender uregelmæssigheder tidligt og sikrer kunderelevante funktioner som login, fakturering og dataadgang mod DDoS, credential stuffing og urimelige belastningsspidser.

Centrale punkter

- Flere lag Begrænsninger: global, bruger, slutpunkt

- Algoritmer vælg: Token/Leaky/Sliding Window

- Gennemsigtig Overskrift: Grænse, Resterende, Nulstil

- Overvågning i realtid med advarsler

- Fair forskudt: kvoter pr. kundesegment

Hvorfor API-hastighedsbegrænsning er uundværlig i hostingpanelet

Jeg bruger klare grænser for at forhindre det Angriber Bloker login- eller dataendpoints med en strøm af anmodninger. På den måde forbliver legitime processer tilgængelige, mens jeg stopper misbrug og holder ventetiden lav. Enhver overbelastning af delte servere koster penge og tillid, så jeg begrænser overdrevne anmodninger i tide. Jeg forhindrer eskalering ved dynamisk at justere grænserne, før kapaciteten springer. Kunderne får ensartede svartider, fordi jeg håndhæver fair kvoter og eliminerer ukontrollerede spidsbelastninger.

Sådan fungerer hastighedsbegrænsning: begreber og algoritmer

Jeg vælger den passende algoritme i henhold til belastningsprofil, slutpunktets kritikalitet og forventede spidsbelastninger, fordi en god proces Misbrug stopper pålideligt og tillader legitime udbrud. Sliding-window-metoder udjævner hårde grænser, token bucket tillader hurtige kortvarige udbrud, leaky bucket opretholder et jævnt flow. Fixed-window er velegnet til enkle regler, men kan virke uretfærdigt ved vindueskanter. Jeg kombinerer metoder, når endpoints varierer meget, f.eks. login vs. statisk indhold. Det giver mig mulighed for at kontrollere flowet uden unødvendige blokeringer.

| Algoritme | Typisk brug | Fordel for sikkerheden |

|---|---|---|

| Fast vindue | Simpel kvotemodel | Forudsigelig Kontingenter |

| Skydevindue | Mere præcis udjævning | Færre grænsetricks |

| Token-spand | Burst-tolerant | Fleksible tips |

| Utæt spand | Konstant gennemstrømning | Rengør afløb |

For hvert slutpunkt dokumenterer jeg den målrettede RPS, burst-størrelsen og reaktionen i tilfælde af overtrædelser, så Kontrol forbliver reproducerbar. Hver regel er versioneret i infrastrukturen, så revisioner tydeligt kan se, hvornår hvilken grænse gælder.

Begrænsninger i flere lag: global, bruger, slutpunkt

Jeg sætter først en global grænse, der definerer Platform som helhed, så ingen enkelt applikation optager kapacitet. Derefter opdeler jeg kvoter pr. kunde, så premium-konti får mere kapacitet uden at presse andre ud. Endelig inddeler jeg slutpunkterne: Auth, betaling, skriveoperationer strammere; læseendepunkter mere generøse. Jeg blokerer ikke blindt for regelbrud, men øger først ventetiden eller beder om en backoff, før jeg tager hårdere midler i brug. På den måde forbliver brugeroplevelsen fair, mens kritiske tjenester beskyttes.

Mål trafikmønstre korrekt

Jeg analyserer typiske spidsbelastninger, fordelingen pr. endepunkt og fejlraten, fordi disse data Grænser karakterisere. Jeg skelner mellem menneskelig brug og automatiserede mønstre via IP-tæthed, brugeragenter og tokenadfærd. Jeg genkender afvigelser ved en pludselig stigning i 401/403/429-fejl eller uregelmæssige svartider. Jeg fremhæver uregelmæssigheder og tester derefter strengere regler i en prøveperiode for at undgå falske alarmer. Først når adfærden er bekræftet som stabil, aktiverer jeg håndhævelsen.

Gennemsigtighed for kunderne: Overskrifter og fejlmeddelelser

Jeg kommunikerer grænser åbent, så Hold integreres på en forudsigelig måde og afvikles i tide. Jeg inkluderer kvoterne i hvert svar, så udviklerne kan kontrollere deres brug. Klare fejlmeddelelser hjælper i stedet for at frustrere. Dette er et eksempel, jeg bruger:

X-RateLimit-grænse: 120

X-RateLimit-rest: 15

X-RateLimit-Reset: 1731187200

Forsøg igen efter: 30

Jeg holder formaterne konsistente og beskriver dem i API-dokumentationen, så der ikke er nogen huller i fortolkningen, og Integration kører problemfrit.

Omkostnings- og kompleksitetsbaserede begrænsninger og samtidighed

Jeg begrænser ikke kun den rene forespørgselsrate, men også Kompleksitet og samtidighed: Beregningsintensive stier får højere „omkostninger“ end simple læsninger. Jeg tildeler en score pr. anmodning (f.eks. 1 for enkle GET'er, 10 for store eksporter) og begrænser i henhold til de samlede omkostninger i tidsvinduet. Jeg begrænser også det maksimale antal samtidige anmodninger pr. nøgle for at beskytte backend-pools. Køer med en kort TTL forhindrer tordnende flokke, mens jeg deler retfærdigt via „max-in-flight“. I tilfælde af overbelastning slukker jeg trinvist: først svarcaching, så læsebegrænsning og til sidst skrivebegrænsning.

Distribueret håndhævelse i klynger

Jeg sætter grænser hele klyngen så ingen instans bliver en bypass. Jeg bruger centrale tællere (f.eks. Redis) med atomare forøgelser, korte TTL'er og opdeling efter nøglepræfiks for at undgå hotspots. Jeg kombinerer sliding window-tællere med probabilistiske strukturer (f.eks. Approx-tællere) til meget store mængder. Jeg opfanger urskævheder ved at få gateways til at synkronisere deres tid og beregne reset-tider på serversiden. Jeg isolerer segmenter i „celler“: Hver cellegruppe sætter sine egne grænser, så en fejl forbliver lokal. Fail-closed for kritiske skrivninger, fail-open for ikke-kritiske læsninger - det holder tjenesten robust.

Edge/CDN-integration og regionale kvoter

Jeg forhindrer trafik i at gå unødvendigt igennem til backend ved at sætte grænser på kanten grab: POP-relaterede regler stopper misbrug tidligt, mens jeg definerer regionale kvoter pr. kontinent eller land. Dette holder brugere i nærheden hurtige, selv om der opstår spidsbelastninger andre steder. Edge-caches reducerer presset på læse-endepunkter; betingede anmodninger (ETag/If-None-Match) reducerer den effektive belastning. For API'er i flere regioner synkroniserer jeg tællere med jævne mellemrum og baseret på tolerancer, så ventetiden ikke eksploderer.

Klienthåndtering: Forsøg, backoff og idempotens

Jeg giver kunderne succes uden at bringe platformen i fare: Eksponentiel backoff med Jitter forhindrer synkroniseringsstorme; 429-svar indeholder klare hints og en „Retry-After“-værdi. For skrive-slutpunkter kræver jeg idempotency-nøgler, så gentagelser ikke gør nogen skade. Jeg bruger konsekvent et eksempel på en 429-krop:

{

"error": "rate_limited",

"message": "For mange anmodninger. Prøv igen efter nulstillingen eller efter Retry-After.",

"limit": 120,

"remaining": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Jeg dokumenterer, om „Retry-After“ indeholder sekunder eller en dato, og sætter klare øvre grænser for det samlede antal forsøg. Dette holder klienterne kontrollerbare, og platformen stabil.

Integration i gateways og load balancere

Jeg flytter hastighedsbegrænsningen så tæt på kanten som muligt: API-gateway først, så load balancer, så applikationslogik, så at dyrt Backend-ressourcer brænder ikke af i første omgang. Gateways tilbyder færdige throttling-plug-ins, header management og centraliserede regler. Load balancers fordeler belastningen og genkender hotspots tidligt. Selve applikationen indstiller finkornede kontroller pr. slutpunkt, herunder anti-replay og strengere kontroller for mutationer. Hvis du ser nærmere på arkitekturen, finder du API-første hosting Nyttig stof til eftertanke for rene håndhævelsespunkter.

Forsvar mod DDoS, brute force og credential stuffing

Jeg genkender DDoS-mønstre med distribuerede IP'er, ensartede stier og spidsbelastninger uden reel sessionsdybde og bremser dem med hårdtn kvoter pr. IP og subnet. Jeg stopper brute force ved login med stramt indstillede bursts, captcha-opfølgning og progressive forsinkelser. Jeg afslører credential stuffing via kendte lækager, serier af mislykkede forsøg og fingeraftryk. Hvis tærsklerne overskrides, blokerer jeg midlertidigt og kræver yderligere verifikation. Jeg bruger signaler til automatiserede fjender Bot-styring, så de rigtige brugere ikke lider.

Retfærdighed og niveaudeling: kvoter pr. kundesegment

Jeg fordeler kvoterne på en gennemsigtig måde: Enterprise får større budgetter, Starter mindre, så Omkostninger forbliver forudsigelige, og alle har fair adgang. Eksempel på retningslinje: 5.000, 1.000 og 100 anmodninger pr. minut for Enterprise, Professional og Starter. Særligt følsomme stier som /auth, /billing eller /write ligger under dette, mens read endpoints forbliver mere generøse. Jeg tjekker hver måned, om segmenter eller grænser skal justeres, f.eks. i tilfælde af ny brugeradfærd. Sådan sikrer jeg vækst uden at bringe platformens kvalitet i fare.

API'er i realtid: WebSockets, SSE og streaming

Jeg begrænser ikke kun HTTP-anmodninger, men også Forbindelser og meddelelseshastigheder: Maksimalt antal samtidige WebSocket-forbindelser pr. konto, beskeder pr. sekund og byte-grænser pr. kanal forhindrer snakkesalige klienter. Jeg beskytter udsendelser med kanalkvoter og adskiller systemhændelser fra brugerhændelser. Heartbeat-intervaller og timeouts holder zombieforbindelser på et minimum. Til SSE begrænser jeg reconnect-frekvenser og bruger cache-venlige event-batches til at udjævne belastningstoppe.

Indgående webhooks og modtryk

Jeg sikrer indgående webhooks fra eksterne tjenester med Indgangsbuffering, dedikerede grænser og afbrydere. I tilfælde af overbelastning svarer jeg med 429/503 inklusive „Retry-After“ og accepterer kun signerede, idempotente leverancer. Jeg isolerer webhook-behandling i køer for at undgå at blokere de centrale API'er og leverer leveringsrapporter, så partnere kan finjustere deres retry-strategier.

Databeskyttelse og compliance inden for telemetri

Jeg logger kun, hvad der er nødvendigt: hashes i stedet for komplette IP'er, korte Fastholdelse for rå logfiler, klar formålsbegrænsning for revisions- og faktureringsdata. Takstgrænsehændelser indeholder pseudonymiserede nøgler; jeg dokumenterer opbevaringsperioder og adgangsrettigheder. Dette sikrer overholdelse af GDPR-kravene uden at miste sikkerhed og gennemsigtighed.

Overvågning, advarsler og reaktionsplaner

Jeg overvåger forespørgselsmængder, fejlrater og ventetider i korte vinduer, så jeg kan tidligt genkende eskalerende mønstre. Jeg definerer advarsler lige under kapaciteten for at give plads til handling. Hvis 95%-tærsklen falder, skalerer jeg grænserne eller omfordeler trafikken. Hvis 5xx-raten stiger, leder jeg først efter årsagerne: defekte implementeringer, database-hotspots, outlier-endepunkter. Derefter kommunikerer jeg status og løsninger til kunderne, før jeg strammer kvoterne.

Konfiguration, test og sikker udrulning

Jeg administrerer regler som Kode (versionering, gennemgang, CI-tjek) og udrulning af ændringer via funktionsflag: først skyggetilstand (kun måling), derefter procentvis udrulning og til sidst fuld håndhævelse. Syntetiske kontroller tjekker 429 stier, header-konsistens og retry-after-logik. Kaostests simulerer bursts, key fanout og Redis latency, så driften forbliver stabil, selv under stress. Jeg whitelister nødvendige systemklienter (build pipelines, compliance-scannere) i en begrænset periode for at minimere falske alarmer.

Forhindrer bypass: Bypass, key fanout og normalisering

Jeg lukker huller, som angribere kan bruge til at overskride grænser: Nøgle fanout (tusindvis af engangsnøgler) er begrænset med kvoter på højere niveau pr. konto, organisation og IP/subnet. Jeg normaliserer stier (store/små bogstaver, Unicode, alias-ruter), så identiske slutpunkter ikke tælles flere gange. Jeg korrelerer signaler (IP, ASN, enhedens fingeraftryk, session, token-oprindelse), så hurtige IP-rotationer ikke fører til uendelige budgetter. For særligt følsomme stier kræver jeg stærkere auth (mTLS/OAuth scope).

Fair afregning for overforbrug

Jeg skaber Planlægbarhed, ved at tilbyde valgfrie overtræksmodeller: ekstra kvoter, der kan bookes på forhånd, automatiske lofter (blødt/hårdt loft) og gennemsigtige månedsrapporter. Dette holder omkostningerne under kontrol, mens teams ikke behøver at bremse midlertidige projekter. Jeg giver tidlig besked via webhooks og e-mail, når kvoterne når 80/90/100%, og foreslår passende opgraderinger, før de hårde grænser træder i kraft.

Finjustering: test, logs og løbende justering

Jeg validerer grænser med belastnings- og stresstest, logger 429 hændelser granulært og tilpasser dem. Regler baseret på reel brug. Jeg minimerer falske positiver med whitelists til compliance-scanninger og build pipelines. For API'er med grafbaserede forespørgsler tester jeg feltkompleksitet for at dække uretfærdige forespørgsler. Det er værd at tage et kig på GraphQL i hostingpanelet, fordi forespørgselsdybde og omkostningsgrænser effektivt supplerer hastighedsbegrænsning. Kontinuerlig iteration holder beskyttelse og ydeevne i balance.

Resumé: beskyttelse, retfærdighed og forudsigelige resultater

Jeg bruger hastighedsbegrænsning i flere lag, så Kunder kan fungere pålideligt, mens misbrug ikke har nogen chance. Kombinationen af passende algoritmer, gennemsigtig kommunikation og klare kvoter holder platformen responsiv. Jeg minimerer risici og holder omkostningskrævende spidsbelastninger under kontrol med overvågning og tests. Fornuftige tiering-modeller sikrer retfærdighed og plads til vækst. Hvis man tænker grænser som produktregler, opnår man stabile tjenester og tilfredse brugere.