wordpress redis fremskynder WordPress mærkbart, fordi jeg cacher dynamiske databaseforespørgsler som objekter i RAM og dermed reducerer belastningen på CPU'en. Jeg konfigurerer caching specifikt fra objekt til side til servercaching og kombinerer Redis med passende plugins, så sideforespørgsler er betydeligt hurtigere, og tiden til første byte reduceres.

Centrale punkter

Før jeg går dybere, vil jeg opsummere de vigtigste justeringer, der gør WordPress med Redis virkelig hurtigt og samtidig holder det rent og håndterbart. Jeg fokuserer på objektcaching med Redis, supplerer det fornuftigt med sidecache og CDN og kontrollerer hver ændring med målte værdier. Jeg vælger en hosting-takst, der leverer Redis pålideligt og tilbyder tilstrækkelig RAM til cachen. Jeg kører Redis sikkert, afgrænser instanser og rydder cachen på en kontrolleret måde. Jeg holder konfigurationen slank, måler regelmæssigt og justerer, hvis det er nødvendigt.

- Objekt-cache i RAM reducerer forespørgsler og forkorter svartider.

- Side-cache tilføjer Redis, især til anonyme besøgende.

- RAM-budget og LRU-strategi sikrer ensartet ydelse.

- Sikker Forbindelse og separate DB-id'er forhindrer konflikter.

- Overvågning med målinger, der viser de reelle effekter af hver ændring.

Hvorfor caching er obligatorisk i WordPress

WordPress genererer hver side dynamisk, hvilket udløser mange databaseforespørgsler og fører til mærkbare ventetider uden en cache. Jeg afbryder denne dyre cyklus ved at gemme fuldt beregnede resultater i Cache og levere det direkte, næste gang det kaldes. Dette reducerer belastningen på PHP og MySQL, og svartiderne er betydeligt kortere. Målinger viser, at objektcaching reducerer indlæsningstiderne massivt; eksempelværdier går ned fra 800 ms til omkring 450 ms [1][2]. Søgemaskiner vurderer korte svartider positivt, og besøgende bliver længere, fordi sider med Aktiver Åbn hurtigere [1][2][5].

Sådan fungerer Redis i objektcachen

Redis opbevarer ofte brugte objekter i arbejdshukommelsen og leverer dem uden at gå gennem databasen. I WordPress ender f.eks. resultaterne af WP_Query, optionsværdier eller transienter direkte i RAM-cache. Det reducerer drastisk antallet af rundrejser til databasen og sparer servertid til komplekse sammenføjninger eller sortering. I modsætning til en ren sidecache forbliver siden dynamisk, fordi Redis leverer datablokke, som WordPress derefter kombinerer. Denne tilgang er ideel til butikker, medlemsområder og meget personaliserede komponenter, hvor komplette sider sjældent er identiske, og en hurtig Objekt-adgang hjælper mærkbart [1][2][3].

Hvad ender egentlig i cachen - og hvad skal ikke?

Ikke alle objekter er egnede til vedvarende caching. Jeg udelader bevidst dynamiske eller sikkerhedskritiske data (f.eks. nonces, sessioner, login-tilstande) eller kategoriserer dem som vedvarende. ikke-vedvarende grupper. Mere stabilt indhold som f.eks. forespørgselsresultater, optionsværdier, menuer, taksonomikort eller produktlister er meget gode kandidater. I mere komplekse opsætninger definerer jeg globale grupper (f.eks. for indstillinger), der er de samme i hele installationen, og ikke-vedvarende gruppersom skal forblive friske pr. anmodning. Det holder cachen konsistent og forhindrer flygtige værdier i at blive forældede.

I miljøer med flere instanser eller websteder indstiller jeg et unikt præfiks, så nøglerne forbliver adskilt, og så nøgler fra forskellige projekter ikke overskriver hinanden. Jeg bruger et talende salt/præfiks til dette, ideelt set med en miljøreference (staging, prod):

// wp-config.php (eksempel)

define('WP_CACHE_KEY_SALT', 'acme_prod_');

define('WP_REDIS_PREFIX', 'acme_prod_'); // afhængigt af det understøttede plugin

Det betyder, at nøgler kan renses på en målrettet måde, og jeg kan hurtigt se i værktøjer eller logfiler, hvilket projekt en post hører til. Især i CI/CD-workflows sparer det mig for at gætte mig frem til selektive invalideringer.

Sæt Redis op: Trin for trin på serveren

Jeg installerer først Redis-tjenesten på serveren og tjekker, om den er tilgængelig. På Debian/Ubuntu opdaterer jeg pakkelisterne, installerer Redis og tester forbindelsen med PING. Derefter tilføjer jeg Redis-udvidelsen til PHP, så WordPress kan tale med. Derefter aktiverer jeg et passende objektcache-plugin i backend'en og forbinder WordPress med tjenesten. Dette giver en hurtig Objekt-cache, som pålideligt leverer data fra hukommelsen.

sudo apt opdatering

sudo apt installer redis-server

redis-cli ping # Forventes: PONG

sudo apt installer php-redis

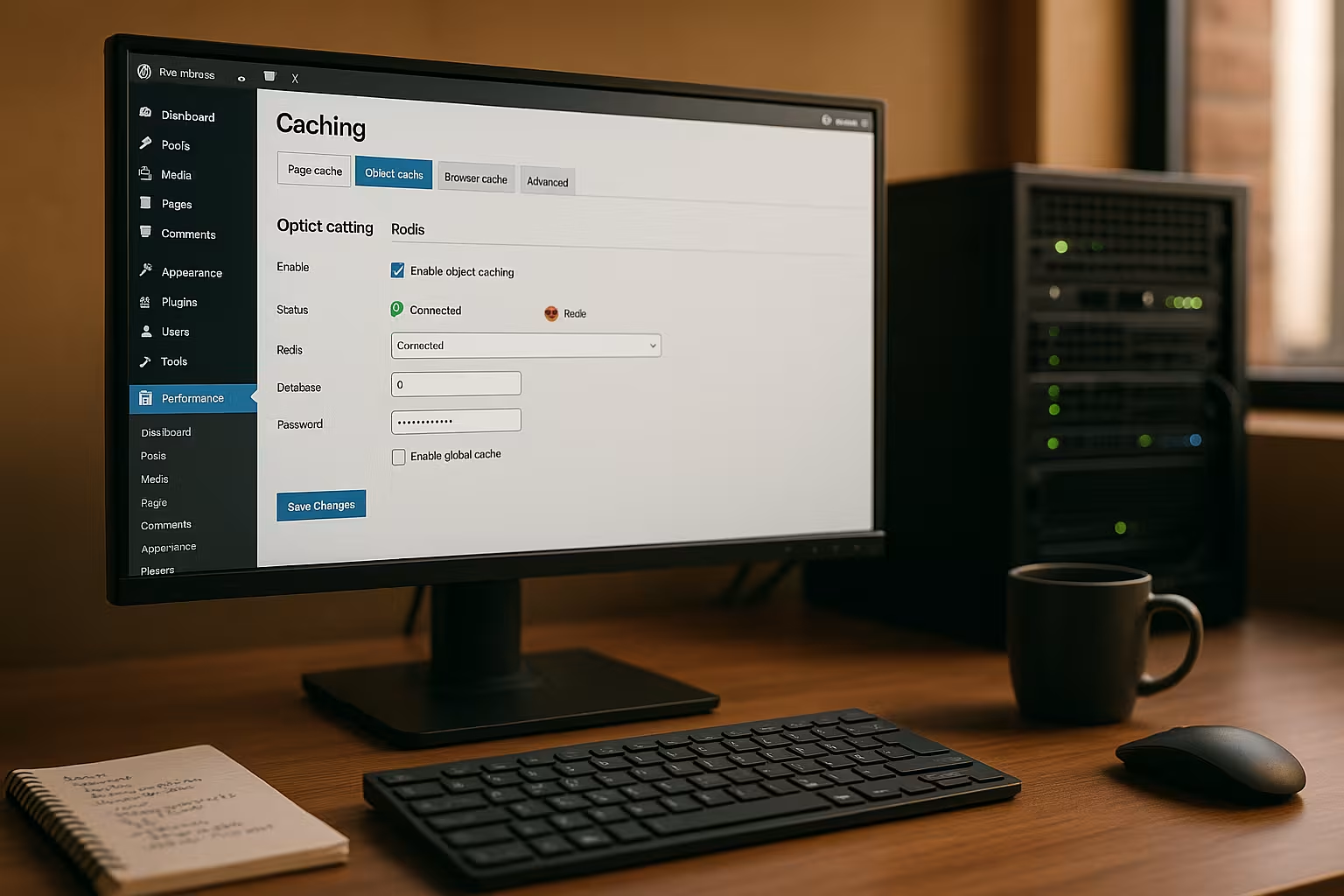

I næste trin aktiverer jeg plugin'et "Redis Object Cache" i WordPress og kontrollerer forbindelsesstatus. Mange hostere inkluderer allerede Redis eller giver mulighed for at aktivere det i panelet, hvilket gør forbindelsen særlig nem. Jeg sørger for, at socket- eller TCP-indstillingerne er korrekte, og rydder cachen en gang efter aktivering. Derefter måler jeg svartiderne igen for at minimere effekten af Ændring kan ses tydeligt [2][3][4].

Serialiser, komprimering og PHP redis-muligheder

Hvordan data ender i Redis påvirker hastighed og RAM-forbrug. Hvis det er muligt, bruger jeg en effektiv serializer (f.eks. igbinary) og valgfri komprimering til store objekter. Det reducerer hukommelsesbelastningen og fremskynder deserialiseringen. Mange plugins tilbyder switches til dette i indstillingerne; alternativt indstiller jeg konstanter i wp-config.php, hvis plugin'et evaluerer dem. Tommelfingerregel: Store objekter, der sjældent ændres, har særlig gavn af det, mens meget små nøgler har mindre gavn af det.

// wp-config.php (eksempel, afhængigt af plugin)

define('WP_REDIS_SERIALIZER', 'igbinary'); // eller 'php'

define('WP_REDIS_COMPRESSION', true);

define('WP_REDIS_MAXTTL', 86400); // Max. Levetid (1 dag)

Med en rimelig MaxTTL Jeg forhindrer "evige" poster, der aldrig bliver opdateret. Det holder cachen frisk og forhindrer inkonsekvente visningstilstande [1][4].

Redis og WordPress-plugins: stærke kombinationer

Mange caching-plugins kan bruge Redis som backend for objektcachen og supplere den med sidecache, HTML-minify eller billedoptimering. Jeg kan især godt lide at bruge LiteSpeed Cachefordi jeg nemt kan styre objektcachen med Redis, edge-side includes og billedformater som WebP der. Jeg aktiverer objektcachen i indstillingerne, vælger "Redis" som metode og indtaster host, port eller socket. Forbindelsestesten viser mig straks, om alt er oppe at køre, og om cachen fungerer. Denne kombination giver dynamisk Indhold hurtigt og sikrer også, at anonyme besøgende ofte betjenes direkte fra sidecachen.

WooCommerce, medlemsområder og ESI

Til butikker og login-områder holder jeg specifikt sidecachen tilbage, men er stærkt afhængig af objektcachen. Til dele, der er personaliserede (indikator for indkøbskurv, hilsen, ønskelister), bruger jeg edge-side includes (ESI) eller henter fragmenterne på klientsiden. Det er vigtigt at have en klar Variererstrategi (f.eks. i henhold til cookies eller roller), så anonyme besøgende får mest muligt ud af det, mens indloggede brugere ser ensartet, dynamisk indhold. Redis leverer byggestenene lynhurtigt uden at være afhængig af fuld sideidentitet [1][2][3].

Finjustering: wp-config og redis.conf

For socket-forbindelser indstiller jeg specifikke konstanter i wp-config.php, så WordPress bruger den korrekte adresse. Jeg definerer skemaet og stien og kontrollerer, om soklen findes og har de rette tilladelser. Jeg bruger redis.conf til at begrænse hukommelsen med maxmemory og vælger en fornuftig eviction policy, ofte allkeys-lru. På denne måde holder jeg cachen beregnelig og forhindrer Redis i at give systemet den RAM er omstridt. Jeg tildeler også en adgangskode eller bruger bindingsadresser og firewalls, så ingen kan få adgang til Redis udefra. forespørgsler [1][4].

// wp-config.php

define('WP_REDIS_SCHEME', 'unix');

define('WP_REDIS_PATH', '/tmp/redis.sock');

// redis.conf (eksempel)

maxmemory 256mb

maxmemory-politik allkeys-lru

requirepass SecretPassword123

TTL-strategier, udsættelser og målrettet invalidisering

En god cache er ikke kun hurtig, men også forudsigelig. Jeg tildeler TTL'er i henhold til dataklassen: korte TTL'er til flygtige feeds, længere til menuer, næsten ingen til sjældent skiftende taksonomitildelinger - begrænset af en MaxTTL. Ved opdateringer ugyldiggør jeg selektivi stedet for at rydde hele cachen: Når jeg gemmer et produkt, rydder jeg kun de nøgler, der påvirker de relevante kategorier, prisfiltre, produktlister eller widgets. Det holder hitraten høj og minimerer spidsbelastninger [2][4].

Om udsmidningspolitikken: allkeys-lru er normalt det mest robuste valg, fordi det fortrænger forældede, lidt brugte taster først. Hvis min opsætning har strenge TTL-specifikationer, kan jeg flygtig-lru kan give mening (kun taster med TTL er forskudt). Jeg overvåger fejlraten efter ændringer; hvis den stiger kraftigt, er RAM-budgettet ofte for lille, eller TTL'en er for kort [1][4].

Typiske fejl og hurtige løsninger

Hvis WordPress forveksler socket og TCP, forbliver objektcachen tom eller rapporterer forbindelsesfejl. Så tjekker jeg plugin-indstillingerne, host/port eller Unix-socket og kigger på serverlogfilerne. Hvis cachen tømmes for ofte, justerer jeg TTL-værdier og ugyldiggørelsesudløsere, f.eks. når jeg gemmer indlæg eller produkter. For flere WordPress-instanser tildeler jeg separate Redis-databaser, så poster ikke overskriver hinanden. Det er sådan, jeg holder Data rent adskilt og modtage en klart forståelig Cache-struktur [4].

Undgå cache-stormløb

Uden beskyttelsesmekanismer kan udløbet af mange populære nøgler føre til en "tordnende flok": Hundredvis af anmodninger om at genopbygge det samme indhold. Jeg afbøder dette ved at indstille lidt forskudte TTL'er, beskytte genopbygninger med låse og - hvis plugin'et tilbyder det - bruge Stale-While-Revalidate brug: Udløbne poster leveres kortvarigt, mens nye poster oprettes i baggrunden. Dette holder svartiderne stabile, selv under spidsbelastninger [2][3].

Mål og accelerer permanent

Jeg stoler ikke på min mavefornemmelse, men måler TTFB, First Contentful Paint og serverens svartider før og efter hver ændring. Værktøjer i browseren, servermetrikker og plugin-statistikker viser mig flaskehalse. Jeg kombinerer også objektcache med ren sidecache og aflaster PHP via mekanismer på serversiden som Nginx-mikrocache eller Apache-acceleratorer. En god introduktion gives af den kompakte Caching på serversiden Oversigt. Sådan øger jeg antallet af Ydelse trin for trin og opnå permanent kort Indlæsningstider.

Vigtige nøgletal og diagnosekommandoer

Jeg ser jævnligt på disse målinger for driften:

- Keyspace hits/missesRatio viser effektiviteten af objektcachen.

- udsatte_nøgler og udløbne_nøglerIndikerer for lidt RAM eller TTL'er, der er for korte.

- brugt_hukommelse, mem_fragmentering_ratio: Giver information om faktisk brug og fragmentering.

- tilsluttede_klienter, blokerede_klienter: Indikationer på flaskehalse ved høj belastning.

Jeg bruger enkle kommandoer på serveren, som f.eks. redis-cli INFO, redis-cli MONITOR (kun i kort tid) og redis-cli MEMORY STATS. I selve WordPress hjælper debug-plugins og statistikkerne fra Object Cache-plugin med at vurdere cache-hits, ventetider og grupper [2][4].

Alternativer kort kategoriseret

Filbaseret caching fungerer enkelt, men er begrænset af tung trafik eller mange dynamiske elementer. Memcached er også en cache i hukommelsen og er hurtig, men tilbyder færre datatyper og mindre fleksibilitet end Redis. Page cache gemmer komplette HTML-sider og er perfekt til anonyme brugere, mens object cache accelererer dynamiske komponenter. Sammen med et CDN reducerer jeg afstande og belastningstoppe i hele verden. Den rigtige Kombination bestemmer resultatet, og Redis leverer den hurtige Underkonstruktion.

Når jeg med vilje ikke bruger Redis

Meget små sider uden databasebelastning eller ekstremt statiske projekter (headless med forhåndsrenderede sider) har kun minimale fordele. Selv med meget begrænset RAM på delte systemer kan en for lille cache forårsage flere evictions end fordele. I sådanne tilfælde har jeg en tendens til at fokusere på sidecache og clean asset management og kun slå Redis til, når målte værdier viser en klar gevinst [1][5].

Hosting med Redis: en kort sammenligning

Til pålidelig objektcaching har du brug for en udbyder, der leverer Redis og giver nok RAM til cachen. Jeg ser efter garanterede ressourcer, SSH-adgang og mulighed for at konfigurere sockets eller porte korrekt. Et veldokumenteret panel og hurtig support sparer tid i det daglige. I den følgende oversigt viser jeg de vigtigste data for et typisk valg. Sådan finder du den rigtige Takst lettere at vælge, og den senere Konfiguration lykkes uden problemer.

| Udbyder | Redis-understøttelse | Ydelse | Pris/ydelse | Støtte |

|---|---|---|---|---|

| webhoster.de | Ja | Topklasse | Fremragende | Meget god |

| Udbyder B | Delvist | God | God | God |

| Udbyder C | Nej | Tilstrækkelig | Tilstrækkelig | Tilfredsstillende |

Skalering, ventetid og høj tilgængelighed

Efterhånden som et projekt vokser, er jeg opmærksom på topologien: Lokale UNIX-sockets er de hurtigste, så længe webserveren og Redis kører på den samme host. For separate servere vælger jeg en tæt netværkslatens og sikrer tilstrækkelig båndbredde. For Høj tilgængelighed replikation og sentinel; med rene cache-opsætninger undgår jeg ofte persistens (RDB/AOF) for at spare I/O. Hvis en node går tabt, genopbygger cachen sig selv, og siden kan stadig betjenes hurtigt takket være sidecachen [3][4].

Sikkerhed og multisite/multiinstance-opsætninger

Jeg eksponerer aldrig Redis ubeskyttet til det offentlige netværk og indstiller bindingsadresser, firewall-regler og en adgangskode. På delte servere foretrækker jeg at bruge Unix-sockets med restriktive tilladelser. Hvis jeg kører flere WordPress-installationer, tildeler jeg hver side sit eget Redis DB ID og, hvis det er muligt, separate namespaces. Det forhindrer kollisioner og giver mig mulighed for at bevare overblikket. Sikkerhed koster næsten ingen tid, men bevarer Integritet dataene og beskytter dem. Tilgængelighed.

ACL'er, rettigheder og adgangsbegrænsning

Ud over adgangskoden indstiller jeg dedikerede Redis-brugere med begrænsede rettigheder, hvor det er muligt. Jeg tillader kun de kommandoer, som min opsætning har brug for, og blokerer for administrative kommandoer. Bind adresser (bind 127.0.0.1 ::1), og firewalls begrænser adgangen til interne netværk. Jeg bruger separate adgangsdata og præfikser til staging og udvikling, så jeg aldrig ved et uheld kan overskrive produktive data [4].

Praktisk arbejdsgang: fra test til ibrugtagning

Jeg starter i et staging-miljø, aktiverer Redis, måler, optimerer og udruller ændringerne i henhold til planen. Før jeg går live, rydder jeg cachen, varmer vigtige sider op og overvåger servermålingerne under belastning. Hvis der opstår timeouts eller usædvanlige miss rates, justerer jeg politikker, TTL'er og størrelsen. For mere dybdegående idéer til tuning bruger jeg regelmæssigt kompakte vejledninger på WordPress' ydeevne. Det er sådan, jeg sikrer en kontrolleret Introduktion og modtage en rent dokumenteret Konfiguration.

Forvarmning, udløsning og selektiv udrensning

Efter udrulning forhindrer jeg koldstart ved automatisk at hente vigtige sider (sitemap-baseret forvarmning) og forvarme kritiske forespørgsler. Når jeg frigiver indhold, renser jeg specifikke berørte områder (f.eks. en kategori og dens arkivsider), ikke hele sitet. Det holder hitraten høj og sikrer, at spidsbelastninger rammer cacher, der allerede er varme. Jeg dokumenterer, hvilke hooks der udløser rensninger, og tester disse stier i staging, så live-kørslen kører problemfrit [2][4][5].

At tage med: Min korte opsummering

Redis gør WordPress betydeligt hurtigere, fordi objektcachen sparer dyre forespørgsler og leverer indhold direkte fra hukommelsen. Jeg kombinerer Redis med en sidecache og, afhængigt af projektet, et CDN for at få global rækkevidde. Med en ren opsætning, korrekte socket/port-specifikationer, passende hukommelsesgrænser og en sikker forbindelse forbliver systemet hurtigt og pålideligt [1][2][3][4][5]. Målte værdier afgør enhver ændring, ikke mavefornemmelse. Det er sådan, jeg opnår kort Indlæsningstiderbedre Brugeroplevelse og et mærkbart hurtigere WordPress-site.