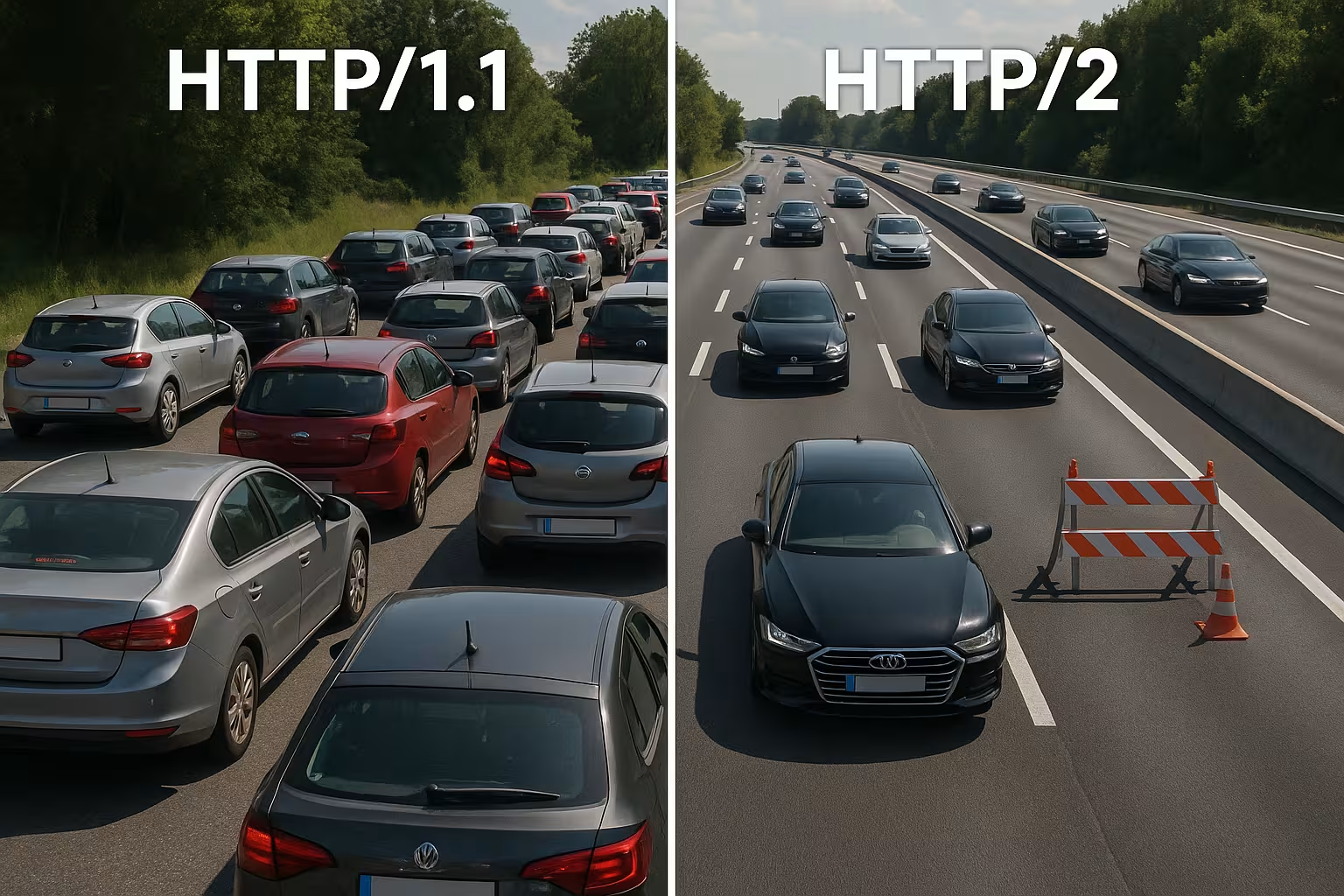

HTTP/2 multiplexing samler mange forespørgsler via en enkelt forbindelse og fjerner blokeringer på protokolniveau. I virkelige netværk bremser TCP-Head-of-Line, TLS-Overhead og mangelfuld prioritering imidlertid, så HTTP/2 ikke automatisk kører hurtigere end HTTP/1.1.

Centrale punkter

- Multiplexing paralleliserer mange anmodninger via en enkelt TCP-forbindelse.

- TCP-HoL forbliver aktiv og stopper alle streams ved tab.

- TLS-opsætning kan forsinke Time-to-First-Byte mærkbart.

- Prioriteringer og Server Push fungerer kun med korrekt tuning.

- Sidetype beslutter: mange små filer kontra få store filer.

Sådan fungerer HTTP/2-multiplexing internt

Jeg opdeler hvert svar i små Rammer, nummererer dem og ordner dem i logiske streams, så flere ressourcer kan køre samtidigt via en enkelt forbindelse. På den måde undgår jeg blokeringer på HTTP-niveau, fordi ingen anmodninger længere skal vente på, at en anden er færdig. Browsere sender HTML, CSS, JS, billeder og skrifttyper parallelt og reducerer omkostningerne ved ekstra forbindelser. HPACK reducerer headere, hvilket mindsker belastningen betydeligt ved mange små filer. Det afgørende er dog stadig, at alle streams deler den samme TCP-linje, hvilket skaber fordele, men også nye afhængigheder. Denne arkitektur leverer hastighed, så længe netværket forbliver stabilt, og Prioritering arbejder fornuftigt.

HTTP/1.1 vs. HTTP/2: Væsentlige forskelle

HTTP/1.1 bruger tekstbaserede meddelelser og flere parallelle forbindelser pr. vært til at indlæse ressourcer samtidigt, hvilket øger håndtryk og overhead. HTTP/2 arbejder binært, bruger en enkelt forbindelse til alt og komprimerer headere, hvilket reducerer ventetider, især ved mange objekter. I vandfaldsdiagrammer forsvinder lange køer, fordi streams kører parallelt. Til gengæld flyttes flaskehalsen fra HTTP-laget til TCP-laget, hvilket jeg mærker tydeligt på ustabile netværk. Små sider med meget caching har ofte kun få fordele i forhold til 1.1, mens store sider med mange ressourcer har mere synlige fordele. Disse forskelle former min Tuningstrategi og retfærdiggør en projektspecifik beslutning.

Vælg flowkontrol og vinduesstørrelser korrekt

HTTP/2 har sin egen strømkontrol pr. strøm og pr. forbindelse. Jeg sørger for, at værdierne er fornuftige for INITIAL_WINDOW_SIZE og antallet af samtidige streams, så ledningen hverken bliver overbelastet eller underudnyttet. For små vinduer skaber unødvendigt mange VINDUE_OPDATERING-rammer og begrænser datahastigheden, for store vinduer kan overbelaste svagere klienter. I netværk med høj båndbredde-forsinkelsesprodukt (BDP) øger jeg vinduesstørrelsen målrettet, så store svar ikke sidder fast i stop-and-go. Samtidig begrænser jeg MAX_CONCURRENT_STREAMS Pragmatisk: tilstrækkelig parallelitet til renderingskritiske elementer, men ikke så meget, at småting bremser LCP-billedet. Disse justeringsskruer er små, men deres indvirkning på de reelle indlæsningstider er stor, hvis de passer til siden og netværket.

Revurdering af domæne-sharding og bundling

Mange 1.1-optimeringer er kontraproduktive under HTTP/2. Jeg opløser gammel domæne-sharding, fordi en enkelt, veludnyttet forbindelse er mere effektiv end kunstigt distribuerede sockets. Jeg sætter også spørgsmålstegn ved aggregering af JavaScript til megafiler: Mindre, logisk adskilte bundter muliggør målrettede caches og undgår, at hele appen skal overføres igen, hvis der foretages en ændring. Billed-sprites mister betydning, fordi parallelle anmodninger er blevet billige, og moderne billedformater sammen med caching fungerer bedre. Jeg afvikler derfor der, hvor multiplexing kan vinde, og samler kun, hvis det virkelig forenkler arkitekturen eller øger caching-træffeprocenten målbart.

Forbindelseskoalescens og certifikater

HTTP/2 tillader browsere at bruge en forbindelse til flere værtsnavne, hvis certifikater og DNS passer. Jeg planlægger SAN-poster og SNI, så sammenlægning bliver mulig, og ekstra håndtryk undgås. Hvis ALPN og Cipher-Suites stemmer overens, kan klienten CSS fra cdn.example.com og billeder af static.example.com via samme forbindelse. Det sparer RTT'er, forenkler prioriteringen og øger chancen for, at kritiske aktiver ankommer uden omveje. Jeg kontrollerer disse effekter specifikt i fanen Netværk: Bruges der virkelig kun en socket, eller tvinger certifikatgrænser og politikker browseren til at oprette nye forbindelser?

Hvorfor multiplexing bremses: TCP-Head-of-Line

Hvis et pakke går tabt på den eneste TCP-forbindelse, venter hele linjen, indtil retransmissionen ankommer – dette stopper kortvarigt alle HTTP/2-strømme. I mobilnetværk med svingende latenstid og øget tabprocent ser jeg derfor regelmæssigt mindre gevinster eller endda ulemper i forhold til flere 1.1-forbindelser. Denne effekt forklarer, hvorfor multiplexing ser godt ud på papiret, men ikke altid fungerer i praksis. Målinger fra forskning og feltarbejde viser netop denne sammenhæng i reelle netværk [6]. Jeg planlægger derfor implementeringer konservativt, tester på typiske brugerstier og undersøger virkningerne for hver målgruppe. Hvis man ignorerer TCP-HoL, går man glip af Strøm og kan endda forlænge opladningstiden.

TLS-håndtryk, TTFB og sidetype

HTTP/2 kører næsten udelukkende via TLS på internettet, hvilket skaber ekstra håndtryk og kan forlænge tiden til første byte mærkbart for få aktiver. Hvis jeg kun leverer en stor fil, forsvinder fordelen ved multiplexing, fordi der ikke er behov for parallel overførsel. Sider med ti til tyve små filer drager snarere fordel af dette, mens svar med enkeltaktiver ofte ligger på niveau med HTTP/1.1. Jeg reducerer overheads med TLS 1.3, session genoptagelse og ren keep-alive, så genforbindelser ikke er nødvendige, og den ene linje virkelig lever. Til finjustering bruger jeg Keep-Alive-tuning, for at indstille genbrug, inaktivitetstidsfrister og begrænsninger, der passer til belastningen. Dette reducerer håndtryksandelen og TTFB stabiliserer sig også ved trafikspidser.

CDN- og proxy-kæder: h2 til origin

Mange stakke afslutter TLS ved kanten og kommunikerer videre til oprindelsen. Jeg kontrollerer, om HTTP/2 også bruges mellem CDN og backend, eller om der sker et tilbageskridt til HTTP/1.1. Buffering af proxyer kan delvist ødelægge fordelene (header-komprimering, prioritering), hvis de reserialiserer svar eller ændrer rækkefølgen. Derfor optimerer jeg end-to-end: Edge-node, mellemliggende proxy og origin skal forstå h2, køre passende vinduesstørrelser og ikke ignorere prioriteter. Hvor h2c (HTTP/2 uden TLS i det interne netværk) er fornuftigt, tester jeg, om det sparer latenstid og CPU uden at overtræde sikkerhedspolitikker. Først en harmonisk kæde udfolder sig Multiplexing-effekten fuldstændigt.

Brug prioritering korrekt

Jeg prioriterer kritiske ressourcer højt, så HTML, CSS og LCP-billedet kommer først og renderingsblokeringer fjernes. Uden klare prioriteter spiser mindre vigtige scripts værdifuld båndbredde, mens indholdet over folden venter. Ikke alle servere overholder browserprioriteterne korrekt, og nogle proxyservere ændrer rækkefølgen, hvorfor jeg evaluerer resultatdata i stedet for ønsketænkning [8]. Preload-headers og en tidligt placeret billedreference forkorter indlæsningsstier og øger hitraten i cachen. Prioritering er ikke magi, men den dirigerer forbindelsen, så brugerne hurtigt kan se, hvad de har brug for. Klare regler giver mærkbare Tryk og gør multiplexing virkelig effektivt.

Prioritering i praksis: Extensible Priorities

Browsere har videreudviklet deres prioriteringsmodeller. Jeg tager højde for, at moderne klienter ofte bruger „Extensible Priorities“ i stedet for faste trævægtninger. De signalerer herved hastighed og progressive parametre for hver stream, som serveren skal fortolke og oversætte til fair schedulere. Jeg kontrollerer, om min server respekterer disse signaler eller baserer sig på gammel adfærd. I A/B-tests sammenligner jeg indlæsningsstier med og uden server-prioritering for at identificere fortrængningseffekter. Vigtigt: Prioritering skal favorisere render-kritiske elementer, men må ikke føre til starvation af langvarige downloads. En forsigtig blanding undgår spidsbelastninger og holder pipelinen fri for synligt indhold.

Server Push: sjældent forkortelsen

Jeg bruger kun server push målrettet, fordi over-pushing optager båndbredde og ignorerer browser-caches. Hvis en allerede cachelagret ressource pushes, bliver stien langsommere i stedet for hurtigere. Mange teams har slået push fra igen og kører med preload, som er betydeligt mere pålideligt [8]. I særlige tilfælde, f.eks. på tilbagevendende ruter med klare mønstre, kan push være nyttigt, men jeg beviser effekten med måleværdier. Uden dokumentation fjerner jeg push og holder pipelinen fri til data, der virkelig er nødvendige. Her er mindre ofte mere. mere, lige på den eneste forbindelse.

Praksis sammenligning: Hvornår HTTP/1.1 kan være hurtigere

Jeg oplever HTTP/1.1 som konkurrencedygtigt, når få, store filer dominerer, eller netværk med større tab fungerer. Flere separate forbindelser fordeler derefter risikoen og kan forkorte enkelte first-byte-tider. På meget små sider kompenserer ekstra TLS-håndtryk ofte fuldstændigt for multiplexing-fordelen. Ved mange små objekter trumfer HTTP/2 derimod, fordi komprimering, prioritering og en enkelt socket virker. Følgende oversigt viser typiske mønstre fra audits og feltforsøg, der styrer mit valg af protokol [6][8]. Dette skema erstatter ikke tests, men leverer en solid Orientering til de første beslutninger.

| Scenarie | Bedre protokol | Årsag |

|---|---|---|

| Mange små aktiver (CSS/JS/billeder/skrifttyper) | HTTP/2 | Multiplexing og HPACK reducerer overhead, én forbindelse er nok |

| Få, meget store filer | HTTP/1.1 ≈ HTTP/2 | Næsten ingen parallelitet nødvendig; håndtryksomkostninger vejer tungere |

| Ustabile mobilnetværk med tab | HTTP/1.1 delvist bedre | TCP‑HoL stopper alle streams ved HTTP/2; flere sockets kan hjælpe |

| Optimeret TLS (1.3, genoptagelse), klare prioriteter | HTTP/2 | Mindre opsætning, målrettet båndbreddekontrol |

| Over-pushing aktiv | HTTP/1.1/HTTP/2 uden push | Unødvendige data blokerer forbindelsen; forhåndsindlæsning er mere sikker |

Bedste praksis for reelle gevinster i opladningstid

Jeg reducerer bytes før protokollen: billeder i WebP/AVIF, passende størrelser, sparsomme scripts og rene caching-headers. Jeg holder kritiske CSS-stidele små, indlæser fonts tidligt og indstiller fallbacks for at undgå layoutskift. Til oprettelse af forbindelse og DNS bruger jeg Preconnect og DNS-prefetch, så håndtryk starter, før parseren støder på ressourcen. Brotli til tekstindhold fremskynder gentagne hentninger, især via CDN'er. Jeg kontrollerer effekter i vandfaldet og sammenligner LCP, FID og TTFB før og efter ændringer. Måleværdier styrer min Prioriteringer, mavefornemmelse gør ikke.

gRPC, SSE og streaming-sager

HTTP/2 udnytter sine styrker særligt ved gRPC og andre bidirektionelle eller langvarige streams. Jeg er opmærksom på timeouts, bufferstørrelser og backlog-regler, så en langsom stream ikke påvirker alle andre forespørgsler negativt. For server-sendte begivenheder og live-feeds er en stabil, vedvarende forbindelse nyttig, så længe serveren administrerer prioriteterne korrekt, og keep-alive-grænser ikke træder i kraft for tidligt. Samtidig tester jeg, hvordan fejl opfører sig: Genopbygning af streams, eksponentiel backoff og fornuftige grænser for genforbindelser forhindrer belastningstoppe, når mange klienter afbryder og genforbinder samtidigt. På den måde forbliver realtidsscenarier forudsigelige.

OS- og TCP-tuning for stabil multiplexing-ydeevne

Valget af protokol kan ikke kompensere for en svag netværkskonfiguration. Jeg kontrollerer algoritmer til overbelastningskontrol (f.eks. BBR vs. CUBIC), socket-buffere, TCP Fast Open-politikker og størrelsen på det indledende overbelastningsvindue. En overbelastningskontrol, der passer til stien, kan reducere retransmissioner og afbøde HoL-effekter. Lige så vigtigt: korrekte MTU/MSS-værdier for at forhindre fragmentering og undgåelige tab. På TLS-niveau foretrækker jeg korte certifikatkæder, OCSP-stapling og ECDSA-certifikater, fordi de fremskynder håndtrykket. Sammen giver disse indstillinger multiplexing den nødvendige Underkonstruktion, så prioritering og headerkomprimering kan udøve deres virkning.

Målemetode og KPI'er i hverdagen

Jeg stoler ikke på medianværdier, men ser på p75/p95 i målingerne, opdelt efter enhed, netværkstype og placering. Syntetiske tests leverer reproducerbare basisværdier, mens Real User Monitoring viser spredningen i marken. Jeg sammenligner vandfald af nøglebaner, kontrollerer tidlige bytes fra HTML, rækkefølgen af CSS/JS og ankomsttiden for LCP-billedet. Jeg implementerer ændringer som kontrollerede eksperimenter og observerer TTFB, LCP og fejlprocenter parallelt. Vigtigt: Prioriteringer uden målbar nytte fjerner jeg igen. På den måde forbliver konfigurationen slank, og jeg investerer i justeringsskruer, der statistisk set sparer tid.

Crawl- og bot-trafik

Ud over brugerne drager også crawlere fordel af ren HTTP/2. Jeg aktiverer h2 for relevante slutpunkter og observerer, om bots genbruger forbindelsen og henter flere sider på samme tid. Unødvendige 301-kaskader, ukomprimerede svar eller for korte Keep-Alive-grænser koster crawl-budget. Jeg tilpasser politikker, så multiplexing også virker her uden at overskride backend-grænser. Resultat: mere effektive scanninger og større stabilitet under belastning.

HTTP/2, HTTP/3 og hvad der tæller næste gang

HTTP/3 bruger QUIC via UDP og løser TCP-Head-of-Line-Blocking, hvilket især hjælper med mobilitet og tab [6]. Opbygningen af forbindelsen bliver kortere, og stream-blokeringer rammer ikke længere alle forespørgsler samtidigt. I blandede flåder forbliver HTTP/2 vigtigt, men jeg aktiverer HTTP/3 der, hvor klienter og CDN'er allerede taler det. Detaljerede sammenligninger som HTTP/3 vs. HTTP/2 hjælper mig med at planlægge udrulninger i faser og målrettet. Jeg måler separat efter placering, enhed og netværkstype, så rigtige brugere får gavn af det. Sådan bruger jeg protokoller til at Indlæsningstider i hverdagssituationer.

Hosting og infrastruktur som accelerator

Gode protokoller kan ikke redde en svag infrastruktur, derfor tjekker jeg nøje placering, peering, CPU, RAM og I/O-grænser. En moderne webserver, et fornuftigt antal arbejdere og et cache-lag forhindrer, at den eneste forbindelse ender i en flaskehals. Strategisk brug af CDN forkorter RTT og afbøder belastningsspidser. Hvis man betjener brugere i hele Europa, drager man ofte større fordel af korte afstande end af finjustering af protokoller. Jeg planlægger kapacitet med reserver, så burst-trafik ikke bringer systemet i knæ. Sådan udfolder multiplexing sin virkning Potentiale pålidelig.

Genkender hurtigt fejlmønstre

Hvis HTTP/2 virker langsommere end forventet, leder jeg efter typiske mønstre: En enkelt lang overførsel, der blokerer mange små; prioriteter, der ignoreres; høje retransmissionshastigheder på mobilforbindelser; eller TLS-genoptagelse, der ikke virker. Derefter sammenligner jeg HTTP/2 og HTTP/1.1 under identiske forhold, adskiller CDN-indflydelse fra oprindelsen og ser på antallet af sokler, det faktiske antal streams og rækkefølgen af de første kilobytes. Hvis jeg finder en flaskehals, justerer jeg først grundlæggende elementer (bytes, caching, håndtryk), før jeg finpudser flowkontrol eller prioriteter. Denne rækkefølge giver de mest pålidelige forbedringer.

Praktisk oversigt til hurtige beslutninger

Jeg bruger HTTP/2 Multiplexing, når der er mange objekter, prioriteterne er på plads, og TLS er konfigureret korrekt. Ved få store filer eller ustabile netværk regner jeg med små fordele og holder øje med 1.1-resultaterne. Jeg bruger kun server push med beviser, næsten altid preload, og jeg holder overhead lavt ved hjælp af komprimering, caching og tidlige forbindelser. Målinger med reelle enheder og placeringer bekræfter mine antagelser, før jeg implementerer ændringer bredt [6][8]. I sidste ende er det ikke protokolnummeret, der tæller, men mærkbar hastighed for reelle brugere. Hvis man gør det på denne måde, får man pålideligt udbytte af HTTP/2. Hastighed og danner grundlaget for HTTP/3.