En reverse proxy-arkitektur fremskynder forespørgsler, beskytter backend-systemer og skalerer webapplikationer uden at ændre app-serverne. Jeg viser, hvordan en Omvendt proxy forbedrer målbart ydeevne, sikkerhed og skalering i den daglige drift.

Centrale punkter

- Ydelse gennem caching, SSL-offloading og HTTP/2/3

- Sikkerhed via WAF, DDoS-beskyttelse og IP/geo-blokering

- Skalering med belastningsbalancering og sundhedstjek

- Kontrol takket være centraliseret routing, logning og analyse

- Øvelse med NGINX, Apache, HAProxy, Traefik

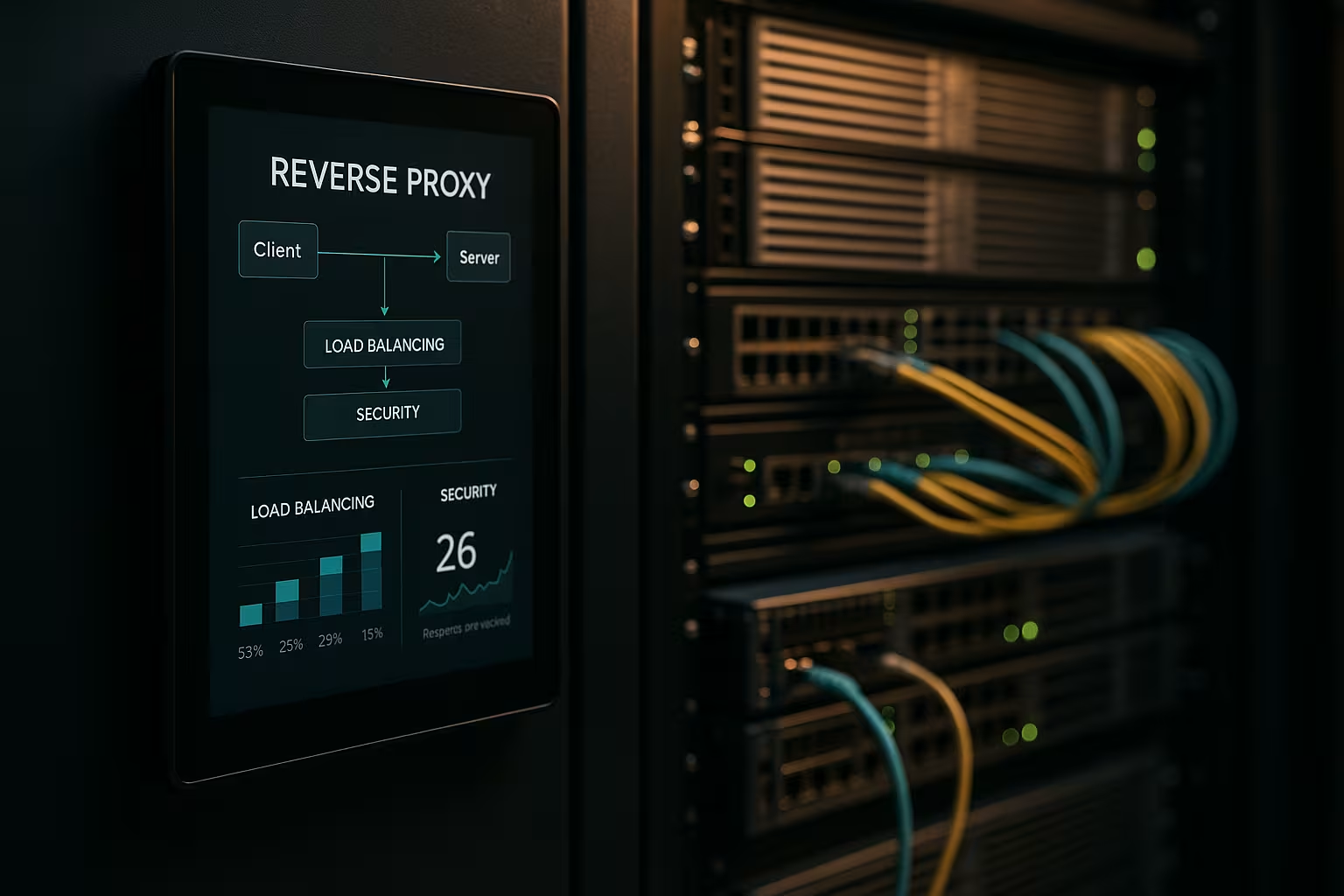

Hvad gør en reverse proxy-arkitektur?

Jeg indstillede Omvendt proxy foran applikationsserverne og får den til at afslutte alle indgående forbindelser. På den måde indkapsler jeg den interne struktur, holder IP'er skjult og minimerer direkte angrebsflader. Proxyen bestemmer, hvilken tjeneste der overtager anmodningen, og den kan cache indhold. Den tager sig af TLS, komprimering og protokoloptimeringer som HTTP/2 og HTTP/3. Dette reducerer mærkbart belastningen på app-serverne og giver mig et sted til retningslinjer, evalueringer og hurtige ændringer.

Optimering af ydeevne: caching, offloading, edge

Jeg kombinerer CachingSSL-offloading og edge-levering for at reducere ventetiden. Jeg serverer almindelige aktiver som billeder, CSS og JS fra cachen, mens dynamiske dele forbliver friske (f.eks. fragmentcaching). Jeg bruger politikker som stale-while-revalidate og stale-if-error for at reducere ventetider og sikre levering i tilfælde af forstyrrelser. TLS 1.3, HTTP/2 push replacement via early hints og Brotli-komprimering giver yderligere acceleration. For internationale brugere ruter proxyen til nærliggende noder, hvilket reducerer tiden til første byte. Et kig på passende Fordele og anvendelsesscenarier viser, hvilke justeringer der er værd at foretage først.

Forbedring af sikkerhedssituationen: WAF, DDoS, geoblokering

Jeg analyserer trafikken på Proxy og filtrerer ondsindede anmodninger, før de når backend-systemerne. En WAF genkender mønstre som SQL-injektion eller XSS og stopper dem centralt. TLS-terminering muliggør inspektion af den krypterede datastrøm, hvorefter jeg videresender den rent. DDoS-forsvar afhænger af proxyen, som fordeler, begrænser eller blokerer forespørgsler uden at berøre applikationer. Geo- og IP-blokering afskærer kendte kilder, mens hastighedsgrænser og bot-detektering bremser misbrug.

Skalering og høj tilgængelighed med belastningsbalancering

Jeg fordeler belastningen via Belastning Balanceringsalgoritmer som Round Robin, Least Connections eller vægtede regler. Jeg sikrer sticky sessions ved hjælp af cookie-affinitet, hvis sessioner skal forblive bundet til en node. Sundhedstjek tjekker aktivt tjenester, så proxyen automatisk fjerner defekte mål fra puljen. Horisontal skalering fungerer på få minutter: registrer nye noder, forny konfigurationen, færdig. Til valg af værktøj er der en kort Sammenligning af værktøjer til belastningsbalancering med fokus på L7-funktioner.

Centraliseret styring og præcis overvågning

Jeg indsamler logfiler centralt på Gateway og måle nøgletal som svartider, gennemløb, fejlrater og TTFB. Dashboards viser hotspots, langsomme endepunkter og trafiktoppe. Header-analyser (f.eks. cache-hit, alder) hjælper med at finjustere cache-strategier. Korrelations-id'er giver mig mulighed for at spore forespørgsler på tværs af tjenester og fremskynde analyser af grundårsager. Jeg sætter standardiserede retningslinjer for HSTS-, CSP-, CORS- og TLS-profiler én gang ved proxyen i stedet for separat i hver tjeneste.

Ruter, regler og udgivelser uden risiko

Jeg kontrollerer Ruteføring baseret på værtsnavn, sti, headers, cookies eller geo-information. Det giver mig mulighed for at route API'er og frontends separat, selv om de kører på de samme porte. Jeg implementerer Blue-Green- og Canary-versioner direkte på proxyen ved at dirigere små brugergrupper til nye versioner. Feature flag headers hjælper med kontrollerede tests under reel trafik. Jeg holder vedligeholdelsesvinduerne korte, fordi jeg skifter ruter på få sekunder.

Teknologisammenligning i praksis

Jeg vælger Værktøjder matcher belastningen, protokollen og driftsmålene. NGINX scorer med statisk indhold, TLS, HTTP/2/3 og effektive reverse proxy-funktioner. Apache brillerer i miljøer med .htaccess, omfattende moduler og ældre stakke. HAProxy giver meget stærk L4/L7-balancering og fin kontrol over sundhedstjek. Traefik integreres godt i containeriserede opsætninger og læser ruter dynamisk fra labels.

| Løsning | Styrker | Typiske anvendelser | Særlige funktioner |

|---|---|---|---|

| NGINX | Høj Ydelse, HTTP/2/3, TLS | Web-frontends, API'er, statisk levering | Brotli, caching, TLS-offloading, stream-modul |

| Apache | Modulær Fleksibilitet.htaccess | Ældre stakke, PHP-tunge installationer | Mange moduler, fin adgangshåndtering |

| HAProxy | Effektiv Afbalancering, Sundhedstjek | L4/L7 load balancer, gateway | Meget detaljerede, sofistikerede ACL'er |

| Traefik | Dynamisk Opdagelse, Container-fokus | Kubernetes, Docker, mikrotjenester | Automatisk konfiguration, LetsEncrypt-integration |

Implementeringstrin og tjekliste

Jeg begynder med MålsætningerPrioriterer ydeevne, sikkerhed, tilgængelighed og budget. Derefter definerer jeg protokoller, certifikater, cipher suites og protokolversioner. Jeg definerer og versionerer klart routing-regler, caching-politikker og -grænser. Jeg opsætter sundhedstjek, observerbarhed og advarsler, før jeg går i luften. Hvis du vil i gang med det samme, kan du finde en instruktiv oversigt på Opsæt omvendt proxy til Apache og NGINX.

Bedste praksis for performance-tuning

Jeg aktiverer HTTP/3 med QUIC, hvor klienter understøtter det, og hold HTTP/2 klar til bred kompatibilitet. Jeg bruger Brotli til tekstressourcer og får proxyen til at komprimere billeder effektivt. Jeg definerer bevidst cachenøgler til at kontrollere variationer gennem cookies eller headers. Jeg minimerer TLS-håndtrykstider, bruger sessionsgenoptagelse og indstiller OCSP-hæftning. Jeg bruger early hints (103) til at give browseren forhåndssignaler om kritiske ressourcer.

Sikkerhedsopsætning uden friktionstab

Jeg holder Certifikater centralt og automatisere fornyelser med ACME. HSTS håndhæver HTTPS, mens CSP og CORP kontrollerer indholdet. Jeg starter en WAF-regelbase konservativt og strammer den gradvist for at undgå falske alarmer. Hastighedsgrænser, mTLS til interne tjenester og IP-lister reducerer risikoen fra dag til dag. Auditlogs forbliver manipulationssikre, så jeg kan spore hændelser med juridisk sikkerhed.

Omkostninger, drift og ROI

Jeg planlægger Budget for serverressourcer, certifikater, DDoS-beskyttelse og overvågning. Små opsætninger starter ofte med et par virtuelle kerner og 4-8 GB RAM til proxyen, som koster et lavt tocifret beløb i euro pr. måned, afhængigt af udbyderen. Større flåder bruger dedikerede instanser, anycast og globale noder, hvilket kan betyde trecifrede euro-omkostninger pr. lokation. Centraliseret administration sparer tid: færre individuelle konfigurationer, hurtigere release-processer og kortere nedetid. ROI afspejles i højere konvertering, lavere afvisningsprocent og mere produktiv teknik.

Arkitekturvarianter og topologier

Jeg vælger en arkitektur, der matcher risiko- og latensprofilen. Enkle miljøer fungerer godt med en enkelt Gateway i DMZ, som videresender anmodninger til interne tjenester. I regulerede eller store miljøer adskiller jeg frontend- og backend-proxyer i to trin: Trin 1 afslutter internettrafik og håndterer WAF, DDoS og caching, trin 2 ruter internt, taler mTLS og håndhæver zero trust-principper. Aktive/aktive opsætninger med anycast IP og globalt distribuerede noder reducerer failover-tider og optimerer nærheden til brugeren. For CDN'er foran den omvendte proxy sikrer jeg korrekt videresendelse af overskrifter (f.eks. X-Forwarded-Proto, Real-IP) og harmoniserede cache-hierarkier, så edge- og gateway-cachen ikke blokerer for hinanden. Jeg indkapsler scenarier med flere lejere ved hjælp af SNI/TLS, separate ruter og isolerede hastighedsgrænser for at undgå naboeffekter.

Protokoller og særlige tilfælde: WebSockets, gRPC og HTTP/3

Jeg overvejer protokoller med særlige krav, så funktionerne forbliver stabile. For WebSockets Jeg aktiverer opgraderingsstøtte og langvarige forbindelser med passende timeouts. gRPC drager fordel af HTTP/2 og rene headere; jeg undgår H2C (almindelig tekst-HTTP/2) i perimeteren til fordel for TLS med korrekt ALPN. For HTTP/3 Jeg leverer QUIC-porte (UDP) og frigiver kun 0-RTT restriktivt, da gentagelser indebærer risici. Streaming-slutpunkter, server-sendte begivenheder og store uploads får deres egne politikker for buffering og body-size, så proxyen ikke bliver en flaskehals. Ved protokoloversættelser (f.eks. HTTP/2 udenfor, HTTP/1.1 indenfor) tester jeg grundigt header-normalisering, komprimering og genbrug af forbindelser for at holde ventetiderne lave og ressourceforbruget forudsigeligt.

Autentificering og autorisation ved gatewayen

Jeg flytter Godkendelse-beslutninger til den omvendte proxy, hvis arkitekturen og overholdelsen tillader det. Jeg integrerer OIDC/OAuth2 via tokenverifikation ved gatewayen: Proxyen validerer signaturer (JWKS), kontrollerer udløb, målgruppe og omfang og indstiller verificerede krav som overskrifter for tjenesterne. Jeg bruger API-nøgler til maskine-til-maskine-slutpunkter og begrænser dem efter rute. Til interne systemer bruger jeg mTLS med gensidig certifikatverifikation for at gøre tilliden eksplicit. Jeg sørger for ikke at logge følsomme headere (autorisation, cookies) unødigt og bruger tilladelses- og afvisningslister pr. rute. Jeg formulerer finkornede politikker via ACL'er eller udtryk (f.eks. sti + metode + krav), som giver mig mulighed for at kontrollere adgangen centralt uden at ændre applikationskoden.

Modstandsdygtighed: timeouts, nye forsøg, backoff og afbrydelse af kredsløb

Jeg definerer Timeouts bevidst pr. hop: etablering af forbindelse, header timeout og response timeout. Jeg aktiverer kun retries for idempotente metoder og kombinerer dem med eksponentiel backoff plus jitter for at undgå tordnende flokke. Strømafbrydere beskytter backend-pools: Hvis proxyen opdager fejl eller forsinkelser, åbner den kredsløbet midlertidigt, videresender kun tilfældigt til den berørte destination og svarer ellers tidligt, eventuelt med fallback fra cachen. Registrering af afvigelser fjerner automatisk "svage" instanser fra puljen. Jeg begrænser også samtidige upstreams, aktiverer genbrug af forbindelser og bruger køer med retfærdig prioritering. Det sikrer, at tjenesterne forbliver stabile, selv om enkelte komponenter kommer under pres.

Compliance, databeskyttelse og beskyttelse af PII

Jeg behandler proxyen som Datahub med klare regler for databeskyttelse. Jeg maskerer eller pseudonymiserer personoplysninger i logfiler; forespørgselsstrenge og følsomme overskrifter logges kun på grundlag af hvidlistning. Jeg forkorter IP-adresser, hvor det er muligt, og overholder strenge opbevaringsperioder. Adgang til logfiler og metrikker er rollebaseret, og ændringer dokumenteres på en revisionssikker måde. I forbindelse med revisioner forbinder jeg gateway-hændelser med change management-poster, så godkendelser og regelopdateringer kan spores. Det giver mig mulighed for at opfylde compliance-krav uden at gå på kompromis med dyb indsigt i performance og sikkerhed.

Kubernetes, Ingress og Gateway API

Jeg integrerer den omvendte proxy problemfrit i Orkestrering af containere. I Kubernetes bruger jeg ingress-controllere eller den mere moderne gateway-API til at beskrive routing, TLS og politikker deklarativt. Traefik læser labels dynamisk, NGINX/HAProxy tilbyder sofistikerede ingress-varianter til høj gennemstrømning. Jeg adskiller klyngens interne øst/vest-routing (service mesh) fra nord/syd-perimeter-gatewayen, så ansvarsfordelingen forbliver klar. Jeg implementerer canary releases med vægtede ruter eller header matches, samtidig med at jeg nøje definerer sundhedstjek og pod-beredskab for at undgå flapping. Jeg versionerer konfigurationer som kode og tester dem i staging-klynger med belastningssimulering, før jeg går live.

Operationel modenhed: konfigurationsstyring og CI/CD

Jeg behandler proxy-konfigurationen som Kode. Ændringer kører via pull requests, testes automatisk (syntaks, linting, sikkerhedstjek) og rulles ud i pipelines. Jeg bruger previews eller skyggetrafik til at validere nye ruter under reelle forhold uden at risikere kundetransaktioner. Rollbacks er mulige på få sekunder, fordi jeg tagger versioner og implementerer dem atomisk. Jeg håndterer følsomme hemmeligheder (certifikater, nøgler) separat, krypteret og med minimale autorisationer. For at opnå høj tilgængelighed distribuerer jeg releases til noder på en forskudt måde og registrerer effekterne i dashboards, så jeg hurtigt kan træffe modforanstaltninger i tilfælde af regressioner.

Typiske snublesten og anti-mønstre

Jeg undgår Kilder til fejlder ofte forekommer i praksis. Jeg forhindrer cache-forgiftning med streng header-normalisering og ren Vary-styring; jeg udelukker cookies, der ikke påvirker gengivelsen, fra cachenøglen. Jeg genkender omdirigeringssløjfer tidligt ved at teste med X-Forwarded-Proto/Host og konsekvente HSTS/CSP-politikker. "Stol på alle X-Forwarded-For" er tabu: Jeg stoler kun på det næste hop og indstiller Real-IP rent. Jeg kontrollerer store uploads via limits og streaming, så proxyen ikke buffer, hvilket backend'en kan gøre bedre. Med 0-RTT i TLS 1.3 er jeg opmærksom på idempotens. Og jeg holder øje med body- og headerstørrelser, så individuelle anmodninger ikke optager hele worker-kapaciteten.

Resumé til hurtige beslutninger

Jeg satser på en Omvendt proxy, fordi den kombinerer hastighed, beskyttelse og skalering på ét sted. Caching, TLS-offloading og HTTP/2/3 fremskynder de reelle indlæsningstider betydeligt. WAF, DDoS-forsvar og IP/geo-kontrol reducerer risikoen mærkbart. Belastningsbalancering, sundhedstjek og rullende udgivelser holder tjenesterne tilgængelige, selv under vækst. Med NGINX, Apache, HAProxy eller Traefik finder jeg en klar løsning til enhver opsætning og holder driften overskuelig.