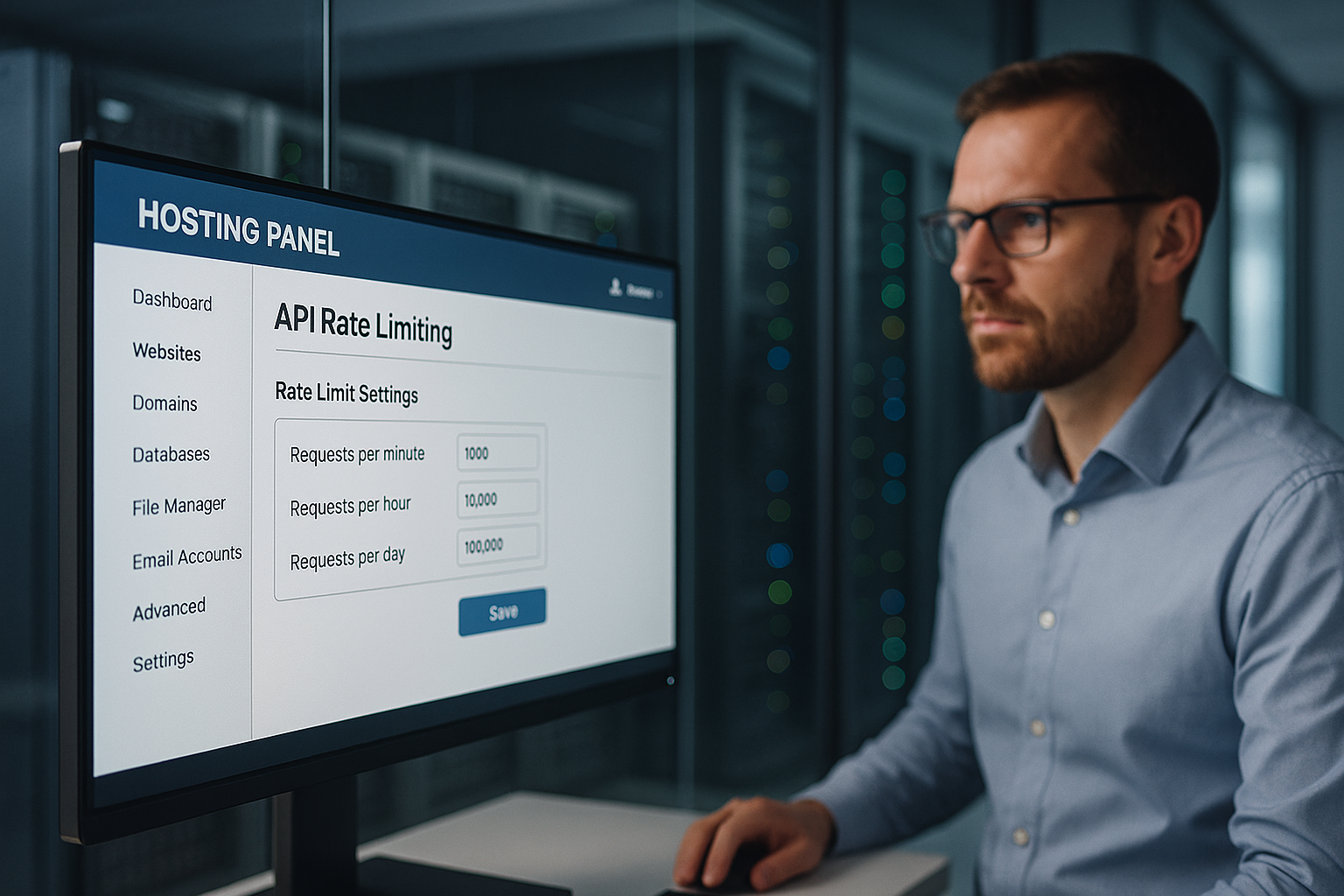

Alojamiento API con limitación de velocidad protege un panel de alojamiento de abusos controlando estrictamente las tasas de solicitud por IP, clave API y punto final, evitando así interrupciones, uso indebido de datos y costes innecesarios. Establezco límites multinivel, reconozco anomalías a tiempo y protejo funciones relevantes para el cliente como el inicio de sesión, la facturación y el acceso a datos contra DDoS, relleno de credenciales y picos de carga injustos.

Puntos centrales

- Multicapa Límites: global, usuario, endpoint

- Algoritmos seleccionar: Token/Leaky/Ventana corredera

- Transparente Cabecera: Límite, Restante, Reiniciar

- Monitoreo en tiempo real con alertas

- Feria escalonadas: cuotas por segmento de clientes

Por qué es indispensable limitar la tasa de API en el panel de alojamiento

Utilizo límites claros para evitarlo Atacante Bloquee los endpoints de inicio de sesión o de datos con avalanchas de peticiones. De este modo, los procesos legítimos siguen disponibles mientras yo detengo los abusos y mantengo baja la latencia. Cualquier sobrecarga en los servidores compartidos cuesta dinero y confianza, así que limito a tiempo las peticiones excesivas. Evito las escaladas ajustando dinámicamente los límites antes de que se desborde la capacidad. Los clientes obtienen tiempos de respuesta constantes porque aplico cuotas justas y elimino los picos incontrolados.

Cómo funciona la limitación de velocidad: conceptos y algoritmos

Selecciono el algoritmo adecuado en función del perfil de carga, la criticidad del punto final y los picos previstos, porque un buen proceso Abuso se detiene de forma fiable y permite ráfagas legítimas. Los métodos de ventana deslizante suavizan los límites duros, el cubo de fichas permite ráfagas rápidas a corto plazo y el cubo con fugas mantiene un flujo uniforme. La ventana fija es adecuada para reglas sencillas, pero puede parecer injusta en los bordes de la ventana. Combino métodos cuando los puntos finales varían mucho, como el inicio de sesión frente al contenido estático. Esto me permite controlar los flujos sin bloqueos innecesarios.

| Algoritmo | Uso típico | Ventaja para la seguridad |

|---|---|---|

| Ventana fija | Modelo simple de cuotas | Previsible Contingentes |

| Ventana corredera | Alisado más preciso | Menos trucos fronterizos |

| Cubo de fichas | Tolerante a las ráfagas | Consejos flexibles |

| Cubo con fugas | Rendimiento constante | Desagüe limpio |

Para cada punto final, documento el RPS objetivo, el tamaño de la ráfaga y la reacción en caso de violaciones para que el Controlar sigue siendo reproducible. Cada regla se versiona en la infraestructura para que las auditorías puedan reconocer claramente cuándo se aplica qué límite.

Límites de varios niveles: global, usuario, punto final

Primero establezco un límite global que define el Plataforma en conjunto para que ninguna aplicación consuma capacidad por sí sola. A continuación, establezco cuotas por cliente, de modo que las cuentas premium obtengan un mayor rendimiento sin excluir a las demás. Por último, gradúo los puntos finales: Autenticación, pago, operaciones de escritura más estrictas; puntos finales de lectura más generosos. No bloqueo ciegamente las infracciones de las normas, sino que primero aumento la latencia o pido un backoff antes de tomar medidas más duras. De este modo, la experiencia del usuario es equitativa y los servicios críticos permanecen protegidos.

Medir correctamente los patrones de tráfico

Analizo las horas punta típicas, la distribución por punto final y la tasa de error porque estos datos Límites caracterizar. Distingo entre el uso humano y los patrones automatizados a través de la densidad de IP, los agentes de usuario y el comportamiento de los tokens. Reconozco las anomalías por un aumento repentino de errores 401/403/429 o tiempos de respuesta erráticos. Destaco las anomalías y pruebo reglas más estrictas en un simulacro para evitar falsas alarmas. Sólo cuando se confirma que el comportamiento es estable activo la aplicación.

Transparencia para los clientes: Cabeceras y mensajes de error

Comunico abiertamente los límites para que Equipos integrarse de forma predecible y retroceder en el tiempo. Incluyo las cuotas en cada respuesta para que los desarrolladores puedan controlar su uso. Los mensajes de error claros ayudan en lugar de frustrar. Este es un ejemplo que utilizo:

Límite X-RateLimit: 120

X-RateLimit-Remanente: 15

X-RateLimit-Reset: 1731187200

Reintento: 30

Mantengo la coherencia de los formatos y los describo en la documentación de la API para que no haya lagunas en la interpretación y el Integración funciona sin problemas.

Límites y simultaneidad basados en los costes y la complejidad

No sólo limito la tasa de solicitud pura, sino también Complejidad y la concurrencia: las rutas con un uso intensivo de la informática reciben „costes“ más elevados que las lecturas simples. Asigno una puntuación a cada solicitud (por ejemplo, 1 a las GET sencillas, 10 a las exportaciones grandes) y acelero en función de los costes totales en la ventana de tiempo. También limito el número máximo de peticiones simultáneas por clave para proteger las reservas de backend. Las colas con un TTL corto evitan las manadas atronadoras, mientras que reparto equitativamente mediante „max-in-flight“. En caso de sobrecarga, desconecto por etapas: primero la caché de respuesta, luego la de lectura y, por último, la de escritura.

Aplicación distribuida en clusters

Pongo límites en todo el clúster para que ninguna instancia se convierta en un bypass. Utilizo contadores centrales (como Redis) con incrementos atómicos, TTLs cortos y fragmentación por prefijo de clave para evitar puntos calientes. Combino contadores de ventana deslizante con estructuras probabilísticas (por ejemplo, contadores Approx) para volúmenes muy altos. Intercepto la desviación del reloj haciendo que las pasarelas sincronicen su hora y calculen los tiempos de reinicio en el lado del servidor. Aíslo los segmentos en „celdas“: cada grupo de celdas establece sus propios límites para que un fallo siga siendo local. Fail-closed para escrituras críticas, fail-open para lecturas no críticas: así se mantiene la robustez del servicio.

Integración Edge/CDN y cuotas regionales

Evito que el tráfico pase innecesariamente al backend estableciendo límites en el borde agárrate: las normas relacionadas con POP detienen pronto los abusos, mientras que yo defino cuotas regionales por continente o país. Así se mantiene la rapidez de los usuarios cercanos, aunque se produzcan picos en otros lugares. Las cachés de borde reducen la presión sobre los puntos finales de lectura; las solicitudes condicionales (ETag/If-None-Match) reducen la carga efectiva. En el caso de las API multirregión, sincronizo los contadores periódicamente y basándome en tolerancias para que las latencias no exploten.

Gestión de clientes: reintentos, backoff e idempotencia

Logro el éxito de los clientes sin poner en peligro la plataforma: Backoff exponencial con Jitter evita tormentas de sincronización; las respuestas 429 contienen pistas claras y un valor „Retry-After“. Para los endpoints de escritura, requiero claves de idempotencia para que los reintentos no hagan daño. Utilizo un cuerpo de ejemplo para 429 de forma coherente:

{

"error": "rate_limited",

"message": "Demasiadas peticiones. Por favor, inténtelo de nuevo después del reinicio o después de Retry-After",

"límite": 120,

"remaining": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Documento si „Retry-After“ contiene segundos o una fecha, y establezco límites superiores claros para el número total de reintentos. Esto mantiene a los clientes controlables y a la plataforma estable.

Integración en pasarelas y equilibradores de carga

Muevo la limitación de velocidad tan cerca del borde como sea posible: primero la pasarela API, luego el equilibrador de carga y después la lógica de la aplicación, de modo que caro Los recursos del backend no se queman en primer lugar. Las pasarelas ofrecen plug-ins de estrangulamiento, gestión de cabeceras y reglas centralizadas. Los equilibradores de carga distribuyen las cargas y reconocen los puntos conflictivos en una fase temprana. La propia aplicación establece controles detallados por punto final, incluidos controles antirrepetición y más estrictos para las mutaciones. Si examina la arquitectura más de cerca, encontrará Alojamiento API-first Una reflexión útil para los puntos limpios de aplicación.

Defensa contra DDoS, fuerza bruta y suplantación de credenciales

Reconozco patrones DDoS por IPs distribuidas, rutas uniformes y picos sin profundidad de sesión real y los ralentizo con duron cuotas por IP y subred. Detengo la fuerza bruta en el inicio de sesión con ráfagas ajustadas, seguimiento de captcha y retrasos progresivos. Expongo el relleno de credenciales mediante fugas conocidas, series de intentos fallidos y huellas dactilares. Si se superan los umbrales, bloqueo temporalmente y exijo una verificación adicional. Utilizo señales para enemigos automatizados Gestión de bots, para que los usuarios reales no sufran.

Equidad y escalonamiento: cuotas por segmento de clientes

Escalono las cuotas de forma transparente: Enterprise recibe presupuestos más altos, Starter más pequeños, de forma que Costos siguen siendo previsibles y todo el mundo tiene un acceso equitativo. Ejemplo orientativo: 5.000, 1.000 y 100 solicitudes por minuto para Enterprise, Professional y Starter. Las rutas especialmente sensibles como /auth, /billing o /write están por debajo, mientras que los puntos finales de lectura siguen siendo más generosos. Cada mes compruebo si es necesario ajustar los segmentos o los límites, por ejemplo, en caso de nuevos comportamientos de los usuarios. Así garantizo el crecimiento sin poner en peligro la calidad de la plataforma.

APIs en tiempo real: WebSockets, SSE y streaming

No sólo limito las peticiones HTTP, sino también Conexiones y de mensajes: El número máximo de conexiones WebSocket simultáneas por cuenta, los mensajes por segundo y los límites de bytes por canal evitan los clientes charlatanes. Protejo las transmisiones con cuotas de canal y separo los eventos del sistema de los eventos de usuario. Los intervalos y tiempos de espera mantienen al mínimo las conexiones zombis. En el caso de SSE, reduzco las frecuencias de reconexión y utilizo lotes de eventos compatibles con caché para suavizar los picos de carga.

Ganchos web entrantes y contrapresión

Aseguro los webhooks entrantes de servicios externos con Búfer de entrada, límites dedicados y disyuntores. En caso de sobrecarga, respondo con 429/503 incluyendo „Retry-After“ y sólo acepto entregas firmadas e idempotentes. Aíslo el procesamiento de webhooks en colas para evitar el bloqueo de las API centrales y proporciono informes de entrega para que los socios puedan ajustar sus estrategias de reintento.

Protección de datos y cumplimiento de la normativa en telemetría

Sólo registro lo necesario: hashes en lugar de IPs completas, breves Retención para los registros en bruto, limitación clara de la finalidad para los datos de auditoría y facturación. Los eventos de límite de tarifa contienen claves seudonimizadas; documento los periodos de retención y los derechos de acceso. Esto garantiza el cumplimiento de los requisitos del GDPR sin perder seguridad y transparencia.

Planes de vigilancia, alerta y respuesta

Superviso los volúmenes de peticiones, las tasas de error y las latencias en ventanas cortas para poder principios de reconocer patrones de escalada. Defino alertas justo por debajo de la capacidad para tener margen de actuación. Si desciende el umbral 95%, amplío los límites o redistribuyo el tráfico. Si la tasa de 5xx aumenta, primero busco las causas: despliegues defectuosos, puntos calientes de la base de datos, puntos finales atípicos. A continuación, comunico el estado y las soluciones a los clientes antes de ajustar las cuotas.

Configuración, pruebas y despliegues seguros

Gestiono las normas como Código (versionado, revisión, comprobaciones CI) y despliegue de cambios a través de banderas de características: primero modo sombra (sólo medida), luego despliegue porcentual, finalmente aplicación completa. Las comprobaciones sintéticas comprueban 429 rutas, la coherencia de los encabezados y la lógica de reintento posterior. Las pruebas de caos simulan ráfagas, fanout de claves y latencia de Redis para que el funcionamiento permanezca estable incluso bajo estrés. Pongo en la lista blanca a los clientes del sistema necesarios (build pipelines, escáneres de cumplimiento) durante un periodo de tiempo limitado para minimizar las falsas alarmas.

Evitar derivaciones: Bypass, key fanout y normalización

Cierro brechas que los atacantes podrían utilizar para anular los límites: Salida de llave (miles de claves únicas) se limitan con cuotas de nivel superior por cuenta, organización e IP/subred. Normalizo las rutas (mayúsculas/minúsculas, Unicode, rutas de alias) para que los puntos finales idénticos no se cuenten varias veces. Correlaciono las señales (IP, ASN, huella digital del dispositivo, sesión, origen del token) para que las rotaciones rápidas de IP no conduzcan a presupuestos infinitos. Para rutas especialmente sensibles, requiero una autenticación más fuerte (mTLS/OAuth scope).

Facturación justa por uso excesivo

Creo Planificabilidad, ofreciendo modelos opcionales de descubierto: cuotas adicionales que pueden reservarse por adelantado, límites automáticos (límite suave/duro) e informes mensuales transparentes. Esto mantiene los costes bajo control, mientras que los equipos no tienen que ralentizar los proyectos temporales. Notifico con antelación mediante webhooks y correo electrónico cuando las cuotas alcanzan 80/90/100% y sugiero actualizaciones adecuadas antes de que entren en vigor los límites duros.

Puesta a punto: pruebas, registros y ajuste continuo

Valido los límites con pruebas de carga y estrés, registro 429 eventos de forma granular y los personalizo. Reglas basado en el uso real. Minimizo los falsos positivos con listas blancas para las exploraciones de cumplimiento y las canalizaciones de construcción. En el caso de las API con consultas basadas en gráficos, compruebo la complejidad de los campos para cubrir las consultas injustas. Merece la pena echar un vistazo a GraphQL en el panel de alojamiento, porque la profundidad de consulta y los límites de coste complementan eficazmente la limitación de velocidad. La iteración continua mantiene el equilibrio entre protección y rendimiento.

Resumen: protección, equidad y rendimiento previsible

Utilizo la limitación de velocidad en varias capas para que Clientes puede funcionar de forma fiable, mientras que los abusos no tienen ninguna posibilidad. La combinación de algoritmos adecuados, comunicación transparente y cuotas claras mantiene la capacidad de respuesta de la plataforma. Reduzco al mínimo los riesgos y mantengo bajo control los picos de costes con supervisión y pruebas. Unos modelos de niveles sensatos garantizan la equidad y el margen de crecimiento. Si piensas en los límites como en las reglas del producto, consigues servicios estables y usuarios satisfechos.