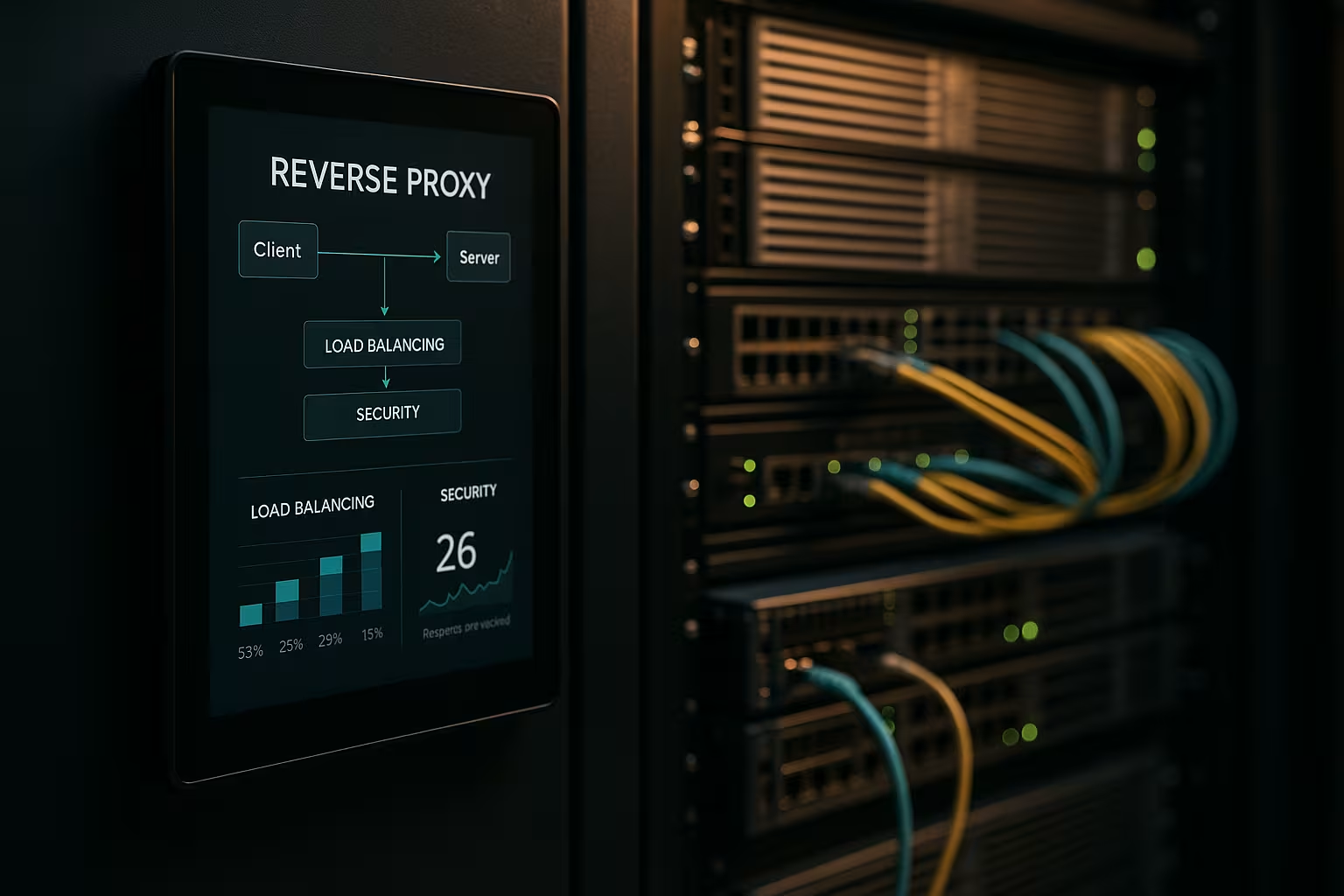

Una arquitectura de proxy inverso acelera las peticiones, protege los sistemas backend y escala las aplicaciones web sin modificar los servidores de aplicaciones. Muestro cómo una Proxy inverso mejora de forma mensurable el rendimiento, la seguridad y el escalado en las operaciones cotidianas.

Puntos centrales

- Actuación mediante almacenamiento en caché, SSL offloading y HTTP/2/3

- Seguridad mediante WAF, protección DDoS y bloqueo de IP/geo

- Escala con equilibrio de carga y comprobaciones de estado

- Controlar gracias al enrutamiento, registro y análisis centralizados

- Práctica con NGINX, Apache, HAProxy, Traefik

¿Qué hace una arquitectura de proxy inverso?

Puse el Invertir proxy delante de los servidores de aplicaciones y hacer que termine todas las conexiones entrantes. De este modo, encapsulo la estructura interna, mantengo ocultas las IP y minimizo las superficies de ataque directo. El proxy decide qué servicio se hace cargo de la solicitud y puede almacenar contenido en caché. Se encarga de TLS, la compresión y las optimizaciones de protocolos como HTTP/2 y HTTP/3. Esto reduce notablemente la carga de los servidores de aplicaciones y me ofrece un lugar para directrices, evaluaciones y cambios rápidos.

Optimización del rendimiento: caching, offloading, edge

Combino Almacenamiento en cachéSSL offloading y edge delivery para reducir latencias. Sirvo activos comunes como imágenes, CSS y JS desde la caché, mientras que las partes dinámicas permanecen frescas (por ejemplo, caché de fragmentos). Utilizo políticas como stale-while-revalidate y stale-if-error para reducir los tiempos de espera y garantizar la entrega en caso de interrupciones. TLS 1.3, HTTP/2 push replacement mediante early hints y la compresión Brotli proporcionan aceleración adicional. Para los usuarios internacionales, el proxy se dirige a nodos cercanos, lo que reduce el tiempo hasta el primer byte. Un vistazo a los Ventajas y escenarios de aplicación muestra qué ajustes merecen la pena en primer lugar.

Mejora de la seguridad: WAF, DDoS, geobloqueo

Analizo el tráfico en Proxy y filtran las peticiones maliciosas antes de que lleguen a los sistemas backend. Un WAF reconoce patrones como la inyección SQL o XSS y los detiene de forma centralizada. La terminación TLS permite inspeccionar el flujo de datos cifrados, tras lo cual lo reenvío de forma limpia. La defensa DDoS depende del proxy, que distribuye, limita o bloquea las peticiones sin tocar las aplicaciones. El bloqueo geográfico y de IP corta las fuentes conocidas, mientras que los límites de velocidad y la detección de bots frenan los abusos.

Escalado y alta disponibilidad con equilibrio de carga

Distribuyo la carga mediante Carga Algoritmos de balanceo como Round Robin, Least Connections o reglas ponderadas. Aseguro sesiones pegajosas usando afinidad de cookies si las sesiones necesitan permanecer ligadas a un nodo. Los controles de salud comprueban activamente los servicios para que el proxy elimine automáticamente los objetivos defectuosos del pool. El escalado horizontal funciona en minutos: registrar nuevos nodos, renovar la configuración, listo. Para la selección de herramientas, un breve Comparación de herramientas de equilibrio de carga centrándose en las funciones L7.

Gestión centralizada y control preciso

Recopilo los registros de forma centralizada en el Pasarela y medir cifras clave como tiempos de respuesta, rendimiento, tasas de error y TTFB. Los cuadros de mando muestran los puntos conflictivos, los extremos lentos y los picos de tráfico. Los análisis de encabezados (por ejemplo, aciertos de caché, antigüedad) ayudan a afinar las estrategias de caché. Los ID de correlación me permiten rastrear las peticiones entre servicios y acelerar el análisis de las causas. Establezco directrices estandarizadas para los perfiles HSTS, CSP, CORS y TLS una vez en el proxy, en lugar de hacerlo por separado en cada servicio.

Rutas, normas y liberaciones sin riesgo

Yo controlo Enrutamiento basándose en el nombre del host, la ruta, las cabeceras, las cookies o la información geográfica. Esto me permite enrutar APIs y frontends por separado, incluso si se ejecutan en los mismos puertos. Implemento las versiones Blue-Green y Canary directamente en el proxy dirigiendo a pequeños grupos de usuarios a las nuevas versiones. Las cabeceras de bandera de características ayudan a realizar pruebas controladas con tráfico real. Mantengo las ventanas de mantenimiento cortas porque cambio las rutas en segundos.

Comparación de tecnologías en la práctica

Elijo el Herramientaque se ajuste a los objetivos de carga, protocolo y funcionamiento. NGINX puntúa con contenido estático, TLS, HTTP/2/3 y funciones eficientes de proxy inverso. Apache brilla en entornos con .htaccess, módulos extensos y pilas heredadas. HAProxy ofrece un equilibrio L4/L7 muy sólido y un control preciso de las comprobaciones de estado. Traefik se integra bien en configuraciones de contenedores y lee rutas dinámicamente a partir de etiquetas.

| Solución | Puntos fuertes | Aplicaciones típicas | Características especiales |

|---|---|---|---|

| NGINX | Alta ActuaciónHTTP/2/3, TLS | Interfaces web, API, entrega estática | Brotli, caché, descarga TLS, módulo de flujo |

| Apache | Modular Flexibilidad.htaccess | Pilas heredadas, instalaciones con mucho PHP | Numerosos módulos, gestión precisa de los accesos |

| HAProxy | Eficaz EquilibrioChequeos médicos | Equilibrador de carga L4/L7, pasarela | ACL muy granulares y sofisticadas |

| Traefik | Dinámico Descubrimiento, Enfoque del contenedor | Kubernetes, Docker, microservicios | Configuración automática, integración con LetsEncrypt |

Etapas de aplicación y lista de control

Empiezo con ObjetivosPriorice el rendimiento, la seguridad, la disponibilidad y el presupuesto. A continuación, defino protocolos, certificados, conjuntos de cifrado y versiones de protocolos. Defino y versiono claramente las reglas de encaminamiento, las políticas de almacenamiento en caché y los límites. Establezco comprobaciones de estado, observabilidad y alertas antes de la puesta en marcha. Si quieres ponerte manos a la obra de inmediato, puedes encontrar un resumen instructivo en Configurar proxy inverso para Apache y NGINX.

Buenas prácticas para ajustar el rendimiento

Activo HTTP/3 con QUIC cuando los clientes lo soportan y mantengo HTTP/2 preparado para una amplia compatibilidad. Utilizo Brotli para los recursos de texto y hago que el proxy comprima las imágenes de forma eficiente. Defino deliberadamente claves de caché para controlar las variaciones a través de cookies o cabeceras. Minimizo los tiempos de handshake TLS, utilizo la reanudación de sesión y configuro el grapado OCSP. Utilizo sugerencias tempranas (103) para dar al navegador señales anticipadas sobre recursos críticos.

Configuración de seguridad sin pérdidas por fricción

Sostengo Certificados de forma centralizada y automatizar las renovaciones con ACME. HSTS refuerza HTTPS, mientras que CSP y CORP controlan el contenido. Empiezo una base de reglas WAF conservadora y la refuerzo gradualmente para evitar falsas alarmas. Los límites de velocidad, mTLS para servicios internos y las listas de IP reducen el riesgo en el día a día. Los registros de auditoría se mantienen a prueba de manipulaciones para que pueda rastrear los incidentes con seguridad jurídica.

Costes, funcionamiento y retorno de la inversión

Estoy planeando Presupuesto para recursos de servidor, certificados, protección DDoS y monitorización. Las configuraciones pequeñas suelen empezar con unos pocos núcleos virtuales y de 4 a 8 GB de RAM para el proxy, lo que supone un coste mensual de dos dígitos, según el proveedor. Las flotas más grandes utilizan instancias dedicadas, anycast y nodos globales, lo que puede suponer costes de tres dígitos por ubicación. La gestión centralizada ahorra tiempo: menos configuraciones individuales, procesos de liberación más rápidos y tiempos de inactividad más cortos. El retorno de la inversión se refleja en una mayor conversión, menores tasas de rebote y una ingeniería más productiva.

Variantes de arquitectura y topologías

Elijo la arquitectura en función del perfil de riesgo y latencia. Los entornos sencillos funcionan bien con un único Pasarela en la DMZ, que reenvía las peticiones a los servicios internos. En entornos regulados o grandes, separo los proxies frontend y backend en dos etapas: la etapa 1 termina el tráfico de Internet y se encarga de WAF, DDoS y almacenamiento en caché, la etapa 2 enruta internamente, habla mTLS y aplica los principios de confianza cero. Las configuraciones activas/activas con IP anycast y nodos distribuidos globalmente reducen los tiempos de conmutación por error y optimizan la proximidad al usuario. En el caso de las CDN situadas delante del proxy inverso, garantizo el reenvío correcto de los encabezados (por ejemplo, X-Forwarded-Proto, Real-IP) y la armonización de las jerarquías de caché para que la caché del extremo y la de la pasarela no se bloqueen mutuamente. Encapsulo los escenarios multiinquilino utilizando SNI/TLS, rutas separadas y límites de velocidad aislados para evitar los efectos de vecindad.

Protocolos y casos especiales: WebSockets, gRPC y HTTP/3

Considero los protocolos con requisitos especiales para que las características permanezcan estables. Para WebSockets Activo el soporte de actualizaciones y las conexiones de larga duración con tiempos de espera adecuados. gRPC se beneficia de HTTP/2 y cabeceras limpias; evito H2C (HTTP/2 en texto plano) en el perímetro en favor de TLS con ALPN correcto. Para HTTP/3 Proporciono puertos QUIC (UDP) y sólo libero 0-RTT de forma restrictiva, ya que las repeticiones entrañan riesgos. Los endpoints de streaming, los eventos enviados por el servidor y las cargas grandes tienen sus propias políticas de buffering y body-size para que el proxy no se convierta en un cuello de botella. Para las traducciones de protocolo (por ejemplo, HTTP/2 fuera, HTTP/1.1 dentro), pruebo a fondo la normalización de encabezados, la compresión y la reutilización de conexiones para mantener bajas las latencias y predecible el consumo de recursos.

Autenticación y autorización en la pasarela

Me traslado Aut-decisiones al proxy inverso si la arquitectura y el cumplimiento lo permiten. Integro OIDC/OAuth2 mediante la verificación de tokens en la pasarela: el proxy valida las firmas (JWKS), comprueba la caducidad, la audiencia y los ámbitos y establece las reclamaciones verificadas como cabeceras para los servicios. Utilizo claves API para los puntos finales de máquina a máquina y las limito por ruta. Para los sistemas internos, confío en mTLS con verificación mutua de certificados para hacer explícita la confianza. Procuro no registrar innecesariamente cabeceras sensibles (autorización, cookies) y utilizo listas de permitidos/denegados por ruta. Formulo políticas detalladas mediante ACL o expresiones (por ejemplo, ruta + método + reivindicación), lo que me permite controlar el acceso de forma centralizada sin cambiar el código de la aplicación.

Resiliencia: tiempos de espera, reintentos, retroceso e interrupción del circuito

Defino Tiempos muertos consciente por salto: establecimiento de conexión, tiempo de espera de cabecera y tiempo de espera de respuesta. Sólo activo reintentos para métodos idempotentes y los combino con backoff exponencial más jitter para evitar rebaños atronadores. Los disyuntores protegen los pools de backend: Si el proxy detecta picos de error o latencia, abre el circuito temporalmente, reenvía sólo al azar al destino afectado y, por lo demás, responde pronto, opcionalmente con fallback desde la caché. La detección de valores atípicos elimina automáticamente las instancias "débiles" del pool. También limito las subidas simultáneas, activo la reutilización de conexiones y utilizo colas con priorización justa. De este modo, los servicios permanecen estables aunque los componentes individuales se vean sometidos a presión.

Cumplimiento, protección de datos y protección de IPI

Trato el proxy como Centro de datos con normas claras de protección de datos. Enmascaro o seudonimizo los datos personales en los registros; las cadenas de consulta y las cabeceras sensibles sólo se registran en listas blancas. Siempre que es posible, acorto las direcciones IP y cumplo estrictos periodos de conservación. El acceso a los registros y métricas se basa en funciones y los cambios se documentan a prueba de auditorías. Para las auditorías, vinculo los eventos del gateway con las entradas de gestión de cambios, de modo que se puedan rastrear las aprobaciones y las actualizaciones de reglas. Esto me permite cumplir los requisitos de conformidad sin renunciar a una visión profunda del rendimiento y la seguridad.

API de Kubernetes, Ingress y Gateway

Integro el proxy inverso a la perfección en Orquestación de contenedores. En Kubernetes, utilizo controladores de entrada o la API de puerta de enlace más moderna para describir el enrutamiento, TLS y las políticas de forma declarativa. Traefik lee las etiquetas dinámicamente, NGINX/HAProxy ofrecen variantes de entrada sofisticadas para un alto rendimiento. Separo el enrutamiento este/oeste interno del clúster (malla de servicios) de la pasarela perimetral norte/sur para que las responsabilidades queden claras. Implemento liberaciones canarias con rutas ponderadas o coincidencias de cabecera, al tiempo que defino estrictamente las comprobaciones de salud y la preparación de los pods para evitar el flapping. Versiono las configuraciones como código y las pruebo en clústeres de ensayo con simulación de carga antes de ponerlas en marcha.

Madurez operativa: gestión de la configuración y CI/CD

Trato la configuración del proxy como Código. Los cambios se ejecutan mediante pull requests, se prueban automáticamente (sintaxis, linting, comprobaciones de seguridad) y se despliegan en pipelines. Utilizo previsualizaciones o tráfico en la sombra para validar nuevas rutas en condiciones reales sin arriesgar las transacciones de los clientes. Las reversiones son posibles en segundos porque etiqueto las versiones y las despliego atómicamente. Gestiono los secretos sensibles (certificados, claves) por separado, cifrados y con autorizaciones mínimas. Para lograr una alta disponibilidad, distribuyo las versiones a los nodos de forma escalonada y registro los efectos en cuadros de mando para poder tomar rápidamente contramedidas en caso de regresiones.

Tropiezos típicos y antipatrones

Evito Fuentes de errorque ocurren con frecuencia en la práctica. Evito el envenenamiento de la caché con una estricta normalización de encabezados y una gestión limpia de Vary; excluyo de la clave de caché las cookies que no afectan a la renderización. Reconozco los bucles de redirección desde el principio mediante pruebas con X-Forwarded-Proto/Host y políticas HSTS/CSP coherentes. "Confiar en todos los X-Forwarded-For" es tabú: sólo confío en el siguiente salto y establezco Real-IP limpiamente. Controlo las subidas grandes mediante límites y streaming para que el proxy no haga buffer, cosa que el backend puede hacer mejor. Con 0-RTT en TLS 1.3, presto atención a la idempotencia. Y vigilo los tamaños de cuerpo y cabecera para que las peticiones individuales no inmovilicen toda la capacidad del trabajador.

Resumen para decisiones rápidas

Apuesto por un Invertir proxy porque combina velocidad, protección y escalado en un solo lugar. El almacenamiento en caché, la descarga TLS y HTTP/2/3 aceleran significativamente los tiempos de carga reales. WAF, defensa DDoS y control IP/geo reducen notablemente los riesgos. El equilibrio de carga, las comprobaciones de estado y las versiones continuas mantienen los servicios disponibles, incluso durante el crecimiento. Con NGINX, Apache, HAProxy o Traefik, encuentro una solución clara para cada configuración y mantengo las operaciones gestionables.