Comparo HTTP/3 Push y Preload sobre la base de valores medidos reales y explico cuándo es más eficiente una tecnología u otra. Rendimiento de http3 notablemente hacia delante. Para ello, analizo las ventajas de QUIC, las prioridades de carga y los errores típicos de implementación que afectan a la Primera Pintura y a la Render frenos.

Puntos centrales

Resumo los siguientes puntos clave para que puedas elegir rápidamente entre empuje y precarga. clasificar puede.

- HTTP/3QUIC elimina el bloqueo en la cabecera de la línea y mantiene los flujos funcionando sin problemas en caso de pérdidas.

- EmpujeLa entrega proactiva ayuda con los activos básicos altamente probables, pero implica gastos generales.

- PrecargaDeclarable, controlable, de bajo riesgo con priorización de recursos críticos.

- Valores medidos: Las ventajas de HTTP/3 son claramente evidentes con la pérdida de paquetes y muchos activos.

- EstrategiaLa combinación de precarga y HTTP/3 suele dar los mejores resultados en la práctica.

Breve explicación de HTTP/3 Push y Preload

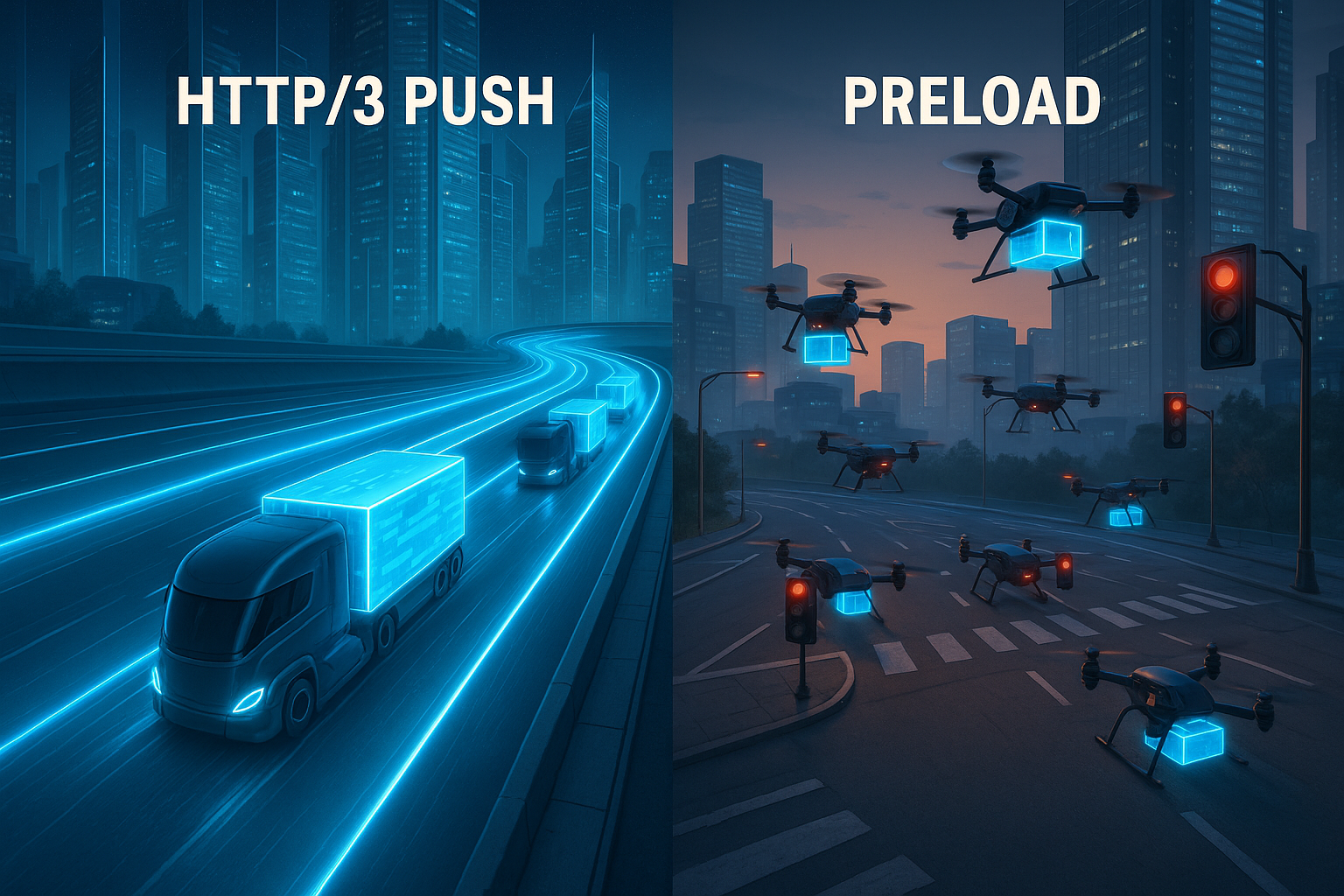

He puesto Servidor Push cuando el servidor entrega archivos antes de que el navegador los solicite, por ejemplo CSS, JS o fuentes web que se necesitan directamente para la renderización. Esta táctica coloca los recursos en la caché desde el principio, ahorra viajes de ida y vuelta y puede favorecer notablemente el First Contentful Paint. Precarga Por otro lado, utilizo etiquetas de enlace en el marcado para que el navegador sepa exactamente qué archivo debe cargar primero. Esto crea prioridades claras, reduce las transferencias duplicadas y funciona igual de bien con HTTP/1.1, HTTP/2 y HTTP/3. Dado que HTTP/3 se basa en QUIC, merece la pena echar un vistazo a la sección Protocolo QUIC, que trata los flujos por separado y evita así la congestión a nivel de línea.

Cómo influye HTTP/3 en el tiempo de carga

Con QUIC, HTTP/3 levanta el Cabecera de línea-bloqueo, lo que significa que las pérdidas de paquetes individuales ya no ralentizan la carga de todos los archivos. Múltiples flujos se ejecutan en paralelo, y las pérdidas sólo afectan al flujo afectado, lo que es especialmente útil con muchos activos. 0-RTT puede acelerar las conexiones si ya existe un historial, permitiendo que las primeras peticiones fluyan más rápido. El control de la potencia de transmisión y la corrección de errores también es adaptativo, lo que mantiene alta la velocidad de reloj bajo carga. Para los que aprecian las comparaciones directas, el HTTP/3 frente a HTTP/2 Comparación del rendimiento: perspectivas adicionales sobre la latencia y el comportamiento de la transferencia.

Empuje frente a precarga: Lógica de decisión

Utilizo Empuje, cuando es muy probable que un activo se necesite inmediatamente, como la hoja de estilo central o un script de sobrepliegue. En estos casos, la entrega proactiva puede suponer un ahorro de tiempo visible, especialmente en redes móviles. Sin embargo, si el archivo se envía aunque el cliente ya lo tenga en la caché o no lo necesite en absoluto, se desperdicia ancho de banda y se alargan las colas de datos realmente importantes. Precarga Lo utilizo cuando quiero controlar exactamente qué comienza con prioridad y cuándo el analizador debe ver la solicitud. Así mantengo el control en mis manos, evito transferencias duplicadas y minimizo los errores al seleccionar recursos.

Comparación de resultados en cifras

En entornos de medición con muchas descargas simultáneas, HTTP/3 sigue siendo significativamente más eficiente, con pérdidas notables de más de 8%. receptivo, mientras que HTTP/2 disminuye [4]. Con archivos de 1 MB y una pérdida de 2%, las pruebas mostraron tiempos de carga de alrededor de 1,8 segundos con HTTP/1 frente a 1,2 segundos con HTTP/3 [5]. Estas diferencias tienen un impacto directo en LCP, TTI y TBT, especialmente cuando una página solicita inicialmente muchos archivos independientes. En el caso de las aplicaciones de una sola página y las páginas multimedia, la separación de flujos resulta especialmente rentable, ya que un activo con problemas deja de retrasar a los demás. Yo siempre evalúo las cifras en el contexto de los tipos de recursos, las prioridades y las visitas a la caché, porque es ahí donde más se aprovechan las ventajas de la separación de flujos. Velocidad.

| Criterio | Push HTTP/3 | Precarga | Efecto sobre las métricas |

|---|---|---|---|

| Sistema de control | Del lado del servidor, proactivo | Del lado del cliente, declarativo | Empezar pronto y establecer prioridades claras |

| Riesgo de doble transferencia | Aumenta si la caché ya está llena | Baja, como se aborda con precisión | Influencia en el ancho de banda y la TBT |

| Carga de red/pérdida de paquetes | Pérdidas de búferes QUIC por flujo [4] | Beneficio a través del nivel de transporte HTTP/3 | Ventajas de LCP/INP bajo carga |

| Índice de aciertos de la caché | Los activos empujados pueden esfumarse | Uso selectivo de las cachés existentes | Reducción del tiempo de espera de los pacientes que regresan |

| Esfuerzo de aplicación | Lógica necesaria en el servidor | Ajustes de marcado en la cabeza | Beneficios rápidos con dependencias claras |

Estado del navegador 2025: Categorización realista de Push

A la hora de planificar, tengo en cuenta que muchos navegadores restringen mucho o ignoran por completo el push en la práctica. Esto se aplica en particular a escenarios en los que las transferencias dobles son inminentes o las cachés ya están llenas. En consecuencia, el push sigue siendo un arma especial para casos claramente definidos -como las visitas iniciales en conexiones nuevas- y no una panacea. En mis configuraciones, por tanto, calculo push como un refuerzo opcional y confío principalmente en la precarga y la priorización limpia a nivel de transporte. Cuando los clientes no utilizan push, recurro automáticamente a la precarga y a las alertas tempranas sin desestabilizar el canal. Esta sobria priorización evita decepciones y mantiene realista la hoja de ruta.

Pistas tempranas (103) y precarga en el equipo

En lugar de empujar a ciegas, envío las configuraciones correctas Primeras pistas (103) con Enlace: rel=preload antes del HTML propiamente dicho. Esto permite al navegador iniciar los archivos críticos mientras el servidor aún está renderizando la página. Esto reduce el tiempo hasta el primer byte de los activos y al mismo tiempo da el control al cliente. En la práctica, esto funciona de forma fiable con HTTP/3 y ofrece muchas de las ventajas del push, sin los riesgos de las transferencias dobles.

HTTP/1.1 103 Primeras pistas

Enlace: ; rel=preload; as=style; fetchpriority=high

Enlace: ; rel=modulepreload

HTTP/1.1 200 OK

...Utilizo Early Hints principalmente para el CSS principal, las fuentes web críticas y los módulos iniciales. Importante como-los tipos deben coincidir exactamente para que no se produzcan peticiones duplicadas. También me aseguro de que las especificaciones CORS y las cabeceras de caché estén configuradas correctamente. Esto me permite aprovechar la mayoría de las ventajas de un inicio temprano sin que el servidor adivine demasiado.

Control preciso de las prioridades: cabecera prioritaria y fetchpriority

Además de Preload, confío en Señales de prioridad en dos niveles:

- En HTML a través de

prioridad de búsqueda, Por ejemplo.fetchpriority="alta"para estilos o imágenes críticos en la ventana gráfica yfetchpriority="baja"para activos decorativos. - Sobre la respuesta mediante una cabecera de prioridad que proporciona al transporte información clara sobre qué respuestas deben priorizarse. Esto armoniza con HTTP/3 y reduce la carga en la línea cuando hay muchos flujos paralelos.

Así trabajan juntos el cliente y el servidor: El navegador toma rápidamente las decisiones correctas y el servidor las entrega con la ponderación adecuada. En combinación con QUIC, esto reduce la presión sobre los cuellos de botella y evita que archivos sin importancia bloqueen la ruta crítica.

Especifique la precarga con precisión

Muchos problemas con la precarga se deben a pequeñas incoherencias. Yo las evito con un marcado limpio y explícito:

Compruebo constantemente que el como-corresponden a los tipos de recursos reales. Para las fuentes crossorigin Obligatorio, de lo contrario se corre el riesgo de descargas dobles. Para los scripts presto atención al modo (type="módulo" vs. clásico) y fijar aplazar, para que el analizador sintáctico no se bloquee. Veo la precarga como un complemento a la ruta de renderizado, no como un sustituto; la integración regular sigue siendo necesaria.

Detalles QUIC que cuentan en la práctica

Planifico HTTP/3 con vistas a las propiedades que se aprecian sobre el terreno:

- Migración de conexionesSi un dispositivo cambia de WLAN a radio móvil, se mantiene la conexión QUIC. Esto evita nuevos apretones de manos y protege las transferencias largas de ser canceladas.

- QPACKCompresión de cabeceras sin riesgo de cabeceras globales. Esto acelera las páginas con muchas peticiones pequeñas, especialmente en CDN con muchas cabeceras recurrentes.

- 0-RTTSólo permito solicitudes aceleradas tempranas para recursos idempotentes y evalúo la situación de seguridad. Cuando 0-RTT surte efecto, gano un tiempo notable durante el arranque en caliente.

- Control de congestión adaptativoEl rendimiento se mantiene más estable en redes con pérdidas. Junto con la priorización, esto se traduce en un comportamiento sólido cuando importa.

Estas características sólo tienen pleno efecto con una configuración limpia del servidor y la CDN. Garantizo TLS 1.3, cadenas de certificados cortas, información de estado de apilamiento y fallbacks coherentes para que los clientes más antiguos también puedan ser atendidos con un alto rendimiento.

Utilizar correctamente la priorización de recursos

Defino Activos básicos claramente: el CSS crítico, las fuentes para el texto visible y los scripts que afectan a la zona por encima del pliegue. A estos archivos se les da la máxima prioridad mediante precarga o se empujan en casos especiales. Los archivos de imagen para el contenido que será visible más tarde tienen una prioridad más baja o se mueven hacia arriba a través de la carga lenta para que la ruta de renderizado y la interacción estén disponibles antes. En el caso de los recursos de terceros, sopeso cuidadosamente las ventajas y, si es necesario, establezco la preconexión para que los apretones de manos comiencen a tiempo. Esto deja la línea libre para los datos realmente importantes y evito que los activos deco bloqueen el inicio.

En la práctica, me atengo a una breve rutina de toma de decisiones:

- Es el activo crítico para FCP/LCP y casi siempre necesario? → Precarga, sugerencias tempranas opcionales; empuje selectivo solo si es mensurablemente superior.

- El uso es variable o depende del usuario? → No push; como mucho precarga según heurística probada o carga descendente.

- Es grande el activo? → Prefiera la precarga; empuje solo si el ancho de banda está asegurado y las visitas a la caché son improbables.

- Existen alternativas como el CSS crítico en línea o la división del código? → Preferible; acortan las rutas y reducen el riesgo general.

Aplicación: Lista de control de la práctica

Empiezo con un Auditoría de la página de inicio y las plantillas más importantes y selecciono todos los archivos necesarios para la primera zona visible. A continuación, creo entradas de precarga en la cabecera, pruebo las prioridades y compruebo si se producen solicitudes duplicadas. Cuando una transferencia anticipada merece mucho la pena, considero el push selectivo y mido el efecto sobre LCP y TTI. Para QUIC/HTTP-3, activo el soporte en la CDN o el servidor y comparo las reglas de priorización con las rutas críticas. Para la ayuda paso a paso, utilizo un práctico Implementación de HTTP/3, para que la configuración, las pruebas y el despliegue se realicen de forma estructurada.

También establezco las siguientes rutinas:

- Primeras pistas y alimentarlo con las mismas entradas de enlace que la cabeza HTML final.

- Estrategia de caché con versionado:

app.abcdef.css, largomax-age,inmutable, para que los clientes habituales se beneficien. - Trabajador de servicios precargar los flujos para que no se duplique el trabajo en la red y en la caché de SW.

- Cabecera prioritaria en el Origen/CDN para que HTTP/3 favorezca las respuestas realmente importantes.

- Banderas de características para push/preload para realizar pruebas A/B de forma rápida y sin riesgos.

Errores típicos y cómo evitarlos

No empujo Activos, que el navegador pueda tener ya en su caché, ya que esto desperdicia ancho de banda. En su lugar, compruebo las cabeceras de la caché, el versionado y la validez, para que los usuarios que regresan se beneficien de nuevas visitas. No sobrecargo Preload, porque una docena de entradas críticas pueden atascar la línea y diluir las prioridades. En cuanto a las fuentes, presto atención a los formatos adecuados y a los rangos unicode para que la transferencia sea ágil y el texto visible aparezca rápidamente. También hago pruebas en distintos dispositivos y redes inalámbricas, porque el verdadero efecto sólo se hace visible en condiciones reales.

Le he echado el ojo a estas trampas en particular:

- Desajuste entre

comoy el tipo de recurso (por ejemplo.as="script"para módulos) → da lugar a requisitos secundarios innecesarios. - Falta crossorigin para fuentes → descargas dobles o errores de bloqueo.

- Listas de precarga demasiado anchas → socavar las prioridades; me limito a los activos básicos.

- Funciones poco claras de Inline-Critical-CSS vs. Preload → Decido por página y evito formas mixtas que carguen en ambos sentidos.

- Empujar a ciegas sin conocimiento de caché → Push sigue siendo una apuesta; mido y aseguro con Early Hints.

Métodos de seguimiento y medición

Mido LCP, TTI, TBT e INP con Lighthouse, añadir datos en tiempo de ejecución a través de RUM y comparar variantes mediante pruebas A/B. WebPageTest o herramientas similares me ayudan a analizar diagramas de cascada y a reconocer si la precarga y el push funcionan según lo previsto. La combinación de datos de laboratorio y de campo muestra si las optimizaciones son viables o generan efectos secundarios. Compruebo regularmente cómo gestionan los navegadores el push del servidor, ya que algunos agentes de usuario restringen o ignoran los activos push [8]. Basándome en estos datos, decido qué tecnología seguir desplegando y cuál retirar.

Diferencio por declaraciones fiables:

- Frío frente a calorAnalizar la primera visita sin caché separadamente de las visitas de retorno.

- Perfiles de redSimule 4G/5G con pérdidas realistas, escenarios de alta RTT y células muy utilizadas.

- Número de solicitudes: Visualiza por separado las páginas con pocos archivos grandes frente a las que tienen muchos archivos pequeños.

- Combinación de dispositivosDispositivos móviles de gama media con una CPU más débil, porque los costes de análisis y descompresión pesan más allí.

Documento cada experimento con exactitud: versiones de compilación, entradas de precarga, cabeceras prioritarias, reglas de inserción, estado de las sugerencias tempranas. Esto me permite reproducir los efectos y revertirlos rápidamente si es necesario.

Alojamiento e infraestructura como palanca

Presto atención a Servidor con soporte HTTP/3 actualizado, una sólida configuración TLS y una priorización limpia. Una CDN de alto rendimiento con buena cobertura PoP reduce las latencias para los usuarios móviles y hace que los beneficios de QUIC sean más tangibles. La configuración limpia de las fallbacks TCP para clientes antiguos también juega un papel importante para que nadie salga perjudicado. Para los presupuestos, calculo primero el efecto, ya que los más pequeños ajustes de CDN o activaciones de HTTP/3 suelen ser suficientes sin elevados costes adicionales en el rango bajo de los dos dígitos de euros al mes. Cuanto más sólida sea la base, más claros serán los efectos del push y la precarga en el día a día.

También compruebo si la infraestructura soporta los siguientes puntos:

- Primeras pistas del Edge para que las precargas comiencen antes que el HTML.

- Priorización ampliable o cabeceras de prioridad que son respetadas por el proxy.

- Normas precisas por ruta/tipo de archivo para empujar sólo los activos seleccionados o para resaltarlos mediante precarga.

- Métricas transparentes a nivel de borde (tasa de aciertos, RTT, pérdidas, repriorización) para hacer visibles las causas de las desviaciones.

Clasificación final

Ya veo. HTTP/3 con QUIC tiene una ventaja en cuanto las redes inalámbricas, muchos flujos paralelos o situaciones de pérdida entran en juego [4][5]. En configuraciones controladas, la precarga proporciona una priorización fiable porque especifico exactamente lo que realmente debe ejecutarse primero. Utilizo el push específicamente para los recursos indispensables cuyo beneficio es constante y cuyo tamaño se mantiene dentro de unos límites. Logro el mejor efecto cuando combino precarga para las prioridades, HTTP/3 para el transporte y push cuidadosamente dosificado. Si se procede de este modo, se reducen notablemente los tiempos de carga, se protege el ancho de banda del usuario y se aumenta significativamente la calidad percibida de la página.