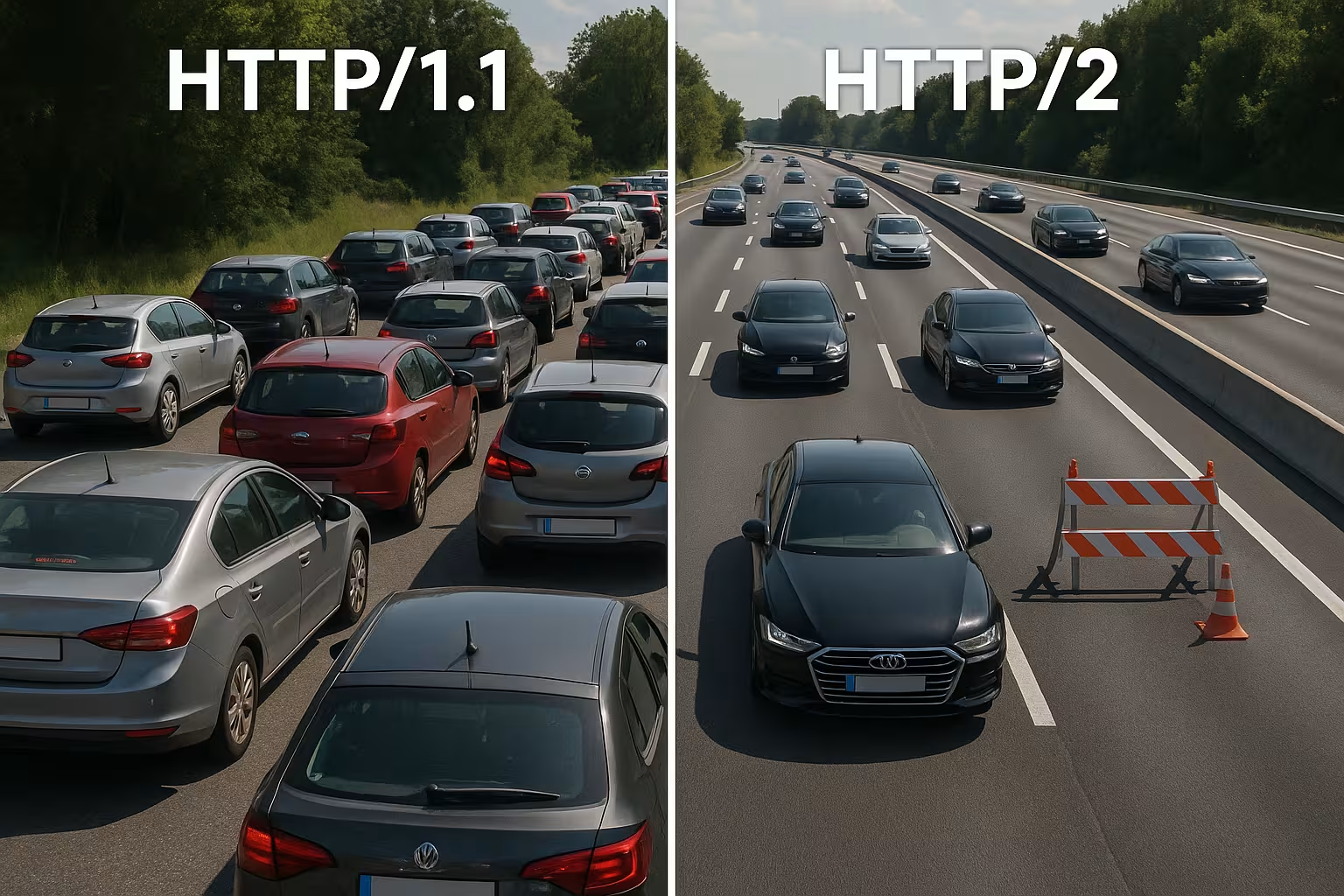

Multiplexación HTTP/2 agrupa muchas solicitudes en una única conexión y elimina los bloqueos a nivel de protocolo. Sin embargo, en redes reales, el TCP Head-of-Line, la sobrecarga TLS y la priorización deficiente ralentizan el proceso, por lo que HTTP/2 no funciona automáticamente más rápido que HTTP/1.1.

Puntos centrales

- Multiplexación Paraleliza muchas solicitudes a través de una única conexión TCP.

- TCP-HoL permanece activo y detiene todas las transmisiones en caso de pérdidas.

- Configuración TLS puede retrasar notablemente el tiempo hasta el primer byte.

- Prioridades y Server Push solo funcionan con una configuración limpia.

- Tipo de página decide: muchos archivos pequeños frente a pocos archivos grandes.

Cómo funciona internamente la multiplexación HTTP/2

Desgloso cada respuesta en pequeñas partes. Marcos, los numero y los asigno a flujos lógicos para que varios recursos se ejecuten simultáneamente a través de una única conexión. De este modo, evito bloqueos a nivel HTTP, ya que ninguna solicitud tiene que esperar a que termine otra. Los navegadores envían HTML, CSS, JS, imágenes y fuentes en paralelo y reducen el coste de las conexiones adicionales. HPACK reduce los encabezados, lo que disminuye considerablemente la carga cuando hay muchos archivos pequeños. Sin embargo, lo decisivo sigue siendo que todas las secuencias comparten la misma línea TCP, lo que crea ventajas, pero también nuevas dependencias. Esta arquitectura proporciona velocidad siempre que la red se mantenga estable y la Priorización funciona de manera sensata.

HTTP/1.1 frente a HTTP/2: diferencias fundamentales

HTTP/1.1 se basa en mensajes de texto y varias conexiones paralelas por host para cargar recursos simultáneamente, lo que aumenta los handshakes y la sobrecarga. HTTP/2 funciona de forma binaria, utiliza una única conexión para todo y comprime los encabezados, lo que reduce los tiempos de espera, especialmente cuando hay muchos objetos. En los diagramas de cascada, las largas colas desaparecen porque los flujos avanzan en paralelo. A cambio, el cuello de botella se desplaza de la capa HTTP a la capa TCP, lo que noto claramente en redes inestables. Las páginas pequeñas con mucho caché a menudo apenas registran ventajas con respecto a la versión 1.1, mientras que las páginas grandes y ricas en activos se benefician de forma más visible. Estas diferencias conforman mi Estrategia de optimización y justifican una decisión específica para el proyecto.

Seleccionar correctamente el control de flujo y el tamaño de las ventanas

HTTP/2 incorpora su propio control de flujo por flujo y por conexión. Presto atención a los valores razonables para TAMAÑO INICIAL DE LA VENTANA y el número de transmisiones simultáneas, para que la línea no se sature ni se infrautilice. Las ventanas demasiado pequeñas generan un número innecesario de ACTUALIZACIÓN DE VENTANALos marcos y reducen la velocidad de datos, las ventanas demasiado grandes pueden sobrecargar a los clientes más débiles. En redes con un alto producto de retraso de ancho de banda (BDP), aumento el tamaño de la ventana de forma específica para que las respuestas grandes no se queden atascadas en el stop-and-go. Al mismo tiempo, limito MAX_CONCURRENT_STREAMS Pragmático: suficiente paralelismo para los elementos críticos del renderizado, pero no tanto como para que los detalles menores ralenticen la imagen LCP. Estos ajustes son pequeños, pero su efecto en los tiempos de carga reales es grande si se adaptan al sitio y a la red.

Reevaluar el fragmentado y agrupado de dominios

Muchas optimizaciones 1.1 son contraproducentes con HTTP/2. Elimino el antiguo fragmentado de dominios, porque una única conexión bien utilizada es más eficiente que los sockets distribuidos artificialmente. También cuestiono la agrupación agresiva de JavaScript en megarchivos: los paquetes más pequeños y separados lógicamente permiten cachés específicas y evitan que, en caso de cambio, sea necesario volver a transferir toda la aplicación. Los sprites de imágenes están perdiendo importancia porque las solicitudes paralelas se han abaratado y los formatos de imagen modernos, junto con el almacenamiento en caché, funcionan mejor. Por lo tanto, elimino lo que se puede multiplexar y solo agrupo cuando realmente simplifica la arquitectura o aumenta de forma apreciable la tasa de aciertos del almacenamiento en caché.

Coalescencia de conexiones y certificados

HTTP/2 permite a los navegadores utilizar una conexión para varios nombres de host si los certificados y el DNS coinciden. Planifico las entradas SAN y SNI de manera que sea posible la fusión y se eliminen los handshakes adicionales. Si ALPN y Cipher Suites coinciden, el cliente puede CSS de cdn.ejemplo.com y fotos de static.example.com a través de la misma línea. Esto ahorra RTT, simplifica la priorización y aumenta la probabilidad de que los activos críticos lleguen sin desvíos. Compruebo estos efectos específicamente en la pestaña Red: ¿se utiliza realmente solo un socket, o los límites de los certificados y las políticas obligan al navegador a establecer nuevas conexiones?

Por qué se frena la multiplexación: TCP Head-of-Line

Si se pierde un paquete en la única conexión TCP, toda la línea espera hasta que llega la retransmisión, lo que detiene temporalmente todos los flujos HTTP/2. Por lo tanto, en redes móviles con latencia variable y mayor tasa de pérdida, veo regularmente ganancias menores o incluso desventajas en comparación con varias conexiones 1.1. Este efecto explica por qué la multiplexación brilla sobre el papel, pero no siempre funciona en la práctica. Las mediciones de la investigación y el campo muestran exactamente esta relación en redes reales [6]. Por lo tanto, planifico las implementaciones de forma conservadora, realizo pruebas en rutas de usuario típicas y compruebo los efectos para cada grupo objetivo. Quien ignora TCP-HoL, desperdicia Actuación e incluso puede prolongar los tiempos de carga.

Protocolo TLS, TTFB y tipo de página

HTTP/2 funciona en la web casi exclusivamente a través de TLS, lo que genera handshakes adicionales y puede prolongar notablemente el tiempo hasta el primer byte en el caso de pocos activos. Si solo entrego un archivo grande, la ventaja de la multiplexación se esfuma, ya que no es necesaria una transmisión paralela. Las páginas con entre diez y veinte archivos pequeños se benefician más, mientras que las respuestas de un solo activo suelen estar a la altura de HTTP/1.1. Reduzco la sobrecarga con TLS 1.3, la reanudación de sesión y un keep-alive limpio, de modo que no sea necesario volver a conectarse y la línea esté realmente activa. Para el control preciso, apuesto por Ajuste de Keep Alive, para ajustar la reutilización, los tiempos de inactividad y los límites de acuerdo con la carga. De este modo, se reduce la proporción de handshake y la TTFB Se estabiliza incluso en picos de tráfico.

CDN y cadenas proxy: h2 hasta el origen

Muchas pilas terminan TLS en el borde y continúan comunicándose con el origen. Compruebo si también se utiliza HTTP/2 entre CDN y backend o si se produce una caída a HTTP/1.1. Los proxies de almacenamiento en búfer pueden anular parcialmente las ventajas (compresión de encabezados, priorización) si reserializan las respuestas o cambian el orden. Por lo tanto, optimizo de extremo a extremo: el nodo periférico, el proxy intermedio y el origen deben comprender h2, utilizar tamaños de ventana adecuados y no ignorar las prioridades. Cuando h2c (HTTP/2 sin TLS en la red interna) tiene sentido, compruebo si ahorra latencia y CPU sin infringir las políticas de seguridad. Solo una cadena coherente despliega el MultiplexaciónEfecto completo.

Usar correctamente la priorización

Clasifico los recursos críticos para que HTML, CSS y la imagen LCP lleguen primero y se eliminen los bloqueos de renderizado. Sin prioridades claras, los scripts menos importantes consumen un ancho de banda valioso, mientras que el contenido «above the fold» queda en espera. No todos los servidores respetan correctamente las prioridades del navegador y algunos proxies cambian el orden, por lo que evalúo los datos de resultados en lugar de las ilusiones [8]. Los encabezados de precarga y una referencia de imagen colocada temprano acortan las rutas de carga y aumentan la tasa de aciertos en la caché. La priorización no es mágica, pero dirige la conexión de manera que los usuarios vean rápidamente lo que necesitan. Las reglas claras aportan un notable Empuje y hacen que la multiplexación sea realmente eficaz.

Priorización en la práctica: prioridades extensibles

Los navegadores han perfeccionado sus modelos de priorización. Tengo en cuenta que los clientes modernos suelen utilizar „prioridades extensibles“ en lugar de pesos de árbol rígidos. De este modo, señalan la urgencia y los parámetros progresivos por flujo, que los servidores deben interpretar y traducir a programadores justos. Compruebo si mi servidor respeta estas señales o se basa en el comportamiento antiguo. En las pruebas A/B, comparo las rutas de carga con y sin priorización del lado del servidor para detectar efectos de desplazamiento. Importante: la priorización debe dar preferencia a lo que es crítico para el renderizado, pero no debe provocar la saturación de las descargas de larga duración. Una combinación cuidadosa evita los picos y mantiene libre el canal para el contenido visible.

Server Push: rara vez la abreviatura

Solo utilizo Server Push de forma selectiva, ya que el over-pushing ocupa ancho de banda e ignora las cachés del navegador. Si se empuja un recurso ya almacenado en caché, la ruta se ralentiza en lugar de acelerarse. Muchos equipos han vuelto a desactivar Push y funcionan de forma mucho más fiable con Preload [8]. En casos especiales, como en rutas recurrentes con patrones claros, el push puede ser útil, pero demuestro el efecto con valores medidos. Sin pruebas, elimino el push y mantengo el canal libre para los datos que realmente se necesitan. En este caso, menos es a menudo más. más, justo en la única conexión.

Comparación práctica: cuándo HTTP/1.1 puede ser más rápido

Considero que HTTP/1.1 es competitivo cuando predominan unos pocos archivos de gran tamaño o cuando las redes funcionan con pérdidas más elevadas. En ese caso, varias conexiones separadas distribuyen el riesgo y pueden acortar los tiempos de primer byte individuales. En páginas muy pequeñas, los handshakes TLS adicionales suelen compensar por completo las ventajas de la multiplexación. Por el contrario, con muchos objetos pequeños, HTTP/2 destaca gracias a la compresión, la priorización y un único socket. La siguiente descripción general muestra patrones típicos de auditorías y pruebas de campo que guían mi elección del protocolo [6][8]. Esta tabla no sustituye a las pruebas, pero proporciona una base sólida. Orientación para las primeras decisiones.

| Escenario | Mejor protocolo | Razón |

|---|---|---|

| Muchos activos pequeños (CSS/JS/imágenes/fuentes) | HTTP/2 | La multiplexación y HPACK reducen la sobrecarga, basta con una conexión |

| Pocos archivos, pero muy grandes | HTTP/1.1 ≈ HTTP/2 | Apenas se necesita paralelismo; los costes de handshake tienen más peso. |

| Redes móviles inestables con pérdidas | HTTP/1.1 parcialmente mejor | TCP-HoL detiene todas las transmisiones en HTTP/2; varios sockets pueden ayudar. |

| TLS optimizado (1.3, reanudación), prioridades claras | HTTP/2 | Menor configuración, control específico del ancho de banda |

| Over-Pushing activo | HTTP/1.1/HTTP/2 sin push | Los datos innecesarios bloquean la línea; la precarga es más segura. |

Mejores prácticas para obtener ganancias reales en el tiempo de carga

Reduzco los bytes antes del protocolo: imágenes en WebP/AVIF, tamaños adecuados, scripts económicos y encabezados de caché limpios. Mantengo pequeñas las partes críticas de la ruta CSS, cargo las fuentes temprano y establezco alternativas para evitar cambios en el diseño. Para el establecimiento de la conexión y el DNS utilizo Preconexión y precarga de DNS, para que los handshakes se inicien antes de que el analizador llegue al recurso. Brotli para contenidos de texto acelera las recuperaciones recurrentes, especialmente a través de CDN. Controlo los efectos en la cascada y comparo LCP, FID y TTFB antes y después de los cambios. Los valores medidos guían mi Prioridades, pero no la intuición.

gRPC, SSE y casos de streaming

HTTP/2 muestra sus puntos fuertes especialmente con gRPC y otros flujos bidireccionales o de larga duración. Presto atención a los tiempos de espera, los tamaños de búfer y las reglas de congestión para que un flujo lento no perjudique al resto de solicitudes. Para los eventos enviados por el servidor y las transmisiones en directo, es útil disponer de una conexión estable y duradera, siempre que el servidor gestione correctamente las prioridades y los límites de keep-alive no se activen demasiado pronto. Al mismo tiempo, compruebo cómo se comportan los casos de error: la reconstrucción de flujos, el retroceso exponencial y los límites razonables para las reconexiones evitan picos de carga cuando muchos clientes se desconectan y se vuelven a conectar al mismo tiempo. De este modo, los escenarios en tiempo real siguen siendo predecibles.

Ajuste del sistema operativo y TCP para un rendimiento de multiplexación estable

La elección del protocolo no compensa una configuración de red deficiente. Compruebo los algoritmos de control de congestión (por ejemplo, BBR frente a CUBIC), los búferes de socket, las políticas TCP Fast Open y el tamaño de la ventana de congestión inicial. Un control de congestión adecuado a la ruta puede reducir las retransmisiones y mitigar los efectos HoL. Igualmente importante: valores MTU/MSS correctos para evitar la fragmentación y las pérdidas evitables. A nivel de TLS, prefiero cadenas de certificados cortas, OCSP stapling y certificados ECDSA, porque aceleran el handshake. En conjunto, estos ajustes proporcionan al multiplexing el necesario Subestructura, para que la priorización y la compresión de encabezados surtan efecto.

Estrategia de medición y KPI en el día a día

No me baso en valores medios, sino que miro el p75/p95 de las métricas, separadas por dispositivo, tipo de red y ubicación. Las pruebas sintéticas proporcionan valores básicos reproducibles, mientras que la monitorización de usuarios reales muestra la dispersión en el campo. Comparo cascadas de rutas clave, compruebo los primeros bytes de HTML, el orden de CSS/JS y la hora de llegada de la imagen LCP. Implanto los cambios como experimentos controlados y observo el TTFB, el LCP y las tasas de error en paralelo. Importante: elimino las prioridades que no aportan un beneficio medible. De este modo, la configuración se mantiene ágil e invierto en ajustes que, según las estadísticas, ahorran tiempo.

Tráfico de rastreadores y bots

Además de los usuarios, los rastreadores también se benefician de un HTTP/2 limpio. Activo h2 para los puntos finales relevantes y observo si los bots reutilizan la conexión y recuperan más páginas en el mismo tiempo. Las cascadas 301 innecesarias, las respuestas sin comprimir o los límites de keep-alive demasiado cortos consumen presupuesto de rastreo. Coordino las políticas para que la multiplexación también funcione aquí sin superar los límites del backend. Resultado: escaneos más eficientes y mayor estabilidad bajo carga.

HTTP/2, HTTP/3 y lo que viene después

HTTP/3 se basa en QUIC sobre UDP y resuelve el bloqueo TCP Head-of-Line, lo que ayuda notablemente en casos de movilidad y pérdidas [6]. El establecimiento de la conexión es más rápido y los bloqueos de flujo ya no afectan a todas las solicitudes al mismo tiempo. En flotas mixtas, HTTP/2 sigue siendo importante, pero yo activo HTTP/3 cuando los clientes y las CDN ya lo utilizan. Comparaciones detalladas como HTTP/3 frente a HTTP/2 me ayudan a planificar los lanzamientos por fases y adaptados al grupo objetivo. Mido por separado según la ubicación, el dispositivo y el tipo de red, para que los usuarios reales se beneficien. Así, utilizo protocolos para Tiempos de carga en situaciones cotidianas.

El alojamiento y la infraestructura como aceleradores

Los buenos protocolos no salvan una infraestructura débil, por lo que compruebo minuciosamente la ubicación, el peering, la CPU, la RAM y los límites de E/S. Un servidor web moderno, un número razonable de trabajadores y una capa de caché evitan que la única conexión termine en un cuello de botella. El uso estratégico de la CDN acorta el RTT y amortigua los picos de carga. Quienes prestan servicio a usuarios de toda Europa suelen beneficiarse más de las distancias cortas que del ajuste fino de los protocolos. Planifico la capacidad con reservas para que el tráfico de ráfagas no nos deje fuera de combate. Así es como se desarrolla el multiplexing. Posible fiable.

Reconocer rápidamente los patrones de error

Si HTTP/2 parece más lento de lo esperado, busco patrones típicos: una única transmisión larga que bloquea muchas pequeñas; prioridades que se ignoran; altas tasas de retransmisión en rutas móviles; o reanudación TLS que no funciona. A continuación, comparo HTTP/2 y HTTP/1.1 en condiciones idénticas, separo la influencia de la CDN del origen y observo el número de sockets, el número real de flujos y el orden de los primeros kilobytes. Si encuentro un cuello de botella, primero ajusto los fundamentos (bytes, almacenamiento en caché, handshakes) antes de perfeccionar el control de flujo o las prioridades. Este orden proporciona las mejoras más fiables.

Resumen práctico para tomar decisiones rápidas

Utilizo el multiplexing HTTP/2 cuando hay muchos objetos, se aplican prioridades y TLS está correctamente configurado. Cuando hay pocos archivos grandes o redes inestables, calculo ventajas mínimas y estoy atento a los resultados de la versión 1.1. Solo utilizo Server Push con evidencia, casi siempre Preload, y mantengo baja la sobrecarga mediante compresión, almacenamiento en caché y conexiones tempranas. Las mediciones con dispositivos y ubicaciones reales confirman mis suposiciones antes de implementar los cambios a gran escala [6][8]. Al final, lo que cuenta no es el número de protocolo, sino la velocidad perceptible para los usuarios reales. Quien proceda así, sacará el máximo partido de HTTP/2 de forma fiable. Velocidad y sienta las bases para HTTP/3.