J'explique le jargon de l'hébergement web autour de Métal nu, hyperviseur et Multi-locataire Concrète et pratique. Tu comprends ainsi immédiatement comment fonctionnent les modèles, en quoi ils diffèrent et quel choix correspond à tes objectifs, du projet individuel à la plateforme avec de nombreux utilisateurs.

Points centraux

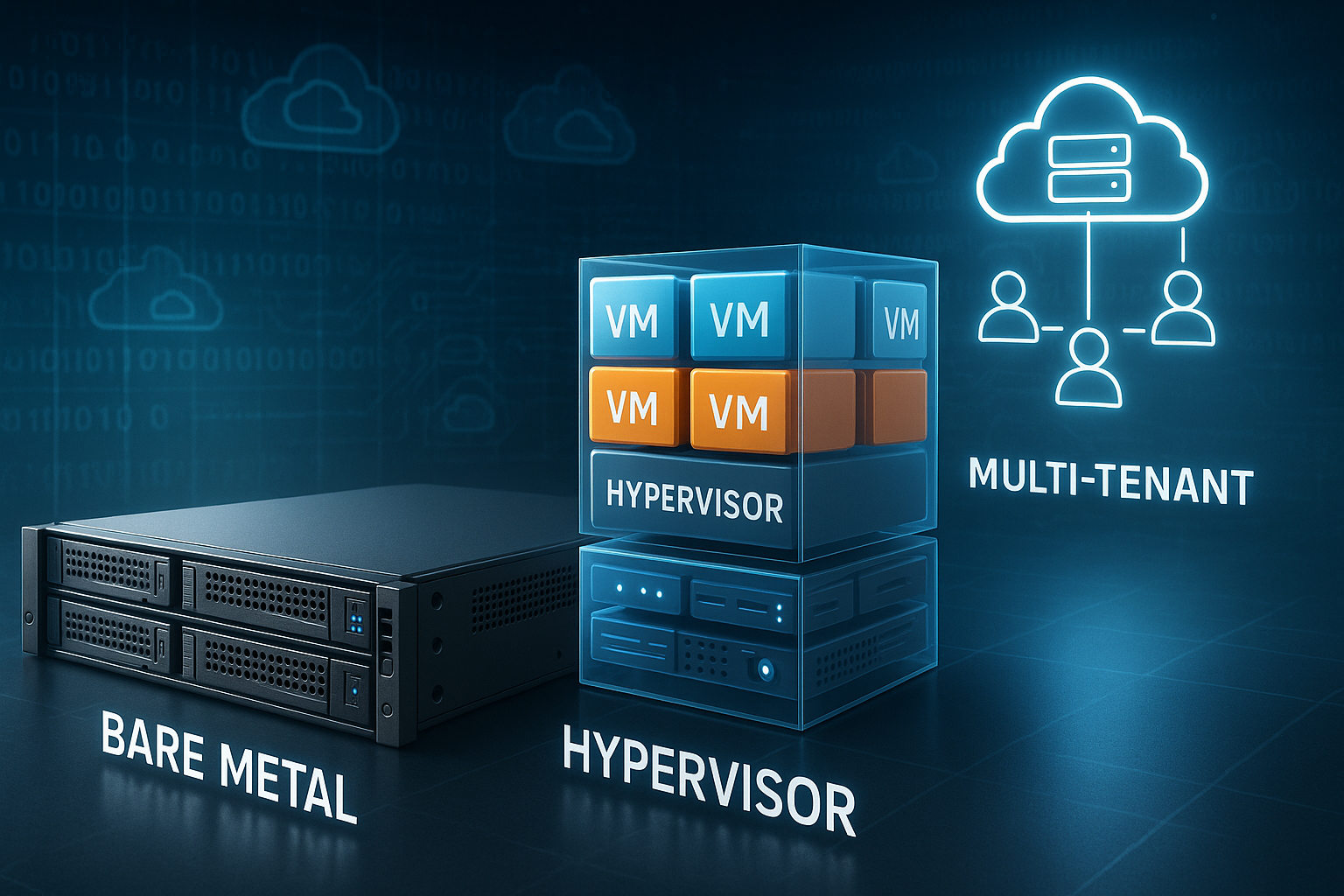

- Métal nu: contrôle total du matériel et performances maximales.

- hyperviseur: virtualisation avec isolation claire et flexibilité.

- Multi-locataire: utilisation efficace des ressources grâce à une séparation logique.

- Noisy Neighbor: gérer et prévenir efficacement les performances.

- Hybride: séparer les charges sensibles, mettre à l'échelle de manière élastique.

Le Bare Metal en bref

Métal nu signifie : un serveur physique vous appartient exclusivement. Vous ne partagez ni CPU, ni RAM, ni SSD avec d'autres utilisateurs. Je détermine moi-même le système d'exploitation, la configuration de stockage et les fonctions de sécurité. Je contrôle ainsi chaque couche, du BIOS au noyau. Pour les données sensibles et les pics de charge, Bare Metal offre les réserves les plus fiables et la latence la plus faible.

L'absence de voisins sur le même matériel est déterminante. Cela me permet d'éviter le Voisin bruyantEffet complet. Je planifie la capacité de manière réaliste et maintiens les performances à un niveau constant. Ceux qui viennent d'environnements partagés remarquent immédiatement la différence. Une comparaison permet de comprendre rapidement le concept : Hébergement mutualisé ou dédié ?.

Principes de base du matériel et des réseaux pour des plateformes résilientes

La base détermine la marge de manœuvre vers le haut. Je choisis des processeurs modernes avec suffisamment de cœurs et une puissance mono-thread élevée, ainsi que de la mémoire RAM ECC pour garantir l'intégrité. Pour les chemins de données, je mise sur des SSD NVMe à haute densité IOPS et je prévois des niveaux RAID dédiés ou des profils ZFS adaptés à la charge de travail. Les cartes réseau avec SR-IOV réduisent la surcharge et permettent des latences stables même avec un débit élevé. Le 25/40/100 GbE assure des réserves pour la réplication, le trafic de stockage et la communication est-ouest.

Avec Bare Metal, j'exploite directement les fonctionnalités matérielles. Dans les piles virtualisées, j'utilise le passthrough de manière ciblée : connexion directe NVMe, transfert SR-IOV-VFs vers les VM, CPU avec Fixation du processeur Dans un environnement multi-locataires, je limite délibérément ces privilèges afin de garantir l'équité et l'isolation. Une conception topologique bien pensée (Leaf-Spine, VLAN séparés, réseaux de gestion dédiés) évite les goulots d'étranglement et facilite le dépannage.

Hyperviseur : type 1 vs type 2 dans la pratique

A hyperviseur Il s'agit de la couche de virtualisation entre le matériel et les machines virtuelles. Le type 1 fonctionne directement sur la machine et minimise la surcharge. Le type 2 repose sur un système d'exploitation existant et convient bien aux tests. En production, j'utilise principalement le type 1, car l'isolation et l'efficacité sont importantes. Pour les configurations de laboratoire, j'utilise le type 2 en raison de sa facilité d'utilisation.

Le CPU pinning, la NUMA awareness et le stockage en cache sont importants. Ces paramètres me permettent de contrôler la latence et le débit. Les snapshots, la migration en direct et les fonctions HA réduisent considérablement les temps d'arrêt. Je choisis les fonctionnalités en fonction de la charge de travail, et non en fonction des termes marketing. Ainsi, la Virtualisation prévisible et performant.

Stratégies de stockage et disposition des données

Le stockage détermine la vitesse perçue. Je sépare les charges de travail en fonction du profil d'accès : les bases de données transactionnelles sur des pools NVMe rapides à faible latence, les tâches analytiques sur un stockage à large bande passante avec des performances séquentielles élevées. Mise en cache avec réécriture Je l'utilise uniquement avec des sauvegardes sur batterie/condensateur, sinon il y a un risque de perte de données. TRIM et des profondeurs de file d'attente correctes garantissent les performances à long terme des SSD.

Dans les environnements virtualisés, je choisis entre le stockage local (faible latence, mais HA délicat) et le stockage partagé (migration plus facile, mais saut de réseau). Des solutions telles que la réplication au niveau des blocs, Provisionnement fin avec une surveillance stricte et des niveaux de stockage séparés (chaud/tiède/froid) aident à équilibrer les coûts et les performances. Pour les sauvegardes, j'utilise des référentiels immuables et je teste régulièrement les restaurations, non seulement les sommes de contrôle, mais aussi les redémarrages réels des systèmes.

Le multi-tenant expliqué de manière compréhensible

Multi-locataire Cela signifie que de nombreux clients partagent la même infrastructure, mais restent logiquement séparés. Je segmente clairement les ressources et définis des quotas. Des limites de sécurité au niveau du réseau, de l'hyperviseur et des applications protègent les données. La surveillance contrôle la charge, les E/S et les modèles inhabituels. Je maîtrise ainsi les coûts et réagis avec souplesse aux pics.

La force réside dans la flexibilité. Je peux attribuer ou libérer des capacités rapidement. Les modèles de paiement à l'utilisation réduisent les coûts fixes et encouragent l'expérimentation. En même temps, je fixe des limites strictes contre les abus. Avec des Politiques évolutif, multi-locataires, sécurisé et prévisible.

Planification des ressources : gérer consciemment la surcharge

L'overcommit n'est pas un tabou, mais un outil. Je définis des limites claires : overcommit CPU modéré (par exemple 1:2 à 1:4, selon la charge de travail), RAM faible à inexistante (memory ballooning uniquement en cas de charge calculée), overcommit stockage avec télémétrie étroite. Pages géantes stabilisent les services gourmands en mémoire, Liaison NUMA empêche les latences cross-socket. Je considère le swap comme un airbag, pas comme un mode de conduite – les budgets RAM alloués doivent suffire.

- CPU : épinglez les cœurs critiques, réservez les cœurs hôtes pour les tâches de l'hyperviseur.

- RAM : utilisez les réservations et les limites, évitez le ballonnement incontrôlé.

- Stockage : planifiez les budgets IOPS par client et définissez le planificateur d'E/S en fonction du profil.

- Réseau : QoS par file d'attente, SR‑IOV pour la latence, chemins dédiés pour le stockage.

Voisin bruyant, isolation et performances tangibles

Je m'incline Voisin bruyant de manière ciblée. Les limites CPU, les plafonds E/S et la QoS réseau protègent les services contre les charges externes. Des pools de stockage dédiés séparent les données critiques en termes de latence. Des commutateurs virtuels et des pare-feu séparés excluent le trafic transversal. Je teste des scénarios à l'aide de générateurs de charge et mesure les effets sur le fonctionnement.

La transparence inspire confiance. J'utilise des indicateurs tels que la latence P95 et P99 plutôt que des valeurs moyennes. Les alertes réagissent aux fluctuations, et pas seulement aux pannes. Cela me permet de détecter les goulots d'étranglement à un stade précoce et d'intervenir. Les clients restent isolés, et les Expérience utilisateur reste constant.

Observabilité, tests et SLO fiables

Je mesure systématiquement : les métriques, les journaux et les traces convergent. Pour les services, j'utilise la méthode RED (taux, erreurs, durée), pour les plateformes, la méthode USE (utilisation, saturation, erreurs). Je définis les SLO pour chaque service, par exemple 99,9% avec une latence P95 inférieure à 150 ms, et je les associe à des alertes sur Error Budgets. Cela me permet d'éviter les alertes intempestives et de me concentrer sur l'impact utilisateur.

Avant toute modification, je réalise des tests de charge : baseline, stress, spike et soak. Je vérifie comment les latences se comportent en cas d'encombrement et où intervient la contre-pression. Expériences chaotiques Vérifiez au niveau du réseau, du stockage et des processus si l'auto-réparation et le basculement fonctionnent réellement. Des contrôles synthétiques effectués à partir de plusieurs régions permettent de détecter les erreurs DNS, TLS ou de routage avant que les utilisateurs ne les remarquent.

Comparaison : bare metal, virtualisation et multi-tenant

Je classe les modèles d'hébergement en fonction du contrôle, des performances, de la sécurité, de l'évolutivité et du prix. Ceux qui exigent un contrôle maximal opteront pour Métal nu. Si vous souhaitez rester flexible, optez pour la virtualisation de type 1. Pour les équipes dynamiques et les charges variables, le multi-tenant est la solution idéale. Le tableau suivant présente les différences en un coup d'œil.

| Critère | Métal nu | Virtualisé | Multi-locataire |

|---|---|---|---|

| contrôle des ressources | Exclusif, pleine souveraineté | Basé sur VM, contrôlable avec précision | Attribué côté logiciel |

| Performance | Très élevé, frais généraux minimes | Élevé, faible surcoût | Varie en fonction de la densité |

| Sécurité | Séparés physiquement | Isolé par hyperviseur | Séparation logique, politiques |

| Mise à l'échelle | Lié au matériel | Rapidement via les VM | Très flexible et rapide |

| Prix | Plus élevé, prévisible | Moyen, en fonction de l'utilisation | Bon marché à modéré |

| Missions typiques | Conformité, charge élevée | Polyvalent, développement/production | SaaS, projets dynamiques |

Je ne prends jamais de décision de manière isolée. Je tiens compte de l'architecture des applications, du savoir-faire de l'équipe et du budget. Les sauvegardes, les plans de reprise après sinistre et l'observabilité sont également pris en considération. Cela permet de garder le contrôle sur la plateforme et évolutif. Les coûts d'exploitation à long terme comptent tout autant que les loyers à court terme.

Modèles d'exploitation et automatisation

J'automatise dès le premier jour. Infrastructure as Code définit les réseaux, les hôtes, les politiques et les quotas. Images d'or et les lignes directrices signées réduisent les dérives. Les pipelines CI/CD créent des images reproductibles, renouvellent les certificats et lancent les déploiements Canary. Pour les tâches récurrentes, je planifie des fenêtres de maintenance, les annonce à l'avance et prépare des chemins de retour en arrière.

Je contrôle les dérives de configuration à l'aide d'audits périodiques et d'un état cible souhaité. Les modifications sont intégrées à la plateforme via des processus de changement – elles sont mineures, réversibles et observables. Je gère les secrets par version, avec rotation et jetons à courte durée de vie. Cela permet de garantir à la fois la rapidité et la sécurité des opérations.

Planifier les coûts, la mise à l'échelle et les SLA pour une utilisation quotidienne

Je ne tiens pas seulement compte du matériel, mais aussi de l'exploitation, des licences et de l'assistance. Pour le bare metal, je prévois une marge pour les pièces de rechange et les fenêtres de maintenance. Dans les environnements multi-locataires, je calcule la charge variable et les réserves possibles. Un SLA clair protège les objectifs en matière de disponibilité et de temps de réponse. Cela permet de maîtriser les coûts et Service dans le lot.

Je commence la mise à l'échelle de manière conservatrice. Je procède à une mise à l'échelle verticale tant que cela est judicieux, puis horizontale. La mise en cache, les CDN et le partitionnement des bases de données stabilisent les temps de réponse. Je mesure les effets avant le déploiement en phase de test. Ensuite, je définis les paramètres appropriés. Limites productif.

Planifier correctement la migration et minimiser le verrouillage

Je commence par dresser un inventaire : dépendances, volumes de données, exigences en matière de latence. Ensuite, je choisis entre Lift-and-shift (rapide, peu de modifications), Re-Plattform (nouvelle base, même application) et Refactoring (plus de travail, mais plus efficace à long terme). Je synchronise les données avec une réplication continue, un cutover final et des niveaux de repli clairs. Si nécessaire, je planifie les temps d'arrêt de manière brève et pendant la nuit, avec un runbook méticuleux.

Pour lutter contre la dépendance vis-à-vis d'un fournisseur, je mise sur des formats ouverts, des images standardisées et des couches réseau et stockage abstraites. Je prépare des plans de sortie : comment exporter les données ? Comment répliquer les identités ? Quelles étapes suivre et dans quel ordre ? La plateforme reste ainsi flexible, même si l'environnement change.

La gestion financière (FinOps) au quotidien

Je contrôle activement les coûts. Je fixe des objectifs d'utilisation par couche (par exemple, 60-70% CPU, 50-60% RAM, 40-50% Storage-IOPS), j'étiquette clairement les ressources et je crée de la transparence entre les équipes. Redimensionnement Je supprime les temps morts et n'utilise les réservations que lorsque la charge de base est stable. J'absorbe les pics de manière flexible. Le showback/chargeback incite les équipes à respecter les budgets et à demander des capacités de manière raisonnable.

Virtualisation ou conteneurs ?

Je compare les machines virtuelles à glanage selon la densité, le temps de démarrage et l'isolation. Les conteneurs démarrent plus rapidement et utilisent les ressources de manière plus efficace. Les VM offrent une séparation plus forte et des systèmes d'exploitation invités flexibles. Les formes mixtes sont courantes : conteneurs sur VM avec hyperviseur de type 1. Je vous en dis plus à ce sujet dans mon guide. Conteneurs ou VM.

L'objectif de l'application est important. Si elle nécessite des fonctions du noyau, j'utilise des machines virtuelles. Si elle nécessite de nombreuses instances éphémères, j'utilise des conteneurs. Je sécurise les deux environnements à l'aide de politiques d'image et de signatures. Je sépare les segments de réseau de manière très granulaire. Ainsi, les déploiements restent rapides et propre.

Utiliser judicieusement les modèles hybrides

Je sépare les données sensibles Métal nu et exploite des interfaces élastiques virtualisées ou dans un cluster multi-locataires. Je combine ainsi sécurité et agilité. Je gère les pics de trafic grâce à l'auto-scaling et aux caches. Je sécurise les flux de données à l'aide de sous-réseaux séparés et de liens cryptés. Cela réduit les risques et permet de maîtriser les coûts.

Une comparaison pratique permet de déterminer si le mélange est adapté, comme suit Métal nu vs. virtualisé. Je commence par définir des SLO clairs pour chaque service. Ensuite, je fixe des objectifs de capacité et des procédures d'escalade. Je teste le basculement de manière réaliste et régulière. Cela permet de maintenir l'interaction fiable.

Sécurité, conformité et surveillance à hauteur d'œil

Je traite Sécurité Non pas comme un complément, mais comme partie intégrante de l'exploitation. Le renforcement commence au niveau du BIOS et se termine au niveau du code. Je gère les secrets de manière centralisée et versionnée. Les réseaux Zero Trust, l'authentification multifactorielle (MFA) et les accès basés sur les rôles sont la norme. Les correctifs sont appliqués selon des cycles fixes avec des fenêtres de maintenance clairement définies.

Je mets en œuvre la conformité grâce à la journalisation, au traçage et aux pistes d'audit. Je collecte les journaux de manière centralisée et je corrèle les événements. Je classe les alertes par ordre de priorité en fonction du risque, et non de leur nombre. Des exercices d'entraînement permettent à l'équipe de rester réactive. La plateforme reste ainsi vérifiable et transparent.

Résidence des données, concepts de suppression et gestion des clés

Je définis clairement où les données peuvent être stockées et quels chemins elles peuvent emprunter. Chiffrement au repos et en transit sont standard, je gère les clés séparément du lieu de stockage. J'utilise des modèles BYOK/HYOK lorsqu'une séparation entre l'exploitant et le détenteur des données est requise. Des processus traçables s'appliquent aux suppressions : de la suppression logique à la destruction cryptographique, en passant par l'élimination physiquement sécurisée des supports de données. Je réponds ainsi aux exigences en matière de protection des données et de traçabilité.

Efficacité énergétique et durabilité

Je planifie en tenant compte de l'efficacité. Les processeurs modernes avec de bons rapports performance/watt, les configurations NVMe denses et les blocs d'alimentation efficaces réduisent la consommation. La consolidation apporte plus que les îlots : mieux vaut avoir peu d'hôtes bien utilisés que beaucoup d'hôtes à moitié vides. J'optimise le refroidissement et la circulation de l'air grâce à la disposition des racks et aux zones de température. La mesure est obligatoire : les mesures de puissance sont intégrées dans les modèles de capacité et de coûts. Cela me permet d'économiser de l'énergie sans sacrifier les performances.

Résumé : Utiliser le jargon de l'hébergement web avec assurance

J'utilise Métal nu, lorsque le contrôle total, les performances constantes et la séparation physique sont essentiels. Pour les projets flexibles, je mise sur la virtualisation basée sur un hyperviseur et la combine si nécessaire avec des conteneurs. Je choisis le multi-tenant lorsque l'élasticité et la rentabilité sont prioritaires et que l'isolation est bonne. L'hybride combine les points forts, sépare les parties sensibles et s'adapte de manière dynamique à la périphérie. Avec des mesures claires, l'automatisation et la discipline, le jargon de l'hébergement web n'est plus un obstacle, mais une boîte à outils pour des plateformes stables et rapides.