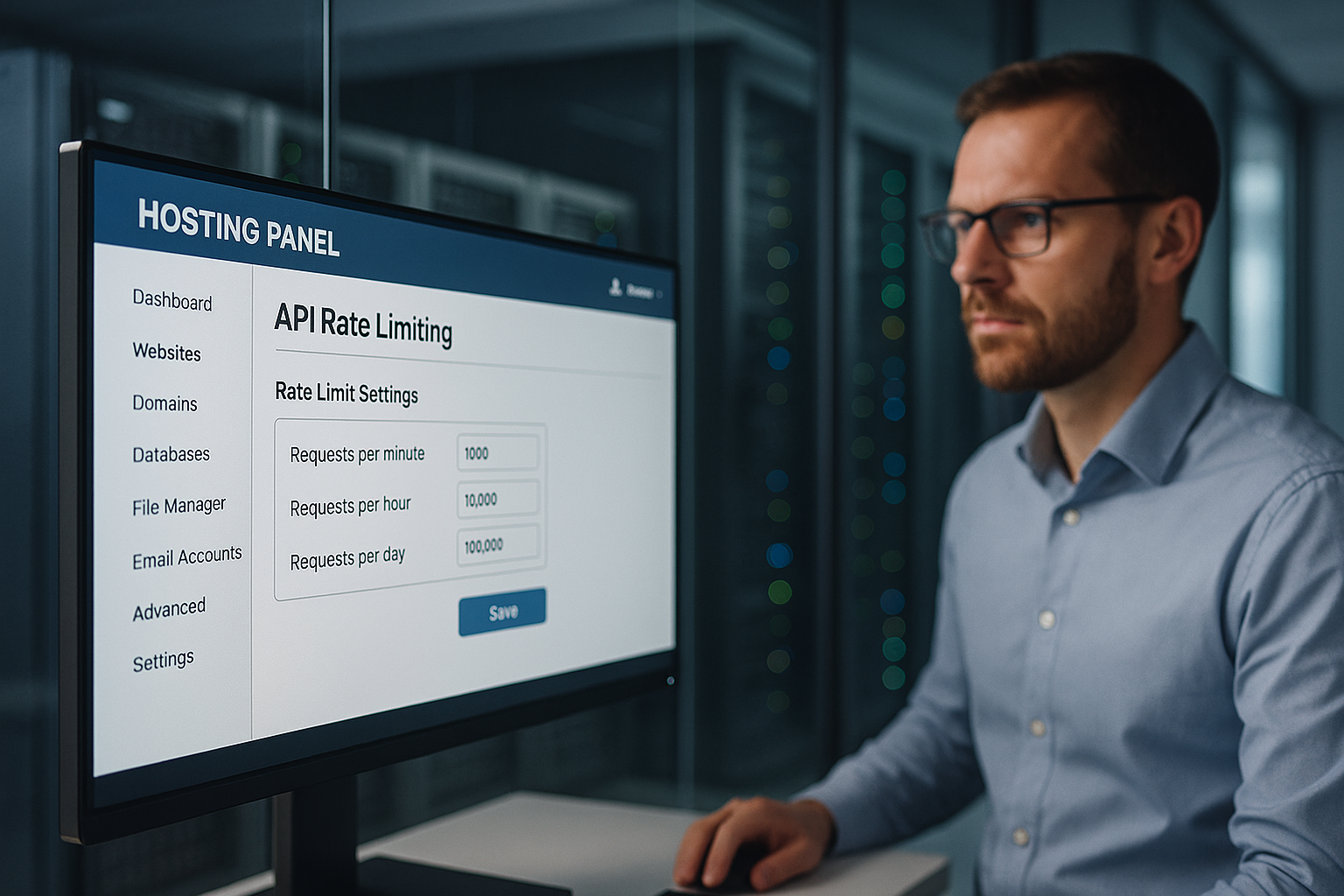

Limitation du taux d'API Hébergement protège un panel d'hébergement contre les abus en contrôlant strictement les taux de demande par IP, par clé API et par point de terminaison, évitant ainsi les pannes, les abus de données et les coûts inutiles. Je fixe des limites à plusieurs niveaux, je détecte les anomalies à un stade précoce et je sécurise les fonctions importantes pour le client telles que la connexion, la facturation et l'accès aux données contre les DDoS, le bourrage de crédits et les pics de charge injustes.

Points centraux

- Plusieurs couches Limites : globales, utilisateur, point final

- Algorithmes sélectionner : Token/Leaky/Fenêtre coulissante

- Transparent En-tête : Limit, Remaining, Reset

- Suivi en temps réel avec des alertes

- Fair échelonner : quotas par segment de clientèle

Pourquoi la limitation du taux d'API est indispensable dans le panneau d'hébergement

J'empêche, grâce à des limites claires, que Agresseur Bloquer les points de connexion ou de données avec des flots de requêtes. Ainsi, les opérations légitimes restent disponibles, tandis que je stoppe les abus et maintiens une faible latence. Toute surcharge sur les serveurs partagés coûte de l'argent et de la confiance, c'est pourquoi j'étrangle les demandes excessives à temps. J'évite l'escalade en ajustant les limites de manière dynamique avant que les capacités ne basculent. Les clients obtiennent des temps de réponse constants parce que j'impose des quotas équitables et que j'élimine les pics incontrôlés.

Comment fonctionne le Rate-Limiting : concepts et algorithmes

Je choisis l'algorithme approprié en fonction du profil de charge, de la criticité du point final et des pics attendus, car un bon procédé Abus arrête de manière fiable et autorise les bursts légitimes. Les méthodes de sliding-window lissent les limites dures, le token-bucket permet des bursts rapides de courte durée, le leaky-bucket maintient un écoulement régulier. Fixed-Window convient aux règles simples, mais peut sembler injuste sur les bords des fenêtres. Je combine les méthodes lorsque les points finaux varient fortement, par exemple connexion vs contenu statique. Je contrôle ainsi les flux sans blocage inutile.

| Algorithme | Utilisation typique | Avantage pour la sécurité |

|---|---|---|

| Fenêtre fixe | Modèle de quota simple | Prévisible Contingents |

| Fenêtre coulissante | Lissage plus précis | Moins de ruses de frontière |

| Token Bucket | Tolérant aux salves | Pointes flexibles |

| Leaky Bucket | Débit constant | Une évacuation propre |

Pour chaque point final, je documente le RPS visé, la taille de la rafale et la réaction en cas de non-respect, de sorte que Contrôle reste reproductible. Chaque règle est intégrée dans l'infrastructure sous forme de version, afin que les audits puissent clairement identifier quand telle ou telle limite est appliquée.

Limites à plusieurs niveaux : global, utilisateur, point final

Je fixe d'abord une limite globale qui Plate-forme comme un tout, afin qu'aucune application individuelle ne dévore la capacité. Ensuite, j'échelonne les quotas par client pour que les comptes premium obtiennent plus de débit sans évincer les autres. Enfin, je classe les points finaux : Auth, Paiement, Opérations d'écriture ; les points finaux de lecture sont plus généreux. En cas de violation des règles, je ne bloque pas aveuglément, mais j'augmente d'abord la latence ou je demande un backoff avant d'intervenir plus durement. Ainsi, l'expérience utilisateur reste équitable, tandis que les services critiques sont protégés.

Mesurer correctement les modèles de trafic

J'analyse les temps de pointe typiques, la répartition par point final et le taux d'erreur, car ces données Limites de l'utilisateur. Je distingue l'utilisation humaine des modèles automatisés par le biais de la densité IP, des agents utilisateurs et du comportement des jetons. Je reconnais les anomalies à l'augmentation soudaine des erreurs 401/403/429 ou à des temps de réponse erratiques. Je marque les anomalies et teste ensuite des règles plus strictes, d'abord en exécution à sec, afin d'éviter les fausses alertes. Ce n'est que lorsque le comportement est confirmé de manière stable que j'arme l'application.

Transparence pour les clients : En-têtes et messages d'erreur

Je communique les limites ouvertement, pour que Équipes intégrer de manière planifiable et ouvrir à temps. Dans chaque réponse, j'envoie les quotas pour que les développeurs puissent gérer leur utilisation. Des messages d'erreur clairs aident au lieu de frustrer. Voici un exemple que j'utilise :

Limite de X-RateLimit : 120

X-RateLimit-Remaining : 15

Réinitialisation de X-RateLimit : 1731187200

Retry-After : 30

Je garde les formats cohérents et je les décris dans la documentation API, afin qu'il n'y ait pas de trous d'interprétation et que les Intégration se déroule sans problème.

Limites et simultanéité basées sur les coûts et la complexité

Je ne limite pas seulement le taux de requêtes pur, mais aussi Complexité et la simultanéité : les chemins à forte intensité de calcul reçoivent des „coûts“ plus élevés que les simples lectures. J'attribue un score par requête (par ex. 1 pour les GET simples, 10 pour les grandes exportations) et j'effectue une sélection en fonction du coût total dans la fenêtre temporelle. En outre, je limite le nombre maximal de requêtes simultanées par clé afin de protéger les pools de backend. Les files d'attente avec un TTL court empêchent les foyers tonitruants, tandis que je partage équitablement via „max-in-flight“. En cas de surcharge, je désactive progressivement : d'abord la mise en cache de la réponse, puis l'étranglement de la lecture, enfin la mise en cache de l'écriture.

Application distribuée en clusters

Je fixe des limites à l'échelle du cluster afin qu'aucune instance ne devienne un contournement. Pour cela, j'utilise des compteurs centraux (comme Redis) avec des incréments atomiques, des TTL courts et un sharding par préfixe de clé afin d'éviter les points chauds. Je combine les compteurs à fenêtres coulissantes avec des structures probabilistes (par ex. compteurs Approx) pour les volumes très élevés. J'intercepte les skew d'horloge en synchronisant l'heure des passerelles et en calculant les temps de réinitialisation côté serveur. J'isole des segments dans des „cellules“ : chaque groupe de cellules fixe ses propres limites, de sorte qu'une panne reste locale. Fail-Closed pour les écritures critiques, Fail-Open pour les lectures non critiques - le service reste ainsi robuste.

Intégration Edge/CDN et quotas régionaux

J'empêche le trafic d'atteindre inutilement le backend en fixant des limites. au bord saisir : les règles proches du POP arrêtent les abus tôt, tandis que je définis des quotas régionaux par continent ou par pays. Ainsi, les utilisateurs proches restent rapides, même si des pics se produisent ailleurs. Les caches de bordure réduisent la pression sur les points finaux de lecture ; les requêtes conditionnelles (ETag/If-None-Match) réduisent la charge effective. Pour les API multirégionales, je synchronise les compteurs périodiquement et sur la base de tolérances, afin que les latences n'explosent pas.

Gestion des clients : Retries, Backoff et Idempotence

Je fais en sorte que les clients réussissent sans mettre en péril la plate-forme : Backoff exponentiel avec Jitter empêche les tempêtes synchrones ; les réponses 429 contiennent des indications claires et une valeur „Retry-After“. Pour les points de terminaison en écriture, j'exige des clés d'idempotence afin que les répétitions ne causent pas de dommages. J'utilise de manière cohérente un exemple de corps pour 429 :

{

"error" : "rate_limited",

"message" : "Trop de demandes. Veuillez réessayer après la réinitialisation ou après Retry-After",

"limit" : 120,

"remaining" : 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Je documente si „Retry-After“ contient des secondes ou une date, et je fixe des limites supérieures claires pour le nombre total d'entrées. Ainsi, les clients restent contrôlables et la plate-forme stable.

Intégration dans les passerelles et les équilibreurs de charge

Je déplace la limitation de débit le plus près possible du bord : la passerelle API d'abord, puis l'équilibreur de charge, puis la logique d'application, de sorte que coûteux Ne pas brûler les ressources du backend. Les passerelles offrent des plug-ins d'étranglement prêts à l'emploi, une gestion des en-têtes et des règles centralisées. Les équilibreurs de charge répartissent les charges et détectent rapidement les points chauds. L'application elle-même définit des contrôles fins par point final, y compris l'anti-replay et des contrôles plus stricts pour les mutations. Si l'on considère l'architecture en profondeur, on trouve chez Hébergement API-first des pistes de réflexion utiles pour des points d'application propres.

Défense contre les DDoS, la force brute et le credential stuffing

Je reconnais les modèles DDoS aux IP distribuées, aux chemins uniformes et aux pics sans réelle profondeur de session et je les freine avec durn quotas par IP et sous-réseau. J'arrête les attaques par force brute sur les identifiants avec des rafales rapprochées, une réactivation par captcha et des délais progressifs. Je démasque le Credential Stuffing grâce à des fuites connues, des séries de tentatives infructueuses et des empreintes digitales. Après un dépassement de seuil, je bloque temporairement et exige une vérification supplémentaire. Pour les ennemis automatisés, j'utilise des signaux Gestion des bots, Pour que les utilisateurs réels ne souffrent pas.

Équité et tiering : quotas par segment de clientèle

J'échelonne les quotas de manière transparente : Enterprise reçoit des budgets plus élevés, Starter des budgets plus faibles, pour que Coûts restent planifiables et que chacun ait un accès équitable. Exemple de ligne directrice : 5.000, 1.000 et 100 requêtes par minute pour Enterprise, Professional et Starter. Les chemins particulièrement sensibles comme /auth, /billing ou /write se situent en dessous, tandis que les points finaux de lecture restent plus généreux. Je vérifie chaque mois si les segments ou les limites doivent être adaptés, par exemple en cas de nouveau comportement des utilisateurs. Je garantis ainsi la croissance sans risquer la qualité de la plate-forme.

API en temps réel : WebSockets, SSE et streaming

Je ne limite pas seulement les requêtes HTTP, mais aussi Connexions et les taux de messages : Le nombre maximal de connexions WebSocket simultanées par compte, les messages par seconde et les limites d'octets par canal empêchent les clients Chatty. Je protège les diffusions avec des quotas de canaux et je sépare les événements système des événements utilisateur. Les intervalles Heartbeat et les délais d'attente limitent les connexions zombies. Pour SSE, je réduis les fréquences de reconnexion et j'utilise des lots d'événements compatibles avec le cache pour lisser les pics de charge.

Webhooks entrants et backpressure

Je sécurise les hôtes web entrants de services externes avec Tampons d'entrée, des limites dédiées et des coupe-circuits. En cas de surcharge, je réponds par 429/503, y compris „Retry-After“, et n'accepte que les livraisons signées et idempotente. J'isole le traitement Webhook dans des files d'attente pour ne pas bloquer les API de base et je fournis des rapports de livraison pour que les partenaires puissent ajuster proprement leurs stratégies de reprise.

Protection des données et conformité dans la télémétrie

Je ne consigne que ce qui est nécessaire : des hashs au lieu d'IP complètes, de courtes Rétention pour les logs bruts, une affectation claire pour les données d'audit et de facturation. Les événements de limite de taux contiennent des clés pseudonymisées ; je documente les délais de conservation et les droits d'accès. Ainsi, les exigences du RGPD sont respectées sans perdre la sécurité et la transparence.

Surveillance, alertes et plans de réaction

J'observe les volumes de demandes, les taux d'erreur et les latences dans de courtes fenêtres afin de pouvoir tôt reconnaître les schémas d'escalade. Je définis les alertes juste en dessous de la capacité afin de disposer d'une marge de manœuvre pour prendre des mesures. Lorsque le seuil de 95% tombe, je modifie les limites ou redistribue le trafic. En cas d'augmentation du taux de 5xx, je commence par rechercher les causes : déploiements défectueux, points chauds de la base de données, points de terminaison aberrants. Ensuite, je communique le statut et les solutions de contournement aux clients avant d'augmenter fortement les quotas.

Configuration, tests et déploiements sécurisés

Je gère les règles en tant que Code (versionning, review, CI checks) et déploie les modifications via les feature flags : d'abord le shadow mode (uniquement mesurer), puis le déploiement en pourcentage, enfin l'application complète. Les contrôles synthétiques vérifient les chemins d'accès 429, la cohérence des en-têtes et la logique "retry after". Des tests de chaos simulent des bursts, des fanouts de clés et des latences de redis, afin que le fonctionnement reste stable même en cas de stress. Je mets en liste blanche les clients système nécessaires (pipelines de construction, scanners de conformité) de manière étroite et limitée dans le temps afin de minimiser les fausses alertes.

empêcher les contournements : Bypass, key fanout et normalisation

Je comble les lacunes qui permettraient aux pirates de contourner les limites : Key-Fanout (des milliers de clés à usage unique), je les limite avec des quotas supérieurs par compte, organisation et IP/sous-réseau. Je normalise les chemins (majuscules/minuscules, Unicode, routes alias) afin que des points finaux identiques ne soient pas comptés plusieurs fois. Je corrige les signaux (IP, ASN, empreinte digitale de l'appareil, session, origine du jeton) afin que les rotations IP rapides ne conduisent pas à des budgets infinis. Pour les chemins particulièrement sensibles, je demande des Auth plus forts (mTLS/OAuth-Scope).

Facturer équitablement la surutilisation

Je crée Planification, Je propose des modèles de dépassement optionnels : contingents supplémentaires réservables à l'avance, plafonds automatiques (soft/hard cap) et rapports mensuels transparents. Ainsi, les coûts restent sous contrôle, tandis que les équipes ne doivent pas freiner les projets temporaires. J'informe à l'avance via des webhooks et des e-mails lorsque les quotas atteignent 80/90/100% et je propose des surclassements adaptés avant que des limites strictes ne s'appliquent.

Ajustement fin : tests, logs et adaptation continue

Je valide les limites à l'aide de tests de charge et de stress, j'enregistre les événements 429 de manière granulaire et j'adapte les limites en conséquence. Règles en fonction de l'utilisation réelle. Je minimise les cas positifs erronés avec des listes blanches pour les analyses de conformité et les pipelines de construction. Pour les API avec des requêtes basées sur des graphes, je teste la complexité des champs afin de limiter les requêtes injustes. Cela vaut la peine de jeter un coup d'œil sur GraphQL dans le panneau d'hébergement, Les limites de profondeur et de coût complètent efficacement la limitation du taux. L'itération continue permet d'équilibrer la protection et la performance.

Bilan succinct : protection, équité et performance planifiable

J'utilise le Rate-Limiting à plusieurs niveaux pour que Clients peuvent fonctionner de manière fiable, tandis que les abus n'ont aucune chance. La combinaison d'algorithmes adaptés, d'une communication transparente et de quotas clairs permet à la plateforme de rester réactive. Le monitoring et les tests me permettent de réduire les risques et de contrôler les pics coûteux. Des modèles de tiering judicieux garantissent l'équité et la marge de croissance. En pensant les limites comme des règles de produit, on obtient des services stables et des utilisateurs satisfaits.