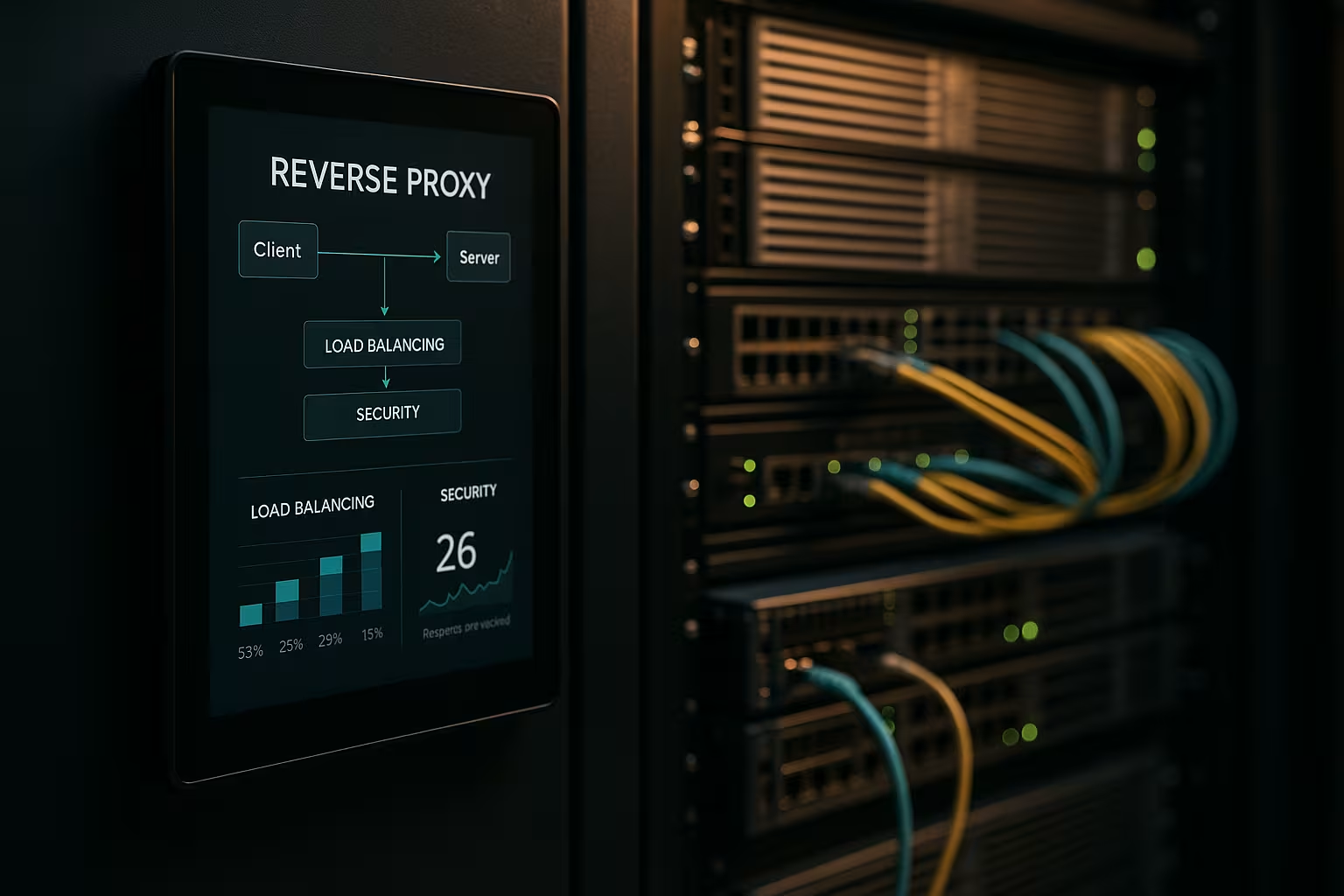

Une architecture reverse proxy accélère les requêtes, protège les systèmes backend et fait évoluer les applications web sans modifier les serveurs d'applications. Je montre comment une Proxy inverse faire progresser de manière mesurable la performance, la sécurité et l'évolutivité dans les opérations quotidiennes.

Points centraux

- Performance grâce à la mise en cache, au déchargement SSL et à HTTP/2/3

- Sécurité via WAF, protection contre les DDoS et blocage IP/géo

- Mise à l'échelle avec load balancing et health checks

- Contrôle grâce à un routage, une journalisation et une analyse centralisés

- Cabinet médical avec NGINX, Apache, HAProxy, Traefik

Que fait une architecture de proxy inverse ?

Je mets le Reverse proxy devant les serveurs d'application et le laisse terminer toutes les connexions entrantes. De cette manière, j'encapsule la structure interne, je garde les IP cachées et je minimise les surfaces d'attaque directes. Le proxy décide quel service prend en charge la demande et il peut mettre en cache les contenus. Il s'occupe de TLS, de la compression et des optimisations de protocole comme HTTP/2 et HTTP/3. Je décharge ainsi sensiblement les serveurs d'applications et gagne un poste pour les directives, les évaluations et les modifications rapides.

Optimisation des performances : mise en cache, délestage, edge

Je combine Mise en cacheSSL-offloading et Edge-livraison pour réduire les temps de latence. Les actifs fréquents tels que les images, CSS et JS sont mis en cache, tandis que les parties dynamiques restent fraîches (par ex. mise en cache de fragments). Des politiques telles que stale-while-revalidate et stale-if-error me permettent de réduire les temps d'attente et de garantir la livraison en cas de perturbations. TLS 1.3, le remplacement du push HTTP/2 via Early Hints et la compression Brotli accélèrent encore les choses. Pour les utilisateurs internationaux, le proxy se dirige vers des nœuds proches, ce qui réduit le Time To First Byte. Un coup d'œil sur les Avantages et scénarios d'utilisation montre quels sont les leviers qui valent la peine d'être actionnés en premier.

Améliorer la situation en matière de sécurité : WAF, DDoS, géoblocage

J'analyse le trafic sur Proxy et filtre les demandes malveillantes avant qu'elles n'atteignent les systèmes backend. Un WAF détecte les modèles tels que les injections SQL ou XSS et les arrête de manière centralisée. La terminaison TLS permet d'inspecter le flux de données crypté, puis de le transmettre proprement. La défense contre les DDoS dépend du proxy qui distribue, limite ou bloque les demandes sans toucher aux applications. Le géo-blocage et le blocage IP coupent les sources connues, tandis que les limites de taux et la détection des bots limitent les abus.

Évolutivité et haute disponibilité avec l'équilibrage des charges

Je répartis la charge sur Charge Algorithmes d'équilibrage tels que Round Robin, Least Connections ou règles pondérées. Je sécurise les sticky sessions par affinité de cookie lorsque les sessions doivent rester liées à un nœud. Les contrôles de santé vérifient activement les services afin que le proxy retire automatiquement les cibles défectueuses du pool. La mise à l'échelle horizontale se fait en quelques minutes : enregistrement de nouveaux nœuds, renouvellement de la configuration, c'est tout. Pour le choix de l'outil, un bref Comparaison des outils d'équilibrage de charge en se concentrant sur les fonctions L7.

Gestion centralisée et suivi précis

Je collecte les logs de manière centralisée le Passerelle et mesure des indicateurs tels que les temps de réponse, le débit, les taux d'erreur et le TTFB. Les tableaux de bord montrent les points chauds, les points de terminaison lents et les pics de trafic. Les analyses d'en-tête (par ex. cache hit, age) aident à affiner les stratégies de cache. Les ID de corrélation me permettent de suivre les demandes à travers les services et d'accélérer l'analyse des causes. Je définis des directives uniformes pour les profils HSTS, CSP, CORS et TLS une seule fois au niveau du proxy, au lieu de les définir séparément dans chaque service.

Itinéraires, règles et versions sans risque

Je contrôle Routage sur la base du nom d'hôte, du chemin, des en-têtes, des cookies ou des informations géographiques. De cette manière, je peux séparer proprement les API et les frontaux, même s'ils fonctionnent sur les mêmes ports. Je mets en œuvre les versions Blue Green et Canary directement sur le proxy en dirigeant de manière ciblée de petits groupes d'utilisateurs vers les nouvelles versions. Les en-têtes de drapeau de fonctionnalité aident à contrôler les tests sous trafic réel. Les fenêtres de maintenance restent courtes, car je change les itinéraires en quelques secondes.

Comparaison des technologies dans la pratique

Je choisis le OutilIl s'agit d'une solution adaptée à la charge, au protocole et aux objectifs opérationnels. NGINX marque des points avec les contenus statiques, TLS, HTTP/2/3 et des fonctions efficaces de reverse proxy. Apache brille dans les environnements avec .htaccess, des modules étendus et des piles héritées. HAProxy fournit un équilibrage L4/L7 très puissant et un contrôle fin des contrôles d'intégrité. Traefik s'intègre bien dans les configurations conteneurisées et lit les itinéraires de manière dynamique à partir des étiquettes.

| Solution | Points forts | Missions typiques | Particularités |

|---|---|---|---|

| NGINX | Haute Performance, HTTP/2/3, TLS | Frontaux web, API, livraison statique | Brotli, mise en cache, déchargement TLS, module de flux |

| Apache | Modulaire Flexibilité, .htaccess | Piles héritées, installations à forte teneur en PHP | De nombreux modules, une gestion fine de l'accès |

| HAProxy | Puissant Équilibrage, Health Checks | Équilibreur de charge L4/L7, passerelle | LCA très granulaire et sophistiquée |

| Traefik | Dynamique Discovery, focus sur les conteneurs | Kubernetes, Docker, Microservices | Auto-configuration, intégration de LetsEncrypt |

Étapes de mise en œuvre et liste de contrôle

Je commence avec Objectifs: donner la priorité aux performances, à la sécurité, à la disponibilité et au budget. Ensuite, je définis les protocoles, les certificats, les suites de chiffrement et les versions de protocole. Je définis proprement les règles de routage, les politiques de mise en cache et les limites et je les versionne. Je configure les contrôles de santé, l'observabilité et les alertes avant la mise en service. Ceux qui souhaitent se lancer directement trouveront un aperçu des instructions sous Mettre en place un reverse proxy pour Apache et NGINX.

Meilleures pratiques pour le réglage des performances

J'active HTTP/3 avec QUIC, là où les clients le supportent, et je garde HTTP/2 prêt pour une large compatibilité. J'utilise Brotli pour les ressources textuelles et je laisse le proxy compresser efficacement les images. Je définis délibérément des clés de cache pour contrôler les variations dues aux cookies ou aux en-têtes. Je minimise les temps de poignée de main TLS, j'utilise la résomption de session et je définis l'étalement OCSP. Avec Early Hints (103), je donne au navigateur des signaux préalables pour les ressources critiques.

Une configuration de sécurité sans friction

Je tiens Certificats de manière centralisée et automatise les renouvellements avec ACME. HSTS impose HTTPS, tandis que CSP et CORP contrôlent le contenu. Je démarre une base de règles WAF de manière conservatrice et la renforce progressivement afin d'éviter les faux positifs. Les limites de débit, le mTLS pour les services internes et les listes IP réduisent les risques au quotidien. Les journaux d'audit restent inviolables afin que je puisse retracer les incidents en toute sécurité juridique.

Coûts, fonctionnement et retour sur investissement

Je prévois Budget pour les ressources du serveur, les certificats, la protection contre les DDoS et la surveillance. Les petites configurations démarrent souvent avec quelques cœurs virtuels et 4 à 8 Go de RAM pour le proxy, ce qui représente des dizaines d'euros par mois, selon le fournisseur. Les flottes plus importantes utilisent des instances dédiées, anycast et des nœuds globaux, ce qui peut représenter des coûts à trois chiffres en euros par site. La gestion centralisée permet de gagner du temps : moins de configurations individuelles, des processus de release plus rapides et des temps d'arrêt plus courts. Le retour sur investissement se traduit par une conversion plus élevée, des taux de rebond plus faibles et une ingénierie plus productive.

Variantes d'architecture et topologies

Je choisis l'architecture en fonction du profil de risque et de latence. Les environnements simples s'en sortent bien avec un seul Passerelle dans la DMZ, qui transmet les requêtes aux services internes. Dans les environnements réglementés ou de grande taille, je sépare les proxies frontaux et back-end en deux niveaux : le niveau 1 termine le trafic Internet et prend en charge le WAF, le DDoS et la mise en cache, le niveau 2 achemine en interne, parle le mTLS et impose des principes de confiance zéro. Les configurations actives/actives avec IP anycast et nœuds globalement répartis réduisent les temps de basculement et optimisent la proximité avec l'utilisateur. Pour les CDN en amont du reverse proxy, je veille à la transmission correcte des en-têtes (par ex. protocole X-Forwarded, Real-IP) et à des hiérarchies de cache coordonnées afin que le cache de l'edge et celui de la passerelle ne se bloquent pas mutuellement. J'encapsule les scénarios multi-tenant via SNI/TLS, des routes séparées et des limites de débit isolées afin d'éviter les effets de voisinage.

Protocoles et cas particuliers : WebSockets, gRPC et HTTP/3

Je prends en compte les protocoles ayant des exigences spécifiques afin que les fonctionnalités restent stables. Pour WebSockets j'active la prise en charge des mises à niveau et les connexions longue durée avec des délais d'attente appropriés. gRPC bénéficie de HTTP/2 et d'en-têtes propres ; j'évite H2C (HTTP/2 en clair) au niveau du périmètre en faveur de TLS avec ALPN correct. Pour HTTP/3 je mets à disposition des ports QUIC (UDP) et je n'autorise le 0-RTT que de manière restrictive, car les Replays comportent des risques. Les points finaux de streaming, les événements d'envoi de serveur et les gros téléchargements reçoivent leurs propres politiques de buffering et de body-size, afin que le proxy ne devienne pas un bottleneck. Pour les traductions de protocoles (par exemple HTTP/2 à l'extérieur, HTTP/1.1 à l'intérieur), je teste minutieusement la normalisation des en-têtes, la compression et l'utilisation des connexions afin de maintenir les latences à un niveau bas et de pouvoir planifier la consommation des ressources.

Authentification et autorisation au niveau de la passerelle

Je déplace Auth-Je confie les décisions de sécurité au reverse proxy si l'architecture et la conformité le permettent. J'intègre OIDC/OAuth2 par le biais de la vérification des jetons au niveau de la passerelle : le proxy valide les signatures (JWKS), vérifie l'expiration, l'audience et les scopes et place les revendications vérifiées comme en-têtes pour les services. J'utilise les clés API pour les points finaux de machine à machine et je les limite par route. Pour les systèmes internes, je mise sur mTLS avec vérification mutuelle des certificats afin de rendre la confiance explicite. Je veille à ne pas journaliser inutilement les en-têtes sensibles (autorisation, cookies) et j'utilise des listes Allow/Deny par route. Je formule des politiques à granularité fine via des ACL ou des expressions (par ex. chemin + méthode + revendication), ce qui me permet de contrôler l'accès de manière centralisée sans modifier le code de l'application.

Résilience : Timeouts, Retries, Backoff et Circuit Breaking

Je définis Timeouts consciemment par saut : établissement de la connexion, délai d'attente de l'en-tête et délai d'attente de la réponse. Je n'active les retries que pour les méthodes idempotentes et je les combine avec un backoff exponentiel et une gigue afin d'éviter les thundering herds. Les coupe-circuits protègent les pools de backend : Si le proxy détecte des pics d'erreur ou de latence, il ouvre temporairement le circuit, ne transmet plus que par échantillonnage à la destination concernée et répond sinon de manière précoce, en option avec un fallback du cache. La détection d'outlier retire automatiquement les instances "faibles" du pool. En outre, je limite les flux montants simultanés, j'active la réutilisation des connexions et j'utilise des files d'attente avec une priorisation équitable. Ainsi, les services restent stables, même si certains composants sont sous pression.

Conformité, protection des données et protection des IIP

Je traite le proxy comme Plaque tournante des données avec des règles claires de protection des données. Je masque ou pseudonymise les données personnelles dans les journaux ; les chaînes de requête et les en-têtes sensibles ne sont consignés que sur la base d'une liste blanche. Je raccourcis les adresses IP lorsque cela est possible et je respecte des périodes de rétention strictes. L'accès aux logs et aux métriques est basé sur les rôles, les modifications sont documentées de manière à garantir une révision. Pour les audits, je relie les événements de la passerelle aux entrées de gestion des changements, ce qui permet de suivre les validations et les mises à jour des règles. Je réponds ainsi aux exigences de conformité sans renoncer à une vision approfondie de la performance et de la sécurité.

Kubernetes, Ingress et Gateway API

J'intègre le reverse proxy de manière transparente dans Orchestration de conteneurs. Dans Kubernetes, j'utilise des contrôleurs Ingress ou l'API Gateway plus moderne pour décrire le routage, TLS et les politiques de manière déclarative. Traefik lit les étiquettes de manière dynamique, NGINX/HAProxy offrent des variantes Ingress sophistiquées pour un débit élevé. Je sépare le routage est/ouest interne au cluster (service mesh) de la passerelle de périmètre nord/sud, afin que les responsabilités restent claires. Je mets en œuvre les releases Canary avec des routes pondérées ou des correspondances d'en-tête, tout en définissant strictement les contrôles de santé et le "pod readiness" afin d'éviter le "flapping". Je versionne les configurations sous forme de code et je les teste dans des clusters de staging avec simulation de charge avant de les mettre en production.

Maturité opérationnelle : gestion de la configuration et CI/CD

Je traite la configuration du proxy en tant que Code. Les modifications passent par des pull requests, sont testées automatiquement (syntaxe, linting, contrôles de sécurité) et déployées dans des pipelines. J'utilise des previews ou du shadow-traffic pour valider de nouvelles routes en conditions réelles, sans risquer de transactions clients. Les rollbacks sont possibles en quelques secondes, car j'étiquette les versions et les déploie de manière atomique. Je gère les secrets sensibles (certificats, clés) séparément, de manière cryptée et avec un minimum d'autorisations. Pour la haute disponibilité, je répartis les versions de manière échelonnée sur les nœuds et j'enregistre les effets dans des tableaux de bord afin de pouvoir réagir rapidement en cas de régression.

Points d'achoppement typiques et anti-patterns

J'évite Sources d'erreurqui se produisent souvent dans la pratique. J'évite l'empoisonnement du cache en normalisant strictement les en-têtes et en gérant proprement le vary ; j'exclue de la clé de cache les cookies qui n'influencent pas le rendu. Je détecte les boucles de redirection à un stade précoce en effectuant des tests avec X-Forwarded-Proto/Host et des politiques HSTS/CSP cohérentes. "Trust all X-Forwarded-For" est tabou : je ne fais confiance qu'au prochain saut et je définis proprement Real-IP. Je contrôle les gros téléchargements via des limites et le streaming, afin que le proxy ne mette pas en mémoire tampon, ce que le backend fait mieux. Avec 0-RTT dans TLS 1.3, je fais attention à l'impuissance des idées. Et je surveille la taille des corps et des en-têtes pour que les requêtes individuelles ne mobilisent pas toute la capacité de l'opérateur.

Résumé pour des décisions rapides

Je mise sur un Reverse Proxy, car il réunit vitesse, protection et évolutivité en un seul endroit. La mise en cache, le déchargement TLS et HTTP/2/3 accélèrent considérablement les temps de chargement réels. Le WAF, la défense contre les DDoS et le contrôle IP/géo réduisent sensiblement les risques. Load Balancing, Health Checks et Rolling Releases maintiennent les services disponibles, même en cas de croissance. Avec NGINX, Apache, HAProxy ou Traefik, je trouve une solution claire pour chaque configuration et je garde l'exploitation sous contrôle.