Dans le comparatif de l'hébergement web 2025, je montre comment Métal nu l'hébergement virtualisé en termes de performance, de sécurité, d'évolutivité et de coûts. Sur la base de charges de travail typiques, j'explique quand l'exclusivité du matériel vaut la peine et quand elle ne vaut pas la peine. VMs marquer des points avec l'agilité.

Points centraux

Les points clés suivants te donnent un aperçu rapide pour une comparaison directe.

- PerformanceL'accès direct au matériel fournit des valeurs de pointe ; la virtualisation apporte un faible surcoût.

- Mise à l'échelle: le bare metal se développe en fonction du matériel ; les configurations de VM évoluent en quelques minutes.

- Sécurité: Séparation physique pour le bare metal ; segmentation stricte nécessaire pour le multi-tenancy.

- Coûts: taux fixes pour le matériel exclusif ; facturation basée sur l'utilisation pour les VM.

- Contrôle: contrôle total sur le bare metal ; automatisation élevée dans le fonctionnement des VM.

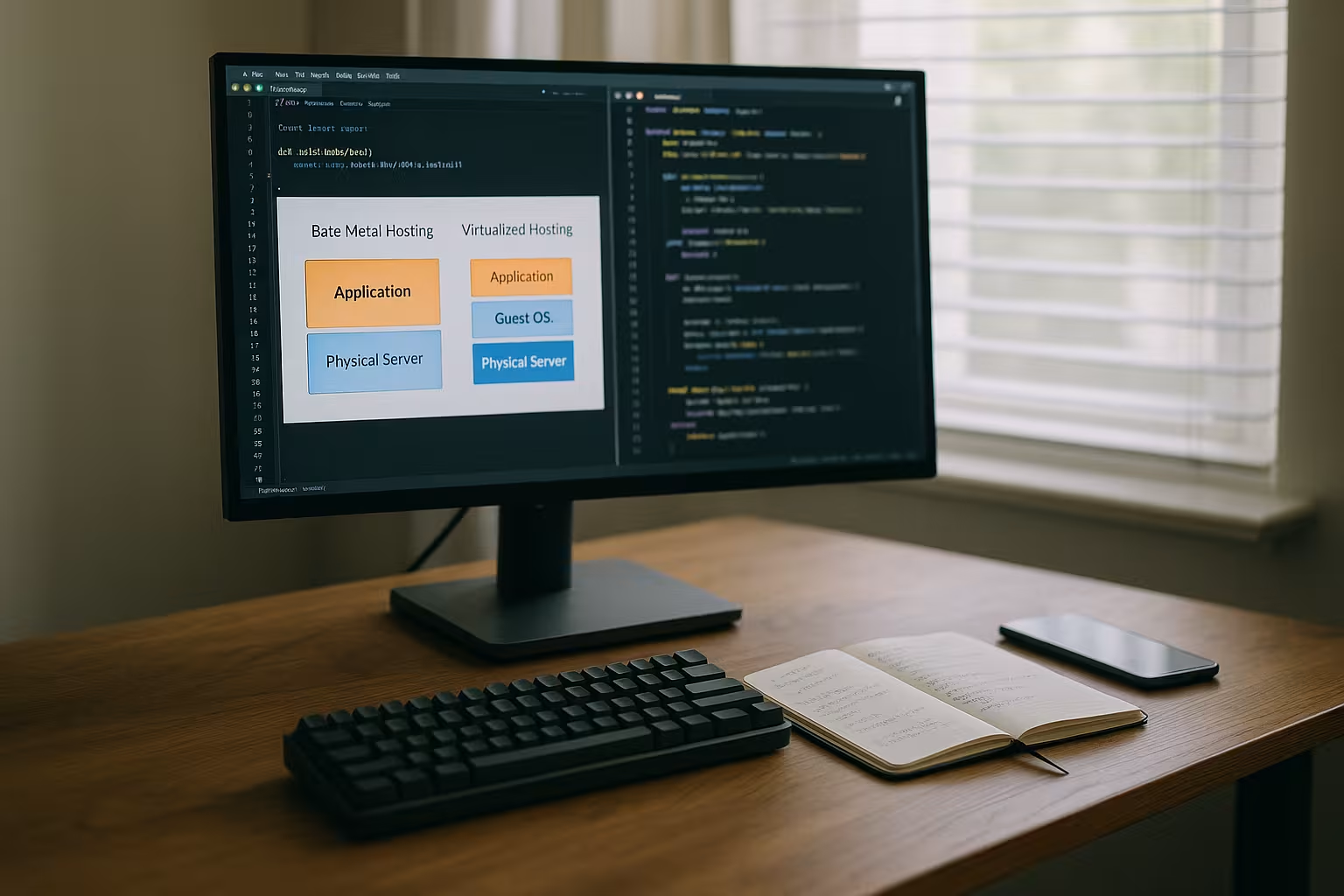

Que signifie réellement l'hébergement à nu ?

Métal nu décrit un serveur physiquement dédié dont j'ai l'usage exclusif. Aucune couche d'hyperviseur ne partage les ressources, ce qui fait que le CPU, la RAM et le stockage m'appartiennent entièrement. Cette utilisation exclusive évite le fameux effet Noisy-Neighbor et garantit des latences reproductibles. Je choisis le système d'exploitation, j'établis mes propres contrôles de sécurité et je peux activer des fonctions matérielles spéciales. Cela apporte un contrôle maximal, mais exige des connaissances spécialisées pour le patching, le monitoring et la récupération. Ceux qui ont besoin d'un stockage de données conforme et de performances constantes profitent particulièrement de Tenue uniqueLes entreprises qui souhaitent utiliser les services d'un fournisseur d'accès à Internet peuvent le faire en payant des frais fixes plus élevés et en acceptant des délais de mise à disposition plus longs.

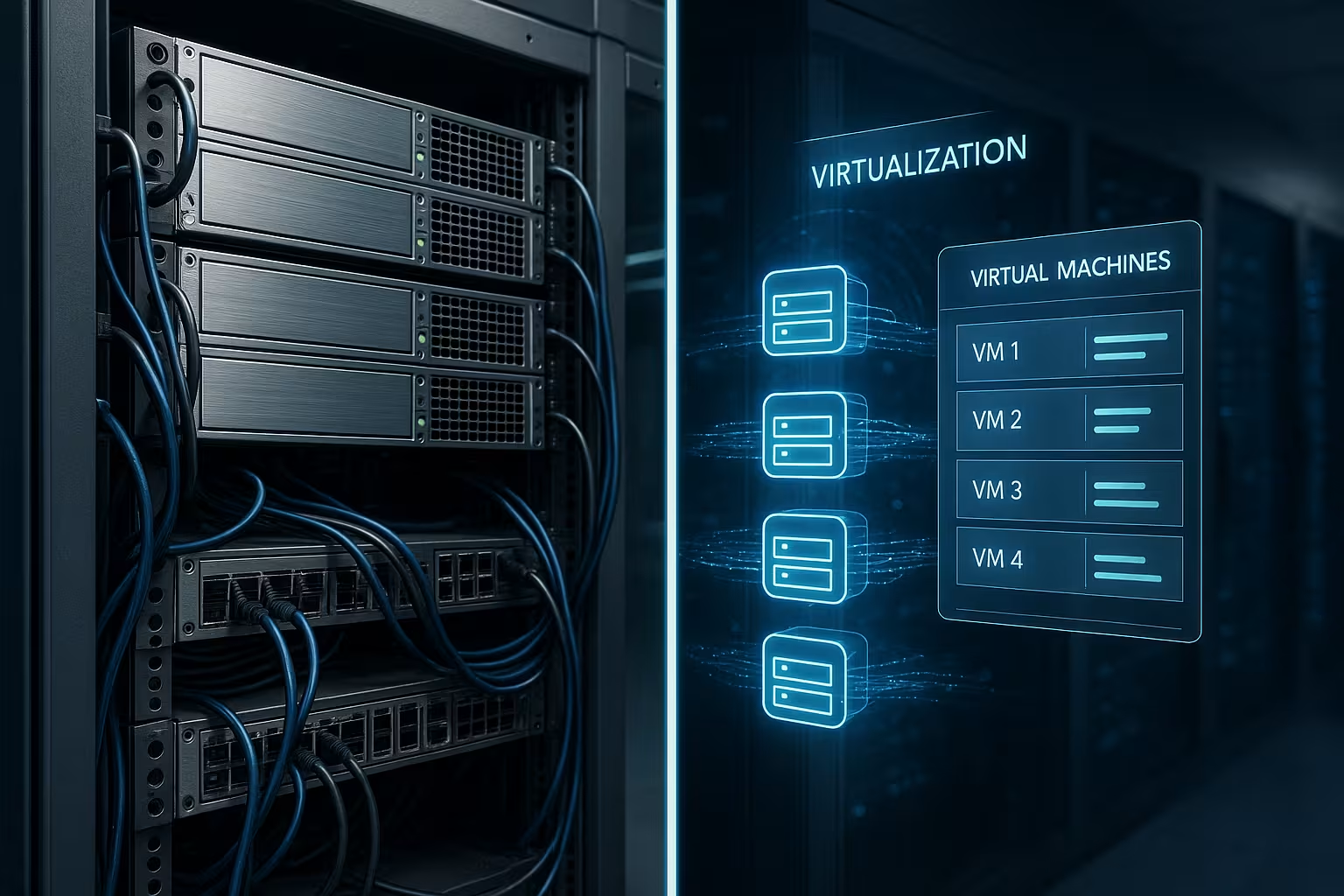

L'hébergement virtualisé en pratique

À l'adresse suivante : Hébergement de VM un hyperviseur divise le matériel en instances isolées, chacune avec son propre OS et des ressources définies. Je démarre de nouvelles machines en quelques minutes, je déplace des charges de travail de manière flexible et je profite des snapshots, des images et de l'automatisation. Cette approche réduit les coûts d'entrée et suit généralement le principe du "pay-as-you-go". En même temps, l'overhead de virtualisation est faible et j'ai moins d'influence sur le matériel de base. Pour ceux qui souhaitent aller plus loin, les principes de base de la virtualisation moderne sont les suivants Virtualisation des serveurs pour comprendre les différences entre les hyperviseurs de type 1 et de type 2. Pour les applications dynamiques, la grande agilité compte, tandis que Multi-Tenancy exige une segmentation propre.

Performance, latence et Noisy Neighbor

Performance reste l'argument le plus fort en faveur de l'hébergement à froid : les accès directs au matériel réduisent les temps de réponse et augmentent le débit. Les configurations virtualisées fournissent aujourd'hui également des valeurs très élevées, mais l'hyperviseur apporte des latences supplémentaires mesurables, même si elles sont faibles. Les goulots d'étranglement critiques en temps réel se produisent surtout lorsque de nombreuses machines virtuelles sont en concurrence pour la même ressource au même moment. Dans de telles situations, Bare Metal empêche les pics indésirables et maintient les performances à un niveau constant. Pour la plupart des applications web, les performances des VM sont toutefois largement suffisantes, surtout si les ressources sont réservées proprement et les limites correctement définies. J'évalue donc d'abord le caractère de la charge de travail, les profils d'E/S et les pics avant de choisir Exclusivité ou la virtualisation.

Réseau, stockage et réglage du matériel

Qu'il s'agisse de bare metal ou de VM, c'est la base qui détermine si la théorie tient dans la pratique. Sur Bare Metal, je peux Épinglage du CPU et Sensibilisation à la NUMA pour garder les threads près des bancs de mémoire et minimiser les changements de contexte. Dans les VM, j'obtiens beaucoup de ces résultats avec des vCPU que je lie à des noyaux physiques, j'active des pages massives et je définis proprement l'affinité IRQ. Les pilotes paravirtualisés (par ex. virtio) permettent d'approcher les E/S des valeurs natives. Dans Réseau fournissent 10/25/40/100 Gbit/s, Jumbo Frames, QoS et éventuellement SR-IOV des latences consistantes ; Bare Metal permet des piles de bypass du noyau (DPDK) et des charges NIC plus fines. Pour Stockage les latences NVMe, le niveau RAID, le cache en écriture (BBU/PLP), les systèmes de fichiers (par ex. XFS, ZFS) et les planificateurs d'E/S décident du débit et de la latence de queue. Le stockage en cluster (par ex. les backends Ceph/NFS) apporte de l'élasticité, le NVMe connecté localement marque des points avec un maximum d'IOPS. Je planifie les goulots d'étranglement par couche : réseau, stockage, CPU, RAM - et je les mesure séparément avant de passer à l'échelle.

Comparaison de la sécurité et de la conformité

Sécurité profite de la séparation physique : aucun client ne partage la plate-forme, ce qui réduit les surfaces d'attaque. J'applique le durcissement, la segmentation du réseau et le cryptage exactement comme l'exigent les directives. Les environnements VM isolent les invités par hyperviseur ; la configuration correcte joue ici un rôle décisif. La multi-location exige des zones de sécurité claires, une discipline en matière de correctifs et une surveillance afin d'éviter tout mouvement latéral. Les secteurs avec des directives strictes choisissent souvent le bare metal, tandis que de nombreux projets web fonctionnent en toute sécurité avec des VM proprement durcies. Pour les données hautement sensibles, je vérifie en outre Sécurité du matériel-Les fonctions de sécurité telles que TPM, Secure Boot et les volumes cryptés sont également disponibles.

Mise à l'échelle et déploiement

Mise à l'échelle distingue particulièrement bien les deux modèles. J'étends les capacités à nu via des mises à niveau matérielles ou des serveurs supplémentaires, ce qui implique une planification et des délais de livraison. Les environnements VM évoluent verticalement et horizontalement en très peu de temps, souvent de manière automatisée via l'orchestration. Cette vitesse prend en charge les versions, les commutateurs bleus/verts et les pics de capacité. En revanche, le bare metal brille pour les charges élevées permanentes sans modèles d'utilisation changeants. Ceux qui ont des profils de charge incertains s'en sortent souvent mieux avec des pools de machines virtuelles, tandis que les charges permanentes prévisibles donnent l'avantage à l'utilisation de VM. Matériel exclusif voir

Conteneurs et orchestration sur bare metal vs VM

Les conteneurs complètent les deux mondes. Sur Métal nu je bénéficie de la couche d'abstraction la plus basse pour Kubernetes, de faibles latences et d'un accès direct aux accélérateurs (GPU/TPU, SmartNICs). En revanche, il me manque des fonctions de confort comme la migration en direct ; je planifie les fenêtres de maintenance via des mises à jour roulantes et des budgets de disruption de pods. Dans Clustering de VM j'obtiens des voies de sécurité et de migration supplémentaires : les plans de contrôle et les workers peuvent être migrés en tant que VMs, les systèmes invités peuvent être gelés via des snapshots et restaurés plus rapidement. Les superpositions réseau (CNI), les pilotes de stockage (CSI) et les couches Ingress déterminent les performances réelles. Je choisis délibérément des domaines de défaillance (racks, hôtes, AZ) afin qu'une panne n'affecte pas l'ensemble du cluster et je vérifie si l'autoscaler du cluster s'applique mieux aux pools de VM ou aux nœuds bare metal.

Modèles de coûts et économies potentielles

Coûts sont structurellement différents. Le bare metal lie le budget à des taux fixes et est rentable en cas d'utilisation durablement élevée. L'hébergement virtualisé est généralement facturé en fonction des ressources utilisées et allège les budgets en cas de demande fluctuante. Pour une décision transparente, je collecte des données sur l'utilisation, j'évalue les pics de charge et je tiens compte des frais d'exploitation. L'automatisation, la surveillance et la sauvegarde sont facturées dans les deux modèles, mais avec des parts différentes pour l'infrastructure et l'exploitation. Le tableau suivant présente une vue d'ensemble compacte des caractéristiques et de la structure des coûts que j'utilise régulièrement pour Charges de travail de l'entreprise.

| Critère | Hébergement en métal nu | Hébergement virtualisé |

|---|---|---|

| Performance | Maximum, constant, exclusif | Variable, en fonction de la charge et de la VM |

| Évolutivité | Lent, lié au matériel | Rapide, à la demande |

| Sécurité | Séparation physique maximale | Bonne isolation, multi-tenance nécessite un durcissement |

| Individualisation | Complet, y compris le choix du matériel | Impact limité sur le matériel de base |

| Structure des coûts | Versements mensuels/annuels fixes | Pay-as-you-go par ressource |

| Frais de gestion | Élevé, expertise importante | Plus bas, largement automatisé |

Licences et piles propriétaires

Les licences ont souvent plus d'influence sur l'architecture que la technique. Pro-Core ou Pro-Socket les bases de données et les systèmes d'exploitation sous licence peuvent favoriser le bare metal si j'exploite peu d'hôtes très sollicités. En virtualisation, je paie selon le modèle par VM, par vCPU ou par hôte, mais je profite de la consolidation. Les charges de travail Windows avec licence de centre de données se justifient si la densité des VM est élevée ; si les instances sont peu nombreuses et importantes, le bare metal peut être plus avantageux. Les points importants sont Limites de la licence (cœurs, RAM) et des droits de mobilité : Toutes les licences n'autorisent pas le libre déplacement entre les hôtes ou vers d'autres centres de données. Je documente les mappings (charge de travail → licence) et je prévois des réserves afin de pouvoir absorber les pics de charge sans enfreindre la licence.

Sauvegarde, reprise après sinistre et haute disponibilité

RPO/RTO définissent le niveau de perte de données et de temps d'arrêt acceptable. Dans Environnements VM j'obtiens des redémarrages rapides grâce aux snapshots, à la réplication et au suivi des blocs modifiés, ce qui est idéal pour les sauvegardes de bases de données cohérentes avec les applications. Métal nu mise plutôt sur les sauvegardes d'images, les restaurations PXE ou l'automatisation de la configuration pour une réinitialisation rapide. Pour les services critiques, je combine réplication asynchrone, copies hors site et immuable sauvegarde (Write-Once) pour réduire les risques de ransomware. Un habitué Runbook pour le failover et des tests de restauration réguliers sont obligatoires - la théorie sans pratique ne compte pas. Je réalise la haute disponibilité par Multi-AZ, Load-Balancing et redondance dans chaque couche ; l'architecture détermine si le failover prend des secondes ou des minutes.

Énergie, durabilité et efficacité

En vue de Durabilité la charge de travail gagne en importance. Les VM consolident mieux les charges variables - ce qui augmente la Performance par watt. Le bare metal est convaincant lorsque la charge de travail est élevée en permanence ou lorsque des accélérateurs spéciaux augmentent l'efficacité. Je prends en compte le PUE du centre de données, Power-Capping, les paramètres C-States/Turbo dans le BIOS et le changement de génération des CPU, qui fournissent nettement plus de puissance par watt. Les profils de charge rectangulaires (batch, jobs nocturnes) peuvent être échelonnés dans le temps dans les pools de VM ; le bare metal peut également être économisé grâce à un dimensionnement précis et à des stratégies de mise en veille. Ceux qui suivent des budgets CO₂ planifient le placement, les points de mesure et les rapports KPI dès le début.

Scénarios d'utilisation typiques en 2025

Cas d'utilisation donnent le ton dans de nombreux projets. Les systèmes nécessitant en permanence beaucoup de CPU ou d'E/S, comme le HPC, l'analyse en temps réel, le streaming financier ou les serveurs de jeux, fonctionnent de manière particulièrement efficace sur du matériel dédié. Les environnements de développement, de test et de staging profitent en revanche de déploiements rapides de VM, de snapshots et d'une mise en veille avantageuse. Les boutiques en ligne dont la demande varie fortement s'adaptent par cluster VM et maintiennent des coûts variables. Ceux qui hésitent entre VPS et machine dédiée trouveront dans le Comparaison VPS vs. serveur dédié d'autres aides à la décision. Pour une conformité stricte, j'opte souvent pour le bare metal, tandis que les charges de travail modernes dans le cloud avec auto-scaling sous Pools de VM briller.

Migration et stratégie de sortie

Je planifie tôt, comme je planifie les plateformes changer peut. P2V (Physique à virtuel), V2V et V2P réduisent les risques de migration lorsque les pilotes, les versions de noyau et les modes de démarrage sont proprement préparés. Je réplique les bases de données à l'avance afin de ne perdre que quelques secondes ou minutes lors du cutover. Les configurations Blue/Green et les traffic shifts progressifs réduisent les temps d'arrêt. Les listes de compatibilité (p. ex. caractéristiques du système de fichiers, modules du noyau), un fallback défini et des points de mesure sont importants : Je compare les latences, le débit, les taux d'erreur et les coûts avant et après le changement. Une stratégie de sortie documentée empêche le verrouillage du vendeur et accélère les réactions aux changements de prix ou de conformité.

Arbre de décision : 7 questions avant l'achat

Je commence avec Profils de charge de travailLes pics de charge sont-ils rares ou fréquents et quelle est leur ampleur ? Ensuite, j'examine les exigences de latence, par exemple pour la gestion en temps réel ou les processus financiers. La troisième question porte sur la souveraineté des données et les certifications qui peuvent nécessiter une séparation physique. Ensuite, je me penche sur la durée : projets à court terme ou projets à long terme avec une charge de travail stable ? Cinquièmement, j'évalue le savoir-faire de l'équipe en matière de patching, d'observabilité et de récupération. Sixièmement, je tiens compte des éventuels verrous fournisseurs dans les chaînes d'outils et les piles d'hyperviseurs. Enfin, je compare les chemins budgétaires : les taux fixes pour le bare metal contre les coûts variables pour le bare metal. Pay-as-you-go.

Exemples de calculs et réflexion sur le TCO

Je calcule le coût total de possession sur 12 à 36 mois et je simule deux variantes : 1) Métal nu avec mensualités fixes, 2) Cluster de machines virtuelles avec une facturation basée sur l'utilisation. Hypothèses retenues : Charge de base, facteur de pic, temps de fonctionnement, volume de données, fréquence de sauvegarde, niveaux de support. Les coûts fixes (matériel/frais de base, hébergement, licences) plus les coûts variables (trafic, IO de stockage, snapshots) donnent le bilan mensuel. En cas de charge élevée 24 heures sur 24 et 7 jours sur 7 et d'utilisation stable, le calcul penche typiquement en faveur du bare metal ; en cas de forte fluctuation de la demande, les pools de VM élastiques sont payants. J'évalue en outre Charges d'exploitation (heures/mois), les coûts d'interruption (€/minute) et les risques (par ex. overprovisioning). Ce n'est qu'avec ces chiffres que l'on peut voir si la flexibilité ou l'exclusivité est économiquement viable.

Modèles hybrides et placement de la charge de travail

Hybride combine des instances bare metal et VM pour répondre à la fois aux pics de performance et à la conformité. Je traite les données de base critiques sur du matériel dédié, tandis que les frontaux évolutifs fonctionnent de manière élastique sur des machines virtuelles. Cette séparation permet de maîtriser les coûts et de réduire les risques. Une couche d'observabilité propre maintient les deux mondes visibles et facilite la planification des capacités. Pour les concepts de rôles et de droits, je renvoie aux différences entre vServer vs. serveur racineEn effet, les modèles d'accès sont souvent décisifs pour les frais d'exploitation. Correctement ordonnée, la configuration permet d'éviter les goulets d'étranglement inutiles et d'augmenter la productivité. Disponibilité.

Choisir un fournisseur : Ce à quoi je fais attention

Ce qui compte pour moi dans la sélection, c'est le vrai Transparence des ressources et des SLA clairs. J'examine les générations de matériel, les profils de stockage, la topologie du réseau et les sauvegardes. S'y ajoutent les temps de réaction du support, les caractéristiques d'automatisation et les catalogues d'images. Les modèles de prix doivent être prévisibles et tenir compte des réservations afin d'éviter les surprises. Des configurations de référence pour des charges de travail typiques aident au démarrage et facilitent les migrations ultérieures. Si l'on souhaite une prise en charge cohérente, il faut en outre veiller à ce que les options de gestion prennent en charge les tâches de routine et permettent de réduire les coûts. Risques d'exploitation baisser.

Liste de contrôle pour la preuve de concept et l'exploitation

- Définir SLI/SLO: valeurs cibles pour la latence p95/p99, la disponibilité, les taux d'erreur, le débit.

- Tests de charge: profils de trafic réalistes (rafale, pente, test de durée), taux de réussite de la base de données et du cache.

- Validation de la sécurité: politiques de durcissement, cycles de correctifs, gestion des secrets, segments de réseau, logs.

- Chemins de données: plan de sauvegarde (3-2-1), mesurer le temps de restauration, vérifier la réplication et le chiffrement.

- Observabilité: des métriques, des traces et des logs uniformes à travers les deux mondes (bare metal/VM)

- Chemin de changement: documenter et tester les scénarios de rolling/blue-green, fenêtres de maintenance, rollback.

- Contrôles des coûts: tags, budgets, alertes ; comparaison théorique/réel par mois.

- Planification des capacités: hypothèses de croissance, règles de headroom, réservations/commitments.

En bref

Pour Métal nu sont synonymes de performances de pointe constantes, de contrôle total et d'isolation renforcée. Les environnements virtualisés marquent des points avec un déploiement agile, une mise à l'échelle flexible et des coûts proches de l'utilisation. Je décide en fonction du profil de la charge de travail, des exigences de conformité et de la trajectoire budgétaire. Je préfère placer les charges élevées permanentes et les données sensibles sur des serveurs dédiés ; je préfère placer les projets web dynamiques et les cycles de test sur des machines virtuelles. En combinant intelligemment les deux, on obtient des coûts prévisibles, des versions rapides et une architecture qui évolue avec le projet. C'est ainsi que l'on obtient une solution qui allie la technique, la sécurité et l'efficacité. Rentabilité bien équilibré.