Je compare HTTP/3 Push et Preload à l'aide de valeurs de mesure réelles et j'explique à quel moment telle ou telle technique performance http3 de manière significative. Pour cela, j'analyse les avantages de QUIC, les priorités de chargement et les erreurs typiques de mise en œuvre, qui font que le First Paint et le Rendu freiner.

Points centraux

Je résume les points forts suivants de manière compacte, afin que tu puisses rapidement choisir entre le push et le preload. classer peut.

- HTTP/3: QUIC élimine le head-of-line blocking et maintient les flux à flot en cas de pertes.

- PushLivraison proactive : aide pour les actifs de base très probables, mais implique des frais généraux.

- Preload: Déclaratif, contrôlable, peu risqué en cas de priorisation des ressources critiques.

- Valeurs mesuréesLes avantages de HTTP/3 sont évidents en cas de perte de paquets et de nombreux actifs.

- StratégieCombinaison du Preload et du HTTP/3 : les meilleurs résultats sont souvent obtenus dans la pratique.

HTTP/3 Push et Preload expliqués en bref

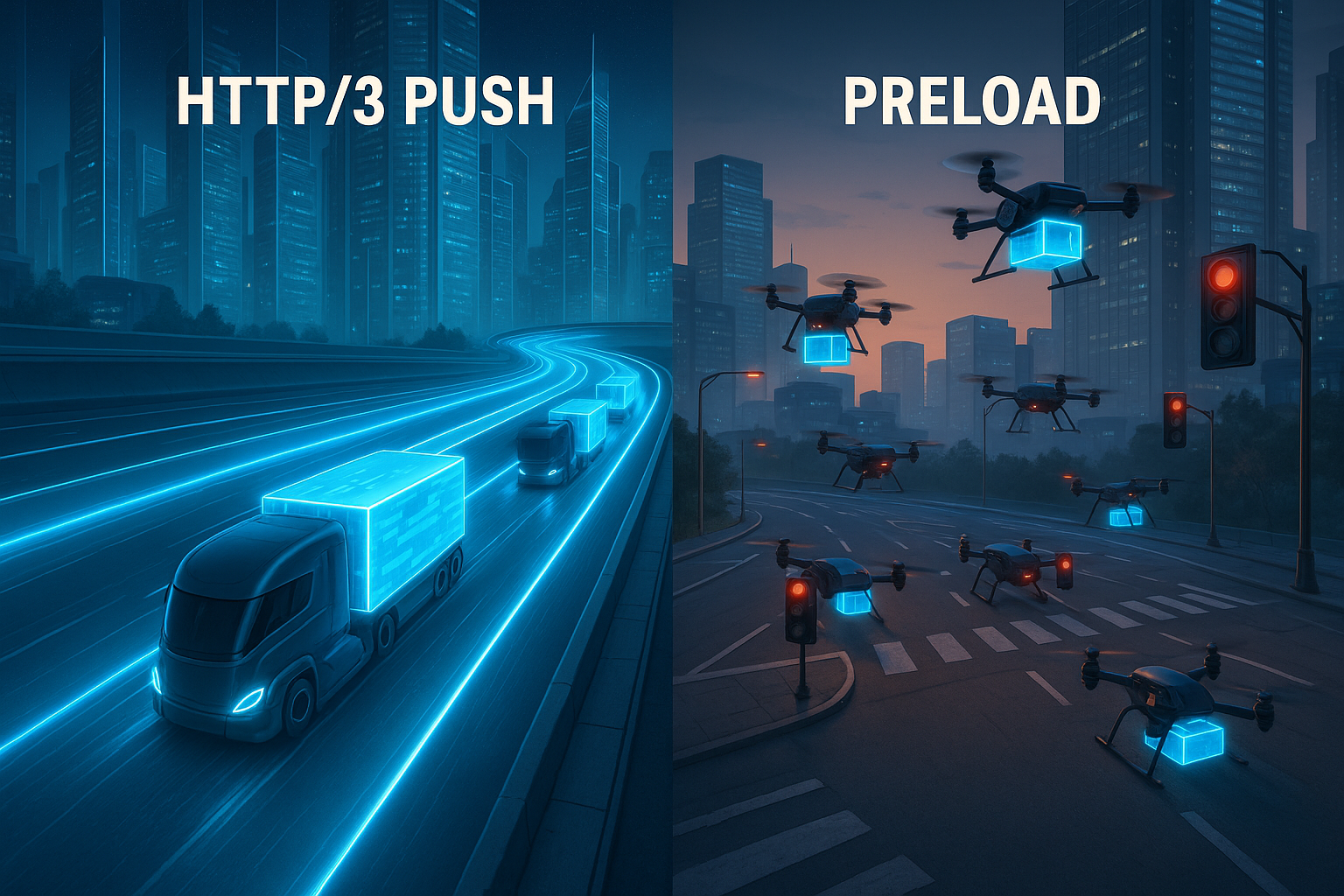

Je mets Push serveur lorsque le serveur fournit des fichiers avant même que le navigateur ne les demande, par exemple des CSS, des JS ou des polices web qui sont directement nécessaires pour le rendu. Cette tactique place très tôt les ressources dans le cache, économise les round trips et peut donner une avance sensible au First Contentful Paint. Preload je contrôle en revanche le balisage à l'aide de balises de lien, ce qui permet au navigateur de savoir exactement quel fichier il doit charger en priorité. Cela crée des priorités claires, réduit les doubles transferts et fonctionne de la même manière avec HTTP/1.1, HTTP/2 et HTTP/3. Comme HTTP/3 est basé sur QUIC, il vaut la peine de jeter un coup d'œil au Protocole QUIC, Le système de gestion des flux de données est un système de gestion des flux de données qui traite les flux séparément et évite ainsi la congestion au niveau de la ligne.

Comment HTTP/3 influence le temps de chargement

Avec QUIC, HTTP/3 met en valeur le Tête de ligne-Ainsi, les pertes de paquets individuelles ne ralentissent plus le chargement de tous les fichiers. Plusieurs flux fonctionnent en parallèle et les pertes n'affectent que le flux concerné, ce qui est particulièrement utile pour de nombreux actifs. 0-RTT peut accélérer les connexions lorsqu'il existe déjà un historique, ce qui permet d'accélérer le flux des premières demandes. La commande de la puissance d'émission et la correction d'erreurs interviennent également de manière adaptative, ce qui permet de maintenir une cadence élevée en cas de charge. Ceux qui apprécient les comparaisons directes trouveront dans le HTTP/3 vs. HTTP/2 Comparaison des performances, perspectives supplémentaires sur la latence et le comportement de transfert.

Push vs. Preload : Logique de décision

J'utilise Push, La livraison rapide peut être utilisée lorsqu'il y a une forte probabilité qu'un asset soit utilisé immédiatement, par exemple la feuille de style centrale ou un script above-the-fold. Dans ces cas, la livraison proactive peut permettre un gain de temps visible, surtout sur les réseaux mobiles. Mais si l'on pousse alors que le client a déjà le fichier en cache ou n'en a pas besoin, on gaspille de la bande passante et on allonge les files d'attente pour les données vraiment importantes. Preload je l'utilise lorsque je veux contrôler exactement ce qui démarre en priorité et quand l'analyseur doit voir la demande. Cela me permet de garder le contrôle, d'éviter les transferts en double et de minimiser les erreurs dans le choix des ressources.

Comparaison des performances en chiffres

Dans les environnements de mesure avec de nombreux téléchargements simultanés, HTTP/3 reste nettement en tête avec des pertes sensibles de plus de 8%. réactif, tandis que HTTP/2 chute [4]. Pour les fichiers de 1 Mo et la perte 2%, les tests ont montré des temps de chargement d'environ 1,8 seconde avec HTTP/1 contre 1,2 seconde avec HTTP/3 [5]. Ces différences ont un impact direct sur le LCP, le TTI et le TBT, notamment lorsqu'une page demande initialement de nombreux fichiers séparés. Pour les applications à page unique et les pages médias, la séparation des flux est particulièrement payante, car un asset qui stagne ne retient plus les autres. J'évalue toujours les chiffres dans le contexte des types de ressources, des priorités et des occurrences de cache, car c'est là que se trouvent les plus grands leviers pour Tempo.

| Critère | HTTP/3 Push | Preload | Effet sur les métriques |

|---|---|---|---|

| Contrôle | Côté serveur, proactif | Côté client, déclaratif | Démarrage précoce vs. priorité claire |

| Risque de double transfert | Augmente si la mémoire cache est déjà remplie | Faible, car adressé avec précision | Influence sur la bande passante et le TBT |

| Charge du réseau/perte de paquets | QUIC met en mémoire tampon les pertes par flux [4]. | Profit grâce au niveau de transport HTTP/3 | Avantages du LCP/INP en charge |

| Taux de réussite de la cache | Les actifs poussés peuvent partir en fumée | Utilisation ciblée des caches existantes | Moins de temps d'attente pour les personnes qui reviennent |

| Effort de mise en œuvre | Logique nécessaire sur le serveur | Adaptation du balisage dans le head | Gain rapide avec des dépendances claires |

État du navigateur en 2025 : Push classé de manière réaliste

Lors de la planification, je tiens compte du fait que de nombreux serveurs de navigateur limitent fortement ou ignorent complètement le push dans la pratique. Cela vaut en particulier pour les scénarios dans lesquels les doubles transferts menacent ou les caches sont déjà remplis. Ainsi, le push reste une arme spéciale pour des cas bien définis - par exemple lors des premières visites sur de nouvelles connexions - et non une panacée. Dans mes configurations, je calcule donc Push comme un booster optionnel et je m'appuie en premier lieu sur le Preload et une priorisation propre au niveau du transport. Là où les clients n'exploitent pas le push, je me rabats automatiquement sur le preload et les indications précoces, sans déstabiliser le pipeline. Ce classement sobre permet d'éviter les déceptions et de maintenir une feuille de route réaliste.

Early Hints (103) et Preload en équipe

Au lieu de pousser à l'aveuglette, j'envoie, dans les configurations appropriées Early Hints (103) avec Lien : rel=preload avant le HTML proprement dit. Le navigateur peut ainsi lancer des fichiers critiques alors que le serveur est encore en train de rendre la page. Cela permet de réduire le temps nécessaire à l'obtention du premier octet des actifs tout en conservant le contrôle chez le client. Dans la pratique, cela fonctionne de manière fiable avec HTTP/3 et offre de nombreux avantages du push - sans les risques de doubles transferts.

HTTP/1.1 103 Remarques préliminaires

Lien : ; rel=preload ; as=style ; fetchpriority=high

Lien : ; rel=modulepreload

HTTP/1.1 200 OK

...J'utilise les Early Hints surtout pour le CSS principal, les polices web critiques et les modules initiaux. Important as-Les types doivent correspondre exactement afin d'éviter de déclencher des demandes secondaires. Je veille également à ce que les spécifications CORS et les en-têtes de cache soient définis de manière cohérente. De cette manière, je peux réaliser la plupart des avantages d'un démarrage précoce sans que le serveur ne devine trop.

Contrôle fin des priorités : en-tête Priority et fetchpriority

Outre Preload, je mise sur Signaux prioritaires sur deux niveaux :

- Dans le HTML via

fetchpriority, par exemple.fetchpriority="high" (priorité de frappe)pour les styles ou les images critiques dans le viewport etfetchpriority="faible"pour les assemblages décoratifs. - Sur la réponse via un en-tête de priorité qui donne au transport des indications claires sur les réponses qui doivent circuler en priorité. Cela s'harmonise avec HTTP/3 et soulage la ligne en cas de nombreux flux parallèles.

C'est ainsi que je travaille ensemble côté client et côté serveur : Le navigateur prend rapidement les bonnes décisions et le serveur les livre avec une pondération appropriée. En combinaison avec QUIC, cela réduit la pression sur les goulets d'étranglement et évite que des fichiers insignifiants ne bloquent la voie critique.

Spécifier précisément le Preload

De nombreux problèmes avec Preload sont dus à de petites incohérences. Je les évite en utilisant un balisage propre et explicite :

Je vérifie systématiquement que les as-correspondent aux types de ressources réels. Pour les polices de caractères crossorigin Obligatoire, sinon les téléchargements risquent d'être doublés. Pour les scripts, je fais attention au mode (type="module" vs. classique) et met defer, pour que l'analyseur ne se bloque pas. Je conçois le Preload comme un complément au chemin de rendu, et non comme un remplacement ; l'intégration régulière reste nécessaire.

Les détails QUIC qui comptent dans la pratique

Je planifie HTTP/3 en tenant compte des caractéristiques qui sont perceptibles sur le terrain :

- Migration de connexion: Lorsqu'un appareil passe du WLAN à la téléphonie mobile, la connexion QUIC est maintenue. Cela évite les nouveaux handshakes et protège les longs transferts contre les interruptions.

- QPACK: compression des en-têtes sans risque global de tête de ligne. Cela accélère les pages avec beaucoup de petites requêtes, en particulier sur les CDN avec beaucoup d'en-têtes récurrents.

- 0-RTTJe n'autorise les requêtes accélérées que pour les ressources idéalement potentielles et j'évalue la situation en matière de sécurité. Là où 0-RTT s'applique, je gagne un temps considérable au démarrage à chaud.

- Contrôle adaptatif de la congestionDans les réseaux avec pertes, le débit reste plus stable. Combiné à la priorisation, cela donne un comportement robuste lorsque cela est nécessaire.

Ces fonctionnalités ne déploient leurs effets qu'avec une configuration propre du serveur et du CDN. Je veille à ce que TLS 1.3, des chaînes de certificats courtes, des informations d'état empilées et des fallbacks cohérents soient utilisés pour que même les clients plus anciens soient performants.

Utiliser correctement la priorisation des ressources

Je définis Actifs de base clairement : le CSS critique, les polices pour le texte visible, et les scripts qui concernent le domaine above-the-fold. Ces fichiers ont la priorité la plus élevée via le préchargement ou sont poussés dans des cas particuliers. Les fichiers d'image pour les contenus visibles ultérieurement sont placés en deuxième position ou via un chargement paresseux, afin que le chemin de rendu et l'interaction soient disponibles rapidement. Pour les ressources de tiers, j'évalue exactement l'utilité et, si nécessaire, j'active la préconnexion pour que les échanges démarrent à temps. Ainsi, la ligne reste libre pour les données vraiment importantes et j'évite que les actifs décoratifs ne bloquent le démarrage.

Pour la pratique, je m'en tiens à une courte routine de décision :

- L'actif est-il critique pour FCP/LCP et presque toujours nécessaire ? → Preload, Early Hints en option ; Push sélectif uniquement si supériorité mesurable.

- L'utilisation est-elle variable ou dépendante de l'utilisateur ? → Pas de push ; tout au plus préchargement selon des heuristiques vérifiées ou chargement en aval.

- L'asset est-il grand ? → Préférer le preload ; le push uniquement si la bande passante est assurée et les hits de cache peu probables.

- Existe-t-il des alternatives telles que Inline-Critical-CSS ou Code-Splitting ? → Préférer ; ils raccourcissent les chemins et réduisent le risque global.

Mise en œuvre : liste de contrôle pratique

Je commence par un Audit de la page d'accueil et des principaux templates et je marque tous les fichiers nécessaires pour la première zone visible. Ensuite, je crée des entrées Preload dans le head, je teste les priorités et je vérifie s'il y a des demandes en double. Là où un transfert précoce est très rentable, j'envisage un push sélectif et je mesure l'effet sur le LCP et le TTI. Pour QUIC/HTTP-3, j'active le support sur CDN ou serveur et je compare les règles de priorité avec les chemins critiques. Pour une aide pas à pas, j'ai recours à un guide pratique. Mise en œuvre de HTTP/3, Il est important que les utilisateurs aient une vue d'ensemble du système, afin que la configuration, les tests et le déploiement se déroulent de manière structurée.

En complément, j'établis les routines suivantes :

- Early Hints et l'alimenter avec les mêmes entrées de lien que l'en-tête HTML final.

- Stratégie de mise en cache avec versionnage :

app.abcdef.css, longmax-age,immuable, Il est important que les personnes qui reviennent en profitent. - Travailleur de service s'aligner sur les flux de préchargement afin d'éviter les doublons sur le réseau et dans le cache du logiciel.

- En-tête de priorité sur le Origin/CDN, afin que HTTP/3 privilégie les réponses vraiment importantes.

- Drapeaux de fonctionnalités pour le push/preload, afin d'effectuer des tests A/B rapidement et sans risque.

Les erreurs typiques et comment les éviter

Je ne pousse pas les Actifs, Je n'ai pas besoin de vérifier les résultats de recherche que le navigateur a peut-être déjà mis en cache, car cela gaspille de la bande passante. Au lieu de cela, je vérifie les en-têtes de cache, le versionnement et la validité, afin que les personnes qui reviennent puissent bénéficier de résultats récents. Je ne surcharge pas le Preload, car une douzaine d'entrées critiques peuvent encombrer la ligne et diluer les priorités. Pour les polices, je veille à ce que les formats et les rangs unicode soient adaptés afin que le transfert reste léger et que le texte visible apparaisse rapidement. De plus, je teste sur différents appareils et réseaux sans fil, car le véritable effet n'est visible que dans des conditions réelles.

Ce sont des pièges que je surveille particulièrement :

- Mismatch entre

aset le type de ressource (par exemple.as="script"pour les modules) → entraîne des demandes secondaires inutiles. - Absence de crossorigin pour les polices → des téléchargements en double ou des erreurs bloquantes.

- Listes de préchargement trop larges → minent les priorités ; je limite aux actifs de base.

- Des rôles peu clairs de Inline-Critical-CSS vs. Preload → je décide par page et j'évite les formes mixtes qui chargent les deux voies.

- Pousser à l'aveugle sans connaissance de la cache → Push reste un pari ; je mesure et sécurise avec des early hints.

Suivi et méthodes de mesure

Je mesure LCP, TTI, TBT et INP avec Lighthouse, j'ajoute des données d'exécution via RUM et je compare les variantes par des tests A/B. WebPageTest ou des outils similaires m'aident à évaluer les diagrammes en cascade et à voir si le preload et le push fonctionnent comme prévu. La combinaison des données de laboratoire et de terrain montre si les optimisations sont viables ou si elles produisent des effets secondaires. Je vérifie régulièrement comment les navigateurs gèrent le Server Push, car certains User Agents limitent ou ignorent les Pushed Assets [8]. Sur la base de ces données, je décide quelle technique je vais continuer à déployer et laquelle je vais retirer.

Pour des déclarations solides, je différencie :

- Froid vs. chaud: évaluer la première visite sans cache séparément des visiteurs de retour.

- Profils de réseau: simuler la 4G/5G avec des pertes réalistes, des scénarios RTT élevés et des cellules fortement sollicitées.

- Nombre de requêtes: voir séparément les pages avec peu de gros fichiers vs. beaucoup de petits fichiers.

- Mix d'appareilsappareils mobiles de classe moyenne avec CPU plus faible, car les coûts d'analyse et de décompression y sont plus importants.

Je documente exactement chaque expérience : versions de construction, entrées de préchargement, en-têtes de priorité, règles de push, statut d'early hints. Je peux ainsi reproduire les effets et les inverser rapidement si nécessaire.

Hébergement et infrastructure comme leviers

Je fais attention à Serveur avec un support HTTP/3 moderne, une configuration TLS solide et une priorisation propre. Un CDN performant avec une bonne couverture PoP réduit les latences vers les utilisateurs mobiles et rend les avantages de QUIC plus faciles à saisir. Une configuration propre des retombées TCP pour les anciens clients joue également un rôle, afin que personne ne soit désavantagé. Pour les budgets, je calcule d'abord l'effet, car souvent les plus petites adaptations de CDN ou les activations de HTTP/3 suffisent sans coûts supplémentaires élevés de l'ordre de quelques dizaines d'euros par mois. Plus la base est forte, plus les effets du push et du preload apparaissent clairement au quotidien.

Je vérifie également si l'infrastructure prend en charge les points suivants :

- Early Hints de Edge, afin que les préchargements démarrent avant le HTML.

- Priorisation extensible ou des en-têtes de priorité respectés par le proxy.

- Règles à grain fin par chemin/type de fichier pour ne pousser que les assets sélectionnés ou les mettre en évidence par Preload.

- Des métriques transparentes au niveau edge (hitrate, RTT, perte, repriorisations) pour rendre visibles les causes des écarts.

Classement final

Je vois HTTP/3 avec QUIC dès que des réseaux radio, de nombreux flux parallèles ou des situations de perte entrent en jeu [4][5]. Dans les configurations contrôlées, Preload fournit une priorisation sûre, car je détermine exactement ce qui doit vraiment être exécuté en premier. J'utilise le push de manière ciblée pour les ressources indispensables, dont l'utilité est cohérente et dont la taille reste raisonnable. J'obtiens le meilleur résultat en combinant le Preload pour les priorités, HTTP/3 pour le transport et le Push soigneusement dosé. En procédant ainsi, on réduit sensiblement les temps de chargement, on protège la bande passante des utilisateurs et on améliore nettement la qualité perçue de la page.