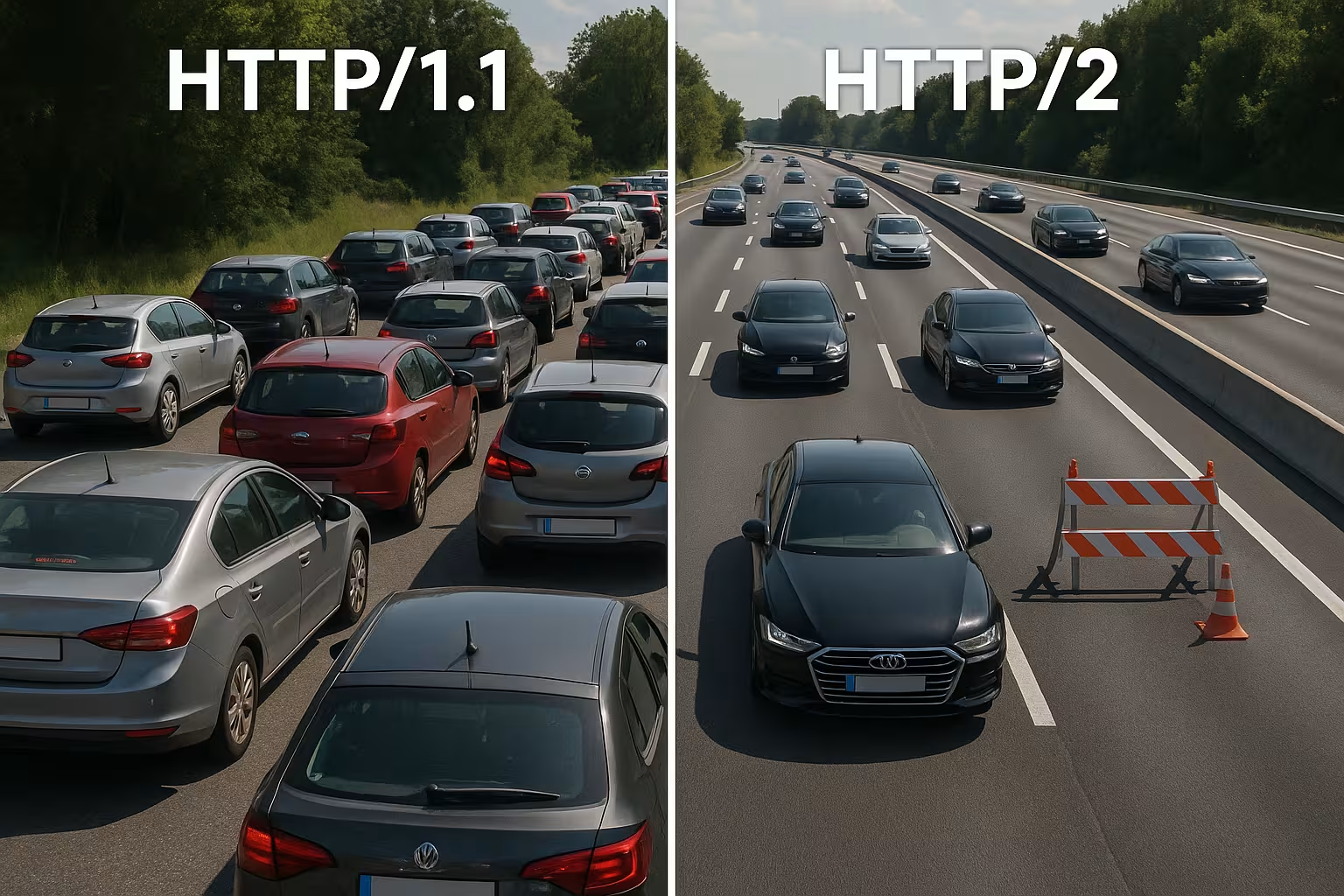

Multiplexage HTTP/2 regroupe plusieurs requêtes via une seule connexion et élimine les blocages au niveau du protocole. Cependant, dans les réseaux réels, le TCP Head-of-Line, la surcharge TLS et une priorisation insuffisante ralentissent le processus, de sorte que HTTP/2 ne fonctionne pas automatiquement plus rapidement que HTTP/1.1.

Points centraux

- Multiplexage traite en parallèle de nombreuses requêtes via une seule connexion TCP.

- TCP-HoL reste actif et arrête tous les flux en cas de pertes.

- Configuration TLS peut retarder sensiblement le temps de réponse (Time-to-First-Byte).

- Priorités et Server Push ne fonctionnent qu'avec un réglage parfait.

- Type de page décide : beaucoup de petits fichiers ou peu de gros fichiers.

Comment fonctionne le multiplexage HTTP/2 en interne

Je décompose chaque réponse en petites Cadres, je les numérote et les attribue à des flux logiques afin que plusieurs ressources puissent fonctionner simultanément via une seule connexion. Cela permet d'éviter les blocages au niveau HTTP, car aucune requête ne doit plus attendre la fin d'une autre. Les navigateurs envoient HTML, CSS, JS, images et polices en parallèle, ce qui réduit le coût des connexions supplémentaires. HPACK réduit la taille des en-têtes, ce qui allège considérablement la charge lorsque les fichiers sont nombreux et petits. Cependant, un élément reste déterminant : tous les flux partagent la même ligne TCP, ce qui présente des avantages, mais crée également de nouvelles dépendances. Cette architecture offre de la vitesse tant que le réseau reste stable et que la Définition des priorités fonctionne de manière judicieuse.

HTTP/1.1 vs HTTP/2 : principales différences

HTTP/1.1 s'appuie sur des messages textuels et plusieurs connexions parallèles par hôte pour charger simultanément des ressources, ce qui augmente les handshakes et la surcharge. HTTP/2 fonctionne en binaire, utilise une seule connexion pour tout et compresse les en-têtes, ce qui réduit les temps d'attente, en particulier lorsqu'il y a beaucoup d'objets. Dans les diagrammes en cascade, les longues files d'attente disparaissent car les flux progressent en parallèle. En revanche, le goulot d'étranglement passe de la couche HTTP à la couche TCP, ce que je ressens clairement sur les réseaux instables. Les petites pages fortement mises en cache ne présentent souvent que peu d'avantages par rapport à la version 1.1, tandis que les grandes pages riches en ressources en bénéficient de manière plus visible. Ces différences façonnent mon Stratégie de tuning et justifient une décision spécifique au projet.

Choisir correctement le contrôle de flux et la taille des fenêtres

HTTP/2 apporte son propre contrôle de flux par flux et par connexion. Je veille à ce que les valeurs soient pertinentes pour INITIAL_WINDOW_SIZE et le nombre de flux simultanés, afin que la ligne ne soit ni saturée ni sous-utilisée. Des fenêtres trop petites génèrent un nombre inutile de WINDOW_UPDATEles trames et réduisent le débit de données, tandis que des fenêtres trop grandes peuvent surcharger les clients moins performants. Dans les réseaux à produit bande passante-retard (BDP) élevé, j'augmente la taille de la fenêtre de manière ciblée afin que les réponses volumineuses ne restent pas bloquées dans le stop-and-go. En même temps, je limite MAX_CONCURRENT_STREAMS Pragmatique : suffisamment de parallélisme pour les éléments critiques pour le rendu, mais pas trop pour que les détails ne ralentissent pas l'image LCP. Ces réglages sont minimes, mais leur effet sur les temps de chargement réels est important s'ils sont adaptés au site et au réseau.

Réévaluer le partitionnement et le regroupement des domaines

De nombreuses optimisations 1.1 sont contre-productives sous HTTP/2. Je supprime l'ancien partitionnement de domaine, car une seule connexion bien utilisée est plus efficace que des sockets répartis artificiellement. Je remets également en question le regroupement agressif de JavaScript en méga-fichiers : des regroupements plus petits et logiquement séparés permettent des caches ciblés et évitent de devoir retransférer l'ensemble de l'application en cas de modification. Les sprites d'images perdent de leur importance, car les requêtes parallèles sont devenues bon marché et les formats d'images modernes, y compris la mise en cache, sont plus efficaces. Je désenchevêtre donc là où le multiplexage peut être avantageux et je ne regroupe plus que lorsque cela simplifie réellement l'architecture ou augmente de manière mesurable le taux de réussite de la mise en cache.

Coalition de connexions et certificats

HTTP/2 permet aux navigateurs d'utiliser une connexion pour plusieurs noms d'hôte si les certificats et le DNS correspondent. Je planifie les entrées SAN et SNI de manière à permettre la coalescence et à éviter des poignées de main supplémentaires. Si ALPN et les suites de chiffrement correspondent, le client peut utiliser CSS de cdn.exemple.com et photos de static.exemple.com via la même ligne. Cela permet d'économiser des RTT, de simplifier la hiérarchisation et d'augmenter les chances que les ressources critiques arrivent sans détours. Je vérifie ces effets de manière ciblée dans l'onglet Réseau : un seul socket est-il réellement utilisé ou les limites des certificats et les politiques obligent-elles le navigateur à établir de nouvelles connexions ?

Pourquoi le multiplexage est ralenti : TCP Head-of-Line

Si un paquet est perdu sur la seule connexion TCP, toute la ligne attend que la retransmission arrive, ce qui interrompt temporairement tous les flux HTTP/2. Dans les réseaux mobiles avec une latence variable et un taux de perte élevé, je constate donc régulièrement des gains moindres, voire des inconvénients, par rapport à plusieurs connexions 1.1. Cet effet explique pourquoi le multiplexage est brillant sur le papier, mais ne fonctionne pas toujours dans la pratique. Des mesures issues de la recherche et du terrain montrent précisément cette corrélation dans les réseaux réels [6]. Je planifie donc les déploiements de manière conservatrice, je teste les chemins d'accès typiques des utilisateurs et je vérifie les effets pour chaque groupe cible. Ignorer TCP-HoL, c'est gaspiller Performance et peut même allonger les temps de chargement.

Poignée TLS, TTFB et type de page

HTTP/2 fonctionne presque exclusivement via TLS sur le Web, ce qui génère des poignées de main supplémentaires et peut prolonger sensiblement le temps de réponse (Time-to-First-Byte) pour un petit nombre d'actifs. Si je ne fournis qu'un seul fichier volumineux, l'avantage du multiplexage disparaît, car aucun transfert parallèle n'est nécessaire. Les pages contenant dix à vingt petits fichiers en bénéficient davantage, tandis que les réponses à ressource unique sont souvent équivalentes à celles de HTTP/1.1. Je réduis la surcharge avec TLS 1.3, la reprise de session et un keep-alive propre, afin d'éviter les reconnexions et de garantir que la ligne soit vraiment active. Pour le contrôle précis, je mise sur Réglage Keep Alive, pour régler les délais d'inactivité, les limites et la réutilisation en fonction de la charge. Cela réduit la proportion de poignées de main et la TTFB se stabilise même pendant les pics de trafic.

Chaînes CDN et proxy : h2 jusqu'à l'origine

De nombreuses piles terminent TLS à la périphérie et continuent à communiquer avec l'origine. Je vérifie si HTTP/2 est également utilisé entre le CDN et le backend ou s'il y a un retour à HTTP/1.1. Les proxys tampons peuvent annuler certains avantages (compression des en-têtes, priorisation) s'ils resérialisent les réponses ou modifient l'ordre. J'optimise donc de bout en bout : le nœud périphérique, le proxy intermédiaire et l'origine doivent comprendre h2, utiliser des tailles de fenêtre appropriées et ne pas ignorer les priorités. Lorsque h2c (HTTP/2 sans TLS dans le réseau interne) est utile, je teste s'il permet de réduire la latence et la charge CPU sans enfreindre les politiques de sécurité. Seule une chaîne cohérente permet de déployer le Multiplexageeffet complètement.

Utiliser correctement la hiérarchisation des priorités

Je classe les ressources critiques afin que le HTML, le CSS et l'image LCP arrivent en premier et que les blocages de rendu disparaissent. Sans priorités claires, les scripts moins importants consomment une bande passante précieuse, tandis que le contenu au-dessus du pli attend. Tous les serveurs ne respectent pas correctement les priorités du navigateur, et certains proxys modifient l'ordre, c'est pourquoi j'évalue les données de résultats plutôt que les vœux pieux [8]. Les en-têtes de préchargement et une référence d'image placée tôt raccourcissent les chemins de chargement et augmentent le taux de réussite dans le cache. La priorisation ne fait pas de miracle, mais elle dirige la connexion de manière à ce que les utilisateurs voient rapidement ce dont ils ont besoin. Des règles claires apportent des avantages tangibles. Poussée et rendent le multiplexage vraiment efficace.

La priorisation dans la pratique : priorités extensibles

Les navigateurs ont perfectionné leurs modèles de priorisation. Je tiens compte du fait que les clients modernes utilisent souvent des „ priorités extensibles “ plutôt que des pondérations arborescentes rigides. Ils signalent ainsi l'urgence et les paramètres progressifs par flux, que les serveurs doivent interpréter et traduire en planificateurs équitables. Je vérifie si mon serveur respecte ces signaux ou s'il se base sur l'ancien comportement. Dans les tests A/B, je compare les chemins de chargement avec et sans priorisation côté serveur afin d'identifier les effets de déplacement. Important : la priorisation doit privilégier les éléments critiques pour le rendu, mais ne doit pas entraîner de famine des téléchargements de longue durée. Un mélange prudent évite les pics et maintient le pipeline libre pour les contenus visibles.

Server Push : rarement l'abréviation

Je n'utilise Server Push que de manière ciblée, car Over-Pushing occupe de la bande passante et ignore les caches du navigateur. Si une ressource déjà mise en cache est poussée, le chemin d'accès ralentit au lieu de s'accélérer. De nombreuses équipes ont désactivé Push et utilisent Preload, qui est nettement plus fiable [8]. Dans des cas particuliers, par exemple sur des itinéraires récurrents avec des schémas clairs, le push peut être utile, mais je prouve son effet à l'aide de mesures. Sans preuve, je supprime le push et garde le pipeline libre pour les données réellement nécessaires. Ici, moins c'est souvent mieux. plus, justement sur la seule liaison.

Comparaison pratique : quand HTTP/1.1 peut être plus rapide

Je considère HTTP/1.1 comme compétitif lorsque quelques fichiers volumineux dominent ou que les réseaux fonctionnent avec des pertes plus importantes. Plusieurs connexions séparées répartissent alors le risque et peuvent réduire les temps de premier octet individuels. Sur les très petites pages, les poignées de main TLS supplémentaires compensent souvent entièrement les avantages du multiplexage. En revanche, HTTP/2 l'emporte lorsque de nombreux petits objets sont présents, car la compression, la priorisation et un socket unique sont efficaces. L'aperçu suivant présente des modèles typiques issus d'audits et de tests sur le terrain qui guident mon choix de protocole [6][8]. Cette grille ne remplace pas les tests, mais fournit une base solide. Orientation pour les premières décisions.

| Scénario | Meilleur protocole | Justification |

|---|---|---|

| Beaucoup de petits éléments (CSS/JS/images/polices) | HTTP/2 | Le multiplexage et HPACK réduisent la surcharge, une seule connexion suffit |

| Peu de fichiers, mais très volumineux | HTTP/1.1 ≈ HTTP/2 | Peu de parallélisme nécessaire ; les coûts liés à la poignée de main pèsent davantage |

| Réseaux mobiles instables avec pertes | HTTP/1.1 en partie meilleur | TCP-HoL arrête tous les flux avec HTTP/2 ; plusieurs sockets peuvent aider |

| TLS optimisé (1.3, reprise), priorités claires | HTTP/2 | Configuration réduite, gestion ciblée de la bande passante |

| Over-Pushing actif | HTTP/1.1/HTTP/2 sans push | Les données inutiles bloquent la ligne ; le préchargement est plus sûr |

Meilleures pratiques pour gagner réellement du temps de chargement

Je réduis les octets avant le protocole : images au format WebP/AVIF, tailles adaptées, scripts économes et en-têtes de mise en cache propres. Je veille à ce que les parties critiques du chemin CSS restent petites, je charge les polices tôt et je définis des solutions de secours pour éviter les changements de mise en page. Pour l'établissement de la connexion et le DNS, j'utilise Préconnexion et préchargement DNS, afin que les poignées de main commencent avant que l'analyseur syntaxique ne rencontre la ressource. Brotli pour le contenu textuel accélère les récupérations récurrentes, en particulier via les CDN. Je contrôle les effets dans la cascade et compare le LCP, le FID et le TTFB avant et après les modifications. Les valeurs mesurées guident mes Priorités, l'intuition ne trompe pas.

gRPC, SSE et cas de streaming

HTTP/2 démontre particulièrement ses atouts avec gRPC et d'autres flux bidirectionnels ou de longue durée. Je fais attention aux délais d'attente, à la taille des tampons et aux règles de congestion afin qu'un flux bloqué ne pénalise pas toutes les autres requêtes. Pour les événements envoyés par le serveur et les flux en direct, une connexion stable et durable est utile, à condition que le serveur gère correctement les priorités et que les limites de maintien en vie ne s'appliquent pas trop tôt. En même temps, je teste le comportement en cas d'erreur : la reconstruction des flux, le backoff exponentiel et les limites raisonnables pour les reconnexions empêchent les pics de charge lorsque de nombreux clients se déconnectent et se reconnectent simultanément. Les scénarios en temps réel restent ainsi prévisibles.

Réglage OS et TCP pour des performances de multiplexage stables

Le choix du protocole ne compense pas une configuration réseau défaillante. Je vérifie les algorithmes de contrôle de congestion (par exemple BBR vs CUBIC), les tampons de socket, les politiques TCP Fast Open et la taille de la fenêtre de congestion initiale. Un contrôle de congestion adapté au chemin peut réduire les retransmissions et atténuer les effets HoL. Tout aussi important : des valeurs MTU/MSS correctes pour éviter la fragmentation et les pertes évitables. Au niveau TLS, je préfère les chaînes de certificats courtes, l'OCSP stapling et les certificats ECDSA, car ils accélèrent la poignée de main. Ensemble, ces paramètres donnent au multiplexage la nécessité Sous-structure, afin que la priorisation et la compression des en-têtes puissent déployer leurs effets.

Stratégie de mesure et indicateurs clés de performance dans le quotidien

Je ne me fie pas aux valeurs médianes, mais je regarde les p75/p95 des métriques, séparées par appareil, type de réseau et emplacement. Les tests synthétiques fournissent des valeurs de base reproductibles, tandis que la surveillance des utilisateurs réels montre la dispersion sur le terrain. Je compare les cascades des chemins clés, je vérifie les premiers octets du HTML, l'ordre du CSS/JS et l'heure d'arrivée de l'image LCP. Je déploie les modifications sous forme d'expériences contrôlées et j'observe en parallèle le TTFB, le LCP et les taux d'erreur. Important : je supprime les priorités qui n'apportent aucun avantage mesurable. La configuration reste ainsi allégée et j'investis dans des réglages qui permettent de gagner du temps de manière statistiquement prouvée.

Trafic des robots d'indexation et des robots

Outre les utilisateurs, les robots d'indexation bénéficient également d'un HTTP/2 propre. J'active h2 pour les points finaux pertinents et observe si les robots réutilisent la connexion et consultent davantage de pages dans le même laps de temps. Les cascades 301 inutiles, les réponses non compressées ou les limites Keep-Alive trop courtes coûtent cher en budget d'indexation. J'ajuste les politiques afin que le multiplexage fonctionne ici aussi, sans dépasser les limites du backend. Résultat : des analyses plus efficaces et une plus grande stabilité sous charge.

HTTP/2, HTTP/3 et ce qui compte ensuite

HTTP/3 s'appuie sur QUIC via UDP et résout le blocage TCP Head-of-Line, ce qui est particulièrement utile en matière de mobilité et de pertes [6]. L'établissement de la connexion est plus rapide et les blocages de flux n'affectent plus toutes les requêtes simultanément. Dans les flottes mixtes, HTTP/2 reste important, mais j'active HTTP/3 là où les clients et les CDN le prennent déjà en charge. Comparaisons détaillées telles que HTTP/3 vs. HTTP/2 m'aident à planifier les déploiements par étapes et en fonction des groupes cibles. Je mesure séparément par site, appareil et type de réseau afin que les utilisateurs réels en bénéficient. J'utilise ainsi des protocoles pour Temps de chargement dans les situations quotidiennes.

L'hébergement et l'infrastructure comme accélérateurs

De bons protocoles ne sauvent pas une infrastructure faible, c'est pourquoi j'examine attentivement l'emplacement, le peering, le CPU, la RAM et les limites d'E/S. Un serveur web moderne, un nombre raisonnable de travailleurs et une couche de cache empêchent que la seule connexion ne se retrouve dans une impasse. L'utilisation stratégique du CDN réduit le RTT et amortit les pics de charge. Ceux qui servent des utilisateurs dans toute l'Europe bénéficient souvent davantage de trajets courts que d'un réglage fin des protocoles. Je planifie la capacité avec des réserves afin que le trafic en rafale ne mette pas le système à genoux. C'est ainsi que le multiplexage déploie tout son potentiel. Potentiel fiable.

Identifier rapidement les images d'erreur

Si HTTP/2 semble plus lent que prévu, je recherche des schémas typiques : une seule longue transmission qui en bloque beaucoup d'autres plus petites ; des priorités ignorées ; des taux de retransmission élevés sur les liaisons mobiles ; ou une reprise TLS qui ne fonctionne pas. Je compare ensuite HTTP/2 et HTTP/1.1 dans des conditions identiques, je sépare l'influence du CDN de l'origine et j'examine le nombre de sockets, le nombre réel de flux et l'ordre des premiers kilo-octets. Si je trouve un goulot d'étranglement, j'ajuste d'abord les bases (octets, mise en cache, poignées de main) avant de peaufiner le contrôle de flux ou les priorités. Cet ordre permet d'obtenir les améliorations les plus fiables.

Résumé pratique pour des décisions rapides

J'utilise le multiplexage HTTP/2 lorsque de nombreux objets sont concernés, que les priorités s'appliquent et que TLS est correctement configuré. En cas de fichiers peu nombreux mais volumineux ou de réseaux instables, je calcule les avantages minimes et garde un œil sur les résultats 1.1. Je n'utilise le Server Push qu'avec des preuves, le Preload presque toujours, et je maintiens une faible charge grâce à la compression, la mise en cache et les connexions précoces. Des mesures effectuées avec des appareils et des emplacements réels confirment mes hypothèses avant que je ne déploie largement les modifications [6][8]. Au final, ce n'est pas le numéro de protocole qui compte, mais la vitesse perceptible pour les utilisateurs réels. En procédant ainsi, vous tirerez le meilleur parti de HTTP/2. Tempo et jette les bases du protocole HTTP/3.