Dans ce guide, je montre comment Extensions Plesk accélérer mon quotidien de développeur, permettre des déploiements sûrs et automatiser les tâches répétitives. Je donne des recommandations claires sur le choix et la mise en place - y compris les étapes de configuration, les valeurs par défaut utiles et les pièges typiques.

Points centraux

- Configuration et des valeurs par défaut raisonnables pour la sécurité, les sauvegardes, les performances

- Flux de travail avec Git, staging, crochets CI et piles de conteneurs

- Sécurité grâce à Imunify360, Let's Encrypt et un concept de durcissement intelligent

- Tempo via Cloudflare-CDN, mise en cache et surveillance

- Mise à l'échelle avec Docker, automatisation et rôles clairs

Pourquoi Plesk accélère mon travail de développeur

Je centralise les projets, les domaines et les serveurs, ce qui me permet de faire des économies chaque jour. Temps. Les extensions couvrent le développement, la sécurité, la performance et l'automatisation et s'intègrent parfaitement. Je contrôle les mises à jour et les étapes de migration directement dans le tableau de bord, sans passer par des scripts shell pour les tâches standard. Grâce au glisser-déposer, je classe les outils les plus importants à l'endroit dont j'ai le plus besoin et je reste dans le flux. Si l'on cherche d'abord une vue d'ensemble, on commence par les Top Extensions Plesk puis établit des priorités en fonction du type de projet et de la taille de l'équipe.

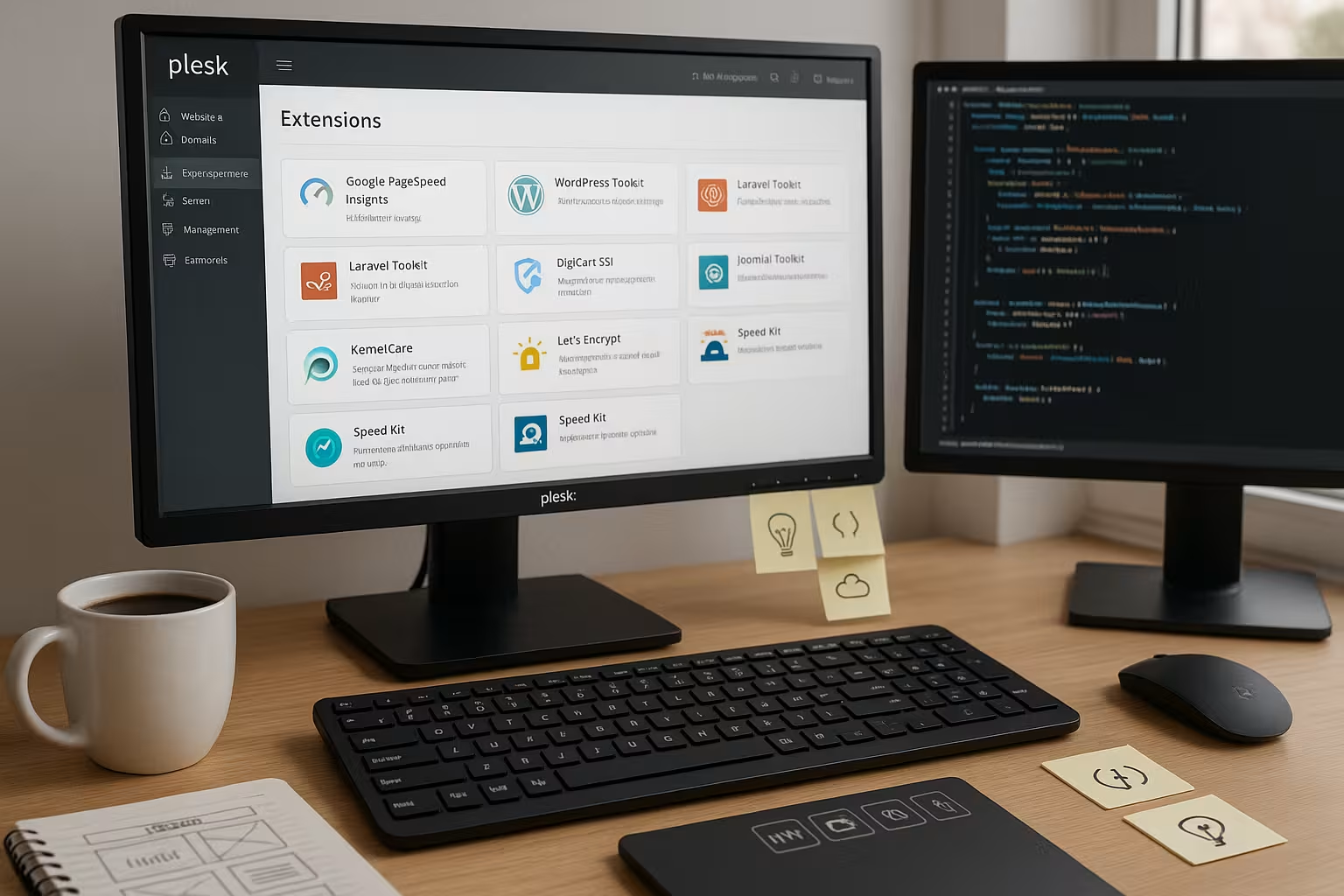

Aperçu des meilleures extensions Plesk

Pour les workflows modernes, je mise sur un noyau clair de WordPress Toolkit, Git, Docker, Cloudflare, Imunify360, Let's Encrypt et Acronis Backup. Cette sélection couvre les déploiements, le durcissement, SSL, CDN et la sauvegarde des données. Je commence généralement avec WordPress Toolkit et Git, puis j'ajoute Docker pour des services tels que Redis ou Node, et j'active ensuite Cloudflare. SSL et sécurité fonctionnent en parallèle, et j'active le renouvellement automatique pour les nouvelles instances. Le tableau suivant résume les avantages et l'utilisation.

| Extension | Principaux avantages | Convient pour | OS | Configuration dans Plesk |

|---|---|---|---|---|

| Boîte à outils WordPress | Staging, clonage, mises à jour | Sites WP, agences | Linux/Windows | Installer, scanner l'instance, créer le staging, définir les mises à jour automatiques |

| Intégration de Git | Contrôle de version, Deploy | Toutes les webapps | Linux/Windows | Connecter le repo, sélectionner la branche, activer le Webhook/Auto-Deploy |

| Docker | Piles de conteneurs | Microservices, Outils | Linux/Windows | Choisir une image, définir des variables d'environnement, libérer des ports |

| Eclat des nuages | CDN & DDoS | Pics de trafic | Linux/Windows | Connecter la zone, activer le proxy, choisir le niveau de mise en cache |

| Imunify360 | Protection contre les logiciels malveillants | Focus sur la sécurité | Linux/Windows | Créer une politique d'analyse, vérifier la quarantaine, définir des règles de pare-feu |

| Let's Encrypt | Automatisation SSL | Tous les projets | Linux/Windows | Demande de certificat, renouvellement automatique activé, HSTS en option |

| Sauvegarde Acronis | Sauvegarde dans le nuage | Critique des affaires | Linux/Windows | Créer un plan, choisir une plage horaire, tester la restauration |

Je décide en fonction des objectifs du projet, pas de l'habitude, et je conserve la pile mince. Chaque extension coûte des ressources, c'est pourquoi je ne mise sur plus que lorsqu'un avantage clair est visible. Pour les équipes, je recommande de consigner la shortlist dans la documentation et de définir des valeurs par défaut obligatoires. Ainsi, les configurations restent cohérentes et les nouveaux collègues s'y retrouvent plus rapidement. La transparence dans la sélection réduit les frais de maintenance ultérieurs.

WordPress Toolkit : configuration et paramètres par défaut utiles

Je commence par un scan afin que Plesk puisse automatiquement reconnaît. Ensuite, je crée un staging pour chaque site de production, j'active la synchronisation des fichiers et je choisis, si nécessaire, des tables de base de données sélectives. Les mises à jour automatiques sont sécurisées pour le noyau, manuelles pour les plug-ins ou échelonnées dans une fenêtre de maintenance. Pour chaque modification, je teste d'abord le staging, vérifie les contrôles de sécurité et active ensuite le live. Ceux qui souhaitent approfondir la question trouveront des informations utiles dans les Détails de la boîte à outils WordPress.

J'utilise la fonction de clonage pour les approches Blue/Green et je garde un plan de retour en arrière prêt. Je réduis ainsi les temps d'arrêt lors de mises à jour importantes. Pour les sites multiples, je désactive les plug-ins inutiles sur les instances de staging afin de rendre les tests plus rapides. Les scans de sécurité sont effectués quotidiennement, je vérifie brièvement la quarantaine dans le tableau de bord. Cela me permet de réduire les risques et de planifier les déploiements.

Intégration Git : des déploiements propres sans détours

Dans Plesk, je connecte un repo Git, je sélectionne la branche concernée et j'active Auto-Deploy sur Push. En option, je place des webhooks pour CI qui exécutent des builds et des tests avant le live-deploy. Pour les projets PHP, je crée une étape de construction pour l'installation de Composer, pour les projets Node, j'ajoute npm ci et une tâche Minify. Je définis la carte de déploiement de manière à ce que seuls les répertoires nécessaires soient exécutés sur le webroot, tandis que les artefacts de construction sont créés en dehors. Je garde les clés d'accès et les autorisations légères et je les fais tourner régulièrement.

Avant les diffusions en direct, j'effectue un contrôle de santé via une URL de maintenance et je vérifie les informations importantes. En-tête. En cas d'erreur, le pipeline arrête automatiquement le déploiement. J'évite ainsi les déploiements à moitié terminés, qui sont plus difficiles à rattraper par la suite. Pour les équipes, je documente les conventions de branche et j'utilise les pull requests comme obligation. La collaboration reste ainsi planifiable et la traçabilité élevée.

Docker dans Plesk : utiliser les conteneurs de manière productive

Pour des services comme Redis, Elasticsearch, Meilisearch ou des applications temporaires de preview, je lance des conteneurs directement dans le Panel. Je sélectionne des images dans le hub, je définis des variables d'environnement, je mappe des ports et je monte des volumes persistants. Je vérifie les contrôles de santé avec des points de terminaison simples pour que Plesk signale les faux départs. Pour les scénarios multi-conteneurs, je travaille avec des conventions de dénomination claires et je documente les dépendances. Ceux qui ont besoin d'une bonne introduction utiliseront le guide compact sur la Intégration de Docker dans Plesk.

Lorsque les projets grandissent, je fais évoluer les services horizontalement et j'encapsule les composants stateful de manière à ce que les sauvegardes restent cohérentes. Je dirige les logs vers leurs propres répertoires et je les fais tourner régulièrement. Je teste d'abord les mises à jour dans une version de conteneur séparée avant de passer à une autre. Je ne complète les enregistrements DNS qu'après des contrôles de santé fiables. Ainsi, les déploiements restent contrôlables et reproductibles.

La sécurité d'abord : bien configurer Imunify360 et Let's Encrypt

J'active l'option automatique Scans dans Imunify360 et je définis des actions claires pour les découvertes, comme la mise en quarantaine avec notification. Les règles de pare-feu sont strictes et je n'autorise que ce qui est vraiment nécessaire. Pour tous les domaines, je mets Let's Encrypt sur Auto-Renew et j'ajoute HSTS si le site fonctionne systématiquement en HTTPS. En outre, je vérifie les en-têtes de sécurité tels que CSP, X-Frame-Options et Referrer-Policy. Des rapports réguliers m'indiquent les points à améliorer.

Pour les connexions admin, j'utilise l'authentification à deux facteurs et je limite l'accès à des IP spécifiques. Les accès SSH se font par clé, je désactive les mots de passe lorsque c'est possible. Je crypte les sauvegardes et je teste régulièrement le processus de restauration. Je tiens une liste des plug-ins critiques et je vérifie leurs journaux de modifications avant les mises à jour. La sécurité reste une tâche quotidienne et non pas unique. Configuration.

Tempo par CDN : configurer Cloudflare intelligemment

Je connecte la zone, j'active le proxy et je choisis un niveau de cache qui permet d'afficher le contenu dynamique. respecte. Pour les API, j'active le cache par en-tête, pour les actifs, je définis de longs TTL avec versionnement. J'utilise des règles de page pour exclure les zones d'administration de la mise en cache et pour protéger strictement les chemins sensibles. HTTP/2, Brotli et Early Hints augmentent la vitesse de chargement sans modification du code. En cas de pics de trafic, les limites de débit atténuent les tentatives d'abus.

Les règles de défi et de bot réduisent la charge inutile sur les systèmes backend. Je surveille les taux HIT/MISS et adapte les règles jusqu'à ce que le quota de cache souhaité soit atteint. Pour les projets internationaux, je travaille avec le géo-steering et je reproduis des variantes régionales. Je documente les modifications DNS dans le journal des changements afin que les retours en arrière soient rapides. Ainsi, la performance reste mesurable et planifiable.

Sauvegardes, restaurations et redémarrage avec Acronis

Je fais des sauvegardes incrémentielles quotidiennes et des sauvegardes hebdomadaires. plein dans le cloud. Je maintiens la rétention de manière à pouvoir accéder à au moins 14 jours d'historique. Après chaque version importante, je teste une restauration dans un environnement isolé. Je mesure régulièrement les temps de restauration afin d'avoir des attentes réalistes en cas d'urgence. Je sauvegarde les bases de données de manière cohérente avec les transactions afin d'éviter la corruption.

Pour les sites critiques, je conserve une sauvegarde hors site séparée. Des playbooks de restauration décrivent les étapes, y compris la commutation DNS et le vidage du cache. Je conserve les mots de passe et les clés sous forme cryptée et je les fais tourner tous les trimestres. Les sauvegardes sans test-restauration sont considérées par moi comme incomplet. Seul ce qui a été exercé fonctionne de manière sûre en cas d'urgence.

Automatisation et surveillance : simplifier la routine quotidienne

J'automatise les tâches répétitives Tâches avec des jobs cron, des scripts hook et des actions git. Les logs vont dans des répertoires centraux, la rotation maintient la mémoire propre. Pour les analyses de trafic simples, j'utilise Webalizer et je vérifie les anomalies dans l'augmentation des codes 4xx et 5xx. Je définis les alertes de manière à ce qu'elles restent pertinentes pour l'action et ne génèrent pas de fatigue d'alerte. Pour les fenêtres de maintenance, je documente des heures de début et de fin claires.

Je marque les déploiements et je les lie à des valeurs mesurées telles que le temps jusqu'au premier octet et le taux d'erreur. En cas de dépassement, j'ai recours à un rollback automatique. Je sauvegarde les configurations sous forme de versions afin de pouvoir suivre les modifications. Les tests de performance sont effectués automatiquement après les mises à jour importantes et me donnent un aperçu rapide de la situation. Réponse. J'évite ainsi les surprises en direct.

Construire ses propres extensions : Quand les standards ne suffisent pas

Je mise sur mes propres extensions Plesk lorsqu'une équipe a des objectifs clairs. Spécial-a des exigences particulières. Il peut s'agir d'un concept d'autorisation interne, d'un flux de déploiement spécial ou d'un pont d'intégration avec des systèmes tiers. Avant de construire, je vérifie si une solution existante suffit avec de petites adaptations. Si ce n'est pas le cas, je définis brièvement et clairement les points finaux de l'API, les rôles et les limites de sécurité. Ce n'est qu'ensuite que j'écris le module et que je le teste par rapport à des scénarios typiques de la vie quotidienne.

Il est important de mettre en place une stratégie de désinstallation et de mise à jour propre, afin que le système reste maintenable. En outre, je documente les fonctions et les limites afin que mes collègues puissent utiliser l'outil en toute sécurité. Si nécessaire, je recueille les commentaires et je planifie de petites itérations plutôt que de grands sauts. Ainsi, l'extension reste gérable et fiable. Les modules propres sont rentables lorsqu'ils raccourcissent les processus de manière judicieuse.

Rôles, abonnements et plans de service : l'ordre donne de la vitesse

Avant de créer des projets, je structure Plesk avec Abonnementsdes plans de service et des rôles. Je répartis ainsi les limites (CPU, RAM, Inodes, quotas de messagerie) et les droits (SSH, Git, Cron) de manière planifiable. Pour les équipes d'agence, je crée des abonnements séparés par client, afin que les autorisations et les sauvegardes restent bien isolées. Les plans standard contiennent des valeurs par défaut raisonnables : PHP-FPM actif, opcache activé, sauvegardes quotidiennes, Auto-SSL, droits de fichiers restrictifs. Pour les tests plus risqués, j'utilise mon propre abonnement de laboratoire avec des ressources strictement limitées - cela protège le reste du système contre les dérives.

Je garde les rôles granulaires : Admins avec accès complet, devs avec Git/SSH et logs, rédacteurs uniquement avec Filemanager/WordPress. Je documente quel rôle effectue quelles tâches et j'évite la prolifération des droits d'utilisateurs individuels. Les nouveaux projets démarrent ainsi de manière cohérente et sont plus faciles à migrer ou à faire évoluer par la suite.

PHP-FPM, NGINX et la mise en cache : performance du panel

La puissance, je la sors en premier Paramètres d'exécutionPHP-FPM avec pm=ondemand, max-children propre par site, opcache avec suffisamment de mémoire et revalidate_freq adapté à l'intervalle de déploiement. Pour NGINX, je fais livrer directement les assets statiques et je place des en-têtes de cache ciblés sans mettre en danger les zones dynamiques. Pour WordPress, j'active si possible un micro-caching uniquement pour les utilisateurs anonymes et j'exclue les cookies qui marquent les sessions. J'active Brotli/Gzip sur l'ensemble du serveur, mais je teste les niveaux de compression contre la charge CPU.

Je tiens à disposition des versions PHP dédiées par site afin de séparer proprement les dépendances. Je complète les optimisations Critical Path (HTTP/2 Push n'est plus nécessaire, à la place Early Hints, Preload/Prefetch-Header propres) lorsque les valeurs mesurées le justifient. La règle : mesurer d'abord, tourner ensuite - des benchmarks après chaque changement important permettent d'éviter l'aveuglement.

E-mail et DNS : mettre en place proprement la délivrabilité et les certificats

Lorsque Plesk envoie du courrier, je mets SPF, DKIM et DMARC par domaine, vérifie le rDNS et maintient la cohérence des adresses de rebond. Je sépare les newsletters des e-mails transactionnels afin de protéger la réputation. Pour le DNS, je choisis consciemment : soit Plesk comme maître, soit une zone externe (par ex. via CDN). Important : si le proxy est actif, je planifie les défis Let's Encrypt de manière à ce que les renouvellements soient fiables - par exemple avec un dé-proxy temporaire ou un défi DNS pour les wildcards. Je documente la stratégie choisie pour chaque client afin que les cas d'assistance puissent être résolus rapidement.

Les webhooks de CI/CD capturent des IP cibles fixes et je n'autorise que ce qui est nécessaire dans le pare-feu. Ainsi, les chemins de messagerie et de construction restent stables.

Bases de données et stockage : stabilité sous charge

Pour les grands projets, j'externalise les bases de données sur des serveurs ou des conteneurs dédiés. Sauvegardes fonctionnent de manière cohérente avec les transactions, sur la base de binlogs pour la récupération ponctuelle. J'utilise les Read-Replicas pour les rapports ou les fonctions de recherche, afin que la Primary-DB reste déchargée. Dans Plesk, je veille à ce que les noms des bases de données soient clairs pour chaque abonnement et à ce que les droits nécessaires soient définis au minimum.

Je contrôle le stockage grâce aux quotas et à la rotation des logs. Je versionne les téléchargements de médias lorsque cela est possible et j'évite les doublons inutiles dans les environnements de staging. Pour les droits de fichiers, je définis des valeurs par défaut de 640/750 et je vérifie régulièrement que les déploiements ne laissent pas de fuites permissives. Ainsi, les restaurations et les migrations restent prévisibles.

Déploiements à temps de descente zéro : bleu/vert et libérations de symlink

En plus de la mise en scène, j'utilise les logiciels Blue/Green ou Symlink-releases. Les builds sont placés dans des dossiers de version en dehors du webroot. Après des tests réussis, je commute par symlink, j'exécute les migrations de base de données en étapes contrôlées et je prévois un retour en arrière. Je définis clairement les répertoires partagés (uploads, cache, session) afin que les commutations ne perdent pas de données. Pour WordPress et les applications PHP, j'empêche brièvement les accès en écriture pendant les fenêtres de migration critiques afin d'éviter les incohérences.

Les contrôles de santé surveillent la nouvelle version avant le flip. Je vérifie automatiquement les en-têtes, les routes importantes et la connexion DB. Ce n'est que lorsque tous les contrôles sont verts que le basculement a lieu. Cette routine m'a permis d'éviter de nombreux déploiements de nuit.

Contrôle des coûts et des ressources : limites, alertes, nettoyage

Je mets Limites par abonnement : temps CPU, RAM, nombre de processus, inodes. Les tâches Cron et les files d'attente reçoivent des plages horaires claires afin que les pics de charge restent calculables. Je nettoie automatiquement les anciennes versions et les logs, je garde les sauvegardes légères et documentées. Je surveille les conteneurs Docker pour voir s'ils ne sont pas trop volumineux ; je fais régulièrement tourner les caches. Ainsi, les coûts d'exploitation et les performances restent prévisibles - sans surprises à la fin du mois.

Les alertes ne sont utiles que si elles permettent d'agir. Je distingue les avertissements (la tendance bascule) et les alertes (une intervention immédiate est nécessaire) et je relie les deux à des runbooks. Celui qui est réveillé la nuit doit pouvoir rétablir la stabilité en trois étapes.

Les pièges typiques et comment les éviter

Les mises à jour automatiques sans staging se brisent rarement, mais alors généralement de manière défavorable - c'est pourquoi il faut toujours tester d'abord. Cloudflare peut mettre en cache de manière agressive les domaines d'administration si les règles sont trop larges ; j'exclue systématiquement les login, /wp-admin, API et Previews. Je ne laisse pas les services Docker comme Redis écouter publiquement et je les sécurise via des réseaux internes. Les renouvellements de Let's-Encrypt échouent si le proxy bloque les challenges ; un challenge DNS ou un bypass temporaire peuvent aider. Les déploiements Git qui exécutent des constructions node/compositeur dans le webroot provoquent souvent un chaos de droits - il faut donc créer les constructions en dehors et ne déployer que des artefacts.

Un deuxième classique : disque plein à cause de logs de débogage oubliés ou de coredumps. Je fixe des limites, je fais tourner les logs de manière stricte et je vérifie après les releases s'il y a une croissance inhabituelle. Et je garde toujours à disposition un accès manuel au break-glass (clé SSH, chemin documenté), au cas où le panel ne serait pas accessible.

Meilleures pratiques compactes

Je garde Plesk et toutes les extensions actuel et je teste les mises à jour avant de les déployer. Les sauvegardes se déroulent comme prévu et je m'entraîne régulièrement à effectuer des restaurations dans un environnement de test. J'organise le tableau de bord par glisser-déposer de manière à ce que les outils centraux soient immédiatement visibles. J'utilise l'automatisation, mais uniquement avec des stratégies de sortie et des retours en arrière clairs. Tous les membres de l'équipe connaissent les principales étapes et travaillent selon les mêmes normes.

Bref résumé

Avec un choix bien pensé de Extensions je mise sur la rapidité, la sécurité et la fiabilité des déploiements. WordPress Toolkit et Git forment la colonne vertébrale, Docker et Cloudflare apportent flexibilité et performance. Imunify360 et Let's Encrypt assurent le fonctionnement, Acronis protège les données et réduit les temps de redémarrage. Des paramètres par défaut clairs, des tests et une automatisation légère permettent de garder une vue d'ensemble du quotidien. L'environnement de développement reste ainsi modulable et les projets atteignent leurs objectifs de manière stable.