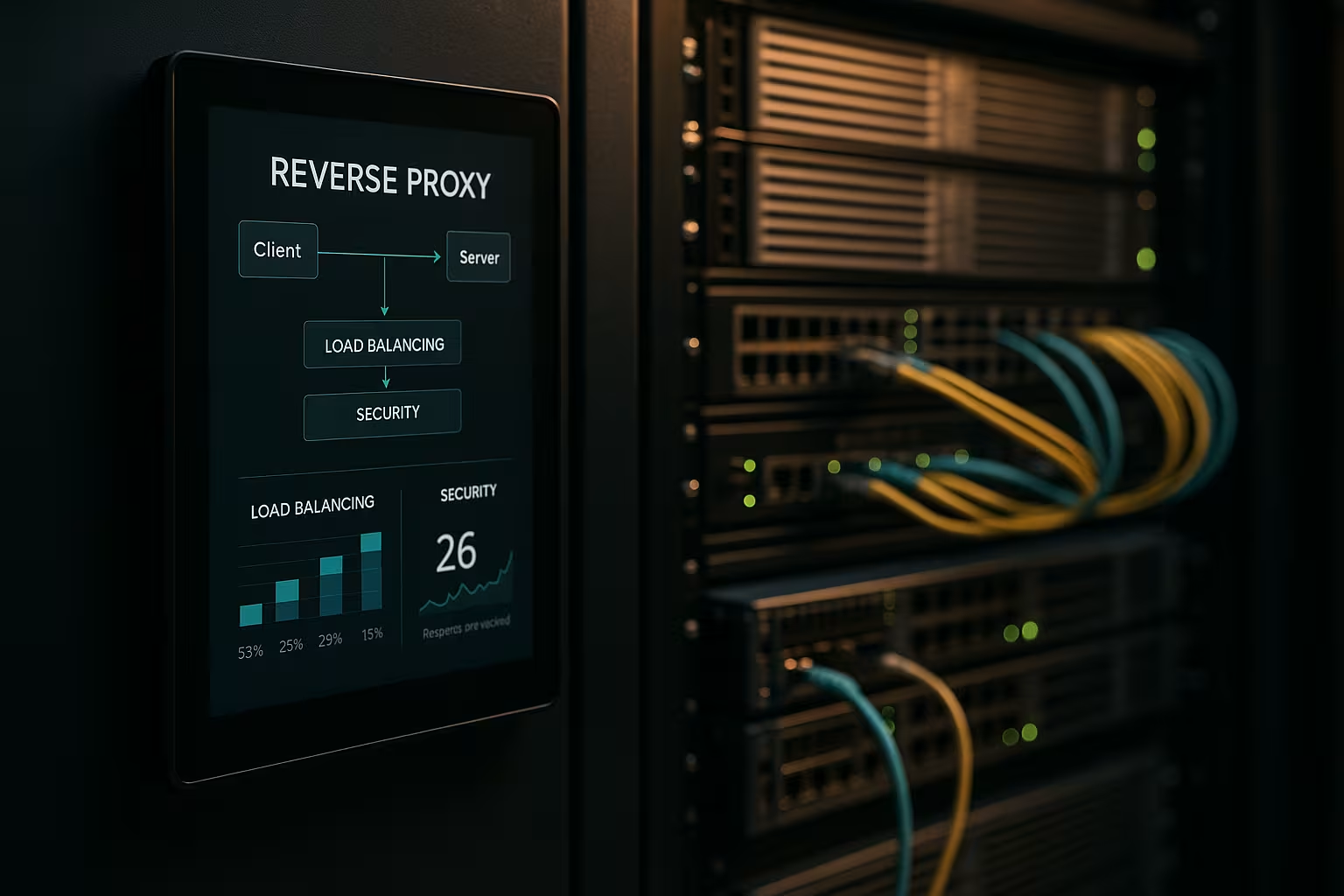

Un'architettura reverse proxy accelera le richieste, protegge i sistemi di backend e scala le applicazioni web senza modificare i server delle applicazioni. Mostro come un Proxy inverso migliora in modo misurabile le prestazioni, la sicurezza e la scalabilità nelle operazioni quotidiane.

Punti centrali

- Prestazioni attraverso il caching, l'offloading SSL e HTTP/2/3

- Sicurezza tramite WAF, protezione DDoS e blocco IP/geo.

- Scala con bilanciamento del carico e controlli di salute

- Controllo grazie all'instradamento, alla registrazione e all'analisi centralizzati

- Pratica con NGINX, Apache, HAProxy, Traefik

Cosa fa un'architettura reverse proxy?

Ho impostato il Inverso proxy davanti ai server delle applicazioni e fargli terminare tutte le connessioni in entrata. In questo modo, incapsulo la struttura interna, tengo nascosti gli IP e minimizzo le superfici di attacco diretto. Il proxy decide quale servizio si fa carico della richiesta e può memorizzare il contenuto nella cache. Si occupa di TLS, compressione e ottimizzazioni di protocolli come HTTP/2 e HTTP/3. Questo riduce notevolmente il carico sui server delle app e mi offre un luogo per linee guida, valutazioni e modifiche rapide.

Ottimizzazione delle prestazioni: caching, offloading, edge

Combino CachingOffloading SSL e consegna edge per ridurre le latenze. Servo risorse comuni come immagini, CSS e JS dalla cache, mentre le parti dinamiche rimangono fresche (ad esempio, la cache dei frammenti). Utilizzo politiche come stale-while-revalidate e stale-if-error per ridurre i tempi di attesa e garantire la consegna in caso di interruzioni. TLS 1.3, HTTP/2 push replacement tramite early hints e compressione Brotli forniscono un'ulteriore accelerazione. Per gli utenti internazionali, il proxy effettua un instradamento verso i nodi più vicini, riducendo così il tempo per il primo byte. Uno sguardo alle soluzioni più adatte Vantaggi e scenari di applicazione mostra quali regolazioni sono utili per prime.

Migliorare la situazione della sicurezza: WAF, DDoS, geoblocking

Analizzo il traffico su Proxy e filtrare le richieste dannose prima che raggiungano i sistemi di backend. Un WAF riconosce schemi come SQL injection o XSS e li blocca a livello centrale. La terminazione TLS consente di ispezionare il flusso di dati crittografati, dopodiché lo inoltra in modo pulito. La difesa DDoS dipende dal proxy, che distribuisce, limita o blocca le richieste senza toccare le applicazioni. I blocchi geografici e IP eliminano le fonti note, mentre i limiti di velocità e il rilevamento dei bot arginano gli abusi.

Scalabilità e alta disponibilità con il bilanciamento del carico

Distribuisco il carico tramite Carico Algoritmi di bilanciamento come Round Robin, Least Connections o regole ponderate. Proteggo le sessioni sticky utilizzando l'affinità dei cookie se le sessioni devono rimanere legate a un nodo. I controlli sullo stato di salute verificano attivamente i servizi in modo che il proxy rimuova automaticamente i target difettosi dal pool. Il ridimensionamento orizzontale funziona in pochi minuti: si registrano nuovi nodi, si rinnova la configurazione e il gioco è fatto. Per la selezione degli strumenti, un breve Confronto tra gli strumenti di bilanciamento del carico con particolare attenzione alle funzioni L7.

Gestione centralizzata e monitoraggio preciso

Raccolgo i log in modo centralizzato presso la Porta d'ingresso e misurare cifre chiave come tempi di risposta, throughput, tassi di errore e TTFB. I cruscotti mostrano i punti caldi, gli endpoint lenti e i picchi di traffico. Le analisi degli header (ad esempio, hit della cache, età) aiutano a mettere a punto le strategie della cache. Gli ID di correlazione mi permettono di tracciare le richieste tra i vari servizi e di accelerare le analisi delle cause principali. Ho impostato linee guida standardizzate per i profili HSTS, CSP, CORS e TLS una volta sola nel proxy, invece che separatamente in ogni servizio.

Percorsi, regole e rilasci senza rischi

Controllo Instradamento in base al nome dell'host, al percorso, alle intestazioni, ai cookie o alle informazioni geografiche. Questo mi permette di instradare separatamente le API e i frontend, anche se vengono eseguiti sulle stesse porte. Implemento le release Blue-Green e Canary direttamente sul proxy, indirizzando piccoli gruppi di utenti alle nuove versioni. Le intestazioni dei flag delle funzionalità aiutano a eseguire test controllati con traffico reale. Mantengo le finestre di manutenzione brevi, perché cambio le rotte in pochi secondi.

Confronto tra tecnologie nella pratica

Scelgo il Strumentoche corrisponde al carico, al protocollo e agli obiettivi operativi. NGINX si distingue per contenuti statici, TLS, HTTP/2/3 e funzioni di reverse proxy efficienti. Apache brilla in ambienti con .htaccess, moduli estesi e stack legacy. HAProxy offre un bilanciamento L4/L7 molto forte e un controllo preciso sui controlli di salute. Traefik si integra bene nelle configurazioni containerizzate e legge le rotte dinamicamente dalle etichette.

| Soluzione | Punti di forza | Applicazioni tipiche | Caratteristiche speciali |

|---|---|---|---|

| NGINX | Alto Prestazioni, HTTP/2/3, TLS | Front-end web, API, distribuzione statica | Brotli, caching, TLS offloading, modulo stream |

| Apache | Modulare Flessibilità.htaccess | Stack legacy, installazioni PHP-heavy | Molti moduli, gestione accurata degli accessi |

| HAProxy | Efficiente Bilanciamento, Controlli sanitari | Bilanciatore di carico L4/L7, gateway | ACL molto granulari e sofisticate |

| Traefik | Dinamico Scoperta, Focus contenitore | Kubernetes, Docker, microservizi | Configurazione automatica, integrazione con LetsEncrypt |

Fasi di attuazione e lista di controllo

Inizio con ObiettiviPrivilegio le prestazioni, la sicurezza, la disponibilità e il budget. Definisco quindi i protocolli, i certificati, le suite di cifratura e le versioni dei protocolli. Definisco chiaramente e in versione le regole di routing, le politiche di caching e i limiti. Prima di entrare in funzione, imposto controlli sullo stato di salute, osservabilità e avvisi. Se volete iniziare subito, potete trovare una panoramica istruttiva su Impostare il reverse proxy per Apache e NGINX.

Le migliori pratiche per la messa a punto delle prestazioni

Attivo HTTP/3 con QUIC dove i client lo supportano e mantenere HTTP/2 pronto per un'ampia compatibilità. Uso Brotli per le risorse testuali e faccio in modo che il proxy comprima le immagini in modo efficiente. Definisco deliberatamente chiavi di cache per controllare le variazioni attraverso i cookie o le intestazioni. Riduco al minimo i tempi di handshake TLS, uso la ripresa della sessione e imposto la pinzatura OCSP. Uso i suggerimenti precoci (103) per dare al browser segnali anticipati per le risorse critiche.

Configurazione di sicurezza senza perdite per attrito

Tengo Certificati centralmente e automatizzare i rinnovi con ACME. HSTS impone l'HTTPS, mentre CSP e CORP controllano i contenuti. Inizio una base di regole WAF in modo conservativo e la rafforzo gradualmente per evitare falsi allarmi. Limiti di velocità, mTLS per i servizi interni ed elenchi di IP riducono il rischio su base giornaliera. I registri di audit rimangono a prova di manomissione, in modo da poter tracciare gli incidenti con certezza legale.

Costi, funzionamento e ROI

Sto progettando Bilancio per le risorse del server, i certificati, la protezione DDoS e il monitoraggio. Le piccole configurazioni iniziano spesso con pochi core virtuali e 4-8 GB di RAM per il proxy, con costi mensili a due cifre, a seconda del fornitore. Le flotte più grandi utilizzano istanze dedicate, anycast e nodi globali, che possono comportare costi a tre cifre di euro per sede. La gestione centralizzata fa risparmiare tempo: meno configurazioni individuali, processi di rilascio più rapidi e tempi di inattività più brevi. Il ROI si riflette in un aumento delle conversioni, in una minore frequenza di rimbalzo e in una maggiore produttività dell'ingegneria.

Varianti di architettura e topologie

Scelgo l'architettura in base al profilo di rischio e latenza. Gli ambienti semplici funzionano bene con un singolo Porta d'ingresso nella DMZ, che inoltra le richieste ai servizi interni. In ambienti regolamentati o di grandi dimensioni, separo i proxy frontend e backend in due fasi: la fase 1 termina il traffico Internet e gestisce WAF, DDoS e caching, la fase 2 esegue il routing interno, parla mTLS e applica i principi di zero trust. Le configurazioni attive/attive con IP anycast e nodi distribuiti a livello globale riducono i tempi di failover e ottimizzano la vicinanza all'utente. Per le CDN davanti al reverse proxy, garantisco un corretto inoltro delle intestazioni (ad esempio X-Forwarded-Proto, Real-IP) e gerarchie di cache armonizzate in modo che la cache edge e quella gateway non si blocchino a vicenda. Incapsulo gli scenari multi-tenant utilizzando SNI/TLS, percorsi separati e limiti di velocità isolati per evitare effetti di vicinato.

Protocolli e casi speciali: WebSocket, gRPC e HTTP/3

Considero i protocolli con requisiti speciali in modo che le caratteristiche rimangano stabili. Per WebSocket Attivo il supporto per gli aggiornamenti e le connessioni di lunga durata con timeout adeguati. gRPC beneficia di HTTP/2 e di intestazioni pulite; evito H2C (HTTP/2 in chiaro) sul perimetro a favore di TLS con ALPN corretto. Per HTTP/3 Fornisco porte QUIC (UDP) e rilascio solo 0-RTT in modo restrittivo, poiché i replay comportano dei rischi. Gli endpoint di streaming, gli eventi inviati dal server e gli upload di grandi dimensioni ricevono le proprie politiche di buffering e body-size, in modo che il proxy non diventi un collo di bottiglia. Per le traduzioni di protocollo (ad esempio HTTP/2 all'esterno, HTTP/1.1 all'interno), verifico accuratamente la normalizzazione delle intestazioni, la compressione e il riutilizzo delle connessioni per mantenere basse le latenze e prevedibile il consumo di risorse.

Autenticazione e autorizzazione al gateway

Mi trasferisco Autorizzazione-decisioni al reverse proxy se l'architettura e la conformità lo consentono. Integro OIDC/OAuth2 tramite la verifica dei token al gateway: il proxy convalida le firme (JWKS), controlla la scadenza, il pubblico e gli ambiti e imposta le richieste verificate come intestazioni per i servizi. Uso le chiavi API per gli endpoint machine-to-machine e le limito in base al percorso. Per i sistemi interni, mi affido a mTLS con verifica reciproca dei certificati per rendere esplicita la fiducia. Faccio attenzione a non registrare inutilmente intestazioni sensibili (autorizzazione, cookie) e utilizzo elenchi di permessi/rifiuti per ogni percorso. Formulo politiche a grana fine tramite ACL o espressioni (ad esempio, percorso + metodo + richiesta), che mi consentono di controllare l'accesso in modo centralizzato senza modificare il codice dell'applicazione.

Resilienza: timeout, tentativi, backoff e interruzione del circuito

Definisco Timeout consapevoli per ogni hop: creazione della connessione, timeout dell'intestazione e timeout della risposta. Attivo i tentativi solo per i metodi idempotenti e li combino con il backoff esponenziale più il jitter per evitare le mandrie di tuoni. Gli interruttori proteggono i pool di backend: Se il proxy rileva errori o picchi di latenza, apre temporaneamente il circuito, inoltra solo in modo casuale verso la destinazione interessata e per il resto risponde in anticipo, opzionalmente con un fallback dalla cache. Il rilevamento degli outlier rimuove automaticamente le istanze "deboli" dal pool. Inoltre, limito gli upstream simultanei, attivo il riutilizzo delle connessioni e utilizzo code con equa priorità. Questo assicura che i servizi rimangano stabili anche se i singoli componenti sono sotto pressione.

Conformità, protezione dei dati e delle PII

Considero il proxy come Hub dati con chiare regole di protezione dei dati. Maschero o pseudonimizzo i dati personali nei log; le stringhe di query e le intestazioni sensibili vengono registrate solo su base whitelist. Se possibile, abbrevio gli indirizzi IP e mi attengo a periodi di conservazione rigorosi. L'accesso ai log e alle metriche è basato sui ruoli e le modifiche sono documentate a prova di audit. Per gli audit, collego gli eventi del gateway con le voci della gestione delle modifiche, in modo da tracciare le approvazioni e gli aggiornamenti delle regole. Questo mi permette di soddisfare i requisiti di conformità senza rinunciare a una visione approfondita delle prestazioni e della sicurezza.

Kubernetes, Ingress e Gateway API

Integro il reverse proxy senza problemi in Orchestrazione dei container. In Kubernetes, utilizzo i controllori di ingress o la più moderna API gateway per descrivere in modo dichiarativo l'instradamento, il TLS e le politiche. Traefik legge le etichette dinamicamente, NGINX/HAProxy offrono varianti di ingress sofisticate per un elevato throughput. Separo l'instradamento interno al cluster verso est/ovest (service mesh) dal gateway perimetrale nord/sud, in modo che le responsabilità rimangano chiare. Implemento release canarie con rotte ponderate o corrispondenze di intestazione, definendo rigorosamente i controlli di salute e la prontezza dei pod, per evitare sbalzi. Eseguo la versione delle configurazioni come codice e le collaudo in cluster di staging con simulazione di carico prima della messa in funzione.

Maturità operativa: gestione della configurazione e CI/CD

La configurazione del proxy viene trattata come Codice. Le modifiche vengono eseguite tramite richieste di pull, sono testate automaticamente (sintassi, linting, controlli di sicurezza) e distribuite in pipeline. Utilizzo anteprime o traffico ombra per convalidare i nuovi percorsi in condizioni reali senza rischiare le transazioni dei clienti. I rollback sono possibili in pochi secondi perché etichetto le versioni e le distribuisco atomicamente. Gestisco i segreti sensibili (certificati, chiavi) separatamente, in modo criptato e con autorizzazioni minime. Per garantire un'elevata disponibilità, distribuisco le release ai nodi in modo scaglionato e registro gli effetti in dashboard, in modo da poter prendere rapidamente le contromisure in caso di regressioni.

Ostacoli tipici e anti-pattern

Evito Fonti di erroreche si verificano spesso nella pratica. Prevengo l'avvelenamento della cache con una rigorosa normalizzazione delle intestazioni e una gestione pulita di Vary; escludo dalla chiave della cache i cookie che non influiscono sul rendering. Riconosco tempestivamente i loop di reindirizzamento testando con X-Forwarded-Proto/Host e politiche HSTS/CSP coerenti. Il "Trust all X-Forwarded-For" è un tabù: mi fido solo dell'hop successivo e imposto Real-IP in modo pulito. Controllo gli upload di grandi dimensioni tramite limiti e streaming in modo che il proxy non faccia buffering, cosa che il backend può fare meglio. Con 0-RTT in TLS 1.3, faccio attenzione all'idempotenza. E tengo d'occhio le dimensioni del corpo e dell'intestazione in modo che le singole richieste non impegnino l'intera capacità del lavoratore.

Sintesi per decisioni rapide

Scommetto su un Inverso perché combina velocità, protezione e scalabilità in un'unica soluzione. Caching, TLS offloading e HTTP/2/3 accelerano notevolmente i tempi di caricamento reali. WAF, difesa DDoS e controllo IP/geo riducono sensibilmente i rischi. Il bilanciamento del carico, i controlli sullo stato di salute e i rilasci periodici mantengono i servizi disponibili anche in fase di crescita. Con NGINX, Apache, HAProxy o Traefik, trovo una soluzione chiara per ogni configurazione e mantengo le operazioni gestibili.