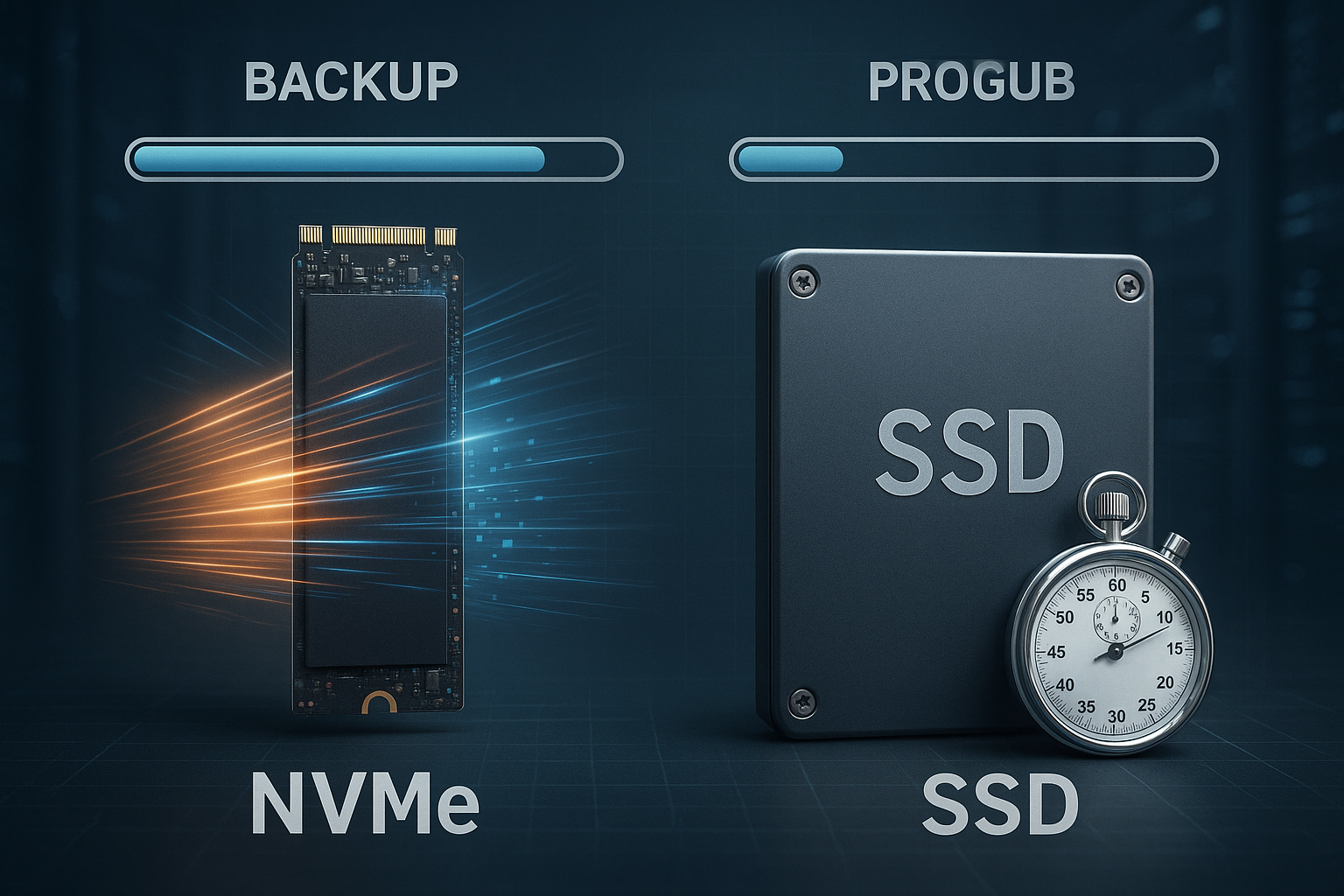

Le classi di storage Backup determinano la velocità di backup e ripristino dei dati: NVMe spesso riduce il tempo di backup di diversi minuti per 100 GB rispetto alle unità SSD SATA, a seconda del throughput e della latenza. Questo articolo mostra come NVMe e SSD influenza i tempi di backup, quali sono i colli di bottiglia che contano davvero e come posso ricavarne una strategia affidabile per ospitare i backup.

Punti centrali

- Vantaggio NVMeMaggiore throughput, minore latenza, tempi di backup e ripristino significativamente più brevi

- Tipo di backupL'uso di NVMe è completo, incrementale e differenziale in varia misura.

- Classi cloudStandard S3 per la velocità, IA/Archivio per il controllo dei costi

- RAID/FSIl layout e il file system influenzano le velocità di trasferimento reali

- RTO/RPOTest e monitoraggio garantiscono tempi di riavvio affidabili

NVMe vs SATA SSD: perché i backup ne traggono un grande vantaggio

NVMe utilizza le corsie PCIe e un protocollo snello, che aumenta la Produttività e IOPS e la latenza si riduce notevolmente rispetto alle unità SSD SATA. Le unità SSD SATA hanno una velocità tipica di 520-550 MB/s, mentre PCIe 4.0 NVMe raggiunge fino a 7.000 MB/s e PCIe 5.0 NVMe oltre 10.000 MB/s, accelerando notevolmente i backup completi. Per 100 GB questo significa in parole povere: SATA-SSD impiega circa 3-5 minuti, PCIe-4.0-NVMe 15-30 secondi, a seconda della compressione, della crittografia e del mix di file. Anche i lavori incrementali traggono vantaggio dalla bassa Latenza, perché molte piccole letture/scritture casuali sono più veloci. Se si vuole fare un confronto più approfondito, si possono trovare differenze pratiche nella tabella di marcia Confronto tra NVMe/SSD/HDD, che confronta prestazioni e costi.

Tipi di backup e loro interazione con la classe di archiviazione

I backup completi scrivono blocchi di dati di grandi dimensioni in modo sequenziale, motivo per cui il sistema di backup velocità di backup quasi linearmente con il throughput grezzo della classe di storage. I backup incrementali salvano i delta dall'ultima esecuzione; la bassa latenza di NVMe e le elevate prestazioni IOPS con molti file di piccole dimensioni sono particolarmente importanti in questo caso. I backup differenziali sono una via di mezzo e in pratica beneficiano di letture veloci durante l'assemblaggio della catena di ripristino. Per i backup di hosting, minimizzo RTO e RPO in questo modo: delta più piccolo, supporti veloci, pianificazione pulita. Combino i metodi ed eseguo i backup completi meno frequentemente, mentre i lavori incrementali sono pianificati in base ai seguenti parametri NVMe ruotano quotidianamente o più spesso.

Throughput, IOPS e latenza nel contesto del backup

Per ottenere tempi di backup realistici, considero tre dati chiave: sequenziale Produttività, IOPS casuali e la latenza per operazione. Il throughput sequenziale determina la durata del backup completo, IOPS e latenza guidano i lavori incrementali, molti file di piccole dimensioni e i metadati. La compressione e la crittografia possono limitare i valori grezzi se la CPU non tiene il passo con la velocità dei dati. Pertanto, misuro sia le prestazioni dello storage che l'utilizzo della CPU durante il backup. La tabella seguente mostra le dimensioni tipiche per i lavori da 100 GB in condizioni ottimali senza un collo di bottiglia di rete:

| Tipo di stoccaggio | Lettura max. | Massimo. Scrivere | Tempo di backup abituale (100 GB) | Latenza |

|---|---|---|---|---|

| SSD SATA | 550 MB/s | 520 MB/s | 3-5 minuti | 80-100 µs |

| PCIe 3.0 NVMe | 3.400 MB/s | 3.000 MB/s | 30-60 secondi | ~25 µs |

| PCIe 4.0 NVMe | 7.000 MB/s | 6.800 MB/s | 15-30 secondi | 10-15 µs |

| PCIe 5.0 NVMe | 12.000 MB/s | 11.000 MB/s | < 15 secondi | 5-10 µs |

In pratica, i valori sono spesso più bassi perché le dimensioni dei file, le checksum, le istantanee e il carico della CPU rallentano i vantaggi di NVMe rimane chiaramente visibile. NVMe è particolarmente vantaggioso per i lavori in parallelo, poiché vengono elaborate diverse code per ogni core. Per molti file di piccole dimensioni, IOPS e latenza contano più delle specifiche di MB/s puro. Pertanto, pianifico i buffer: 20-30% di margine rispetto alla velocità prevista, in modo che i backup non escano dalla finestra temporale durante le fasi di collo di bottiglia. Questa riserva si rivela utile durante le corse notturne e i colli di bottiglia della rete.

Classi di archiviazione cloud nel mix di backup

Per le copie esterne utilizzo classi compatibili con S3, per cui Standard è la scelta migliore per un recupero rapido. L'accesso non frequente consente di risparmiare sui costi di gestione, ma richiede tempi di recupero più lunghi ed eventualmente spese di recupero. Le classi di archivio sono adatte per l'archiviazione legale, non per i ripristini critici in termini di tempo. Combino le istantanee NVMe locali con lo standard S3 per le copie fresche e sposto le versioni più vecchie in classi più favorevoli. Una buona introduzione ai concetti è fornita da Storage a oggetti nell'hosting, che spiega chiaramente i vantaggi e gli svantaggi.

RAID e file system: velocità e protezione

I layout RAID influenzano l'effettivo Tasso di backup perché la dimensione dello stripe e il parallelismo soddisfano o meno i modelli di scrittura del software. Il RAID 10 offre un elevato IOPS e solide prestazioni di scrittura, mentre il RAID 5/6 offre maggiore capacità ma scritture casuali più deboli. I moderni file system come XFS o ZFS elaborano flussi paralleli in modo efficiente e facilitano le istantanee, che possono ridurre le finestre di backup. Per gli host Linux, verifico i carichi di lavoro specifici e poi scelgo il file system. Un breve aiuto alla decisione è fornito da ext4, XFS o ZFS con note di esecuzione per gli scenari più comuni.

Esempio pratico: 100 GB calcolati in cifre

Supponiamo di eseguire il backup di 100 GB non compressi ad una velocità netta di 2.000 MB/s su NVMe, la durata è di circa 50 secondi. Su un'unità SSD SATA con 500 MB/s, sono necessari circa 3,3 minuti, più l'overhead per checksum e metadati. Se utilizzo una compressione 2:1 e la CPU mantiene la velocità, il tempo richiesto spesso si dimezza. Le cose si fanno difficili quando la CPU o la rete non riescono a tenere il passo: Un collegamento da 10 GbE è limitato a 1.000-1.200 MB/s netti, indipendentemente dalla velocità dell'unità. Ecco perché eseguo test end-to-end e non isolati, al fine di determinare la velocità reale di un'unità. Tempo di backup per pianificare in modo sicuro.

Rete e software: il freno spesso trascurato

Il software di backup decide in che misura posso utilizzare i vantaggi di NVMe a tutti. Le pipeline single-thread difficilmente saturano i supporti veloci, mentre l'I/O multi-stream e asincrono aumenta significativamente la velocità. La deduplicazione risparmia la trasmissione e la memoria, ma costa CPU e IOP casuali, il che fa consumare rapidamente le SSD poco costose. La crittografia TLS protegge i dati ma richiede anche potenza di calcolo; AES-NI e l'offload hardware aiutano in questo caso. Pertanto, controllo in parallelo: flussi, compressione, dedup e crittografia, e adatto la pipeline al supporto di destinazione invece di adottare ciecamente i valori predefiniti.

Controllo dei costi: euro per minuto risparmiato

Mi piace fare un calcolo a ritroso: se NVMe fa risparmiare in media 2,5 minuti al giorno rispetto a un'unità SSD SATA da 100 GB, questo si aggiunge a circa 75 minuti al mese e 15,6 ore all'anno, per Server. Con una tariffa oraria di 50 euro per il tempo operativo o i costi di opportunità, ciò equivale a 780 euro all'anno; in molte configurazioni, i vantaggi superano notevolmente il costo aggiuntivo di una soluzione NVMe. Ne beneficiano soprattutto i sistemi critici con finestre di backup ridotte, perché i ritardi si trasformano immediatamente in rischi di RTO. Chiunque conservi archivi può aggiungere classi di storage a oggetti convenienti, riducendo così i costi dei supporti. Questa visione aiuta a sostenere economicamente le decisioni al di là delle cifre dei MB/s.

Utilizzate le funzioni di sicurezza senza perdere velocità

Backup immutabili con Blocco oggetto proteggere da manomissioni, ransomware e cancellazioni accidentali. Creo snapshot su sorgenti NVMe, li esporto dedicati e li trasferisco con throttling in modo che l'IO di produzione non venga rallentato. Il versioning in S3 consente di creare punti di ripristino a grana fine che invecchio con le regole del ciclo di vita. La crittografia a riposo e in transito rimane obbligatoria; tuttavia, misuro i costi della CPU e seleziono parametri che rispettino le finestre di backup. In questo modo, la sicurezza non è un freno, ma parte della routine pianificabile.

Strategia di migrazione senza rischi di inattività

Quando si passa da un'unità SSD SATA a NVMe Per prima cosa eseguo il backup dello status quo, creo dei test e misuro i tempi end-to-end. Quindi migro i carichi di lavoro su base mobile, iniziando dalle finestre di backup più grandi, in modo che gli effetti siano immediatamente visibili. Le istantanee e la replica riducono i tempi di passaggio; pianifico la sovrapposizione fino a quando i nuovi lavori funzionano in modo stabile. Le strategie di backoff impediscono a diversi lavori di grandi dimensioni di generare picchi nello stesso momento. La documentazione e un breve percorso di rollback assicurano l'operatività se le prime notti non sono all'altezza.

Configurazione che consente la velocità

Ho impostato la profondità della coda e il parallelismo in modo tale che la coda Code di IO delle unità NVMe sono utilizzate, ma non sovraccaricate. Le dimensioni dei blocchi più grandi sono utili per i backup completi, mentre i blocchi più piccoli e i flussi più numerosi accelerano le esecuzioni incrementali. La cache write-through vs. write-back e gli intervalli di flush influenzano la latenza e la consistenza; l'uso previsto è quello che conta. Il monitoraggio dei tempi di attesa dell'I/O, del consumo di CPU e dei buffer di rete rivela tempestivamente i colli di bottiglia. Uso questi segnali per affinare gradualmente la pipeline invece di rischiare grandi balzi.

Implementare correttamente la coerenza delle applicazioni e gli snapshot

I supporti veloci sono poco utili se i dati sono incoerenti. Per ottenere backup coerenti con l'applicazione, stabilizzo in modo specifico i database e i servizi prima dell'istantanea: pre-/post-hooks per gelo/disgelo, brevi intervalli di flush e scritture di journal evitano le pagine sporche. In Linux utilizzo snapshot LVM o ZFS, con XFS se necessario. xfs_freeze, con Windows VSS. Per i database vale quanto segue: eseguire il backup dei log write-ahead e documentare la catena di ripristino. Le macchine virtuali ricevono snapshot in quiescenza con gli agenti guest; in questo modo lo stato del file system e delle applicazioni rimane coerente. Il risultato: meno sorprese nel ripristino e RPO affidabili senza estendere inutilmente la finestra di backup.

Esercitazioni di verifica e ripristino: la fiducia si crea al ritorno

Controllo sistematicamente che i backup siano leggibili e completi. Questo include checksum end-to-end, controlli di catalogo/manifesto e ripristini casuali in un ambiente di destinazione isolato. Le esercitazioni mensili di ripristino per i servizi critici misurano gli RTO reali e rilevano gli errori di schema o di autorizzazione. Le scansioni regolari dell'integrità sono obbligatorie per i repository deduplicati; lo storage di oggetti beneficia di ETag-confronti e scrubbing periodico. I risultati finiscono in un runbook: Quali fasi, quale obiettivo, quale durata. In questo modo il ripristino si trasforma da caso eccezionale a routine e gli investimenti in NVMe mostrano i loro vantaggi nel momento della verità.

Dettagli hardware: tipo di NAND, TBW, PLP ed effetti termici

Non tutti gli NVMe sono uguali: i modelli TLC mantengono velocità di scrittura elevate più a lungo dei QLC, la cui cache SLC si esaurisce più rapidamente sotto carico continuo. Nei backup con lunghe scritture sequenziali, questo può dimezzare la velocità netta non appena si verifica il throttling termico. Presto attenzione a un raffreddamento sufficiente, ai dissipatori e al flusso d'aria per evitare il throttling. Le unità Enterprise con protezione dalla perdita di potenza (PLP) proteggono i dati in caso di interruzione dell'alimentazione e garantiscono latenze più costanti. Ho impostato la cifra chiave TBW (Total Bytes Written) in relazione al mio volume di backup giornaliero per mantenere l'usura calcolabile. In questo modo la pipeline rimane stabile, non solo nel benchmark, ma notte dopo notte.

Scalare la pipeline di backup

Con l'aumento del numero di host, l'orchestrazione diventa fondamentale. Scagliono gli orari di avvio, limito i backup completi simultanei e riservo delle fasce orarie per ogni client. Un sistema NVMe supportato Zona di atterraggio-La cache sul server di backup bufferizza i picchi più elevati e smista i dati in modo asincrono nell'archiviazione a oggetti. Gli algoritmi di condivisione equa e i limiti di velocità IO impediscono a un singolo lavoro di consumare tutte le risorse. Aumento i flussi paralleli solo fino a quando la sorgente, la destinazione e la rete riescono a tenere il passo; oltre la saturazione, la latenza aumenta e la velocità netta diminuisce. L'obiettivo è una curva di utilizzo regolare invece di picchi notturni: in questo modo mantengo gli SLA anche se interviene un ripristino inaspettato.

Messa a punto della rete e del sistema operativo per velocità elevate

Per 10-25 GbE, ottimizzo MTU (jumbo frame, se possibile end-to-end), buffer TCP, scaling lato ricezione e affinità IRQ. Gli stack moderni beneficiano di io_uring o I/O asincrono; questo riduce l'overhead delle syscall e aumenta il parallelismo. Scelgo un metodo di controllo della congestione TCP che si adatti alla mia latenza e uso flussi multipli per utilizzare percorsi ad alto BDP. Sul lato CPU, AES-NI e possibilmente livelli di compressione che si adattino al clock del core aiutano (ad esempio, i livelli medi sono spesso il miglior rapporto tra throughput e ratio). Importante: non ottimizzare da un lato e creare colli di bottiglia dall'altro: la misura end-to-end rimane la linea guida.

Note specifiche sul carico di lavoro: Database, macchine virtuali e container

Eseguo il backup dei database su base log e a orari precisi: il backup di base e la registrazione continua dei log riducono l'RPO quasi a zero e accelerano i ripristini. Per le macchine virtuali, il tracciamento dei blocchi di modifica e i metodi di quiescenza basati su agenti valgono oro perché catturano con precisione le modifiche incrementali del volume. Negli ambienti container, separo i dati del piano di controllo (ad esempio i metadati del cluster) dai volumi persistenti; le istantanee tramite i driver CSI sui backend NVMe accorciano notevolmente le finestre di backup. Denominatore comune: la coerenza dell'applicazione prima delle prestazioni grezze. Solo quando la semantica è corretta vale la pena di sfruttare tutto il potenziale del throughput e degli IOPS di NVMe.

Regole e conformità: 3-2-1-1-0 in pratica

Operativamente stabilisco la regola 3-2-1-1-0: tre copie, due tipi di supporto, una fuori sede, una immutabile, zero errori non controllati. In termini concreti, ciò significa: copia snapshot NVMe locale, copia secondaria su uno storage separato (RAID diverso/zona di disponibilità diversa) e offsite in S3 con blocco dell'oggetto. Le politiche del ciclo di vita mappano i periodi di conservazione, i mandati di conservazione legale non sono influenzati dalle operazioni di eliminazione. I checksum regolari e i ripristini di prova forniscono lo „0“. Questo rende le misure tecniche conformi e verificabili, senza superare le finestre di backup.

Benchmarking senza errori di misura

Una misurazione corretta significa una misurazione riproducibile. Scelgo le dimensioni dei blocchi e le profondità delle code in base all'obiettivo (ad esempio, 1-4 MB per i backup completi sequenziali, 4-64 KB con un parallelismo maggiore per gli incrementi). Tengo conto delle cache e del precondizionamento per visualizzare gli effetti della cache SLC. Riscaldamento, Il test „dd“, la durata uniforme del test e la valutazione delle latenze P99 mostrano se i picchi sono imminenti. Il test "dd" con la cache del sistema operativo fornisce valori fittizi; i modelli di I/O asincrono simili al software di backup sono significativi. In parallelo, registro la CPU, le attese di I/O e la rete, in modo che sia chiara la causa, non solo il sintomo.

Pianificazione della capacità e dei costi nel tempo

I backup crescono gradualmente: nuovi clienti, database più grandi, più file. Pianifico la capacità in tre dimensioni: Throughput (MB/s per finestra), IOPS/latenza (per metadati e file di piccole dimensioni) e requisiti di storage (primario, offsite, immutabile). Su NVMe dimensiono 20-30% di riserva per i picchi, su S3 considero i costi di recupero e la potenziale replica cross-region per i casi di disastro. Una landing zone supportata da NVMe consente una deduplicazione/compressione aggressiva nel follow-up e riduce i costi di archiviazione degli oggetti. Importante: verificate le tendenze mensili e definite i valori soglia che attivano per tempo gli aggiornamenti dell'hardware o della rete.

Quale piattaforma è adatta al mio obiettivo?

Per gli ambienti di hosting produttivi, verifico se il provider NVMe RAID, istantanee e connessione S3. I dettagli decisivi sono la generazione PCIe, le corsie disponibili, la larghezza di banda di rete e gli obiettivi offsite affidabili. Un confronto tra le offerte attuali mostra rapidamente se le tariffe pubblicizzate sono realisticamente raggiungibili o se si tratta solo di valori di picco. Se volete orientarvi, potete confrontare i dati principali con le misurazioni pratiche e valutare i backup di prova. In questo modo, evito investimenti sbagliati e do la priorità ai componenti che riducono effettivamente il tempo di backup.

Piano da portare via

Per prima cosa, misuro il tempo effettivo per ogni lavoro e registro RTO e i requisiti di RPO per ogni servizio. Identifico quindi il collo di bottiglia: storage, CPU, rete o pipeline software. Quindi eseguo aggiornamenti mirati: NVMe per i dati primari e la cache di backup, 10-25 GbE nel core, multi-stream e compressione in base alla CPU. Seguono test di ripristino, che ripeto mensilmente, e un piano del ciclo di vita per le copie offsite. Per ulteriori informazioni sul contesto, vale la pena di dare un'occhiata alla panoramica compatta di NVMe/SSD/HDD, che confronta brevemente prestazioni, costi e campi di applicazione.

Riassumendo brevemente

NVMe abbreviato Tempi di backup evidente: maggiore throughput, molti più IOPS, latenza significativamente inferiore. I backup completi beneficiano della velocità sequenziale, quelli incrementali dell'accesso casuale veloce. Le classi cloud integrano gli snapshot NVMe locali se voglio mantenere RTO e costi equilibrati. Il layout RAID, il file system, la rete e il software determinano se l'hardware mostra il suo potenziale. Misurando sistematicamente, eliminando i colli di bottiglia e regolando la pipeline, è possibile ottenere backup affidabili di classi di storage con finestre temporali prevedibili.