Multiplexing HTTP/2 raggruppa molte richieste in un unico collegamento ed elimina i blocchi a livello di protocollo. Tuttavia, nelle reti reali, il TCP Head-of-Line, il TLS Overhead e la priorità inadeguata rallentano il sistema, quindi HTTP/2 non funziona automaticamente più velocemente di HTTP/1.1.

Punti centrali

- Multiplexing parallelizza molte richieste su una singola connessione TCP.

- TCP-HoL rimane attivo e interrompe tutti gli streaming in caso di perdite.

- Configurazione TLS può rallentare notevolmente il tempo di risposta del primo byte.

- Priorità e Server Push funzionano solo con una configurazione corretta.

- Tipo di pagina decide: tanti file piccoli contro pochi file grandi.

Come funziona internamente il multiplexing HTTP/2

Scomponi ogni risposta in piccole parti Frames, li numero e li assegno a flussi logici, in modo che più risorse possano essere gestite contemporaneamente tramite un'unica connessione. In questo modo evito blocchi a livello HTTP, poiché nessuna richiesta deve più attendere la fine di un'altra. I browser inviano HTML, CSS, JS, immagini e font in parallelo, riducendo i costi di connessioni aggiuntive. HPACK riduce le dimensioni degli header, alleggerendo notevolmente il carico in caso di molti file di piccole dimensioni. Tuttavia, rimane fondamentale il fatto che tutti i flussi condividono la stessa linea TCP, il che crea vantaggi ma anche nuove dipendenze. Questa architettura garantisce velocità fintanto che la rete rimane stabile e la Definizione delle priorità funziona in modo sensato.

HTTP/1.1 vs. HTTP/2: differenze fondamentali

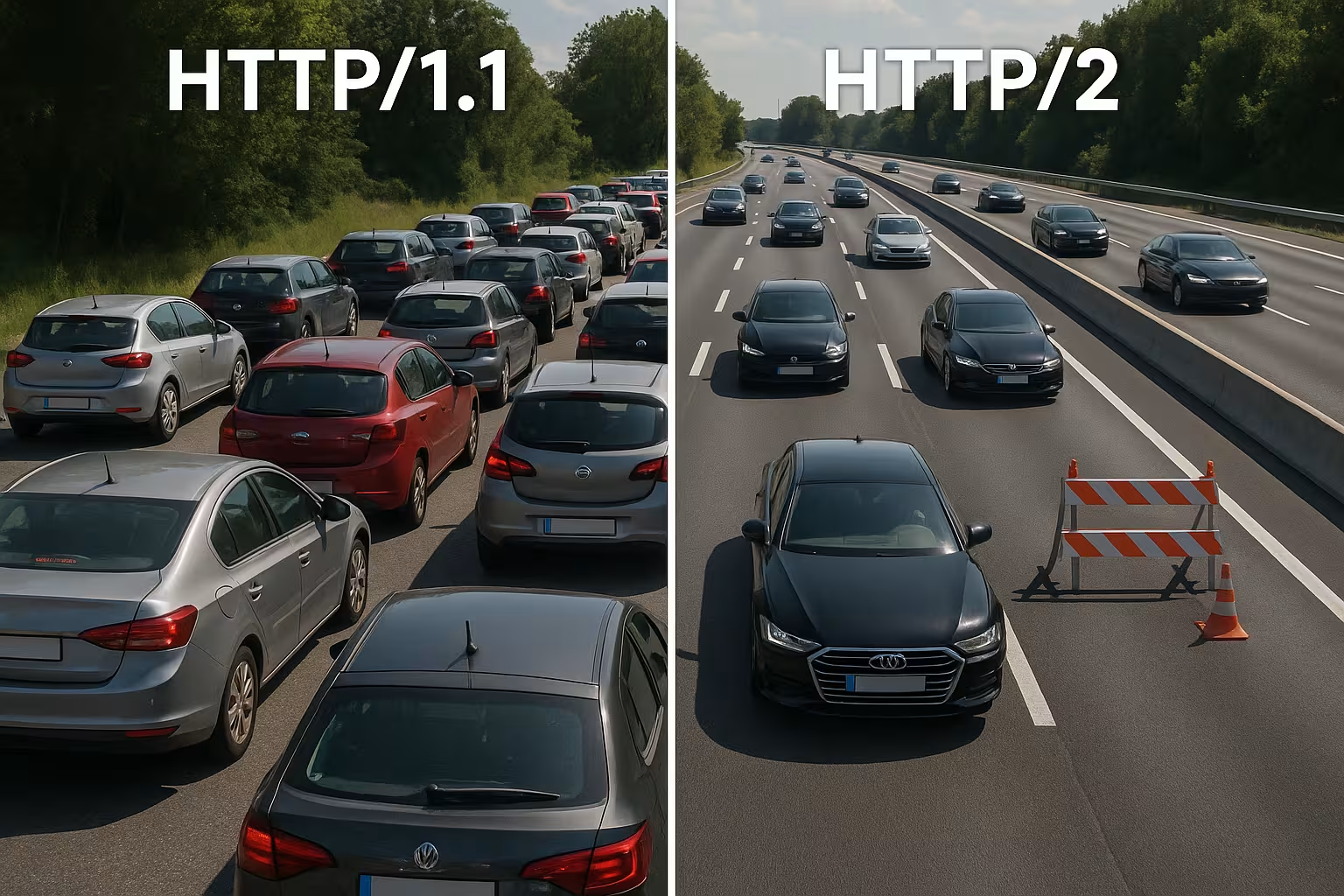

HTTP/1.1 si basa su messaggi testuali e più connessioni parallele per host per caricare le risorse contemporaneamente, aumentando gli handshake e il sovraccarico. HTTP/2 funziona in modo binario, utilizza un'unica connessione per tutto e comprime le intestazioni, riducendo i tempi di attesa, soprattutto in presenza di molti oggetti. Nei diagrammi a cascata, le lunghe code scompaiono perché i flussi procedono in parallelo. In cambio, il collo di bottiglia si sposta dal livello HTTP al livello TCP, cosa che noto chiaramente su reti instabili. Le pagine piccole e fortemente memorizzate nella cache spesso non registrano quasi nessun vantaggio rispetto alla versione 1.1, mentre le pagine grandi e ricche di risorse ne traggono benefici più evidenti. Queste differenze influenzano la mia Strategia di ottimizzazione e giustificano una decisione specifica per il progetto.

Scegliere correttamente il controllo di flusso e le dimensioni delle finestre

HTTP/2 offre un controllo del flusso specifico per ogni stream e ogni connessione. Presto attenzione a valori significativi per DIMENSIONE INIZIALE DELLA FINESTRA e il numero di stream simultanei, in modo che la linea non sia né congestionata né sottoutilizzata. Finestre troppo piccole generano un numero inutile di WINDOW_UPDATE-frame e riducono la velocità di trasmissione dati, finestre troppo grandi possono sovraccaricare i client più deboli. Nelle reti con un elevato prodotto larghezza di banda-ritardo (BDP), aumento in modo mirato la dimensione della finestra, in modo che le risposte di grandi dimensioni non rimangano bloccate nello stop-and-go. Allo stesso tempo, limito MAX_CONCURRENT_STREAMS Pragmatico: parallelismo sufficiente per gli elementi critici per il rendering, ma non tanto da rallentare l'immagine LCP con dettagli insignificanti. Queste regolazioni sono minime, ma hanno un grande effetto sui tempi di caricamento effettivi se sono adeguate al sito e alla rete.

Rivalutare il domain sharding e il bundling

Molte ottimizzazioni 1.1 sono controproducenti con HTTP/2. Elimino il vecchio domain sharding perché una singola connessione ben utilizzata è più efficiente di socket distribuiti artificialmente. Metto in discussione anche l'aggro bundling di JavaScript in mega file: bundle più piccoli e separati logicamente consentono cache mirate ed evitano che, in caso di modifica, sia necessario ritrasmettere l'intera app. Gli sprite delle immagini stanno perdendo importanza perché le richieste parallele sono diventate economiche e i formati di immagine moderni, compresa la cache, funzionano meglio. Quindi, elimino dove il multiplexing può essere vantaggioso e raggruppo solo se semplifica davvero l'architettura o aumenta in modo misurabile il tasso di successo della cache.

Coalescenza delle connessioni e certificati

HTTP/2 consente ai browser di utilizzare una connessione per più nomi host se i certificati e il DNS corrispondono. Pianifico le voci SAN e SNI in modo da rendere possibile il coalescing ed eliminare handshake aggiuntivi. Se ALPN e Cipher Suite corrispondono, il client può CSS da cdn.esempio.com e immagini di static.example.com tramite la stessa linea. Ciò consente di risparmiare RTT, semplifica la prioritizzazione e aumenta la possibilità che le risorse critiche arrivino a destinazione senza deviazioni. Verifico questi effetti in modo mirato nella scheda Rete: viene utilizzato davvero un solo socket o i limiti dei certificati e le politiche costringono il browser a stabilire nuove connessioni?

Perché il multiplexing viene rallentato: TCP Head-of-Line

Se un pacchetto viene perso sull'unica connessione TCP, l'intera linea rimane in attesa fino all'arrivo della ritrasmissione, interrompendo temporaneamente tutti i flussi HTTP/2. Nelle reti mobili con latenza variabile e tasso di perdita elevato, vedo quindi regolarmente vantaggi minori o addirittura svantaggi rispetto a più connessioni 1.1. Questo effetto spiega perché il multiplexing è eccellente sulla carta, ma non sempre funziona nella pratica. Le misurazioni effettuate dalla ricerca e sul campo mostrano esattamente questa correlazione nelle reti reali [6]. Pertanto, pianifico le implementazioni in modo conservativo, eseguo test sui percorsi tipici degli utenti e verifico gli effetti per ogni gruppo target. Chi ignora il TCP-HoL spreca Prestazioni e può addirittura prolungare i tempi di caricamento.

TLS Handshake, TTFB e tipo di pagina

HTTP/2 funziona sul web quasi esclusivamente tramite TLS, il che genera handshake aggiuntivi e può prolungare notevolmente il time-to-first-byte con pochi asset. Se consegno solo un file di grandi dimensioni, il vantaggio del multiplexing svanisce perché non è necessaria alcuna trasmissione parallela. Le pagine con dieci-venti file di piccole dimensioni ne traggono maggiori vantaggi, mentre le risposte con una sola risorsa sono spesso alla pari con HTTP/1.1. Riduco il sovraccarico con TLS 1.3, Session Resumption e Keep-Alive pulito, in modo da eliminare le riconnessioni e mantenere realmente attiva una linea. Per il controllo di precisione mi affido a Ottimizzazione Keep-Alive, per impostare Reuse, Idle‑Timeouts e Limits in base al carico. In questo modo si riduce la percentuale di handshake e la TTFB si stabilizza anche nei picchi di traffico.

CDN e catene proxy: h2 fino all'origine

Molti stack terminano TLS all'edge e continuano a comunicare con l'origine. Verifico se anche tra CDN e backend viene utilizzato HTTP/2 o se si verifica un fallback a HTTP/1.1. I proxy di bufferizzazione possono in parte annullare i vantaggi (compressione dell'intestazione, prioritizzazione) se riserializzano le risposte o modificano l'ordine. Ottimizzo quindi end-to-end: edge node, proxy intermedio e origine dovrebbero comprendere h2, utilizzare dimensioni di finestra adeguate e non ignorare le priorità. Laddove h2c (HTTP/2 senza TLS nella rete interna) è utile, verifico se consente di risparmiare latenza e CPU senza violare le politiche di sicurezza. Solo una catena coerente sviluppa il MultiplexingEffetto completo.

Utilizzare correttamente le priorità

Classifico le risorse critiche in modo che HTML, CSS e l'immagine LCP arrivino per prime e i blocchi di rendering vengano eliminati. Senza priorità chiare, gli script meno importanti consumano preziosa larghezza di banda, mentre i contenuti above the fold rimangono in attesa. Non tutti i server rispettano correttamente le priorità del browser e alcuni proxy modificano l'ordine, motivo per cui valuto i dati dei risultati invece delle aspirazioni [8]. L'intestazione Preload e un riferimento immagine posizionato in alto riducono i percorsi di caricamento e aumentano la percentuale di successo nella cache. La prioritizzazione non fa miracoli, ma dirige la connessione in modo che gli utenti vedano rapidamente ciò di cui hanno bisogno. Regole chiare portano a risultati tangibili. Spinta e rendono il multiplexing davvero efficace.

Priorità nella pratica: priorità estensibili

I browser hanno ulteriormente sviluppato i loro modelli di prioritizzazione. Tengo conto del fatto che i client moderni utilizzano spesso „priorità estensibili“ invece di pesi rigidi ad albero. In questo modo segnalano l'urgenza e i parametri progressivi per ogni flusso, che i server devono interpretare e tradurre in scheduler equi. Verifico se il mio server rispetta questi segnali o si basa sul vecchio comportamento. Nei test A/B confronto i percorsi di caricamento con e senza prioritizzazione lato server per identificare eventuali effetti di soppiantamento. Importante: la prioritizzazione deve privilegiare gli elementi critici per il rendering, ma non deve portare alla saturazione dei download di lunga durata. Un mix accurato evita i picchi e mantiene libera la pipeline per i contenuti visibili.

Server Push: raramente l'abbreviazione

Utilizzo il server push solo in modo mirato, perché l'over-pushing occupa larghezza di banda e ignora le cache del browser. Se una risorsa già memorizzata nella cache viene sottoposta a push, il percorso rallenta invece di diventare più veloce. Molti team hanno disattivato nuovamente il push e utilizzano il preload, che è molto più affidabile [8]. In casi particolari, ad esempio su percorsi ricorrenti con schemi chiari, il push può essere utile, ma ne dimostro l'effetto con valori misurati. Senza prove, rimuovo il push e mantengo la pipeline libera per i dati realmente necessari. In questo caso, spesso meno è meglio. di più, proprio sull'unico collegamento.

Confronto pratico: quando HTTP/1.1 può essere più veloce

Ritengo che HTTP/1.1 sia competitivo quando predominano pochi file di grandi dimensioni o quando le reti operano con perdite elevate. In tal caso, più connessioni separate distribuiscono il rischio e possono ridurre i tempi di primo byte. Su pagine molto piccole, gli handshake TLS aggiuntivi spesso compensano completamente i vantaggi del multiplexing. Con molti oggetti di piccole dimensioni, invece, HTTP/2 ha la meglio grazie alla compressione, alla prioritizzazione e a un unico socket. La seguente panoramica mostra modelli tipici tratti da audit e test sul campo che guidano la mia scelta del protocollo [6][8]. Questa griglia non sostituisce i test, ma fornisce una solida Orientamento per le prime decisioni.

| Scenario | Protocollo migliorato | Motivo |

|---|---|---|

| Molti piccoli asset (CSS/JS/immagini/font) | HTTP/2 | Il multiplexing e l'HPACK riducono il sovraccarico, è sufficiente una sola connessione |

| Pochi file di grandi dimensioni | HTTP/1.1 ≈ HTTP/2 | Parallelismo quasi superfluo; i costi dell'handshake hanno un peso maggiore |

| Reti mobili instabili con perdite | HTTP/1.1 in parte migliore | TCP-HoL interrompe tutti gli stream con HTTP/2; l'uso di più socket può essere d'aiuto |

| TLS ottimizzato (1.3, ripresa), priorità chiare | HTTP/2 | Configurazione ridotta, gestione mirata della larghezza di banda |

| Over-Pushing attivo | HTTP/1.1/HTTP/2 senza push | I dati non necessari intasano la linea; il precaricamento è più sicuro |

Best practice per ottenere reali guadagni in termini di tempo di caricamento

Riduco i byte prima del protocollo: immagini in WebP/AVIF, dimensioni adeguate, script economici e header di caching puliti. Mantengo piccole le parti critiche del percorso CSS, carico i font in anticipo e imposto dei fallback per evitare cambiamenti di layout. Per la connessione e il DNS utilizzo Preconnect e DNS-Prefetch, in modo che gli handshake inizino prima che il parser incontri la risorsa. Brotli per i contenuti di testo accelera le richieste ricorrenti, in particolare tramite CDN. Controllo gli effetti nella cascata e confronto LCP, FID e TTFB prima e dopo le modifiche. I valori misurati guidano la mia Priorità, l'istinto no.

Casi gRPC, SSE e streaming

HTTP/2 mostra i suoi punti di forza soprattutto con gRPC e altri flussi bidirezionali o di lunga durata. Presto attenzione ai timeout, alle dimensioni dei buffer e alle regole di backlog, in modo che uno stream lento non penalizzi tutte le altre richieste. Per gli eventi inviati dal server e i feed live è utile una connessione stabile e permanente, purché il server gestisca correttamente le priorità e i limiti di keep-alive non entrino in vigore troppo presto. Allo stesso tempo, verifico il comportamento in caso di errore: la ricostruzione degli stream, il backoff esponenziale e limiti ragionevoli per le riconnessioni impediscono picchi di carico quando molti client si disconnettono e si riconnettono contemporaneamente. In questo modo, gli scenari in tempo reale rimangono prevedibili.

Ottimizzazione OS e TCP per prestazioni di multiplexing stabili

La scelta del protocollo non può compensare una configurazione di rete inadeguata. Verifico gli algoritmi di controllo della congestione (ad es. BBR vs. CUBIC), i buffer dei socket, le politiche TCP Fast Open e la dimensione della finestra di congestione iniziale. Un controllo della congestione adeguato al percorso può ridurre le ritrasmissioni e attenuare gli effetti HoL. Altrettanto importante: valori MTU/MSS corretti per evitare la frammentazione e perdite evitabili. A livello TLS, preferisco catene di certificati brevi, OCSP stapling e certificati ECDSA perché accelerano l'handshake. Nel loro insieme, queste impostazioni forniscono al multiplexing il necessario Sottostruttura, affinché la prioritizzazione e la compressione dell'intestazione possano svolgere la loro funzione.

Strategia di misurazione e KPI nella quotidianità

Non mi affido ai valori mediani, ma guardo i valori p75/p95 delle metriche, suddivisi per dispositivo, tipo di rete e posizione. I test sintetici forniscono valori di base riproducibili, mentre il monitoraggio degli utenti reali mostra la dispersione sul campo. Confronto i grafici a cascata dei percorsi chiave, controllo gli early byte dell'HTML, l'ordine dei CSS/JS e il tempo di arrivo dell'immagine LCP. Implemento le modifiche come esperimenti controllati e osservo parallelamente TTFB, LCP e tassi di errore. Importante: rimuovo le priorità senza benefici misurabili. In questo modo la configurazione rimane snella e investo in regolazioni che consentono di risparmiare tempo in modo statisticamente comprovato.

Traffico crawl e bot

Oltre agli utenti, anche i crawler traggono vantaggio da un HTTP/2 pulito. Attivo h2 per gli endpoint rilevanti e osservo se i bot riutilizzano la connessione e recuperano più pagine nello stesso tempo. Cascate 301 inutili, risposte non compresse o limiti Keep-Alive troppo brevi consumano il budget di scansione. Concordo le politiche in modo che il multiplexing funzioni anche qui, senza superare i limiti del backend. Risultato: scansioni più efficienti e maggiore stabilità sotto carico.

HTTP/2, HTTP/3 e ciò che conta dopo

HTTP/3 si basa su QUIC su UDP e risolve il blocco TCP Head-of-Line, il che è particolarmente utile in termini di mobilità e perdite [6]. La connessione viene stabilita più rapidamente e i blocchi di streaming non interessano più tutte le richieste contemporaneamente. Nelle flotte miste, HTTP/2 rimane importante, ma io attivo HTTP/3 laddove i client e i CDN lo supportano già. Confronto dettagliato come HTTP/3 vs. HTTP/2 mi aiutano a pianificare i rollout in modo graduale e in base al target. Effettuo misurazioni separate per sede, dispositivo e tipo di rete, in modo che gli utenti reali possano trarne vantaggio. Utilizzo i protocolli per Tempi di caricamento nelle situazioni quotidiane.

Hosting e infrastruttura come acceleratori

I protocolli efficaci non possono compensare un'infrastruttura inadeguata, pertanto esamino attentamente la posizione, il peering, la CPU, la RAM e i limiti I/O. Un server web moderno, un numero adeguato di worker e un livello di cache impediscono che l'unica connessione diventi un collo di bottiglia. L'uso strategico della CDN riduce l'RTT e attenua i picchi di carico. Chi serve utenti in tutta Europa spesso trae maggiori vantaggi dalle distanze brevi che dalla messa a punto dei protocolli. Pianifico la capacità con riserve, in modo che il traffico di picco non metta in ginocchio il sistema. In questo modo il multiplexing sviluppa tutto il suo potenziale. Potenziale affidabile.

Riconoscere rapidamente i modelli di errore

Se HTTP/2 sembra più lento del previsto, cerco modelli tipici: un unico trasferimento lungo che ne blocca molti altri più piccoli; priorità ignorate; elevati tassi di ritrasmissione su tratte mobili; o ripresa TLS che non funziona. Poi confronto HTTP/2 e HTTP/1.1 in condizioni identiche, separo l'influenza della CDN dall'origine e guardo il numero di socket, il numero effettivo di stream e la sequenza dei primi kilobyte. Se trovo un collo di bottiglia, prima modifico le impostazioni di base (byte, caching, handshake), prima di lavorare sul controllo di flusso o sulle priorità. Questa sequenza garantisce i miglioramenti più affidabili.

Sintesi pratica per decisioni rapide

Utilizzo il multiplexing HTTP/2 quando ci sono molti oggetti, le priorità sono attive e TLS è configurato correttamente. Con pochi file di grandi dimensioni o reti instabili, calcolo vantaggi minimi e tengo d'occhio i risultati 1.1. Utilizzo il server push solo con evidenza, il preload quasi sempre e mantengo basso il sovraccarico tramite compressione, caching e connessioni anticipate. Le misurazioni con dispositivi e posizioni reali confermano le mie ipotesi prima di implementare le modifiche su larga scala [6][8]. Alla fine, ciò che conta non è il numero di protocollo, ma la velocità percepibile dagli utenti reali. Chi procede in questo modo ottiene risultati affidabili da HTTP/2. Velocità e getta le basi per HTTP/3.