Confronto HTTP/3 Push e Preload sulla base di valori reali misurati e spiego quando la tecnologia è la più efficiente. Prestazioni http3 notevolmente in avanti. Per fare ciò, analizzo i vantaggi di QUIC, le priorità di caricamento e i tipici errori di implementazione che riguardano il First Paint e il Render freni.

Punti centrali

Riassumo i seguenti punti chiave in modo che possiate scegliere rapidamente tra spinta e precarico. categorizzare può.

- HTTP/3QUIC elimina i blocchi di testa della linea e mantiene i flussi senza problemi in caso di perdite.

- SpingereLa consegna proattiva è utile per gli asset principali altamente probabili, ma comporta spese generali.

- PrecaricoDichiarativo, controllabile, a basso rischio con priorità alle risorse critiche.

- Valori misuratiI vantaggi di HTTP/3 sono chiaramente evidenti con la perdita di pacchetti e molte risorse.

- StrategiaLa combinazione di preload e HTTP/3 spesso ottiene i migliori risultati nella pratica.

HTTP/3 Push e Preload spiegati brevemente

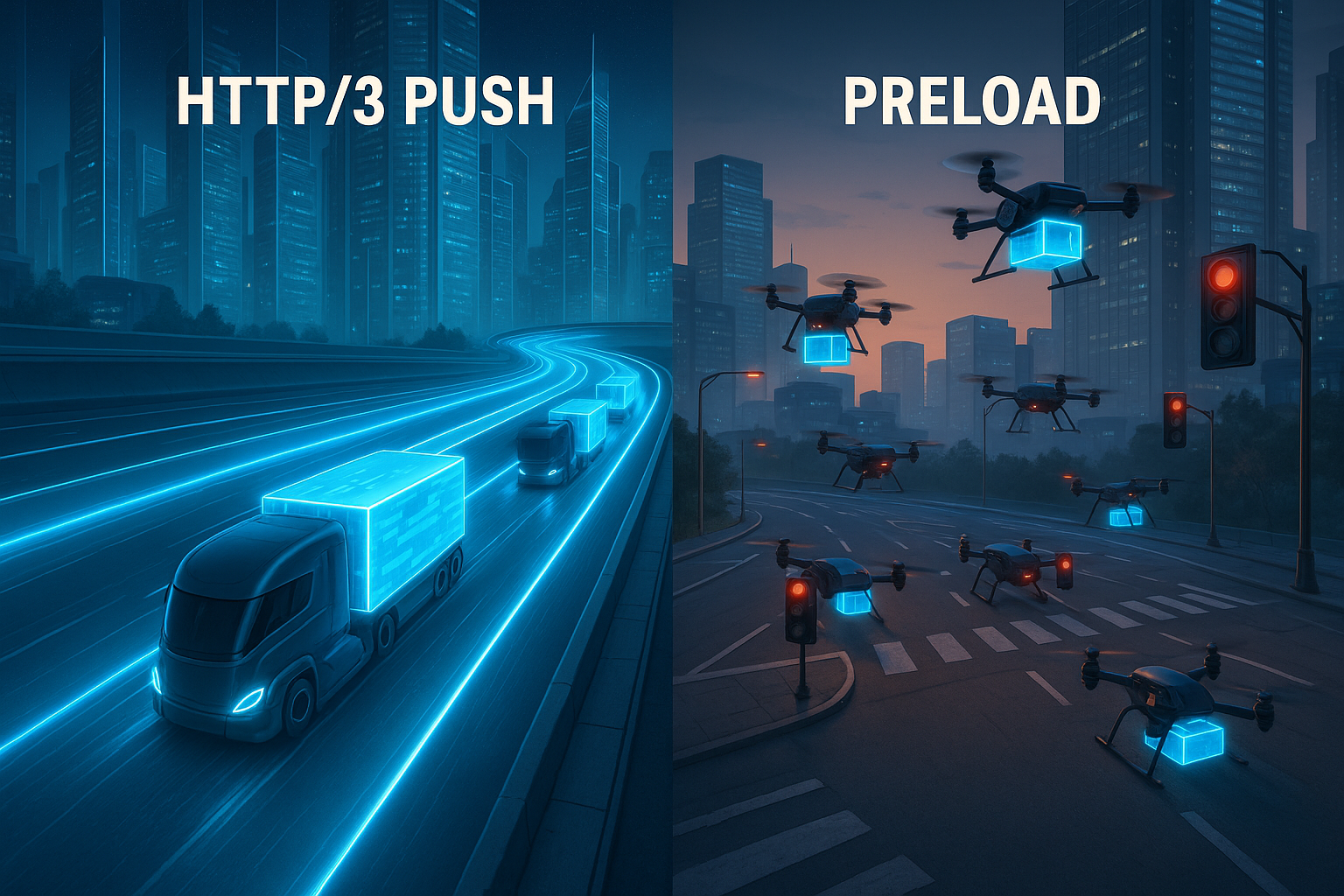

Ho impostato Server Push quando il server fornisce i file prima che il browser li richieda, ad esempio CSS, JS o font web che sono necessari direttamente per il rendering. Questa tattica colloca le risorse nella cache in una fase iniziale, risparmia i viaggi di andata e ritorno e può favorire sensibilmente il primo Contentful Paint. Precarico d'altra parte, uso i tag di collegamento nel markup, in modo che il browser sappia esattamente quale file deve caricare per primo. In questo modo si creano chiare priorità, si riducono i trasferimenti duplicati e si lavora ugualmente bene con HTTP/1.1, HTTP/2 e HTTP/3. Poiché HTTP/3 è basato su QUIC, vale la pena di dare un'occhiata al file Protocollo QUIC, che tratta i flussi separatamente e quindi evita la congestione a livello di linea.

Come HTTP/3 influenza il tempo di caricamento

Con QUIC, HTTP/3 elimina l'obbligo di Capo linea-Il blocco, che significa che le perdite di singoli pacchetti non rallentano più il caricamento di tutti i file. Più flussi vengono eseguiti in parallelo e le perdite interessano solo il flusso interessato, il che è particolarmente utile con molte risorse. 0-RTT può accelerare le connessioni se esiste già una cronologia, consentendo alle prime richieste di fluire più velocemente. Anche il controllo della potenza di trasmissione e della correzione degli errori è adattivo, in modo da mantenere alta la velocità di clock sotto carico. Per coloro che apprezzano i confronti diretti, il HTTP/3 vs. HTTP/2 Confronto delle prestazioni prospettive aggiuntive sulla latenza e sul comportamento di trasferimento.

Spinta o precarico: Logica decisionale

Uso Spingere, quando è molto probabile che una risorsa sia necessaria immediatamente, come il foglio di stile centrale o uno script above-the-fold. In questi casi, la consegna proattiva può comportare un visibile risparmio di tempo, soprattutto sulle reti mobili. Tuttavia, se il file viene inviato anche se il client lo ha già nella cache o non ne ha affatto bisogno, si spreca larghezza di banda e si allungano le code per i dati veramente importanti. Precarico Lo uso quando voglio controllare esattamente cosa inizia con priorità e quando il parser deve vedere la richiesta. In questo modo mantengo il controllo nelle mie mani, evito trasferimenti doppi e riduco al minimo gli errori nella selezione delle risorse.

Confronto delle prestazioni in cifre

In ambienti di misura con molti download simultanei, HTTP/3 rimane significativamente più efficiente con perdite evidenti di oltre 8%. reattivo, mentre HTTP/2 diminuisce [4]. Con file da 1 MB e perdita di 2%, i test hanno mostrato tempi di caricamento di circa 1,8 secondi con HTTP/1 rispetto a 1,2 secondi con HTTP/3 [5]. Queste differenze hanno un impatto diretto su LCP, TTI e TBT, soprattutto quando una pagina richiede inizialmente molti file separati. Per le applicazioni a pagina singola e le pagine multimediali, la separazione dei flussi è particolarmente vantaggiosa, perché un asset che vacilla non blocca più gli altri. Valuto sempre i dati nel contesto dei tipi di risorse, delle priorità e degli accessi alla cache, perché è qui che si ottiene la massima leva per la gestione delle risorse. Velocità.

| Criterio | HTTP/3 Push | Precarico | Effetto sulle metriche |

|---|---|---|---|

| Sistema di controllo | Lato server, proattivo | Lato client, dichiarativo | Inizio anticipato vs. chiara definizione delle priorità |

| Rischio di doppi trasferimenti | Aumenta se la cache è già piena | Basso, come precisamente affrontato | Influenza sulla larghezza di banda e sul TBT |

| Carico di rete/perdita di pacchetti | Perdite di buffer QUIC per flusso [4] | Profitto attraverso il livello di trasporto HTTP/3 | Vantaggi di LCP/INP sotto carico |

| Tasso di risposta della cache | Gli asset spinti possono esaurirsi | Uso mirato delle cache esistenti | Riduzione dei tempi di attesa per i pazienti di ritorno |

| Sforzo di implementazione | Logica richiesta sul server | Regolazioni di markup nella testa | Profitto rapido con dipendenze chiare |

Stato del browser 2025: spinta realisticamente categorizzata

Quando pianifico, tengo conto del fatto che molti browser limitano fortemente o ignorano completamente il push nella pratica. Questo vale in particolare per gli scenari in cui i trasferimenti doppi sono imminenti o le cache sono già piene. Di conseguenza, il push rimane un'arma speciale per casi ben definiti, come le visite iniziali su nuove connessioni, e non una panacea. Nelle mie configurazioni, quindi, considero il push come un booster opzionale e mi affido principalmente al preload e alla prioritizzazione pulita a livello di trasporto. Quando i clienti non usano il push, ripiego automaticamente sul preload e sui suggerimenti precoci senza destabilizzare la pipeline. Questa sobria definizione delle priorità previene le delusioni e mantiene la tabella di marcia realistica.

Suggerimenti precoci (103) e precarico in squadra

Invece di spingere alla cieca, invio le giuste configurazioni Primi accenni (103) con Collegamento: rel=preload prima dell'HTML vero e proprio. Ciò consente al browser di avviare i file critici mentre il server sta ancora eseguendo il rendering della pagina. In questo modo si riduce il tempo fino al primo byte delle risorse e allo stesso tempo si dà al client il controllo. In pratica, questo funziona in modo affidabile con HTTP/3 e offre molti dei vantaggi del push, senza i rischi del doppio trasferimento.

HTTP/1.1 103 Primi suggerimenti

Link: ; rel=preload; as=style; fetchpriority=high

Link: ; rel=modulepreload

HTTP/1.1 200 OK

...Uso Early Hints soprattutto per il CSS principale, i font web critici e i moduli iniziali. Importante: il come-I tipi devono corrispondere esattamente, in modo da evitare richieste duplicate. Mi assicuro anche che le specifiche CORS e le intestazioni della cache siano impostate correttamente. Questo mi permette di sfruttare la maggior parte dei vantaggi di un inizio anticipato senza che il server faccia troppe congetture.

Controllo fine delle priorità: intestazione di priorità e fetchpriority

Oltre a Preload, mi affido a Segnali di priorità su due livelli:

- In HTML tramite

fetchpriority, ad esempio.fetchpriority="high"per stili o immagini critiche nella finestra di visualizzazione efetchpriority="low"per i beni decorativi. - Sulla risposta tramite un'intestazione di priorità che fornisce al trasporto informazioni chiare su quali risposte debbano avere la priorità. Ciò si armonizza con HTTP/3 e riduce il carico sulla linea quando ci sono molti flussi paralleli.

Questo è il modo in cui lavoro insieme sul lato client e server: Il browser prende rapidamente le decisioni giuste e il server le fornisce con la ponderazione adeguata. In combinazione con QUIC, questo riduce la pressione sui colli di bottiglia e impedisce ai file insignificanti di bloccare il percorso critico.

Specificare con precisione il precarico

Molti problemi con il precaricamento sono causati da piccole incoerenze. Le evito con un markup pulito ed esplicito:

.

.

Verifico costantemente che il come-corrispondono ai tipi di risorse effettive. Per i font crossorigine Obbligatorio, altrimenti si rischia di scaricare due volte. Per gli script faccio attenzione alla modalità (tipo="modulo" vs. classico) e impostare rinviare, in modo che il parser non si blocchi. Vedo il precaricamento come un'integrazione al percorso di rendering, non come una sostituzione; l'integrazione regolare rimane necessaria.

Dettagli QUIC che contano nella pratica

Pianifico HTTP/3 in vista di proprietà che si notano sul campo:

- Migrazione della connessioneSe un dispositivo passa dalla WLAN alla radio mobile, la connessione QUIC viene mantenuta. In questo modo si evitano nuovi handshake e si evita che i trasferimenti lunghi vengano annullati.

- QPACKCompressione delle intestazioni senza rischio di head-of-line globale. Questo accelera le pagine con molte piccole richieste, soprattutto su CDN con molte intestazioni ricorrenti.

- 0-RTTConsento richieste accelerate precoci solo per risorse idempotenti e valuto la situazione della sicurezza. Quando entra in vigore lo 0-RTT, guadagno un tempo considerevole durante l'avvio a caldo.

- Controllo adattativo della congestioneIl throughput rimane più stabile nelle reti con perdite. Insieme alla prioritizzazione, ciò si traduce in un comportamento robusto quando è importante.

Queste funzionalità diventano efficaci solo con una configurazione pulita di server e CDN. Garantisco TLS 1.3, catene di certificati corte, informazioni sullo stato di stacking e fallback coerenti, in modo che anche i client più vecchi possano essere serviti con prestazioni elevate.

Utilizzare correttamente la prioritizzazione delle risorse

Definisco Attività principali chiaramente: i CSS critici, i font per il testo visibile e gli script che influiscono sull'area above-the-fold. A questi file viene data la massima priorità tramite il precaricamento o vengono spinti in casi speciali. I file di immagine per i contenuti che saranno visibili in seguito hanno una priorità più bassa o vengono spostati in alto tramite il caricamento pigro, in modo che il percorso di rendering e l'interazione siano disponibili in anticipo. Per le risorse di terze parti, valuto attentamente i vantaggi e, se necessario, imposto la preconnessione, in modo che gli handshake inizino in tempo. Questo lascia la linea libera per i dati veramente importanti e impedisce alle risorse deco di bloccare l'avvio.

In pratica, mi attengo a una routine decisionale breve:

- L'asset è critico per FCP/LCP e quasi sempre necessario? → Precarico, suggerimenti precoci facoltativi; spinta selettiva solo se misurabilmente superiore.

- L'uso è variabile o dipende dall'utente? → Nessun push; al massimo si può precaricare secondo un'euristica testata o caricare a valle.

- L'asset è di grandi dimensioni? → Preferire il precaricamento; spingere solo se la larghezza di banda è assicurata e gli accessi alla cache sono improbabili.

- Esistono alternative come il CSS critico inline o la suddivisione del codice? → Preferibile; accorciano i percorsi e riducono il rischio complessivo.

Attuazione: lista di controllo dalla pratica

Inizio con un Audit della pagina iniziale e dei modelli più importanti e seleziono tutti i file necessari per la prima area visibile. Creo quindi voci di precaricamento nella testata, verifico le priorità e controllo se si verificano richieste duplicate. Quando un trasferimento anticipato è molto utile, considero il push selettivo e misuro l'effetto su LCP e TTI. Per QUIC/HTTP-3, attivo il supporto sul CDN o sul server e confronto le regole di priorità con i percorsi critici. Per l'assistenza passo-passo, utilizzo una pratica Implementazione HTTP/3, in modo che la configurazione, i test e il rollout avvengano in modo strutturato.

Stabilisco anche le seguenti routine:

- I primi suggerimenti e alimentarlo con le stesse voci di collegamento della testa HTML finale.

- Strategia di cache con il versioning:

app.abcdef.css, lungoetà massima,immutabile, in modo che i clienti che ritornano ne traggano vantaggio. - Lavoratore di servizio per precaricare i flussi in modo da evitare la duplicazione del lavoro nella rete e nella cache del SW.

- Intestazione di priorità sull'origine/CDN, in modo che HTTP/3 favorisca le risposte veramente importanti.

- Bandiere caratteristiche per push/preload per eseguire test A/B in modo rapido e senza rischi.

Errori tipici e come evitarli

Non spingo Attività, che il browser potrebbe già avere nella sua cache, in quanto ciò comporta uno spreco di banda. Invece, controllo le intestazioni della cache, la versione e la validità, in modo che gli utenti che ritornano possano beneficiare di nuove visite. Non sovraccarico Preload, perché una dozzina di voci critiche possono intasare la linea e diluire le priorità. Per quanto riguarda i font, faccio attenzione ai formati adatti e ai ranghi unicode, in modo che il trasferimento rimanga snello e il testo visibile appaia rapidamente. Eseguo anche test su diversi dispositivi e reti wireless, perché l'effetto reale diventa visibile solo in condizioni reali.

Ho messo gli occhi su queste trappole in particolare:

- Disadattamento tra

comee il tipo di risorsa (ad es.as="script"per i moduli) → porta a requisiti secondari non necessari. - Manca crossorigine per i font → download doppi o errori di blocco.

- Elenchi di precaricamento troppo ampi → minare le priorità; mi limito alle attività principali.

- Ruoli non chiari di Inline-Critical-CSS vs. Preload → Decido per pagina ed evito forme miste che gravano in entrambi i sensi.

- Spinta cieca senza conoscenza della cache → La spinta rimane una scommessa; misuro e proteggo con i primi suggerimenti.

Metodi di monitoraggio e misurazione

Misuro LCP, TTI, TBT e INP con Lighthouse, aggiungere dati di runtime tramite RUM e confrontare le varianti utilizzando test A/B. WebPageTest o strumenti simili mi aiutano ad analizzare i diagrammi a cascata e a riconoscere se il preload e il push funzionano come previsto. La combinazione di dati di laboratorio e sul campo mostra se le ottimizzazioni sono fattibili o generano effetti collaterali. Verifico regolarmente come i browser gestiscono il push del server, poiché alcuni user agent limitano o ignorano gli asset spinti [8]. Sulla base di questi dati, decido quale tecnologia implementare ulteriormente e quale ritirare.

Mi differenzio per le dichiarazioni affidabili:

- Freddo e caldoValutare la prima visita senza cache separatamente dalle visite di ritorno.

- Profili di reteSimulazione di 4G/5G con perdite realistiche, scenari ad alta velocità e celle fortemente utilizzate.

- Numero di richiesteVisualizza separatamente le pagine con pochi file di grandi dimensioni rispetto a quelle con molti file di piccole dimensioni.

- Mix di dispositiviDispositivi mobili di fascia media con una CPU più debole, perché i costi del parser e della decompressione sono più elevati.

Documento esattamente ogni esperimento: versioni di build, voci di precaricamento, intestazioni di priorità, regole di push, stato dei primi suggerimenti. Questo mi permette di riprodurre gli effetti e di invertirli rapidamente, se necessario.

Hosting e infrastruttura come leva

Presto attenzione a Server con un supporto HTTP/3 aggiornato, una solida configurazione TLS e una prioritizzazione pulita. Una CDN ad alte prestazioni con una buona copertura PoP riduce le latenze per gli utenti mobili e rende più tangibili i vantaggi di QUIC. Anche una configurazione pulita dei fallback TCP per i client più vecchi svolge un ruolo importante, in modo che nessuno sia svantaggiato. Per quanto riguarda i budget, calcolo innanzitutto l'effetto, in quanto i più piccoli aggiustamenti del CDN o le attivazioni di HTTP/3 sono spesso sufficienti senza costi aggiuntivi elevati, nell'ordine delle due cifre al mese. Più forte è la base, più chiari diventano gli effetti di push e preload nella vita quotidiana.

Verifico inoltre se l'infrastruttura supporta i seguenti punti:

- I primi suggerimenti da Edge, in modo che il precaricamento inizi prima dell'HTML.

- Priorità estensibile o intestazioni di priorità che vengono rispettate dal proxy.

- Regole a grana fine per percorso/tipo di file per spingere solo le risorse selezionate o per evidenziarle tramite il precaricamento.

- Metriche trasparenti a livello di edge (hit rate, RTT, perdita, ridefinizione delle priorità) per rendere visibili le cause delle deviazioni.

Categorizzazione finale

Vedo HTTP/3 con QUIC ha un vantaggio non appena le reti wireless, molti flussi paralleli o situazioni di perdita entrano in gioco [4][5]. Nelle configurazioni controllate, il preload fornisce una prioritizzazione affidabile, in quanto specifico esattamente cosa deve essere eseguito per primo. Uso il push specificamente per le risorse indispensabili, il cui beneficio è costante e la cui dimensione rimane entro i limiti. Ottengo l'effetto migliore quando combino il preload per le priorità, HTTP/3 per il trasporto e un push attentamente dosato. Se si procede in questo modo, si riducono sensibilmente i tempi di caricamento, si protegge la larghezza di banda dell'utente e si aumenta significativamente la qualità percepita della pagina.