HTTP/2-multiplexing bundelt veel verzoeken via één enkele verbinding en verwijdert blokkades op protocolniveau. In echte netwerken remmen TCP-head-of-line, TLS-overhead en gebrekkige prioritering echter de snelheid, waardoor HTTP/2 niet automatisch sneller werkt dan HTTP/1.1.

Centrale punten

- Multiplexing paralleliseert veel verzoeken via één enkele TCP-verbinding.

- TCP-HoL blijft bestaan en stopt alle streams bij verliezen.

- TLS-configuratie kan de time-to-first-byte aanzienlijk vertragen.

- Prioriteiten en Server Push werken alleen met een goede afstemming.

- Type pagina besluit: veel kleine bestanden versus weinig grote bestanden.

Hoe HTTP/2-multiplexing intern werkt

Ik splits elk antwoord op in kleine stukjes. Frames, nummer ze en wijs ze toe aan logische streams, zodat meerdere bronnen tegelijkertijd via één enkele verbinding kunnen lopen. Zo voorkom ik blokkades op HTTP-niveau, omdat geen enkel verzoek meer hoeft te wachten op het einde van een ander verzoek. De browsers sturen HTML, CSS, JS, afbeeldingen en lettertypen parallel en verminderen zo de kosten van extra verbindingen. Door HPACK worden headers kleiner, wat bij veel kleine bestanden de belasting aanzienlijk vermindert. Het belangrijkste blijft echter dat alle streams dezelfde TCP-lijn delen, wat voordelen oplevert, maar ook nieuwe afhankelijkheden creëert. Deze architectuur levert snelheid zolang het netwerk stabiel blijft en de Prioritering zinvol werkt.

HTTP/1.1 versus HTTP/2: belangrijkste verschillen

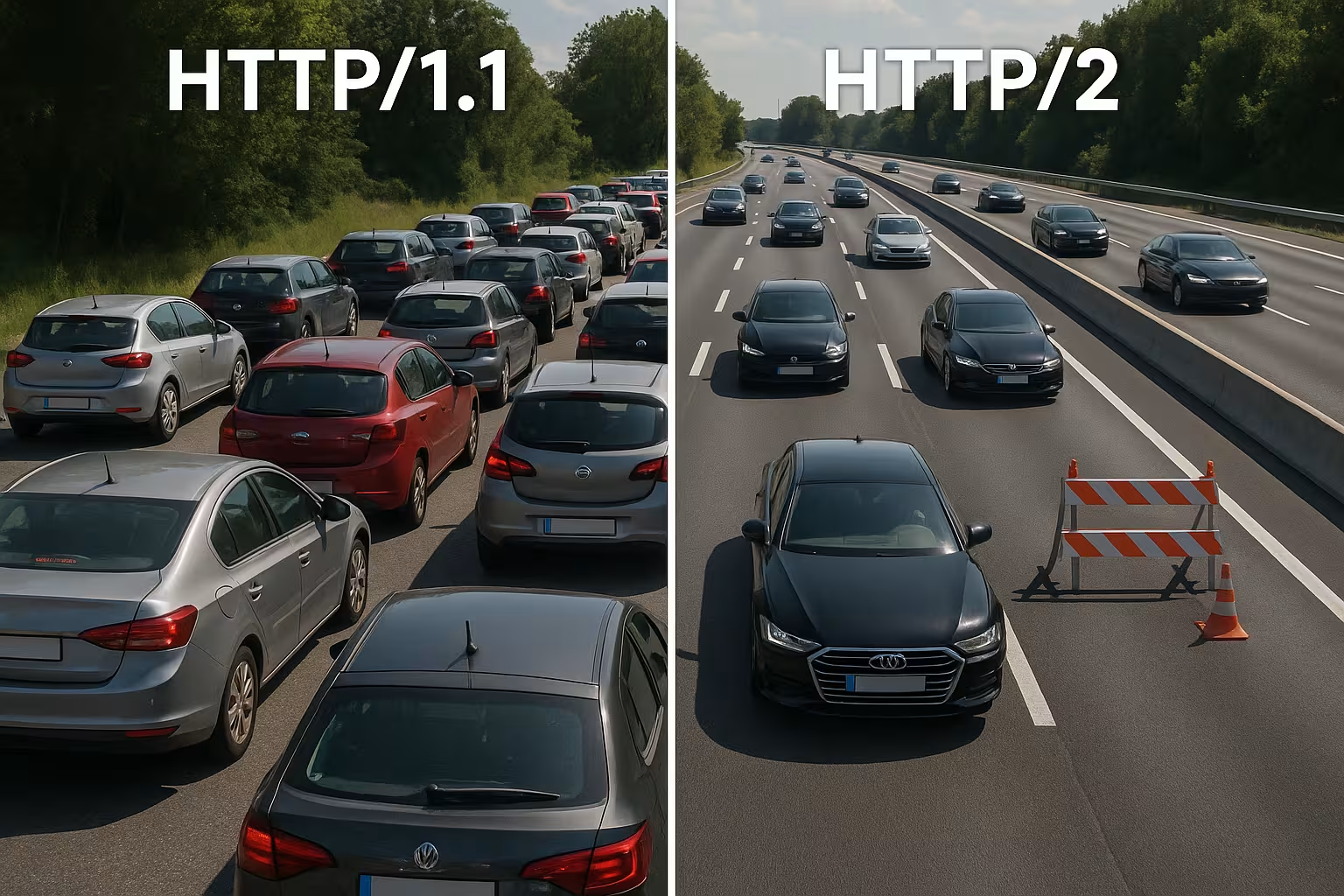

HTTP/1.1 maakt gebruik van op tekst gebaseerde berichten en meerdere parallelle verbindingen per host om bronnen tegelijkertijd te laden, wat handshakes en overhead verhoogt. HTTP/2 werkt binair, gebruikt één enkele verbinding voor alles en comprimeert headers, waardoor wachttijden worden verkort, vooral bij veel objecten. In watervalgrafieken verdwijnen lange wachtrijen omdat streams parallel verlopen. Daarvoor verschuift het knelpunt van de HTTP-laag naar de TCP-laag, wat ik duidelijk merk bij onstabiele netwerken. Kleine, sterk gecachete pagina's hebben vaak nauwelijks voordelen ten opzichte van 1.1, terwijl grote, assetrijke pagina's duidelijker profiteren. Deze verschillen vormen mijn Tuningstrategie en rechtvaardigen een projectspecifieke beslissing.

Flow Control en venstergroottes correct kiezen

HTTP/2 biedt eigen stroomcontrole per stream en per verbinding. Ik let op zinvolle waarden voor INITIAL_WINDOW_SIZE en het aantal gelijktijdige streams, zodat de lijn niet verstopt raakt of onderbenut blijft. Te kleine vensters genereren onnodig veel WINDOW_UPDATE-frames en beperken de datasnelheid, te grote vensters kunnen zwakkere clients overbelasten. In netwerken met een hoog bandbreedte-vertragingsproduct (BDP) vergroot ik de venstergrootte doelgericht, zodat grote antwoorden niet vastlopen in stop-and-go. Tegelijkertijd beperk ik MAX_CONCURRENT_STREAMS Pragmatisch: voldoende parallelliteit voor renderkritische zaken, maar niet zo veel dat kleine dingen het LCP-beeld vertragen. Deze instellingen zijn klein, maar hebben een groot effect op de werkelijke laadtijden als ze passen bij de pagina en het netwerk.

Domeinsharding en bundeling opnieuw evalueren

Veel 1.1-optimalisaties zijn contraproductief onder HTTP/2. Ik los oude domeinsharding op, omdat één goed gebruikte verbinding efficiënter is dan kunstmatig verdeelde sockets. Ik plaats ook vraagtekens bij het aggrosamenvoegen van JavaScript tot megabestanden: kleinere, logisch gescheiden bundels maken gerichte caches mogelijk en voorkomen dat bij een wijziging de hele app opnieuw moet worden overgedragen. Beeldsprites verliezen aan belang omdat parallelle verzoeken goedkoop zijn geworden en moderne beeldformaten, inclusief caching, beter werken. Ik ontwar dus waar multiplexing voordelen biedt en bundel alleen nog als dit de architectuur echt vereenvoudigt of het caching-trefpercentage meetbaar verhoogt.

Verbindingscoalescentie en certificaten

HTTP/2 stelt browsers in staat om één verbinding te gebruiken voor meerdere hostnamen, mits de certificaten en DNS overeenkomen. Ik plan SAN-vermeldingen en SNI zodanig dat coalescing mogelijk is en extra handshakes overbodig worden. Als ALPN en cipher suites overeenkomen, kan de client CSS van cdn.voorbeeld.com en foto's van static.example.com via dezelfde verbinding. Dat bespaart RTT's, vereenvoudigt de prioritering en vergroot de kans dat kritieke assets zonder omwegen aankomen. Ik controleer deze effecten specifiek in het tabblad Netwerk: wordt er echt maar één socket gebruikt, of dwingen certificaatlimieten en beleidsregels de browser tot nieuwe verbindingen?

Waarom multiplexing wordt afgeremd: TCP-Head-of-Line

Als er één pakket verloren gaat op de enige TCP-verbinding, wacht de hele lijn totdat de hertransmissie binnenkomt – dit stopt tijdelijk alle HTTP/2-streams. In mobiele netwerken met wisselende latentie en een verhoogd verliespercentage zie ik daarom regelmatig minder voordelen of zelfs nadelen in vergelijking met meerdere 1.1-verbindingen. Dit effect verklaart waarom multiplexing op papier zo goed lijkt, maar in de praktijk niet altijd werkt. Metingen uit onderzoek en praktijk laten precies dit verband zien in echte netwerken [6]. Ik plan daarom implementaties conservatief, test op typische gebruikerspaden en controleer de effecten voor elke doelgroep. Wie TCP-HoL negeert, verspeelt kansen. Prestaties en kan zelfs de laadtijden verlengen.

TLS-handshake, TTFB en paginatype

HTTP/2 draait op het web bijna uitsluitend via TLS, wat extra handshakes genereert en de time-to-first-byte bij weinig assets merkbaar kan verlengen. Als ik slechts één groot bestand lever, verdwijnt het multiplexingvoordeel omdat er geen parallelle overdracht nodig is. Pagina's met tien tot twintig kleine bestanden profiteren eerder, terwijl antwoorden met één asset vaak op hetzelfde niveau liggen als HTTP/1.1. Ik verkort de overhead met TLS 1.3, Session Resumption en clean Keep-Alive, zodat herverbindingen overbodig zijn en de verbinding echt blijft bestaan. Voor de fijnafstemming vertrouw ik op Keep-Alive-tuning, om reuse, idle-time-outs en limieten in te stellen die passen bij de belasting. Zo daalt het handshake-aandeel en de TTFB stabiliseert zich ook bij verkeerspieken.

CDN- en proxyketens: h2 tot aan de oorsprong

Veel stacks beëindigen TLS aan de rand en communiceren verder met de oorsprong. Ik controleer of tussen CDN en backend ook HTTP/2 wordt gebruikt of dat er wordt teruggevallen op HTTP/1.1. Bufferingproxy's kunnen voordelen (headercompressie, prioritering) gedeeltelijk tenietdoen als ze antwoorden opnieuw serialiseren of de volgorde wijzigen. Daarom optimaliseer ik end-to-end: edge-node, tussenproxy en origin moeten h2 begrijpen, geschikte venstergroottes gebruiken en prioriteiten niet negeren. Waar h2c (HTTP/2 zonder TLS in het interne netwerk) zinvol is, test ik of het latentie en CPU bespaart zonder het beveiligingsbeleid te schenden. Alleen een consistente keten ontvouwt de Multiplexing-effect volledig.

Prioriteiten op de juiste manier stellen

Ik geef kritieke bronnen een hoge prioriteit, zodat HTML, CSS en de LCP-afbeelding als eerste binnenkomen en renderblokkades verdwijnen. Zonder duidelijke prioriteiten slokken minder belangrijke scripts kostbare bandbreedte op, terwijl above-the-fold-content moet wachten. Niet elke server houdt zich correct aan de browserprioriteiten en sommige proxyservers wijzigen de volgorde, daarom evalueer ik resultaatgegevens in plaats van wishful thinking [8]. Preload-headers en een vroeg geplaatste afbeeldingsreferentie verkorten de laadtrajecten en verhogen het trefpercentage in de cache. Prioritering doet geen wonderen, maar het stuurt de verbinding zo dat gebruikers snel zien wat ze nodig hebben. Duidelijke regels zorgen voor merkbare Stuwkracht en maken multiplexing pas echt effectief.

Prioritering in de praktijk: Extensible Priorities

Browsers hebben hun prioriteitsmodellen verder ontwikkeld. Ik houd er rekening mee dat moderne clients vaak „Extensible Priorities“ gebruiken in plaats van starre boomgewichten. Daarbij geven ze urgentie en progressieve parameters per stream aan, die servers moeten interpreteren en vertalen naar eerlijke schedulers. Ik controleer of mijn server deze signalen respecteert of gebaseerd is op oud gedrag. In A/B-tests vergelijk ik laadpaden met en zonder server-prioritering om verdringingseffecten te detecteren. Belangrijk: prioritering moet voorrang geven aan renderkritische elementen, maar mag niet leiden tot starvation van langdurige downloads. Een zorgvuldige mix voorkomt pieken en houdt de pijplijn vrij voor zichtbare inhoud.

Server Push: zelden de afkorting

Ik gebruik server push alleen gericht, omdat overmatig pushen bandbreedte in beslag neemt en browsercaches negeert. Als een reeds gecachete bron wordt gepusht, wordt het pad trager in plaats van sneller. Veel teams hebben push weer uitgeschakeld en werken met preload, wat aanzienlijk betrouwbaarder is [8]. In speciale gevallen, bijvoorbeeld op terugkerende routes met duidelijke patronen, kan push nuttig zijn, maar ik bewijs het effect met meetwaarden. Zonder bewijs verwijder ik push en houd ik de pijplijn vrij voor echt noodzakelijke gegevens. Minder is hier vaak meer. meer, juist op de enige verbinding.

Praktische vergelijking: wanneer HTTP/1.1 sneller kan zijn

Ik ervaar HTTP/1.1 als concurrerend wanneer er weinig grote bestanden zijn of wanneer netwerken met hogere verliezen werken. Meerdere afzonderlijke verbindingen verdelen dan het risico en kunnen de individuele first-byte-tijden verkorten. Op zeer kleine pagina's compenseren extra TLS-handshakes vaak volledig het voordeel van multiplexing. Bij veel kleine objecten scoort HTTP/2 daarentegen beter, omdat compressie, prioritering en een enkele socket effectief zijn. Het volgende overzicht toont typische patronen uit audits en veldtests die mijn keuze van het protocol bepalen [6][8]. Dit raster is geen vervanging voor tests, maar biedt een solide Oriëntatie voor eerste beslissingen.

| Scenario | Beter protocol | Reden |

|---|---|---|

| Veel kleine assets (CSS/JS/afbeeldingen/lettertypen) | HTTP/2 | Multiplexing en HPACK verminderen overhead, één verbinding volstaat |

| Weinig, zeer grote bestanden | HTTP/1.1 ≈ HTTP/2 | Paralleliteit nauwelijks nodig; handshake-kosten wegen zwaarder |

| Onstabiele mobiele netwerken met verliezen | HTTP/1.1 deels beter | TCP-HoL stopt alle streams bij HTTP/2; meerdere sockets kunnen helpen |

| Geoptimaliseerde TLS (1.3, hervatting), duidelijke prioriteiten | HTTP/2 | Minder setup, gerichte bandbreedtebeheer |

| Over‑Pushing actief | HTTP/1.1/HTTP/2 zonder push | Onnodige gegevens blokkeren de verbinding; preload is veiliger |

Best practices voor echte winst in laadtijd

Ik reduceer bytes vóór het protocol: afbeeldingen in WebP/AVIF, passende formaten, zuinige scripts en schone caching-headers. Ik houd kritieke CSS-paddelen klein, laad fonts vroeg en stel fallbacks in om lay-outverschuivingen te voorkomen. Voor het opzetten van verbindingen en DNS gebruik ik Preconnect en DNS-prefetch, zodat handshakes starten voordat de parser de bron tegenkomt. Brotli voor tekstinhoud versnelt terugkerende opvragingen, met name via CDN's. Ik controleer effecten in de waterval en vergelijk LCP, FID en TTFB voor en na wijzigingen. Meetwaarden sturen mijn Prioriteiten, maar je intuïtie niet.

gRPC, SSE en streaming-gevallen

HTTP/2 komt vooral tot zijn recht bij gRPC en andere bidirectionele of langlopende streams. Ik let daarbij op time-outs, buffergroottes en backlogregels, zodat een haperende stream geen nadelige invloed heeft op alle andere verzoeken. Voor server-sent events en live feeds is een stabiele, permanente verbinding nuttig, zolang de server de prioriteiten correct beheert en keep-alive-limieten niet te vroeg ingrijpen. Tegelijkertijd test ik hoe foutgevallen zich gedragen: het opnieuw opbouwen van streams, exponentiële backoff en zinvolle limieten voor herverbindingen voorkomen piekbelastingen wanneer veel clients tegelijkertijd verbreken en opnieuw verbinding maken. Zo blijven realtime scenario's voorspelbaar.

OS- en TCP-tuning voor stabiele multiplexprestaties

De protocolkeuze compenseert geen zwakke netwerkconfiguratie. Ik controleer congestiebeheersingsalgoritmen (bijv. BBR vs. CUBIC), socketbuffers, TCP Fast Open-beleidsregels en de grootte van het initiële congestievenster. Een congestiebeheersing die past bij het pad kan hertransmissies verminderen en HoL-effecten verzachten. Even belangrijk: correcte MTU/MSS-waarden om fragmentatie en vermijdbare verliezen te voorkomen. Op TLS-niveau geef ik de voorkeur aan korte certificaatketens, OCSP-stapling en ECDSA-certificaten, omdat deze de handshake versnellen. Samen geven deze instellingen multiplexing de nodige Onderbouw, zodat prioritering en headercompressie hun effect kunnen ontplooien.

Meetstrategie en KPI's in het dagelijks leven

Ik vertrouw niet op mediaanwaarden, maar kijk naar p75/p95 van de statistieken, gescheiden naar apparaat, netwerktype en locatie. Synthetische tests leveren reproduceerbare basiswaarden op, terwijl Real User Monitoring de spreiding in het veld laat zien. Ik vergelijk watervallen van belangrijke paden, controleer early bytes van HTML, de volgorde van CSS/JS en de aankomsttijd van de LCP-afbeelding. Ik implementeer wijzigingen als gecontroleerde experimenten en observeer tegelijkertijd TTFB, LCP en foutpercentages. Belangrijk: prioriteiten zonder meetbaar nut verwijder ik weer. Zo blijft de configuratie slank en investeer ik in aanpassingen die statistisch bewezen tijd besparen.

Crawl- en botverkeer

Naast gebruikers profiteren ook crawlers van schone HTTP/2. Ik activeer h2 voor relevante eindpunten en kijk of bots de verbinding opnieuw gebruiken en meer pagina's in dezelfde tijd ophalen. Onnodige 301-cascades, ongecomprimeerde antwoorden of te korte keep-alive-limieten kosten crawlbudget. Ik stem het beleid af, zodat multiplexing ook hier werkt zonder backend-limieten te overschrijden. Resultaat: efficiëntere scans en meer stabiliteit onder belasting.

HTTP/2, HTTP/3 en wat daarna komt

HTTP/3 maakt gebruik van QUIC via UDP en lost het TCP-head-of-line-blocking op, wat vooral bij mobiliteit en verliezen merkbaar helpt [6]. Het opbouwen van de verbinding duurt minder lang en streamblokkades treffen niet langer alle verzoeken tegelijk. In gemengde vloten blijft HTTP/2 belangrijk, maar ik activeer HTTP/3 waar clients en CDN's het al ondersteunen. Gedetailleerde vergelijkingen zoals HTTP/3 vs. HTTP/2 helpen mij om roll-outs gefaseerd en doelgroepgericht te plannen. Ik meet afzonderlijk per locatie, apparaat en netwerktype, zodat echte gebruikers hiervan profiteren. Zo gebruik ik protocollen om Laadtijden in alledaagse situaties te verminderen.

Hosting en infrastructuur als versneller

Goede protocollen redden geen zwakke infrastructuur, daarom controleer ik de locatie, peering, CPU, RAM en I/O-limieten nauwkeurig. Een moderne webserver, zinvolle worker-aantallen en een cache-laag voorkomen dat de enige verbinding in een bottleneck terechtkomt. Strategisch CDN-gebruik verkort RTT en vangt piekbelastingen op. Wie gebruikers in heel Europa bedient, profiteert vaak meer van korte afstanden dan van protocol-finetuning. Ik plan capaciteit met reserves, zodat burst-traffic niet alles platlegt. Zo komt multiplexing tot zijn recht. Potentieel betrouwbaar.

Snel foutpatronen herkennen

Als HTTP/2 langzamer lijkt te werken dan verwacht, zoek ik naar typische patronen: één lange overdracht die veel kleine overdrachten blokkeert; prioriteiten die worden genegeerd; hoge hertransmissiesnelheden op mobiele routes; of TLS-hervatting die niet werkt. Vervolgens vergelijk ik HTTP/2 en HTTP/1.1 onder identieke omstandigheden, scheid ik de invloed van CDN van de oorsprong en kijk ik naar het aantal sockets, het werkelijke aantal streams en de volgorde van de eerste kilobytes. Als ik een bottleneck vind, pas ik eerst de basis aan (bytes, caching, handshakes) voordat ik aan flowcontrol of prioriteiten werk. Deze volgorde levert de meest betrouwbare verbeteringen op.

Praktische samenvatting voor snelle beslissingen

Ik gebruik HTTP/2 Multiplexing wanneer er veel objecten zijn, prioriteiten gelden en TLS correct is geconfigureerd. Bij weinig grote bestanden of onstabiele netwerken houd ik rekening met kleine voordelen en houd ik de resultaten van 1.1 in de gaten. Ik gebruik server push alleen met bewijs, preload bijna altijd, en ik houd de overhead laag door compressie, caching en vroege verbindingen. Metingen met echte apparaten en locaties bevestigen mijn aannames voordat ik wijzigingen op grote schaal doorvoer [6][8]. Uiteindelijk telt niet het protocolnummer, maar de merkbare snelheid voor echte gebruikers. Wie zo te werk gaat, haalt betrouwbaar het maximale uit HTTP/2. Snelheid en legt de basis voor HTTP/3.