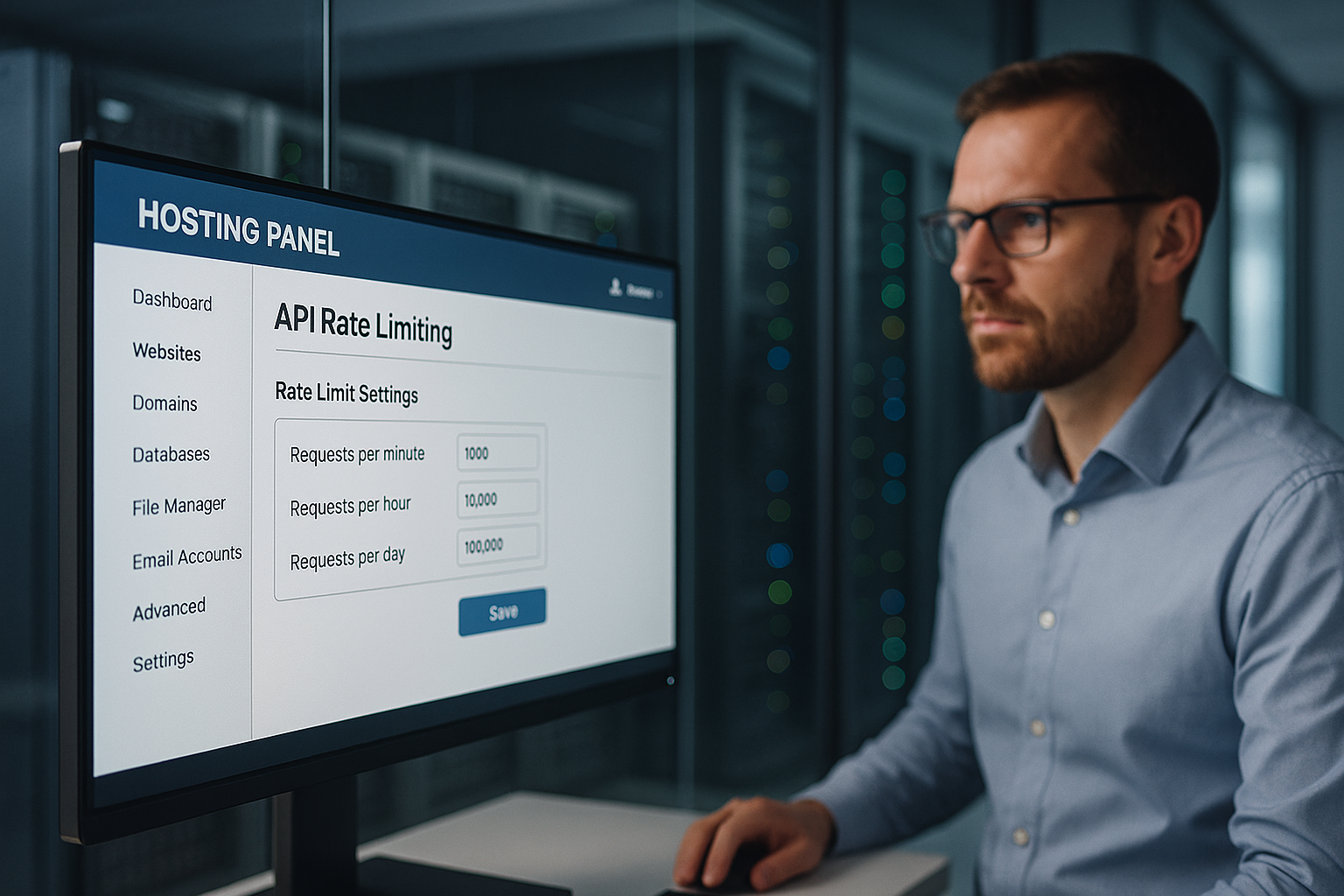

API-snelheidsbeperkende hosting beschermt een hostingpaneel tegen misbruik door de aanvraagsnelheden per IP, API-sleutel en eindpunt strikt te controleren en zo uitval, misbruik van gegevens en onnodige kosten te voorkomen. Ik stel limieten in op meerdere niveaus, herken afwijkingen in een vroeg stadium en beveilig klantrelevante functies zoals inloggen, facturering en gegevenstoegang tegen DDoS, credential stuffing en oneerlijke belastingspieken.

Centrale punten

- Meerlagig Grenzen: globaal, gebruiker, eindpunt

- Algoritmen selecteren: Token/Lekkig/Schuifvenster

- Transparant Kopregel: Limiet, Resterend, Reset

- Controle in realtime met waarschuwingen

- Eerlijk gespreid: quota per klantsegment

Waarom API-snelheidsbeperking onmisbaar is in het hostingpaneel

Ik gebruik duidelijke grenzen om dat te voorkomen Aanvaller Blokkeer aanmeldings- of gegevenseindpunten met stortvloed aan verzoeken. Op deze manier blijven legitieme processen beschikbaar terwijl ik misbruik tegenhoud en de latentie laag houd. Elke overbelasting op gedeelde servers kost geld en vertrouwen, dus ik smoor excessieve verzoeken op tijd af. Ik voorkom escalatie door de limieten dynamisch aan te passen voordat de capaciteit toeneemt. Klanten krijgen consistente responstijden omdat ik eerlijke quota's afdwing en ongecontroleerde pieken elimineer.

Hoe snelheidsbegrenzing werkt: concepten en algoritmen

Ik selecteer het juiste algoritme op basis van het belastingsprofiel, de kriticiteit van het eindpunt en de verwachte pieken, omdat een goed proces Misbruik stopt betrouwbaar en staat legitieme uitbarstingen toe. Schuifvenster-methoden maken harde grenzen glad, token bucket staat snelle kortetermijnuitbarstingen toe, leaky bucket handhaaft een gelijkmatige stroom. Vast venster is geschikt voor eenvoudige regels, maar kan oneerlijk lijken aan de randen van het venster. Ik combineer methoden als eindpunten sterk verschillen, zoals inloggen versus statische inhoud. Hierdoor kan ik flows controleren zonder onnodige blokkades.

| Algoritme | Typisch gebruik | Voordeel voor veiligheid |

|---|---|---|

| Vast venster | Eenvoudig quotamodel | Voorspelbaar Contingenten |

| Schuifraam | Preciezer gladstrijken | Minder grenstrucs |

| Fiches emmer | Barsttolerant | Flexibele tips |

| Lekke emmer | Constante doorvoer | Afvoer reinigen |

Voor elk eindpunt documenteer ik de beoogde RPS, de burst-grootte en de reactie bij overtredingen, zodat de Controle reproduceerbaar blijft. Elke regel is geversioneerd in de infrastructuur, zodat bij audits duidelijk te zien is wanneer welke limiet van toepassing is.

Gelaagde limieten: globaal, gebruiker, eindpunt

Ik stel eerst een globale limiet in die de Platform als geheel zodat geen enkele applicatie capaciteit opslokt. Vervolgens maak ik per klant quota's zodat premium accounts meer verwerkingscapaciteit krijgen zonder anderen te verdringen. Tenslotte maak ik een indeling in eindpunten: Auth, betaling, schrijfoperaties strakker; lees eindpunten genereuzer. Ik blokkeer regelovertredingen niet blindelings, maar verhoog eerst de latentie of vraag om een backoff voordat ik harder optreed. Dit houdt de gebruikerservaring eerlijk, terwijl kritieke services beschermd blijven.

Verkeerspatronen correct meten

Ik analyseer typische piektijden, de verdeling per eindpunt en het foutenpercentage omdat deze gegevens Grenzen karakteriseren. Ik maak onderscheid tussen menselijk gebruik en geautomatiseerde patronen via IP-dichtheid, user agents en tokengedrag. Ik herken anomalieën aan een plotselinge toename van 401/403/429 fouten of grillige responstijden. Ik markeer anomalieën en test vervolgens strengere regels in een generieke test om vals alarm te voorkomen. Pas als is bevestigd dat het gedrag stabiel is, activeer ik de handhaving.

Transparantie voor klanten: Headers en foutmeldingen

Ik communiceer grenzen openlijk zodat Teams integreren op een voorspelbare manier en op tijd backoff. Ik vermeld de quota's in elk antwoord zodat ontwikkelaars hun gebruik kunnen controleren. Duidelijke foutmeldingen helpen in plaats van frustreren. Dit is een voorbeeld dat ik gebruik:

Limiet X-snelheid: 120

Resterende limiet: 15

X-RateLimit-Reset: 1731187200

Opnieuw proberen na: 30

Ik houd de formaten consistent en beschrijf ze in de API-documentatie zodat er geen gaten in de interpretatie vallen en de Integratie verloopt soepel.

Op kosten en complexiteit gebaseerde limieten en gelijktijdigheid

Ik beperk niet alleen de zuivere aanvraagsnelheid, maar ook Complexiteit en gelijktijdigheid: rekenintensieve paden krijgen hogere „kosten“ dan eenvoudige leesbewerkingen. Ik ken een score per verzoek toe (bijv. 1 voor eenvoudige GET's, 10 voor grote exports) en geef gas op basis van de totale kosten in het tijdsvenster. Ik beperk ook het maximale aantal gelijktijdige verzoeken per sleutel om backend pools te beschermen. Wachtrijen met een korte TTL voorkomen donderende kuddes, terwijl ik eerlijk verdeel via „max-in-flight“. In het geval van overbelasting schakel ik gefaseerd uit: eerst response caching, dan read throttle, tenslotte write shed.

Gedistribueerde handhaving in clusters

Ik stel grenzen clusterbreed zodat geen enkele instantie een bypass wordt. Ik gebruik centrale tellers (zoals Redis) met atomische incrementen, korte TTL's en sharding per sleutelprefix om hotspots te vermijden. Ik combineer sliding window counters met probabilistische structuren (zoals Approx counters) voor zeer hoge volumes. Ik onderschep klokvertraging door gateways hun tijd te laten synchroniseren en reset-tijden aan de serverkant te laten berekenen. Ik isoleer segmenten in „cellen“: elke celgroep stelt zijn eigen limieten in zodat een storing lokaal blijft. Fail-closed voor kritieke schrijfacties, fail-open voor niet-kritieke leesacties - dit houdt de service robuust.

Edge/CDN-integratie en regionale quota

Ik voorkom dat verkeer onnodig naar de backend gaat door limieten in te stellen aan de rand grab: POP-gerelateerde regels stoppen misbruik vroegtijdig, terwijl ik regionale quota's definieer per continent of land. Dit houdt gebruikers in de buurt snel, zelfs als er elders pieken optreden. Edge caches verminderen de druk op read endpoints; voorwaardelijke verzoeken (ETag/If-None-Match) verminderen de effectieve belasting. Voor API's met meerdere regio's synchroniseer ik tellers periodiek en op basis van toleranties zodat latenties niet exploderen.

Clientafhandeling: Retries, backoff en idempotence

Ik maak klanten succesvol zonder het platform in gevaar te brengen: Exponentiële backoff met Jitter voorkomt synchronisatiestormen; 429 antwoorden bevatten duidelijke hints en een „Retry-After“ waarde. Voor schrijf-eindpunten heb ik idempotency-sleutels nodig zodat retries geen kwaad kunnen. Ik gebruik consequent een voorbeeld body voor 429:

{

"error": "rate_limited",

"message": "Te veel aanvragen. Probeer het opnieuw na de reset of na Retry-After.",

"limiet": 120

"remaining": 0,

"reset_at": "2025-11-10T12:00:00Z"

}

Ik documenteer of „Retry-After“ seconden of een datum bevat en stel duidelijke bovengrenzen in voor het totale aantal pogingen. Dit houdt clients controleerbaar en het platform stabiel.

Integratie in gateways en loadbalancers

Ik beperk de snelheid zo dicht mogelijk bij de rand: eerst de API-gateway, dan de loadbalancer en dan de applicatielogica, zodat dure Backend resources verbranden niet in de eerste plaats. Gateways bieden kant-en-klare throttling plug-ins, headerbeheer en gecentraliseerde regels. Loadbalancers verdelen belastingen en herkennen hotspots in een vroeg stadium. De applicatie zelf stelt fijnkorrelige controles in per eindpunt, inclusief anti-replay en strengere controles voor mutaties. Als u de architectuur nader bekijkt, zult u het volgende aantreffen API-eerste hosting Nuttige stof tot nadenken voor schone handhavingspunten.

Verdediging tegen DDoS, brute kracht en credential stuffing

Ik herken DDoS-patronen door gedistribueerde IP's, uniforme paden en pieken zonder echte sessiediepte en vertraag ze met hardn quota per IP en subnet. Ik stop brute kracht bij inloggen met strak ingestelde bursts, captcha follow-up en progressieve vertragingen. Ik onthul het opvullen van aanmeldgegevens via bekende lekken, series mislukte pogingen en vingerafdrukken. Als drempels worden overschreden, blokkeer ik tijdelijk en vraag om extra verificatie. Ik gebruik signalen voor geautomatiseerde vijanden Beheer Bot, zodat echte gebruikers er niet onder lijden.

Eerlijkheid en niveaus: quota per klantsegment

Ik spreid quota transparant: Enterprise krijgt hogere budgetten, Starter kleinere, zodat Kosten voorspelbaar blijven en iedereen eerlijke toegang heeft. Voorbeeldrichtlijn: 5.000, 1.000 en 100 verzoeken per minuut voor Enterprise, Professional en Starter. Bijzonder gevoelige paden zoals /auth, /billing of /write zitten hier onder, terwijl read endpoints royaler blijven. Ik controleer maandelijks of segmenten of limieten moeten worden aangepast, bijvoorbeeld bij nieuw gebruikersgedrag. Zo zorg ik voor groei zonder de kwaliteit van het platform in gevaar te brengen.

Real-time API's: WebSockets, SSE en streaming

Ik beperk niet alleen HTTP-verzoeken, maar ook Verbindingen en berichtsnelheden: Maximum aantal gelijktijdige WebSocket-verbindingen per account, berichten per seconde en byte-limieten per kanaal voorkomen chatachtige clients. Ik bescherm uitzendingen met kanaalquota en scheid systeemgebeurtenissen van gebruikersgebeurtenissen. Heartbeat-intervallen en timeouts beperken zombieverbindingen tot een minimum. Voor SSE smoor ik herverbindingsfrequenties af en gebruik ik cache-vriendelijke event batches om belastingspieken af te vlakken.

Inkomende webhooks en tegendruk

Ik beveilig inkomende webhooks van externe services met Invoerbuffering, toegewijde limieten en stroomonderbrekers. Bij overbelasting reageer ik met 429/503 inclusief „Retry-After“ en accepteer ik alleen ondertekende, idempotente leveringen. Ik isoleer webhookverwerking in wachtrijen om te voorkomen dat de kern-API's worden geblokkeerd en ik leveringsrapporten zodat partners hun retry-strategieën kunnen afstemmen.

Gegevensbescherming en compliance in telemetrie

Ik log alleen wat nodig is: hashes in plaats van volledige IP's, korte Behoud voor onbewerkte logs, duidelijke doelbeperking voor audit- en factureringsgegevens. Tarieflimietgebeurtenissen bevatten gepseudonimiseerde sleutels; ik documenteer bewaarperioden en toegangsrechten. Dit zorgt voor naleving van de GDPR-vereisten zonder aan veiligheid en transparantie in te boeten.

Bewaking, waarschuwingen en reactieplannen

Ik monitor de hoeveelheid aanvragen, foutpercentages en latenties in korte vensters zodat ik vroeg escalerende patronen herkennen. Ik definieer waarschuwingen net onder de capaciteit om ruimte te laten voor actie. Als de 95% drempel daalt, pas ik de limieten aan of herverdeel ik het verkeer. Als het 5xx-percentage toeneemt, zoek ik eerst naar de oorzaken: defecte implementaties, database hotspots, afwijkende eindpunten. Vervolgens communiceer ik de status en workarounds met klanten voordat ik de quota's aanscherp.

Configuratie, tests en veilige uitrol

Ik beheer regels als Code (versiebeheer, herziening, CI-controles) en het uitrollen van wijzigingen via kenmerkvlaggen: eerst schaduwmodus (alleen meten), dan percentage uitrol, uiteindelijk volledige handhaving. Synthetische controles controleren 429 paden, headerconsistentie en retry-after logica. Chaos tests simuleren bursts, key fanout en Redis latency zodat de werking stabiel blijft, zelfs onder stress. Ik zet noodzakelijke systeemclients (build pipelines, compliance scanners) voor een beperkte tijd op een witte lijst om valse alarmen te minimaliseren.

Voorkom bypasses: Bypass, key fanout en normalisatie

Ik dicht gaten die aanvallers kunnen gebruiken om limieten te omzeilen: Sleutel fanout (duizenden eenmalige sleutels) worden beperkt met quota's op hoger niveau per account, organisatie en IP/subnet. Ik normaliseer paden (hoofdletters/kleine letters, Unicode, aliasroutes) zodat identieke eindpunten niet meerdere keren worden geteld. Ik correleer signalen (IP, ASN, apparaat vingerafdruk, sessie, token oorsprong) zodat snelle IP rotaties niet leiden tot oneindige budgetten. Voor bijzonder gevoelige paden heb ik sterkere auth nodig (mTLS/OAuth scope).

Eerlijke facturering voor overmatig gebruik

Ik maak Planbaarheid, door optionele overschrijdingsmodellen aan te bieden: extra quota die vooraf kunnen worden geboekt, automatische limieten (soft/hard cap) en transparante maandelijkse rapporten. Dit houdt de kosten onder controle, terwijl teams tijdelijke projecten niet hoeven te vertragen. Ik zorg voor een vroegtijdige melding via webhooks en e-mail wanneer quota 80/90/100% bereiken en stel passende upgrades voor voordat harde limieten van kracht worden.

Fijnafstelling: tests, logboeken en continue aanpassing

Ik valideer limieten met belasting- en stresstests, log 429 gebeurtenissen granulair en pas ze aan. Regels gebaseerd op echt gebruik. Ik minimaliseer valse positieven met witte lijsten voor compliance scans en pipelines. Voor API's met op grafieken gebaseerde query's test ik de complexiteit van velden om oneerlijke query's te dekken. Het is de moeite waard om te kijken naar GraphQL in het hostingpaneel, omdat querydiepte en kostenlimieten een effectieve aanvulling zijn op snelheidslimieten. Continue iteratie houdt bescherming en prestaties in balans.

Samenvatting: bescherming, eerlijkheid en voorspelbare prestaties

Ik gebruik snelheidsbegrenzing in verschillende lagen zodat Klanten betrouwbaar kan werken, terwijl misbruik geen kans krijgt. De combinatie van geschikte algoritmen, transparante communicatie en duidelijke quota houdt het platform responsief. Ik minimaliseer risico's en houd kostenintensieve pieken onder controle met monitoring en tests. Verstandige tieringmodellen zorgen voor eerlijkheid en ruimte voor groei. Als je limieten als productregels beschouwt, bereik je stabiele services en tevreden gebruikers.