wordpress redis WordPress merkbaar sneller omdat ik dynamische database queries cache als objecten in RAM en zo de belasting op de CPU verminder. Ik configureer caching specifiek van object naar pagina naar server caching en combineer Redis met geschikte plugins zodat pagina's aanzienlijk sneller worden weergegeven en de time-to-first byte wordt verminderd.

Centrale punten

Voordat ik dieper inga, zal ik de belangrijkste aanpassingen samenvatten die WordPress met Redis echt snel maken en tegelijkertijd eenvoudig te beheren houden. Ik concentreer me op object caching met Redis, vul het verstandig aan met pagina cache en CDN, en controleer elke verandering met gemeten waarden. Ik kies een hostingtarief dat Redis betrouwbaar levert en voldoende RAM-geheugen voor de cache biedt. Ik gebruik Redis op een veilige manier, baken instances af en wis de cache op een gecontroleerde manier. Ik houd de configuratie slank, meet regelmatig en pas zo nodig aan.

- Object cache in RAM vermindert het aantal zoekopdrachten en verkort de reactietijden.

- Pagina cache voegt Redis toe, vooral voor anonieme bezoekers.

- RAM-budget en LRU-strategie zorgen voor consistente prestaties.

- Veilig Verbinding en aparte DB ID's voorkomen conflicten.

- Controle met statistieken toont de echte effecten van elke verandering.

Waarom caching verplicht is in WordPress

WordPress genereert elke pagina dynamisch, wat veel databasequery's triggert en zonder cache tot merkbare wachttijden leidt. Ik onderbreek deze dure cyclus door de berekende resultaten op te slaan in de Cache en levert het direct af wanneer het de volgende keer wordt aangeroepen. Hierdoor worden PHP en MySQL minder belast en zijn de responstijden aanzienlijk korter. Metingen tonen aan dat object caching de laadtijd aanzienlijk verkort; voorbeeldwaarden dalen van 800 ms naar ongeveer 450 ms [1][2]. Zoekmachines beoordelen korte responstijden positief en bezoekers blijven langer omdat pagina's met Activa open sneller [1][2][5].

Hoe Redis werkt in de objectcache

Redis bewaart veelgebruikte objecten in het werkgeheugen en levert ze af zonder via de database te gaan. In WordPress komen bijvoorbeeld de resultaten van WP_Query, optiewaarden of transients direct in de RAM-cache. Dit vermindert de roundtrips naar de database drastisch en bespaart servertijd voor complexe joins of sorteren. In tegenstelling tot een pure pagina cache, blijft de pagina dynamisch omdat Redis gegevensblokken levert die WordPress vervolgens combineert. Deze aanpak is ideaal voor winkels, ledengebieden en zeer gepersonaliseerde onderdelen, waar complete pagina's zelden identiek zijn en een snelle Object-toegang helpt merkbaar [1][2][3].

Wat komt er precies in de cache terecht - en wat niet

Niet elk object is geschikt voor persistent cachen. Ik laat dynamische of veiligheidskritische gegevens (zoals nonces, sessies, aanmeldstatussen) bewust weg of categoriseer ze als persistent. niet-persistent groepen. Meer stabiele inhoud zoals queryresultaten, optiewaarden, menu's, taxonomiekaarten of productlijsten zijn zeer goede kandidaten. In complexere opstellingen definieer ik internationale groepen (bijvoorbeeld voor opties) die installatiebreed hetzelfde zijn, en niet-persistente groependie per verzoek vers moet blijven. Dit houdt de cache consistent en voorkomt dat vluchtige waarden verouderd raken.

Voor multi-instance of multisite omgevingen stel ik een unieke prefix in zodat sleutels netjes gescheiden blijven en sleutels van verschillende projecten elkaar niet overschrijven. Ik gebruik hiervoor een sprekende salt/prefix, idealiter met een verwijzing naar de omgeving (staging, prod):

// wp-config.php (voorbeeld)

define('WP_CACHE_KEY_SALT', 'acme_prod_');

define('WP_REDIS_PREFIX', 'acme_prod_'); // afhankelijk van de ondersteunde plugin

Dit betekent dat sleutels gericht kunnen worden verwijderd en dat ik in één oogopslag in tools of logboeken kan zien bij welk project een item hoort. Vooral in CI/CD-workflows bespaart me dit het giswerk van selectieve ongeldigmakingen.

Redis instellen: Stap voor stap op de server

Ik installeer eerst de Redis-service op de server en controleer of deze toegankelijk is. Op Debian/Ubuntu werk ik de pakketlijsten bij, installeer Redis en test de verbinding met PING. Vervolgens voeg ik de Redis-extensie toe aan PHP zodat WordPress kan spreken. Vervolgens activeer ik een geschikte object cache plugin in de backend en verbind WordPress met de service. Dit zorgt voor een snelle Object-cache, die op betrouwbare wijze gegevens uit het geheugen levert.

sudo apt update

sudo apt installeer redis-server

redis-cli ping # Verwacht: PONG

sudo apt installeert php-redis

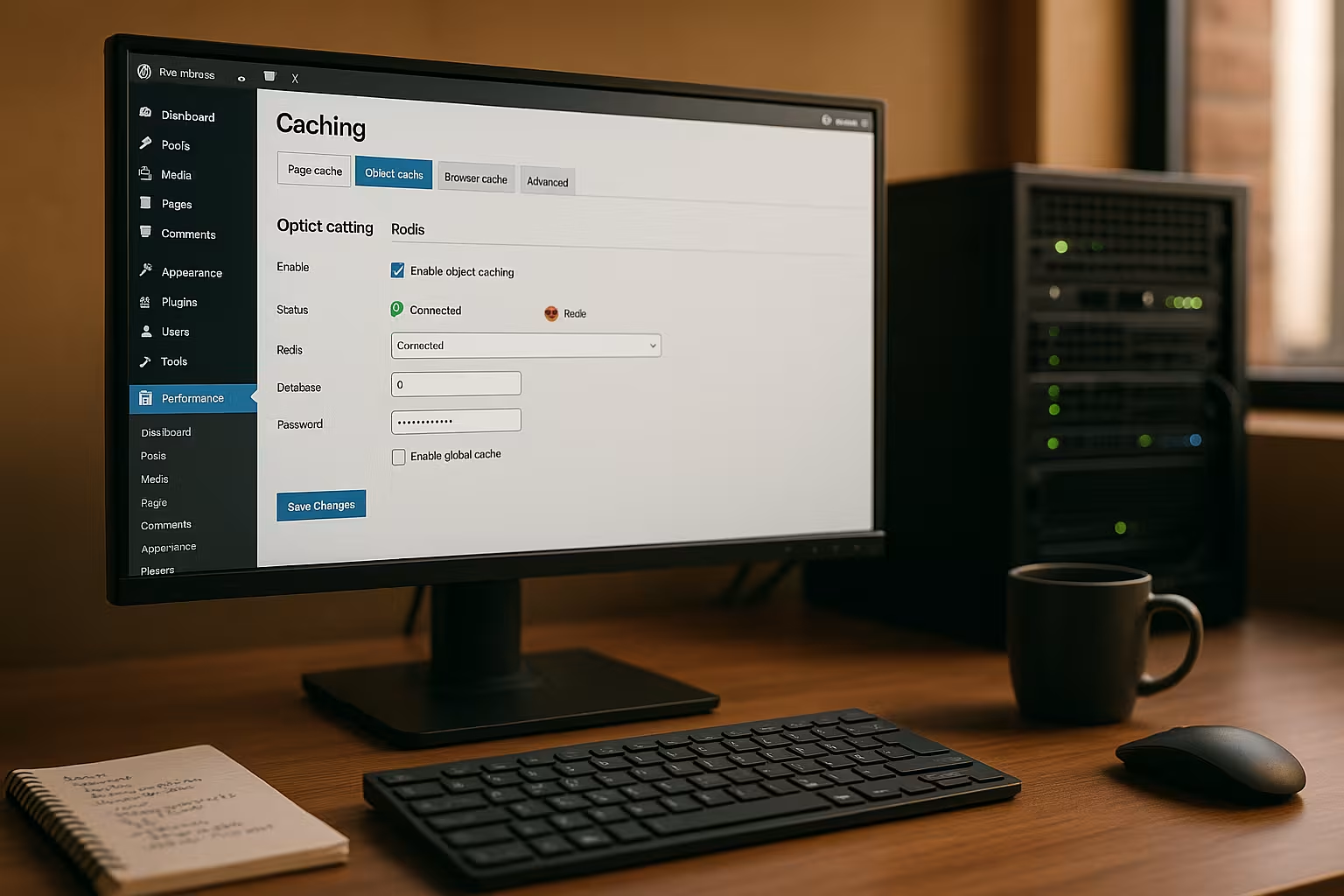

In de volgende stap activeer ik de "Redis Object Cache" plugin in WordPress en controleer ik de verbindingsstatus. Bij veel hosters is Redis al inbegrepen of kan het worden geactiveerd in het paneel, waardoor de verbinding bijzonder eenvoudig is. Ik controleer of de socket- of TCP-instellingen correct zijn en wis de cache één keer na de activering. Daarna meet ik de reactietijden opnieuw om het effect van de Amendement duidelijk te zien [2][3][4].

Serialiser, compressie en PHP redis opties

Hoe gegevens in Redis terechtkomen, beïnvloedt de snelheid en het RAM-verbruik. Indien beschikbaar, gebruik ik een efficiënte serialiser (bijv. igbinary) en optionele compressie voor grote objecten. Dit vermindert de geheugenbelasting en versnelt deserialisatie. Veel plugins bieden hiervoor schakelaars in de instellingen; als alternatief stel ik constanten in wp-config.php in als de plugin deze evalueert. Vuistregel: vooral grote, zelden veranderde objecten profiteren, heel kleine sleutels wat minder.

// wp-config.php (voorbeeld, afhankelijk van de plugin)

define('WP_REDIS_SERIALIZER', 'igbinary'); // of 'php'

define('WP_REDIS_COMPRESSION', true);

define('WP_REDIS_MAXTTL', 86400); // Max. Lifetime (1 dag)

Met een redelijke MaxTTL Ik voorkom "eeuwige" vermeldingen die nooit worden bijgewerkt. Dit houdt de cache vers en voorkomt inconsistente weergavetoestanden [1][4].

Redis en WordPress plugins: krachtige combinaties

Veel cachingplugins kunnen Redis gebruiken als backend voor de objectcache en deze aanvullen met paginacache, HTML minify of afbeeldingoptimalisatie. Ik gebruik vooral graag LiteSpeed cacheomdat ik daar op een handige manier de object cache met Redis, edge-side includes en afbeeldingsformaten zoals WebP kan beheren. Ik activeer de object cache in de instellingen, selecteer "Redis" als methode en voer de host, poort of socket in. De verbindingstest laat me meteen zien of alles draait en de cache werkt. Deze combinatie zorgt voor dynamische Inhoud snel en zorgt er ook voor dat anonieme bezoekers vaak direct vanuit de paginacache worden bediend.

WooCommerce, ledengebieden en ESI

Voor winkels en inloggebieden houd ik specifiek de paginacache achter, maar vertrouw ik sterk op de objectcache. Voor onderdelen die gepersonaliseerd zijn (winkelwagenindicator, begroeting, verlanglijstjes), gebruik ik edge-side includes (ESI) of haal ik de fragmenten op aan de clientzijde. Het is belangrijk om een duidelijke Variërenstrategie (bijvoorbeeld op basis van cookies of rollen) zodat anonieme bezoekers maximaal profiteren, terwijl ingelogde gebruikers consistente, dynamische inhoud zien. Redis levert de bouwstenen razendsnel zonder afhankelijk te zijn van volledige pagina-identiteit [1][2][3].

Fijnafstelling: wp-config en redis.conf

Voor socketverbindingen stel ik specifieke constanten in wp-config.php in zodat WordPress het juiste adres gebruikt. Ik definieer het schema en pad en controleer of de socket bestaat en de juiste rechten heeft. Ik gebruik redis.conf om het geheugen te beperken met maxmemory en selecteer een verstandig verwijderingsbeleid, vaak allkeys-lru. Op deze manier houd ik de cache berekenbaar en voorkom ik dat Redis het systeem de RAM wordt betwist. Ik wijs ook een wachtwoord toe of gebruik bindadressen en firewalls zodat niemand Redis van buitenaf kan benaderen. vragen [1][4].

// wp-config.php

define('WP_REDIS_SCHEME', 'unix');

define('WP_REDIS_PATH', '/tmp/redis.sock');

// redis.conf (voorbeeld)

maxgeheugen 256mb

maxmemory-policy allkeys-lru

wachtwoord geheim wachtwoord123

TTL-strategieën, uitzettingen en gerichte invalidatie

Een goede cache is niet alleen snel, maar ook voorspelbaar. Ik wijs TTL's toe op basis van dataklasse: korte TTL's voor vluchtige feeds, langere voor menu's, bijna geen voor zelden veranderende taxonomietoewijzingen - beperkt door een MaxTTL. Voor updates maak ik selectiefin plaats van de hele cache te wissen: Wanneer ik een product opsla, wis ik alleen sleutels die van invloed zijn op de relevante categorieën, prijsfilters, productlijsten of widgets. Dit houdt de hitrate hoog en minimaliseert piekbelastingen [2][4].

Over het uitzettingsbeleid: alle-sleutels-lru is meestal de meest robuuste keuze omdat het verouderde, weinig gebruikte toetsen als eerste vervangt. Als mijn opstelling strikte TTL specificaties heeft, kan ik vluchtig-lru kan zinvol zijn (alleen sleutels met TTL worden verplaatst). Ik controleer de miss rate na wijzigingen; als deze sterk stijgt, is het RAM budget vaak te klein of de TTL te kort [1][4].

Typische fouten en snelle oplossingen

Als WordPress socket en TCP verwisselt, blijft de object cache leeg of meldt verbindingsfouten. Ik controleer dan de plugin-instellingen, host/poort of de Unix socket en bekijk de serverlogs. Als de cache te vaak leeg raakt, pas ik de TTL-waarden en de triggers voor ongeldig maken aan, bijvoorbeeld bij het opslaan van berichten of producten. Voor meerdere WordPress instanties wijs ik aparte Redis databases toe zodat items elkaar niet overschrijven. Zo houd ik de Gegevens netjes gescheiden en krijgen een duidelijk begrijpelijke Cache-structuur [4].

Voorkom een stormloop op de cache

Zonder beschermingsmechanismen kan het verlopen van veel populaire sleutels leiden tot een "donderende kudde": Honderden aanvragen herbouwen dezelfde inhoud. Ik beperk dit door TTL's iets te verschuiven, herbouwingen te beveiligen met sloten en - als de plugin het aanbiedt - gebruik te maken van Stale-While-Revalidate gebruik: Verlopen vermeldingen worden kort afgeleverd terwijl nieuwe vermeldingen op de achtergrond worden aangemaakt. Dit houdt de responstijden stabiel, zelfs tijdens verkeerspieken [2][3].

Permanent meten en versnellen

Ik vertrouw niet op onderbuikgevoelens, maar meet TTFB, First Contentful Paint en serverreactietijden voor en na elke wijziging. Tools in de browser, serverstatistieken en plugin-statistieken laten me knelpunten zien. Ik combineer ook object cache met clean page cache en ontlast PHP via server-side mechanismen zoals Nginx microcaching of Apache accelerators. Een goede introductie wordt geboden door de compacte Server-side caching Overzicht. Zo verhoog ik de Prestaties stap voor stap en bereik permanent korte Laadtijden.

Belangrijke kerncijfers en diagnostische commando's

Ik kijk regelmatig naar deze statistieken voor operaties:

- Sleutelruimte hits/missersRatio toont de effectiviteit van de objectcache.

- uitgezette_sleutels en verlopen_sleutelsGeeft aan dat er te weinig RAM is of dat de TTL's te kort zijn.

- gebruikt_geheugen, mem_fragmentatie_ratioGeeft informatie over het werkelijke gebruik en versnippering.

- verbonden_klanten, geblokkeerde_klantenIndicaties van knelpunten bij hoge belasting.

Ik gebruik eenvoudige commando's op de server, zoals redis-cli INFO, redis-cli MONITOR (slechts voor korte tijd) en redis-cli GEHEUGEN STATS. In WordPress zelf helpen debug-plugins en de statistieken van de Object Cache-plugin bij het beoordelen van cache-hits, latenties en groepen [2][4].

Alternatieven kort gecategoriseerd

Bestandsgebaseerde caching werkt eenvoudig, maar wordt beperkt door zwaar verkeer of veel dynamische elementen. Memcached is ook een in-memory cache en is snel, maar biedt minder datatypes en minder flexibiliteit dan Redis. Pagina cache slaat volledige HTML-pagina's op en is perfect voor anonieme gebruikers, terwijl object cache dynamische onderdelen versnelt. Samen met een CDN verklein ik afstanden en laadpieken wereldwijd. De juiste Combinatie bepaalt het resultaat en Redis levert de snelle Onderbouw.

Als ik Redis opzettelijk niet gebruik

Zeer kleine sites zonder databasebelasting of extreem statische projecten (headless met vooraf gerenderde pagina's) hebben slechts minimaal voordeel. Zelfs met zeer beperkt RAM op gedeelde systemen kan een te kleine cache meer verwijderingen veroorzaken dan voordelen. In zulke gevallen ben ik geneigd om me te richten op pagina cache en clean asset management en Redis alleen in te schakelen als gemeten waarden een duidelijke winst laten zien [1][5].

Hosting met Redis: een korte vergelijking

Voor betrouwbare object caching heb je een provider nodig die Redis aanbiedt en genoeg RAM geheugen heeft voor de cache. Ik zoek naar gegarandeerde bronnen, SSH-toegang en de mogelijkheid om sockets of poorten goed te configureren. Een goed gedocumenteerd paneel en snelle ondersteuning besparen tijd in de dagelijkse praktijk. In het volgende overzicht laat ik de belangrijkste gegevens van een typische selectie zien. Hoe vind je de juiste Tarief gemakkelijker te kiezen en de latere Configuratie slaagt probleemloos.

| Aanbieder | Redis-ondersteuning | Prestaties | Prijs/prestatie | Steun |

|---|---|---|---|---|

| webhoster.de | Ja | Topklasse | Uitstekend | Zeer goed |

| Aanbieder B | Gedeeltelijk | Goed | Goed | Goed |

| Aanbieder C | Geen | Voldoende | Voldoende | Bevredigend |

Schalen, latentie en hoge beschikbaarheid

Als een project groeit, let ik op de topologie: lokale UNIX sockets zijn het snelst, zolang de webserver en Redis op dezelfde host draaien. Voor aparte servers kies ik een netwerk dat dicht bij de latentie ligt en zorg ik voor voldoende bandbreedte. Voor Hoge beschikbaarheid replicatie en sentinel; met pure cache-opstellingen doe ik het vaak zonder persistentie (RDB/AOF) om I/O te besparen. Als een node verloren gaat, bouwt de cache zichzelf opnieuw op en kan de pagina nog steeds snel geserveerd worden dankzij de pagina cache [3][4].

Beveiliging en multisite/multi-instance opstellingen

Ik stel Redis nooit onbeschermd bloot aan het publieke netwerk en stel bindadressen, firewallregels en een wachtwoord in. Op gedeelde servers gebruik ik bij voorkeur Unix sockets met beperkte rechten. Als ik meerdere WordPress installaties heb, wijs ik elke site zijn eigen Redis DB ID toe en, indien mogelijk, aparte namespaces. Dit voorkomt botsingen en helpt me het overzicht te bewaren. Beveiliging kost nauwelijks tijd, maar behoudt de Integriteit de gegevens en beschermt de Beschikbaarheid.

ACL's, rechten en toegangsbeperking

Naast het wachtwoord stel ik waar mogelijk speciale Redis-gebruikers in met beperkte rechten. Ik sta alleen de commando's toe die mijn setup nodig heeft en blokkeer administratieve commando's. Adressen binden (binden 127.0.0.1 ::1) en firewalls beperken de toegang tot interne netwerken. Ik gebruik aparte toegangsgegevens en prefixen voor staging en ontwikkeling, zodat ik nooit per ongeluk productieve gegevens kan overschrijven [4].

Praktische workflow: van testen tot live gaan

Ik begin in een staging-omgeving, activeer Redis, meet, optimaliseer en rol de veranderingen volgens plan uit. Voordat ik live ga, maak ik de cache leeg, warm ik belangrijke pagina's op en monitor ik de serverstatistieken onder belasting. Als er timeouts of ongewone missers optreden, pas ik het beleid, de TTL's en de grootte aan. Voor meer diepgaande tuningideeën gebruik ik regelmatig compacte gidsen op WordPress prestaties. Zo zorg ik voor een gecontroleerde Inleiding en ontvang een goed gedocumenteerde Configuratie.

Voorverwarmen, vrijgeven en selectief zuiveren

Na implementaties voorkom ik een koude start door automatisch belangrijke pagina's op te roepen (sitemap-gebaseerde prewarming) en kritieke query's voor te verwarmen. Bij het vrijgeven van content verwijder ik specifieke gebieden (bijvoorbeeld een categorie en de bijbehorende archiefpagina's), niet de hele site. Dit houdt de hitrate hoog en zorgt ervoor dat piekbelastingen terechtkomen in caches die al warm zijn. Ik documenteer welke haken zuiveringen triggeren en test deze paden in staging zodat de live-run soepel verloopt [2][4][5].

Meenemen: Mijn korte samenvatting

Redis versnelt WordPress aanzienlijk omdat de object cache dure queries uitspaart en inhoud direct uit het geheugen levert. Ik combineer Redis met een pagina cache en, afhankelijk van het project, een CDN voor wereldwijd bereik. Met een schone setup, correcte socket/portspecificaties, de juiste geheugenlimieten en een beveiligde verbinding blijft het systeem snel en betrouwbaar [1][2][3][4][5]. Gemeten waarden bepalen elke verandering, geen onderbuikgevoel. Dit is hoe ik korte Laadtijdenbetere Gebruikerservaring en een merkbaar snellere WordPress site.