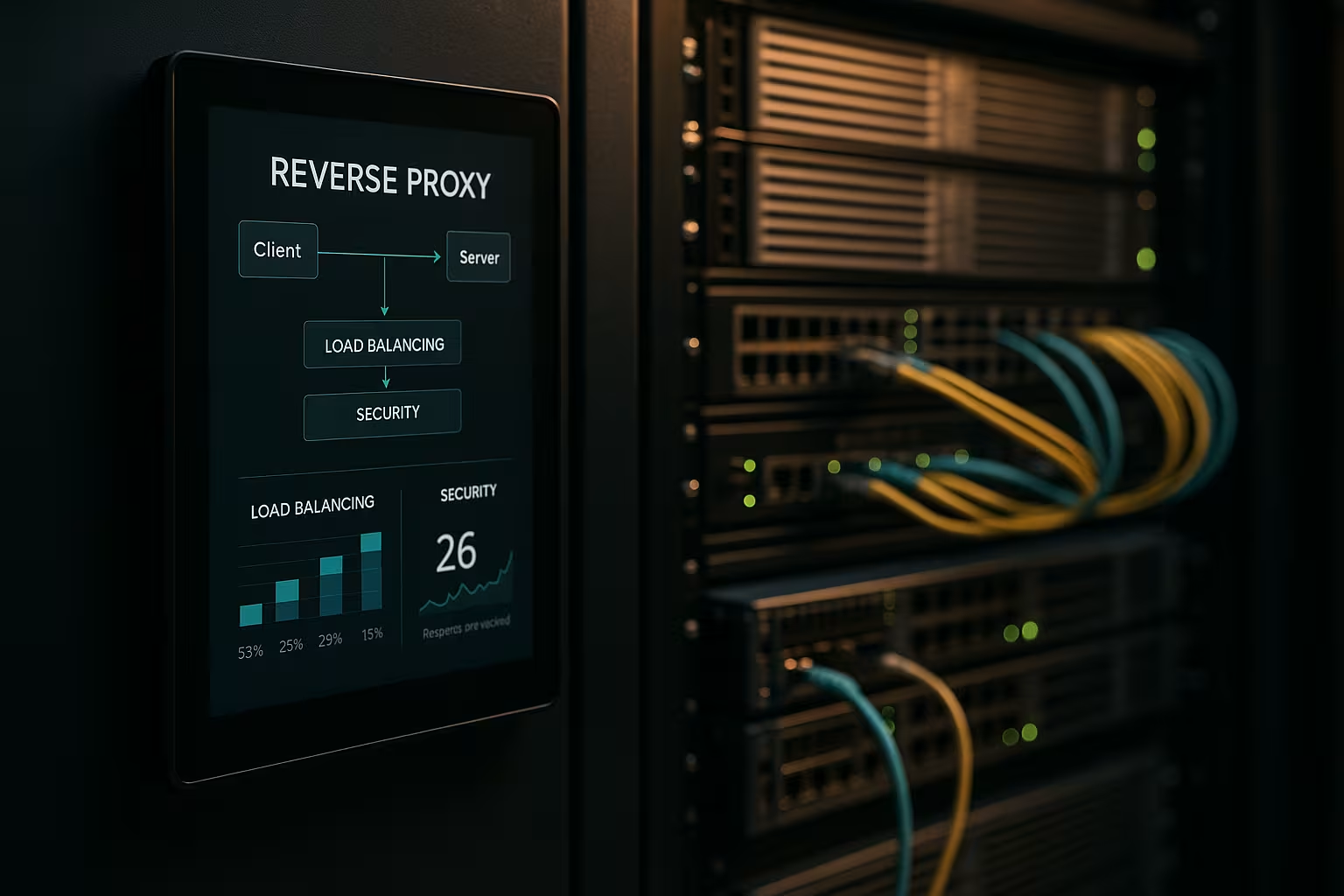

Een reverse proxy-architectuur versnelt aanvragen, beschermt backendsystemen en schaalt webapplicaties zonder de app-servers aan te passen. Ik laat zien hoe een Omgekeerde proxy prestaties, beveiliging en schaalbaarheid in de dagelijkse werkzaamheden meetbaar verbetert.

Centrale punten

- Prestaties door caching, SSL offloading en HTTP/2/3

- Beveiliging via WAF, DDoS-bescherming en IP/geo-blocking

- Schalen met load balancing en gezondheidscontroles

- Controle dankzij gecentraliseerde routering, logboekregistratie en analyse

- Praktijk met NGINX, Apache, HAProxy, Traefik

Wat doet een reverse proxy-architectuur?

Ik heb de Omgekeerd proxy voor de applicatieservers en laat deze alle inkomende verbindingen beëindigen. Op deze manier kap ik de interne structuur in, houd ik IP's verborgen en minimaliseer ik directe aanvalsoppervlakken. De proxy beslist welke service het verzoek overneemt en kan inhoud cachen. Hij zorgt voor TLS, compressie en protocoloptimalisaties zoals HTTP/2 en HTTP/3. Dit vermindert de belasting van de app-servers aanzienlijk en geeft me een plek voor richtlijnen, evaluaties en snelle wijzigingen.

Prestatieoptimalisatie: caching, offloading, edge

Ik combineer CachingSSL offloading en edge delivery om latency te verminderen. Ik serveer algemene onderdelen zoals afbeeldingen, CSS en JS vanuit de cache, terwijl dynamische onderdelen vers blijven (bijvoorbeeld fragment caching). Ik gebruik beleidsregels zoals stale-while-revalidate en stale-if-error om wachttijden te verkorten en levering te garanderen in het geval van storingen. TLS 1.3, HTTP/2 push replacement via early hints en Brotli compressie zorgen voor extra versnelling. Voor internationale gebruikers routeert de proxy naar nodes in de buurt, wat de tijd tot de eerste byte verkort. Een blik op geschikte Voordelen en toepassingsscenario's laat zien welke aanpassingen het eerst de moeite waard zijn.

De veiligheidssituatie verbeteren: WAF, DDoS, geo-blocking

Ik analyseer verkeer op Proxy en filtert kwaadaardige verzoeken voordat ze de backend systemen bereiken. Een WAF herkent patronen zoals SQL-injectie of XSS en houdt ze centraal tegen. TLS-beëindiging maakt inspectie van de versleutelde gegevensstroom mogelijk, waarna ik deze netjes doorstuur. DDoS-verdediging is afhankelijk van de proxy, die verzoeken verdeelt, beperkt of blokkeert zonder de toepassingen te raken. Geo- en IP-blokkering schakelen bekende bronnen uit, terwijl snelheidslimieten en botdetectie misbruik tegengaan.

Schalen en hoge beschikbaarheid met load balancing

Ik verdeel de belasting via Belasting Balanceringsalgoritmen zoals Round Robin, Least Connections of gewogen regels. Ik beveilig sticky sessies met cookie affiniteit als sessies gebonden moeten blijven aan een node. Gezondheidscontroles controleren services actief zodat de proxy defecte targets automatisch uit de pool verwijdert. Horizontaal schalen werkt in enkele minuten: nieuwe nodes registreren, configuratie vernieuwen, klaar. Voor gereedschapsselectie is een korte Vergelijking van tools voor loadbalancing met de nadruk op L7-functies.

Gecentraliseerd beheer en nauwkeurige bewaking

Ik verzamel logboeken centraal op de Gateway en meet belangrijke cijfers zoals responstijden, doorvoer, foutpercentages en TTFB. Dashboards tonen hotspots, trage eindpunten en verkeerspieken. Header-analyses (bijv. cache-hit, leeftijd) helpen bij de fijnafstemming van cache-strategieën. Correlatie ID's stellen me in staat om verzoeken over services heen te volgen en de hoofdoorzaak sneller te analyseren. Ik stel gestandaardiseerde richtlijnen in voor HSTS-, CSP-, CORS- en TLS-profielen, eenmaal bij de proxy in plaats van afzonderlijk bij elke service.

Routes, regels en releases zonder risico

I controle Routing gebaseerd op hostnaam, pad, headers, cookies of geo-informatie. Hierdoor kan ik API's en frontends apart routeren, zelfs als ze op dezelfde poorten draaien. Ik implementeer blue-green en canary releases direct op de proxy door kleine gebruikersgroepen naar nieuwe versies te leiden. Feature flag headers helpen met gecontroleerde tests onder echt verkeer. Ik houd onderhoudsvensters kort omdat ik routes in seconden verwissel.

Technologievergelijking in de praktijk

Ik kies voor de Gereedschapdie past bij de belasting, het protocol en de operationele doelstellingen. NGINX scoort met statische content, TLS, HTTP/2/3 en efficiënte reverse proxy-functies. Apache schittert in omgevingen met .htaccess, uitgebreide modules en legacy-stacks. HAProxy biedt zeer sterke L4/L7 balancering en fijne controle over gezondheidscontroles. Traefik integreert goed in gecontaineriseerde opstellingen en leest routes dynamisch uit labels.

| Oplossing | Sterke punten | Typische toepassingen | Bijzondere kenmerken |

|---|---|---|---|

| NGINX | Hoog Prestaties, HTTP/2/3, TLS | Web front-ends, API's, statische levering | Brotli, caching, TLS offloading, stream module |

| Apache | Modulair Flexibiliteit.htaccess | Legacy-stacks, PHP-zware installaties | Veel modules, fijne toegangsafhandeling |

| HAProxy | Efficiënt EvenwichtGezondheidscontroles | L4/L7 loadbalancer, gateway | Zeer granulaire, geavanceerde ACL's |

| Traefik | Dynamisch Ontdekking, Containerfocus | Kubernetes, Docker, microservices | Autoconfiguratie, LetsEncrypt-integratie |

Implementatiestappen en checklist

Ik begin met DoelenPrioriteit geven aan prestaties, beveiliging, beschikbaarheid en budget. Vervolgens definieer ik protocollen, certificaten, cipher suites en protocolversies. Ik definieer duidelijk routingregels, cachingbeleidsregels en limieten en versiebeheer. Ik stel gezondheidscontroles, observeerbaarheid en waarschuwingen in voordat ik live ga. Als je meteen aan de slag wilt, kun je een instructieoverzicht vinden op Reverse proxy instellen voor Apache en NGINX.

Beste werkwijzen voor prestatie-afstemming

Ik activeer HTTP/3 met QUIC waar clients het ondersteunen en houd HTTP/2 gereed voor brede compatibiliteit. Ik gebruik Brotli voor tekstbronnen en laat de proxy afbeeldingen efficiënt comprimeren. Ik definieer bewust cache-sleutels om variaties te controleren via cookies of headers. Ik minimaliseer TLS-handshake tijden, gebruik sessiehervatting en stel OCSP-nietjes in. Ik gebruik vroege hints (103) om de browser vooraf signalen te geven voor kritieke bronnen.

Veiligheidsopstelling zonder wrijvingsverliezen

Ik houd Certificaten centraal en automatiseer vernieuwingen met ACME. HSTS dwingt HTTPS af, terwijl CSP en CORP de inhoud controleren. Ik begin conservatief met een WAF rulebase en verscherp deze geleidelijk om vals alarm te voorkomen. Snelheidslimieten, mTLS voor interne services en IP-lijsten verminderen het risico op dagelijkse basis. Auditlogs blijven fraudebestendig zodat ik incidenten met juridische zekerheid kan traceren.

Kosten, werking en ROI

Ik ben van plan Budget voor serverbronnen, certificaten, DDoS-bescherming en bewaking. Kleine configuraties beginnen vaak met een paar virtuele cores en 4-8 GB RAM voor de proxy, wat afhankelijk van de provider rond de twee cijfers per maand kost. Grotere vloten maken gebruik van dedicated instances, anycast en wereldwijde nodes, wat kosten van drie cijfers per locatie kan betekenen. Gecentraliseerd beheer bespaart tijd: minder individuele configuraties, snellere releaseprocessen en kortere downtimes. De ROI komt tot uiting in een hogere conversie, lagere bouncepercentages en productievere engineering.

Architectuurvarianten en topologieën

Ik kies de architectuur die past bij het risico- en latentieprofiel. Eenvoudige omgevingen werken goed met een enkele Gateway in de DMZ, die verzoeken doorstuurt naar interne diensten. In gereguleerde of grote omgevingen scheid ik frontend en backend proxies in twee fasen: fase 1 sluit internetverkeer af en handelt WAF, DDoS en caching af, fase 2 routeert intern, spreekt mTLS en dwingt zero trust principes af. Actieve/actieve opstellingen met anycast IP en wereldwijd verspreide nodes verkorten de failover-tijden en optimaliseren de nabijheid tot de gebruiker. Met CDN's voor de reverse proxy zorg ik voor correcte header forwarding (bijv. X-Forwarded-Proto, Real-IP) en geharmoniseerde cache hiërarchieën zodat de edge en gateway cache elkaar niet blokkeren. Ik sluit multi-tenant scenario's in met behulp van SNI/TLS, gescheiden routes en geïsoleerde snelheidslimieten om nabuurschapseffecten te voorkomen.

Protocollen en speciale gevallen: WebSockets, gRPC en HTTP/3

Ik overweeg protocollen met speciale vereisten zodat functies stabiel blijven. Voor WebSockets Ik activeer upgrade-ondersteuning en langlevende verbindingen met geschikte timeouts. gRPC profiteert van HTTP/2 en schone headers; ik vermijd H2C (platte tekst HTTP/2) in de perimeter ten gunste van TLS met correcte ALPN. Voor HTTP/3 Ik lever QUIC-poorten (UDP) en geef alleen 0-RTT restrictief vrij, omdat replays risico's inhouden. Streaming endpoints, server-sent events en grote uploads krijgen hun eigen buffering en body-size policies zodat de proxy geen bottleneck wordt. Voor protocolvertalingen (bijv. HTTP/2 buiten, HTTP/1.1 binnen) test ik headernormalisatie, compressie en hergebruik van verbindingen grondig om latencies laag en resourcegebruik voorspelbaar te houden.

Authenticatie en autorisatie bij de gateway

Ik verhuis Auth-beslissingen naar de reverse proxy als de architectuur en compliance dit toelaten. Ik integreer OIDC/OAuth2 via tokenverificatie bij de gateway: de proxy valideert handtekeningen (JWKS), controleert verval, audience en scopes en stelt geverifieerde claims in als headers voor de services. Ik gebruik API-sleutels voor eindpunten van machine naar machine en beperk ze per route. Voor interne systemen vertrouw ik op mTLS met wederzijdse certificaatverificatie om vertrouwen expliciet te maken. Ik zorg ervoor dat gevoelige headers (autorisatie, cookies) niet onnodig worden gelogd en gebruik toestaan/weigeren-lijsten per route. Ik formuleer fijnkorrelig beleid via ACL's of expressies (bijv. pad + methode + claim), waarmee ik toegang centraal kan regelen zonder applicatiecode te veranderen.

Veerkracht: time-outs, retries, backoff en circuitonderbreking

Ik definieer Time-outs bewust per hop: verbindingsopbouw, header timeout en response timeout. Ik activeer alleen retries voor idempotente methoden en combineer ze met exponentiële backoff plus jitter om donderende kuddes te voorkomen. Stroomonderbrekers beschermen backend pools: Als de proxy fout- of latentiepieken detecteert, opent hij het circuit tijdelijk, stuurt alleen willekeurig door naar de getroffen bestemming en reageert anders vroeg, optioneel met fallback vanuit de cache. Detectie van uitschieters verwijdert automatisch "zwakke" instanties uit de pool. Ik beperk ook gelijktijdige upstreams, activeer hergebruik van verbindingen en gebruik wachtrijen met eerlijke prioritering. Dit zorgt ervoor dat services stabiel blijven, zelfs als individuele componenten onder druk komen te staan.

Naleving, gegevensbescherming en bescherming van PII

Ik behandel de proxy als Dataknooppunt met duidelijke regels voor gegevensbescherming. Ik maskeer of pseudonimiseer persoonlijke gegevens in logs; query strings en gevoelige headers worden alleen gelogd op basis van whitelisting. Ik kort waar mogelijk IP-adressen in en houd me aan strikte bewaarperioden. Toegang tot logs en metrics is rolgebaseerd en wijzigingen worden gedocumenteerd op een audit-proof manier. Voor audits koppel ik gateway-events aan change management-items, zodat goedkeuringen en regelupdates kunnen worden getraceerd. Zo kan ik voldoen aan de compliance-eisen zonder dat dit ten koste gaat van het inzicht in prestaties en beveiliging.

Kubernetes, Ingress en Gateway API

Ik integreer de reverse proxy naadloos in Containerorkestratie. In Kubernetes gebruik ik ingress controllers of de modernere gateway API om routing, TLS en beleid declaratief te beschrijven. Traefik leest labels dynamisch, NGINX/HAProxy bieden geavanceerde ingress-varianten voor hoge doorvoer. Ik scheid de clusterinterne oost/west routering (service mesh) van de noord/zuid perimeter gateway zodat de verantwoordelijkheden duidelijk blijven. Ik implementeer canary releases met gewogen routes of header matches, terwijl ik gezondheidscontroles en podgereedheid strikt definieer om flapping te voorkomen. Ik versie configuraties als code en test ze in staging clusters met belastingssimulatie voordat ik live ga.

Operationele maturiteit: configuratiebeheer en CI/CD

Ik behandel de proxyconfiguratie als Code. Wijzigingen lopen via pull requests, worden automatisch getest (syntaxis, linting, beveiligingscontroles) en uitgerold in pipelines. Ik gebruik previews of schaduwverkeer om nieuwe routes onder echte omstandigheden te valideren zonder klanttransacties te riskeren. Rollbacks zijn mogelijk in seconden omdat ik versies label en ze atomisch uitrol. Ik beheer gevoelige geheimen (certificaten, sleutels) apart, versleuteld en met minimale autorisaties. Voor een hoge beschikbaarheid distribueer ik releases naar nodes op een gespreide manier en registreer ik de effecten in dashboards zodat ik snel tegenmaatregelen kan nemen in het geval van regressies.

Typische struikelblokken en antipatronen

Ik vermijd Bronnen van foutendie in de praktijk vaak voorkomen. Ik voorkom cache-poisoning met strikte header-normalisatie en schoon Vary-beheer; ik sluit cookies die geen invloed hebben op rendering uit van de cache-sleutel. Ik herken redirect loops in een vroeg stadium door te testen met X-Forwarded-Proto/Host en consistent HSTS/CSP-beleid. "Vertrouw alle X-Forwarded-For" is taboe: ik vertrouw alleen de volgende hop en stel Real-IP netjes in. Ik controleer grote uploads via limieten en streaming zodat de proxy niet buffert, wat de backend beter kan. Met 0-RTT in TLS 1.3 let ik op idempotence. En ik houd een oogje op de body en header sizes zodat individuele requests niet de hele worker capaciteit in beslag nemen.

Samenvatting voor snelle beslissingen

Ik gok op een Omgekeerd proxy omdat het snelheid, bescherming en schaalbaarheid op één plek combineert. Caching, TLS offloading en HTTP/2/3 versnellen de echte laadtijden aanzienlijk. WAF, DDoS-verdediging en IP/geo controle verminderen de risico's aanzienlijk. Load balancing, gezondheidscontroles en rolling releases houden services beschikbaar, zelfs tijdens groei. Met NGINX, Apache, HAProxy of Traefik vind ik een duidelijke oplossing voor elke opstelling en houd ik de operaties beheersbaar.