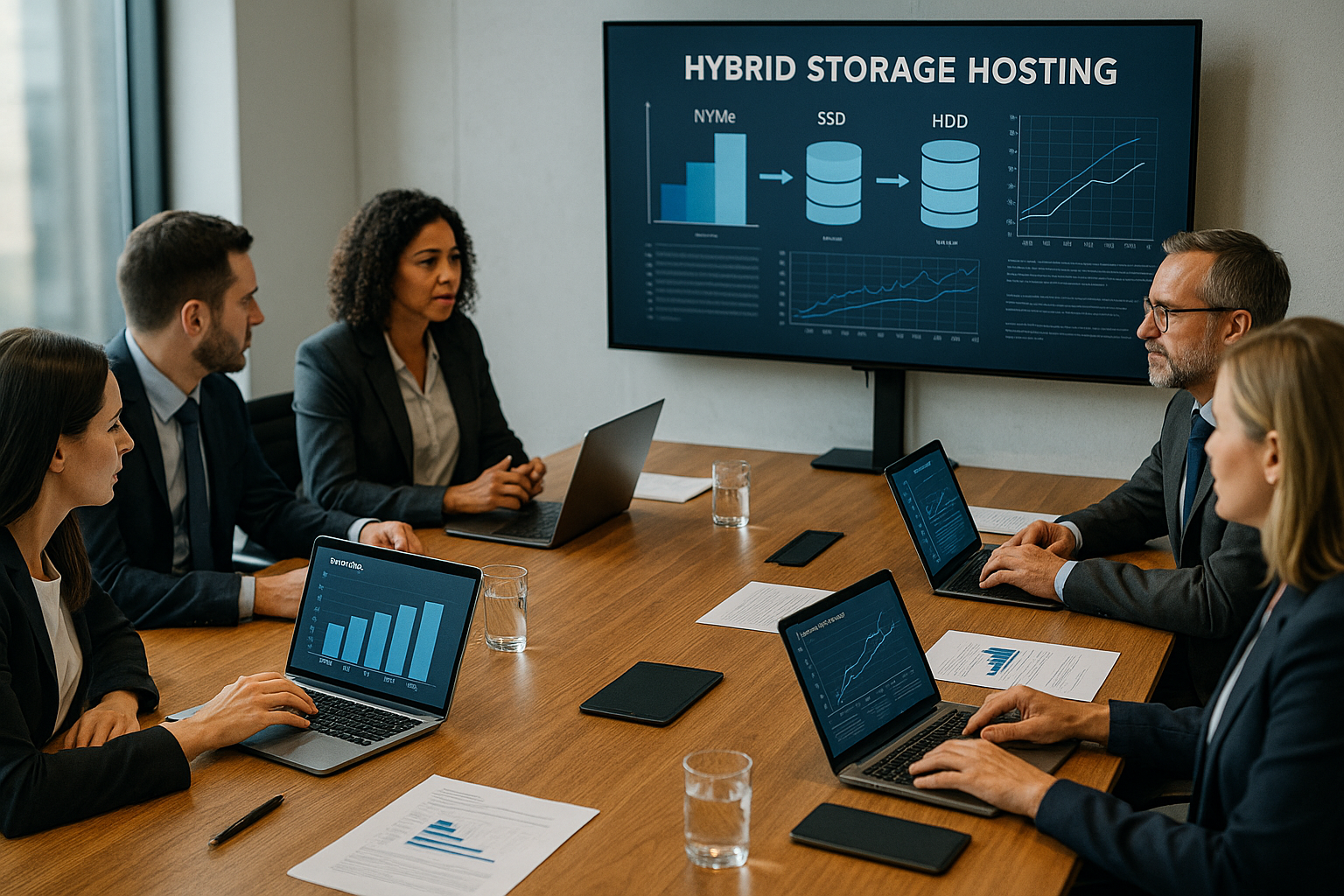

Pokazuję, jak hybrydowa pamięć masowa w hostingu łączy mocne strony NVMe, SSD i HDD w szybką, przystępną cenowo architekturę pamięci masowej, a tym samym optymalnie obsługuje obciążenia w zależności od wzorca dostępu. Dzięki jasnym zasadom warstwowania mogę przyspieszyć bazy danych, ekonomicznie zabezpieczyć duże ilości danych i utrzymać działanie aplikacji z bardzo małą ilością danych. Opóźnienie responsywny.

Punkty centralne

- NVMe-FirstDane transakcji, pamięć podręczna i system operacyjny są przechowywane na niezwykle szybkich dyskach NVMe.

- Obciążenia SSDWebspace, CMS i średniej wielkości bazy danych korzystają z dysków SSD SATA.

- Pojemność dysku twardegoKopie zapasowe i archiwa są przenoszone na duże, niedrogie dyski twarde.

- Poziomowanie pamięci masowejAutomatyczna zmiana w zależności od wykorzystania zapewnia równowagę między kosztami i wydajnością.

- SkalowaniePoziomy rozwijają się niezależnie i zabezpieczają przyszłość Elastyczność.

Dlaczego hybrydowy hosting pamięci masowej ma dziś znaczenie

Nowoczesne aplikacje internetowe, handel elektroniczny i analiza danych wymagają jednocześnie wysokiej Wydajność i dużą pojemność - pojedyncza klasa pamięci masowej rzadko radzi sobie z tym balansem. Dlatego łączę NVMe, SSD i HDD w taki sposób, że gorące dane są zawsze przechowywane na szybkich nośnikach, podczas gdy zimne dane są przechowywane tanio i bezpiecznie [1][3][6]. Takie połączenie obniża opóźnienia zapytań, przyspiesza wdrożenia i znacznie obniża koszty archiwizacji. Jednocześnie zachowuję możliwość dostosowania infrastruktury, ponieważ warstwy można rozszerzać osobno bez przenoszenia istniejących systemów. Oznacza to, że platforma pozostaje odporna, szybko reaguje i pozostaje opłacalna finansowo wraz ze wzrostem ilości danych przenośny.

Porównanie technologii pamięci masowej

NVMe wykorzystuje magistralę PCIe i zapewnia ogromną liczbę operacji wejścia/wyjścia na sekundę (IOPS), a także bardzo niskie zużycie energii. Opóźnienia, co znacznie przyspiesza dynamiczne sklepy, pamięci podręczne i bazy danych OLTP [2][6][10]. Dyski SSD SATA zapewniają solidną przepustowość dla CMS, mikrousług i mniejszych baz danych - idealne, gdy prędkość jest ważna, ale nie musi być maksymalna [8][12]. Dyski HDD osiągają wysokie wyniki pod względem ceny za terabajt i są odpowiednie do tworzenia kopii zapasowych, archiwizacji danych i rzadko używanych plików [3][7]. W moim planowaniu wybieram klasę w zależności od częstotliwości dostępu, struktury danych i wymagań dotyczących niezawodności. Więcej informacji na temat różnic między generacjami pamięci flash można znaleźć na stronie NVMe vs. SSD, zanim sfinalizuję koncepcję miksowania.

| Technologia | Interfejs | Średnia prędkość | Maksymalna pojemność | Zakres zastosowania |

|---|---|---|---|---|

| HDD | SATA | 100 MB/s | do 12 TB | Kopie zapasowe, archiwizacja |

| SSD | SATA | 500-600 MB/s | do 4 TB | Webhosting, DB |

| NVMe SSD | PCIe | 3 500-7 000 MB/s | do 2 TB | Bazy danych, aplikacje czasu rzeczywistego |

Strategie warstwowania: Prawidłowe umieszczanie danych

Organizuję dane według temperatury: gorące (NVMe), ciepłe (SSD) i zimne (HDD) - i pozwalam, aby procesy hostingu warstw pamięci masowej działały automatycznie [1][6][11]. Często odczytywane pliki indeksów, dzienniki transakcji i obiekty pamięci podręcznej pozostają na NVMe, podczas gdy zasoby statyczne i pliki CMS spoczywają na dyskach SSD. Duże pliki eksportu, migawki i codzienne kopie zapasowe parkuję na dyskach HDD, aby utrzymać korzystną pojemność. Zautomatyzowane reguły przenoszą nieaktywne dane na wolniejsze poziomy w oparciu o czas lub wykorzystanie. W ten sposób utrzymuję szybkie poziomy na niskim poziomie, oszczędzając budżet i jednocześnie utrzymując je w dobrym stanie. Dostępność.

Wzrost wydajności w typowych obciążeniach

W przypadku handlu elektronicznego i dużych systemów CMS, NVMe zauważalnie skraca czas odpowiedzi, ponieważ zapytania katalogowe, indeksy wyszukiwania i sesje są dostarczane niezwykle szybko [2][3]. Testy wykazały do 1200 % wyższą szybkość transferu sekwencyjnego w porównaniu do dysków SSD SATA i redukcję opóźnień o 80-90 % - dzięki temu transakcje są płynne, a strony wyszukiwania szybkie [2][4][6][10][13]. Potoki CI/CD kompilują się szybciej, kontenery uruchamiają się szybciej, a wdrożenia przebiegają niezawodnie, gdy artefakty i pamięci podręczne kompilatorów znajdują się na NVMe. Analiza danych czerpie korzyści z wysokiej szybkości sekwencyjnej: Zadania ETL i strumienie odczytują i zapisują na NVMe/SSD bez spowalniania, podczas gdy zestawy danych historycznych pozostają na HDD w tle. To ukierunkowane rozmieszczenie zapobiega powstawaniu wąskich gardeł i utrzymuje działanie aplikacji nawet pod obciążeniem responsywny.

Czynniki sprzętowe, które robią różnicę

Zwracam uwagę na linie PCIe, jakość kontrolera, pamięć podręczną HMB/DRAM dysków SSD, a także profile RAID, ponieważ czynniki te mają realny wpływ na wydajność. Wydajność charakterystyka. Rozsądne połączenie RAID1/10 dla NVMe i RAID6/60 dla dysków twardych równoważy szybkość i ochronę przed awarią. Pamięć podręczna zapisu i bateria/kondensator zapasowy (BBU) zabezpieczają transakcje bez narażania danych. Sprawdzam również, ile gniazd NVMe oferuje płyta główna i czy chłodzenie zapobiega dławieniu. Ci, którzy chcą zagłębić się w kwestie związane z platformą, znajdą praktyczne wskazówki dotyczące Wydajny sprzęt, co pomaga w projektowaniu hostingu.

Efektywność ekonomiczna: kontrola kosztów, zapewnienie wydajności

NVMe jest drogie w przeliczeniu na terabajt, ale używam go szczególnie tam, gdzie ma to wpływ na przychody i wrażenia użytkowników. windy. Dyski SSD zapewniają szybkość dla większości plików internetowych bez ponoszenia kosztów pełnej strategii NVMe. Dyski HDD przenoszą obciążenie pojemnościowe i znacznie zmniejszają budżety na tworzenie kopii zapasowych i archiwizację. Dzięki takiemu poziomowaniu infrastruktura płaci za wydajność dokładnie tam, gdzie ma ona wymierny wpływ i oszczędza tam, gdzie ma mniejszy wpływ. Oznacza to, że całkowity koszt posiadania (TCO) pozostaje przewidywalny, a inwestycje są kierowane do rzeczywistych wąskich gardeł, a nie tych nieużywanych Wartości szczytowe.

Skalowanie i zabezpieczenie na przyszłość

Planuję warstwy tak, aby pojemność rosła niezależnie: NVMe dla rosnącego obciążenia transakcyjnego, SSD dla treści internetowych, HDD dla danych długoterminowych. Kubernetes, Proxmox lub porównywalne platformy pozwalają na pule na warstwę, które elastycznie rozszerzam bez wyłączania usług. Koncepcje migawek i replikacji zabezpieczają stany danych i zauważalnie skracają czasy przywracania. Utrzymuję również otwarte ścieżki migracji, aby zintegrować szybsze generacje NVMe lub większe dyski twarde, gdy tylko będą dostępne. Takie podejście chroni inwestycje i utrzymuje platformę dopasowanie do przyszłości.

Etapy wdrażania: od planowania do działania

Zaczynam od analizy obciążenia: rozmiar danych, wzorce R/W, wymagania IOPS, docelowe opóźnienia i czasy przywracania definiują alokację warstw. Następnie definiuję wytyczne dotyczące automatycznego przenoszenia, w tym wartości progowe dla wieku, częstotliwości dostępu i ważności danych. Integruję kopie zapasowe, migawki i replikację we wszystkich warstwach, aby zapewnić, że korzyści związane z pojemnością nie są osiągane kosztem wydajności. Bezpieczeństwo go. Podczas pracy regularnie sprawdzam hotspoty oraz dostosowuję limity i pamięci podręczne. Regularne testy przywracania i przełączania awaryjnego zapewniają gotowość operacyjną na wypadek awarii.

Monitorowanie i optymalizacja podczas pracy

Mierzę przepustowość, IOPS, opóźnienia 95/99 percentyla, głębokości kolejek, współczynniki trafień pamięci podręcznej i wskaźniki poziomu zużycia, aby wcześnie wykrywać wąskie gardła. Alarmy ostrzegają, gdy warstwy NVMe zapełniają się, dyski SSD dławią się lub dyski HDD przekraczają czasy odbudowy. W oparciu o dane telemetryczne przenoszę dane w ukierunkowany sposób lub dostosowuję reguły warstw, aby szybka warstwa pozostała wolna. Proaktywne aktualizacje oprogramowania układowego i jądra stabilizują ścieżkę między aplikacją a pamięcią i zapobiegają nieestetycznemu Wartości odstające. Dzięki temu koncepcja mieszania jest szybka i niezawodna w dłuższej perspektywie.

Test dostawcy 2025: Porównanie funkcji hybrydowej pamięci masowej

Przed dokonaniem rezerwacji sprawdzam, czy dostępna jest prawdziwa hybrydowa pamięć masowa, czy zasady warstwowania są elastyczne i jak platforma radzi sobie z opóźnieniami pod obciążeniem. Certyfikowane centra danych, czas reakcji wsparcia i przejrzyste opcje aktualizacji również wpływają na moją decyzję. Oceniam również, czy dostawcy dostarczają interfejsy API do monitorowania oraz w jaki sposób obsługują generacje NVMe i profile RAID. Szybkie porównanie ujawnia różnice, zanim zobowiążę się do długoterminowych planów pojemności. Pozwala mi to dokonać świadomego wyboru i zapewnić niezbędne Pewność działania.

| Miejsce | Dostawca | Obsługa hybrydowej pamięci masowej | Opcje podziału na poziomy | Wydajność |

|---|---|---|---|---|

| 1 | webhoster.de | Tak | Tak | wybitny |

| 2 | Dostawca B | Tak | Tak | Bardzo dobry |

| 3 | Dostawca C | Częściowo | Nie | Dobry |

Inteligentna obsługa projektów multimedialnych i streamingowych

Duże pliki multimedialne zajmują dużo miejsca, ale żądania często dotyczą tylko niewielkiej części danych - wykorzystuję to dzięki hybrydowej pamięci masowej. Przechowuję miniatury, pliki manifestów i gorące treści na SSD lub NVMe, podczas gdy długoterminowe zasoby są przechowywane na HDD. Pamięć podręczna i pliki podzielone na segmenty korzystają z szybkiego udostępniania, podczas gdy platforma korzystnie skaluje pojemność. Jeśli chodzi o pomysły wdrożeniowe i przepływy pracy związane z pulami treści, ten praktyczny przewodnik pomaga mi w następujących kwestiach Optymalizacja pamięci dla stron multimedialnych. Dzięki temu streaming i pobieranie są szybkie, a koszty nie wymykają się spod kontroli. Ster.

Prawidłowy wybór systemów plików i warstw buforowania

Wybór systemu plików decyduje o tym, jak dobrze wykorzystywany jest potencjał sprzętowy. Używam XFS lub ext4 do ogólnych obciążeń sieciowych i dzienników, ponieważ są one sprawdzone i wydajne. W przypadku połączonych wymagań ze zintegrowanymi migawkami, sumami kontrolnymi i ścieżkami replikacji, rozważam ZFS. ZFS-ARC wykorzystuje pamięć RAM jako podstawową pamięć podręczną, L2ARC integruje NVMe jako pamięć podręczną do zimnych odczytów, a dedykowany SLOG przyspiesza synchroniczne zapisy - idealne rozwiązanie dla baz danych o rygorystycznych wymaganiach dotyczących trwałości. TRIM/discard, czyste wyrównanie 4K i odpowiednie opcje montażu są ważne, aby wzmocnienie zapisu pozostało niskie, a dyski flash działały dłużej. W przypadku milionów małych plików polegam na niestandardowych rozmiarach i-węzłów, haszowaniu katalogów i, w razie potrzeby, bramach obiektowej pamięci masowej, podczas gdy duże sekwencyjne strumienie danych (kopie zapasowe, wideo) korzystają z dużych rozmiarów we/wy i wyprzedzania odczytu.

Do pamięci masowej dodaję również pamięć podręczną RAM i dedykowane pamięci podręczne aplikacji. Redis/Memcached przechwytuje hot keys, podczas gdy Linux page cache obsługuje wiele powtarzających się odczytów. Celowo zapewniam wystarczającą ilość pamięci RAM, aby NVMe nie przetwarzała niepotrzebnie tego, co i tak pochodziłoby z pamięci podręcznej. Warstwowanie pamięci RAM, NVMe, SSD i HDD gwarantuje, że najszybszy poziom jest maksymalnie odciążony i wykorzystywany w ukierunkowany sposób.

Protokoły i ścieżki dostępu: lokalne, sieciowe i NVMe-oF

Lokalne woluminy NVMe zapewniają najniższe opóźnienia - bezkonkurencyjne dla OLTP i dzienników transakcji. Tam, gdzie zapewniam pamięć masową przez sieć, wybieram protokół zgodnie z wymaganiami: NFS jest elastyczny i dobry dla farm serwerów internetowych, iSCSI zapewnia urządzenia blokowe dla maszyn wirtualnych i baz danych, SMB obsługuje obciążenia systemu Windows. NVMe over Fabrics (NVMe-oF) jest opcją dla klastrów o ekstremalnych opóźnieniach, ponieważ wykorzystuje semantykę NVMe w RDMA lub TCP. Kluczowe znaczenie mają czyste ramki jumbo, QoS w sieci, wielościeżkowe IO dla odporności i segmentacja, która oddziela ruch w pamięci masowej od komunikacji wschód-zachód. W ten sposób unikam korków na autostradzie danych i utrzymuję stabilną przepustowość i opóźnienia.

Spójność danych, migawki i replikacja

Definiuję cele RPO/RTO dla każdej warstwy: ściśle replikuję dane transakcyjne, często używając procedur synchronicznych lub prawie synchronicznych, podczas gdy dane archiwalne są wystarczające asynchronicznie. Migawki spójne z aplikacją (DB-Quiesce, zamrożenia systemu plików) zapobiegają niespójnościom logicznym. Polityka migawek: częste, krótkotrwałe migawki na NVMe, rzadsze, długotrwałe kopie na SSD/HDD. Utrzymuję spójną replikację we wszystkich warstwach - na przykład NVMe→NVMe dla gorących ścieżek i SSD/HDD→nośniki o odpowiedniej pojemności dla zimnych zapasów. Ważnymi punktami są okna niezmienności (niezmienne migawki) w celu zablokowania przypadkowych lub złośliwych zmian, a także separacja lokalizacji w celu uzyskania prawdziwej odporności.

Odporność na oprogramowanie ransomware i mechanizmy ochrony

Planuję warstwy ochrony, które wykraczają poza zwykłe kopie zapasowe. Niezmienne migawki ze zdefiniowanym oknem czasu retencji, oddzielne domeny administratorów i bezpieczny dostęp API zapobiegają atakom na wszystkie kopie. Polegam również na mechanizmach zapisu-jednorazowego-odczytu-wielu (logiczny WORM), szczegółowym monitorowaniu nietypowych profili I/O (np. masa małych zmian, rzucająca się w oczy entropia) i oddzielnych ścieżkach logowania do systemów kopii zapasowych i systemów produkcyjnych. Zapewnia to możliwość odzyskania danych nawet w najgorszym scenariuszu, a ja osiągam krótkie czasy odzyskiwania bez kosztownych pełnych wyłączeń.

Możliwość obsługi wielu klientów i I/O QoS

W środowiskach z wieloma dzierżawcami zapobiegam efektowi „hałaśliwego sąsiada“ dzięki wyraźnym limitom IOPS i przepustowości na wolumin lub maszynę wirtualną. Na poziomie bloków używam profili QoS; po stronie hosta, cgroups/blkio i ionice pomagają ustawić priorytety. Dławię zadania wymagające intensywnego zapisu (ETL, kopie zapasowe) na podstawie kontrolowanego czasu, tak aby obciążenia front-end utrzymywały swoje budżety opóźnień w godzinach szczytu. Na poziomach dysków twardych planuję duże rezerwy na czas odbudowy, aby awaria nie powaliła na kolana wydajności wszystkich klientów. Rezultatem jest stabilna przepustowość, nawet jeśli poszczególne projekty generują obciążenia szczytowe.

Planowanie wydajności, wymiarowanie i zarządzanie zużyciem

Obliczam hybrydową pamięć masową nie tylko w terabajtach, ale także w IOPS, budżetach opóźnień i TBW/dysk zapisów dziennie. W przypadku NVMe planuję 20-30 rezerw %, aby odśmiecanie i zadania w tle miały wystarczająco dużo miejsca. W przypadku dysków SSD biorę pod uwagę nadmiar rezerw; modele korporacyjne z wyższym OP lepiej amortyzują obciążenia związane z zapisem. Pule dysków twardych dobieram zgodnie z oknami odbudowy: im większe dyski, tym ważniejsze są poziomy parzystości (RAID6/60), dyski zapasowe i szczupłe strategie odbudowy (np. częściowa odbudowa). Przyjmuję założenia dotyczące wzrostu (miesięczny wzrost, obciążenia szczytowe, efekty sezonowe) i wcześnie planuję okna rozbudowy, aby uniknąć kosztownych aktualizacji ad hoc.

Awarie, przebudowy i stabilność operacyjna

Konfiguracje hybrydowe pozostają odporne tylko wtedy, gdy można zaplanować odbudowę. Regularnie testuję scenariusze degradacji i odbudowy: Jak zachowują się opóźnienia podczas resynchronizacji kopii lustrzanej NVMe? Jak długo trwa odbudowa dysku twardego przy pełnej pojemności? Scrubs, sumy kontrolne i kontrole integralności w tle identyfikują wkradające się błędy. W przypadku usterek kontrolera lub backplane'u planuję koncepcje hot spare i cold spare, a także przejrzyste zarządzanie częściami zamiennymi. Zwracam uwagę na parzystość oprogramowania układowego, aby mieszane stany nie prowadziły do pętli resynchronizacji lub spadków wydajności.

Operacyjna lista kontrolna i rozwiązywanie problemów

Tworzę runbooki do codziennego użytku: krótkie testy porównawcze FIO do weryfikacji po konserwacji, kontrole SMART/health z wartościami progowymi, regularne zadania TRIM/discard, okresy reindeksacji systemów wyszukiwania i zdefiniowane bramki zdrowotne przed wydaniami. Usuwam typowe wzorce błędów - zbyt głęboką lub zbyt płytką głębokość kolejki, niewyrównane partycje, brak zapisu zwrotnego z BBU, dławienie termiczne - za pomocą jasnych standardowych środków. Dane telemetryczne trafiają do raportów wydajności, które łączą zarówno perspektywę techniczną, jak i biznesową.

Zgodność z przepisami, ochrona danych i ochrona kluczy

Szyfruję dane w sposób przyjazny dla zwierząt, w zależności od ich wrażliwości: NVMe z szyfrowaniem OS lub wolumenu, SSD/HDD opcjonalnie obsługiwane sprzętowo. Ścieżka klucza pozostaje ściśle oddzielona, a procesy rotacji/odzyskiwania są udokumentowane. Dostęp jest przyznawany na zasadzie need-to-know, a dzienniki audytu rejestrują zmiany w regułach warstwowania, migawkach i zadaniach replikacji. Platforma spełnia zatem powszechne wymogi zgodności bez utraty wydajności operacyjnej.

Ścieżki migracji i stopniowe wprowadzanie

Migruję istniejące środowiska etapami: Najpierw przenoszę gorące ścieżki (dzienniki transakcji, indeksy, cache) na NVMe, a następnie często używane dane na SSD. Zimne dane pozostają na razie, ale są konsolidowane na HDD z jasnymi regułami retencji. Na każdym etapie mierzę wpływ na opóźnienia 95/99 percentyla i kluczowe wskaźniki wydajności. Pozwala to w przejrzysty sposób określić ilościowo korzyści płynące z podejścia hybrydowego i skoncentrować budżet tam, gdzie poprawa w przeliczeniu na euro jest największa.

Krótkie podsumowanie

Dzięki przemyślanemu połączeniu NVMe, SSD i HDD, zapewniam szybkie transakcje, stabilne czasy ładowania i przystępne pojemności - w skrócie: hosting NVMe SSD HDD do praktycznych zastosowań. Obciążenia. NVMe należy do gorących ścieżek i dzienników, SSD obsługuje pliki internetowe i CMS, a HDD archiwa i kopie zapasowe. Automatyczny tiering utrzymuje wolne szybkie poziomy i zmniejsza koszty bez narażania doświadczenia użytkownika [1][6][11]. Monitorowanie i jasne zasady umożliwiają planowanie infrastruktury, a aktualizacje i testy zapewniają jej działanie. Ci, którzy korzystają z hybrydowej pamięci masowej, konsekwentnie kontrolują wzrost, utrzymują budżety pod kontrolą i tworzą platformę, która może reagować na nowe wymagania. uruchamia się.