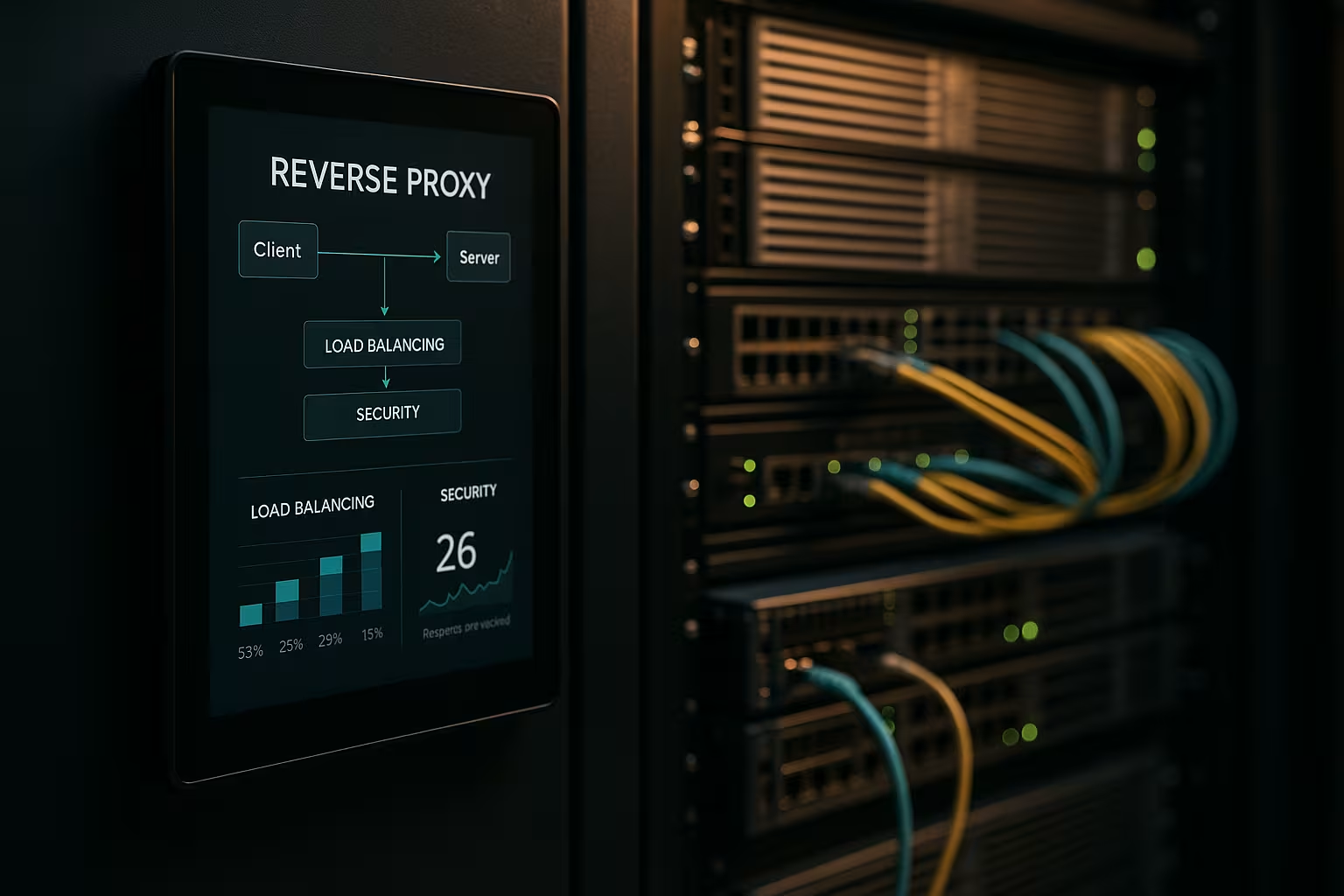

Архитектура обратного прокси ускоряет запросы, защищает внутренние системы и масштабирует веб-приложения без модификации серверов приложений. Я показываю, как Обратный прокси ощутимо повышает производительность, безопасность и масштабирование в повседневной работе.

Центральные пункты

- Производительность благодаря кэшированию, разгрузке SSL и HTTP/2/3

- Безопасность через WAF, защиту от DDoS и блокировку IP/гео.

- Масштабирование с балансировкой нагрузки и проверкой работоспособности

- Управление благодаря централизованной маршрутизации, регистрации и анализу

- Практика с NGINX, Apache, HAProxy, Traefik

Что делает архитектура обратного прокси?

Я установил Реверс прокси перед серверами приложений и заставляю его завершать все входящие соединения. Таким образом, я инкапсулирую внутреннюю структуру, скрываю IP-адреса и минимизирую прямые атаки. Прокси решает, какая служба примет запрос, и может кэшировать содержимое. Он заботится о TLS, сжатии и оптимизации протоколов, таких как HTTP/2 и HTTP/3. Это заметно снижает нагрузку на серверы приложений и дает мне место для рекомендаций, оценок и быстрых изменений.

Оптимизация производительности: кэширование, разгрузка, границы

Я сочетаю КэшированиеSSL-разгрузка и пограничная доставка для снижения задержек. Я обслуживаю общие ресурсы, такие как изображения, CSS и JS, из кэша, а динамические части остаются свежими (например, с помощью кэширования фрагментов). Я использую такие политики, как stale-while-revalidate и stale-if-error, чтобы сократить время ожидания и обеспечить доставку в случае сбоев. TLS 1.3, замена HTTP/2 push через ранние подсказки и сжатие Brotli обеспечивают дополнительное ускорение. Для международных пользователей прокси-сервер прокладывает маршруты к близлежащим узлам, что сокращает время до получения первого байта. Обзор подходящих Преимущества и сценарии применения показывает, какие настройки стоит выполнить в первую очередь.

Улучшение ситуации с безопасностью: WAF, DDoS, геоблокировка

Я анализирую трафик на Прокси-сервер и фильтровать вредоносные запросы до того, как они достигнут внутренних систем. WAF распознает такие шаблоны, как SQL-инъекции или XSS, и останавливает их централизованно. Прерывание TLS позволяет проверять зашифрованный поток данных, после чего я пересылаю его в чистом виде. Защита от DDoS зависит от прокси, который распределяет, ограничивает или блокирует запросы, не затрагивая приложения. Гео- и IP-блокировка отсекает известные источники, а ограничение скорости и обнаружение ботов сдерживают злоупотребления.

Масштабирование и высокая доступность с помощью балансировки нагрузки

Я распределяю нагрузку через Загрузить Алгоритмы балансировки, такие как Round Robin, Least Connections или взвешенные правила. Я защищаю липкие сессии с помощью cookie affinity, если сессии должны оставаться привязанными к узлу. Проверка работоспособности активно проверяет сервисы, чтобы прокси автоматически удалял неисправные цели из пула. Горизонтальное масштабирование работает в считанные минуты: зарегистрируйте новые узлы, обновите конфигурацию, готово. Для выбора инструмента достаточно короткого Сравнение инструментов для балансировки нагрузки с акцентом на функции L7.

Централизованное управление и точный контроль

Я собираю журналы централизованно в Шлюз и измерять такие ключевые показатели, как время отклика, пропускная способность, количество ошибок и TTFB. Приборные панели показывают "горячие точки", медленные конечные точки и пики трафика. Анализ заголовков (например, хиты кэша, возраст) помогает точно настроить стратегии кэширования. Идентификаторы корреляции позволяют отслеживать запросы в разных службах и ускоряют анализ первопричин. Я устанавливаю стандартизированные правила для профилей HSTS, CSP, CORS и TLS на прокси-сервере, а не отдельно в каждом сервисе.

Маршруты, правила и релизы без риска

Я контролирую Маршрутизация на основе имени хоста, пути, заголовков, cookies или геоинформации. Это позволяет мне маршрутизировать API и фронтенды отдельно, даже если они работают на одних и тех же портах. Я внедряю сине-зеленые и канареечные релизы непосредственно на прокси, направляя небольшие группы пользователей на новые версии. Заголовки с флагами возможностей помогают проводить контролируемые тесты в условиях реального трафика. Я делаю окна обслуживания короткими, потому что переключаю маршруты за секунды.

Сравнение технологий на практике

Я выбираю Инструменткоторый соответствует нагрузке, протоколу и операционным целям. NGINX выигрывает благодаря статическому контенту, TLS, HTTP/2/3 и эффективным функциям обратного прокси. Apache выигрывает в средах с .htaccess, обширными модулями и устаревшими стеками. HAProxy обеспечивает очень сильную балансировку L4/L7 и тонкий контроль над проверкой работоспособности. Traefik хорошо интегрируется в контейнерные системы и динамически считывает маршруты из ярлыков.

| Решение | Сильные стороны | Типичные применения | Специальные характеристики |

|---|---|---|---|

| NGINX | Высокий Производительность, HTTP/2/3, TLS | Веб-фронтэнды, API, статические поставки | Brotli, кэширование, разгрузка TLS, потоковый модуль |

| Apache | Модульные Гибкость.htaccess | Устаревшие стеки, установки с большим содержанием PHP | Множество модулей, тонкая обработка доступа |

| HAProxy | Эффективный Балансировка, Медицинские осмотры | L4/L7 балансировщик нагрузки, шлюз | Очень подробные, сложные ACL |

| Traefik | Динамический Discovery, Контейнерный фокус | Kubernetes, Docker, микросервисы | Автоматическая конфигурация, интеграция с LetsEncrypt |

Этапы реализации и контрольный список

Я начинаю с ЦелиОпределите приоритеты производительности, безопасности, доступности и бюджета. Затем я определяю протоколы, сертификаты, наборы шифров и версии протоколов. Я четко определяю правила маршрутизации и их версии, политики кэширования и ограничения. Перед запуском я настраиваю проверки работоспособности, наблюдаемость и оповещения. Если вы хотите приступить к работе прямо сейчас, вы можете найти обучающий обзор на сайте Настройте обратный прокси-сервер для Apache и NGINX.

Лучшие практики настройки производительности

Я активирую HTTP/3 с QUIC там, где клиенты его поддерживают, и поддерживаю HTTP/2 для широкой совместимости. Я использую Brotli для текстовых ресурсов и заставляю прокси эффективно сжимать изображения. Я намеренно определяю ключи кэша, чтобы контролировать изменения через куки или заголовки. Я минимизирую время рукопожатия TLS, использую возобновление сеанса и устанавливаю сшивание OCSP. Я использую ранние подсказки (103), чтобы дать браузеру предварительные сигналы для критических ресурсов.

Безопасная установка без потерь на трение

Я держу Сертификаты централизованно и автоматизировать продление с помощью ACME. HSTS обеспечивает соблюдение HTTPS, а CSP и CORP контролируют содержимое. Я создаю консервативную базу правил WAF и постепенно ужесточаю ее, чтобы избежать ложных срабатываний. Ограничения скорости, mTLS для внутренних служб и списки IP-адресов снижают риск на ежедневной основе. Журналы аудита остаются защищенными от несанкционированного доступа, поэтому я могу отследить инциденты с юридической точностью.

Затраты, эксплуатация и окупаемость инвестиций

Я планирую Бюджет за серверные ресурсы, сертификаты, защиту от DDoS и мониторинг. Небольшие системы часто начинаются с нескольких виртуальных ядер и 4-8 ГБ оперативной памяти для прокси-сервера, что в зависимости от провайдера обходится в двузначные суммы евро в месяц. Более крупные парки используют выделенные экземпляры, anycast и глобальные узлы, что может означать трехзначные суммы в евро на каждое место. Централизованное управление экономит время: меньше индивидуальных конфигураций, быстрее процессы выпуска и короче время простоя. Окупаемость инвестиций выражается в повышении конверсии, снижении числа отказов и более продуктивной работе инженеров.

Варианты архитектуры и топологии

Я выбираю архитектуру в соответствии с профилем риска и задержки. Простые среды хорошо работают с одним Шлюз в DMZ, который перенаправляет запросы к внутренним службам. В регулируемых или крупных средах я разделяю внешние и внутренние прокси на два этапа: первый этап завершает интернет-трафик и управляет WAF, DDoS и кэшированием, второй этап осуществляет внутреннюю маршрутизацию, использует mTLS и обеспечивает соблюдение принципов нулевого доверия. Активные/неактивные системы с anycast IP и глобально распределенными узлами сокращают время восстановления после сбоев и оптимизируют близость к пользователю. Для CDN перед обратным прокси я обеспечиваю корректную пересылку заголовков (например, X-Forwarded-Proto, Real-IP) и согласованную иерархию кэша, чтобы пограничный и шлюзовой кэш не блокировали друг друга. Я инкапсулирую многопользовательские сценарии с помощью SNI/TLS, отдельных маршрутов и изолированных ограничений скорости, чтобы избежать эффекта соседства.

Протоколы и особые случаи: WebSockets, gRPC и HTTP/3

Я рассматриваю протоколы с особыми требованиями, чтобы функции оставались стабильными. Для WebSockets Я активирую поддержку обновлений и длительных соединений с подходящими таймаутами. gRPC выигрывает от HTTP/2 и чистых заголовков; я избегаю H2C (простой текстовый HTTP/2) на периметре в пользу TLS с правильным ALPN. Для HTTP/3 Я предоставляю порты QUIC (UDP) и ограничиваю только 0-RTT, поскольку повторы несут в себе риски. Потоковые конечные точки, события, отправляемые сервером, и большие загрузки имеют свои собственные политики буферизации и размера тела, чтобы прокси не стал узким местом. Для трансляции протоколов (например, HTTP/2 снаружи, HTTP/1.1 внутри) я тщательно тестирую нормализацию заголовков, сжатие и повторное использование соединений, чтобы сохранить низкие задержки и предсказуемое потребление ресурсов.

Аутентификация и авторизация на шлюзе

Я переезжаю Авторизация-Решения передаются обратному прокси, если архитектура и соответствие требованиям позволяют это сделать. Я интегрирую OIDC/OAuth2 через проверку токенов на шлюзе: прокси проверяет подписи (JWKS), проверяет срок действия, аудитории и диапазоны и устанавливает проверенные утверждения в качестве заголовков для сервисов. Я использую ключи API для межмашинных конечных точек и ограничиваю их по маршрутам. Для внутренних систем я полагаюсь на mTLS с взаимной проверкой сертификатов, чтобы сделать доверие явным. Я слежу за тем, чтобы не записывать в журнал чувствительные заголовки (авторизация, cookies) без необходимости, и использую списки разрешений/запретов для каждого маршрута. Я формулирую тонкие политики с помощью ACL или выражений (например, путь + метод + требование), что позволяет мне централизованно контролировать доступ без изменения кода приложения.

Устойчивость: тайм-ауты, повторные попытки, откат и разрыв цепи

Я определяю Тайм-ауты на каждый прыжок: установление соединения, таймаут заголовка и таймаут ответа. Я активирую повторные попытки только для идемпотентных методов и комбинирую их с экспоненциальным бэкоффом плюс джиттер, чтобы избежать громогласных стад. Автоматические выключатели защищают внутренние пулы: Если прокси обнаруживает скачки ошибок или задержек, он временно размыкает цепь, пересылает только случайные запросы к затронутому месту назначения и в противном случае отвечает раньше, опционально с возвратом из кэша. Обнаружение выбросов автоматически удаляет "слабые" экземпляры из пула. Я также ограничиваю одновременные восходящие потоки, активирую повторное использование соединений и использую очереди со справедливым распределением приоритетов. Это обеспечивает стабильность сервисов, даже если отдельные компоненты испытывают нагрузку.

Соответствие нормативным требованиям, защита данных и защита PII

Я отношусь к прокси как к Концентратор данных с четкими правилами защиты данных. Я маскирую или псевдонимизирую личные данные в журналах; строки запросов и чувствительные заголовки регистрируются только на основе белых списков. Я сокращаю IP-адреса, где это возможно, и придерживаюсь строгих сроков хранения данных. Доступ к журналам и метрикам зависит от роли, а изменения документируются с учетом аудита. Для проведения аудита я связываю события шлюза с записями управления изменениями, чтобы можно было отследить утверждения и обновления правил. Это позволяет мне выполнять требования по соблюдению нормативных требований, не жертвуя глубокими знаниями о производительности и безопасности.

Kubernetes, Ingress и Gateway API

Я интегрирую обратный прокси в Оркестровка контейнеров. В Kubernetes я использую контроллеры ингресса или более современный API шлюза для декларативного описания маршрутизации, TLS и политик. Traefik считывает метки динамически, NGINX/HAProxy предлагают сложные варианты ingress для высокой пропускной способности. Я отделяю внутреннюю маршрутизацию кластера с востока на запад (service mesh) от шлюза по периметру с севера на юг, чтобы ответственность оставалась четкой. Я внедряю канареечные релизы с взвешенными маршрутами или совпадениями заголовков, при этом строго определяя проверки работоспособности и готовность стручков, чтобы не допустить сбоев. Я верстаю конфигурации в виде кода и тестирую их в стейджинговых кластерах с симуляцией нагрузки перед запуском.

Операционная зрелость: управление конфигурацией и CI/CD

Я рассматриваю конфигурацию прокси как Код. Изменения отправляются через pull request, автоматически тестируются (синтаксис, линтинг, проверка безопасности) и разворачиваются в конвейерах. Я использую предварительные просмотры или теневой трафик для проверки новых маршрутов в реальных условиях без риска для клиентских транзакций. Откат возможен за считанные секунды, поскольку я маркирую версии и развертываю их атомарно. Я управляю конфиденциальными секретами (сертификатами, ключами) отдельно, в зашифрованном виде и с минимальными полномочиями. Для обеспечения высокой доступности я распределяю релизы по узлам в шахматном порядке и фиксирую их эффект в инструментальных панелях, чтобы быстро принять контрмеры в случае регрессий.

Типичные камни преткновения и антишаблоны

Я избегаю Источники ошибоккоторые часто встречаются на практике. Я предотвращаю отравление кэша с помощью строгой нормализации заголовков и чистого управления Vary; я исключаю из ключа кэша куки, которые не влияют на рендеринг. Я распознаю петли перенаправления на ранней стадии, тестируя X-Forwarded-Proto/Host и применяя последовательные политики HSTS/CSP. "Доверять всем X-Forwarded-For" - это табу: я доверяю только следующему хопу и устанавливаю Real-IP в чистом виде. Я контролирую большие загрузки с помощью лимитов и потоковой передачи, чтобы прокси не буферизировал, что бэкенд может делать лучше. С 0-RTT в TLS 1.3 я обращаю внимание на идемпотентность. И я слежу за размерами тела и заголовков, чтобы отдельные запросы не занимали всю рабочую мощность.

Резюме для быстрого принятия решений

Я ставлю на Реверс прокси, потому что он сочетает в себе скорость, защиту и масштабирование в одном месте. Кэширование, разгрузка TLS и HTTP/2/3 значительно ускоряют реальное время загрузки. WAF, защита от DDoS и контроль IP/geo заметно снижают риски. Балансировка нагрузки, проверка работоспособности и скользящие релизы обеспечивают доступность сервисов даже во время роста. С помощью NGINX, Apache, HAProxy или Traefik я нахожу четкое решение для любой установки и обеспечиваю управляемость операций.