Мультиплексирование HTTP/2 объединяет множество запросов в одно соединение и устраняет препятствия на уровне протоколов. Однако в реальных сетях TCP-Head-of-Line, TLS-Overhead и неэффективная приоритезация замедляют работу, поэтому HTTP/2 не работает автоматически быстрее, чем HTTP/1.1.

Центральные пункты

- Мультиплексирование параллелизует множество запросов через одно TCP-соединение.

- TCP-HoL остается в силе и при убытках останавливает все потоки.

- Настройка TLS может значительно задержать время до получения первого байта.

- Приоритеты и Server Push работают только при правильной настройке.

- Тип страницы Решение: много маленьких файлов против нескольких больших.

Как работает мультиплексирование HTTP/2 внутри

Я разбиваю каждый ответ на небольшие части кадры, нумерую их и распределяю по логическим потокам, чтобы несколько ресурсов одновременно проходили через одно соединение. Таким образом я избегаю блокировок на уровне HTTP, поскольку ни один запрос больше не должен ждать окончания другого. Браузеры отправляют HTML, CSS, JS, изображения и шрифты параллельно, что снижает затраты на дополнительные соединения. Благодаря HPACK размер заголовков уменьшается, что значительно снижает нагрузку при большом количестве небольших файлов. Однако решающим фактором остается то, что все потоки используют одну и ту же линию TCP, что дает преимущества, но также создает новые зависимости. Эта архитектура обеспечивает скорость, пока сеть остается стабильной и Расстановка приоритетов работает эффективно.

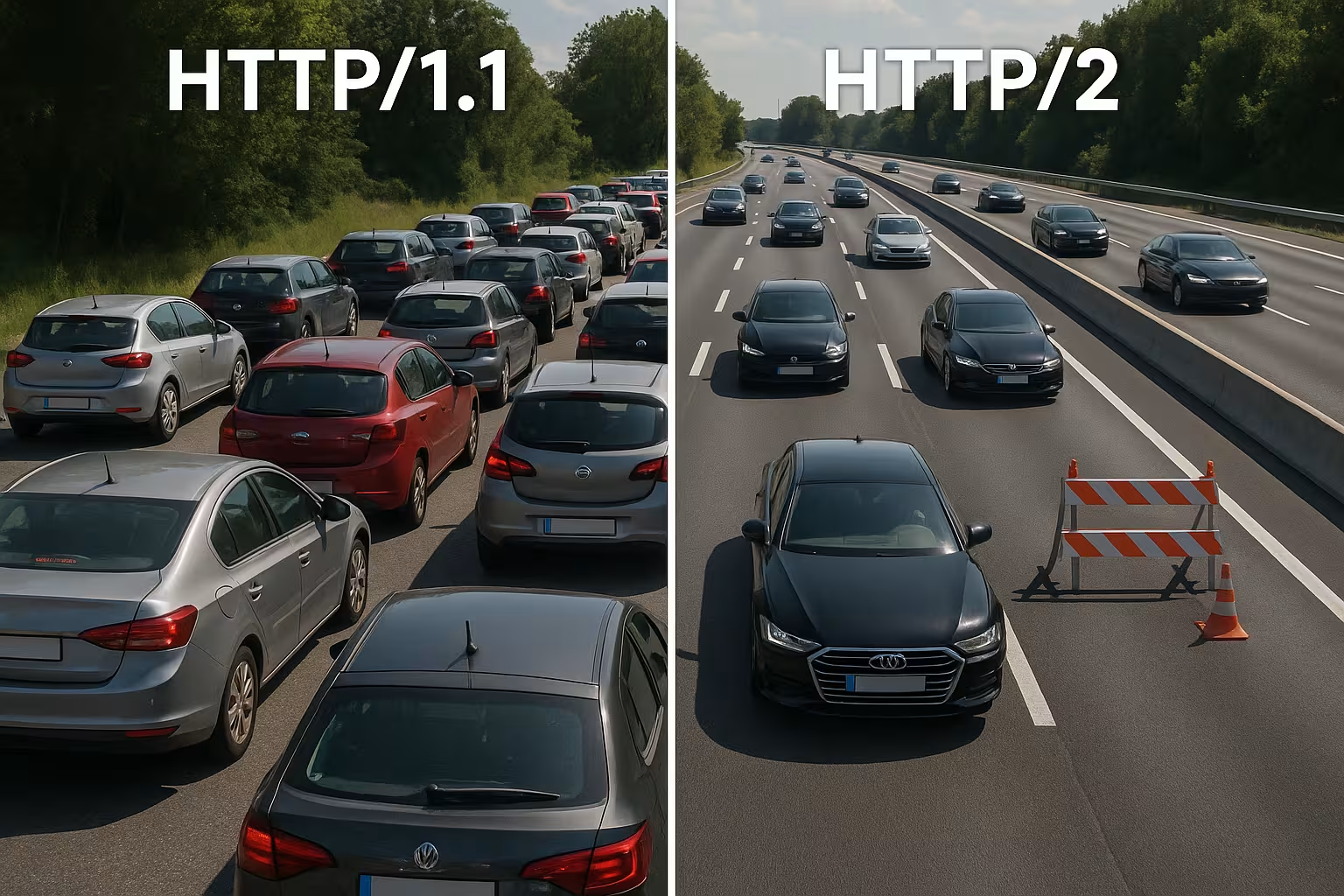

HTTP/1.1 против HTTP/2: основные различия

HTTP/1.1 использует текстовые сообщения и несколько параллельных соединений на каждый хост для одновременной загрузки ресурсов, что увеличивает количество рукопожатий и накладные расходы. HTTP/2 работает в бинарном режиме, использует одно соединение для всего и сжимает заголовки, что сокращает время ожидания, особенно при большом количестве объектов. В водопадных диаграммах исчезают длинные очереди, потому что потоки продвигаются параллельно. Вместо этого узкое место перемещается с HTTP-уровня на TCP-уровень, что я явно ощущаю в нестабильных сетях. Небольшие, сильно кэшированные страницы часто не имеют преимуществ по сравнению с 1.1, в то время как большие, богатые ресурсами страницы получают более заметную выгоду. Эти различия формируют мое Стратегия настройки и оправдывают решение, принятое с учетом специфики проекта.

Правильный выбор управления потоком и размера окон

HTTP/2 обеспечивает собственный контроль потока для каждого потока и каждого соединения. Я обращаю внимание на значимые значения для INITIAL_WINDOW_SIZE и количество одновременных потоков, чтобы линия не была перегружена и не работала с недогрузкой. Слишком маленькие окна создают ненужное количество WINDOW_UPDATE-фреймы и ограничивают скорость передачи данных, слишком большие окна могут перегружать слабые клиенты. В сетях с высоким продуктом пропускной способности и задержки (BDP) я целенаправленно увеличиваю размер окна, чтобы большие ответы не застревали в режиме «стоп-анд-гоу». Одновременно я ограничиваю MAX_CONCURRENT_STREAMS Прагматичный подход: достаточно параллелизма для критически важных элементов рендеринга, но не настолько, чтобы мелкие детали замедляли загрузку LCP-изображения. Эти настройки незначительны, но их влияние на реальные времена загрузки велико, если они подходят для сайта и сети.

Переоценка доменного шардинга и бондинга

Многие оптимизации 1.1 являются контрпродуктивными в HTTP/2. Я отказываюсь от старого доменного шардинга, потому что одно хорошо используемое соединение более эффективно, чем искусственно распределенные сокеты. Я также ставлю под сомнение агрессивное объединение JavaScript в мегафайлы: более мелкие, логически разделенные пакеты позволяют использовать целевые кэши и избегать необходимости перезагрузки всего приложения при внесении изменений. Спрайты изображений теряют свое значение, потому что параллельные запросы стали дешевыми, а современные форматы изображений, включая кэширование, работают лучше. Таким образом, я устраняю мультиплексирование там, где оно может принести пользу, и объединяю только в тех случаях, когда это действительно упрощает архитектуру или заметно увеличивает коэффициент попадания в кэш.

Объединение соединений и сертификаты

HTTP/2 позволяет браузерам использовать одно соединение для нескольких доменных имен, если сертификаты и DNS совпадают. Я планирую записи SAN и SNI таким образом, чтобы было возможно объединение и не требовалось дополнительных рукопожатий. Если ALPN и наборы шифров совпадают, клиент может использовать CSS от cdn.example.com и фотографии static.example.com через одну и ту же линию. Это экономит RTT, упрощает приоритезацию и увеличивает вероятность того, что критически важные ресурсы будут доставлены без задержек. Я проверяю эти эффекты в вкладке «Сеть»: действительно ли используется только один сокет, или ограничения сертификатов и политики заставляют браузер устанавливать новые соединения?

Почему мультиплексирование тормозится: TCP‑Head‑of‑Line

Если на единственном TCP-соединении теряется пакет, вся линия ожидает повторной передачи, что на короткое время останавливает все HTTP/2-потоки. Поэтому в мобильных сетях с колеблющейся задержкой и повышенным коэффициентом потерь я регулярно наблюдаю меньшие выгоды или даже недостатки по сравнению с несколькими соединениями 1.1. Этот эффект объясняет, почему мультиплексирование выглядит блестяще на бумаге, но не всегда работает на практике. Измерения, проведенные в ходе исследований и полевых испытаний, показывают именно эту зависимость в реальных сетях [6]. Поэтому я планирую развертывания консервативно, тестирую на типичных пользовательских траекториях и проверяю влияние на каждую целевую группу. Игнорируя TCP-HoL, вы теряете Производительность и может даже увеличить время загрузки.

TLS-рукопожатие, TTFB и тип страницы

HTTP/2 работает в Интернете почти исключительно через TLS, что создает дополнительные рукопожатия и может заметно увеличить время до получения первого байта при небольшом количестве ресурсов. Если я передаю только один большой файл, преимущество мультиплексирования теряется, поскольку параллельная передача не требуется. Страницы с десятью-двадцатью небольшими файлами получают больше преимуществ, в то время как ответы с одним ресурсом часто находятся на одном уровне с HTTP/1.1. Я сокращаю накладные расходы с помощью TLS 1.3, возобновления сеанса и чистого Keep-Alive, чтобы не было повторных подключений и канал действительно работал. Для точного управления я использую Настройка Keep-Alive, чтобы настроить повторы, таймауты простоя и ограничения в соответствии с нагрузкой. Таким образом, уменьшается доля рукопожатий, а TTFB стабилизируется даже при пиковых нагрузках трафика.

CDN и прокси-цепочки: h2 до источника

Многие стеки завершают TLS на границе и продолжают общаться с источником. Я проверяю, используется ли HTTP/2 между CDN и бэкэндом или происходит переход на HTTP/1.1. Буферизующие прокси могут частично нивелировать преимущества (сжатие заголовков, приоритезация), если они пересериализуют ответы или меняют порядок. Поэтому я оптимизирую систему от начала до конца: пограничный узел, промежуточный прокси и исходный сервер должны понимать h2, использовать подходящие размеры окон и не игнорировать приоритеты. Там, где целесообразно использовать h2c (HTTP/2 без TLS во внутренней сети), я проверяю, позволяет ли это сократить задержку и снизить нагрузку на ЦП без нарушения политики безопасности. Только согласованная цепочка позволяет раскрыть весь потенциал Мультиплексированиеэффект полностью.

Правильное использование приоритетов

Я присваиваю высокий приоритет критическим ресурсам, чтобы HTML, CSS и изображение LCP поступали в первую очередь, а блокировки рендеринга исчезали. Без четких приоритетов менее важные скрипты потребляют ценную пропускную способность, в то время как контент выше линии сгиба остается в ожидании. Не все серверы правильно учитывают приоритеты браузера, а некоторые прокси-серверы изменяют порядок, поэтому я анализирую фактические данные, а не желаемое [8]. Заголовки Preload и раннее размещение ссылок на изображения сокращают пути загрузки и повышают точность попадания в кэш. Приоритезация не творит чудес, но она направляет соединение таким образом, что пользователи быстро видят то, что им нужно. Четкие правила приносят ощутимый результат. Упор и делают мультиплексирование действительно эффективным.

Приоритезация на практике: расширяемые приоритеты

Браузеры усовершенствовали свои модели приоритезации. Я учитываю, что современные клиенты часто используют „расширяемые приоритеты“ вместо жестких весов дерева. При этом они сигнализируют о срочности и прогрессивных параметрах для каждого потока, которые серверы должны интерпретировать и переводить в справедливые планировщики. Я проверяю, уважает ли мой сервер эти сигналы или основан на старом поведении. В A/B-тестах я сравниваю пути загрузки с приоритезацией на стороне сервера и без нее, чтобы выявить эффекты вытеснения. Важно: приоритезация должна отдавать предпочтение критическим для рендеринга элементам, но не должна приводить к «голоданию» длительных загрузок. Тщательно сбалансированный микс позволяет избежать пиков и сохранять конвейер для видимого контента свободным.

Server Push: редко сокращение

Я использую серверный push только в определенных случаях, потому что чрезмерный push занимает пропускную способность и игнорирует кэш браузера. Если уже кэшированный ресурс подвергается push, путь замедляется, а не ускоряется. Многие команды отключили push и работают с презагрузкой, которая значительно более надежна [8]. В особых случаях, например на повторяющихся маршрутах с четкими шаблонами, push может быть полезен, но я доказываю его эффективность с помощью измерений. Без доказательств я удаляю push и оставляю конвейер свободным для действительно необходимых данных. Здесь часто меньше значит больше. подробнее, прямо на единственном соединении.

Сравнение на практике: когда HTTP/1.1 может быть быстрее

Я считаю HTTP/1.1 конкурентоспособным, когда преобладают несколько больших файлов или сети работают с большими потерями. В этом случае несколько отдельных соединений распределяют риск и могут сократить время получения первого байта. На очень маленьких страницах дополнительные TLS-рукопожатия часто полностью компенсируют преимущества мультиплексирования. При наличии множества небольших объектов, напротив, HTTP/2 имеет преимущество, поскольку действуют сжатие, приоритезация и единственный сокет. В следующей таблице приведены типичные модели из аудитов и полевых испытаний, которые определяют мой выбор протокола [6][8]. Эта таблица не заменяет тестирование, но дает надежную Ориентация для принятия первых решений.

| Сценарий | Улучшенный протокол | Причина |

|---|---|---|

| Множество мелких ресурсов (CSS/JS/изображения/шрифты) | HTTP/2 | Мультиплексирование и HPACK снижают накладные расходы, достаточно одного соединения |

| Немного очень больших файлов | HTTP/1.1 ≈ HTTP/2 | Параллельность практически не требуется; затраты на установление соединения имеют большее значение |

| Нестабильные мобильные сети с потерями | HTTP/1.1 частично лучше | TCP‑HoL останавливает все потоки в HTTP/2; несколько сокетов могут помочь |

| Оптимизированный TLS (1.3, возобновление), четкие приоритеты | HTTP/2 | Меньшая настройка, целенаправленное управление пропускной способностью |

| Over‑Pushing активен | HTTP/1.1/HTTP/2 без Push | Ненужные данные блокируют линию; предварительная загрузка более безопасна |

Лучшие практики для реального сокращения времени загрузки

Я сокращаю количество байтов перед протоколом: изображения в WebP/AVIF, подходящие размеры, экономичные скрипты и чистые заголовки кэширования. Я сокращаю критические части пути CSS, загружаю шрифты заранее и устанавливаю резервные варианты, чтобы избежать сдвигов макета. Для установления соединения и DNS я использую Preconnect и DNS‑Prefetch, чтобы рукопожатия начинались до того, как парсер наткнется на ресурс. Brotli для текстового контента ускоряет повторные запросы, особенно через CDN. Я контролирую эффекты в водопаде и сравниваю LCP, FID и TTFB до и после изменений. Измеренные значения определяют мои Приоритеты, интуиция — нет.

gRPC, SSE и потоковые случаи

HTTP/2 особенно хорошо проявляет свои преимущества при использовании gRPC и других двунаправленных или длительных потоков. Я обращаю внимание на таймауты, размеры буферов и правила задержки, чтобы задержка одного потока не влияла на все остальные запросы. Для событий, отправляемых сервером, и прямых трансляций полезно иметь стабильное, постоянное соединение, при условии, что сервер правильно управляет приоритетами и ограничения Keep-Alive не срабатывают слишком рано. Одновременно я тестирую, как ведут себя ошибки: восстановление потоков, экспоненциальный бэкофф и разумные ограничения для повторных подключений предотвращают пиковые нагрузки, когда многие клиенты одновременно прерывают соединение и подключаются заново. Таким образом, сценарии в реальном времени остаются предсказуемыми.

Настройка ОС и TCP для стабильной производительности мультиплексирования

Выбор протокола не компенсирует слабую конфигурацию сети. Я проверяю алгоритмы управления перегрузкой (например, BBR против CUBIC), буферы сокетов, политики быстрого открытия TCP и размер начального окна перегрузки. Управление перегрузкой, соответствующее пути, может уменьшить количество повторных передач и смягчить эффекты HoL. Не менее важно: правильные значения MTU/MSS, чтобы предотвратить фрагментацию и предотвратимые потери. На уровне TLS я предпочитаю короткие цепочки сертификатов, OCSP-стекинг и сертификаты ECDSA, потому что они ускоряют рукопожатие. В совокупности эти настройки дают мультиплексированию необходимую Подконструкция, чтобы приоритезация и сжатие заголовков могли проявить свое действие.

Стратегия измерения и KPI в повседневной работе

Я не полагаюсь на медианные значения, а смотрю на p75/p95 метрик, разделенных по устройствам, типам сетей и местоположениям. Синтетические тесты предоставляют воспроизводимые базовые значения, а мониторинг реальных пользователей показывает распределение в поле. Я сравниваю водопады ключевых путей, проверяю ранние байты HTML, порядок CSS/JS и время прибытия изображения LCP. Я внедряю изменения в виде контролируемых экспериментов и параллельно наблюдаю за TTFB, LCP и коэффициентами ошибок. Важно: приоритеты без измеримой пользы я удаляю. Таким образом, конфигурация остается компактной, и я инвестирую в настройки, которые статистически гарантированно экономят время.

Трафик роботов-пауков и ботов

Помимо пользователей, от чистого HTTP/2 выигрывают и сканеры. Я активирую h2 для соответствующих конечных точек и наблюдаю, используют ли боты соединение повторно и загружают ли больше страниц за то же время. Ненужные каскады 301, несжатые ответы или слишком короткие лимиты Keep-Alive затрагивают бюджет сканирования. Я согласовываю политики, чтобы мультиплексирование работало и здесь, не превышая ограничения бэкэнда. Результат: более эффективное сканирование и большая стабильность под нагрузкой.

HTTP/2, HTTP/3 и что будет дальше

HTTP/3 использует QUIC через UDP и устраняет блокировку TCP Head-of-Line, что особенно помогает в случае мобильности и потерь [6]. Установление соединения происходит быстрее, и блокировка потоков больше не затрагивает все запросы одновременно. В смешанных флотах HTTP/2 по-прежнему остается важным, но я активирую HTTP/3 там, где клиенты и CDN уже его поддерживают. Подробные сравнения, такие как HTTP/3 против HTTP/2 помогают мне планировать внедрение поэтапно и с учетом целевой аудитории. Я провожу измерения отдельно по местоположению, устройству и типу сети, чтобы реальные пользователи могли извлечь из этого выгоду. Таким образом, я использую протоколы, чтобы Время загрузки в повседневных ситуациях.

Хостинг и инфраструктура как ускорители

Хорошие протоколы не спасут слабую инфраструктуру, поэтому я тщательно проверяю местоположение, пиринг, CPU, RAM и ограничения ввода-вывода. Современный веб-сервер, разумное количество рабочих процессов и кэш-слой предотвращают возникновение узких мест в единственном соединении. Стратегическое использование CDN сокращает RTT и смягчает пиковые нагрузки. Те, кто обслуживает пользователей по всей Европе, часто получают больше выгоды от коротких путей, чем от тонкой настройки протоколов. Я планирую емкость с запасом, чтобы всплески трафика не приводили к сбоям. Так мультиплексирование раскрывает свой потенциал. Потенциал надежный.

Быстро распознавайте шаблоны ошибок

Если HTTP/2 работает медленнее, чем ожидалось, я ищу типичные шаблоны: одна длинная передача, блокирующая множество небольших; игнорируемые приоритеты; высокие показатели повторной передачи на мобильных трассах; или неработающая возобновление TLS. Затем я сравниваю HTTP/2 и HTTP/1.1 в идентичных условиях, отделяю влияние CDN от источника и смотрю на количество сокетов, фактическое количество потоков и порядок первых килобайт. Если обнаруживается узкое место, я сначала корректирую основные параметры (байты, кэширование, рукопожатия), а затем занимаюсь потоковым управлением или приоритетами. Такой порядок действий дает наиболее надежные улучшения.

Практическое резюме для быстрого принятия решений

Я использую мультиплексирование HTTP/2, когда возникает много объектов, приоритеты действуют и TLS настроен правильно. При небольшом количестве больших файлов или нестабильных сетях я рассчитываю на небольшие преимущества и слежу за результатами 1.1. Я использую Server Push только при наличии доказательств, почти всегда использую Preload и минимизирую накладные расходы за счет сжатия, кэширования и ранних подключений. Измерения с использованием реальных устройств и местоположений подтверждают мои предположения, прежде чем я широко внедряю изменения [6][8]. В конце концов, важен не номер протокола, а ощутимая скорость для реальных пользователей. Кто поступает таким образом, тот надежно извлекает выгоду из HTTP/2. Скорость и закладывает основу для HTTP/3.