Anycast Geo-DNS entscheidet heute, wie schnell, sicher und verlässlich Nutzer deine Inhalte erreichen. Ich zeige die technischen Unterschiede, reale Einsatzfelder und eine klare Entscheidungslogik, mit der du in 2025 die passende Smart-DNS-Routing-Strategie wählst.

Zentrale Punkte

- Anycast: Automatische Nähe, sehr niedrige Latenz

- Geo‑DNS: Gezielte Steuerung, regionale Regeln

- DDoS: Verteilung schützt globale Nameserver

- Compliance: Datenstandorte und Sprachversionen

- Hybrid: Automatik plus Regeln vereint

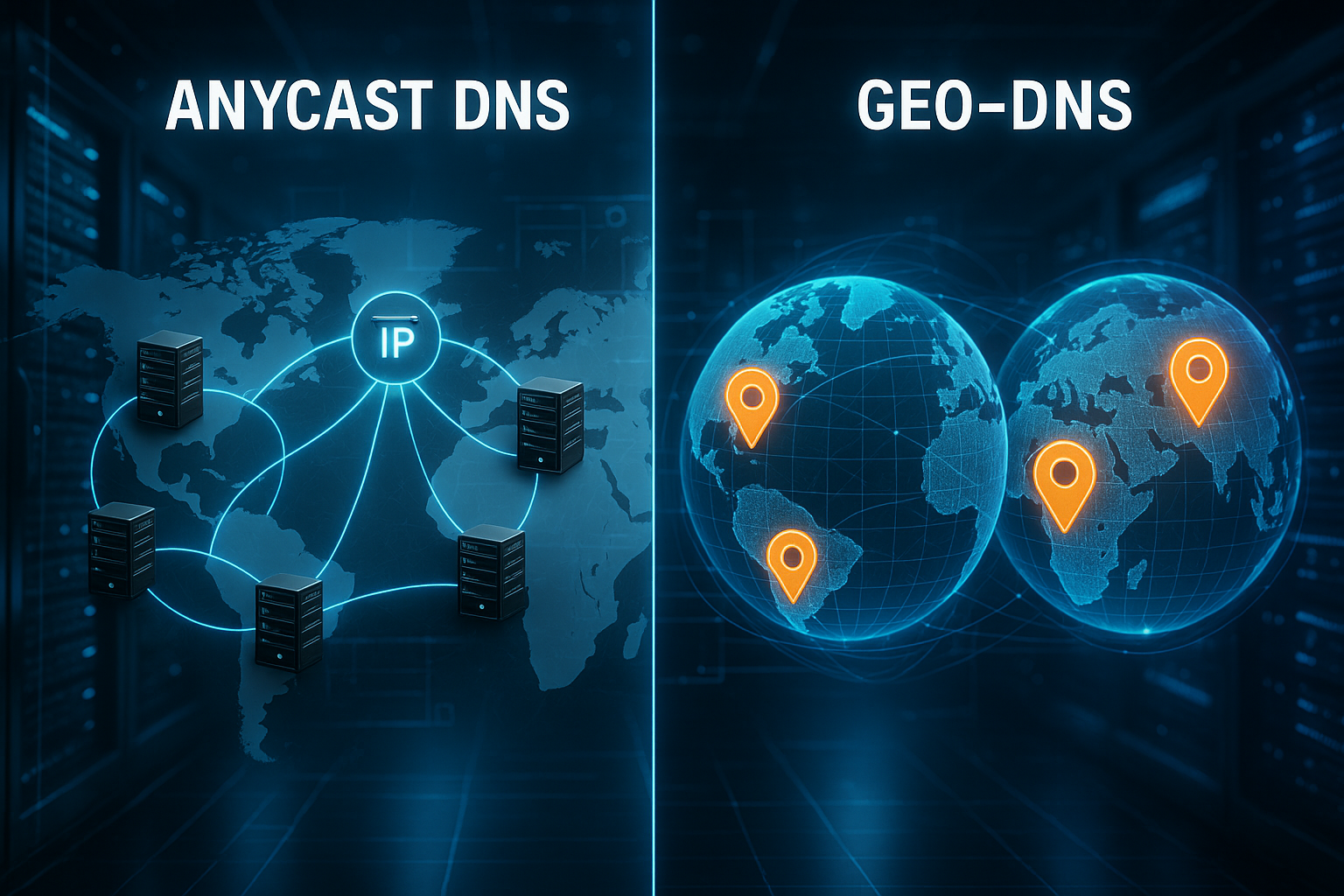

Wie Anycast DNS funktioniert

Bei Anycast teilen sich mehrere Nameserver dieselbe IP, und BGP leitet Anfragen automatisch zum am besten erreichbaren Knoten. Ich profitiere davon, weil Nutzer aus jeder Region die kürzeste Route erhalten. Die Latenz sinkt, da kein zentraler Server alle Anfragen abarbeiten muss. Fällt ein Standort aus, übernimmt der nächste Knoten ohne manuelle Umschaltung. So bleiben Auflösung und Erreichbarkeit auch bei Störungen verlässlich.

Größere Anycast-Netze decken Hunderte Städte weltweit ab und senken dadurch die Antwortzeit spürbar. Je dichter das Netz, desto geringer ist die Streuung der Latenz über Regionen. Ich sehe in Monitoring-Daten oft Drops von zweistelligen Millisekunden. Dazu kommt ein natürlicher DDoS-Vorteil: Angriffe verteilen sich auf viele Knoten und verlieren Wirkung. Diese Eigenschaften machen Anycast zur Standardwahl für globalen Traffic.

Geo-DNS in der Praxis

Geo‑DNS ordnet Anfragen anhand des Quellstandorts gezielt einem Serverpool zu. Ich steuere damit, dass Benutzer in Deutschland deutsche Server und Inhalte erhalten. Das schafft sprachliche Konsistenz, kürzere Wege zu regionalen Caches und erfüllt Datenresidenz‑Vorgaben. Für Kampagnen kann ich Regionen trennen, A/B testen und Lastverteiler pro Land autorisieren. So lassen sich regionale Unterschiede sauber abbilden.

Wichtig bleibt die Konfiguration. Geo‑Zonen, IP‑zu‑Region‑Mappings und Failover‑Pfade müssen sauber definiert sein. Ich beachte dazu die TTL der Records, da sie die Umschaltgeschwindigkeit bestimmt. Für Rollouts helfen mir verkürzte Time-to-Live-Werte, die ich später wieder erhöhe; hier liefert der Leitfaden zu optimale DNS‑TTL hilfreiche Eckwerte. Mit dieser Disziplin bleiben Routing und Nutzererlebnis planbar.

Anycast vs. Geo-DNS im direkten Vergleich 2025

Ich treffe die Wahl anhand von Routing, Latenz, Kontrolle, Ausfallsicherheit und Pflegeaufwand. Anycast punktet mit Automatik und kurzen Wegen ohne viele Regeln. Geo‑DNS überzeugt mit gezielter Steuerung, etwa für Sprachversionen, regionale Preise und Gesetze. Bei globalen Shops zähle ich jede Millisekunde und setze daher häufig auf Anycast. Brauche ich hingegen klare Ländertrennung, greife ich auf Geo‑Regeln zurück.

| Aspekt | Anycast | Geo-DNS |

|---|---|---|

| Routing-Prinzip | Automatisch zum nächstgelegenen/besten Knoten | Standortbasiert per Region-Regeln |

| Latenz | Sehr niedrig, ohne viele Eingriffe | Abhängig von Konfiguration und Verteilung |

| Kontrolle | Wenig manuelle Steuerung nötig | Feingranular, mehr Administration |

| Skalierung | Weltweit sehr gut | Gut, aber verwaltungsintensiver |

| DDoS-Schutz | Starke Verteilung der Last | Gut, Fokus auf Regionen möglich |

| Ausfallsicherheit | Automatische Umleitung bei Ausfällen | Hoch mit sauberem Failover |

| Einrichtung | Nahezu plug‑and‑play | Aufwendige Planung der Regeln |

| Beste Verwendung | Globale Sites mit viel Traffic | Lokale Inhalte, Gesetze, Sprachen |

Entscheidend bleibt die Zielsetzung. Für maximale Performance und einfache Pflege schiebt Anycast die Anfragen in die Nähe der Nutzer. Für standortbewusste Features liefert Geo‑DNS die nötige Regelbasis. Beides kann koexistieren und sich ergänzen. So erhalte ich Flexibilität ohne Verzicht auf Tempo. Diese Kombi trägt viele Produkt‑Roadmaps über Jahre.

Leistungswerte, Latenz und Ausfallsicherheit

Ich messe die Antwortzeit der DNS‑Resolver über mehrere Kontinente und sammele Median‑ und P95‑Werte. Anycast reduziert typischerweise die Streuung, was den P95 deutlich drückt. Geo‑DNS liefert Vorteile, wenn ich Nutzer in regionalen Clustern halte. Für Ausfälle plane ich Health‑Checks, die fehlerhafte Ziele aus dem Pool nehmen. So bleibt die Erreichbarkeit selbst bei Teilausfällen hoch.

Ein zweiter Hebel ist die TTL. Kurze TTLs beschleunigen Änderungen und Failover, erhöhen aber die Anfragezahl. Lange TTLs entlasten die Infrastruktur, verzögern jedoch Umschaltungen. Ich nutze gestaffelte TTL‑Strategien mit vorbereiteten Cutover‑Fenstern. Monitoring‑Alarme prüfen dabei Rate, NXDOMAINs und Servo‑Codes. Dadurch erkenne ich Anomalien früh und reagiere proaktiv.

Sicherheitsaspekte, DNSSEC und DDoS

Ich aktiviere DNSSEC, um Manipulationen der Antworten zu verhindern. Signierte Zonen schützen vor Spoofing und Man‑in‑the‑Middle. Bei Anycast bleibt die Signaturkette konsistent über alle Knoten. Geo‑DNS erfordert saubere Signaturen pro Variante der Antwort, damit die Kette gültig bleibt. Regelmäßige Rollovers der Schlüssel und Tests mit Validierern gehören in den Betrieb.

Gegen DDoS setze ich auf mehrschichtige Maßnahmen. Anycast verteilt ungewollte Last und steigert die Aufnahmefähigkeit der Nameserver. Rate‑Limits, DNS‑Cookies und Response‑Padding verteuern Angriffe zusätzlich. Ich prüfe zudem die Fähigkeit zum automatischen Blackholing. So bleibt der Autoritativ‑Dienst lieferfähig, selbst wenn einzelne Vektoren zuschlagen.

Hybrid-Architektur: Regeln plus Automatik

Ein Hybrid aus Anycast und Geo‑DNS vereint Tempo und Steuerbarkeit. Ich lasse die Nameserver per Anycast an die Nutzer rücken. Gleichzeitig definiere ich Geo‑Regeln für Länder, Sprachen oder Partnerzonen. Diese Struktur spielt ihre Stärke aus, wenn Compliance und Geschwindigkeit zusammen zählen. Für die Auslieferungsebene ergänze ich das mit Multi‑CDN‑Strategien und regionalen Caches.

Wichtig ist eine klare Priorität der Regeln. Gesundheitschecks entscheiden zuerst, Geografie danach, und Features wie Weighted‑Routing schließen ab. Ich dokumentiere diese Kaskade, damit Teams sie verstehen. Für Releases plane ich Stufen, die ich bei Bedarf zurückdrehe. So bleiben Rollouts beherrschbar, auch in Spitzenzeiten.

Einsatzszenarien und Fallbeispiele

Für globale E‑Commerce-Shops liefert Anycast das beste Verhältnis aus Aufwand und Gewinn. Jede Millisekunde entscheidet Conversion, und Ausfälle kosten Umsatz. Medienportale kombinieren Geo‑Regeln mit Anycast, um regionale Inhalte und schnelle Auflösung zu verbinden. SaaS‑Anbieter mit Datenresidenz nutzen Geo‑DNS für Ländervorgaben und bleiben performant durch Anycast‑Nameserver. Für die Kante der Auslieferung ziehe ich Edge‑ und CDN‑Hosting hinzu, damit die Strecke zum Endnutzer kurz bleibt.

CDNs profitieren stark von Anycast, weil POP‑Nähe direkte Latenzvorteile bringt. Unternehmensportale mit lokalen Sprachen setzen auf Geo‑DNS, damit Inhalte regional passen. Gaming‑Services benötigen beides: schnelles Routing und regionale Session‑Anker. Auf Ereignisse wie Sales oder Releases reagiere ich mit temporär kürzeren TTLs. Nach dem Peak hebe ich sie wieder an, um Last zu reduzieren.

Provider-Auswahl und Kosten

Ich prüfe das echte Anycast-Fußabdruck des Anbieters und die Dichte der Standorte. SLAs mit klarer Uptime‑Zusage und Credits bringen Verbindlichkeit in den Betrieb. Ein integrierter DDoS‑Schutz senkt das Risiko teurer Ausfälle. DNSSEC‑Support mit einfacher Schlüsselpflege spart Zeit. APIs, Rollback‑Funktionen und Änderungslogs helfen mir im Alltag.

Bei Kosten schaue ich auf Requests, Zonen, Queries‑per‑Second und Zusatzfeatures. Free‑Tiers helfen beim Start, doch für kritische Systeme kalkuliere ich Reserven ein. In Europa plane ich Budgets von zweistelligen bis niedrigen dreistelligen Euro pro Monat je nach Traffic. Große Plattformen erreichen vierstellige Beträge, sparen aber durch weniger Ausfälle schnell ein. Versteckte Gebühren für DNSSEC oder Advanced‑Routing notiere ich im Vergleich.

Operative Tipps für Setup und Betrieb

Ich starte mit klaren Zielen: Latenz, Fehlerquote, Zeit bis zur Änderung. Dann richte ich synthetische Tests pro Region ein, die DNS‑Antworten und End‑to‑End messen. Für Geo‑Regeln pflege ich IP‑Region‑Daten und teste Grenzfälle. Health‑Checks müssen schneller sein als die TTL, sonst klappt das Failover zu spät. Änderungsprotokolle halte ich sauber, damit ich Konfigurationen schnell zurückrollen kann.

Für den Tag‑2‑Betrieb zählt Transparenz. Dashboards zeigen Query‑Raten, Verteilung, Fehler und Latenz. Warnungen reagieren auf Abweichungen jenseits definierter Schwellen. Ich führe regelmäßig Fire‑Drills durch: gezielte Knotenabschaltungen, um Failover zu verifizieren. Dokumentation und Runbooks helfen, wenn es ernst wird. So bleibt der Dienst auch unter Druck verlässlich.

Resolver-Verhalten, Caching und TTL-Fallen

Ich berücksichtige das Verhalten großer Resolver (Access‑Provider, Public DNS), weil sie die Wirkung meiner Strategie prägen. Anycast entscheidet zwar, welcher Autoritativ‑Knoten antwortet, doch der Endnutzer erlebt die Latenz des für seinen Resolver nächstgelegenen POPs. Arbeitet ein Unternehmen mit zentralem Egress, landen Anfragen aus Filialen oft bei einem weit entfernten Resolver – Geo‑Zuordnung kann dann vom Firmensitz statt vom Nutzerstandort ausgehen. Ich bewerte daher Catchments für Nutzer‑ und Resolver‑Standorte getrennt.

Caches bringen Tempo, bergen aber TTL-Fallstricke. Manche Resolver setzen TTL‑Untergrenzen oder -Obergrenzen, wodurch sehr kurze oder sehr lange TTLs nicht wie geplant wirken. Features wie serve‑stale liefern bei Autoritativ‑Ausfällen noch alte Antworten aus – gut für Verfügbarkeit, aber heikel bei dringenden Umschaltungen. Ich kalibriere meine TTLs so, dass Failover‑Ziele zuverlässig erreicht werden, und teste negative Caches: NXDOMAIN‑Antworten werden separat gecacht und können Fehlkonfigurationen überraschend lang konservieren.

Mit Geo‑DNS beachte ich, dass verschiedene Nutzer über denselben Resolver laufen können, der eventuell in einer anderen Region steht. EDNS‑Erweiterungen zur Standortnähe werden aus Datenschutzgründen nicht überall eingesetzt. Ich plane daher konservativ: Geo‑Regeln arbeiten mit Clustern statt mit zu feinen Grenzen, und ich dokumentiere Ausnahmen (z. B. Grenzregionen oder Roaming‑Netze), um Fehltargeting zu minimieren.

IPv6, DoH/DoQ und moderne Record-Typen

Ich stelle eine konsistente Dual‑Stack-Strategie sicher: A und AAAA erhalten gleichwertige Ziele, Health‑Checks prüfen beide Protokolle. Ungleichgewicht führt sonst zu einseitigen Engpässen. Moderne Resolver und Browser nutzen Happy Eyeballs; schleppende IPv6‑Endpunkte verschlechtern dennoch die wahrgenommene Latenz. Ich teste deshalb IPv4/IPv6 getrennt und im Verbund.

Verschlüsselte Resolver‑Protokolle wie DoH und DoQ verändern Pfade und Latenzen, da Anfragen neue Transitwege nehmen können. Anycast bleibt nützlich, doch Catchments verschieben sich geringfügig. Ich messe End‑to‑End statt mich auf einzelne Hop‑Zeiten zu fixieren. Zusätzlich setze ich auf HTTPS/SVCB-Records, um Clients früh zu signalisieren, welche Endpunkte und Protokolle bevorzugt sind. Das verkürzt Verbindungsaufbau und schafft Raum für feinere Routing‑Signale in der Zukunft.

An der Zone‑Spitze nutze ich ALIAS/ANAME bzw. Flattening, um CDN‑ oder Geo‑Ziele trotz Apex‑Beschränkung sauber zu verweisen. Dabei prüfe ich, wie mein Provider Geo‑Antworten flacht, damit keine Inkonsistenzen zwischen Ketten entstehen. Für Services mit vielen Unterdomänen halte ich CNAME‑Ketten kurz, um zusätzliche Resolver‑Roundtrips zu vermeiden.

Multi-Provider-Authority und Delegation

Für hohe Resilienz plane ich Multi‑Provider bei Autoritativ‑DNS. Unterschiedliche NS in getrennten AS‑Netzen reduzieren systemische Risiken. Ich achte auf konsistente Zonensignierung: Schlüssel‑ und Algorithmuswahl müssen bei allen Anbietern zusammenpassen. Für Rollovers koordiniere ich KSK/ZSK über alle Plattformen und teste Validierungen, bevor ich Schalter umlege.

Bei der Delegation prüfe ich Glue‑Records beim Registry, Delegations‑TTL und DS‑Einträge sorgfältig. Änderungen an NS‑Sets oder DS brauchen Zeit, bis sie weltweit wirken. Ich nutze deshalb Stufen: neuen Provider hinzufügen, Konsistenz prüfen, alten erst danach entfernen. Für die Zonenpflege setze ich, wo möglich, auf Hidden‑Primary mit AXFR/IXFR und NOTIFY. Das verhindert Drift zwischen Providern und hält die Serial‑Logik simpel.

Im Betrieb werte ich pro NS‑IP die Query‑Verteilung aus. Unbalance weist auf Catchment‑Anomalien oder Limits hin. Ich halte die Anzahl der NS schlank (typisch 2‑4 Anbieter‑IPs), damit Resolver nicht in Timeouts laufen und Retries die Latenz erhöhen.

Rollouts: Weighted, Canary und Blau/Grün

Ich rolle Änderungen mit Weighted‑Routing und Canaries aus. Kleine Prozentsätze fangen Fehler früh ab, ohne viele Nutzer zu stören. Geo‑Regeln kombiniere ich mit Gewichten, etwa um ein Land pilotweise umzustellen. Bei stateful Backends plane ich Session‑Affinität außerhalb des DNS – DNS selbst ist zustandslos und garantiert keine Bindung. Lastverteiler oder Tokens übernehmen die Klebeeffekte.

Für Blau/Grün betreibe ich zwei Zielwelten parallel und schalte via DNS‑Cutover. Vor dem Flip senke ich TTLs stufenweise, danach erhöhe ich sie wieder. Health‑Checks laufen dabei enger als die TTL, damit Ausschlüsse vor dem Caching greifen. Ich definiere zudem Degradationspfade: lieber ein Feature temporär abdrehen als globalen Traffic zu verlieren.

Bei Geo‑DNS vermeide ich Regel‑Explosion. Ich gruppiere Länder mit ähnlicher Infrastruktur, ersetze Sonderregeln durch Datenmodelle (z. B. Preiszonen) und beschränke die Anzahl aktiver Pools. Das senkt Pflegeaufwand und Fehlerfläche.

Messung und Troubleshooting in der Praxis

Ich bewerte Tail‑Latenzen (P95/P99) pro Region und vergleiche sie mit Catchment‑Karten. Sprünge deuten auf Routing‑Änderungen, überlastete POPs oder Resolver‑Retransmits hin. SERVFAIL‑ und FORMERR‑Spitzen weise ich DNSSEC‑Fehlern, Größenlimits oder defekten Antworten zu. NXDOMAIN‑Anstiege signalisieren Client‑Bugs oder Tippfehler‑Kampagnen; ich nutze Filter, um legitime und fehlerhafte Queries zu trennen.

Zur Fehlersuche prüfe ich die SOA-Serial pro NS, vergleiche Signaturen und beobachte Response‑Größen. Fragmentierung kann UDP‑Antworten ausbremsen; ich aktiviere gegebenenfalls TCP‑Fallback‑Metriken und EDNS‑Tuning. Traceroutes zur Anycast‑IP zeigen, welcher POP aktuell bedient – bei Abweichungen ziehe ich Provider‑Peering‑Events in Betracht.

Runbooks enthalten Schalter für serve‑stale, Abschalten einzelner Regeln und Notfall‑TTL‑Sets. Ich halte Kontaktwege zu Providern parat und automatisiere Post‑Mortems: Logs, Metriken, Change‑Sets und Zeitleisten landen in einem Paket, das Ursachen schnell sichtbar macht.

Compliance- und Datenschutz konkret

Ich definiere, welche Logdaten anfallen, wo sie liegen und wie lange sie gespeichert werden. IP‑Adressen gelten als personenbezogen; Aufbewahrung und Pseudonymisierung kläre ich mit Legal. Geo‑DNS‑Entscheidungen dokumentiere ich nachvollziehbar: Regeln, Quellen der Geo‑Daten und Freigaben. Für Datenresidenz stelle ich sicher, dass nicht nur die App‑Server, sondern auch Caches, Proxies und Telemetrie in den zulässigen Regionen verbleiben.

Split‑Horizon nutze ich für interne und externe Sichten, halte jedoch die Risiken im Blick: Vermischte Zonen führen schnell zu Inkonsistenzen. Ich trenne Namen strikt (z. B. corp.example vs. public example) und verhindere, dass interne Records versehentlich öffentlich werden. Änderungsfreigaben und Vier‑Augen‑Prinzip sind hier kein Luxus, sondern Pflicht.

Kurzüberblick: Welche Option wähle ich?

Ich greife zu Anycast, wenn globale Performance, wenig Pflege und Ausfallsicherheit im Vordergrund stehen. Für regionale Inhalte, Sprachen und Gesetze nutze ich Geo‑DNS mit klaren Regeln. In vielen Fällen kombiniere ich beides und erhalte Tempo plus Steuerung. Diese Mischung deckt E‑Commerce, Medien, SaaS und Gaming gut ab. Entscheidend bleiben Messwerte, klare Ziele und ein Anbieter mit breiter Abdeckung, starken SLAs und guter Bedienbarkeit.