Caching Hierarchien liefern die schnellsten Ladezeiten, wenn ich jede Ebene gezielt einsetze: Opcode, Seite, Browser und Edge. Ich zeige in klaren Schritten, wie ich diese Schichten kombiniere, Konflikte vermeide und Konfigurationen so setze, dass Anfragen kürzer werden und der TTFB sichtbar sinkt.

Zentrale Punkte

Damit der Überblick sitzt, fasse ich die Kernthemen zuerst zusammen und ordne sie direkt an den Leistungszielen aus. Ich erkläre alle Ebenen mit konkreten Einstellungen, damit die Umsetzung ohne Umwege gelingt. Ich grenze dynamische Teile sauber aus, um Personalisierung zu bewahren. Ich optimiere Header und Cache-Keys so, dass kein unnötiger Miss im Cache entsteht. Zum Schluss führe ich alles in einer stringenten Kette zusammen, sodass jeder Abruf die schnellste Route nimmt.

- Opcode beschleunigt PHP

- Seiten-Cache verkürzt TTFB

- Browser spart Bandbreite

- Edge reduziert Latenz

- Orchestrierung verhindert Konflikte

Was meint „Caching Hierarchien“ konkret?

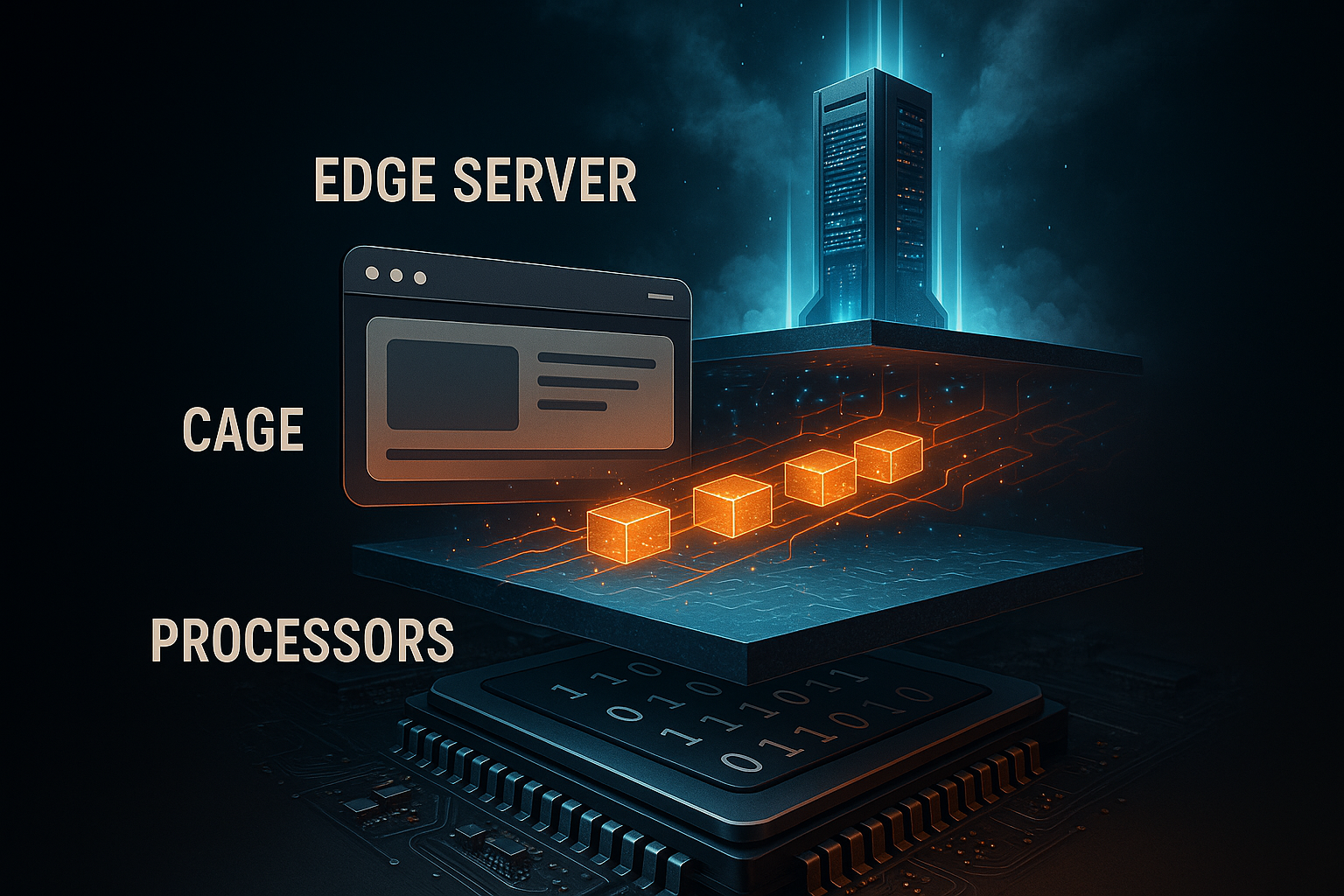

Ich verstehe unter Hierarchie die gestaffelte Zwischenspeicherung vom Serverkern bis zum Endgerät. Jede Lage beantwortet eine andere Frage: Muss der Server Code neu kompilieren, muss PHP die Seite neu rendern, muss der Browser Assets neu laden, oder liefert ein Edge-Knoten bereits fertige Inhalte nahe am Nutzer aus. Ich vermeide doppelte Arbeit, indem ich die Ebenen harmonisiere und klare Verantwortungen vergebe. So reduziere ich CPU-Last, Backend-Queries und Netzwerklatenz, ohne Funktionalität zu verlieren. Eine kurze Einführung zu den Stufen finde ich in diesem kompakten Leitfaden: Caching-Ebenen einfach.

Opcode-Caching: PHP sofort beschleunigen

Beim Opcode-Caching halte ich kompilierten PHP-Bytecode im RAM und spare mir das wiederholte Parsen. Das beschleunigt jeden Request, der PHP berührt, besonders CMS-Workloads wie WordPress. Ich aktiviere OPcache und dimensioniere den Speicher großzügig genug, damit häufige Skripte nie verdrängt werden. Ich setze eine moderate Revalidierung, damit Änderungen zeitnah sichtbar bleiben, ohne zu oft zu prüfen. So bringe ich sowohl CPU-Last als auch Antwortzeiten spürbar nach unten.

Typische OPcache-Parameter in der php.ini setze ich bewusst konservativ, beobachte die Hit-Rate und passe nach Bedarf an. Ich halte die Anzahl beschleunigter Dateien hoch genug, damit das Projekt komplett Platz findet. Ich nutze Preloading für zentrale Klassen, damit selbst Kaltstarts schneller ablaufen. Änderungen deploye ich mit Cache-Reset, um keine inkonsistenten Zustände zu riskieren. Der Konfigurationsblock dient mir als Startpunkt und nicht als starres Dogma.

opcache.enable=1

opcache.memory_consumption=256

opcache.max_accelerated_files=20000

opcache.validate_timestamps=1

opcache.revalidate_freq=2

Ich prüfe regelmäßig die OPcache-Statistiken, denn nur Messung zeigt, ob der Cache trägt oder thrash’t. Dashboards des Hostings oder PHP-Statusseiten helfen mir, die Zahl der Misses zu minimieren. Ich meide zu kleine Speicherwerte, die zu Evictions führen. Ebenfalls vermeide ich zu seltene Validierung, damit Produktivänderungen nicht stecken bleiben. Mit dieser Balance arbeite ich effizient und sicher.

Seiten-Caching: HTML ohne Wartezeit

Beim Seiten-Cache speichere ich das fertige HTML, sodass PHP und Datenbank gar nicht mehr laufen. Das reduziert TTFB drastisch und bringt die größten Sprünge unter Last. Ich schließe personalisierte Pfade wie Warenkorb, Checkout und Nutzerkonten konsequent aus. Gleichzeitig kapsle ich kleine dynamische Teile über AJAX oder Edge-Side-Includes, damit der Rest hart aus dem Cache kommen kann. So bleibt die Seite schnell, ohne wichtige Individualität zu verlieren.

Ich entscheide, ob ich Server-Level-Caching nutze oder mit einem Plugin arbeite. Auf dem Server erreiche ich die beste Latenz, Plugins geben mir flexible Steuerung im CMS. Preload-Mechanismen füllen den Cache vor, damit Erstaufrufe nicht warten. Ich räume verwaiste Einträge per Purge-Regeln auf, wenn ich Inhalte aktualisiere. Für besonders teure Bereiche kombiniere ich zusätzlich Object-Cache, damit Datenbankzugriffe seltener stattfinden.

Browser-Caching: Assets lokal halten

Beim Browser-Cache lasse ich statische Dateien wie Bilder, CSS und JS lokal liegen. Wiederkehrende Besucher laden dann fast nichts mehr nach, und der Server bleibt frei. Ich setze lange max-age-Werte für unveränderliche Assets, die ich mit Dateinamen-Versionierung versehe. Dynamische Endpunkte versehe ich mit kurzen Zeiten oder must-revalidate, damit die App aktuell bleibt. So senke ich Bandbreite und optimiere wahrgenommene Geschwindigkeit.

Ich achte auf eine saubere Mischung aus Cache-Control, ETag und Last-Modified. Bei unveränderlichen Dateien setze ich immutable, damit der Browser nicht unnötig prüft. Für Ressourcen mit häufigen Updates nutze ich bedingte Anfragen per ETag. Ich vermeide doppeldeutige Header, denn widersprüchliche Signale führen zu Missverständnissen. Kontrolle halte ich direkt im Webserver oder via CMS-Plugin, abhängig von meiner Umgebung.

Edge-Caching: Nähe zum Nutzer

Über Edge-Netze liefere ich Inhalte in globalen PoPs aus, was Latenz minimiert und Peaks glättet. HTML, Bilder und APIs können je nach Regelwerk nahe am Nutzer bedient werden. Ich arbeite mit Cache-Keys, die nur notwendige Variablen enthalten, damit die Fragmentierung gering bleibt. Regeln wie stale-while-revalidate und stale-if-error sorgen dafür, dass Nutzer sofort eine gültige Kopie sehen, selbst wenn der Origin gerade warm läuft. Internationale Zielgruppen profitieren besonders, weil Routingzeiten spürbar sinken.

Ich trenne Varianten, wenn Mobile und Desktop stark voneinander abweichen. Checkout und Kontobereich lasse ich an der Kante bewusst aus, um Kollisionen mit Sitzungen und Cookies zu vermeiden. Ich prüfe regelmäßig die Hit-Rate und passe TTLs an, bis sich optimale Quoten einstellen. Ein praxisnahes Vertiefen bietet dieser Edge‑Caching Guide mit Fokus auf Latenz und Netzwerkwege. Saubere Purge-Strategien halte ich griffbereit, damit Aktualisierungen sofort weltweit greifen.

HTTP-Header richtig setzen

Die Header steuern, wie weit Inhalte reisen dürfen und wann sie neu validiert werden. Mit Cache-Control bestimme ich Sichtbarkeit, Lebensdauer und Revalidierungspflichten. ETag identifiziert eine Ressource eindeutig und ermöglicht If-None-Match-Anfragen. Last-Modified bietet einen Fallback für Clients, die ETags ignorieren. Ich halte die Kombination klar, damit Client, CDN und Origin dieselben Erwartungen teilen.

Die folgende Übersicht nutze ich als praktische Referenz bei der Konfiguration. Ich prüfe jede Zeile gegen den Ressourcentyp und das Änderungsverhalten. Bei statischen Dateien setze ich lange Max-Age-Werte mit immutable. Für häufig aktualisierte Inhalte reduziere ich die Dauer und verlasse mich auf bedingte Requests. So bleibt der Datenpfad effizient und korrekt.

| Header | Funktion |

|---|---|

| Cache-Control | Steuert Dauer, Sichtbarkeit, Revalidierung (z. B. max-age, public, must-revalidate) |

| ETag | Eindeutige Kennung einer Version, Basis für bedingte Abrufe |

| Last-Modified | Zeitstempel als Alternative zu ETag, dient der Validierung |

Cache-Invalidierung und Freshness-Strategien

Ich plane Invalidierung so sorgfältig wie das Caching selbst. Punktuelles Purge nach ID, Tag oder Pfad verhindert Voll-Flushs, die Kosten verursachen. Beim Deployment räume ich nur das, was sich wirklich geändert hat. Stale-while-revalidate hält Nutzer schnell, während der Hintergrund frische Kopien lädt. Stale-if-error fängt Ausfälle am Origin ab, ohne die Nutzererfahrung zu verschlechtern.

Ich kombiniere kurze TTL mit hoher Hit-Rate, wenn Inhalte häufig rotieren. Für Archive, Medien und Bibliotheken wähle ich lange Zeiten, versioniere Dateinamen und entferne Prüflasten. Dashboards auf CDN- oder Server-Seite zeigen mir, wo Cache-Buckets zu klein dimensioniert sind. Ich passe dann Slot-Anzahlen und Objektgrößen an. Dieser stete Feinschliff macht den Unterschied im Alltag.

Cache-Keys, Cookies und Vary

Mit schlanken Keys halte ich die Zahl der Varianten klein. Nur Parameter, die das Ergebnis wirklich verändern, landen im Key. Ich setze Vary-Header bewusst ein, etwa nach Accept-Encoding oder User-Agent-Klassen, wenn notwendig. Zu viele Cookies im Key zerlegen den Cache und senken die Hit-Rate. Ich bereinige ungenutzte Cookies und reguliere Parameter, die Tracking dienen, aus dem Key heraus.

Wenn ich Sprachen, Währungen oder Layouts variieren muss, nutze ich gezielte Schlüssel wie lang=de oder currency=EUR. Ich beschränke diese Vielfalt auf die Fälle, die ich wirklich brauche. Für A/B-Tests trenne ich nur die Segmente, die inhaltliche Unterschiede aufweisen. Alles andere verwalte ich clientseitig oder per Edge-Logic ohne Key-Explosion. So halte ich den globalen Cache effizient.

Object-Cache und Transients

Ein Object-Cache reduziert teure Datenbankabfragen, indem er Ergebnisse im Speicher hält. Für WordPress wähle ich Redis oder Memcached und sichere so schnelle Zugriffe auf häufig angefragte Optionen, Queries und Sessions. Transients nutze ich, um teure Berechnungen zeitweise vorzuhalten. Ich bereinige diese Werte beim Deployment, wenn sich Abhängigkeiten ändern. So bleibt die Seite dynamisch und trotzdem flott.

Für Projektgrößen mit intensiver Datenlast hilft mir dieser Vergleich: Redis vs Memcached. Dort erkenne ich typische Stärken beider Systeme je nach Workload. Ich dimensioniere RAM und prüfe Eviction-Strategien, damit selten genutzte Objekte neuen Platz machen. Monitoring von Hit/Miss-Raten zeigt, ob die Konfiguration trägt. Diese Ebene ergänzt den Seiten-Cache ideal.

Kombination: Die optimierte Kette

Ich kombiniere die Ebenen so, dass jede Anfrage den kürzesten Pfad nimmt. OPcache beschleunigt die Generierung, wenn HTML wirklich neu entsteht. Der Seiten-Cache liefert fertiges Markup für anonyme Besucher. Browser-Caching verhindert wiederholte Asset-Transfers, und Edge verteilt die Inhalte global. Ganz am Ende steht eine saubere Purge- und Versionierungs-Strategie, damit Aktualisierungen sofort wirken.

Die folgende Tabelle halte ich als Spickzettel bereit, wenn ich an den Stellschrauben drehe. Ich lese die Spalte „Konfiguration“ wie eine To-do-Liste bei der Umsetzung. Dabei beachte ich, dass die Ebenen sich ergänzen und sich nicht gegenseitig aushebeln. So bleibt die Gesamtarchitektur übersichtlich und leistungsfähig. Dieser Überblick verhindert Fehlgriffe bei der Planung.

| Cache-Ebene | Vorteil | Typische Inhalte | Konfiguration |

|---|---|---|---|

| Opcode | Schnelle PHP-Ausführung | PHP-Bytecode | php.ini, Server-Panel |

| Seite | Niedriger TTFB | Fertiges HTML | Server-Level oder Plugin |

| Browser | Lokale Wiederverwendung | CSS, JS, Bilder | HTTP-Header, Versionierung |

| Edge | Globale Nähe | HTML und Assets | CDN-Regeln, Keys, Purge |

Messung: TTFB, LCP und Hit-Rates

Ich messe TTFB, um zu sehen, wie schnell der erste Byte ankommt. LCP zeigt mir, ob der sichtbare Inhalt rechtzeitig erscheint. Mit Cache-Analytics prüfe ich Hit-Rates und erkenne Strecken, auf denen Misses häufen. Ich korreliere Metriken mit Deployments, Crawler-Last und Traffic-Spitzen. Erst Zahlen zeigen, wo ich Schrauben nachziehen muss.

Ich protokolliere Response-Header wie Age und CF-Cache-Status, um Edge-Erfolge sichtbar zu machen. Server-Logs verraten mir, ob der Seiten-Cache sauber greift. Bei großen Abweichungen schaue ich nach Cookies, Query-Parametern oder Vary, die den Cache zersplitten. Ich teste Varianten mit und ohne eingeloggten Zustand. So finde ich zügig die Stellschrauben für stabile Geschwindigkeit.

Typische Fehler und Fixes

Zu viele Varianten im Cache sind ein häufiger Bremsklotz. Ich reduziere Query-Parameter im Key und neutralisiere Tracking-Parameter. Ein weiterer Klassiker sind widersprüchliche Header, etwa no-store zusammen mit langem max-age. Auch leere oder falsche Purges können den Eindruck erwecken, der Cache funktioniere nicht. Mit klaren Regeln und Logs behebe ich solche Probleme schnell.

Ein anderes Thema sind Plugins, die dynamische Inhalte hart ins HTML schreiben. Ich verlagere solche Elemente in fragmentierte Endpunkte, die unabhängig cachen oder frisch laden. Häufig blockieren Cookies ungewollt den Edge-Cache; ich lösche unnötige Cookies frühzeitig. Schlechte Versionierung zwingt Browser immer wieder zum Nachladen; ich nummeriere Dateien konsistent. So bleibt die Pipeline sauber und belastbar.

Entscheidungsbaum: Wer antwortet auf eine Anfrage?

Ich lege einen klaren Entscheidungsweg fest, um zu bestimmen, welche Ebene liefern darf. Das vermeidet unnötige Origin-Treffer und senkt TTFB reproduzierbar.

- 1) Ist die Ressource unveränderlich (versionierte Datei)? Browser-Cache mit langem max-age und immutable.

- 2) Ist die Anfrage anonym, GET und ohne sensible Cookies? Edge/Seiten-Cache mit public, s-maxage und stale-While-Revalidate.

- 3) Enthält die Anfrage Auth-Cookies, Authorization-Header oder ist POST? Origin, optional mit Object-Cache.

- 4) Enthält die URL nur kosmetische Parameter (utm, fbclid)? Ich entferne sie aus dem Cache-Key.

- 5) Bedarf es kleiner Live-Teile (z. B. Warenkorb-Count)? Fragmentiert über AJAX oder ESI.

// Pseudologik

if (immutable_asset) return browser_cache;

if (is_get && is_anonymous && cacheable) return edge_or_page_cache;

if (needs_fragment) return cached_html + dynamic_fragment;

return origin_with_object_cache;Fragmentierung beherrschen: ESI, AJAX und Teil-Rendern

Ich isoliere dynamische Inseln, damit der Rest hart cachen kann. ESI eignet sich für serverseitige Einsprengsel (z. B. personalisierte Blöcke), AJAX für clientseitige Nachladepunkte. Wichtig ist, dass Fragmente eigene, kurze TTLs erhalten, damit sie aktuell bleiben, ohne das gesamte Dokument zu invalidieren.

- Statisches Grundgerüst: lange TTL, public, s-maxage, stale-while-revalidate.

- Dynamisches Fragment: kurze TTL, must-revalidate oder no-store, wenn personenbezogen.

- Fehlerfall: stale-if-error auf der HTML-Hülle verhindert weiße Seiten.

// Beispiel-Header für HTML-Hülle

Cache-Control: public, max-age=0, s-maxage=600, stale-while-revalidate=60, stale-if-error=86400

// Beispiel-Header für persönliches Fragment

Cache-Control: private, no-storeCache-Stampede vermeiden und Warmup steuern

Ich verhindere Herdeneffekte, bei denen viele gleichzeitige Misses den Origin fluten. Soft-TTL/Hard-TTL, Request-Koaleszierung und Locking sind meine Werkzeuge. Ich nutze Preloader, die Sitemaps oder wichtige Pfade zyklisch aufwärmen und TTLs staffeln, damit nicht alles gleichzeitig verfällt.

- Soft-TTL: Abgelaufene Objekte darf ein Worker erneuern, während andere Konsumenten noch stale erhalten.

- Koaleszierung: Gleichzeitige Anfragen auf denselben Key werden zusammengeführt.

- Gestaffelte TTLs: Kritische Seiten erhalten versetzte Laufzeiten, um Purge-Wellen zu glätten.

// Beispiel für abgestufte Laufzeiten

/home, /kategorie/* -> s-maxage=900

/artikel/* -> s-maxage=1800

/suche -> s-maxage=120, stale-while-revalidate=30TTL-Design in der Kette sauber ausrichten

Ich stimme Browser-, Edge- und Origin-TTLs so ab, dass Revalidierung dort passiert, wo sie am günstigsten ist. Für HTML verlasse ich mich auf s-maxage am Edge und halte max-age im Browser niedrig, um schnelle Purges zu garantieren. Für Assets drehe ich es um: sehr lange Browser-TTL, weil Versionierung die Aktualität sicherstellt.

// HTML

Cache-Control: public, max-age=0, s-maxage=600, stale-while-revalidate=60

// Versionierte Assets

Cache-Control: public, max-age=31536000, immutableIch vermeide widersprüchliche Angaben wie no-cache zusammen mit immutable. Klare Regeln schaffen konsistente Ergebnisse in der gesamten Hierarchie.

Kompression, HTTP/2/3 und Priorisierung

Ich aktiviere Gzip/Brotli und setze den Vary-Header korrekt, damit Varianten sauber getrennt werden. Mit HTTP/2/3 profitiere ich von Multiplexing und Priorisierung; das reduziert Head-of-Line-Blocking, wenn viele Assets parallel geladen werden.

# NGINX-Beispiel

gzip on;

gzip_types text/css application/javascript application/json image/svg+xml;

brotli on;

brotli_types text/css application/javascript application/json image/svg+xml;

add_header Vary "Accept-Encoding" always;

# Lange Browser-TTL für Assets

location ~* .(css|js|svg|woff2|jpg|png)$ {

expires 1y;

add_header Cache-Control "public, max-age=31536000, immutable";

}Authentifizierung, Cookies und Sicherheit

Ich cache niemals personenbezogene Inhalte öffentlich. Requests mit Authorization-Header oder Sitzungs-Cookies markiere ich als privat oder umgehe den Edge-Cache gezielt. Gleichzeitig whiteliste ich nur essenzielle Cookies, damit der Cache-Key schlank bleibt.

- Login-/Konto-Bereiche: Cache-Control: private oder no-store.

- Öffentliche HTML-Seiten: public, s-maxage; Set-Cookie vermeiden.

- Cookie-Hygiene: Unerhebliche Cookies (z. B. Tracking) aus dem Key entfernen.

// VCL-ähnliche Logik

if (req.http.Authorization) { return(pass); }

if (req.http.Cookie ~ "session=") { return(pass); }

// Nur notwendige Cookies in den Key

unset req.http.Cookie: ".*";

API- und Such-Endpunkte effizient cachen

Ich unterscheide streng zwischen Methoden: GET kann gecacht werden, POST in der Regel nicht. Für häufige Suchabfragen setze ich kurze s-maxage-Werte plus stale-while-revalidate, um Reaktionszeiten zu glätten. Antworten mit 4xx/5xx Fehlern lasse ich nur kurz oder gar nicht cachen, damit Korrekturen sofort greifen.

// Beispiel-Header für öffentliche GET-API

Cache-Control: public, max-age=0, s-maxage=120, stale-while-revalidate=30

// Fehler sparsam cachen

Cache-Control: public, s-maxage=10Beobachtbarkeit: Header, Logs und TTFB-Check

Ich nutze Header-Inspektion und Logs, um die Kette transparent zu machen. Age, Hit/Miss-Indikatoren und Upstream-Status zeigen mir, wo Zeit verloren geht. Mit einfachen Tools prüfe ich TTFB reproduzierbar und finde Ausreißer.

# TTFB messen

curl -o /dev/null -s -w "TTFB: %{time_starttransfer}sn" https://example.org

# Header prüfen

curl -I https://example.org | sed -n '1,20p'# NGINX-Log mit Cache-Status

log_format timed '$remote_addr "$request" $status $body_bytes_sent '

'$upstream_cache_status $upstream_response_time $request_time';

access_log /var/log/nginx/access.log timed;Ich gleiche die Logdaten mit Deployments und Purges ab. Hohe Miss-Spitzen direkt nach Rollouts deuten auf fehlendes Warmup oder zu kurze TTLs hin. Bleibt Age dauerhaft niedrig, prüfe ich, ob Cookies den Edge-Cache unbeabsichtigt umgehen.

Deployment: Versionierung und rollende Purges

Ich baue Versionen in Dateinamen ein (z. B. app.9f3c1.js), damit Browser-Cache aggressiv sein darf. Für HTML setze ich rollende Purges ein, die kritische Seiten zuerst aktualisieren, gefolgt von Tiefe und Langläufern. Blue/Green-Deployments entkoppeln Build von Release und geben mir Zeit, Caches gezielt aufzuwärmen.

// Asset-Pipeline

style.[hash].css

app.[hash].js

// HTML verweist stets auf neue HashesIch plane Purge-Fenster außerhalb der Peak-Zeiten und überwache die Hit-Rate unmittelbar danach. So vermeide ich Lastspitzen auf dem Origin.

Bildvarianten, DPR und Responsive Caching

Ich erzeugte Bildvarianten (Größe, Format) deterministisch, damit der Cache-Key stabil bleibt. Für WebP/AVIF-Varianten trenne ich explizit über Dateipfad oder Parameter statt allein über Accept-Header, um Vary-Explosionen zu vermeiden. Für hochauflösende Displays (DPR) nutze ich srcset/sizes, wodurch der Browser die beste Variante wählt und der Cache pro konkretem Asset greifen kann.

<img src="img/hero-1024.jpg"

srcset="img/hero-768.jpg 768w, img/hero-1024.jpg 1024w, img/hero-1600.jpg 1600w"

sizes="(max-width: 768px) 90vw, 1024px" alt="">Ich halte die Zahl der Varianten pro Motiv klein und räume veraltete Größen aus der Pipeline, damit der Cache nicht fragmentiert.

Kapazitätsplanung: Cache-Speicher und Objektgrößen

Ich dimensioniere Caches nach realen Zugriffsmustern: wenige große Objekte (Bilder, Videos) benötigen andere Strategien als viele kleine (HTML, JSON). Ich setze Grenzen für maximale Objektgröße und prüfe, ob populäre Objekte im Speicher bleiben. Eine hohe Re-Use-Rate ist wichtiger als absolute Größe; deshalb trimme ich Keys, führe Varianten zusammen und verhindere Duplikate.

// Beispiel: Limits

max_object_size = 10m

default_ttl = 600

nuke_limit = moderat (Evictions ohne Stalls)Praxis-Checkliste für die Umsetzung

Ich aktiviere OPcache mit ausreichendem Speicher und kontrolliere die Hit-Rate. Danach richte ich Seiten-Caching ein, schließe kritische Pfade aus und preloade wichtige URLs. Anschließend setze ich Browser-Header mit langen Zeiten für unveränderliche Dateien und Versionierung. Im CDN definiere ich Cache-Keys, TTLs und Purge-Strategien und aktiviere stale-while-revalidate. Zum Abschluss prüfe ich mit Messwerkzeugen, ob TTFB, LCP und Edge-Hit-Rate die Ziele erreichen.

Kurze Zusammenfassung

Ich nutze Caching hierarchisch: OPcache beschleunigt Code, der Seiten-Cache liefert HTML, Browser-Header halten Assets lokal, und Edge bringt Inhalte nah an Nutzer. Mit klaren Keys, passenden TTLs und kluger Invalidierung reduziere ich Serverlast, Bandbreite und Latenz. Messwerte sichern die Fortschritte ab und zeigen Optimierungspotenzial. So entsteht eine belastbare Kette vom Origin bis zum Endgerät. Wer zusätzlich Details zur globalen Auslieferung sucht, findet in der Praxis genug Ansatzpunkte, um die eigene Architektur spürbar schneller zu machen.