wordpress redis beschleunigt WordPress spürbar, weil ich dynamische Datenbankabfragen als Objekte im RAM zwischenspeichere und so die CPU entlaste. Ich konfiguriere Caching gezielt von Object- über Page- bis Server-Caching und kombiniere Redis mit geeigneten Plugins, sodass Seitenaufrufe deutlich schneller erfolgen und die Time‑to‑First‑Byte sinkt.

Zentrale Punkte

Bevor ich tiefer einsteige, fasse ich die wichtigsten Stellschrauben zusammen, die WordPress mit Redis wirklich flink machen und zugleich sauber administrierbar halten. Ich fokussiere mich auf Object‑Caching mit Redis, ergänze es sinnvoll mit Page‑Cache und CDN, und prüfe jede Änderung mit Messwerten. Ich wähle einen Hosting‑Tarif, der Redis zuverlässig bereitstellt und genügend RAM für den Cache bietet. Ich betreibe Redis sicher, grenze Instanzen ab und räume den Cache kontrolliert. Ich halte die Konfiguration schlank, messe regelmäßig und justiere bei Bedarf nach.

- Object‑Cache im RAM reduziert Abfragen und verkürzt Antwortzeiten.

- Page‑Cache ergänzt Redis, besonders für anonyme Besucher.

- RAM‑Budget und LRU‑Strategie sichern konstante Leistung.

- Sichere Verbindung und getrennte DB‑IDs verhindern Konflikte.

- Monitoring mit Metriken zeigt echte Effekte jeder Änderung.

Warum Caching in WordPress Pflicht ist

WordPress erzeugt jede Seite dynamisch, was viele Datenbankabfragen auslöst und ohne Cache zu spürbaren Wartezeiten führt. Ich unterbreche diesen teuren Zyklus, indem ich fertig berechnete Ergebnisse im Cache ablege und beim nächsten Aufruf direkt ausliefere. So sinkt die Last auf PHP und MySQL, und die Antwortzeiten werden deutlich kürzer. Messungen zeigen, dass Object‑Caching Ladezeiten massiv drückt; Beispielwerte bewegen sich etwa von 800 ms auf rund 450 ms herunter [1][2]. Suchmaschinen bewerten kurze Reaktionszeiten positiv, und Besucher bleiben länger, weil sich Seiten samt Assets schneller öffnen [1][2][5].

Wie Redis im Object Cache arbeitet

Redis hält häufig benötigte Objekte im Arbeitsspeicher und liefert sie ohne Umweg über die Datenbank aus. In WordPress landen so z. B. Ergebnisse von WP_Query, Optionswerte oder Transients direkt im RAM‑Cache. Ich reduziere damit die Roundtrips zur Datenbank drastisch und spare Serverzeit für aufwendige Joins oder Sortierungen. Anders als ein reiner Page‑Cache bleibt die Seite dynamisch, weil Redis Datenbausteine bereitstellt, die WordPress dann kombiniert. Der Ansatz passt optimal zu Shops, Member‑Bereichen und stark personalisierten Komponenten, wo komplette Seiten selten identisch sind und ein schneller Object‑Zugriff spürbar hilft [1][2][3].

Was genau im Cache landet – und was besser nicht

Nicht jedes Objekt eignet sich für persistentes Caching. Ich lasse bewährt dynamische oder sicherheitskritische Daten (z. B. Nonces, Sessions, Login‑Zustände) bewusst außen vor oder ordne sie nicht‑persistenten Gruppen zu. Stabilere Inhalte wie Query‑Ergebnisse, Optionswerte, Menüs, Taxonomie‑Maps oder Produktlisten sind sehr gute Kandidaten. In komplexeren Setups definiere ich globale Gruppen (z. B. für Optionen), die installationsweit gleich sind, und nicht persistente Gruppen, die pro Request frisch bleiben müssen. Das hält den Cache konsistent und verhindert, dass flüchtige Werte veralten.

Für Mehrinstanz‑ oder Multisite‑Umgebungen setze ich ein eindeutiges Präfix, damit Schlüssel sauber getrennt bleiben und sich Keys verschiedener Projekte nicht überschreiben. Ich verwende dafür einen sprechenden Salt/Prefix, idealerweise mit Umgebungsbezug (staging, prod):

// wp-config.php (Beispiel)

define('WP_CACHE_KEY_SALT', 'acme_prod_');

define('WP_REDIS_PREFIX', 'acme_prod_'); // je nach Plugin unterstützt

So lassen sich Keys gezielt purgen, und ich sehe in Tools oder Logs auf einen Blick, zu welchem Projekt ein Eintrag gehört. Besonders in CI/CD‑Workflows spare ich mir damit Rätselraten bei selektiven Invalidierungen.

Redis einrichten: Schritt‑für‑Schritt auf dem Server

Ich installiere zuerst den Redis‑Dienst auf dem Server und prüfe, ob er erreichbar ist. Auf Debian/Ubuntu aktualisiere ich die Paketlisten, installiere Redis und teste die Verbindung mit PING. Danach erweitere ich PHP um die Redis‑Erweiterung, damit WordPress sprechen kann. Anschließend aktiviere ich im Backend ein geeignetes Object‑Cache‑Plugin und verbinde WordPress mit dem Dienst. So steht ein schneller Object‑Cache bereit, der Daten zuverlässig aus dem Speicher liefert.

sudo apt update

sudo apt install redis-server

redis-cli ping # Erwartet: PONG

sudo apt install php-redis

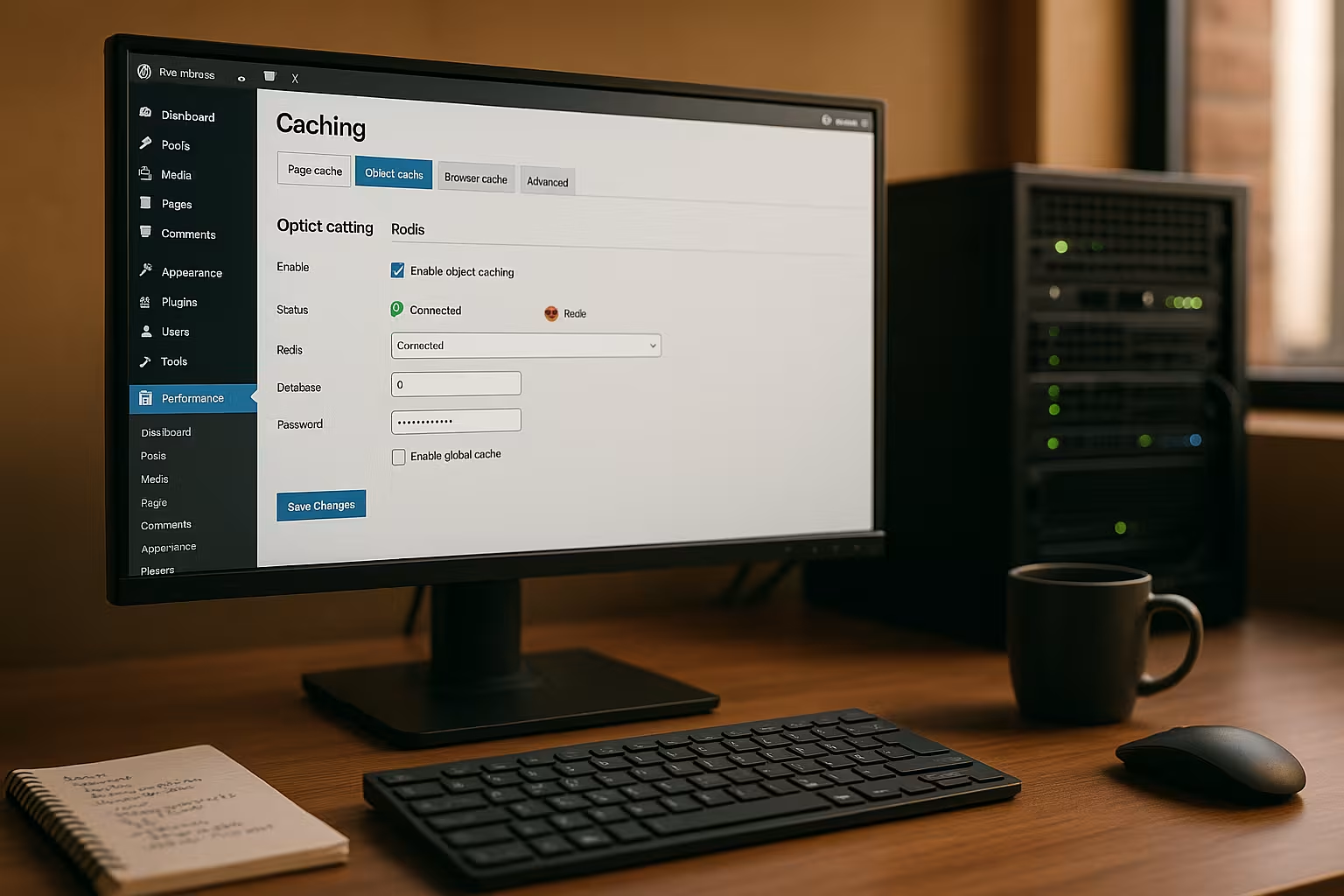

Im nächsten Schritt aktiviere ich das Plugin „Redis Object Cache“ in WordPress und schaue auf den Verbindungsstatus. Viele Hoster liefern Redis bereits mit oder erlauben die Aktivierung im Panel, sodass die Koppelung besonders leicht fällt. Ich achte darauf, dass die Socket‑ oder TCP‑Einstellungen korrekt sind, und leere nach der Aktivierung einmal den Cache. Danach messe ich die Antwortzeiten neu, um den Effekt der Änderung klar zu sehen [2][3][4].

Serializer, Kompression und PHP‑Redis‑Optionen

Wie Daten in Redis landen, beeinflusst Geschwindigkeit und RAM‑Verbrauch. Ich setze – sofern verfügbar – einen effizienten Serializer (z. B. igbinary) und optional Kompression für große Objekte. Das reduziert die Speicherlast und beschleunigt Deserialisierung. Viele Plugins bieten dafür Schalter in den Einstellungen; alternativ setze ich Konstanten in der wp-config.php, wenn das Plugin sie auswertet. Faustregel: Große, selten veränderte Objekte profitieren besonders, sehr kleine Keys eher weniger.

// wp-config.php (Beispiel, je nach Plugin)

define('WP_REDIS_SERIALIZER', 'igbinary'); // oder 'php'

define('WP_REDIS_COMPRESSION', true);

define('WP_REDIS_MAXTTL', 86400); // Max. Lebensdauer (1 Tag)

Mit einem vernünftigen MaxTTL verhindere ich „ewige“ Einträge, die nie erneuert werden. Das hält den Cache frisch und beugt inkonsistenten Anzeigeständen vor [1][4].

Redis und WordPress‑Plugins: starke Kombinationen

Viele Caching‑Plugins können Redis als Backend für den Object‑Cache nutzen und ergänzen ihn um Page‑Cache, HTML‑Minify oder Bildoptimierung. Ich setze besonders gerne auf LiteSpeed Cache, weil ich dort Object‑Cache mit Redis, Edge‑Side‑Includes und Bildformate wie WebP komfortabel steuere. In den Einstellungen aktiviere ich den Objekt‑Cache, wähle „Redis“ als Methode und trage Host, Port oder Socket ein. Der Verbindungstest zeigt mir sofort, ob alles steht und der Cache arbeitet. Diese Kombination liefert dynamische Inhalte schnell aus und sorgt zusätzlich dafür, dass anonyme Besucher häufig direkt aus dem Page‑Cache bedient werden.

WooCommerce, Member‑Bereiche und ESI

Bei Shops und Login‑Bereichen halte ich den Page‑Cache gezielt zurück, setze aber stark auf den Object‑Cache. Für Teile, die personalisiert sind (Warenkorbindikator, Begrüßung, Wunschlisten), nutze ich Edge‑Side‑Includes (ESI) oder hole die Fragmente clientseitig nach. Wichtig ist eine klare Vary‑Strategie (z. B. nach Cookies oder Rollen), damit anonyme Besucher maximal profitieren, während eingeloggte Nutzer konsistente, dynamische Inhalte sehen. Redis liefert dabei die Bausteine blitzschnell, ohne dass ich auf volle Seitenidentität angewiesen bin [1][2][3].

Feinjustierung: wp-config und redis.conf

Bei Socket‑Verbindungen setze ich in der wp-config.php gezielt Konstanten, damit WordPress die richtige Adresse nutzt. Ich definiere Schema und Pfad und prüfe, ob der Socket existiert und passende Rechte hat. Über redis.conf grenze ich den Speicher mit maxmemory ein und wähle eine sinnvolle Eviction‑Policy, oft allkeys‑lru. So halte ich den Cache kalkulierbar und verhindere, dass Redis dem System den RAM streitig macht. Zusätzlich vergebe ich ein Passwort oder nutze Bind‑Adressen und Firewalls, damit niemand Redis von außen abfragt [1][4].

// wp-config.php

define('WP_REDIS_SCHEME', 'unix');

define('WP_REDIS_PATH', '/tmp/redis.sock');

// redis.conf (Beispiel)

maxmemory 256mb

maxmemory-policy allkeys-lru

requirepass GeheimesPasswort123

TTL‑Strategien, Evictions und gezielte Invalidierung

Ein guter Cache ist nicht nur schnell, sondern auch vorhersehbar. Ich vergabe TTLs nach Datenklasse: kurze TTLs für volatile Feeds, längere für Menüs, nahezu keine für selten ändernde Taxonomie‑Zuordnungen – begrenzt durch einen MaxTTL. Bei Updates invalidiere ich selektiv, statt den kompletten Cache zu leeren: Beim Speichern eines Produkts purge ich nur Keys, die betroffene Kategorien, Preisfilter, Produktlisten oder Widgets betreffen. Das hält die Trefferquote hoch und dämpft Lastspitzen [2][4].

Zur Eviction‑Policy: allkeys‑lru ist meist die robusteste Wahl, weil sie veraltete, wenig genutzte Keys zuerst verdrängt. Hat mein Setup strikte TTL‑Vorgaben, kann volatile‑lru sinnvoll sein (nur Keys mit TTL werden verdrängt). Ich beobachte die Miss‑Rate nach Änderungen; steigt sie sprunghaft, ist das RAM‑Budget oft zu klein oder die TTL zu kurz [1][4].

Typische Fehler und schnelle Lösungen

Verwechselt WordPress Socket und TCP, bleibt der Objekt‑Cache leer oder meldet Verbindungsfehler. Dann prüfe ich die Plugin‑Einstellungen, Host/Port oder den Unix‑Socket und werfe einen Blick in die Serverlogs. Entleert sich der Cache zu häufig, passe ich TTL‑Werte und die Invalidierungs‑Trigger an, z. B. beim Speichern von Beiträgen oder Produkten. Bei mehreren WordPress‑Instanzen vergebe ich getrennte Redis‑Datenbanken, damit sich Einträge nicht überschreiben. So halte ich die Daten sauber getrennt und erhalte eine klar nachvollziehbare Cache‑Struktur [4].

Cache‑Stampede vermeiden

Ohne Schutzmechanismen kann es bei Ablaufen vieler populärer Keys zur „Thundering Herd“ kommen: Hunderte Requests bauen denselben Inhalt neu auf. Ich entschärfe das, indem ich leicht versetzte TTLs setze, Rebuilds mit Locks schütze und – wenn das Plugin es anbietet – Stale‑While‑Revalidate nutze: Abgelaufene Einträge werden kurz weiter ausgeliefert, während im Hintergrund frisch aufgebaut wird. So bleiben Antwortzeiten stabil, selbst bei Trafficspitzen [2][3].

Messen und dauerhaft beschleunigen

Ich verlasse mich nicht auf Bauchgefühl, sondern messe TTFB, First Contentful Paint und Server‑Antwortzeiten vor und nach jeder Änderung. Tools im Browser, Server‑Metriken und Plugin‑Statistiken zeigen mir Engpässe. Zusätzlich kombiniere ich Object‑Cache mit sauberem Page‑Cache und entlaste PHP über serverseitige Mechanismen wie Nginx Microcaching oder Apache‑Beschleuniger. Einen guten Einstieg liefert der kompakte Serverseitiges Caching Überblick. So steigere ich die Performance Schritt für Schritt und erreiche dauerhaft kurze Ladezeiten.

Wichtige Kennzahlen und Diagnosebefehle

Für den Betrieb schaue ich mir regelmäßig diese Metriken an:

- Keyspace hits/misses: Verhältnis zeigt die Effektivität des Object‑Caches.

- evicted_keys und expired_keys: Deutet auf zu wenig RAM oder zu kurze TTLs hin.

- used_memory, mem_fragmentation_ratio: Gibt Aufschluss über tatsächliche Nutzung und Fragmentierung.

- connected_clients, blocked_clients: Hinweise auf Engpässe bei hoher Last.

Ich nutze dabei simple Befehle auf dem Server, etwa redis-cli INFO, redis-cli MONITOR (nur kurzzeitig) und redis-cli MEMORY STATS. In WordPress selbst helfen Debug‑Plugins und die Statistiken des Object‑Cache‑Plugins, um Cache‑Treffer, Latenzen und Gruppen zu beurteilen [2][4].

Alternativen kurz eingeordnet

Dateibasiertes Caching funktioniert einfach, limitiert aber bei starkem Traffic oder vielen dynamischen Elementen. Memcached ist ebenfalls ein In‑Memory‑Cache und schnell, bietet jedoch weniger Datentypen und Flexibilität als Redis. Page‑Cache speichert komplette HTML‑Seiten und ist perfekt für anonyme Nutzer, während Object‑Cache dynamische Bausteine beschleunigt. Zusammen mit einem CDN reduziere ich Distanzen und Lastspitzen weltweit. Die richtige Kombination bestimmt das Ergebnis, und Redis liefert dafür den schnellen Unterbau.

Wann ich Redis bewusst nicht einsetze

Sehr kleine Sites ohne Datenbanklast oder extrem statische Projekte (Headless mit vorgerenderten Seiten) profitieren nur minimal. Auch bei sehr knappem RAM auf Shared‑Systemen kann ein zu kleiner Cache mehr Evictions als Nutzen bringen. In solchen Fällen fokussiere ich mich eher auf Page‑Cache und sauberes Asset‑Management und schalte Redis erst zu, wenn Messwerte einen klaren Gewinn zeigen [1][5].

Hosting mit Redis: kurzer Vergleich

Für zuverlässiges Object‑Caching braucht es einen Anbieter, der Redis bereitstellt und genug RAM für den Cache ermöglicht. Ich achte auf garantierte Ressourcen, SSH‑Zugriff und die Option, Sockets oder Ports sauber zu konfigurieren. Ein gut dokumentiertes Panel und schneller Support sparen Zeit im Alltag. Im folgenden Überblick zeige ich die Eckdaten einer typischen Auswahl. So lässt sich der passende Tarif einfacher wählen und die spätere Konfiguration gelingt reibungslos.

| Anbieter | Redis‑Unterstützung | Performance | Preis/Leistung | Support |

|---|---|---|---|---|

| webhoster.de | Ja | Spitzenklasse | Exzellent | Sehr gut |

| Anbieter B | Teilweise | Gut | Gut | Gut |

| Anbieter C | Nein | Ausreichend | Ausreichend | Befriedigend |

Skalierung, Latenz und Hochverfügbarkeit

Wächst ein Projekt, achte ich auf die Topologie: Lokale UNIX‑Sockets sind am schnellsten, sofern Webserver und Redis auf demselben Host laufen. Bei separaten Servern wähle ich eine nahe Netzwerk‑Latenz und sorge für genügend Bandbreite. Für Hochverfügbarkeit kommen Replikation und Sentinel in Frage; bei reinen Cache‑Setups verzichte ich oft auf Persistenz (RDB/AOF), um I/O zu sparen. Geht ein Knoten verloren, baut sich der Cache nach und die Seite bleibt dank Page‑Cache trotzdem schnell bedienbar [3][4].

Sicherheit und Multisite/Mehrinstanz‑Setups

Ich exponiere Redis nie ungeschützt ins öffentliche Netz und setze Bind‑Adressen, Firewall‑Regeln sowie ein Passwort. Auf Shared‑Servern verwende ich bevorzugt Unix‑Sockets mit restriktiven Rechten. Betreibe ich mehrere WordPress‑Installationen, vergebe ich pro Site eine eigene Redis‑DB‑ID und, wenn möglich, getrennte Namespaces. So verhindere ich Kollisionen und behalte die Übersicht. Sicherheit kostet kaum Zeit, bewahrt aber die Integrität der Daten und schützt die Verfügbarkeit.

ACLs, Rechte und Zugriffsbeschränkung

Zusätzlich zum Passwort setze ich – wenn möglich – dedizierte Redis‑Benutzer mit eingeschränkten Rechten. Ich erlaube nur die Befehle, die mein Setup braucht, und sperre administrative Kommandos. Bind‑Adressen (bind 127.0.0.1 ::1) und Firewalls begrenzen den Zugriff auf interne Netze. Für Staging und Entwicklung verwende ich getrennte Zugangsdaten und Prefixes; so kann ich produktive Daten nie versehentlich überschreiben [4].

Praxis‑Workflow: vom Test bis zum Livegang

Ich starte in einer Staging‑Umgebung, aktiviere Redis, messe, optimiere und rolle die Änderungen planvoll aus. Vor dem Livegang leere ich den Cache, wärme wichtige Seiten an und beobachte die Server‑Metriken unter Last. Tauchen Zeitouts oder ungewöhnliche Miss‑Raten auf, passe ich Policies, TTLs und die Größe an. Für tiefergehende Tuning‑Ideen nutze ich regelmäßig kompakte Leitfäden zu WordPress-Performance. So sichere ich eine kontrollierte Einführung und erhalte eine sauber dokumentierte Konfiguration.

Prewarming, Releases und selektives Purgen

Nach Deployments verhindere ich kalte Starts, indem ich wichtige Seiten automatisch aufrufe (Sitemap‑basiertes Prewarming) und kritische Queries vorwärme. Beim Content‑Release purge ich gezielt betroffene Bereiche (z. B. eine Kategorie und ihre Archivseiten), nicht die gesamte Site. Das hält die Hit‑Rate hoch und sorgt dafür, dass Spitzenlasten auf bereits warmen Cache treffen. Ich dokumentiere, welche Hooks Purges auslösen, und teste diese Pfade in Staging, damit der Livegang reibungslos verläuft [2][4][5].

Zum Mitnehmen: Meine kurze Zusammenfassung

Redis beschleunigt WordPress deutlich, weil der Object‑Cache teure Abfragen spart und Inhalte direkt aus dem Speicher ausliefert. Ich kombiniere Redis mit einem Page‑Cache und, je nach Projekt, einem CDN für globale Reichweite. Mit sauberer Einrichtung, korrekten Socket‑/Port‑Angaben, passender Speicherbegrenzung und sicherer Anbindung bleibt das System schnell und verlässlich [1][2][3][4][5]. Messwerte entscheiden über jede Änderung, nicht Bauchgefühl. So erreiche ich kurze Ladezeiten, bessere Nutzererfahrung und eine spürbar schnellere WordPress‑Site.