HTTP/2 Multiplexing bündelt viele Anfragen über eine einzige Verbindung und räumt Blockaden auf Protokollebene aus dem Weg. In realen Netzen bremst jedoch TCP‑Head‑of‑Line, TLS‑Overhead und mangelhafte Priorisierung, sodass HTTP/2 nicht automatisch schneller als HTTP/1.1 läuft.

Zentrale Punkte

- Multiplexing parallelisiert viele Requests über eine einzelne TCP‑Verbindung.

- TCP‑HoL bleibt bestehen und stoppt bei Verlusten alle Streams.

- TLS‑Setup kann Time‑to‑First‑Byte spürbar verzögern.

- Prioritäten und Server Push wirken nur mit sauberem Tuning.

- Seitentyp entscheidet: viele kleine vs. wenige große Dateien.

Wie HTTP/2 Multiplexing intern arbeitet

Ich zerlege jede Antwort in kleine Frames, nummeriere sie und ordne sie logischen Streams zu, damit mehrere Ressourcen gleichzeitig über eine einzelne Verbindung laufen. So vermeide ich Blockaden auf HTTP‑Ebene, weil kein Request mehr auf das Ende eines anderen warten muss. Die Browser schicken HTML, CSS, JS, Bilder und Fonts parallel und reduzieren die Kosten zusätzlicher Verbindungen. Durch HPACK schrumpfen Header, was bei vielen kleinen Dateien die Last deutlich verringert. Entscheidend bleibt jedoch: Alle Streams teilen sich dieselbe TCP‑Leitung, was Vorteile schafft, aber auch neue Abhängigkeiten erzeugt. Diese Architektur liefert Tempo, solange das Netz stabil bleibt und die Priorisierung sinnvoll arbeitet.

HTTP/1.1 vs. HTTP/2: Kernunterschiede

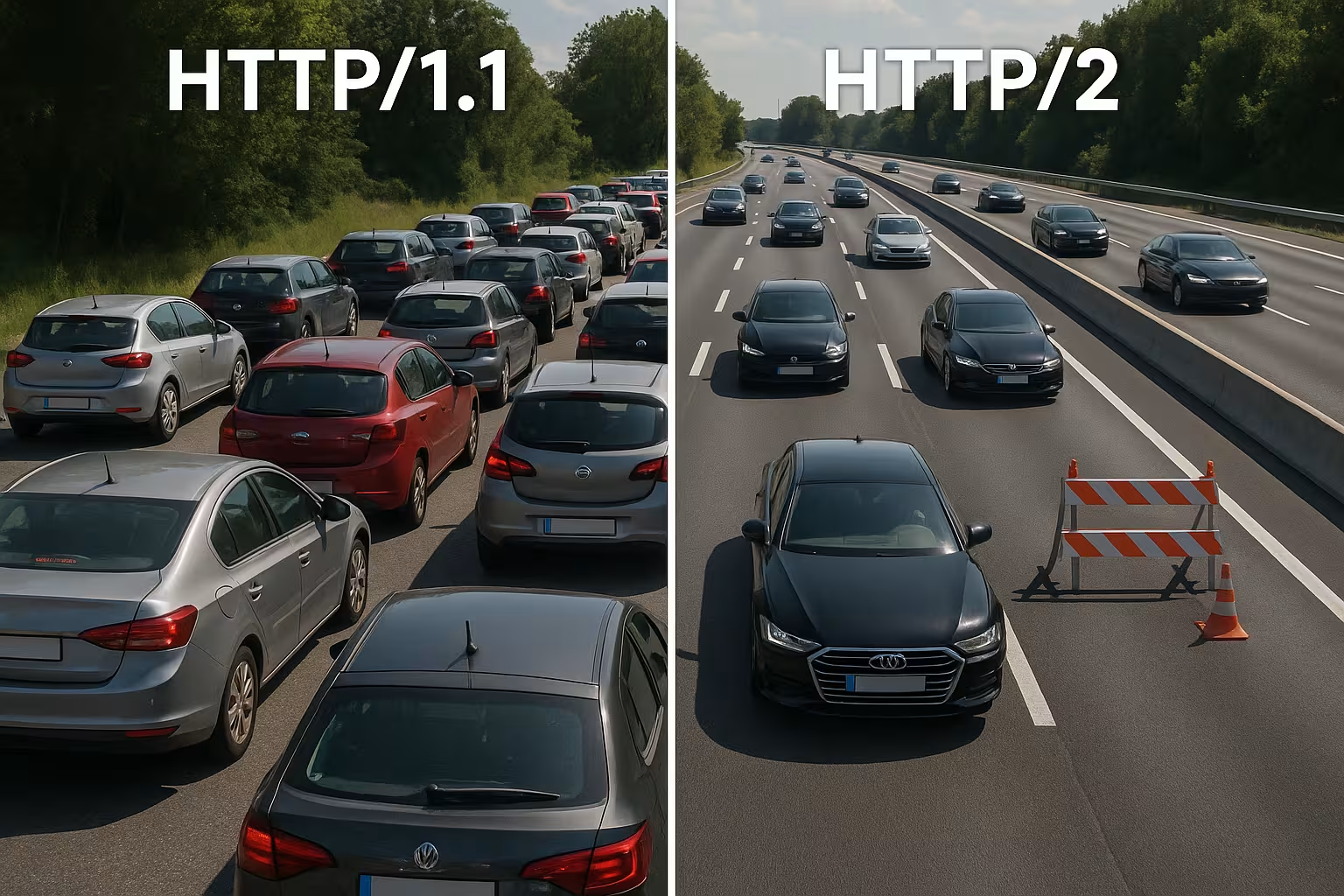

HTTP/1.1 setzt auf textbasierte Nachrichten und mehrere parallele Verbindungen pro Host, um Ressourcen gleichzeitig zu laden, was Handshakes und Overhead erhöht. HTTP/2 arbeitet binär, nutzt eine einzige Verbindung für alles und komprimiert Header, wodurch sich Wartezeiten vor allem bei vielen Objekten verkürzen. In Wasserfalldiagrammen verschwinden lange Warteschlangen, weil Streams parallel vorankommen. Dafür verschiebt sich die Engstelle von der HTTP‑Schicht zur TCP‑Schicht, was ich bei instabilen Netzen deutlich spüre. Kleine, stark gecachte Seiten verzeichnen häufig kaum Vorteile gegenüber 1.1, während große, assetreiche Seiten sichtbarer profitieren. Diese Unterschiede formen meine Tuning‑Strategie und rechtfertigen eine projektspezifische Entscheidung.

Flow Control und Fenstergrößen richtig wählen

HTTP/2 bringt eigene Flusskontrolle pro Stream und pro Verbindung mit. Ich achte auf sinnvolle Werte für INITIAL_WINDOW_SIZE und die Zahl der gleichzeitigen Streams, damit die Leitung weder verstopft noch unterausgelastet ist. Zu kleine Fenster erzeugen unnötig viele WINDOW_UPDATE‑Frames und drosseln die Datenrate, zu große Fenster können schwächere Clients überfordern. In Netzen mit hoher Bandbreiten‑Verzögerungs‑Produkt (BDP) erhöhe ich die Fenstergröße gezielt, damit große Antworten nicht im Stop‑and‑Go stecken bleiben. Gleichzeitig begrenze ich MAX_CONCURRENT_STREAMS pragmatisch: genug Parallelität für Render‑Kritisches, aber nicht so viel, dass Kleinkram das LCP‑Bild ausbremst. Diese Stellschrauben sind klein, ihre Wirkung auf echte Ladezeiten ist jedoch groß, wenn sie zur Seite und zum Netz passen.

Domain‑Sharding und Bundling neu bewerten

Viele 1.1‑Optimierungen sind unter HTTP/2 kontraproduktiv. Ich löse altes Domain‑Sharding auf, weil eine einzige gut genutzte Verbindung effizienter ist als künstlich verteilte Sockets. Auch Aggro‑Bundling von JavaScript zu Mega‑Dateien stelle ich in Frage: Kleinere, logisch getrennte Bundles erlauben gezielte Caches und vermeiden, dass bei einer Änderung die ganze App neu übertragen werden muss. Bild‑Sprites verlieren an Bedeutung, weil parallele Requests billig geworden sind und moderne Bildformate samt Caching besser greifen. Ich entzerre also dort, wo Multiplexing gewinnen kann, und bündele nur noch, wenn es die Architektur wirklich vereinfacht oder die Caching‑Trefferquote messbar erhöht.

Verbindungs‑Koaleszierung und Zertifikate

HTTP/2 erlaubt es Browsern, eine Verbindung für mehrere Hostnamen zu verwenden, wenn Zertifikate und DNS passen. Ich plane SAN‑Einträge und SNI so, dass Coalescing möglich wird und zusätzliche Handshakes entfallen. Stimmen ALPN und Cipher‑Suites, kann der Client CSS von cdn.example.com und Bilder von static.example.com über dieselbe Leitung beziehen. Das spart RTTs, vereinfacht Priorisierung und erhöht die Chance, dass kritische Assets ohne Umwege ankommen. Ich prüfe diese Effekte gezielt im Netzwerk‑Tab: Wird wirklich nur ein Socket genutzt, oder zwingen Zertifikatsgrenzen und Policies den Browser zu neuen Verbindungen?

Warum Multiplexing ausgebremst wird: TCP‑Head‑of‑Line

Geht auf der einzigen TCP‑Verbindung ein Paket verloren, wartet die gesamte Leitung, bis die Retransmission eintrifft – das stoppt kurzzeitig alle HTTP/2‑Streams. In Mobilnetzen mit schwankender Latenz und erhöhter Verlustquote sehe ich deshalb regelmäßig geringere Gewinne oder sogar Nachteile im Vergleich zu mehreren 1.1‑Verbindungen. Dieser Effekt erklärt, warum Multiplexing auf dem Papier glänzt, in der Praxis aber nicht immer führt. Messungen aus Forschung und Feld zeigen genau diesen Zusammenhang in realen Netzen [6]. Ich plane Deployments daher konservativ, teste auf typischen Nutzerpfaden und prüfe die Auswirkungen für jede Zielgruppe. Wer TCP‑HoL ignoriert, verschenkt Leistung und kann Ladezeiten sogar verlängern.

TLS‑Handshake, TTFB und Seitentyp

HTTP/2 läuft im Web fast ausschließlich über TLS, was zusätzliche Handshakes erzeugt und die Time‑to‑First‑Byte bei wenigen Assets spürbar verlängern kann. Liefere ich nur eine große Datei aus, verfliegt der Multiplexing‑Vorteil, weil keine parallele Übertragung nötig ist. Seiten mit zehn bis zwanzig kleinen Files profitieren eher, während Single‑Asset‑Antworten oft auf Augenhöhe mit HTTP/1.1 liegen. Ich verkürze den Overhead mit TLS 1.3, Session Resumption und sauberem Keep‑Alive, damit Wiederverbindungen entfallen und die eine Leitung wirklich lebt. Für die Feinsteuerung setze ich auf Keep‑Alive‑Tuning, um Reuse, Idle‑Timeouts und Limits passend zur Last einzustellen. So sinkt der Handshake‑Anteil, und die TTFB stabilisiert sich auch bei Traffic‑Spitzen.

CDN‑ und Proxy‑Ketten: h2 bis zum Origin

Viele Stacks terminieren TLS am Edge und sprechen zum Origin weiter. Ich prüfe, ob zwischen CDN und Backend ebenfalls HTTP/2 genutzt wird oder ob ein Rückfall auf HTTP/1.1 erfolgt. Puffernde Proxies können Vorteile (Header‑Kompression, Priorisierung) teilweise zunichte machen, wenn sie Antworten reserialisieren oder Reihenfolgen umstellen. Ich optimiere deshalb End‑to‑End: Edge‑Node, Zwischen‑Proxy und Origin sollten h2 verstehen, passende Fenstergrößen fahren und Prioritäten nicht ignorieren. Wo h2c (HTTP/2 ohne TLS im internen Netz) sinnvoll ist, teste ich, ob es Latenz und CPU spart, ohne Sicherheitspolitiken zu verletzen. Erst eine stimmige Kette entfaltet den Multiplexing‑Effekt vollständig.

Priorisierung richtig einsetzen

Ich stufe kritische Ressourcen hoch, damit HTML, CSS und das LCP‑Bild zuerst ankommen und Render‑Blockaden fallen. Ohne klare Prioritäten fressen weniger wichtige Skripte wertvolle Bandbreite, während Above‑the‑Fold‑Inhalte warten. Nicht jeder Server beachtet die Browser‑Prioritäten korrekt, und manche Proxies ändern die Reihenfolge, weshalb ich Ergebnisdaten statt Wunschdenken auswerte [8]. Preload‑Header und eine früh platzierte Bildreferenz verkürzen Ladepfade und erhöhen die Trefferquote im Cache. Priorisierung erzeugt keinen Zauber, doch sie dirigiert die eine Verbindung so, dass Nutzer schnell sehen, was sie brauchen. Saubere Regeln bringen spürbaren Schub und machen Multiplexing erst richtig effektiv.

Priorisierung in der Praxis: Extensible Priorities

Browser haben ihre Priorisierungsmodelle weiterentwickelt. Ich berücksichtige, dass moderne Clients statt starrer Baum‑Gewichte oft „Extensible Priorities“ verwenden. Dabei signalisieren sie Dringlichkeit und Progressive‑Parameter je Stream, was Server interpretieren und in faire Scheduler übersetzen müssen. Ich prüfe, ob mein Server diese Signale respektiert oder auf altem Verhalten basiert. In A/B‑Tests vergleiche ich Ladepfade mit und ohne Server‑seitige Priorisierung, um Verdrängungseffekte zu erkennen. Wichtig: Priorisierung soll Render‑Kritisches bevorzugen, darf aber nicht zu starvation von langlaufenden Downloads führen. Ein behutsamer Mix meidet Spitzen und hält die Pipeline für sichtbare Inhalte frei.

Server Push: selten die Abkürzung

Ich setze Server Push nur gezielt ein, weil Over‑Pushing Bandbreite belegt und Browser‑Caches ignoriert. Wird eine bereits gecachte Ressource gepusht, verlangsamt sich der Pfad statt schneller zu werden. Viele Teams haben Push wieder abgeschaltet und fahren mit Preload deutlich verlässlicher [8]. In Sonderfällen, etwa auf wiederkehrenden Routen mit klaren Mustern, kann Push nützen, doch ich beweise den Effekt mit Messwerten. Ohne Beleg entferne ich Push und halte die Pipeline frei für wirklich benötigte Daten. Weniger ist hier oft mehr, gerade auf der einzigen Verbindung.

Praxisvergleich: Wann HTTP/1.1 schneller sein kann

Ich erlebe HTTP/1.1 als konkurrenzfähig, wenn wenige, große Dateien dominieren oder Netze mit höheren Verlusten arbeiten. Mehrere getrennte Verbindungen verteilen dann das Risiko und können einzelne First‑Byte‑Zeiten verkürzen. Auf sehr kleinen Seiten kompensieren zusätzliche TLS‑Handshakes den Multiplexing‑Nutzen oft vollständig. Bei vielen kleinen Objekten trumpft dagegen HTTP/2, weil Kompression, Priorisierung und ein einziger Socket wirken. Die folgende Übersicht zeigt typische Muster aus Audits und Feldtests, die meine Wahl des Protokolls steuern [6][8]. Dieses Raster ersetzt keine Tests, liefert aber eine solide Orientierung für erste Entscheidungen.

| Szenario | Besseres Protokoll | Begründung |

|---|---|---|

| Viele kleine Assets (CSS/JS/Bilder/Fonts) | HTTP/2 | Multiplexing und HPACK senken Overhead, eine Verbindung reicht |

| Wenige, sehr große Dateien | HTTP/1.1 ≈ HTTP/2 | Kaum Parallelität nötig; Handshake‑Kosten wiegen stärker |

| Instabile Mobilnetze mit Verlusten | HTTP/1.1 teils besser | TCP‑HoL stoppt bei HTTP/2 alle Streams; mehrere Sockets können helfen |

| Optimiertes TLS (1.3, Resumption), saubere Prioritäten | HTTP/2 | Geringeres Setup, gezielte Bandbreitenlenkung |

| Over‑Pushing aktiv | HTTP/1.1/HTTP/2 ohne Push | Unnötige Daten blockieren Leitung; Preload ist sicherer |

Best Practices für echte Ladezeitgewinne

Ich reduziere Bytes vor dem Protokoll: Bilder in WebP/AVIF, passende Größen, sparsame Skripte und saubere Caching‑Header. Kritische CSS‑Pfadteile halte ich klein, Fonts lade ich früh und setze Fallbacks, um Layout‑Shifts zu vermeiden. Für Verbindungsaufbau und DNS nutze ich Preconnect und DNS‑Prefetch, damit Handshakes starten, bevor der Parser an die Ressource stößt. Brotli für Textinhalte beschleunigt wiederkehrende Abrufe, insbesondere über CDNs. Ich kontrolliere Effekte im Wasserfall und vergleiche LCP, FID und TTFB vor und nach Änderungen. Messwerte lenken meine Prioritäten, Bauchgefühl nicht.

gRPC, SSE und Streaming‑Fälle

HTTP/2 spielt seine Stärken besonders bei gRPC und anderen bidirektionalen oder langlaufenden Streams aus. Ich achte dabei auf Timeouts, Puffergrößen und Rückstau‑Regeln, damit ein stockender Stream nicht alle anderen Anfragen benachteiligt. Für Server‑Sent Events und Live‑Feeds ist eine stabile, dauerhafte Verbindung hilfreich, solange der Server die Prioritäten korrekt verwaltet und Keep‑Alive‑Limits nicht zu früh greifen. Gleichzeitig teste ich, wie sich Fehlerfälle verhalten: Wiederaufbau von Streams, Exponential Backoff und sinnvolle Grenzen für Reconnects verhindern Lastspitzen, wenn viele Clients gleichzeitig abbrechen und neu verbinden. So bleiben Real‑Time‑Szenarien berechenbar.

OS‑ und TCP‑Tuning für stabile Multiplexing‑Leistung

Die Protokollwahl überdeckt keine schwache Netzwerk‑Konfiguration. Ich überprüfe Congestion‑Control‑Algorithmen (z. B. BBR vs. CUBIC), Socket‑Puffer, TCP‑Fast‑Open‑Policies und die Initial‑Congestion‑Window‑Größe. Eine zum Pfad passende Congestion‑Control kann Retransmits reduzieren und HoL‑Effekte abmildern. Ebenso wichtig: korrekte MTU/MSS‑Werte, um Fragmentierung und vermeidbare Verluste zu verhindern. Auf TLS‑Ebene bevorzuge ich kurze Zertifikatsketten, OCSP‑Stapling und ECDSA‑Zertifikate, weil sie den Handshake beschleunigen. Zusammengenommen geben diese Einstellungen Multiplexing den nötigen Unterbau, damit Priorisierung und Header‑Kompression ihre Wirkung entfalten.

Messstrategie und KPIs im Alltag

Ich verlasse mich nicht auf Medianwerte, sondern schaue auf p75/p95 der Metriken, getrennt nach Gerät, Netztyp und Standort. Synthetic‑Tests liefern reproduzierbare Basiswerte, Real‑User‑Monitoring zeigt die Streuung im Feld. Ich vergleiche Wasserfälle von Schlüsselpfaden, prüfe Early‑Bytes von HTML, Reihenfolge von CSS/JS und die Ankunftszeit des LCP‑Bildes. Änderungen rolle ich als kontrollierte Experimente aus und beobachte TTFB, LCP und Fehlerquoten parallel. Wichtig: Priorisierung ohne messbaren Nutzen entferne ich wieder. So bleibt die Konfiguration schlank und ich investiere in Stellschrauben, die statistisch gesichert Zeit sparen.

Crawl‑ und Bot‑Traffic

Neben Nutzern profitieren auch Crawler von sauberem HTTP/2. Ich aktiviere h2 für relevante Endpunkte und beobachte, ob Bots die Verbindung wiederverwenden und mehr Seiten in gleicher Zeit abrufen. Unnötige 301‑Kaskaden, unkomprimierte Antworten oder zu kurze Keep‑Alive‑Limits kosten Crawl‑Budget. Ich stimme Policies ab, damit Multiplexing auch hier greift, ohne Backend‑Limits zu reißen. Ergebnis: effizientere Scans und mehr Stabilität unter Last.

HTTP/2, HTTP/3 und was als Nächstes zählt

HTTP/3 setzt auf QUIC über UDP und löst das TCP‑Head‑of‑Line‑Blocking, was gerade bei Mobilität und Verlusten spürbar hilft [6]. Der Verbindungsaufbau wird kürzer, und Stream‑Blockaden treffen nicht mehr alle Anfragen gleichzeitig. In gemischten Flotten bleibt HTTP/2 wichtig, doch ich aktiviere HTTP/3 dort, wo Clients und CDNs es bereits sprechen. Detaillierte Gegenüberstellungen wie HTTP/3 vs. HTTP/2 helfen mir, Rollouts phasenweise und zielgruppengerecht zu planen. Ich messe getrennt nach Standort, Gerät und Netztyp, damit echte Nutzer profitieren. So nutze ich Protokolle, um Ladezeiten in Alltagssituationen zu senken.

Hosting und Infrastruktur als Beschleuniger

Gute Protokolle retten keine schwache Infrastruktur, darum prüfe ich Standort, Peering, CPU, RAM und I/O‑Limits genau. Ein moderner Webserver, sinnvolle Worker‑Zahlen und ein Cache‑Layer verhindern, dass die einzige Verbindung im Engpass endet. Strategische CDN‑Nutzung verkürzt RTT und federt Lastspitzen ab. Wer europaweit Nutzer bedient, profitiert oft stärker von kurzen Wegen als von Protokoll‑Feintuning. Ich plane Kapazität mit Reserven, damit Burst‑Traffic nicht auf die Knie zwingt. So entfaltet Multiplexing sein Potenzial zuverlässig.

Fehlerbilder schnell erkennen

Wenn HTTP/2 langsamer wirkt als erwartet, suche ich nach typischen Mustern: Eine einzige lange Übertragung, die viele kleine blockiert; Prioritäten, die ignoriert werden; hohe Retransmit‑Raten auf Mobilstrecken; oder TLS‑Resumption, die nicht greift. Ich vergleiche dann HTTP/2 und HTTP/1.1 unter identischen Bedingungen, trenne CDN‑Einfluss vom Origin und schaue auf die Zahl der Sockets, die tatsächliche Stream‑Zahl und die Reihenfolge der ersten Kilobytes. Findet sich ein Flaschenhals, passe ich zuerst Grundlagen an (Bytes, Caching, Handshakes), bevor ich an Flow‑Control oder Prioritäten feile. Diese Reihenfolge liefert die verlässlichsten Verbesserungen.

Praxisnahe Zusammenfassung für schnelle Entscheidungen

Ich setze HTTP/2 Multiplexing dann ein, wenn viele Objekte anfallen, Prioritäten greifen und TLS sauber konfiguriert ist. Bei wenigen großen Dateien oder wackeligen Netzen kalkuliere ich geringe Vorteile ein und halte einen Blick auf 1.1‑Ergebnisse offen. Server Push nutze ich nur mit Evidenz, Preload fast immer, und ich halte Overhead durch Kompression, Caching und frühe Verbindungen klein. Messungen mit realen Geräten und Standorten bestätigen meine Annahmen, bevor ich Änderungen breit ausrolle [6][8]. Am Ende zählt nicht die Protokollnummer, sondern spürbare Geschwindigkeit für echte Nutzer. Wer so vorgeht, holt aus HTTP/2 verlässlich Tempo heraus und legt die Basis für HTTP/3.