Veel websites falen door PHP Geheugenlimiet, hoewel er geen foutmelding verschijnt. Ik laat zien hoe deze onzichtbare crashes ontstaan, wat ze veroorzaakt en hoe ik met gerichte Afstemmen Geheugenfouten betrouwbaar stoppen.

Centrale punten

- Stille fouten blokkeer pagina's zonder zichtbare melding.

- Grenzen van 64–128M zijn vaak niet meer voldoende.

- Plugins en grote databases zorgen voor een hoge RAM-belasting.

- Hosting-tuning met FPM en OPcache vermindert het risico.

- Controle ontdekt knelpunten in een vroeg stadium.

Wat gebeurt er bij geheugenuitputting?

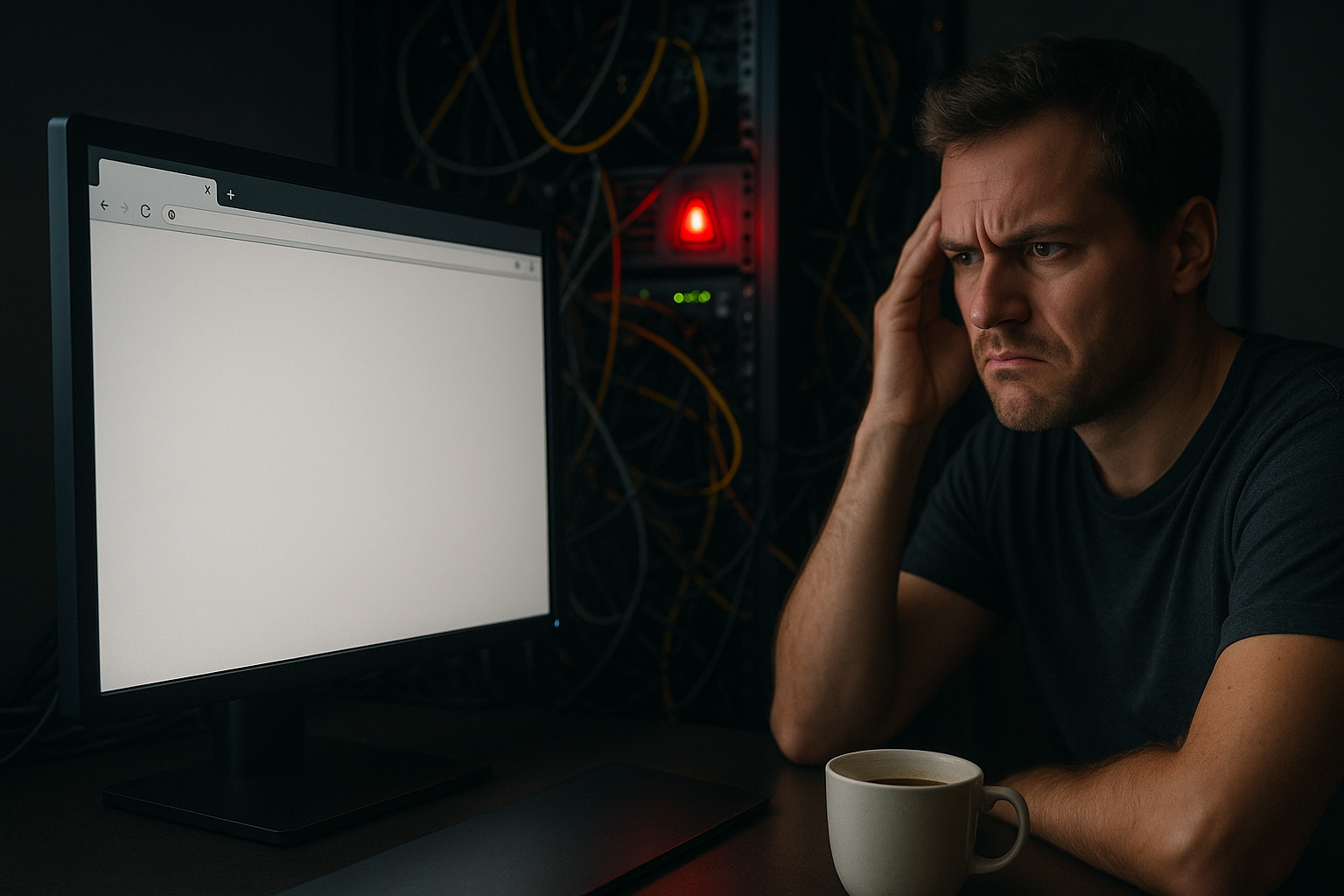

Als een script zijn toegewezen geheugen overschrijdt, veroorzaakt dit vaak geen zichtbare Fout. In plaats daarvan stopt het proces abrupt met werken en laat het een wit scherm achter of een geblokkeerde aanvraag die eruitziet als een Time-out werkt. Op gedeelde servers zijn extra beveiligingsmechanismen actief die processen voortijdig beëindigen. Zo voorkomt het platform overbelasting, maar voor jou lijkt het alsof het systeem op mysterieuze wijze vastloopt. Ik zie dan hiaten in logs, afgebroken verzoeken of FPM-herstarts, terwijl de werkelijke oorzaak in de RAM-limiet ligt.

Het is belangrijk om een onderscheid te maken: 504- of 502-fouten werken als klassieke time-outs, maar zijn vaak het gevolg van een voortijdige procesonderbreking. Dat geheugenlimiet werkt per verzoek; het reserveert geen RAM vooraf, maar stopt hard wanneer de limiet wordt overschreden. Als de server zelf in de swap terechtkomt, worden de responstijden aanzienlijk langer, hoewel de limiet formeel niet lijkt te zijn bereikt – in de praktijk is het effect hetzelfde: gebruikers zien vastlopers of lege pagina's.

Silent Errors zonder melding herkennen

Silent Errors ontstaan vaak omdat productiesystemen foutmeldingen onderdrukken en PHP-FPM bij knelpunten Worker opnieuw starten. Dicht bij de limiet wordt de garbage collection vaker gestart en verhoogt de Latency, zonder een duidelijke melding te geven. Onder druk beëindigt de OOM-killer processen voordat PHP een uitvoer kan schrijven. In de praktijk zie ik 502/503-gatewayfouten, sporadische witte schermen en sporadisch lege logbestanden. Wie wil begrijpen hoe limieten de responstijden beïnvloeden, leest de compacte Prestatie-effecten van de PHP-geheugenlimiet; zo kan ik symptomen beter indelen.

Ik controleer aanvullend de FPM-slowlogs en de FPM-status. De status toont actieve/inactieve workers, gemiddelde looptijden en actuele wachtrijlengtes. Als „terminated“ of „out of memory“ vaak voorkomen in foutlogboeken, of als de slowlog-vermeldingen parallel stijgen met pieken, is dat een betrouwbare indicator. In Nginx- of Apache-foutlogboeken herken ik bovendien patronen in 502/504-fouten die samenvallen met FPM-herstarts of pooloverlopen.

Typische oorzaken in het dagelijks leven

Plug-ins die veel bronnen verbruiken, laden grote Arrays en objecten in het geheugen; als er meerdere tegelijkertijd draaien, stijgt het verbruik enorm. Beeldoptimalisatoren, crawlers, SEO-scanners of paginabouwers maken er intensief gebruik van en houden gegevens langer in het RAM dan nodig is. Een database die in de loop der jaren is gegroeid met revisies, transiënten en spamcommentaar versterkt het probleem, omdat zoekopdrachten meer resultaten in het proces trekken. Bij hoge belasting, bijvoorbeeld in winkels met filterzoekopdrachten, strijden meerdere PHP-workers om beperkte opslagruimte. Bovendien verhogen veel geactiveerde uitbreidingen het basisverbruik, zodat er weinig ruimte overblijft voor echte verzoeken.

Beeld- en PDF-verwerking (Imagick/GD), importers, back-upplugins, full-text zoekopdrachten en REST-eindpunten die grote JSON-payloads verwerken, zijn bijzonder kritisch. Cron-taken (bijv. index-rebuilds, feeds, synchronisaties) worden vaak parallel aan bezoekers uitgevoerd en veroorzaken zo onverwachte pieken. In admin-gebieden komen daar nog editor-previews, metaboxen en live-validaties bij – dat verklaart waarom backends vaker aan WP_MAX_MEMORY_LIMIT botsen als frontends.

Zo controleer ik de limiet en het werkelijke verbruik

Ik begin met een korte PHP-info of een CLI-check om het effectieve geheugenlimiet en actieve modules te zien. In WordPress log ik via de debugmodus het piekgeheugen per verzoek in en zie ik welke oproepen bijzonder veel verbruiken. Voor een snelle test zet ik een testpagina op, deactiveer ik plug-ins in blokken en observeer ik de Piek bij identieke paginaweergave. In hostingpanelen of via ps/top/wpm vraag ik hoeveel elke FPM-worker gemiddeld nodig heeft. Zo kan ik knelpunten meetbaar vaststellen en een weloverwogen beslissing nemen over de volgende limiet.

// Korte test in WordPress (wp-config.php) define('WP_DEBUG', true); define('SCRIPT_DEBUG', true); // Controleer het piekgeheugen, bijvoorbeeld via Query Monitor of logbestanden.

Voor reproduceerbare metingen log ik de pieken rechtstreeks vanuit PHP. Zo kan ik ook in productiegerichte tests zien hoeveel individuele controllers, hooks of shortcodes verbruiken:

// In een MU-plugin-bestand of functions.php: add_action('shutdown', function () { if (function_exists('memory_get_peak_usage')) {

error_log('Peak memory: ' . round(memory_get_peak_usage(true) / 1024 / 1024, 1) . ' MB | URI: ' . ($_SERVER['REQUEST_URI'] ?? 'CLI')); } });

Belangrijk: CLI en FPM gebruiken vaak verschillende php.ini-bestanden. Een script dat via WP-CLI probleemloos werkt, kan in de webcontext mislukken. Ik controleer daarom beide contexten expliciet (php -i vs. php-fpm) en test indien nodig met php -d memory_limit=512M script.php de grenzen van een baan.

PHP-geheugenlimiet correct verhogen

Ik verhoog de limiet stapsgewijs en test na elke stap de Stabiliteit. In eerste instantie is een verhoging naar 256 MB vaak voldoende, voor gegevensintensieve taken ga ik naar 512 MB en observeer ik de Pieken. Belangrijk: een te hoge limiet lost het fundamentele probleem niet op, omdat inefficiënte zoekopdrachten nog steeds werk genereren. Houd er ook rekening mee dat FPM-workers vermenigvuldigd met de limiet en het aantal processen snel het totale RAM-geheugen overschrijden. Daarom combineer ik de verhoging met optimalisaties aan plug-ins, databases en FPM-parameters.

// 1) wp-config.php (voor "Dat is alles, stop met bewerken!") define('WP_MEMORY_LIMIT', '256M');

# 2) .htaccess (voor "# END WordPress") php_value memory_limit 256M

; 3) php.ini memory_limit = 256M ; indien nodig 512M testen

// 4) functions.php (fallback, indien nodig) ini_set('memory_limit', '256M');

Voor beheertaken stel ik aanvullend een hogere limiet in, zonder de frontend onnodig op te blazen:

// wp-config.php define('WP_MAX_MEMORY_LIMIT', '512M'); // alleen voor /wp-admin en bepaalde taken

Typische valkuilen: bij PHP-FPM grijpen php_value-richtlijnen in .htaccess niet – hier gebruik ik .user.ini of de FPM-poolconfiguratie. Bovendien overschrijven sommige hosters de instellingen van de klant; ik valideer altijd de effectieve limiet tijdens de looptijd (ini_get('memory_limit')). memory_limit = -1 is taboe in de productie, omdat het lekken of pieken niet meer beperkt en de server lamlegt.

Hosting-tuning: OPcache, FPM en uitbreidingen

Een haalbare oplossing combineert een verhoging van de limiet met gerichte Afstemmen. Ik dimensionneer OPcache ruim genoeg, zodat veelgebruikte scripts in de cache blijven en er minder hercompilatie nodig is. Bij PHP-FPM stel ik pm.max_children, pm.max_requests en pm.memory_limit zo in dat verzoeken niet worden vertraagd, maar de server voldoende ruimte behoudt. Ik verwijder onnodige PHP-extensies, omdat deze het basisgeheugen van elke worker opblazen. Zo win ik headroom, verlaag ik de latentie en verminder ik het risico op stille onderbrekingen aanzienlijk.

Voor OPcache hebben solide standaardinstellingen hun waarde bewezen, die ik aanpas aan de codebasis:

; opcache-aanbevelingen opcache.enable=1 opcache.memory_consumption=256 opcache.interned_strings_buffer=16 opcache.max_accelerated_files=20000 opcache.validate_timestamps=1 opcache.revalidate_freq=2

Ik dimensioner FPM op basis van reële meetwaarden. Als vuistregel geldt: (totale RAM − OS/services − DB − OPcache) / gemiddeld werkgevend verbruik = pm.max_kinderen. Voorbeeld: 8 GB RAM, 1,5 GB OS/daemons, 2 GB DB, 256 MB OPcache, 180 MB/worker → (8192−1536−2048−256)/180 ≈ 24, dus ik begin met 20–22 en houd de wachtrij en swap in de gaten. pm.max_aanvragen Ik stel een gematigde waarde in (bijvoorbeeld 500-1000) om lekken te stoppen zonder te vaak opnieuw te starten. Tussen dynamisch en ondemand Ik kies afhankelijk van het verkeersprofiel: ondemand bespaart RAM bij sporadische pieken in de belasting, dynamic reageert sneller bij continue belasting.

| Type hosting | Typische geheugenlimiet | Tuning-functies | Gebruik |

|---|---|---|---|

| Gedeeld basis | 64–128M | Weinig opties | Kleine Blogs |

| WordPress beheerd | 256–512M | OPcache, FPM-profielen | Groeiende Sites |

| VPS | 512 MB – onbeperkt | Volledige controle | Winkels, Portalen |

| webhoster.de (testwinnaar) | tot 768M+ | OPcache & FPM-optimalisatie | PrestatiesFocus |

Houd de database en plug-ins slank

Ik ruim de database regelmatig op, verwijder oude Revisie, verwijder verlopen transiënten en verwijder spamreacties. Schone indexen versnellen zoekopdrachten en verminderen de opslagbehoefte per verzoek aanzienlijk. Bij plug-ins controleer ik het nut ten opzichte van de kosten en vervang ik zware plug-ins door lichtere alternatieven. Cache-plug-ins en een schone paginacache verminderen dynamische oproepen en besparen RAM onder belasting. Deze gedisciplineerde aanpak beperkt het piekverbruik aanzienlijk en maakt limieten betrouwbaar.

Ik zorg er ook voor dat queryresultaten worden beperkt en dat alleen de benodigde velden worden geladen. In WordPress verminder ik bijvoorbeeld met 'velden' => 'ids' de opslagbehoefte van grote lijstweergaven aanzienlijk. Persistente objectcaches ontlasten de database en verkorten de looptijden van verzoeken; het is echter belangrijk om interne in-request-caches niet te overschrijden, zodat er niet onnodig veel gegevens in het proces achterblijven.

Memory-fragmentatie begrijpen

Zelfs als er voldoende RAM lijkt te zijn, kan fragmentatie vrije Blokken in veel kleine stukjes opdelen die niet meer in grote arrays passen. Daarom observeer ik de patronen van toewijzing en vrijgave, vooral bij beeld-, JSON- en zoekfuncties. Kortere verzoeken met duidelijke levenscycli van de gegevens verminderen de fragmentatie. Ook OPcache en geoptimaliseerde autoload-strategieën verminderen de churn in het geheugen. Wie zich hier verder in wil verdiepen, vindt achtergrondinformatie over Geheugenfragmentatie en hun effecten op reële workloads.

Garbage Collection: valkuilen en instellingen

PHP-garbage collection bespaart geheugen, maar kan in grensgevallen Spikes activeren. Hoge objectgrafieken met cycli dwingen de engine tot frequente GC-runs, wat verzoeken vertraagt. Ik reduceer grote structuren, gebruik streams in plaats van volledige loads en sla zelden gebruikte gegevens op in tussenstappen. In randgevallen is het de moeite waard om GC voor korte taken te pauzeren en op gecontroleerde wijze weer te activeren. Het artikel biedt een praktische inleiding. Garbage Collection optimaliseren, die concrete instelmogelijkheden uitlegt.

Coderingstrategieën tegen piekverbruik

Ik los veel opslagproblemen op in de code. In plaats van grote hoeveelheden in arrays te laden, werk ik met generators, paginering en streams. Ik vermijd breed geaggregeerde structuren en schrijf functies zodanig dat tussentijdse resultaten vroeg kunnen worden vrijgegeven.

- Paginering: grote lijsten opsplitsen in pagina's, alleen de benodigde velden laden.

- Streams/generatoren: bestanden en resultaten stuk voor stuk verwerken.

- Chunking: import/export in blokken in plaats van volledige ladingen.

- Formaatkeuze: JSON-streams in plaats van enorme arrays; waar mogelijk iteratief parseren.

- Bewuste levenscycli: variabelen vroeg instellen, referenties vermijden.

// Voorbeeld: bestanden streamen in plaats van volledig laden function stream_copy($src, $dst) { $in = fopen($src, 'rb'); $out = fopen($dst, 'wb');

while (!feof($in)) { fwrite($out, fread($in, 8192)); } fclose($in); fclose($out); }

// Voorbeeld: grote arrays in blokken verwerken foreach (array_chunk($bigArray, 500, true) as $chunk) { process($chunk); unset($chunk); }

// WordPress: geheugenarme query

$q = new WP_Query([ 'post_type' => 'product', 'posts_per_page' => 200, 'fields' => 'ids', 'no_found_rows' => true, 'update_post_meta_cache' => false, 'update_post_term_cache' => false, ]);

Voor beeldverwerking kies ik bewust voor de editor. Op systemen met beperkte capaciteit overweeg ik bij problemen een verandering:

// Imagick tijdelijk omzeilen (bijv. bij hoge pieken) add_filter('wp_image_editors', function() { return ['WP_Image_Editor_GD', 'WP_Image_Editor_Imagick']; });

Monitoring en logging zonder lawaai

Ik activeer logging met zinvolle Grens en registreer fouten, pieken en trage verzoeken zonder het systeem te overbelasten. Query Monitor en FPM-statuspagina's tonen mij RAM, uitvoeringstijd en knelpunten per eindpunt. In logboeken zoek ik naar patronen zoals gelijktijdige 502-fouten, FPM-herstarts of abrupte afbrekingen. Kleine belastingstests na elke wijziging geven snel feedback of ik de juiste schroef heb aangedraaid. Zo voorkom ik stille storingen voordat echte bezoekers ze merken.

In de praktijk heeft een „basisset“ zijn nut bewezen: FPM-slowlog activeren, errorlogs roteren en rate limits instellen om logfluten te voorkomen. Bij de monitoring correleer ik CPU, RAM, swap, FPM-wachtrijlengte en responstijden. Zodra swap toeneemt of de FPM-wachtrij registreert, verlaag ik parallel de concurrency (minder workers) of optimaliseer ik eerst de duurste eindpunten.

Speciale gevallen: Admin, CLI, Container

In het admin-gedeelte zijn de limieten natuurlijk hoger – hier verwerk ik veel gegevens, genereer ik previews of exporteer ik lijsten. Met WP_MAX_MEMORY_LIMIT beperk ik dit extra werk specifiek tot de beheerder. Voor CLI-taken definieer ik limieten per taak (bijv. php -d memory_limit=768M), zodat zware exports betrouwbaar verlopen zonder de frontend te belasten. In containers (cgroups) merk ik dat de kernel harde RAM-limieten oplegt; PHP ziet weliswaar zijn geheugenlimiet, maar wordt toch door de OOM-killer beëindigd wanneer de containergrenzen worden overschreden. Daarom stem ik de containerlimiet, het aantal FPM-workers en geheugenlimiet samen.

Valkuilen gericht vermijden

- .htaccess-richtlijnen werken vaak niet bij FPM – beter

.user.iniof poolconfiguratie gebruiken. - Verschillende ini-bestanden voor CLI en FPM maken tests inconsistent – controleer altijd beide.

geheugenlimietVerhogen zonder FPM-herstart heeft geen effect – services netjes herladen.- Te hoge limieten zorgen voor swap-belasting – kies liever voor efficiëntere queries en minder workers.

pm.max_aanvragenZet niet op oneindig – zo blijven lekken voor altijd in het proces zitten.- Uploads/exports: POST/uploadlimieten (post_max_size, upload_max_filesize) nauwkeurig afstemmen op de RAM-capaciteit.

Kort samengevat: zo voorkom ik uitval

Ik controleer eerst de limiet en het piekverbruik, til het geheugenlimiet matig aan en meet opnieuw. Tegelijkertijd stroomlijn ik plug-ins, optimaliseer ik de database en verwijder ik onnodige uitbreidingen. Vervolgens stem ik OPcache en PHP-FPM op elkaar af, zodat de server voldoende Buffer voor piekbelastingen. Met nette logging en korte belastingstests houd ik de risico's klein en herken ik stille fouten sneller. Zo blijft de site stabiel, belonen zoekmachines betere laadtijden – en blijven bezoekers.