Ich zeige dir, warum Page Cache und Object Cache völlig verschiedene Aufgaben übernehmen und wie du damit WordPress unter Last schnell hältst. Wer beide Caches richtig kombiniert, reduziert Serverarbeit, senkt TTFB und beschleunigt dynamische Shops, Mitgliederbereiche und Portale deutlich.

Zentrale Punkte

- Page Cache: Fertige HTML-Ausgabe, ideal für anonyme Aufrufe.

- Object Cache: Datenbank-Ergebnisse im RAM, ideal für dynamische Logik.

- Synergie: Beide Ebenen lösen verschiedene Flaschenhälse.

- Ausnahmen: Checkout, Konto, Warenkorb nicht als Seite cachen.

- Steuerung: Klare TTL- und Invalidierungsregeln verhindern Fehler.

Was Caching in WordPress wirklich leistet

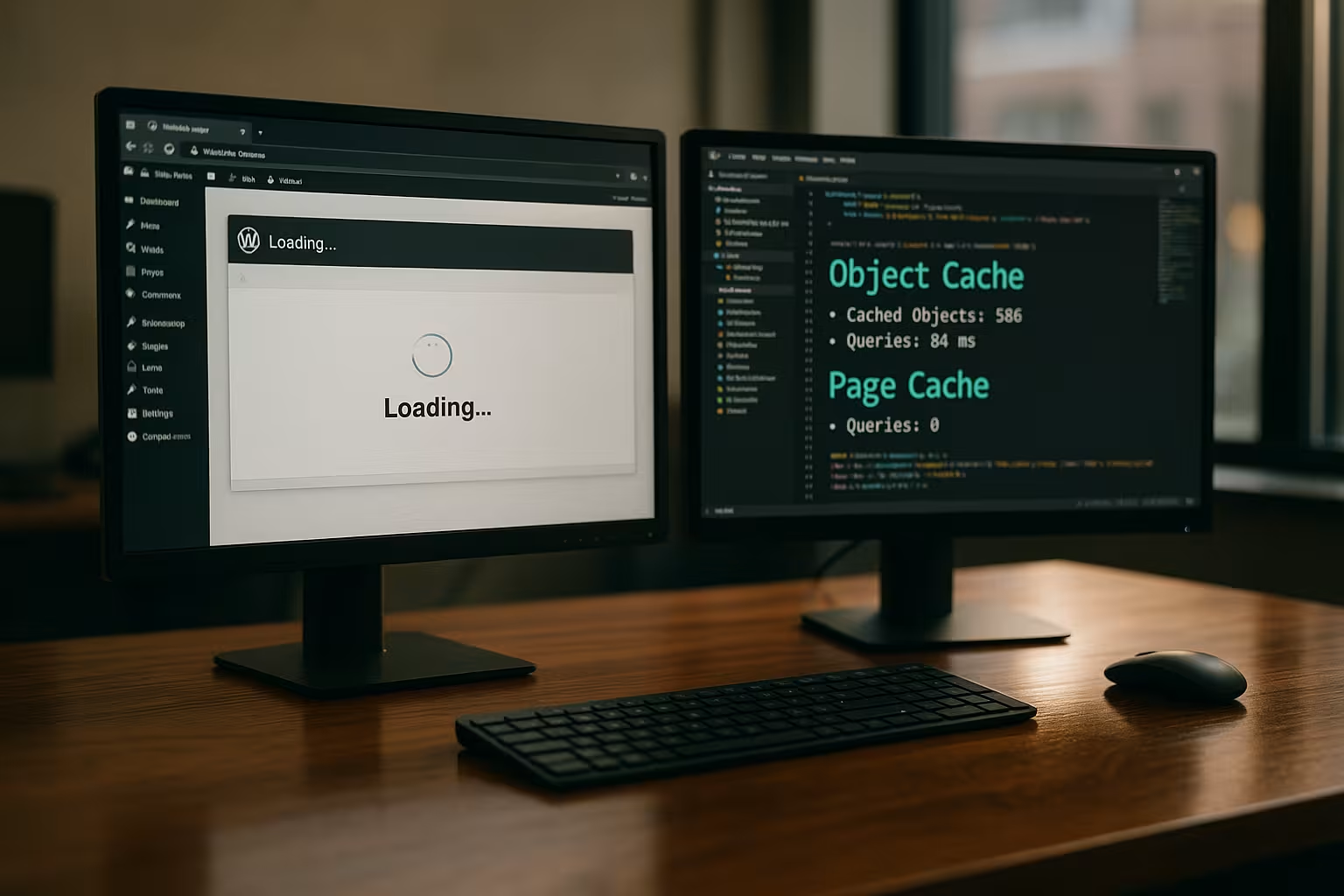

WordPress erzeugt jede Seite bei jedem Aufruf neu, was ohne Caching PHP, Datenbank und Plugins ständig beschäftigt. Das kostet Zeit, erzeugt Last und bremst besonders bei steigenden Zugriffen. Ein Cache speichert Zwischenergebnisse und liefert bei Wiederholungen Daten sofort aus dem Speicher. Auf Seitenebene vermeidest du die komplette Neu-Generierung, auf Objektebene sparst du teure Abfragen. So sinkt die Serverarbeit, die Antwortzeit fällt und die Benutzerführung fühlt sich direkter an.

Page Cache: fertige HTML-Seiten für anonyme Aufrufe

Beim Page-Cache speichere ich die komplette HTML-Ausgabe einer URL, wodurch der Server bei späteren Treffern Page Cache direkt ausliefert. Das umgeht WordPress-Bootstrap, PHP und nahezu alle Abfragen, was TTFB und LCP spürbar senkt. Besonders gut funktioniert das bei Blog-Artikeln, Landingpages, Kategorien und statischen Inhaltsseiten. Vorsicht gilt bei personalisierten Abschnitten wie Warenkorb, Checkout oder Konto, die ich gezielt vom Caching ausnehme. Häufige Content-Updates erfordern zusätzlich eine zuverlässige Ungültigerklärung, damit Besucher frische Inhalte sehen.

Object Cache: der Turbo für Datenbank und Logik

Der Object Cache speichert einzelne Ergebnisse von Abfragen oder Berechnungen im RAM, damit dieselbe Anfrage nicht erneut die Datenbank belastet und damit die Leistung sinkt. Standardmäßig gilt der interne WP_Object_Cache nur pro Request, weshalb ich für echte Wirkung einen persistenten Cache nutze. Hier spielen In-Memory-Stores wie Redis oder Memcached ihre Stärken aus, weil sie häufig gebrauchte Datensätze millisekundenschnell zurückgeben. Bei Shops, Membership-Portalen oder Multisite-Setups reduziert das Query-Zeiten und schützt vor Engpässen. Wer tiefer in Technik und Auswahl einsteigen will, prüft Redis vs Memcached für WordPress.

Page Cache vs Object Cache – der entscheidende Unterschied

Beide Caches lösen verschiedene Engstellen: Der Seiten-Cache umgeht die teure Generierung der kompletten Ausgabe, während ein Datenobjekt-Cache die Query-Schicht beschleunigt und damit die Unterschiede sichtbar macht. Du kombinierst also Frontend-Schnelligkeit mit Datenbank-Entlastung. Daraus entsteht eine stimmige Architektur, die sowohl anonyme Aufrufe als auch eingeloggte Sitzungen effizient bedient. Wichtig bleibt jeweils eine klare Regelung, welche Inhalte wie lange gecacht werden dürfen.

| Merkmal | Page Cache | Object Cache |

|---|---|---|

| Ebene | Komplette HTML-Ausgabe | Einzelne Datenobjekte/Abfrage-Ergebnisse |

| Ziel | Schnell fertige Seiten ausliefern | Datenbank und PHP-Logik entlasten |

| Typischer Einsatz | Blog, Magazin, Landingpages, Produktlisten | WooCommerce, Memberships, komplexe Queries, API-Daten |

| Sichtbarkeit | Direkt messbarer Ladezeit-Gewinn | Indirekt, besonders bei Lastspitzen |

| Risiko | Falsches Caching dynamischer Seiten | Zu lange TTL führt zu veralteten Daten |

Konkrete Einsatzszenarien, die den Unterschied machen

Bei Blogs und Unternehmensseiten setze ich den Seiten-Cache als Haupthebel ein, während der Objekt-Cache optional Queries auf Start- und Archivseiten abkürzt und so die Performance hebt. In WooCommerce-Shops cache ich Produkt- und Kategorieseiten, schließe Checkout, Warenkorb und Konto jedoch strikt aus und lasse Redis oder Memcached die Datenlast schultern. Auf Membership- oder E‑Learning-Plattformen liefert Page-Cache nur bei öffentlichen Inhalten Vorteile, während ein persistenter Object Cache die personalisierte Logik beschleunigt. Nachrichtenportale profitieren von aggressivem Seiten-Caching, ergänzt durch Edge-Caching am CDN und eine Objekt-Ebene für Filter, Suchen und personalisierte Teile. Jedes dieser Szenarien zeigt, wie sich beide Caches sinnvoll ergänzen und keine Konkurrenz bilden.

So spielen die Caches zusammen

Ein starkes Setup kombiniert mehrere Schichten, damit jede Anfrage auf dem schnellsten Weg bedient wird und die Synergie greift. Serverseitiger Seiten-Cache (z. B. Nginx/Apache) liefert statische HTML-Dateien blitzschnell aus. Der Objekt-Cache fängt wiederkehrende, teure Abfragen ab, gerade dort, wo Seiten-Caching nicht möglich ist. Browser-Cache reduziert wiederholte Transfers für Assets, und OPcache hält vorkompilierten Bytecode im RAM. Wie diese Ebenen ineinandergreifen, zeigt ein Blick auf Caching-Hierarchien für Webtechnik und Hosting.

Best Practices für nachhaltige Geschwindigkeit

Ich definiere zuerst je Seitentyp klare Regeln: Seiten-Cache für öffentliche Inhalte, kein Seiten-Cache für persönliche Flows, starker Objekt-Cache für wiederkehrende Daten und eine passende Strategie für TTL/Invalidierung. Beim Veröffentlichen oder Aktualisieren leerst du gezielt betroffene Seiten sowie abhängige Listen. Für Shops gilt: Produktänderungen invalidieren passende Produkt- und Kategorieseiten, damit Preise und Lagerstände stimmen. Monitoring hilft, Hit-Rates, RAM-Auslastung und TTL-Werte zu beurteilen und nachzujustieren. Für maximale Effizienz setze ich bevorzugt serverseitiges Caching ein und nutze Plugins nur für Regeln und Frontend-Optimierung.

Monitoring, TTL und Invalidierung klug einstellen

Ohne Beobachtung läuft jeder Cache ins Leere, deshalb messe ich Hit-Rate, miss Rate und Latenzen, um Engstellen zu erkennen und die TTL richtig zu wählen. Für häufig geänderte Inhalte setze ich kürzere Lebenszeiten oder Event-gesteuerte Invalidierung ein. Für unveränderte Seiten dürfen die Werte großzügiger sein, solange Aktualität gewährleistet bleibt. Keys strukturiere ich nachvollziehbar, damit ich gezielt leeren kann, statt den gesamten Speicher zu löschen. Diese Ordnung verhindert Fehlentscheidungen und sorgt für planbare Ergebnisse.

Fehler vermeiden: typische Stolpersteine

Ein häufiger Fehler liegt im versehentlichen Caching personalisierter Ansichten, weshalb ich Warenkorb, Checkout und Konto grundsätzlich ausschließe und damit Sicherheit erhöhe. Ebenso problematisch: zu lange TTLs, die veraltete Daten liefern und Vertrauen kosten. Manchmal verhindern Query-Strings oder Cookies einen Seiten-Cache-Treffer, obwohl es sinnvoll wäre, also prüfe ich Regeln sorgfältig. Fehlende OPcache-Aktivierung verschenkt CPU-Potenzial und verlängert PHP-Laufzeiten. Und wer den Objekt-Cache ohne Monitoring betreibt, riskiert Speicherengpässe oder ineffektive Trefferquoten.

Caching für eingeloggte Nutzer und personalisierte Inhalte

Nicht jede Seite lässt sich vollflächig cachen – gerade eingeloggte Bereiche brauchen flexible Strategien. Ich splitte die Oberfläche in statische und dynamische Fragmente: Der Rahmen (Header, Footer, Navigation) kann als Seite oder Edge-Fragment gecacht werden, während personalisierte Bereiche (Mini-Warenkorb, „Hallo, Max“, Benachrichtigungen) per Ajax oder ESI dynamisch nachgeladen werden. So bleibt der Großteil schnell, ohne Datenschutz oder Korrektheit zu kompromittieren. Wichtig sind klare Ausschlussregeln: Nonces, CSRF-Tokens, Einmal-Links, personalisierte Preise, Punkte/Kredite oder Nutzerspezifische Empfehlungen dürfen nicht im Seiten-Cache landen. Für problematische Ansichten setze ich hart DONOTCACHEPAGE oder markiere einzelne Blöcke als nicht cachebar. Je granularer ich fragmentiere, desto größer der Anteil der Seite, der sicher gecacht werden kann.

Cache-Schlüssel, Variationen und Kompatibilität

Guter Cache steht und fällt mit sauberen Keys. Ich definiere Variationen dort, wo sie fachlich nötig sind: Sprache, Währung, Standort, Gerätetyp, User-Rolle oder relevante Query-Parameter. Ein pauschales „Vary: Cookie“ vermeide ich, weil sonst jeder Nutzer einen eigenen Cache-Eintrag erzeugt. Stattdessen nutze ich schmale, vorhersehbare Schlüssel (z. B. lang=de, currency=EUR, role=subscriber) und gruppiere Daten im Object Cache, damit sich selektiv löschen lässt. Für Such- und Filterseiten setze ich kurze TTLs und begrenze die Parameter, die in den Schlüssel einfließen. So verhindere ich Fragmentierung und halte die Hit-Rate hoch. Bei Multisite-Umgebungen trenne ich über Site-Prefixes, um versehentliche Überschneidungen zu vermeiden.

WooCommerce und andere Commerce-Plugins richtig cachen

Shops profitieren stark von Cache – solange sensible Flows ausgespart bleiben. Ich cache Produkt-, Kategorie- und CMS-Seiten mit moderaten TTLs und invalidiere bei Preis-, Lager- oder Attribut-Änderungen gezielt betroffene URLs. Checkout, Warenkorb, Konto, „order-pay“ und alle wc-ajax-Endpunkte sind tabu für den Page-Cache. GET-Parameter wie add-to-cart oder Gutschein-Parameter dürfen keine statische Seite ziehen. Bei Mehrwährung, Geolokation oder kundenspezifischen Preisen erweitere ich die Cache-Keys um Währung/Land und setze kurze TTLs. Stock-Änderungen invalidiere ich eventbasiert, damit Überverkäufe ausbleiben. Falls Theme/Plugin „Cart Fragments“ nutzt, achte ich auf effiziente Ajax-Antworten und vermeide, dass diese Requests den Seiten-Cache entwerten. Der Object Cache puffert zudem teure Produkt-Queries (Variationen, Metafelder, Preisberechnungen) – das entlastet die Datenbank bei Trafficspitzen.

REST API, Blocks und Headless-Setups

Auch die WordPress-REST-API lässt sich cachend beschleunigen. Ich vergebe für häufig aufgerufene Endpunkte (z. B. Listen, Populäre Beiträge, Produktfeeds) eine definierte TTL und leere bei Änderungen gezielt. In Headless- oder Block-Themes lade ich wiederkehrende API-Widgets über den Object Cache vor und minimiere Roundtrips, indem ich Ergebnisse serverseitig zusammenstelle. Wichtig: Personalisierte API-Antworten nicht global cachen, sondern nach Nutzer- oder Rollen-Kontext variieren oder ganz aussparen. Für öffentliche Endpunkte funktionieren darüber hinaus Edge-TTLs am CDN sehr gut – solange die Antwort frei von Cookies und privaten Headern bleibt.

CDN-Integration und Edge-Strategien

Ein CDN verschiebt den Seiten-Cache näher zum Besucher und entlastet den Origin. Ich sorge dafür, dass öffentliche Seiten ohne Session-Cookies auskommen, setze konsistente Cache-Control-Header und erlaube „stale-while-revalidate“ und „stale-if-error“, damit der Edge bei Updates nicht blockiert. Purges triggert das Backend ereignisgesteuert (z. B. beim Veröffentlichen, Planen, Aktualisieren), idealerweise mit Tag- oder Pfad-basierten Löschungen statt Full Purge. Regeln für Query-Strings, Cookies und Device-Varianten gestalte ich minimal – jede zusätzliche Variation verdünnt die Hit-Rate. Für personalisierte Teile nutze ich ESI/Ajax-Fragmente, damit der Edge weiterhin die Hülle gecacht hält.

Microcaching und Schutz vor Cache-Stampedes

Für stark frequentierte, aber dynamische Seiten setze ich Microcaching ein: wenige Sekunden TTL auf Edge- oder Serverebene glätten Lastspitzen enorm, ohne die Aktualität spürbar zu beeinträchtigen. Um Cache-Stampedes (gleichzeitiges Rekompilieren) zu verhindern, nutze ich Locking/Mutex-Mechanismen oder „request collapsing“, sodass nur eine Anfrage die Seite regeneriert und alle anderen kurz warten oder „stale“ bekommen. Auf Object-Cache-Ebene helfen „dogpile prevention“-Strategien: vor Ablauf wird ein Key im Hintergrund erneuert, während Leser noch die alte, aber gültige Version erhalten. So bleiben TTFB und Fehlerquote auch bei Flash-Traffic stabil.

Prewarming und planvolles Leeren

Nach Purges oder Deployments wärme ich kritische Seiten vor, damit echte Nutzer nicht auf „kalte“ Antworten treffen. Grundlage sind Sitemap-URLs, Topseller, Einstiegs- und Kampagnenseiten. Ich steuere die Aufrufrate, um nicht selbst Lastspitzen zu erzeugen, und prüfe dabei die Cache-Hit-Header, bis die wichtigsten Routen warm sind. Beim Leeren vermeide ich Full Purges und arbeite mit Abhängigkeiten: Ein Produkt invalidiert seine Seite, Varianten, betroffene Kategorien und eventuell Startseiten-Teaser – mehr nicht. So bleibt der Cache großteils intakt, während geänderte Inhalte sofort korrekt erscheinen.

Debugging im Alltag: Kopfzeilen und Checks

Ob ein Cache greift, sehe ich an Response-Headern wie Cache-Control, Age, X-Cache/X-Cache-Status oder Plugin-spezifischen Hinweisen. Ich vergleiche TTFB zwischen Erstaufruf und Reload, beachte dabei Cookies, Query-Strings und Login-Status. Für Objekt-Caching beobachte ich Hit/Miss-Quoten und Laufzeiten der Top-Queries. A/B-Tests und Personalisierung kennzeichne ich klar über Variations-Cookies oder route sie gezielt an den Origin, damit der Page-Cache nicht fragmentiert. Sobald Messwerte kippen (z. B. steigende Miss-Rate bei stabilen Besuchern), justiere ich TTLs, Invalidierung oder Schlüsselstrategie.

Multisite, Mehrsprachigkeit und Multiwährung

In Multisite-Setups trenne ich Caches sauber pro Site via Prefix oder separatem Namespace. So bleiben Invalidierungen gezielt und Statistiken aussagekräftig. Mehrsprachige Seiten erhalten pro Sprache eigene Page-Cache-Varianten; auf Object-Ebene halte ich übersetzte Menüs, Optionen und Übersetzungs-Maps separat. Bei Multiwährung erweitere ich Keys um Währung und – wenn nötig – Land. Wichtig: Geolokalisierung sollte früh und deterministisch greifen, damit dieselbe URL nicht unkontrolliert in viele Varianten zerfällt. Für Suchen, Feeds und Archive setze ich konservative TTLs und halte die Parameter-Whitelist klein.

Hosting-Faktoren, die Caching erst stark machen

Leistung hängt auch vom Server ab, daher achte ich auf eine aktuelle PHP-Version mit aktivem OPcache, genügend RAM für Redis und schnelle NVMe-SSDs, wodurch die Umgebung passt. Eine Plattform mit serverseitigem Page-Cache und CDN-Integration spart viele Plugin-Schichten. Gute Netzwerkanbindung verringert Latenzen und hilft dem TTFB. Auf Managed-WordPress-Angeboten prüfe ich, ob Page- und Object-Caching integriert und sauber abgestimmt sind. So holst du messbare Zeitgewinne heraus, ohne jedes Detail manuell zu justieren.

Kurz zusammengefasst

Die wichtigste Kernaussage: Page Cache beschleunigt die vollständige Seitenausgabe, Object Cache verkürzt den Weg zu wiederkehrenden Daten. Beide zusammen decken die relevanten Flaschenhälse ab und liefern Geschwindigkeit für anonyme und eingeloggte Nutzer. Mit klaren Regeln für Ausnahmen, TTL und Invalidierung bleiben Inhalte korrekt und frisch. Ergänzende Ebenen wie Browser-Cache, Edge-Cache und OPcache runden das Setup ab. So erreichst du bessere Kennzahlen, geringere Last und ein spürbar schnelleres WordPress – selbst bei viel Traffic und dynamischen Inhalten.